综合介绍

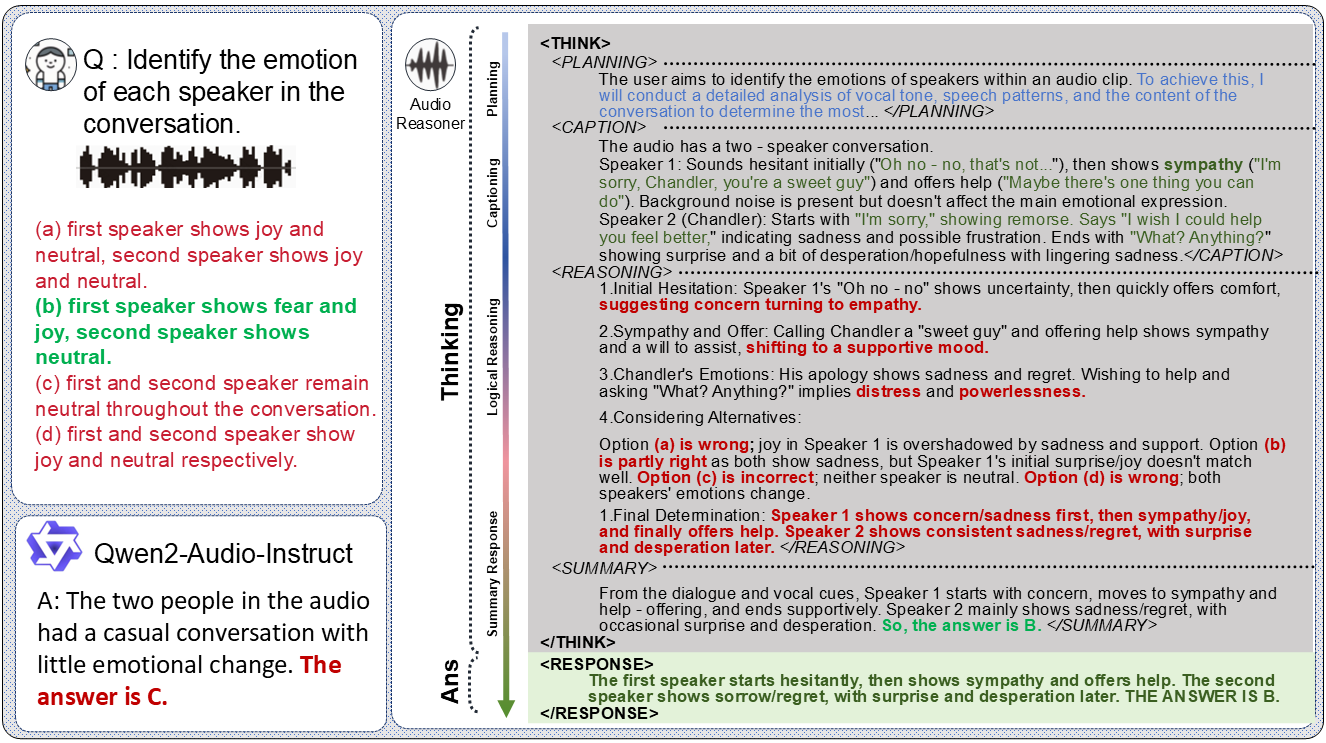

Audio-Reasoner 是由清华大学团队开发并托管于 GitHub 的开源项目,专注于构建支持音频深度推理的大型语言模型。该模型基于 Qwen2-Audio-Instruct,通过引入结构化的链式思维(Chain-of-Thought, CoT)技术,实现对音频内容的复杂推理和多模态理解。项目包含 Audio-Reasoner-7B 模型和即将推出的 CoTA 数据集(含120万高质量样本),在 MMAU-mini 和 AIR-Bench-Chat 基准测试中分别提升 25.42% 和 14.57% 的性能,达到领先水平。Audio-Reasoner 支持处理声音、音乐、语音等多种音频类型,适用于音频分析、内容理解等场景,是研究人员和开发者的理想工具。

功能列表

- 音频深度推理: 利用结构化链式思维,分析音频并生成详细的推理过程和结果。

- 多模态任务支持: 结合音频与文本输入,完成跨模态理解和推理任务。

- 多种音频处理: 支持声音、音乐、语音等多种音频类型的识别与分析。

- 高性能预训练模型: 提供 Audio-Reasoner-7B 模型,在多项基准测试中表现优异。

- CoTA 数据集: 包含120万样本,支持模型的结构化推理训练和能力提升。

- 推理代码与演示: 提供完整的推理代码和演示示例,便于用户测试和开发。

- 开源计划: 未来将开放数据合成流程和训练代码,促进社区协作。

使用帮助

安装流程

Audio-Reasoner 的安装需要配置 Python 环境并下载模型权重,以下是详细步骤,确保用户可以顺利完成搭建:

1. 克隆 GitHub 仓库

首先在本地克隆 Audio-Reasoner 项目。打开终端,运行以下命令:

git clone https://github.com/xzf-thu/Audio-Reasoner.git

cd Audio-Reasoner

这会将项目文件下载到本地并进入项目目录。

2. 创建并激活虚拟环境

为避免依赖冲突,建议使用 Conda 创建独立的 Python 环境:

conda create -n Audio-Reasoner python=3.10

conda activate Audio-Reasoner

此命令创建并激活一个基于 Python 3.10 的环境,名为 "Audio-Reasoner"。

3. 安装依赖包

项目提供了 requirements.txt 文件,包含必要的依赖。安装步骤如下:

pip install -r requirements.txt

pip install transformers==4.48.0

注意:transformers 需安装 4.48.0 版本,以确保模型性能稳定。先安装其他依赖,再单独指定 transformers 版本,避免冲突。

4. 下载模型权重

Audio-Reasoner-7B 模型已发布于 HuggingFace,需手动下载并配置路径:

- 访问 HuggingFace Audio-Reasoner-7B,下载模型文件。

- 将下载的检查点路径填入代码中的

last_model_checkpoint变量,例如:

last_model_checkpoint = "/path/to/Audio-Reasoner-7B"

如何使用

安装完成后,用户可以通过代码运行 Audio-Reasoner,处理音频任务。以下是详细操作指南:

快速开始:运行示例代码

项目提供了一个快速入门示例,帮助用户测试模型功能:

- 准备音频文件

默认使用项目自带的assets/test.wav文件,也可替换为自己的 WAV 格式音频。确保路径正确。 - 编辑代码中的音频路径和问题

打开inference.py或直接使用以下代码,设置音频路径和提问:audiopath = "assets/test.wav" prompt = "这段音频的节奏感和拍子是怎样的?" audioreasoner_gen(audiopath, prompt) - 运行程序

在终端中执行:conda activate Audio-Reasoner cd Audio-Reasoner python inference.py模型将输出结构化的推理结果,包括

<THINK>(计划、描述、推理、总结)和<RESPONSE>(最终回答)。

核心功能:音频深度推理

Audio-Reasoner 的核心是基于链式思维的音频推理,以下是操作流程:

- 输入音频和问题

- 使用

audioreasoner_gen函数,传入音频路径和具体问题。例如:audiopath = "your_audio.wav" prompt = "音频中是否有鸟叫声?" audioreasoner_gen(audiopath, prompt)

- 使用

- 查看推理输出

模型会返回详细的推理过程,例如:<THINK> <PLANNING>: 检查音频中的声音特征,识别是否有鸟叫声。 <CAPTION>: 音频包含自然环境音,可能有风声和动物叫声。 <REASONING>: 分析高频声音特征,与鸟类叫声模式匹配。 <SUMMARY>: 音频中可能存在鸟叫声。 </THINK> <RESPONSE>: 是的,音频中有鸟叫声。 - 调整输出参数(可选)

若需更长或更灵活的回答,可修改RequestConfig参数:request_config = RequestConfig(max_tokens=4096, temperature=0.5, stream=True)

本地测试预设样本

项目内置了测试音频和问题,方便快速验证:

conda activate Audio-Reasoner

cd Audio-Reasoner

python inference.py

运行后,终端会显示对 assets/test.wav 的分析结果,适合初次体验。

特色功能:多模态理解

Audio-Reasoner 支持音频与文本的联合分析。例如:

prompt = "这段音乐的情绪是否与‘悲伤’描述相符?"

audioreasoner_gen("sad_music.wav", prompt)

模型会结合音频特征和文本语义,输出推理结果。

注意事项与常见问题

- 音频格式: 推荐使用 WAV 格式,采样率 16kHz,单声道。

- 运行缓慢: 若速度慢,检查是否启用 GPU(需安装 CUDA 版 PyTorch)。

- 模型无响应: 确认模型路径是否正确,依赖是否完整安装。

- 依赖冲突: 若安装失败,尝试新建环境并严格按顺序安装依赖。

进阶使用

- 自定义推理逻辑: 修改

system提示词,调整模型的推理风格。 - 批量处理: 将

max_batch_size设为更高值(如 128),支持多音频同时推理。 - 结合 CoTA 数据集: 未来 CoTA 数据集发布后,可用于进一步训练或微调模型。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...