衡量通用人工智能(AGI)进展的基准至关重要。有效的基准能够揭示能力,而优秀的基准更能激发研究方向。ARC Prize 基金会致力于通过其 ARC-AGI 系列基准扮演这样的角色,引导研究力量关注真正的通用智能。最新的 ARC-AGI-2 基准及其初步测试结果,为当前 AI 能力的边界和效率问题敲响了警钟。

ARC-AGI-1 自 2019 年推出以来,在追踪 AGI 进展方面扮演了独特角色,曾帮助识别 AI 何时开始超越单纯的模式记忆。随后的 ARC Prize 2024 竞赛也吸引了大量研究者探索新的测试时适应性思路。

然而,通往 AGI 的道路依然漫长。当前的进展,如 OpenAI 的 o3 系统所展现的,或许只是在“流体智力”这个维度上实现了有限突破。这些系统不仅效率低下,且仍需大量人工监督。显然,AGI 的实现需要更多源头上的创新。

新挑战:ARC-AGI-2,专为暴露 AI 弱点而生

为此,ARC Prize 基金会现已推出 ARC-AGI-2 基准。其设计目标明确:对 AI(尤其是推理系统)来说难度显著提升,同时保持对人类的相对易处理性。这并非简单的难度增加,而是针对性地挑战当前 AI 方法难以克服的障碍。

设计哲学:聚焦人易 AI 难的智能鸿沟

与其他许多追求超人能力的 AI 基准不同,ARC-AGI 聚焦于那些对人类来说相对容易,但对当前 AI 而言却极其困难的任务。这种策略旨在揭示那些无法通过简单地“扩大规模”就能弥补的能力缺口。通用智能的核心在于从有限经验中高效泛化和应用知识的能力,而这正是当前 AI 的软肋。

ARC-AGI-2:难度升级,直面 AI 推理软肋

ARC-AGI-2 在 ARC-AGI-1 的基础上,显著提高了对 AI 的要求,强调高适应性与高效率的结合。通过分析前沿 AI 在先前任务上的失败案例,ARC-AGI-2 引入了更多考验符号解释、组合推理、上下文规则应用等能力的挑战。这些任务旨在迫使 AI 超越表面模式匹配,进行更深层次的抽象和推理。

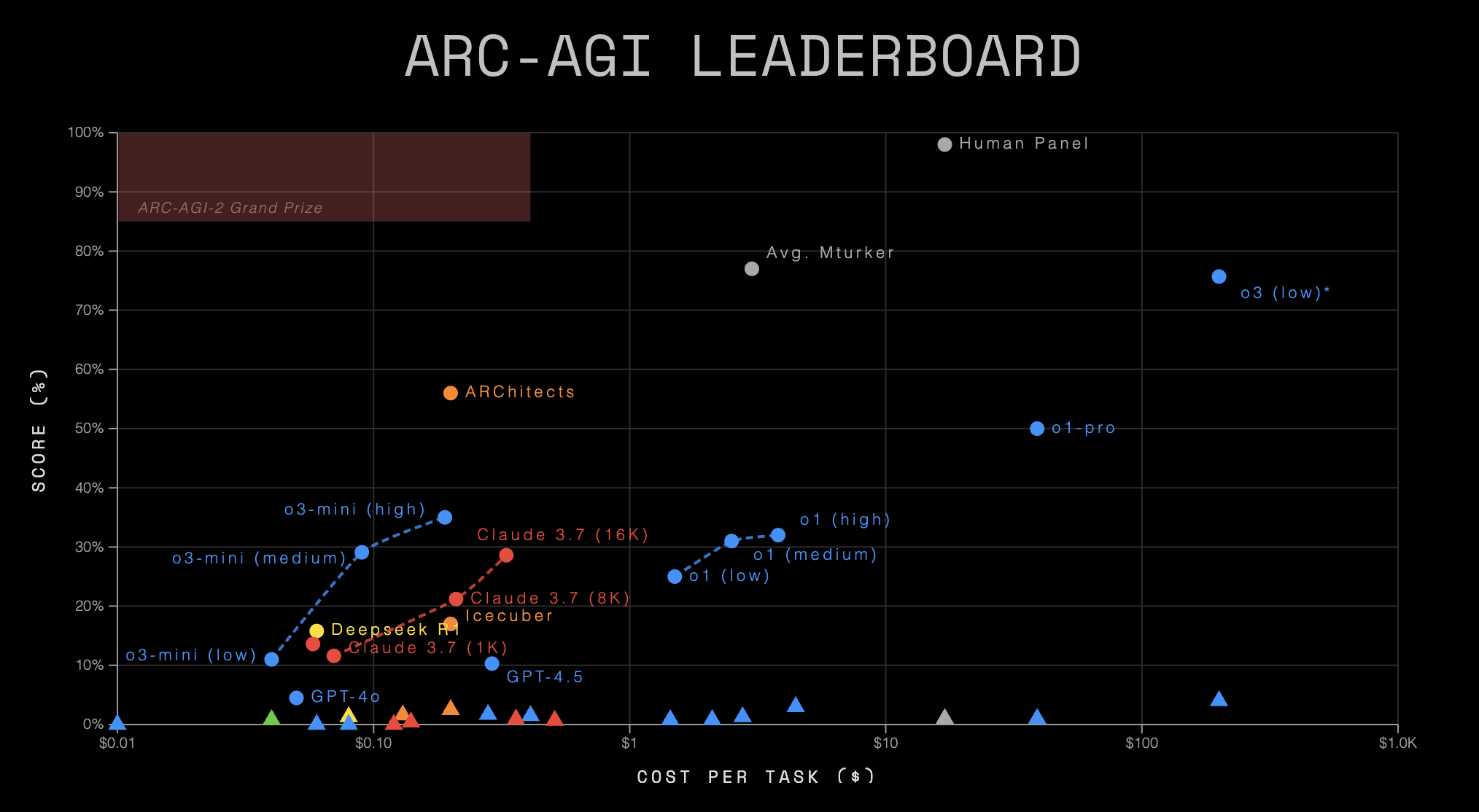

ARC-AGI-2 成绩单:一份严峻的现实映照

最新公布的 ARC-AGI 排行榜数据,为我们描绘了一幅关于当前 AI 能力的严峻图景。这份数据不仅证实了 ARC-AGI-2 的挑战性,更深刻地揭示了 AI 在通用推理能力和效率上的巨大鸿沟。

Leaderboard 数据概览

| AI System | Organization | System Type | ARC-AGI-1 | ARC-AGI-2 | Cost/Task | Code / Paper |

|---|---|---|---|---|---|---|

| Human Panel | Human | N/A | 98.0% | 100.0% | $17.00 | — |

| o3 (low)* | OpenAI | CoT + Synthesis | 75.7% | 4.0% | $200.00 | 📄 |

| o1 (high) | OpenAI | CoT | 32.0% | 3.0% | $4.45 | 💻 |

| ARChitects | ARC Prize 2024 | Custom | 56.0% | 2.5% | $0.200 | 📄💻 |

| o3-mini (medium) | OpenAI | CoT | 29.1% | 1.7% | $0.280 | 💻 |

| Icecuber | ARC Prize 2024 | Custom | 17.0% | 1.6% | $0.130 | 💻 |

| o3-mini (high) | OpenAI | CoT | 35.0% | 1.5% | $0.410 | 💻 |

| Gemini 2.0 Flash | Base LLM | N/A | 1.3% | $0.004 | 💻 | |

| o1 (medium) | OpenAI | CoT | 31.0% | 1.3% | $2.76 | 💻 |

| Deepseek R1 | Deepseek | CoT | 15.8% | 1.3% | $0.080 | 💻 |

| Gemini-2.5-Pro-Exp-03-25 ** | CoT | 12.5% | 1.3% | N/A | 💻 | |

| o1-pro | OpenAI | CoT + Synthesis | 50.0% | 1.0% | $39.00 | — |

| Claude 3.7 (8K) | Anthropic | CoT | 21.2% | 0.9% | $0.360 | 💻 |

| Gemini 1.5 Pro | Base LLM | N/A | 0.8% | $0.040 | 💻 | |

| GPT-4.5 | OpenAI | Base LLM | 10.3% | 0.8% | $2.10 | 💻 |

| o1 (low) | OpenAI | CoT | 25.0% | 0.8% | $1.44 | 💻 |

| Claude 3.7 (16K) | Anthropic | CoT | 28.6% | 0.7% | $0.510 | 💻 |

| Claude 3.7 (1K) | Anthropic | CoT | 11.6% | 0.4% | $0.140 | 💻 |

| Claude 3.7 | Anthropic | Base LLM | 13.6% | 0.0% | $0.120 | 💻 |

| GPT-4o | OpenAI | Base LLM | 4.5% | 0.0% | $0.080 | 💻 |

| GPT-4o-mini | OpenAI | Base LLM | N/A | 0.0% | $0.010 | 💻 |

| o3-mini (low) | OpenAI | CoT | 11.0% | 0.0% | $0.060 | 💻 |

(注:表格中 * 表示初步估计值,* 表示实验性模型)*

深刻解读:数据背后的警示

- 人类 vs AI:难以逾越的鸿沟

最引人注目的莫过于人类与 AI 表现的悬殊对比。在ARC-AGI-2上,人类小组取得了 100% 的完美得分,而表现最好的 AI 系统——OpenAI的o3 (low),得分仅为 4.0%。其他知名模型,如Gemini 2.0 Flash、Deepseek R1等,得分均在 1.3% 左右徘徊。更令人震惊的是,像Claude 3.7、GPT-4o、GPT-4o-mini这些在其他领域表现出色的基础大语言模型(Base LLM),在ARC-AGI-2上的得分直接归零。这无情地揭示了,尽管 AI 在特定任务上能力惊人,但在面对需要灵活、抽象、通用推理能力的新颖问题时,与人类相比仍有本质上的差距。 - 从 AGI-1 到 AGI-2:AI 能力的断崖式下跌

几乎所有参与测试的 AI 系统,在从ARC-AGI-1过渡到ARC-AGI-2时,性能都出现了急剧下滑。例如,o3 (low)从 75.7% 骤降至 4.0%,o1-pro从约 50% 跌至 1.0%,ARChitects从 56.0% 降至 2.5%。这一普遍现象强烈暗示,ARC-AGI-2确实成功触及了当前 AI 方法论的“痛点”,无论是基于 CoT(思维链)、Synthesis(综合/搜索)还是其他定制方法,都难以有效应对ARC-AGI-2所代表的推理挑战。 - 系统类型与效率:高成本并未带来高智能

排行榜进一步揭示了不同 AI 系统类型在ARC-AGI-2上的表现差异和严峻的效率问题:- CoT + Synthesis 系统 (

o3 (low),o1-pro) 虽然取得了相对最高的 AI 分数(4.0% 和 1.0%),但其成本却高得惊人(分别为 $200 和 $39 每任务)。这表明复杂的推理加搜索策略或许能“挤”出一点分数,但效率极其低下。 - 纯 CoT 系统 表现参差不齐,得分普遍在 1%-3% 之间,成本也从几美分到几美元不等。这似乎说明仅靠 CoT 不足以应对挑战。

- 基础大语言模型 (Base LLM) (

GPT-4.5,Gemini 1.5 Pro,Claude 3.7,GPT-4o) 的表现堪称溃败,得分多为 0% 或接近 0%。这有力地反驳了“规模就是一切”的观点,至少在ARC-AGI所衡量的通用流体智力方面是如此。 - 定制系统 (Custom) (

ARChitects,Icecuber) 作为ARC Prize 2024的产物,以极低的成本(约 $0.1-$0.2 每任务)取得了与其他 AI 系统相当甚至略优的成绩(2.5%, 1.6%)。这或许暗示了,针对性的、轻量级的算法或架构,在解决这类问题上可能比庞大而通用的模型更有潜力,也凸显了开放竞赛和社区创新的价值。

- CoT + Synthesis 系统 (

- 效率危机:智能不能只看分数

ARC Prize将“成本/任务”作为关键指标纳入排行榜,意义重大。数据显示,即使是表现最好的 AI (o3 (low)得 4%),其单任务成本 ($200) 也是人类 ($17 得 100%) 的十倍以上。而一些低成本模型,如Gemini 2.0 Flash,虽然成本极低 ($0.004),得分也仅有 1.3%。这形成了鲜明的对比:AI 要么得分极低,要么成本高昂,或者两者兼具。智能并非不计成本地获得正确答案,效率是其内在属性。当前 AI 在ARC-AGI-2上展现的“能力-成本”曲线,无疑暴露了一场深刻的“效率危机”。

数据集构成与竞赛细节

ARC-AGI-2 包含经校准的训练集和评估集,沿用 pass@2 评分机制。主要变更包括任务数量增加、移除易被暴力破解的任务、基于人类测试进行难度校准、并设计了针对性的新任务。

ARC Prize 2025 竞赛启动:百万美元悬赏新思路

伴随着这份严峻的成绩单,ARC Prize 2025 竞赛在 Kaggle 平台上线(3月26日-11月3日),总奖金高达 100 万美元。竞赛环境限制了 API 使用和计算资源(约 50 美元/提交),并强制要求获奖者开源解决方案。这进一步强化了对效率和创新的要求。

相较于 2024 年,2025 年竞赛的主要变更日志包括:采用 ARC-AGI-2 数据集、新的排行榜报告机制、强化开源要求、计算资源翻倍、以及额外的防过拟合措施。

结语:真正的突破亟待新范式

ARC-AGI-2 的排行榜数据如同一面镜子,清晰地映照出当前 AI 在通用推理和效率上的局限性。它提醒我们,通往 AGI 的道路远非坦途,简单的模型放大或增加计算资源可能不足以跨越眼前的鸿沟。真正的突破,或许需要全新的思路、不同的架构,甚至可能来自大型实验室之外的创新者。ARC Prize 2025 正是这样一个呼唤新范式的平台。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...