简介

评估是开发和优化检索增强生成(RAG)系统的关键环节。评估涉及对 RAG 流程各方面的性能、准确性和质量进行衡量,包括从检索效果到生成响应的相关性和真实性。

RAG 评估的重要性

对 RAG 系统进行有效评估非常重要,因为它:

- 有助于识别检索和生成流程中的优点和缺点。

- 指导整个 RAG 流程的改进和优化。

- 确保系统满足质量标准和用户期望。

- 便于比较不同 RAG 实现或配置。

- 帮助检测诸如幻觉(hallucinations)、偏见或无关响应等问题。

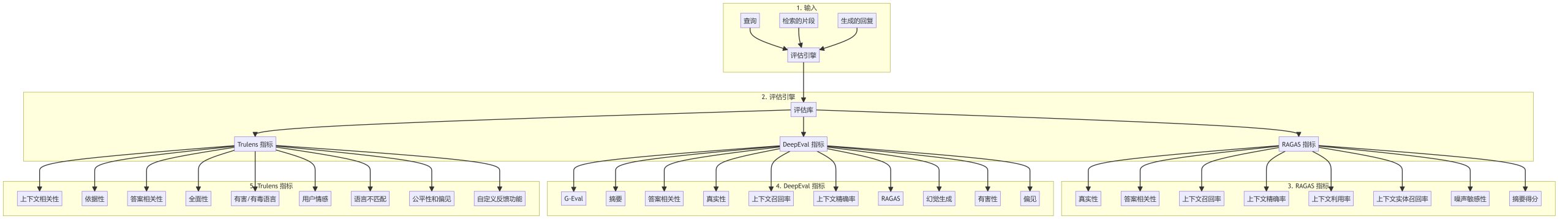

RAG 评估流程

RAG 系统的评估通常包括以下步骤:

核心评估指标

RAGAS 指标

- 真实性:衡量生成的响应与检索上下文的一致性。

- 答案相关性:评估响应与查询的相关性。

- 上下文召回率:评估检索的分块是否覆盖了回答查询所需的信息。

- 上下文精确度:衡量检索的分块中相关信息的比例。

- 上下文利用率:评估生成的响应对提供上下文的利用效率。

- 上下文实体召回:评估响应中是否涵盖上下文中的重要实体。

- 噪声敏感度:衡量系统对无关或噪声信息的鲁棒性。

- 摘要得分:评估响应中摘要的质量。

DeepEval 指标

- G-Eval:文本生成任务的通用评估指标。

- 摘要:评估文本摘要的质量。

- 答案相关性:衡量响应对查询的回答程度。

- 真实性:评估响应与源信息的准确性。

- 上下文召回和精确度:衡量上下文检索的有效性。

- 幻觉检测:识别响应中的虚假或不准确信息。

- 毒性:检测响应中可能存在的有害或冒犯内容。

- 偏见:识别生成内容中的不公平偏好或倾向。

Trulens 指标

- 上下文相关性:评估检索上下文与查询的匹配程度。

- 有依据性:衡量响应是否得到检索信息的支持。

- 答案相关性:评估响应对查询的解答质量。

- 全面性:衡量响应的完整程度。

- 有害/冒犯性语言:识别潜在的冒犯或危险内容。

- 用户情感:分析用户交互中的情感语气。

- 语言不匹配:检测查询和响应之间语言使用的不一致性。

- 公平性和偏见:评估系统对不同群体的公平对待。

- 自定义反馈函数:允许针对特定用例开发定制评估指标。

RAG 评估的最佳实践

- 全面评估:结合多种指标评估 RAG 系统的不同方面。

- 定期基准测试:在流程发生变化时持续评估系统。

- 人类参与:结合人工评估和自动指标进行全面分析。

- 领域特定指标:开发与具体用例或领域相关的定制指标。

- 错误分析:分析低分响应中的模式,识别改进领域。

- 对比评估:将您的 RAG 系统与基线模型和替代实现进行基准测试。

结论

一个健全的评估框架对于开发和维护高质量的 RAG 系统至关重要。通过利用多样化的指标并遵循最佳实践,开发人员可以确保其 RAG 系统提供准确、相关且可信的响应,同时持续提升性能。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...