因为访问量过大以及遭受网络攻击,DeepSeek官网和APP这几天时好时坏,API也没法用。

此前我们已分享了本地部署DeepSeek-R1的方法(参见DeepSeek-R1本地部署),但普通用户限于硬件配置,连70b模型也很难跑起来,更别说671b的全量模型了。

幸好各大平台都接入了DeepSeek-R1,大家可以尝试作为平替。

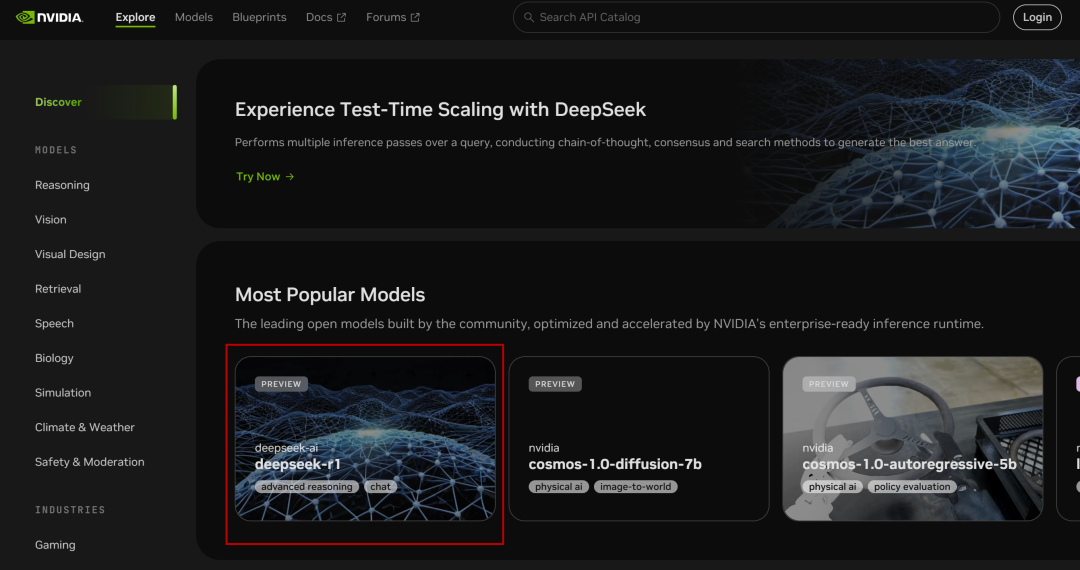

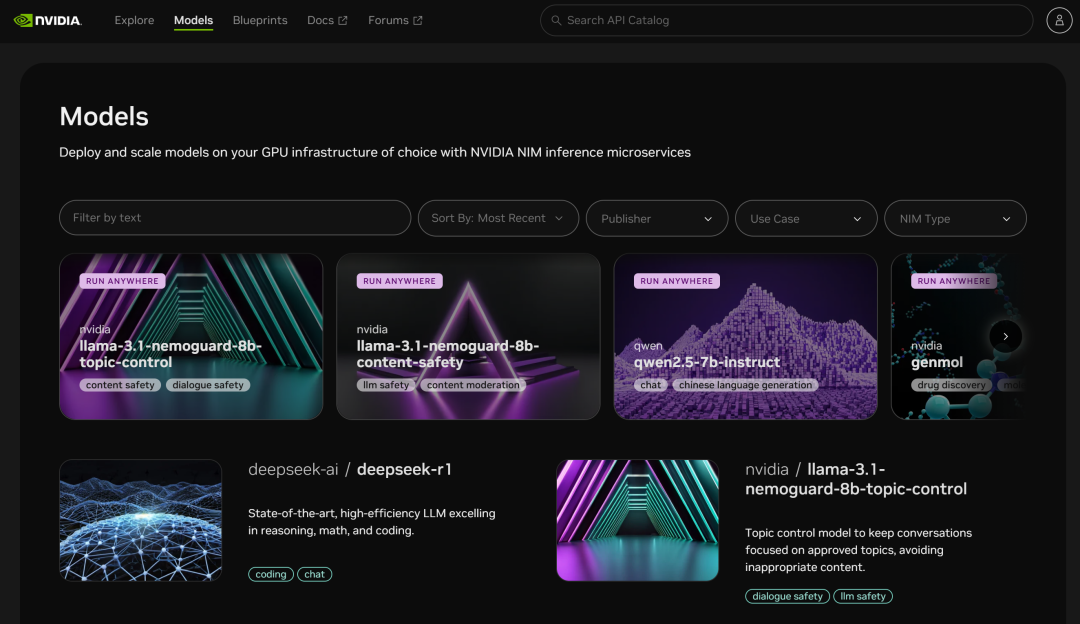

一、英伟达NIM微服务

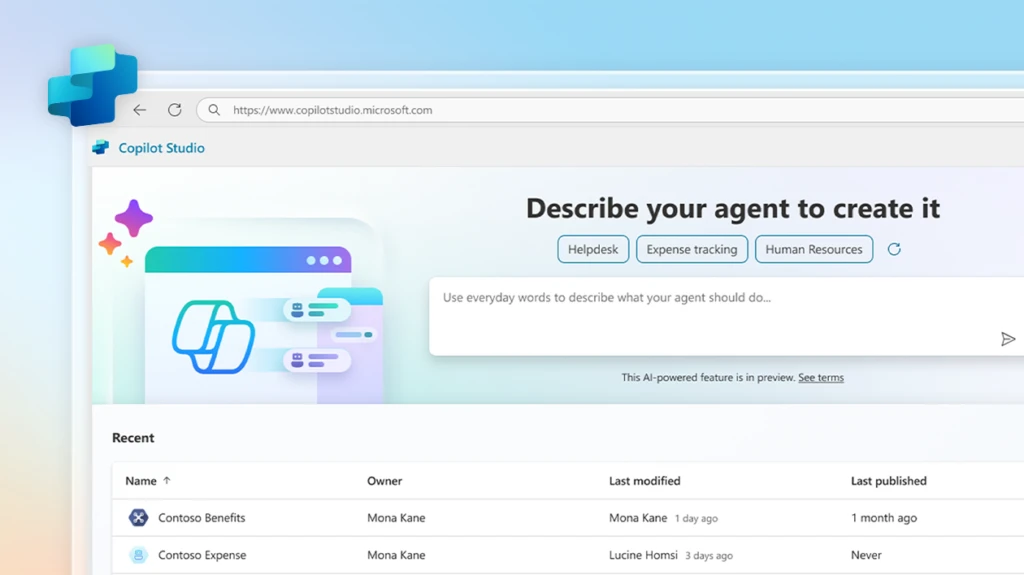

NVIDIA Build:集成多种AI模型并免费体验

网址:https://build.nvidia.com/deepseek-ai/deepseek-r1

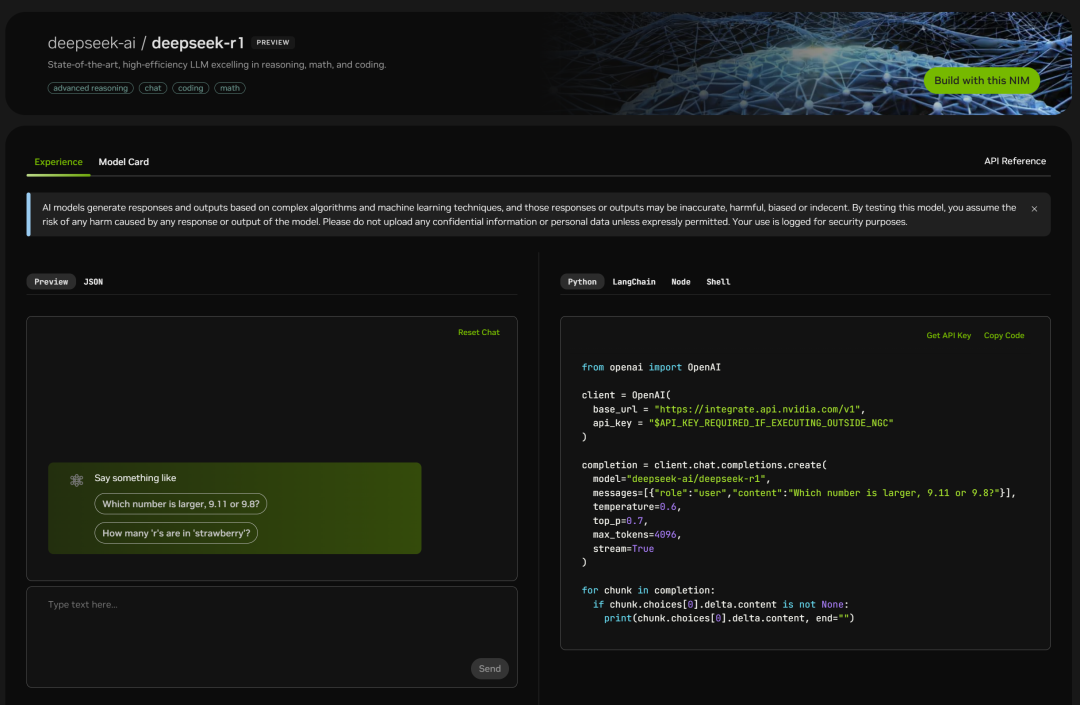

英伟达部署了全量参数671B的 DeepSeek-R1 模型,网页版直接使用,点进去就能看到聊天窗口:

同时右侧也列出了代码页:

简单测试一下:

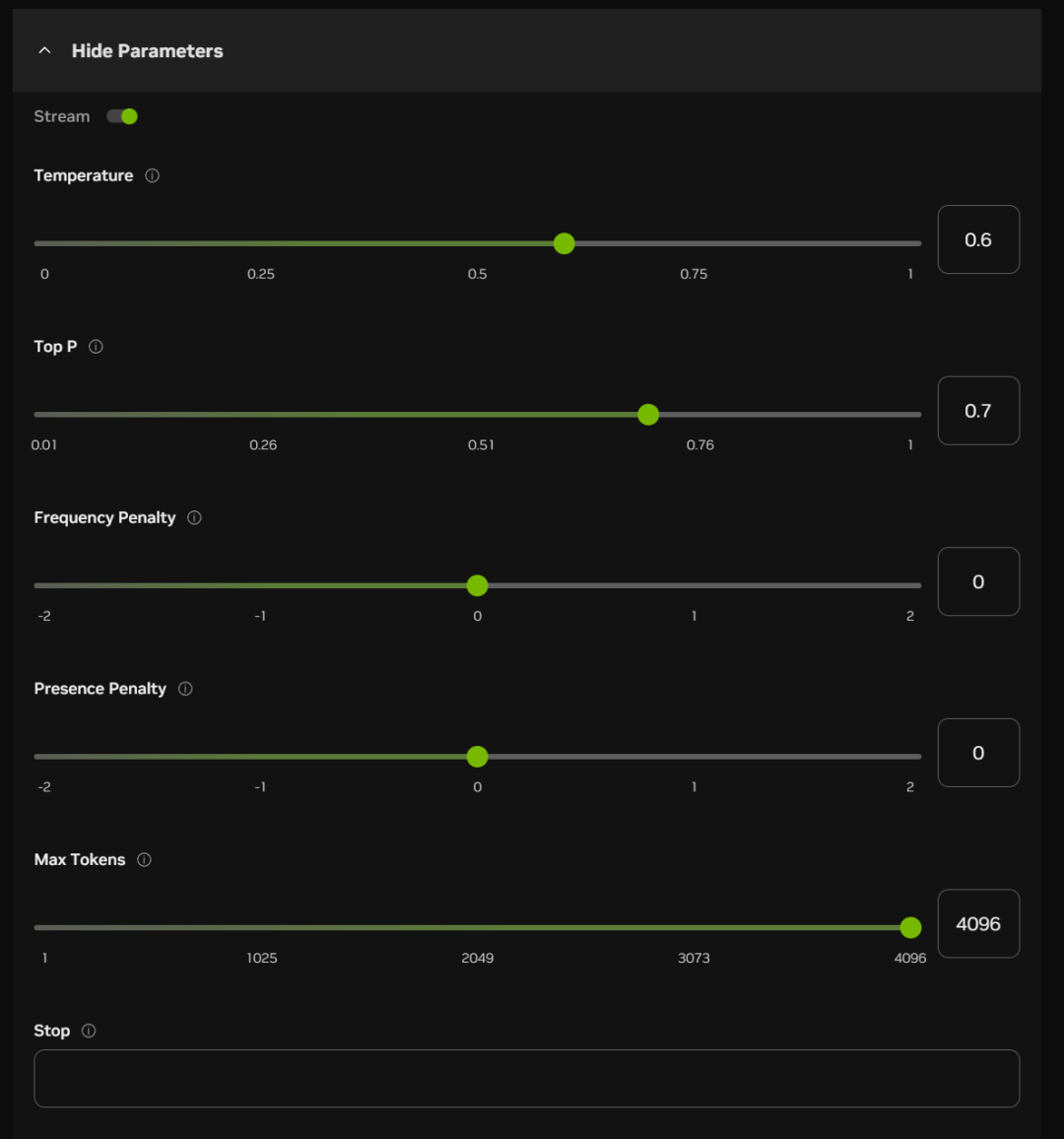

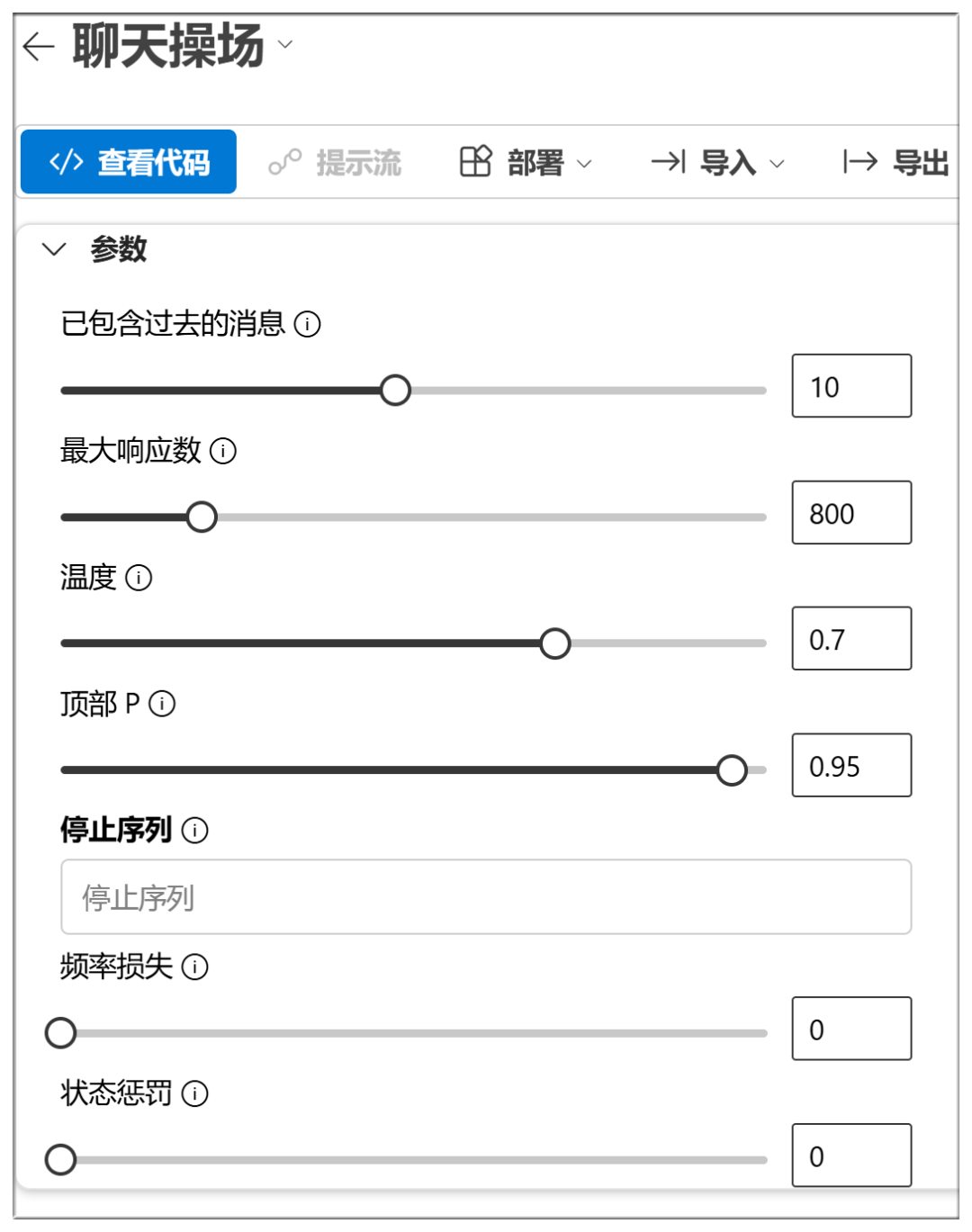

聊天框下方,还可以开启一些参数项(多数情况下可默认):

这些选项的大概意思和功能如下:

Temperature(温度):

数值越高,输出更随机,可能生成更具创造性的回答

Top P(核采样):

数值越高,保留更多概率质量的token,生成更具多样性

Frequency Penalty(词频惩罚):

数值越高,越多地惩罚高频词,减少啰嗦或重复

Presence Penalty(出现惩罚):

数值越高,越倾向于让模型尝试新词

Max Tokens(最大生成长度):

数值越高,回答潜在的篇幅越长

Stop(停止条件):

生成到某些特定字符或序列时,停止输出,防止生成过长或跑题

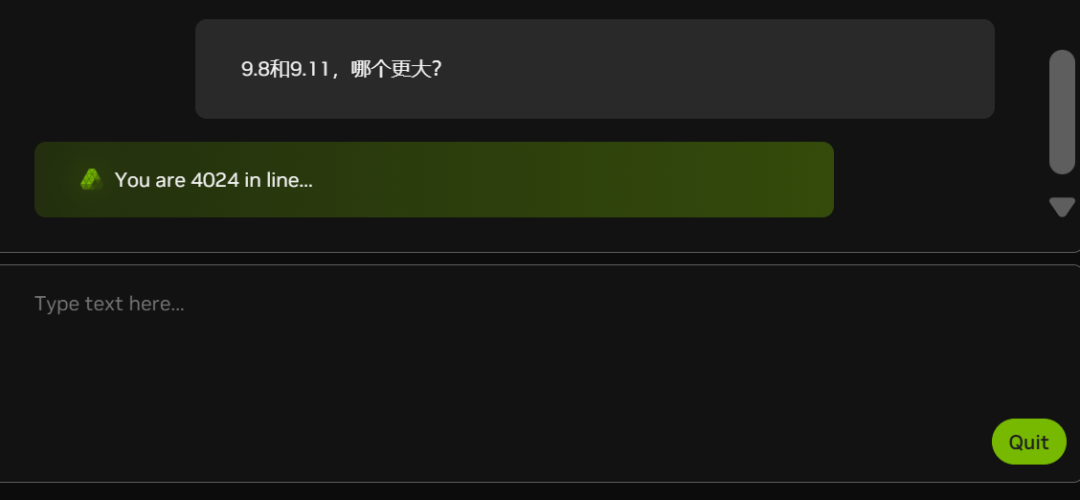

目前,由于白嫖的人越来越多(看下图的排队人数),NIM部分时段会出现卡顿:

难道英伟达也缺显卡?

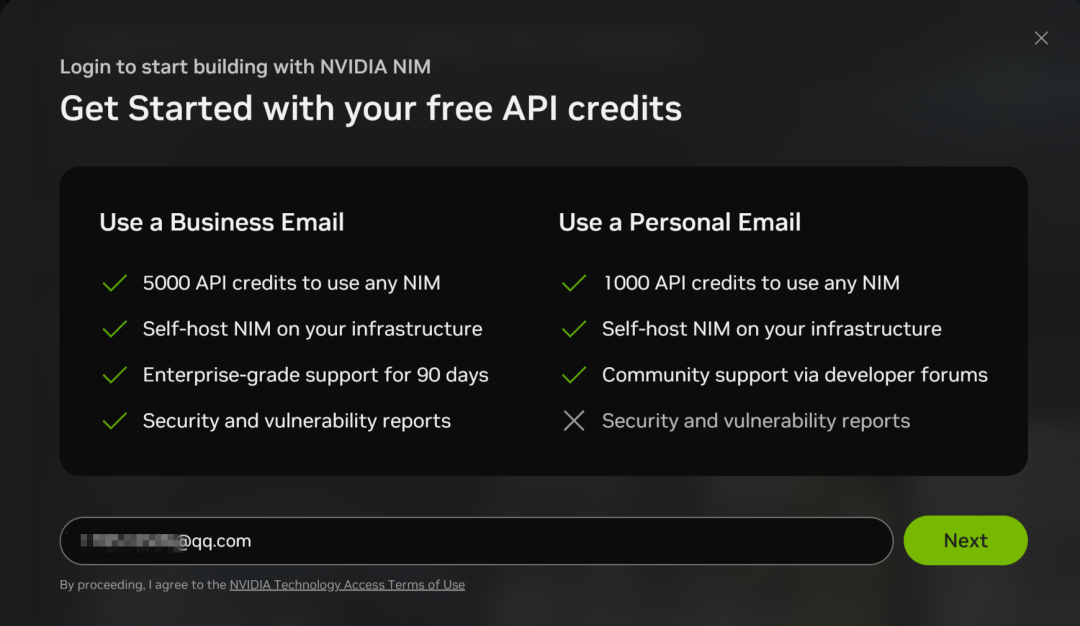

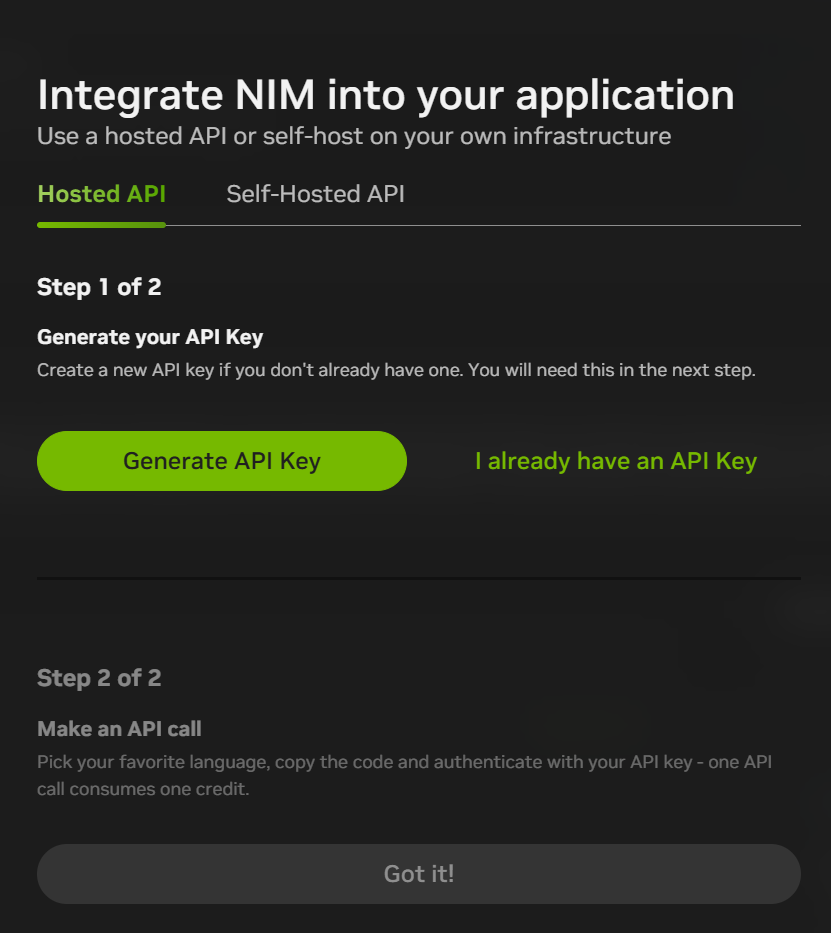

NIM微服务还支持API调用DeepSeek-R1,但你需要用邮箱注册账号:

注册过程比较简单,只用邮箱验证:

注册好之后,可以点击聊天界面右上方的“Build with this NIM”生成API KEY,目前注册就送1000点数(互动1000次),白嫖党可以用完再换个新邮箱再注册。

NIM微服务平台也提供其他许多模型的使用:

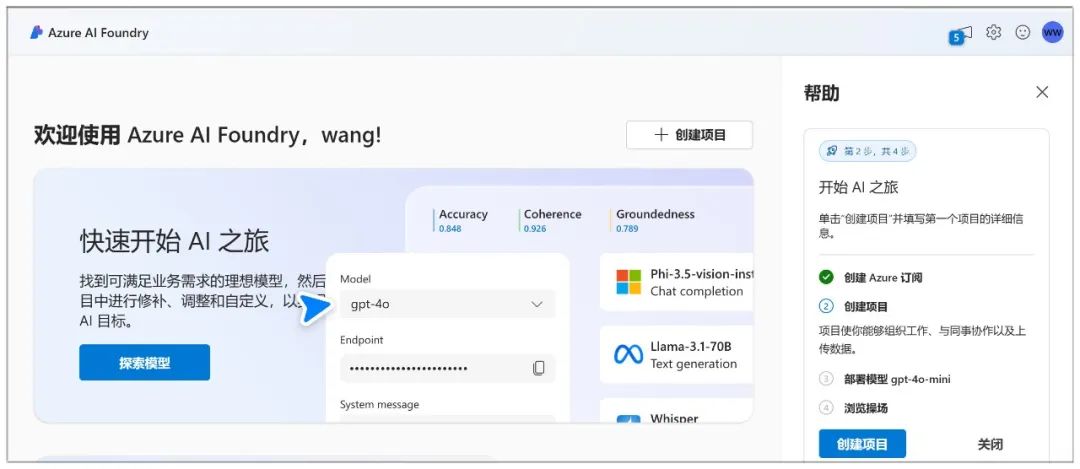

二、微软Azure

网址:

https://ai.azure.com

微软Azure可以通过聊天操场,创建一个聊天机器人,并与模型交互。

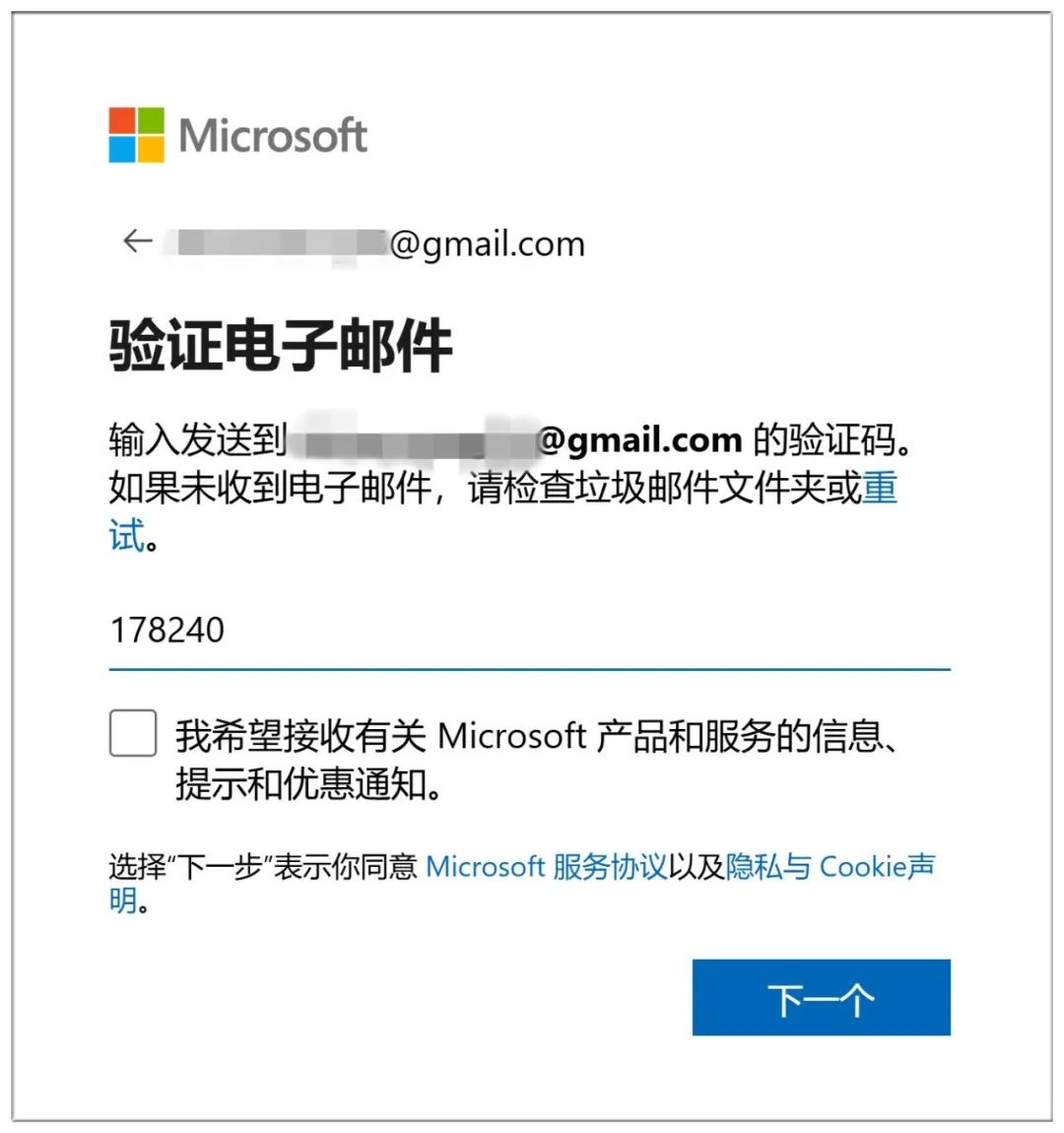

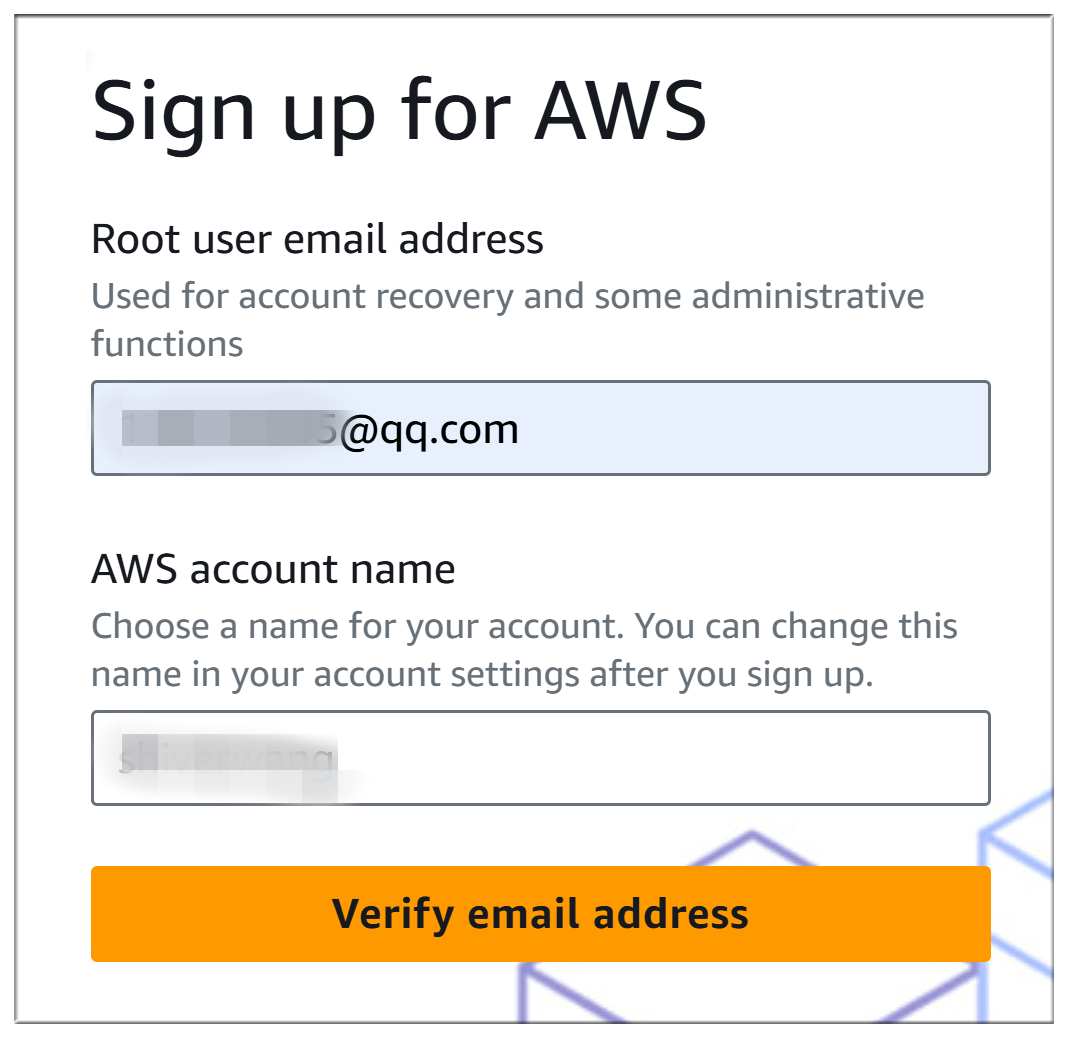

Azure的注册麻烦许多,首先你要创建一个微软账户(如果已经有了就直接登录):

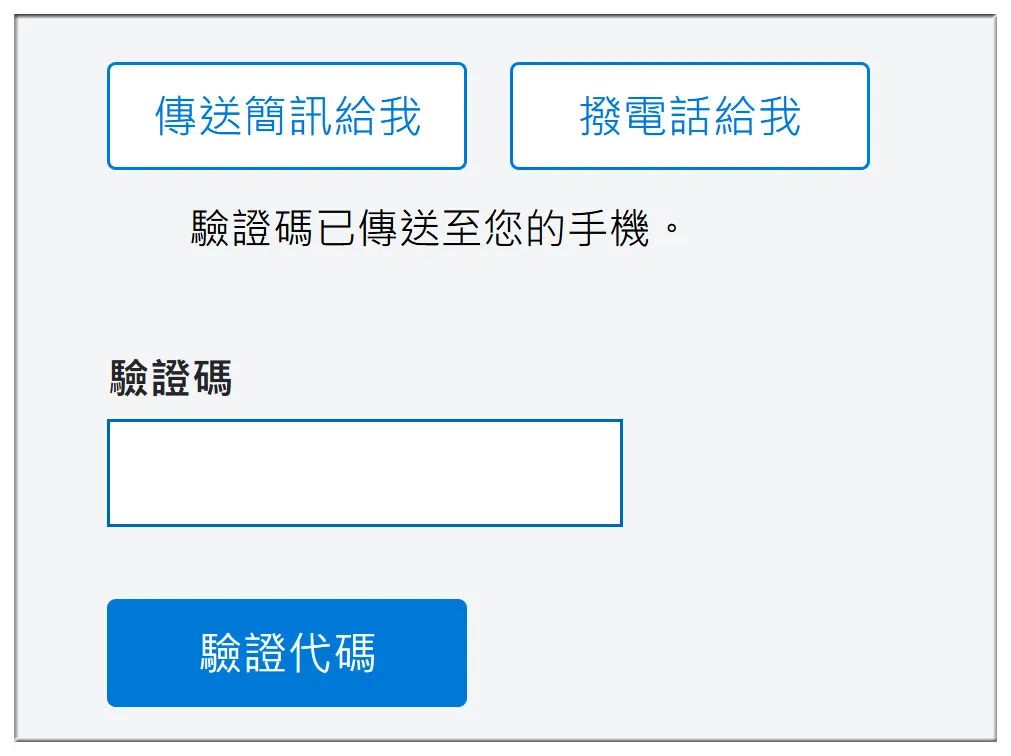

创建账户也需要邮箱验证:

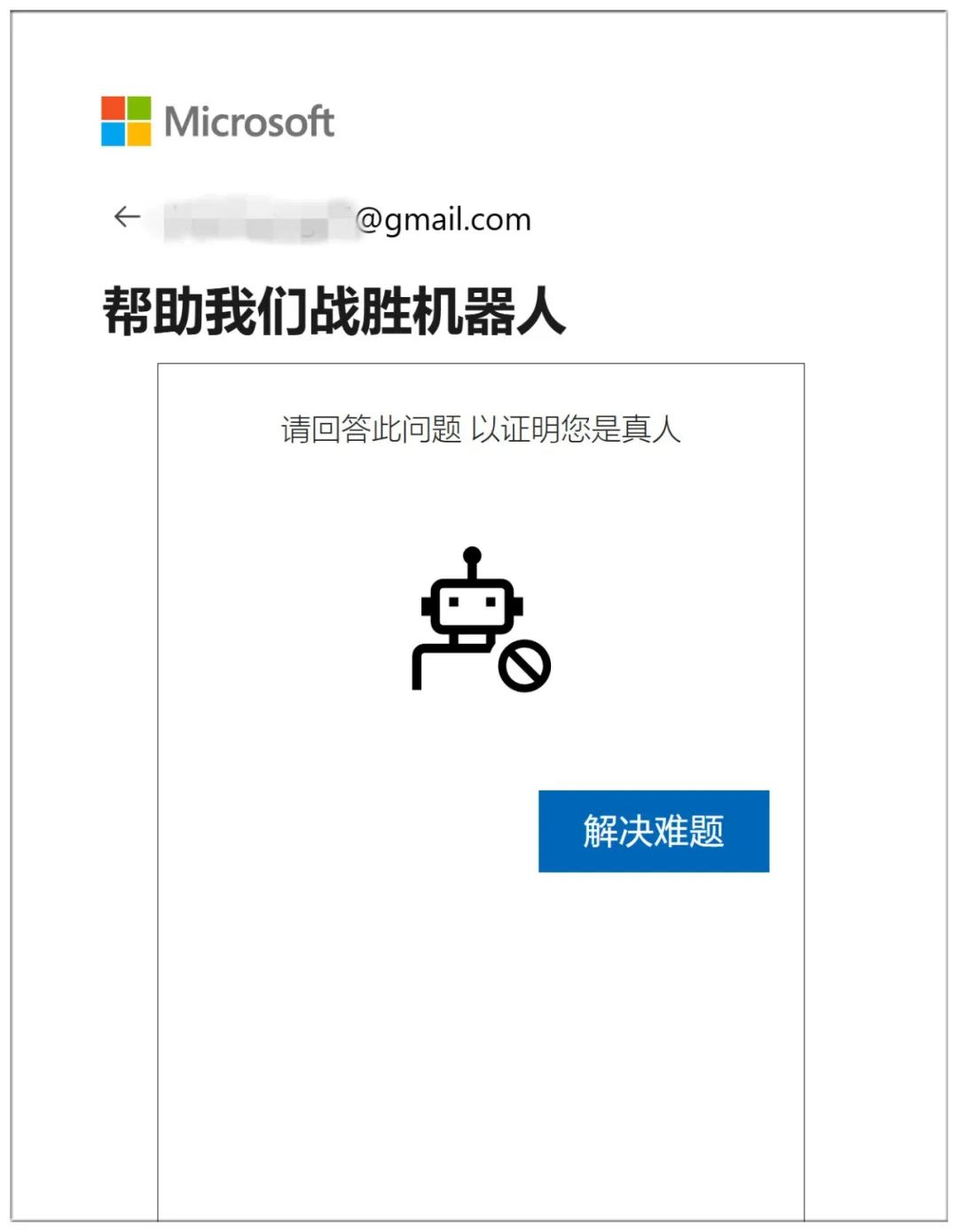

完了要证明自己是人类,连续回答10道阴间问题:

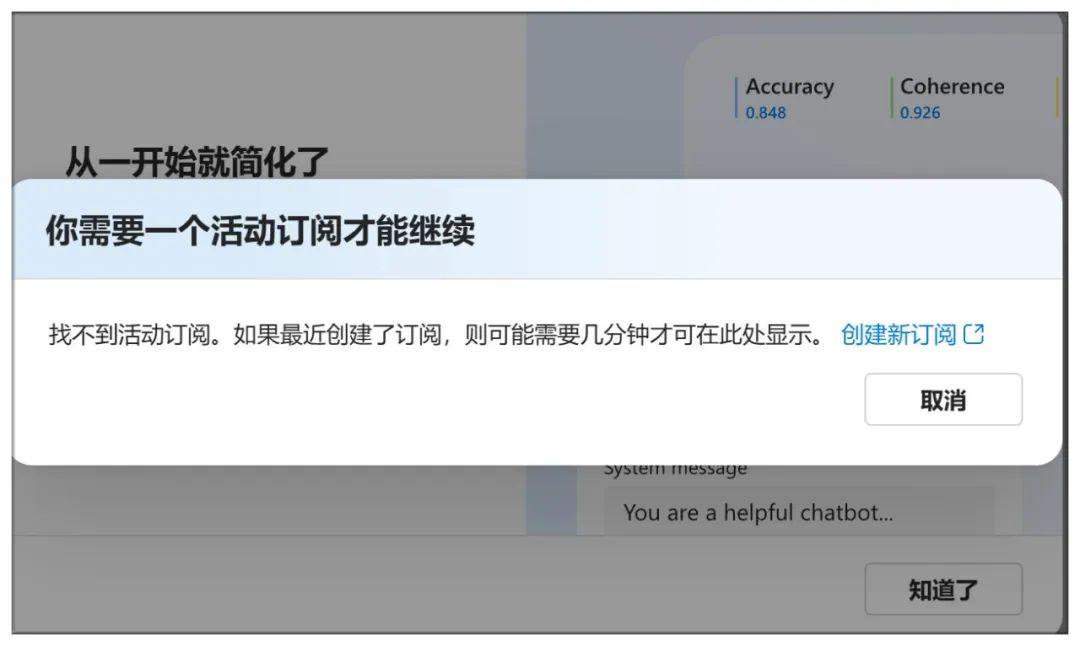

到这里还不够,还得创建订阅:

验证手机号码以及银行账号等信息:

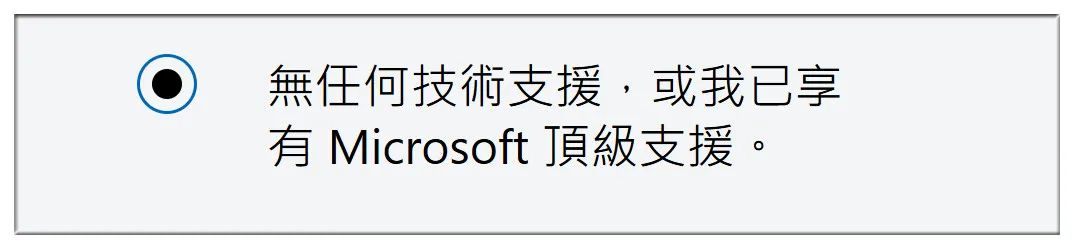

接下来选择“无任何技术支援”:

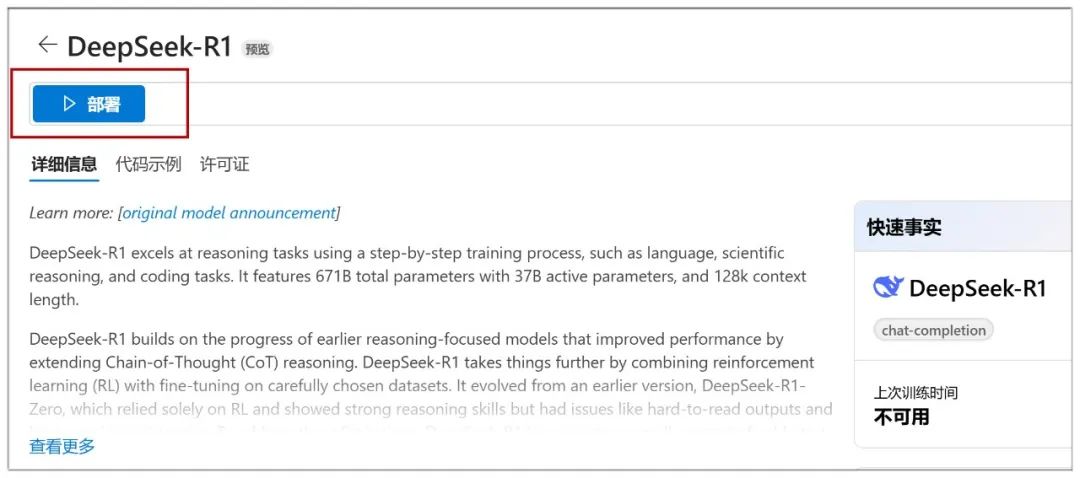

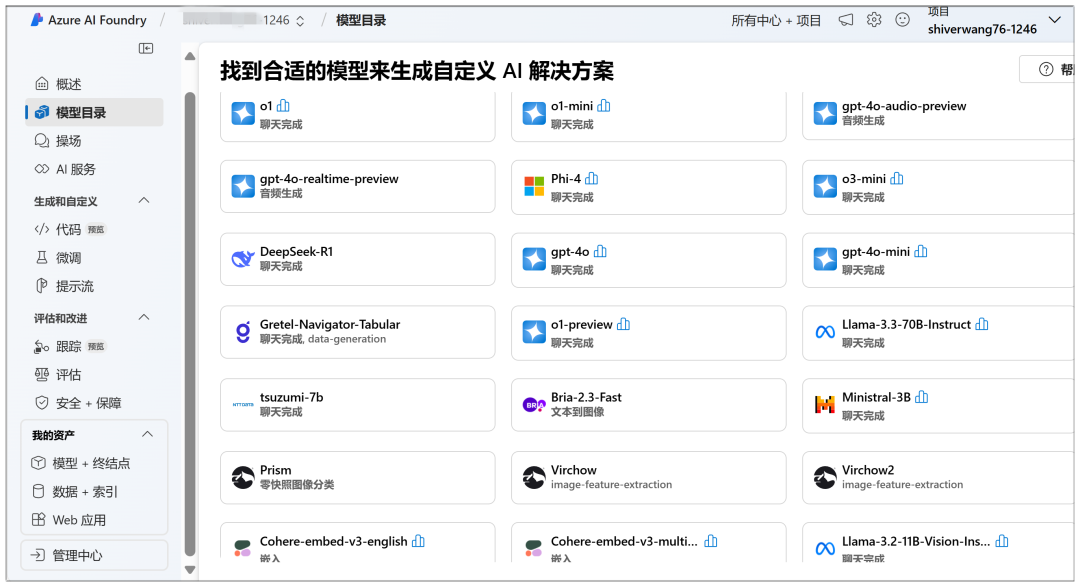

到这里就可以开始云部署了,在“模型目录”可以看到显眼的DeepSeek-R1模型:

点击之后,在下一个页面点击“部署”:

接下来要选择“创建新项目”:

然后全部默认,点击“下一个”:

接下来点击“创建”:

在这个页面下创建就开始了,需要等待一段时间:

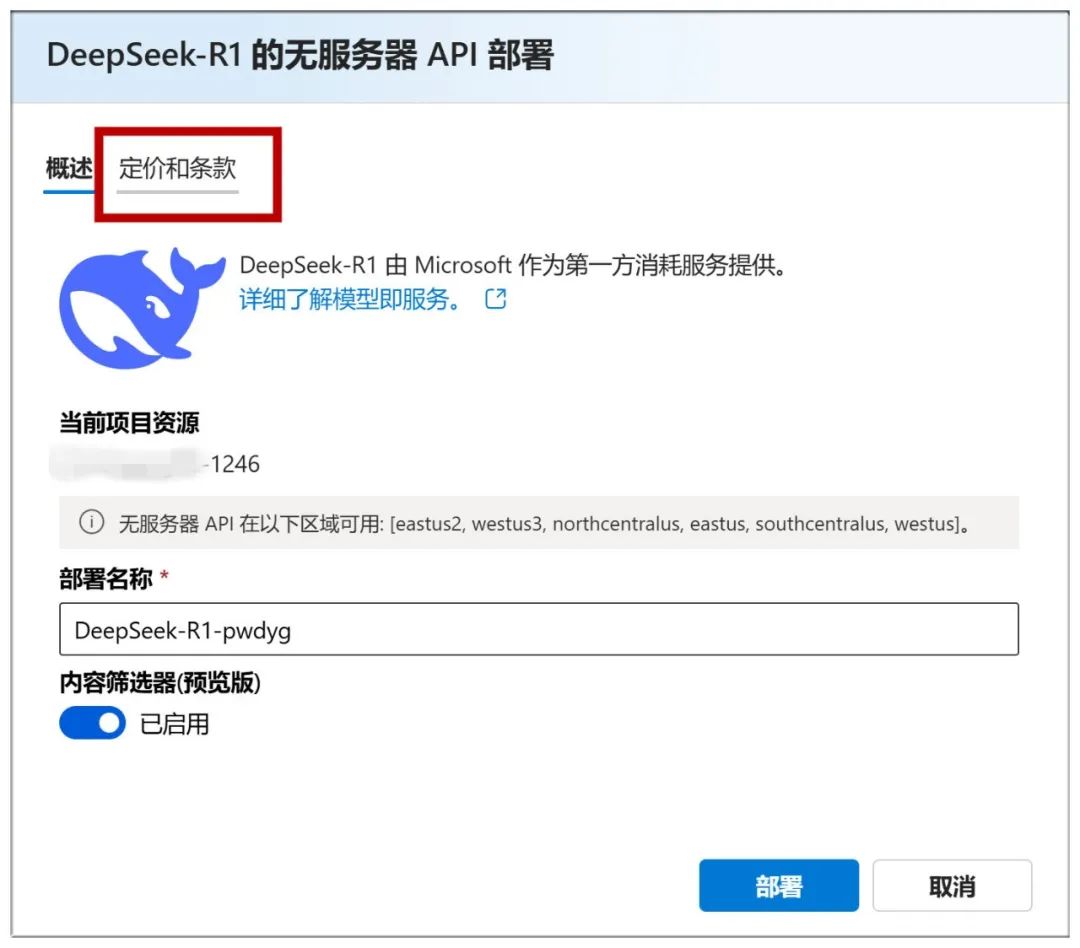

完成后来到这个页面,你可以点击“部署”,进入下一步:

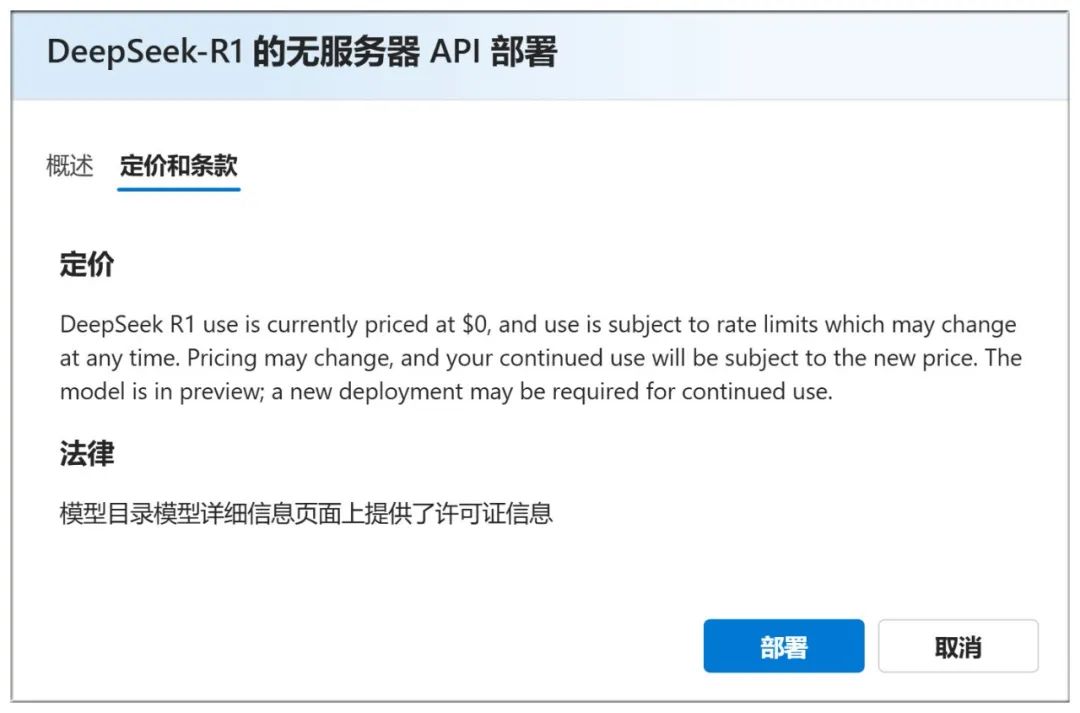

也可以查看上方面的“定价和条款”,可以看到是免费使用:

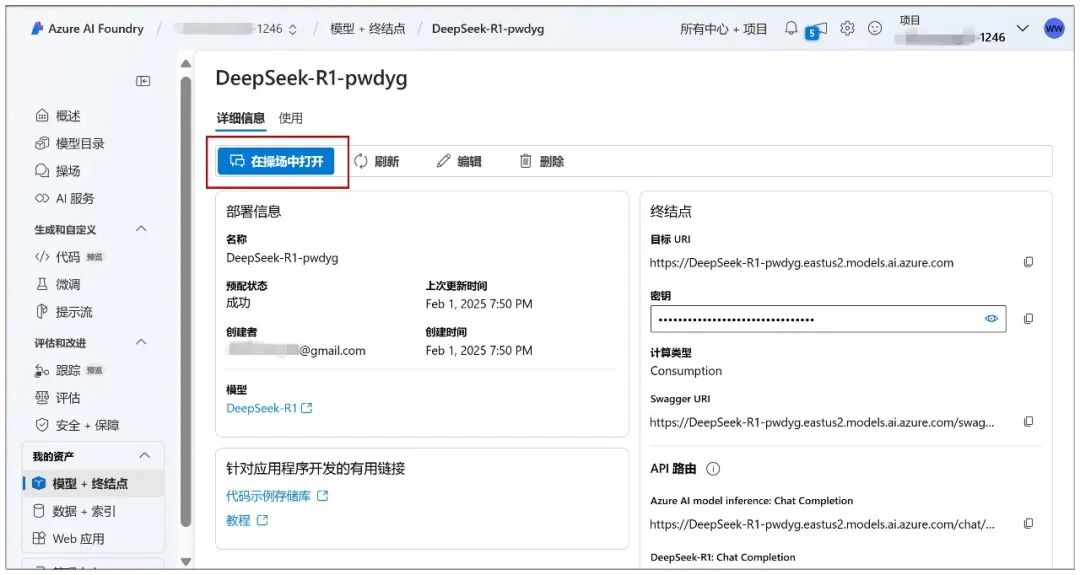

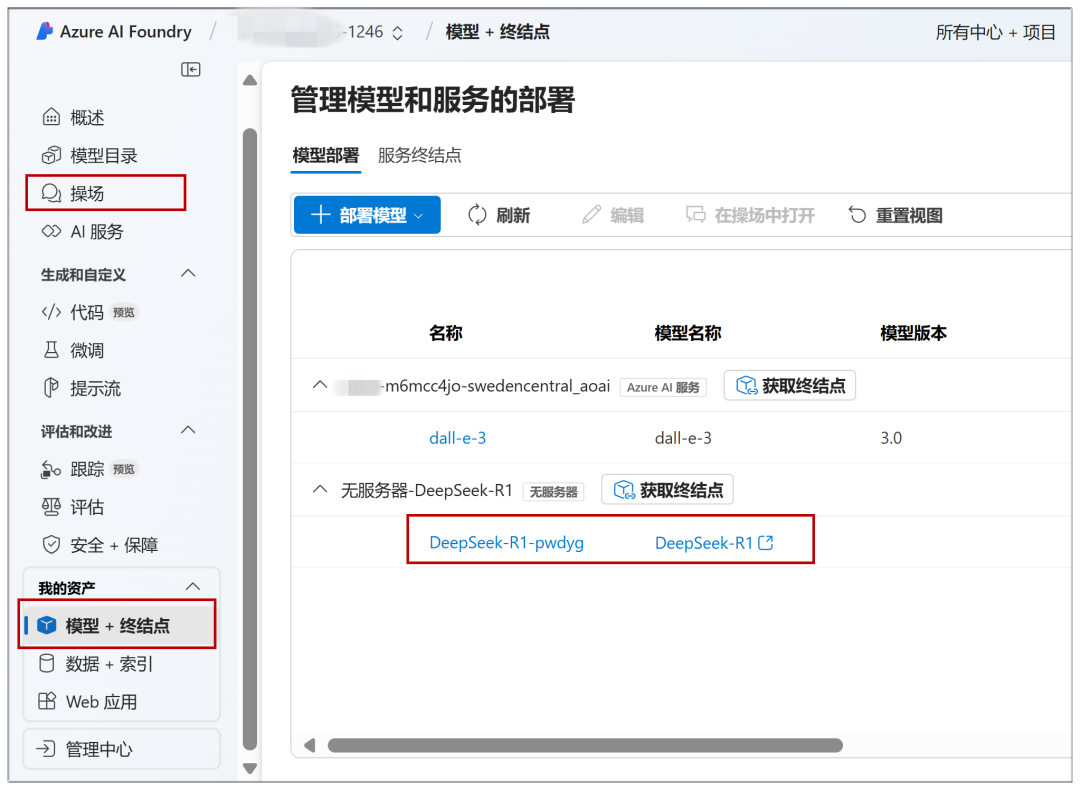

继续点击“部署”进入这个页面,可以点击“在操场中打开”:

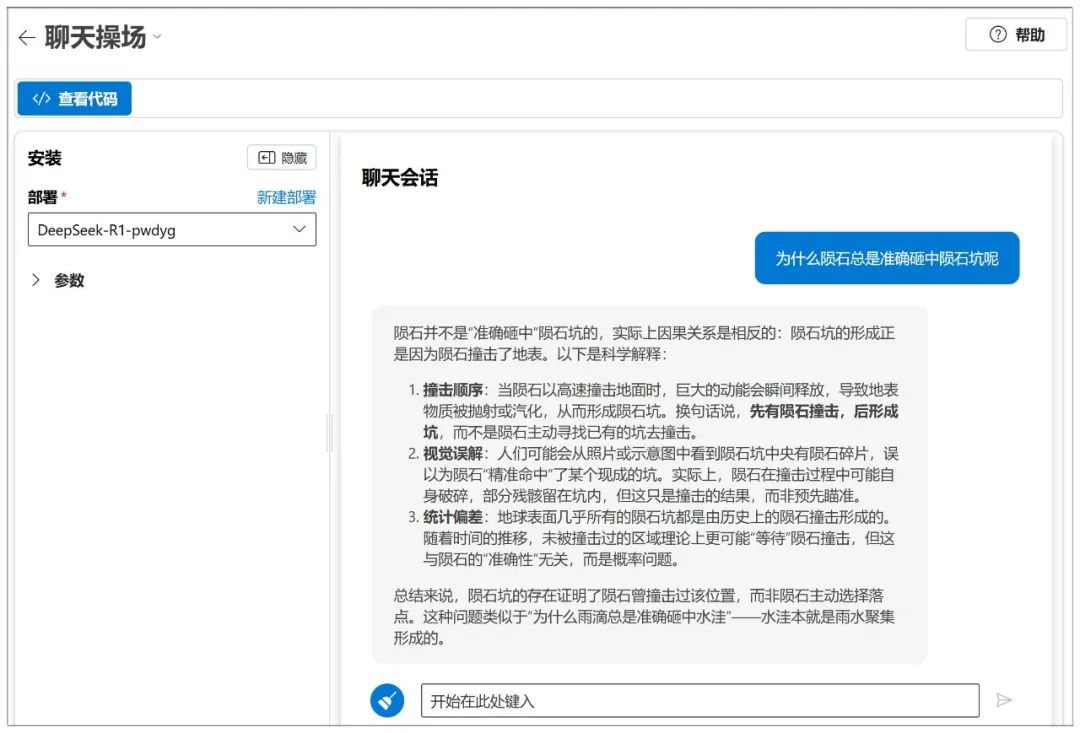

然后就可以开始对话:

Azure也有类似NIM的参数调节可选:

作为平台,有许多模型可以部署:

对于已经部署的模型,今后通过左边菜单的“操场”或“模型+终结点”就可以快速访问:

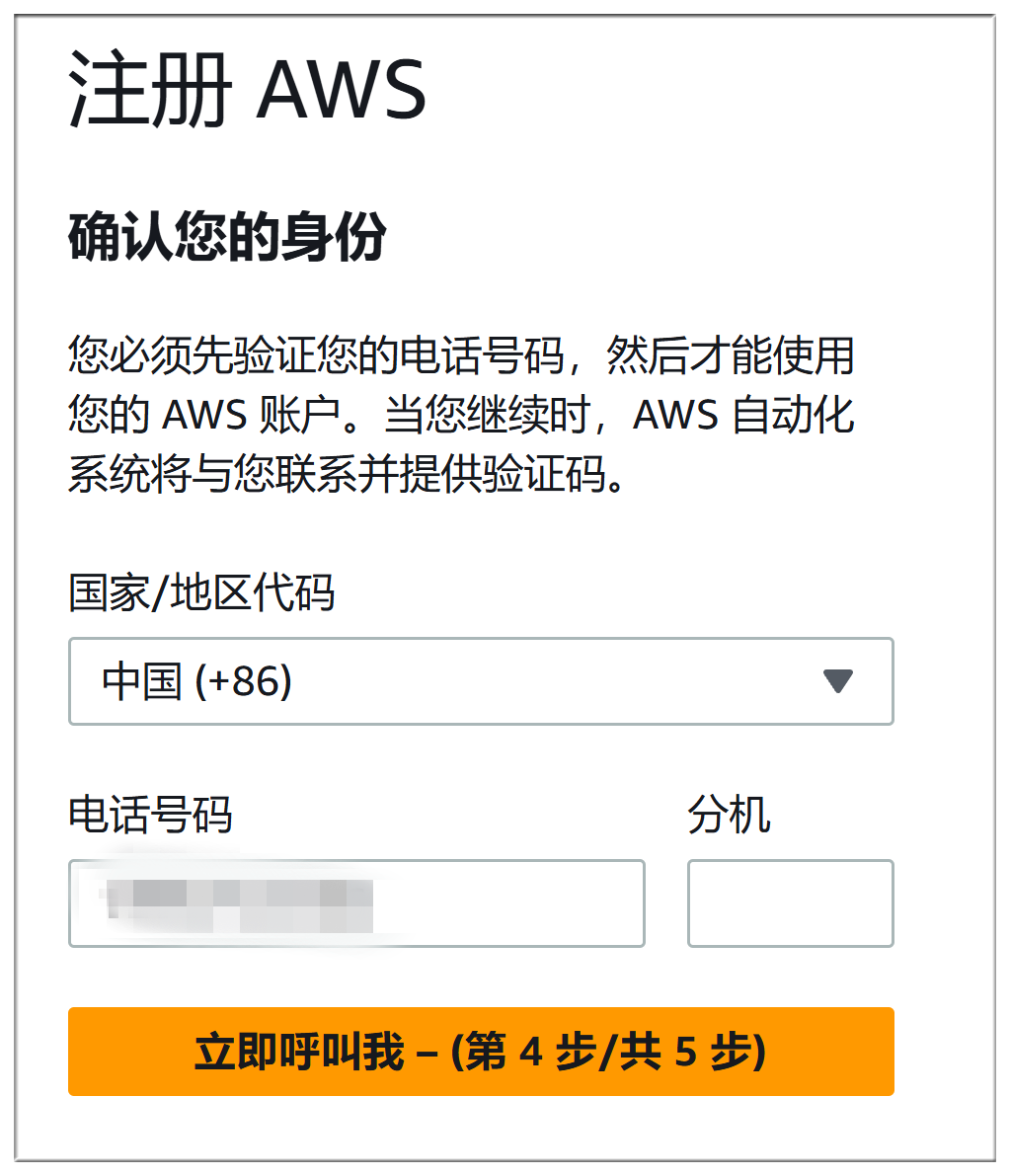

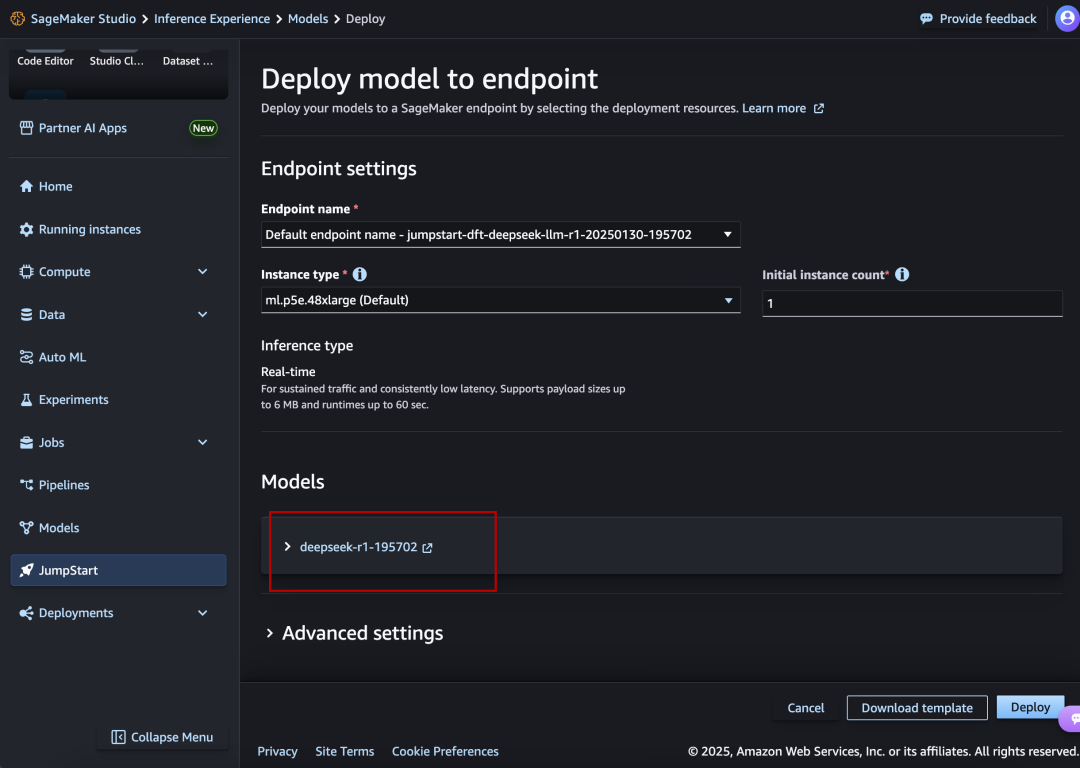

三、亚马逊AWS

网址:

https://aws.amazon.com/cn/blogs/aws/deepseek-r1-models-now-available-on-aws

DeepSeek-R1同样在显眼位置,排面。

亚马逊AWS注册过程和微软Azure差不多麻烦,都要填写付款方式,还要电话验证+语音验证,这里就不再详细描述:

具体部署过程和微软Azure也是大同小异:

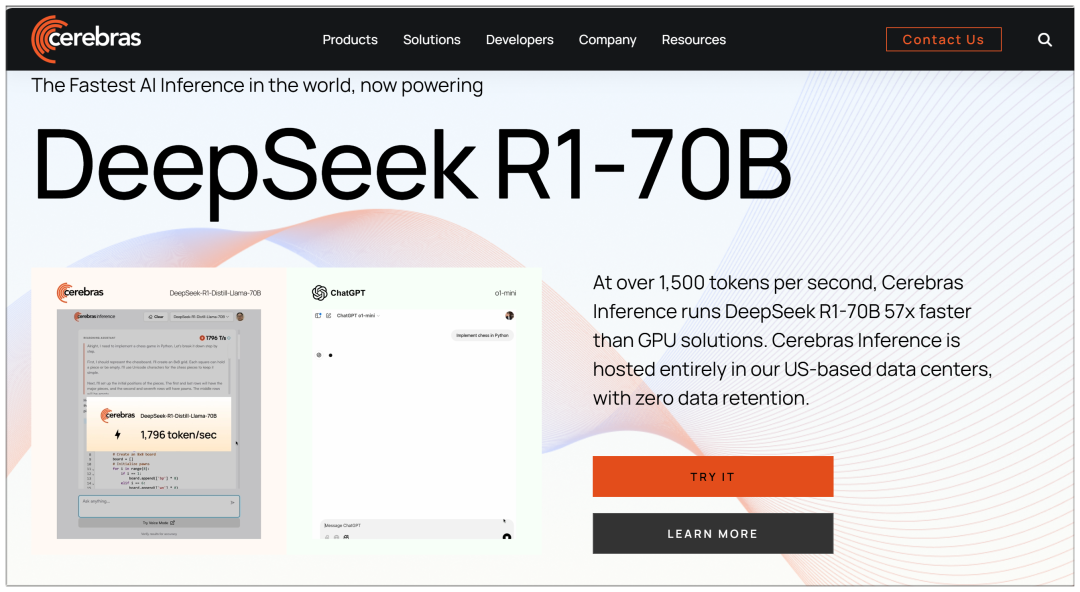

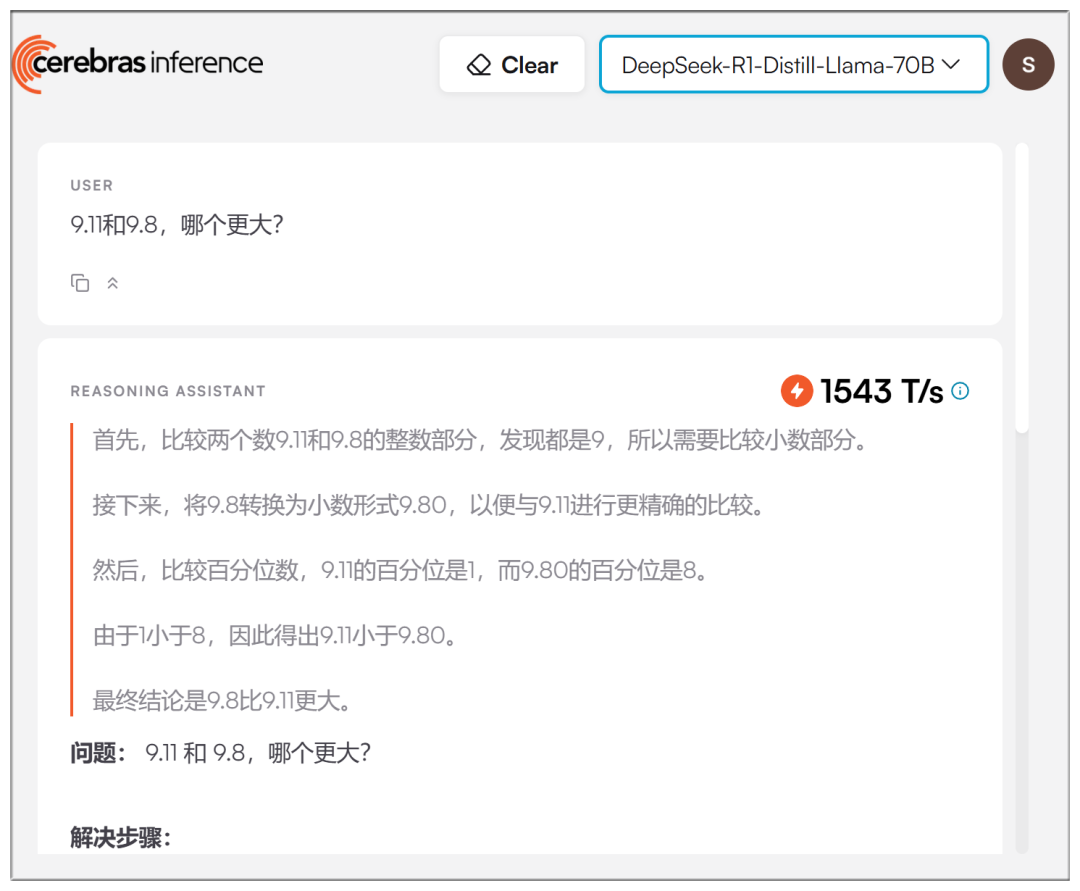

四、Cerebras

Cerebras:目前全球最快的AI推理、高性能计算平台

网址:https://cerebras.ai

和几家大型平台不同,Cerebras使用的是70b模型,宣称“比GPU方案快57倍”:

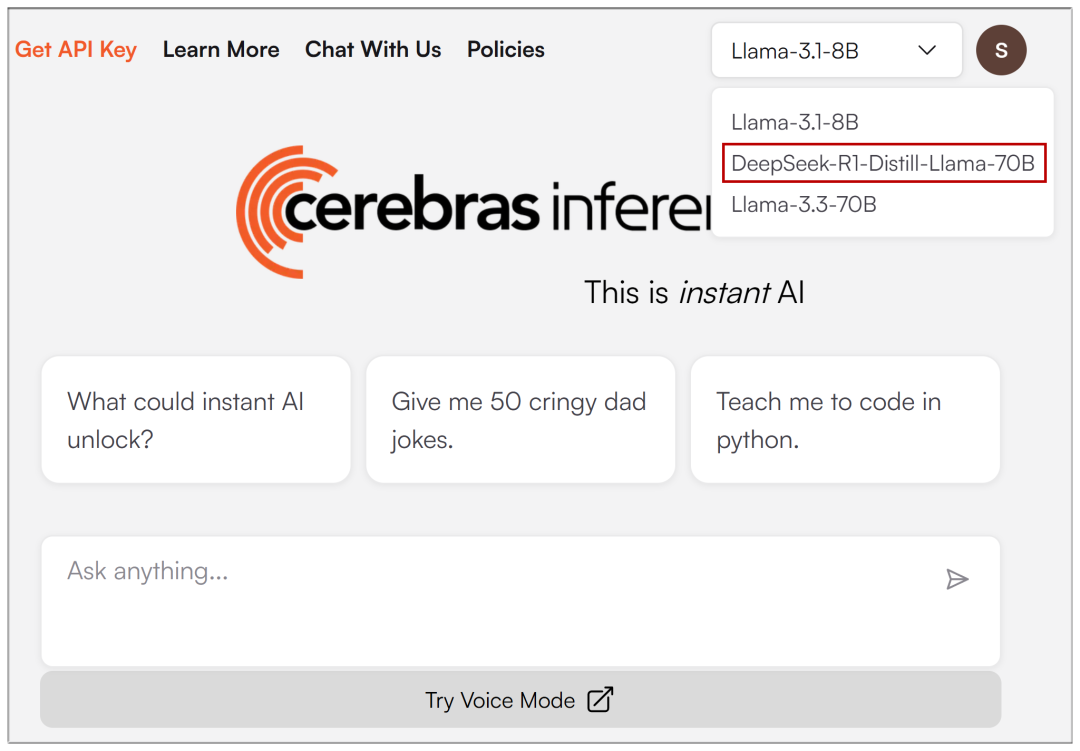

邮箱注册进入后,上方的下拉菜单可以选择DeepSeek-R1:

实测速度确实比较快,虽然没有宣称的夸张:

五、Groq

Groq:AI大模型推理加速解决方案提供商,高速免费大模型接口

网址:https://groq.com/groqcloud-makes-deepseek-r1-distill-llama-70b-available

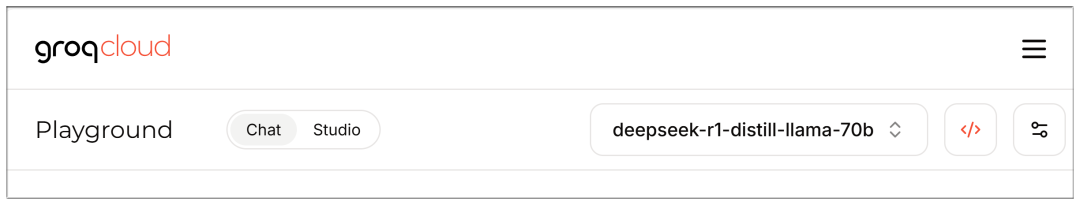

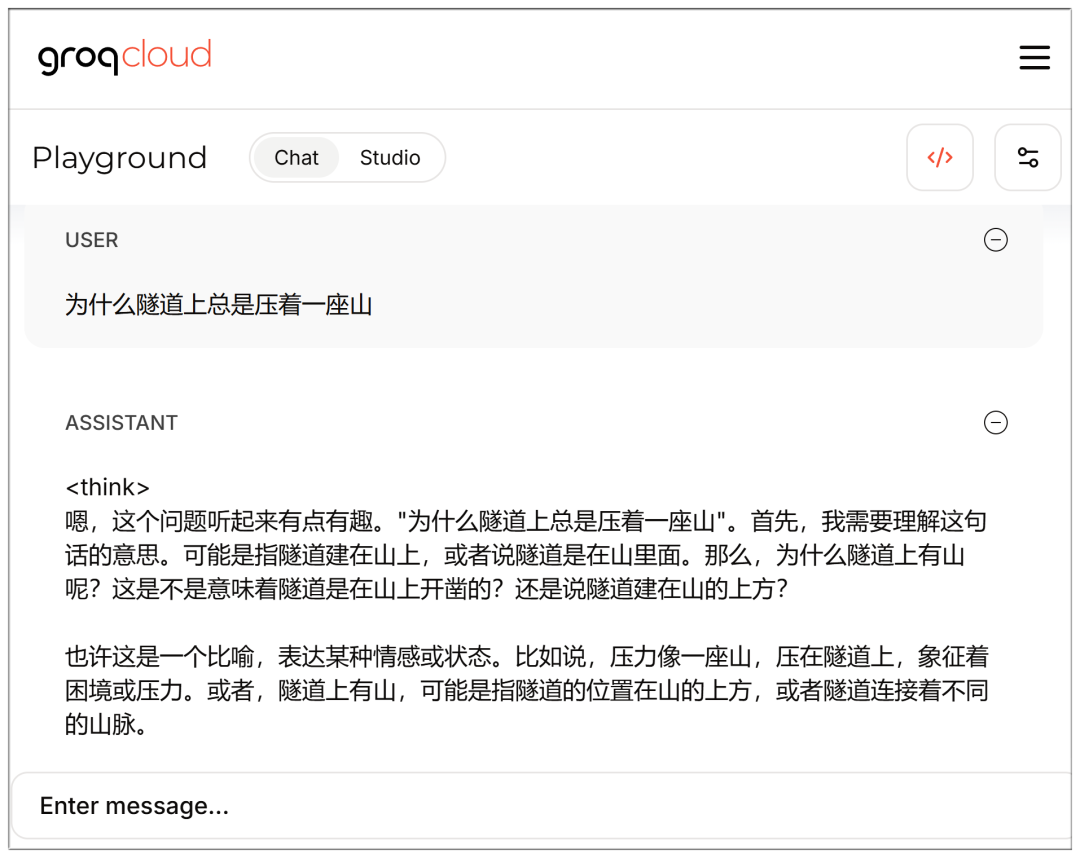

邮箱注册进入后,也是可以选择模型:

速度也很快,但同样是70b,感觉比Cerebras的要弱智一点?

注意,登录状态下可以直接访问聊天界面:

https://console.groq.com/playground?model=deepseek-r1-distill-llama-70b

完整 DeepSeek V3 和 R1 列表:

AMD

AMD Instinct™ GPUs Power DeepSeek-V3: Revolutionizing AI Development with SGLang (AMD Instinct™ GPU 为 DeepSeek-V3 提供动力:利用 SGLang 革新 AI 开发)

NVIDIA

DeepSeek-R1 NVIDIA model card (DeepSeek-R1 NVIDIA 模型卡)

Microsoft Azure

Running DeepSeek-R1 on a single NDv5 MI300X VM (在单个 NDv5 MI300X VM 上运行 DeepSeek-R1)

Baseten

https://www.baseten.co/library/deepseek-v3/

Novita AI

Novita AI uses SGLang running DeepSeek-V3 for OpenRouter (Novita AI 使用 SGLang 运行 DeepSeek-V3 用于 OpenRouter)

ByteDance Volcengine

DataCrunch

Deploy DeepSeek-R1 671B on 8x NVIDIA H200 with SGLang (使用 SGLang 在 8x NVIDIA H200 上部署 DeepSeek-R1 671B)

Hyperbolic

https://x.com/zjasper666/status/1872657228676895185

Vultr

How to Deploy Deepseek V3 Large Language Model (LLM) Using SGLang (如何使用 SGLang 部署 Deepseek V3 大语言模型 (LLM))

RunPod

What's New for Serverless LLM Usage in RunPod in 2025? (2025 年 RunPod 中 Serverless LLM 使用的新功能是什么?)

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...