综合介绍

Together AI 是一个专注于生成式AI模型的平台,提供从模型训练、微调到推理的全方位服务。用户可以利用Together AI的高效推理引擎和GPU集群,快速部署和运行各种开源模型。平台支持多种模型架构,满足不同的AI应用需求。

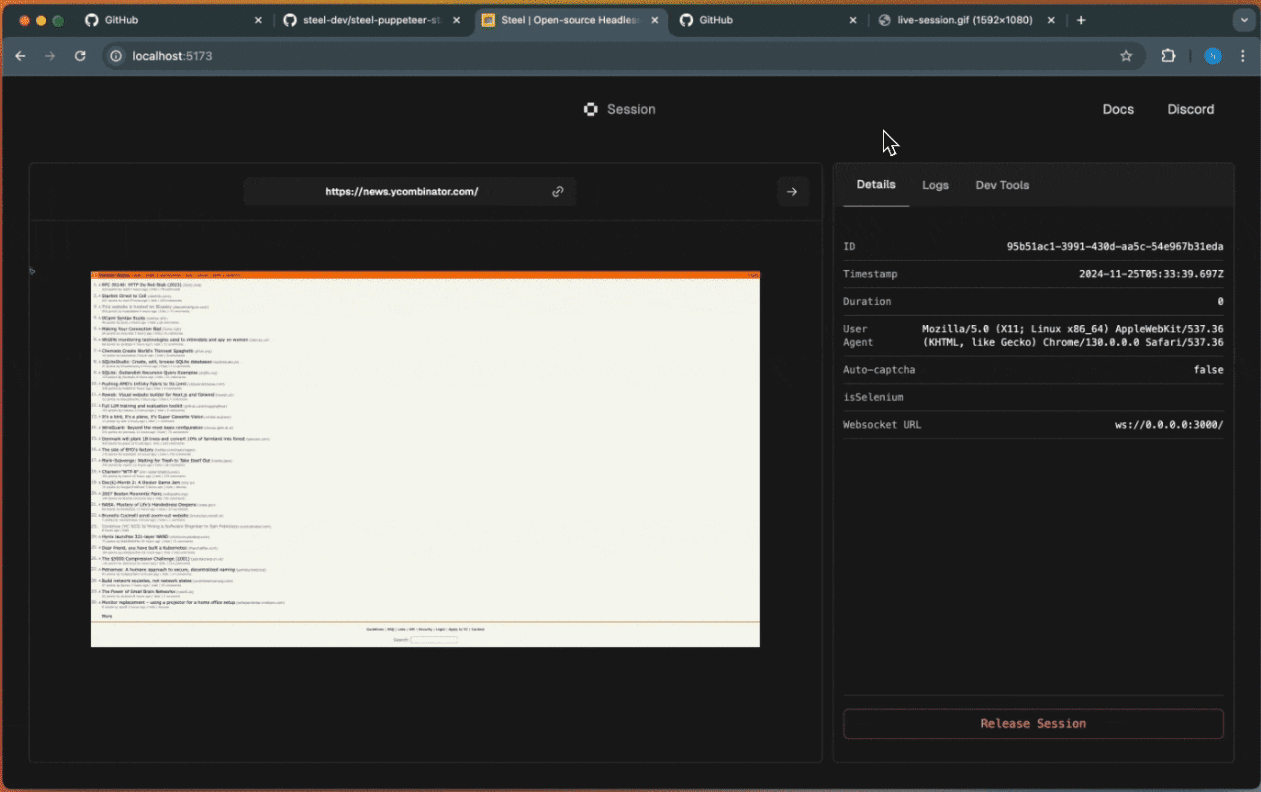

大模型聊天演示界面

功能列表

- 推理API:支持100多个开源模型的推理,提供无服务器和专用实例两种模式。

- 微调功能:允许用户使用自己的数据对生成式AI模型进行微调,保持数据所有权。

- GPU集群:提供16到1000+ GPU的前沿集群,支持大规模模型训练。

- 自定义模型训练:从头开始训练前沿模型,支持多种模型架构。

- 多模态模型:支持图像识别、图像推理、图像生成等功能。

- 高效推理引擎:集成FlashAttention-3和Flash-Decoding等最新推理技术,提供快速、准确的推理服务。

使用帮助

安装与使用

- 注册与登录:

- 访问Together AI官网(https://www.together.ai/),点击“开始构建”按钮,进行注册。

- 注册完成后,登录账户,进入用户控制面板。

- 选择服务:

- 在控制面板中,选择需要使用的服务模块,如推理API、微调功能或GPU集群。

- 根据需求选择无服务器或专用实例模式。

- 推理API使用:

- 选择需要运行的开源模型,如Llama-3、RedPajama等。

- 通过Together AI提供的API接口,将模型集成到您的应用中。

- 使用Together AI的嵌入端点,构建自己的RAG应用。

- 微调功能:

- 上传您的数据集,选择需要微调的模型。

- 配置微调参数,开始微调过程。

- 微调完成后,下载微调后的模型,进行部署。

- GPU集群使用:

- 选择所需的GPU集群规模,配置硬件参数。

- 上传训练数据和模型代码,开始训练。

- 训练完成后,下载训练好的模型,进行推理或进一步微调。

- 自定义模型训练:

- 选择自定义模型训练模块,配置模型架构和训练参数。

- 上传数据集,开始训练过程。

- 训练完成后,下载模型,进行部署和推理。

操作流程

- 访问控制面板:登录后,进入控制面板,选择需要的服务模块。

- 配置参数:根据需求配置推理、微调或训练参数。

- 上传数据:上传所需的数据集或模型代码。

- 开始任务:启动推理、微调或训练任务,实时监控任务进度。

- 下载结果:任务完成后,下载模型或推理结果,进行应用集成。

常见问题

- 如何选择合适的模型?

- 根据应用场景选择合适的开源模型,如文本生成、图像识别等。

- 微调过程中遇到错误怎么办?

- 检查数据集格式和参数配置,参考官方文档进行调整。

- GPU集群使用过程中性能不佳?

- 确认硬件配置是否满足需求,调整训练参数,提高效率。

可用模型

| Serverless Endpoints | Author | Type | Pricing (per 1M tokens) | |

|---|---|---|---|---|

| Meta Llama 3.2 11B Vision Instruct Turbo | ||||

| Meta | chat | $0.18 | ||

| Meta Llama 3.2 90B Vision Instruct Turbo | ||||

| Meta | chat | $1.20 | ||

| Qwen2.5 7B Instruct Turbo | ||||

| Qwen | chat | $0.30 | ||

| Qwen2.5 72B Instruct Turbo | ||||

| Qwen | chat | $1.20 | ||

| FLUX.1 [schnell] | ||||

| Black Forest Labs | image | See pricing | ||

| FLUX1.1 [pro] | ||||

| Black Forest Labs | image | See pricing | ||

| FLUX.1 [pro] | ||||

| Black Forest Labs | image | See pricing | ||

| FLUX.1 [schnell] Free | ||||

| Black Forest Labs | image | See pricing | ||

| Meta Llama 3.2 3B Instruct Turbo | ||||

| Meta | chat | $0.06 | ||

| Meta Llama Vision Free | ||||

| Meta | chat | Free | ||

| Meta Llama Guard 3 11B Vision Turbo | ||||

| Meta | moderation | $0.18 | ||

| Meta Llama 3.1 8B Instruct Turbo | ||||

| Meta | chat | $0.18 | ||

| Mixtral-8x22B Instruct v0.1 | ||||

| mistralai | chat | $1.20 | ||

| Stable Diffusion XL 1.0 | ||||

| Stability AI | image | See pricing | ||

| Meta Llama 3.1 70B Instruct Turbo | ||||

| Meta | chat | $0.88 | ||

| Meta Llama 3.1 405B Instruct Turbo | ||||

| Meta | chat | $3.50 | ||

| Gryphe MythoMax L2 Lite (13B) | ||||

| Gryphe | chat | $0.10 | ||

| Salesforce Llama Rank V1 (8B) | ||||

| salesforce | rerank | $0.10 | ||

| Meta Llama Guard 3 8B | ||||

| Meta | moderation | $0.20 | ||

| Meta Llama 3 70B Instruct Turbo | ||||

| Meta | chat | $0.88 | ||

| Meta Llama 3 70B Instruct Lite | ||||

| Meta | chat | $0.54 | ||

| Meta Llama 3 8B Instruct Lite | ||||

| Meta | chat | $0.10 | ||

| Meta Llama 3 8B Instruct Turbo | ||||

| Meta | chat | $0.18 | ||

| Meta Llama 3 70B Instruct Reference | ||||

| Meta | chat | $0.90 | ||

| Meta Llama 3 8B Instruct Reference | ||||

| Meta | chat | $0.20 | ||

| Qwen 2 Instruct (72B) | ||||

| Qwen | chat | $0.90 | ||

| Gemma-2 Instruct (27B) | ||||

| chat | $0.80 | |||

| Gemma-2 Instruct (9B) | ||||

| chat | $0.30 | |||

| Mistral (7B) Instruct v0.3 | ||||

| mistralai | chat | $0.20 | ||

| Qwen 1.5 Chat (110B) | ||||

| Qwen | chat | $1.80 | ||

| Meta Llama Guard 2 8B | ||||

| Meta | moderation | $0.20 | ||

| WizardLM-2 (8x22B) | ||||

| microsoft | chat | $1.20 | ||

| DBRX Instruct | ||||

| Databricks | chat | $1.20 | ||

| DeepSeek LLM Chat (67B) | ||||

| DeepSeek | chat | $0.90 | ||

| Gemma Instruct (2B) | ||||

| chat | $0.10 | |||

| Mistral (7B) Instruct v0.2 | ||||

| mistralai | chat | $0.20 | ||

| Mixtral-8x7B Instruct v0.1 | ||||

| mistralai | chat | $0.60 | ||

| Mixtral-8x7B v0.1 | ||||

| mistralai | language | $0.60 | ||

| Qwen 1.5 Chat (72B) | ||||

| Qwen | chat | $0.90 | ||

| Llama Guard (7B) | ||||

| Meta | moderation | $0.20 | ||

| Nous Hermes 2 - Mixtral 8x7B-DPO | ||||

| NousResearch | chat | $0.60 | ||

| Mistral (7B) Instruct | ||||

| mistralai | chat | $0.20 | ||

| Mistral (7B) | ||||

| mistralai | language | $0.20 | ||

| LLaMA-2 Chat (13B) | ||||

| Meta | chat | $0.22 | ||

| LLaMA-2 Chat (7B) | ||||

| Meta | chat | $0.20 | ||

| LLaMA-2 (70B) | ||||

| Meta | language | $0.90 | ||

| Code Llama Instruct (34B) | ||||

| Meta | chat | $0.78 | ||

| Upstage SOLAR Instruct v1 (11B) | ||||

| upstage | chat | $0.30 | ||

| M2-BERT-Retrieval-32k | ||||

| Together | embedding | $0.01 | ||

| M2-BERT-Retrieval-8k | ||||

| Together | embedding | $0.01 | ||

| M2-BERT-Retrieval-2K | ||||

| Together | embedding | $0.01 | ||

| UAE-Large-V1 | ||||

| WhereIsAI | embedding | $0.02 | ||

| BAAI-Bge-Large-1p5 | ||||

| BAAI | embedding | $0.02 | ||

| BAAI-Bge-Base-1p5 | ||||

| BAAI | embedding | $0.01 | ||

| MythoMax-L2 (13B) | ||||

| Gryphe | chat | $0.30 |

使用示例

模型推理示例

import os

import requests

url = "https://api.together.xyz/v1/chat/completions"

payload = {

"model": "mistralai/Mixtral-8x7B-Instruct-v0.1",

"max_tokens": 512,

"temperature": 0.7,

"top_p": 0.7,

"top_k": 50,

"repetition_penalty": 1

}

headers = {

"accept": "application/json",

"content-type": "application/json",

"Authorization": "Bearer TOGETHER_API_KEY"

}

response = requests.post(url, json=payload, headers=headers)

print(response.text)

模型微调示例

import os

import requests

url = "https://api.together.xyz/v1/fine-tune"

payload = {

"model": "togethercomputer/llama-2-70b-chat",

"data": "path/to/your/data",

"epochs": 3,

"batch_size": 8

}

headers = {

"accept": "application/json",

"content-type": "application/json",

"Authorization": "Bearer TOGETHER_API_KEY"

}

response = requests.post(url, json=payload, headers=headers)

print(response.text)© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...