一、测试提示词的根本原因:

- LLM 对提示词高度敏感,细微的措辞变化可能导致显著不同的输出结果

- 未经测试的提示词可能产生:

- 事实错误的信息

- 不相关的回复

- 不必要的 API 成本浪费

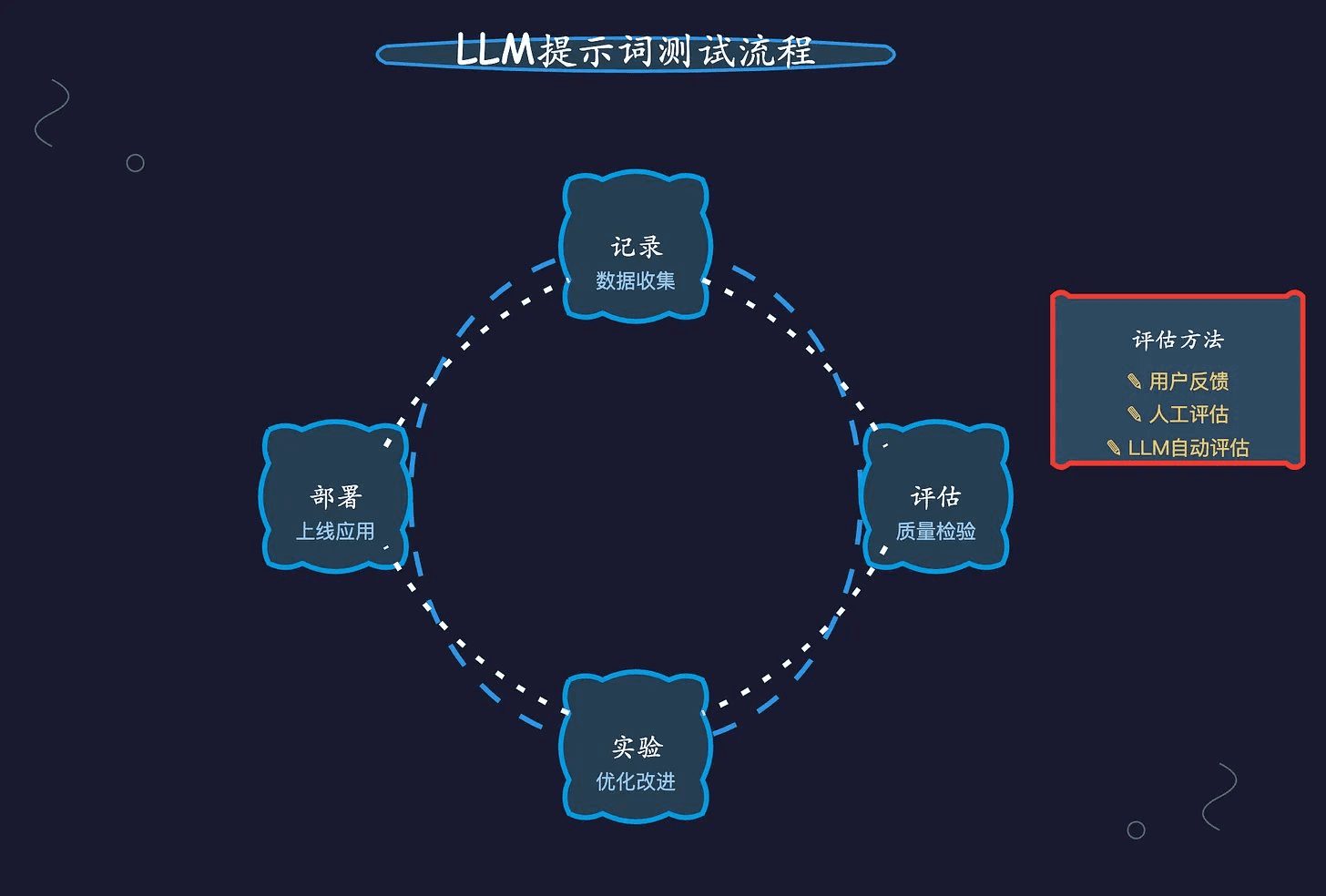

二、系统化的提示词优化流程:

- 准备阶段

- 使用观察工具记录 LLM 请求

- 追踪关键指标:使用量、延迟、成本、首次响应时间等

- 监控异常:错误率上升、API成本突增、用户满意度下降

- 测试流程

- 创建多个提示词变体,采用链式思维和多示例等技术

- 使用真实数据进行测试:

- 标准数据集(golden datasets):经过精心策划的输入和预期输出

- 生产数据采样:更能反映真实场景的挑战

- 对比评估不同版本的效果

- 将最佳方案部署到生产环境

三、三种关键评估方法的深度解析:

- 真实用户反馈

- 优势:直接反映实际使用效果

- 特点:可以通过明确的评分或隐含的行为数据收集

- 局限:需要时间积累,反馈可能主观

- 人工评估

- 应用场景:需要细微判断的主观任务

- 评估方式:

- 是/否判断

- 0-10分打分

- A/B测试比较

- 局限性:资源密集,难以规模化

- LLM自动评估

- 适用场景:

- 分类任务

- 结构化输出验证

- 约束条件检查

- 关键要素:

- 评估提示词本身的质量控制

- 使用少样本学习提供评估指导

- 温度参数设为0确保一致性

- 优势:可扩展、高效

- 注意事项:可能继承模型偏见

- 适用场景:

四、评估框架的实践建议:

- 明确评估维度:

- 准确性:是否正确解决问题

- 流畅性:语法和自然度

- 相关性:是否切中用户意图

- 创造性:想象力和参与度

- 一致性:与历史输出的协调性

- 针对不同任务类型的具体评估策略:

- 技术支持类:关注问题解决的准确性和专业性

- 创意写作类:注重原创性和品牌调性

- 结构化任务:强调格式规范和数据准确性

五、持续优化的关键点:

- 建立完整的反馈循环

- 保持迭代实验的心态

- 通过数据驱动决策

- 平衡效果提升和资源投入

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...