Показано, что:RL превосходит SFT в обучении обобщенным знаниям, особенно в мультимодальных задачах, демонстрируя более сильные способности к рассуждению и визуальному распознаванию

краткое содержание

В области искусственного интеллекта.базовая модель(например, крупномасштабные языковые модели и визуальные языковые модели) стали центральной движущей силой технологического прогресса. Однако как эффективно расширить возможности этих моделейспособность к обобщениюПроблема адаптации к сложности и изменчивости реальных сценариев остается одной из главных. В настоящее время.Супервизорная тонкая настройка (SFT) и обучение с подкреплением (RL)являются двумя широко распространенными методами пост-обучения, однако их роль и влияние на улучшение обобщающей способности моделей остаются неясными.

Этот тезис подтверждаетсяУглубленное сравнительное исследованиеМы систематически исследуем влияние SFT и RL на обобщающие возможности базовой модели. Мы фокусируемся на следующих двух ключевых аспектах:

- Обобщение на основе текстовых правил: Мы разработали систему под названием GeneralPoints карточной игры с арифметическими рассуждениями, в которой оценивается работа модели при различных вариантах правил.

- Визуальное обобщение: Мы использовали V-IRL задача, навигационная среда, основанная на реальном визуальном вводе, для проверки способности модели адаптироваться к изменениям визуального ввода.

Благодаря серииТщательные эксперименты и анализМы пришли к следующим важным выводам:

- RL превосходит SFT как в обобщении правил, так и в визуальном обобщении: RL способен эффективно обучаться и применять новые правила, сохраняя при этом хорошую производительность при наличии вариаций визуального ввода. В отличие от этого, SFT имеет тенденцию запоминать обучающие данные и с трудом адаптируется к невидимым вариантам.

- RL улучшает визуальное распознавание: В визуальном моделировании языка (VLM) RL не только улучшает рассуждения, но и улучшает визуальное распознавание, в то время как SFT уменьшает визуальное распознавание.

- SFT имеет решающее значение для обучения RL: SFT является ключевым фактором успеха обучения RL, когда базовая модель не обладает хорошей способностью следовать инструкциям. Он стабилизирует выходной формат модели, чтобы RL могла в полной мере использовать ее производительность.

- Увеличение числа итераций проверки улучшает обобщение RL: При обучении RL увеличение числа итераций проверки может еще больше улучшить обобщение модели.

Эти выводыПредоставляет ценные сведения для будущих исследований и приложений ИИВ данном исследовании показано, что RL обладает большим потенциалом в сложных мультимодальных задачах. Наше исследование не только выявляет различные роли SFT и RL, но и предлагает новые идеи о том, как более эффективно сочетать эти два подхода для построения более мощных и надежных базовых моделей.

Независимо от того, являетесь ли вы исследователем ИИ, инженером или читателем, интересующимся будущим ИИ, в этой статье вы найдете полезные сведения и практические рекомендации. Давайте углубимся в тайны SFT и RL, чтобы выявить критический путь к обобщению базовой модели.

Оригинальный текст:https://tianzhechu.com/SFTvsRL/assets/sftvsrl_paper.pdf

скорочтение

1. RL превосходит SFT в обобщении правил

Заключение:

RL способен эффективно изучать и обобщать текстовые правила, в то время как SFT склонен запоминать обучающие данные и с трудом адаптируется к неизвестным вариантам правил.

Пример:

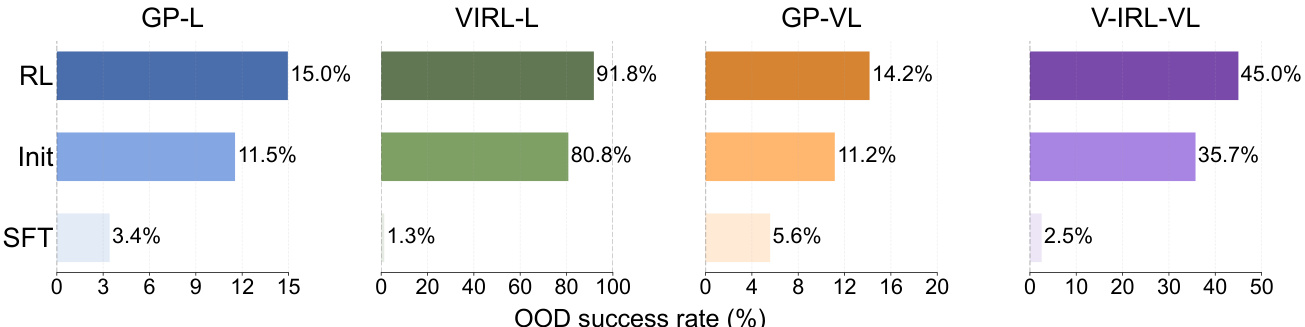

RL превосходит SFT по производительности вне распределения (OOD) в задачах GeneralPoints и V-IRL.

- GeneralPoints (GP-L):

- RL. Коэффициент успешности составил 15,01 TP3T, что больше, чем 11,51 TP3T на начальной контрольной точке. +3.5%.

- SFT. Коэффициент успешности составил 3,41 TP3T, что меньше, чем 11,51 TP3T в начальной контрольной точке. -8.1%.

- V-IRL (V-IRL-L):

- RL. Точность на шаг составила 91,8%, что выше, чем 80,8% на начальной контрольной точке. +11.0%.

- SFT. Точность на шаг составила 1,31 TP3T, что ниже 80,81 TP3T на начальной контрольной точке. -79.5%.

Рисунок 6: Для каждого подграфа RL и SFT обучаются с одинаковым объемом вычислений, а их общая начальная контрольная точка (обозначена как Init) задается в качестве базовой. Подробные настройки см. в приложении C.3.

2. RL также обобщает результаты в визуальных задачах OOD, в то время как SFT демонстрирует низкие результаты

Заключение:

Даже в задачах, содержащих визуальные модальности, RL все еще способен обобщать на невидимые визуальные варианты, в то время как SFT страдает от снижения производительности.

Пример:

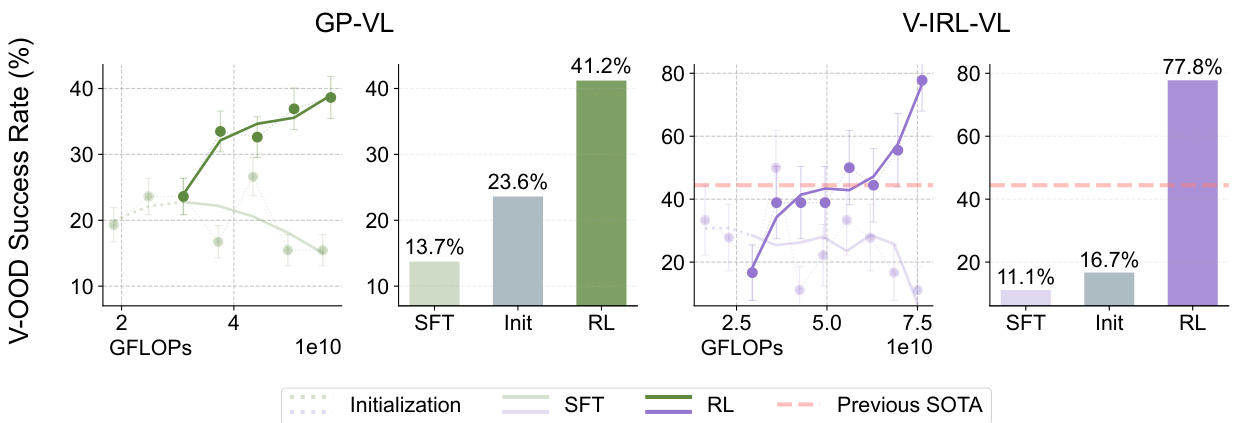

В заданиях GeneralPoints-VI и V-IRL-VL:

- GeneralPoints-VI (GP-VI):

- RL. Коэффициент успешности составил 41,21 TP3T, что выше, чем 23,61 TP3T на начальном контрольном пункте. +17.6%.

- SFT. Коэффициент успешности составил 13,71 TP3T по сравнению с 23,61 TP3T на первой контрольной точке. -9.9%.

- V-IRL-VL (V-IRL-VL):

- RL. Точность на шаг составила 77,81 TP3T, что выше 16,71 TP3T на начальной контрольной точке. +61.1%.

- SFT. Точность на шаг составила 11,11 TP3T по сравнению с 16,71 TP3T на начальной контрольной точке. -5.6%.

Рисунок 7: Как и на рисунках 5 и 6, мы показываем динамику производительности (показана линиями) и итоговую производительность (показана столбиками), оцененную вне визуального распределения. Оранжевым цветом отмечен предыдущий современный результат в малом эталонном тесте V- IRL VLN (Yang et al., 2024a). Подробную настройку оценки (и сглаживание кривых) см. в приложении C.3.

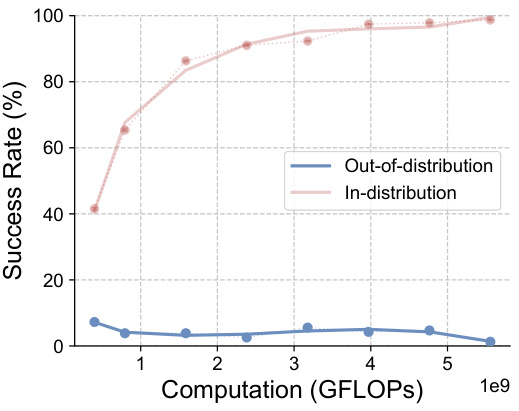

3. RL улучшает визуальное распознавание ВЛМ

Заключение:

RL не только улучшает вывод модели, но и улучшает ее визуальное распознавание, в то время как SFT уменьшает визуальное распознавание.

Пример:

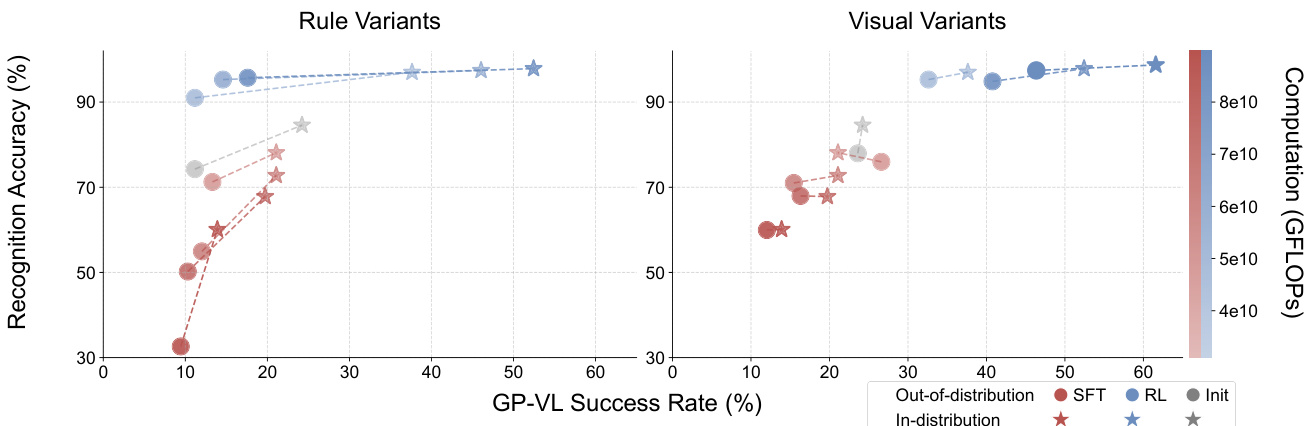

В задании GeneralPoints-VI:

- RL. По мере увеличения объема обучающих вычислений повышается как точность визуального распознавания, так и общий коэффициент успешности.

- SFT. С увеличением объема обучающих вычислений снижается как точность визуального распознавания, так и общий коэффициент успешности.

Рисунок 8: Сравнение скорости распознавания и успешности Reinforcement Learning (RL) и Supervised Fine Tuning (SFT) при различных вариантах GP-VL. На графиках показаны показатели скорости распознавания (ось y) и успешности работы с одним экраном (ось x), соответствующие данным, полученным при распределении (красный цвет) и вне распределения (синий цвет), соответственно. Прозрачность точек данных (цветные полосы) отражает объем обучающих вычислений. Пары данных, соединенные линиями (⋆-◦ ), оцениваются по тем же контрольным точкам. Результаты показывают, что Reinforcement Learning (RL) улучшает как скорость распознавания, так и общую точность по мере увеличения объема посттренировочных вычислений, в то время как Supervised Fine-Tuning (SFT) демонстрирует противоположную тенденцию.

Рисунок 8: Сравнение скорости распознавания и успешности Reinforcement Learning (RL) и Supervised Fine Tuning (SFT) при различных вариантах GP-VL. На графиках показаны показатели скорости распознавания (ось y) и успешности работы с одним экраном (ось x), соответствующие данным, полученным при распределении (красный цвет) и вне распределения (синий цвет), соответственно. Прозрачность точек данных (цветные полосы) отражает объем обучающих вычислений. Пары данных, соединенные линиями (⋆-◦ ), оцениваются по тем же контрольным точкам. Результаты показывают, что Reinforcement Learning (RL) улучшает как скорость распознавания, так и общую точность по мере увеличения объема посттренировочных вычислений, в то время как Supervised Fine-Tuning (SFT) демонстрирует противоположную тенденцию.

4. SFT необходим для обучения RL

Заключение:

SFT необходим для обучения RL, когда магистральная модель не имеет хорошего следования командам.

Пример:

Все эксперименты, в которых сквозной RL применялся непосредственно к пост-тренировочному Llama-3.2 без инициализации SFT, закончились неудачей.

- Примеры неудач:

- Модель генерирует длинные, отвлеченные и неструктурированные ответы, которые не позволяют получить информацию и вознаграждения, связанные с обучением RL.

- Например, модель пытается решить игру на 24 очка, написав код, но не может завершить генерацию кода, что приводит к ошибке проверки.

![]()

Рисунок 20: Мы записали ответы модели, используя сигналы, аналогичные тем, что показаны на рисунке 11. Результаты показывают, что Llama-3.2-Vision-11B не может правильно следовать инструкциям. Мы пропустили длинные ответы, в которых пытались решить головоломку с помощью кода, но не смогли завершить ее в рамках ограниченной длины контекста.

5. Увеличение числа итераций проверки улучшает обобщающую способность RL

Заключение:

При обучении RL увеличение числа итераций валидации улучшает обобщение модели.

Пример:

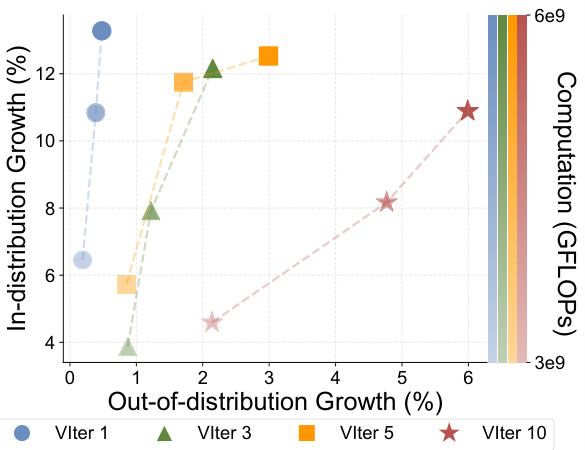

В задаче GeneralPoints-Language (GP-L):

- 1 итерация проверки. Производительность OOD повышается только за счет +0.48%.

- 3 итерации проверки. Повышается производительность OOD +2.15%.

- 5 итераций проверки. Повышается производительность OOD +2.99%.

- 10 итераций проверки. Повышается производительность OOD +5.99%.

Рисунок 10: Мы записали RL-эксперименты с разным количеством итераций проверки (VIter), чтобы увеличить объем обучающих вычислений (цвет прозрачный).

6. SFT перестраивается на маркеры для вывода и игнорирует маркеры для распознавания

Заключение:

SFT имеет тенденцию к избыточному приспособлению к предполагаемым маркерам и недостаточной ориентации на идентифицированные маркеры, возможно, из-за высокой частоты предполагаемых маркеров.

Пример:

В задаче GeneralPoints-VI SFT не смог достичь сравнимой с RL производительности внутри распределения, даже после корректировки гиперпараметров.

- Исследование абляции СФТ.

- После корректировки скорости обучения и других регулируемых компонентов ни один из показателей успешности SFT не превысил 30% и не показал тенденции к увеличению.

Рисунок 16: Абляционное исследование GeneralPoints-VL SFT. Мы провели эксперименты с абляцией по скорости обучения и представили данные о коэффициенте успешности в пределах распределения, на одном экране (%) для всех экспериментов. Ни в одном из экспериментов коэффициент успешности не превышал 30% и не имел тенденции к увеличению.

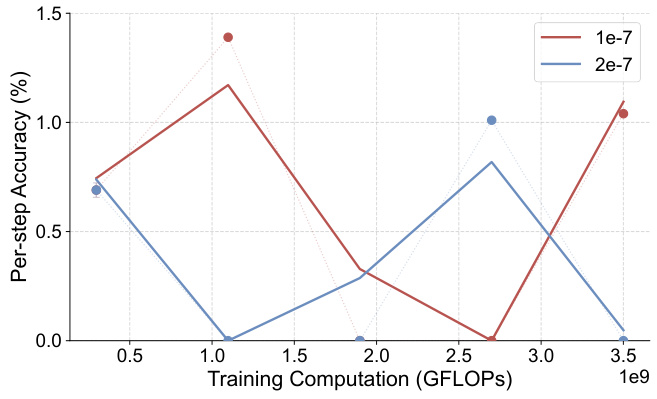

7. RL не может восстановить производительность OOD после перебора контрольных точек

Заключение:

При инициализации из контрольной точки с избыточной настройкой RL не смогла восстановить производительность модели OOD.

Пример:

В задании V-IRL-VL:

- RL Инициализация из контрольных точек с избыточной настройкой:

- Первоначальная точность на каждом шаге ниже, чем 1%, и RL не может улучшить производительность OOD.

Рисунок 19: Одношаговая точность вне распределения (%) - GFLOPs: модель V-IRL-VL при регулярных вариантах (с использованием завышенных начальных контрольных точек). Подробности о метриках оценки см. в Приложении C.3.

резюме

С помощью серии экспериментов и анализа в диссертации демонстрируются преимущества RL в обучении обобщающим знаниям и тенденция SFT к запоминанию обучающих данных. В диссертации также подчеркивается важность SFT для обучения RL и положительное влияние увеличения числа итераций валидации на способность RL к обобщению. Эти результаты дают ценные сведения для построения более надежных и достоверных базовых моделей в будущем.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...