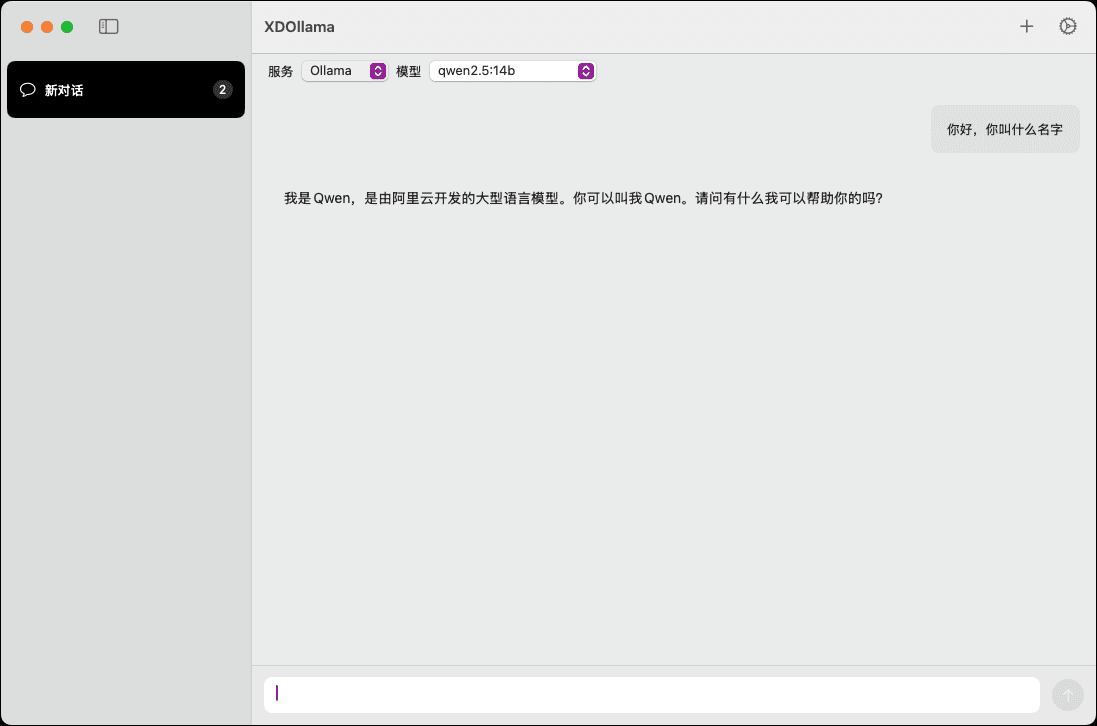

XDOllama: интерфейс модели искусственного интеллекта для быстрого вызова Ollama\Dify\Xinference на MacOS.

Общее введение

XDOllama - это настольное приложение, предназначенное для пользователей MacOS, чтобы быстро вызывать Ollama, Dify и Xinference Приложение позволяет пользователям легко вызывать локальные или онлайн-модели искусственного интеллекта с помощью упрощенного интерфейса и процесса работы. Приложение позволяет пользователям легко вызывать локальных или онлайн-моделей искусственного интеллекта с помощью упрощенного интерфейса и процесса работы, повышая эффективность работы и опыт.

Список функций

- вызвать локальный Оллама моделирование

- Вызов онлайн-модели Ollama

- Вызов локальной модели Xinference

- Вызов онлайн-модели Xinference

- вызвать локальный Dify прибор

- Вызов онлайн-приложения Dify

- Поддержка множества фреймворков искусственного интеллекта

- Простой в использовании дизайн интерфейса

- Эффективная скорость вызова модели

Использование помощи

Процесс установки

- Загрузите файл DMG.

- Дважды щелкните, чтобы открыть загруженный DMG-файл.

- Перетащите файл XDOllama.app в папку Applications.

- После завершения установки откройте приложение, и оно будет готово к работе.

Руководство по использованию

- Откройте приложение XDOllama.

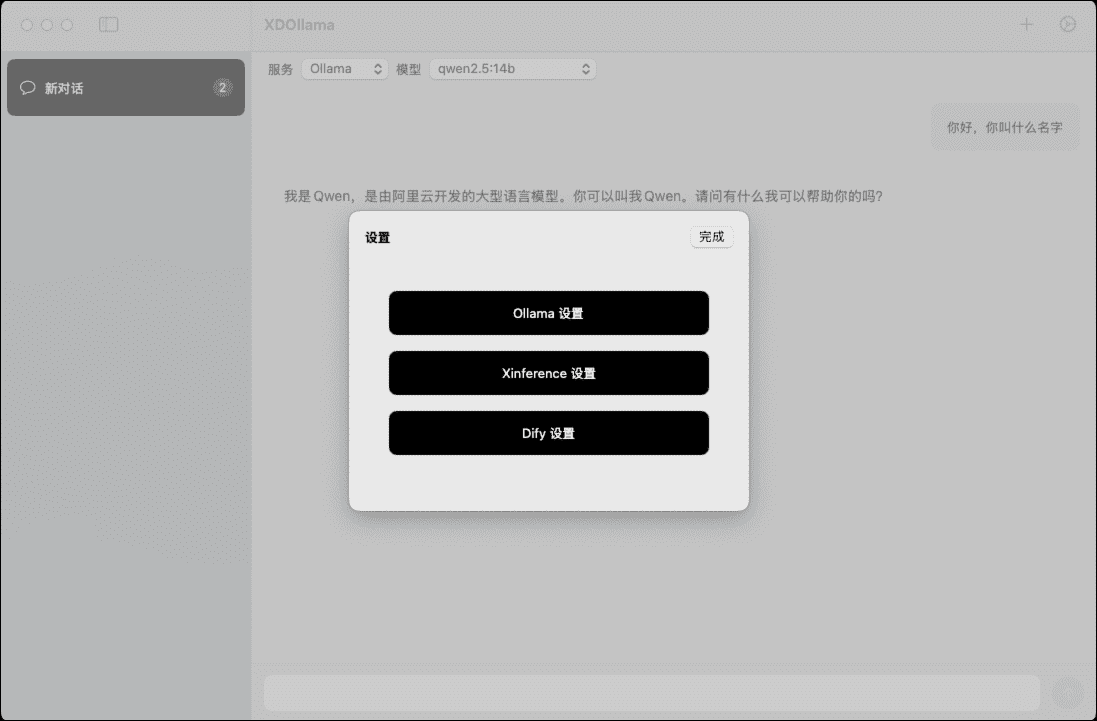

- Выберите модель искусственного интеллекта для вызова (Ollama, Dify или Xinference).

- Выберите способ вызова (локальный или онлайн).

- Введите соответствующие параметры и настройки, как будет предложено.

- Нажмите кнопку "Вызов" и дождитесь загрузки и запуска модели.

- Просмотр и использование результатов моделирования.

Подробный порядок работы функций

Вызов локальной модели Ollama

- Выберите "Ollama" на главном экране.

- Выберите метод вызова "Местный".

- Введите путь и параметры модели.

- Нажмите кнопку "Вызов" и дождитесь загрузки модели.

- Просмотрите выходные данные модели.

Вызов онлайн-модели Ollama

- Выберите "Ollama" на главном экране.

- Выберите метод вызова "Онлайн".

- Введите URL-адрес и параметры онлайн-модели.

- Нажмите кнопку "Вызов" и дождитесь загрузки модели.

- Просмотрите выходные данные модели.

Вызов локальной модели Xinference

- Выберите "Xinference" на главном экране.

- Выберите метод вызова "Местный".

- Введите путь и параметры модели.

- Нажмите кнопку "Вызов" и дождитесь загрузки модели.

- Просмотрите выходные данные модели.

Вызов онлайн-модели Xinference

- Выберите "Xinference" на главном экране.

- Выберите метод вызова "Онлайн".

- Введите URL-адрес и параметры онлайн-модели.

- Нажмите кнопку "Вызов" и дождитесь загрузки модели.

- Просмотрите выходные данные модели.

Вызов локального приложения Dify

- Выберите "Dify" на главном экране.

- Выберите метод вызова "Местный".

- Введите путь и параметры приложения.

- Нажмите кнопку "Вызов" и дождитесь загрузки приложения.

- Просмотрите вывод приложения.

Вызов онлайн-приложения Dify

- Выберите "Dify" на главном экране.

- Выберите метод вызова "Онлайн".

- Введите URL-адрес и параметры онлайн-приложения.

- Нажмите кнопку "Вызов" и дождитесь загрузки приложения.

- Просмотрите вывод приложения.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...