Частное развертывание без локальных графических процессоров DeepSeek-R1 32B

в отношении DeepSeek-R1 Для ежедневного использования в офисе, непосредственно на официальном сайте является лучшим выбором, если у вас есть другие проблемы или особые потребности... Его необходимо использовать в Локальное развертывание DeepSeek-R1 (с помощью программы установки одним щелчком мыши)Белые учебники, представленные здесь, идеально подходят для вас.

Если у вас плохо настроенный компьютер, но вы все равно хотите развернуть его с помощью частного DeepSeek-R1... Тогда подумайте об использовании бесплатных графических процессоров, чему все давно научились. Развертывание модели DeepSeek-R1 с открытым исходным кодом в режиме онлайн с использованием бесплатных мощностей GPUОднако есть фатальный недостаток, то есть, бесплатный GPU может установить только 14B, установка 32B будет очень карты, но после тестирования только установить DeepSeek-R1 32B или более качество вывода, чтобы удовлетворить потребности повседневной работы.

Итак... Мы собираемся установить свободные GPU в эффективно работающие Количественная версия DeepSeek-R1 32B. Он идет!

В бесплатном GPU можно выводить от 2 до 6 слов в секунду (в зависимости от сложности проблемы скорость вывода колеблется), недостатком этого метода является то, что вам нужно время от времени включать сервис.

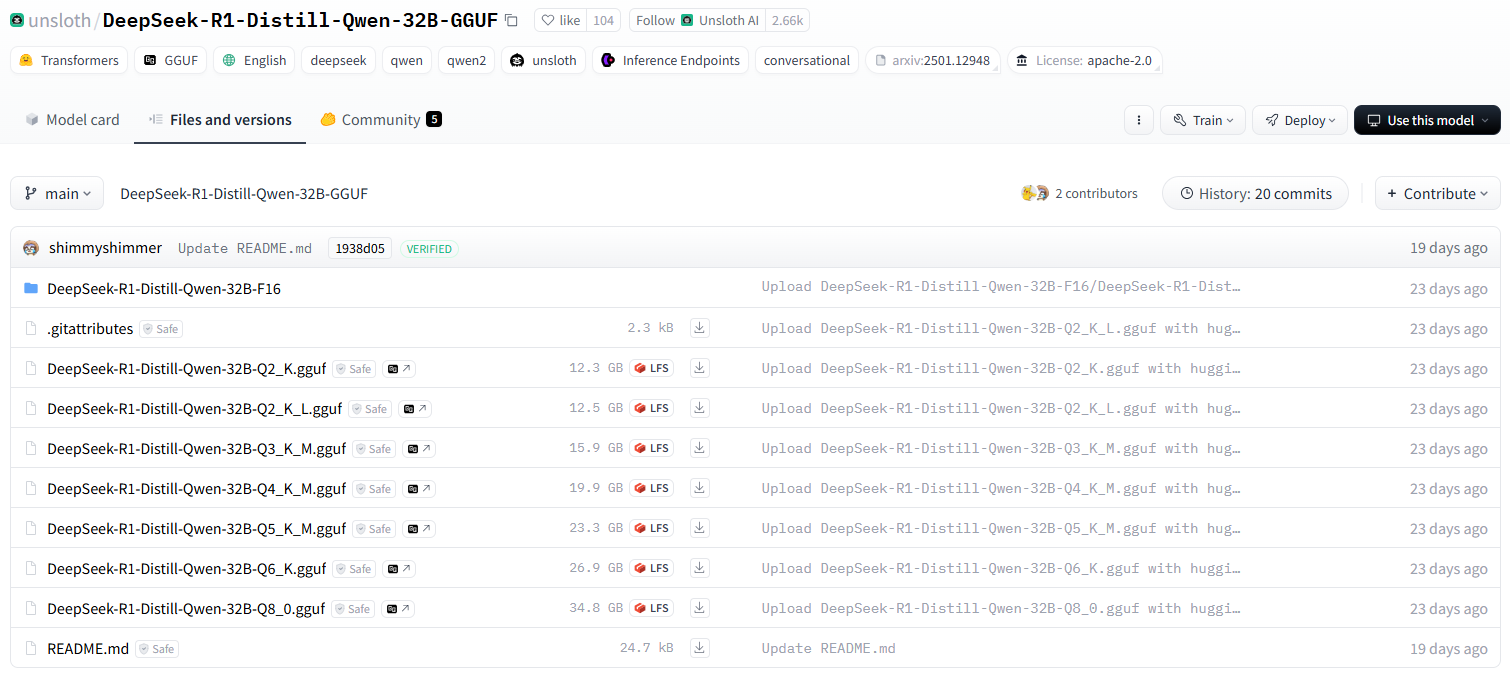

unsloth team quantised version DeepSeek-R1

unsloth Поставляемая версия Qwen-32B-Q4_K_M сжата до 20 ГБ, что уже позволяет работать на одной карте потребительского класса..

Краткое описание требований к производительности компьютера для квантифицированной версии

DeepSeek-R1-Distill-Qwen-32B-GGUFОписание различных количественных версий модели

Суффикс каждого файла (например, Q2_K_L, Q4_K_M и т.д.) представляет собой различную квантификацию. Вот их основные отличия:

q2_k_l, q3_k_m, q4_k_m, q5_k_m, q6_k, q8_0

Q2, иQ3, иQ4, иQ5, иQ6, иQ8Указывает количество вычисляемых битов (например.Q4(указывает на 4-битное вычисление).KкромеMЭто может быть другая количественная стратегия или уровень точности.Q8_0Обычно 8-битное квантование, близкое к точности FP16, с самыми высокими вычислительными требованиями, но лучшим качеством выводов.

DeepSeek-R1-Distill-Qwen-32B-F16

F16указать16-разрядная плавающая точка (FP16)это нерасчетная модель, которая обладает наивысшей точностью, но использует больше всего видеопамяти.

Подробнее о концепции квантования можно узнать здесь:Что такое квантование моделей: объяснение типов данных FP32, FP16, INT8, INT4

Как выбрать подходящую версию?

- Устройства с малым объемом видеопамяти (например, потребительские GPU) → ВыбратьКоличественное определение Q4, Q5например.

Q4_K_MвозможноQ5_K_MБаланс между производительностью и точностью. - Крайне малые объемы памяти (например, при работе с процессором) → ВыбратьКоличественное определение Q2 или Q3например.

Q2_K_LвозможноQ3_K_Mчто уменьшает объем занимаемой памяти. - Высокопроизводительные серверы на базе GPU→ ВыбратьКоличественное определение Q6 или Q8например.

Q6_KвозможноQ8_0что позволяет добиться лучшего качества рассуждений. - наиболее эффективный→ Выбрать

F16версия, но требует значительного объема памяти (около 60 ГБ или более).

Бесплатный GPU Рекомендуемая версия установки

Q2_K_L

Начните установку DeepSeek-R1 32B

От того, как получить бесплатный GPU до его установки Оллама Просматривайте или читайте:Развертывание модели DeepSeek-R1 с открытым исходным кодом в режиме онлайн с использованием бесплатных мощностей GPUЕдинственное отличие от предыдущего руководства - небольшое изменение в команде установки.

Перейдите непосредственно к процессу установки конкретной версии quantised в Ollama. К счастью, Ollama до предела упростила весь процесс установки, требуя всего одну команду установки.

1. Установка базового формата команд количественной модели версионирования huggingface

Запомните следующий формат команд установки

ollama run hf.co/{username}:{reponame}

2. Выбор количественной версии

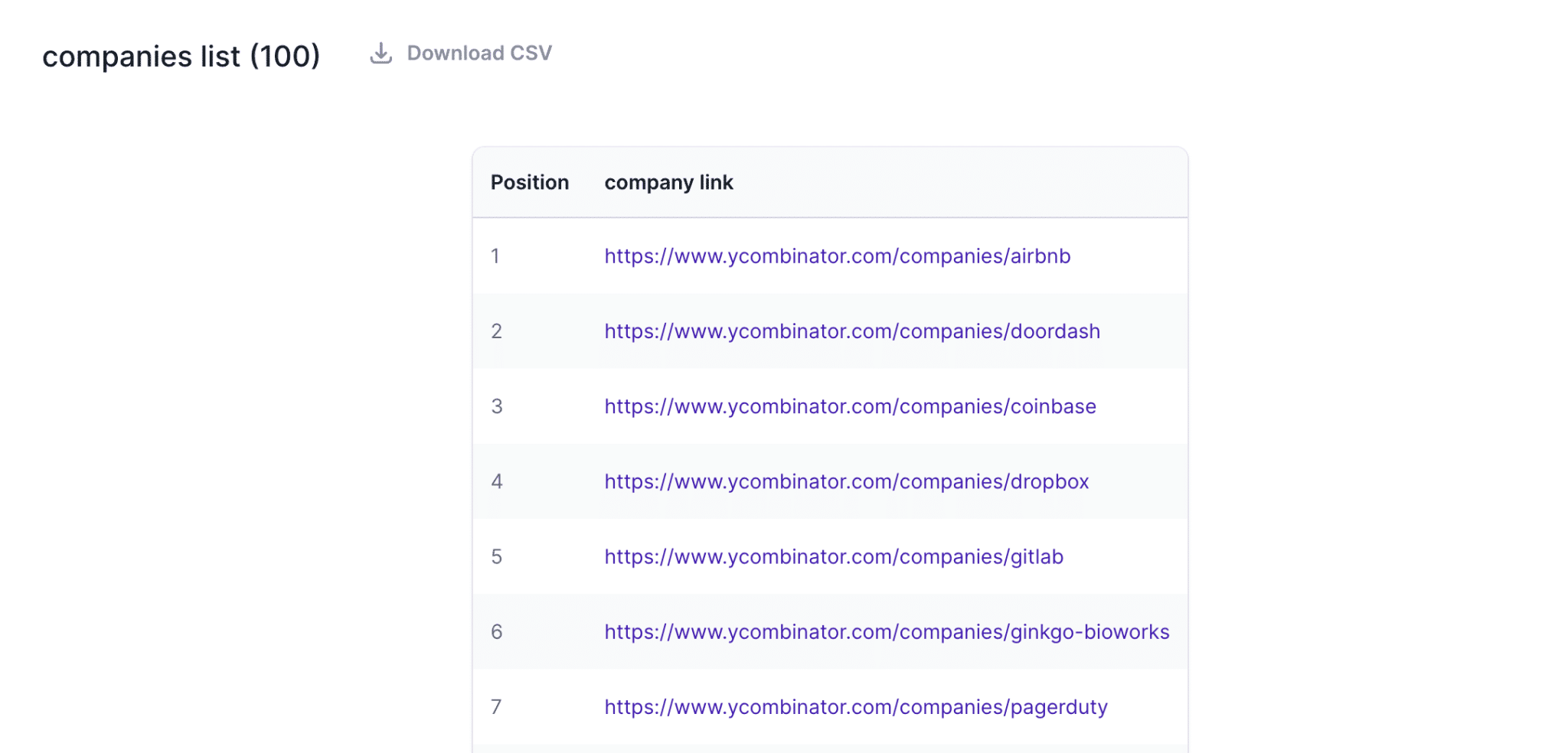

Список всех количественных версий: https://huggingface.co/unsloth/DeepSeek-R1-Distill-Qwen-32B-GGUF/tree/main

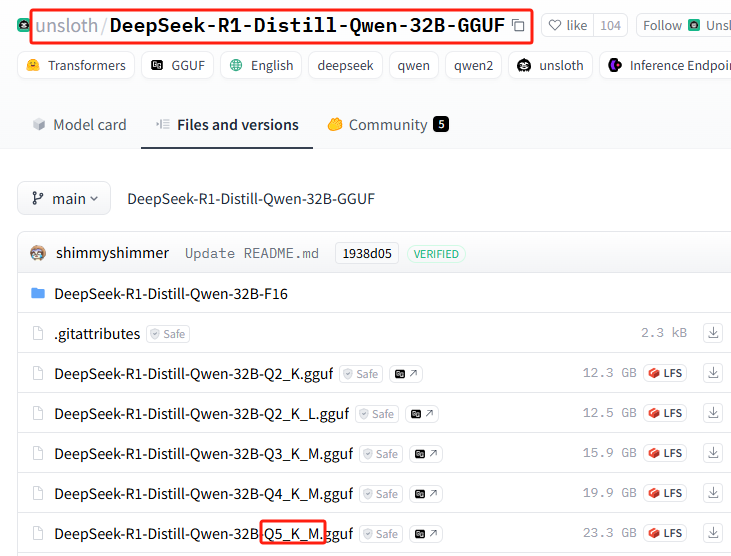

В этой установке используется: Q5_K_M (только для демонстрационных целей, вИ снова, пожалуйста, установите бесплатную версию, рекомендованную GPU!(Для установки Q5 требуется 23 Гб пространства на жестком диске)

3. Команда установки сплитов

{имя пользователя}=unsloth/DeepSeek-R1-Distill-Qwen-32B-GGUF

{reponame}=Q5_K_M

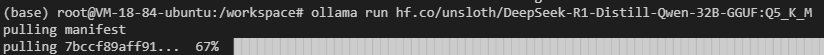

Соедините их вместе, чтобы получить полную команду установки:ollama run hf.co/unsloth/DeepSeek-R1-Distill-Qwen-32B-GGUF:Q5_K_M

4. Выполните установку в Ollama

Выполните команду установки

У вас могут возникнуть сбои в сети (удачи вам), повторите команду установки еще несколько раз...

Все еще не работает? Выполните следующую команду, чтобы попробовать (переключитесь на внутренний адрес зеркала):ollama run https://hf-mirror.com/unsloth/DeepSeek-R1-Distill-Qwen-32B-GGUF:Q5_K_M

Почему бы вам просто не использовать адрес зеркала для загрузки, а не использовать сначала официальный адрес, а затем зеркало?

Это связано с тем, что интегрированная установка выполняется быстрее!

Конечно, вам может не понадобиться эта квантизированная версия, вот более свежая популярная версия без цензуры: ollama run huihui_ai/deepseek-r1-abliterated:14b

5. сделать Олламу доступной для изгоев

Подтвердите порт Ollama, введя в терминале команду

ollama serve

11414 или 6399

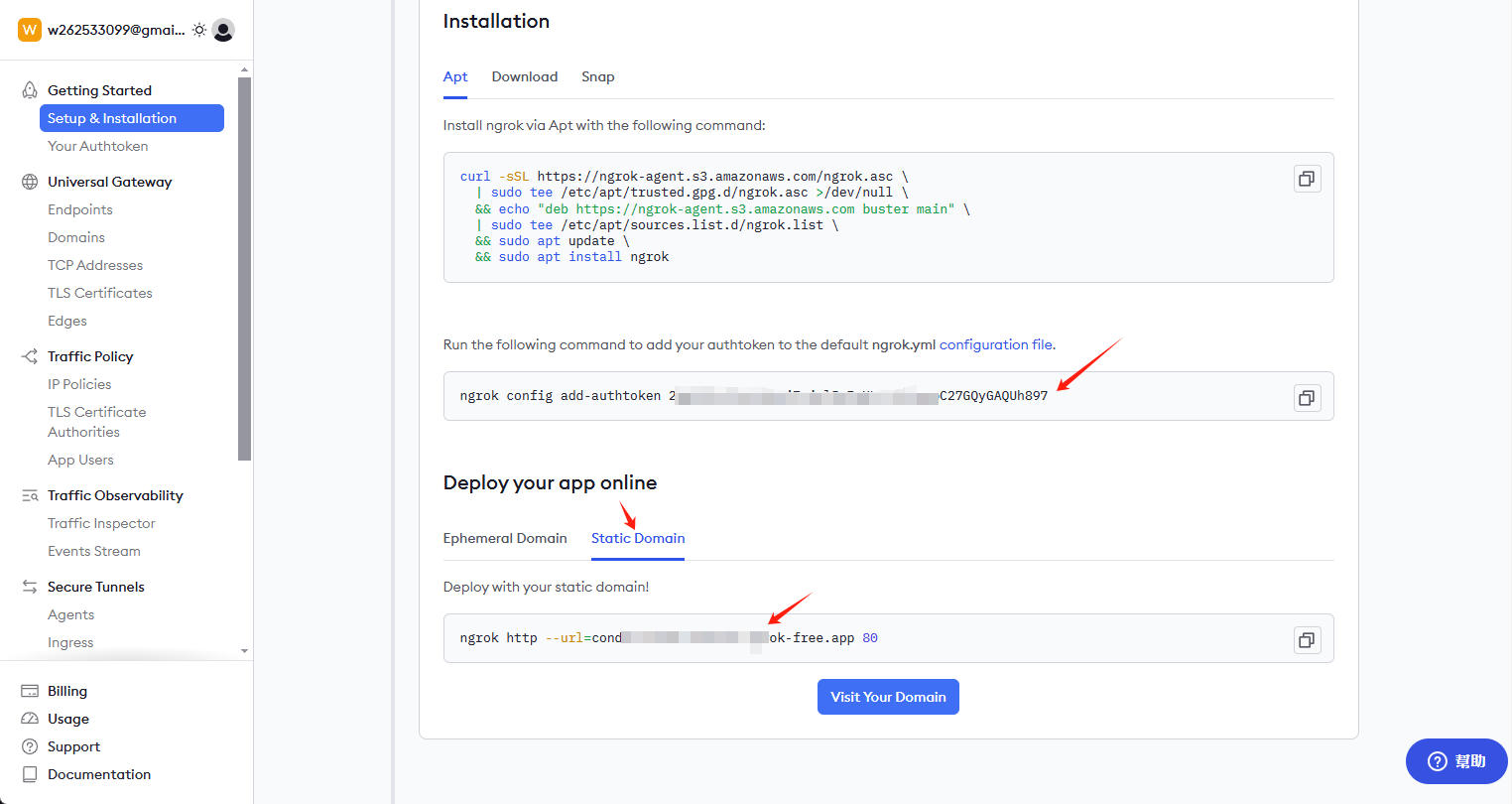

Установка ngrok

curl -sSL https://ngrok-agent.s3.amazonaws.com/ngrok.asc \ | tee /etc/apt/trusted.gpg.d/ngrok.asc >/dev/null \ && echo "deb https://ngrok-agent.s3.amazonaws.com buster main" \ | tee /etc/apt/sources.list.d/ngrok.list \ && apt update \ && apt install ngrok

Получить ключ и постоянную ссылку

Посетите сайт ngrok.com, чтобы зарегистрировать аккаунт и перейти на главную страницу, чтобы получить ключ и постоянную ссылку

Установите ключ и включите внешний адрес доступа

Введите следующую команду в клиенте:

ngrok config add-authtoken 这里是你自己的密钥

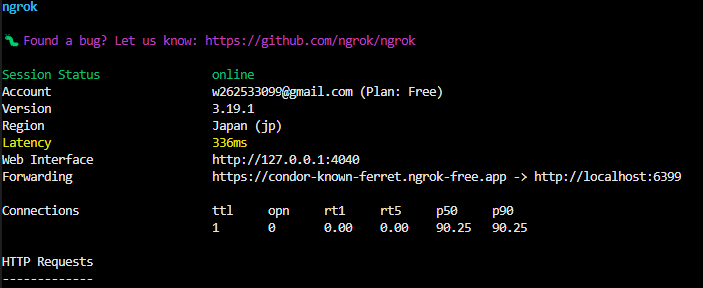

Продолжайте вводить следующие команды для открытия внешнего доступа: 6399 этот порт может отличаться от всех, проверьте и измените свой собственный

ngrok http --url=condor-known-ferret.ngrok-free.app 6399

После успеха вы увидите в терминале

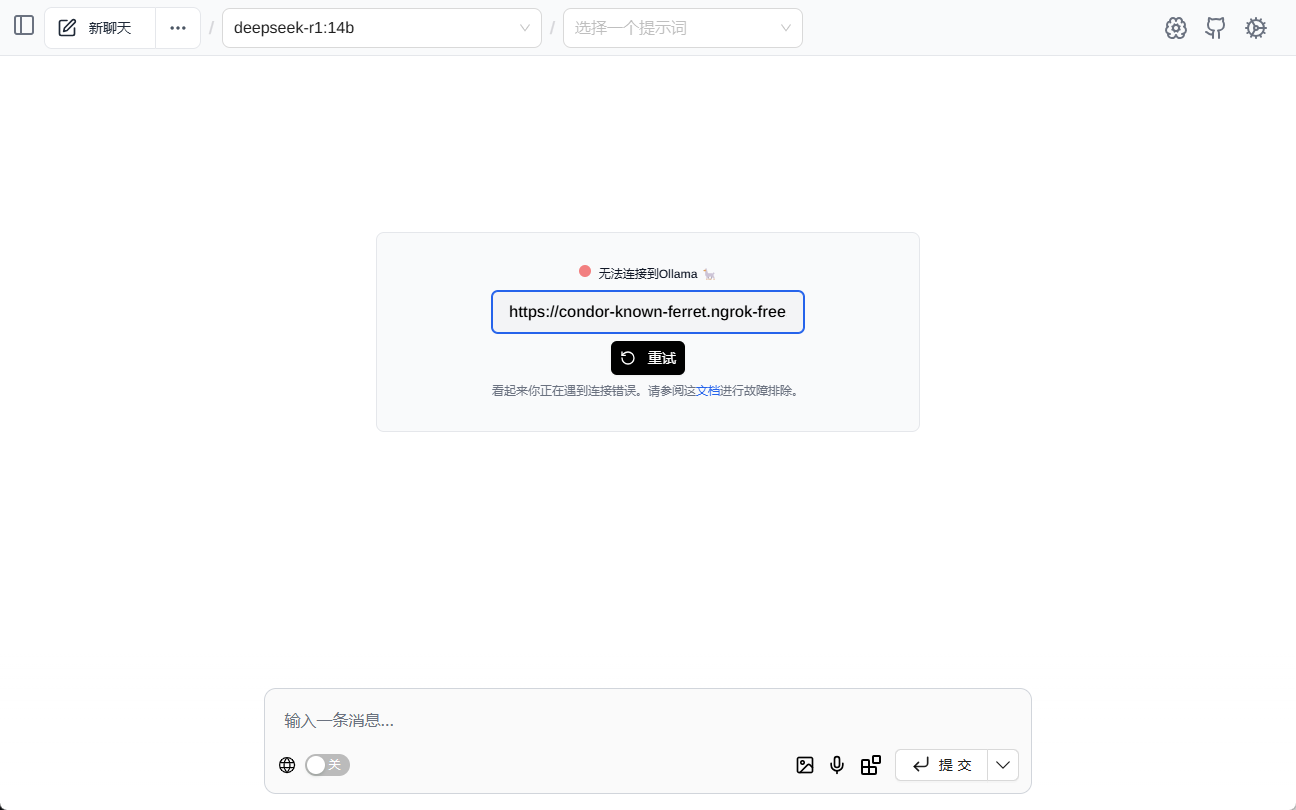

https://condor-known-ferret.ngrok-free.app - это адрес доступа к интерфейсу модели, откройте его и вы увидите следующее содержимое

пользоваться

Получено с сайта https://condor-known-ferret.ngrok-free.app如何使用?

Самый простой способ сделать это - установить Помощник страницы При совместном использовании инструмент представляет собой плагин для браузера, который устанавливается самостоятельно.

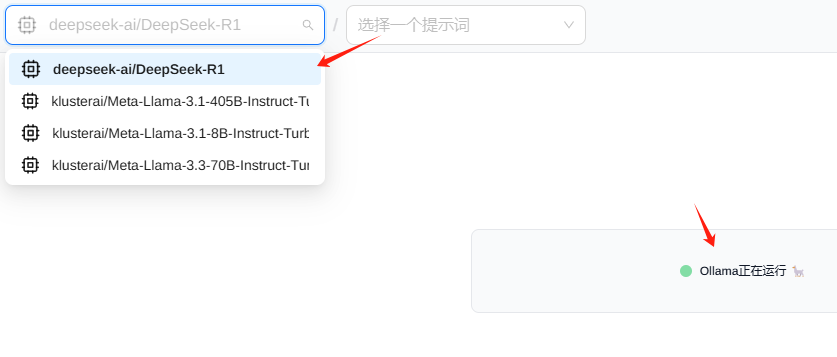

настроить

показать (билет) Помощник страницы После этого вы увидите следующий интерфейс, пожалуйста, введите адрес интерфейса

Обычно вы видите, что модель загружается автоматически

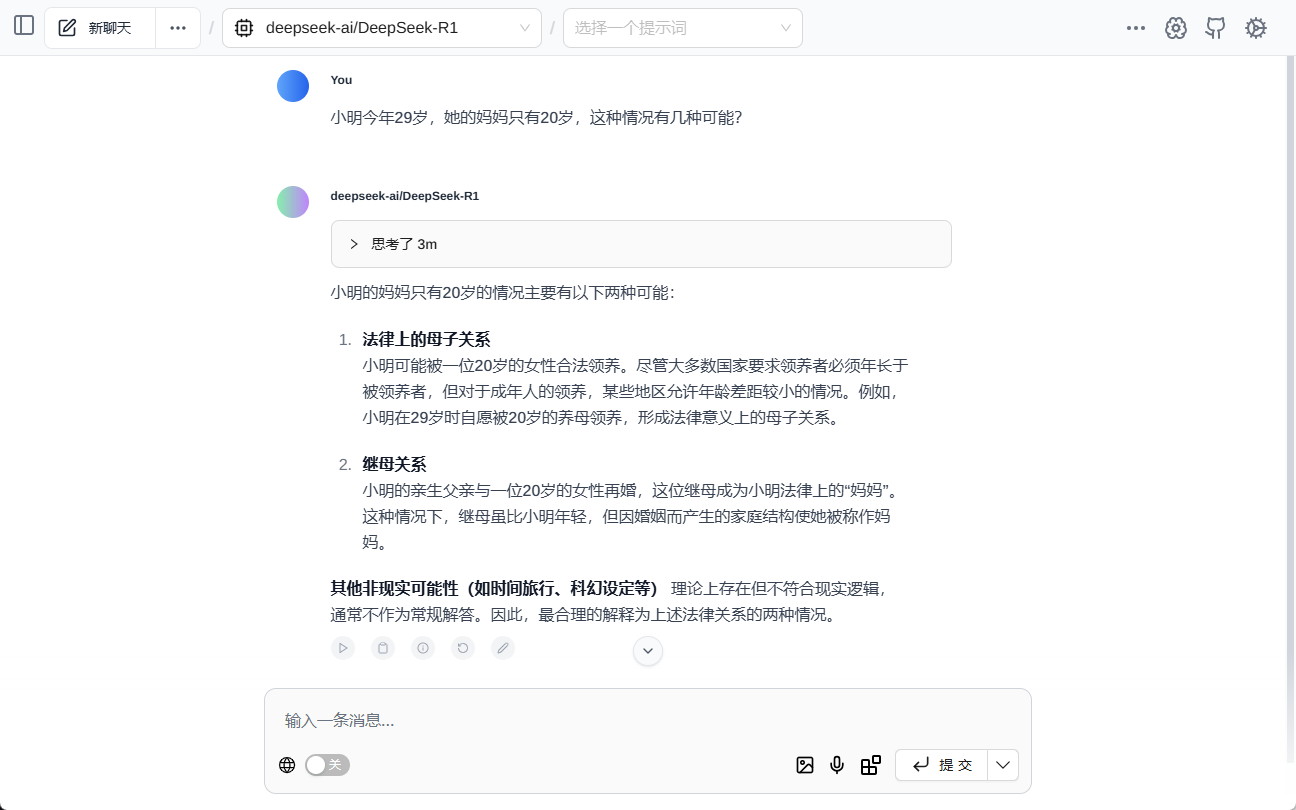

испытание (машины и т.д.)

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...