Механизм внимания (Механизм внимания) - что это, статья для чтения и понимания

Определение механизмов внимания

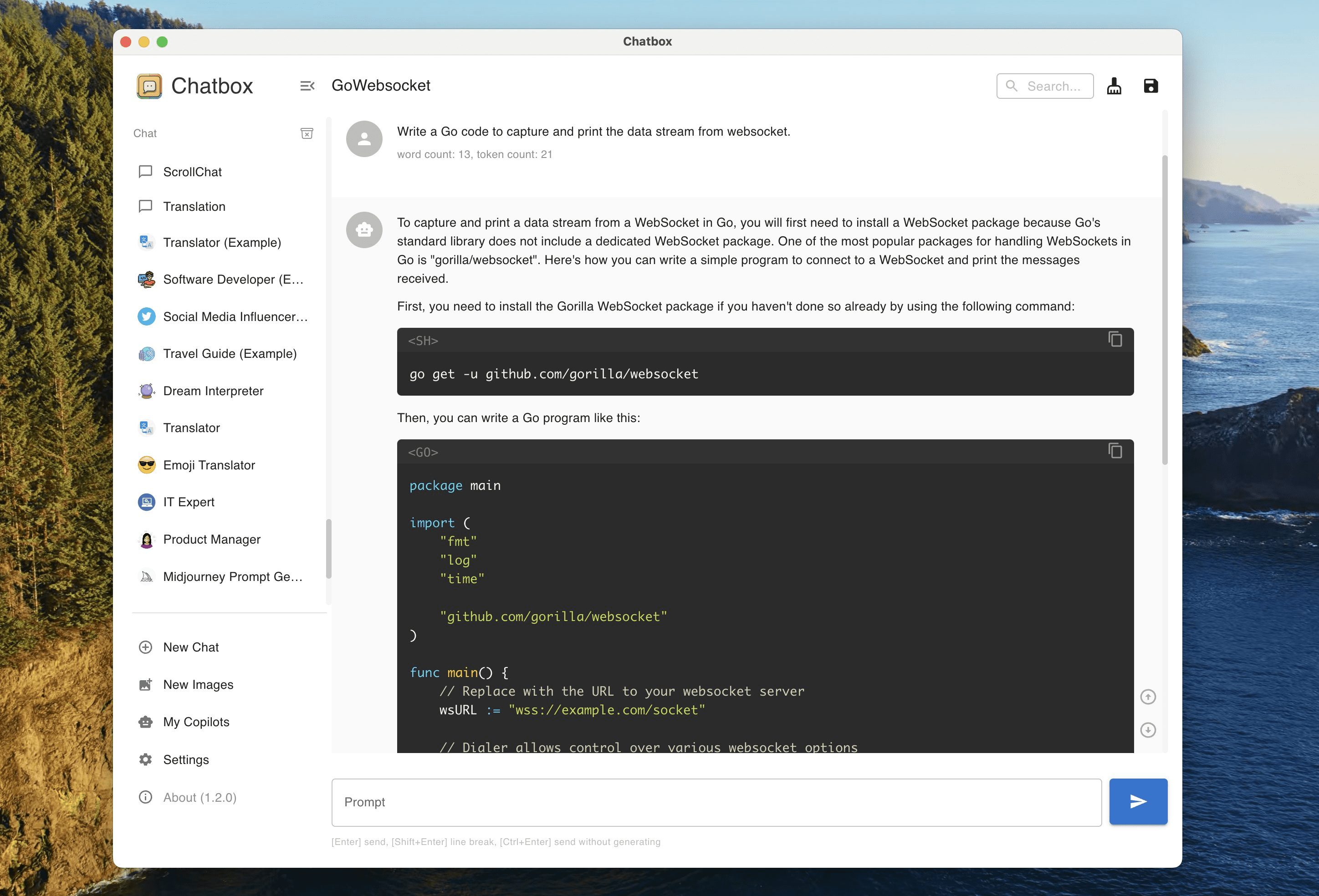

Механизм внимания (Attention Mechanism) - это вычислительная техника, имитирующая человеческие когнитивные процессы, которая изначально применялась в области машинного перевода, а затем стала важной частью глубокого обучения. Основная идея заключается в том, чтобы позволить модели динамически фокусироваться на значимых частях входных данных при обработке информации, подобно тому как человек автоматически фокусируется на ключевых словах при чтении. Важность элементов входного сигнала представляется путем присвоения им различных весов, причем более высокие веса означают более сильное внимание. С точки зрения технической реализации функция внимания сопоставляет запрос с набором пар ключ-значение в виде взвешенного суммированного результата, где веса вычисляются из функции совместимости между запросом и ключами.

Наиболее распространенной реализацией является внимание по точечному произведению, где распределение внимания получается путем вычисления точечного произведения запросов и ключей. Успех механизма внимания заключается в его способности эффективно обрабатывать длинные последовательности данных, решая проблему дальних зависимостей, которая существует в традиционных рекуррентных нейронных сетях. С развитием механизм внимания был расширен от первоначальной архитектуры кодера-декодера до таких форм, как самовнимание, которое стало основным компонентом архитектуры Transformer. Эта техника не только улучшила качество машинного перевода, но и получила широкое применение во многих областях, таких как обработка изображений, распознавание речи и т. д., значительно улучшив способность модели улавливать важную информацию.

Историческое происхождение механизмов внимания

- Основы когнитивной психологии: Концепция механизмов внимания уходит своими корнями в изучение когнитивной психологии человека. Еще в XIX веке психолог Уильям Джеймс предположил, что внимание - это "процесс, посредством которого разум занимает себя одним из нескольких одновременно существующих объектов или мыслей". Этот механизм избирательного внимания человека обеспечивает теоретическую основу для вычислительных моделей.

- Первые попытки вычислительного моделирования: В 1990-х годах исследователи начали внедрять идею внимания в нейронные сети. Модель выравнивания, предложенная командой Джошуа Бенджио в 1997 году, может рассматриваться как прототип механизма внимания для улучшения производительности обучения по принципу "последовательность-последовательность".

- Прорывы в области машинного перевода: В 2014 году Бахданау и др. впервые успешно реализовали механизм внимания в нейронном машинном переводе, что позволило значительно улучшить качество перевода длинных предложений за счет мягкого выравнивания. Эта работа открывает путь к широкому применению механизма внимания в области обработки естественного языка

- Инновации в архитектуре трансформатора: В 2017 году Васвани и др. опубликовали работу Attention Is All You Need, в которой построили архитектуру Transformer полностью на основе механизма внимания, отказавшись от традиционной структуры рекуррентных нейронных сетей и создав новый эталон производительности.

- Междоменное расширение: С углублением исследований механизм внимания был распространен на обработку естественного языка, компьютерное зрение, распознавание речи, рекомендательные системы и многие другие области, став важной частью моделей глубокого обучения.

Как работает механизм внимания

- каскад входного сигнала: Входная последовательность сначала преобразуется в векторное представление, где каждому слову или элементу соответствует высокоразмерный вектор. Эти векторы содержат информацию как о самом элементе, так и о его положении в последовательности

- Система квестов и ключей: В механизме внимания используются три компонента: запрос, ключ и значение. Запрос представляет то, на чем нужно сосредоточиться в данный момент, ключ - объект сравнения, а значение - фактическую информацию, которую нужно извлечь.

- Расчет сходства: Оценка внимания получается путем вычисления сходства между запросом и каждым ключом. Обычно используются такие методы вычисления сходства, как точечное произведение, аддитивное внимание и т. д. Метод точечного произведения широко используется из-за его высокой вычислительной эффективности.

- нормализация веса: Используйте функцию softmax для преобразования оценок внимания в распределение вероятностей, обеспечивая, чтобы все веса равнялись 1, формируя матрицу весов внимания.

- Выход взвешенной суммыНаконец, веса внимания перемножаются и суммируются с соответствующими векторами значений, чтобы получить взвешенное представление на выходе. Этот выход концентрирует наиболее значимую информацию во входной последовательности

Основные типы механизмов внимания

- Мягкое и жесткое вниманиеМягкое внимание присваивает непрерывные веса всей входной последовательности, которая является дифференцируемой и легко обучаемой; жесткое внимание фокусируется только на определенных местах, что является вычислительно эффективным, но не дифференцируемым, и требует обучения с помощью таких методов, как обучение с подкреплением.

- Глобальное и локальное вниманиеГлобальное внимание учитывает все входные позиции, что приводит к большим вычислительным затратам, но обеспечивает высокую точность; локальное внимание фокусируется только на некоторых позициях в окне, балансируя между точностью и эффективностью

- Механизм самовнушенияСамовнимание, также известное как внутреннее внимание, позволяет каждой позиции в последовательности вычислять аттенционные веса по отношению ко всем позициям в последовательности, и хорошо улавливает зависимости внутри последовательностей.

- Долгое внимание: Повышение выразительности модели и ее способности улавливать множественные взаимосвязи путем распараллеливания нескольких центров внимания и предоставления модели возможности одновременно воспринимать информацию в различных подпространствах представления.

- разделённое внимание: используется между двумя различными последовательностями, позволяя одной последовательности действовать как запрос, а другой предоставлять ключи и значения; обычно используется для кросс-модальных взаимодействий в архитектурах кодировщиков-декодировщиков

Сценарии применения механизмов внимания

- система машинного перевода: В нейронном машинном переводе механизм внимания помогает модели автоматически фокусироваться на соответствующих частях предложения на исходном языке при генерации слов на целевом языке, что значительно улучшает качество перевода длинных предложений.

- Распознавание и обработка изображений: Механизмы внимания в компьютерном зрении позволяют моделям фокусироваться на ключевых областях изображения, что дает хорошие результаты в задачах классификации изображений, обнаружения целей и генерации изображений.

- технология распознавания речи: Механизм выравнивания аудиокадров и выходного текста при распознавании речи, обработки входных и выходных последовательностей разной длины и повышения точности распознавания.

- Рекомендуемая оптимизация системы: Анализируя последовательность поведения пользователя, механизм внимания может улавливать изменения в интересах пользователя и фокусироваться на историческом поведении, которое наиболее важно для прогнозирования рекомендаций, что повышает точность рекомендаций.

- Медицинские диагностические приборы: В анализе медицинских изображений механизм внимания помогает модели сфокусироваться на очаге поражения и предоставить врачам поддержку в принятии решений, одновременно повышая интерпретируемость модели.

Преимущественные особенности механизма привлечения внимания

- возможность параллельных вычислений: В отличие от рекуррентных нейронных сетей, которые обрабатывают последовательности последовательно, механизм внимания может вычислять веса внимания для всех позиций параллельно, что значительно повышает эффективность обучения и вывода.

- Моделирование зависимостей на дальних расстояниях: Он может напрямую устанавливать связь между любыми двумя позициями в последовательности, эффективно решая проблему захвата зависимостей в длинных последовательностях и преодолевая проблему исчезновения градиента в традиционных RNN.

- Повышение интерпретируемостиРаспределение весов внимания дает наглядное представление о процессе принятия решений моделью, помогая исследователям понять, на что направлено внимание модели, и повышая прозрачность модели.

- Гибкость Архитектурный дизайн: могут быть легко интегрированы в различные архитектуры нейронных сетей без изменения основной структуры, что предоставляет больше возможностей для проектирования моделей

- Возможность мультимодального слияния: Опыт работы с взаимодействием между различными модальными данными, способность эффективно интегрировать несколько типов информации, таких как текст, изображения, аудио и т.д.

Проблемы, связанные с реализацией механизма внимания

- Вопросы вычислительной сложности: Вычислительная сложность механизма внимания растет с длиной последовательности в квадратных шагах, и при работе с длинными последовательностями он сталкивается с ограничениями по вычислительным ресурсам и памяти.

- большой объем памяти: необходимость хранения матрицы весов внимания, требования к памяти резко возрастают при большой длине последовательности, что предъявляет высокие требования к аппаратному устройству.

- Явление чрезмерного сглаживания: Иногда веса внимания распределяются слишком равномерно, в результате чего модель не может эффективно сфокусироваться на ключевой информации, что негативно сказывается на производительности модели.

- Нестабильность обученияВ частности, при многоголовом внимании скорость обучения в разных головах внимания может быть неодинаковой, что требует точной настройки гиперпараметров

- Кодирование информации о местоположенииМеханизм самонаблюдения сам по себе не учитывает местоположение и требует дополнительного кодирования местоположения для передачи информации о порядке следования.

Направления совершенствования механизма внимания

- Дизайн для эффективного внимания: Исследователи предложили множество вариантов разреженного внимания, локального внимания и т.д., чтобы уменьшить вычислительную сложность и позволить моделям обрабатывать более длинные последовательности.

- Решение для оптимизации памяти: Сокращение объема памяти с помощью таких методов, как разбивка на части и градиентная контрольная точка, чтобы механизмы внимания могли работать в условиях ограниченных ресурсов.

- Изучение структурных инноваций: Внедрение новых методов, таких как кодирование относительной позиции и кодирование вращательной позиции, для более эффективной обработки позиционных отношений и информации в последовательностях

- многомасштабное внимание: Комбинируйте различные механизмы внимания, чтобы сосредоточиться как на локальных деталях, так и на глобальном контексте для улучшения работы модели.

- Исследование теоретических основ: Расширение теоретического анализа механизмов внимания, чтобы понять, как они работают и каковы их ограничения, а также для создания более совершенных моделей.

Будущее развитие механизмов внимания

- Унифицированная кросс-модальная архитектураМеханизмы внимания должны стать фундаментальной основой для унифицированной обработки мультимодальных данных, стимулируя развитие мультимодального ИИ.

- Вдохновленные неврологией:: Дальнейшее изучение нейронных механизмов системы внимания человека для разработки более биологически обоснованной модели внимания

- адаптивное внимание: Разработка интеллектуальных систем, способных автоматически регулировать объем и точность внимания в зависимости от сложности задачи для повышения эффективности вычислений

- Повышение интерпретируемости: Сочетание техники визуализации и методов объяснения для того, чтобы сделать объяснения, предоставляемые механизмами внимания, более точными и надежными

- Развертывание пограничных устройств: Обеспечение эффективной работы моделей, основанных на внимании, на мобильных и IoT-устройствах за счет сжатия и оптимизации моделей

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...