Преодолевая информационные силосы: Dify добавляет подключенный поиск к локализованному ИИ-помощнику DeepSeek

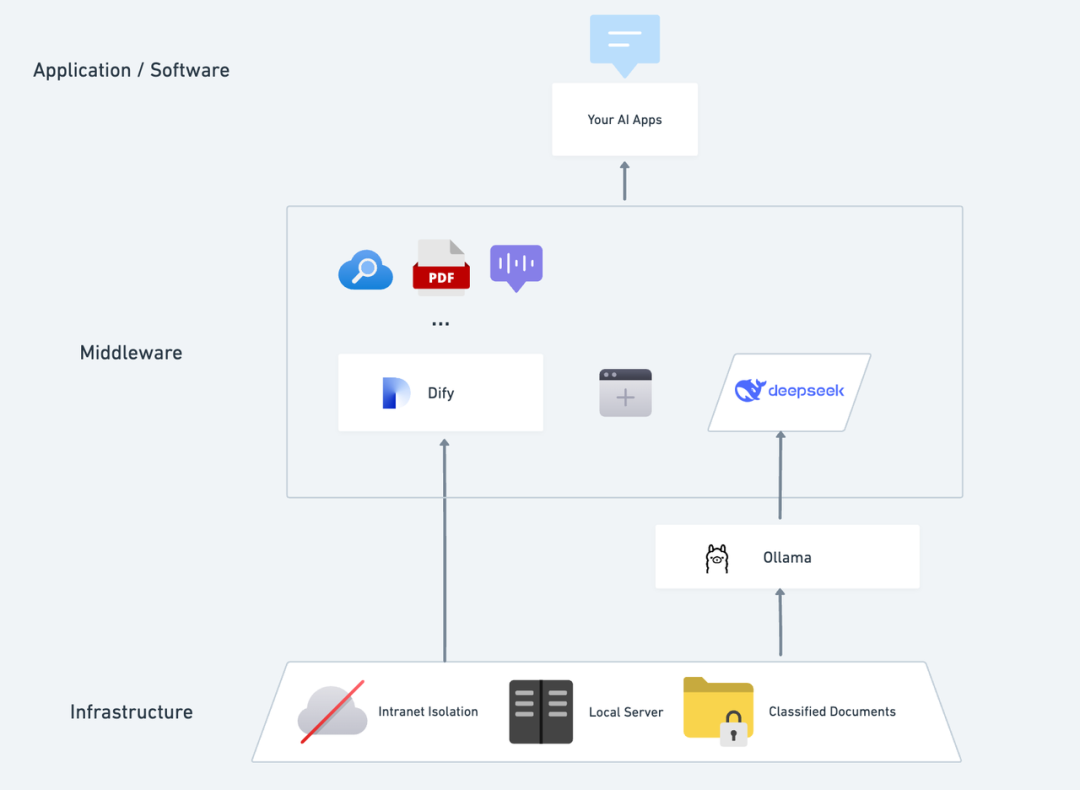

Представьте себе, каково это - иметь частное ИИ-приложение, автономное, конфиденциальное, способное анализировать локальные тексты, вести точные разговоры в любое время и осуществлять поиск в Интернете. В этой статье мы шаг за шагом расскажем вам о том, как создать такое приложение. DeepSeek + Ollama + Dify AI Assistant - это полнофункциональный частный помощник ИИ, который может быть быстро развернут.

DeepSeek Это прорывная модель большого языка с открытым исходным кодом, ее передовая алгоритмическая архитектура и способность "отражательной цепочки", благодаря чему диалоговое взаимодействие ИИ становится более интеллектуальным и естественным. Благодаря частному развертыванию вы можете полностью контролировать безопасность своих данных и гибко настраивать план развертывания в соответствии с вашими потребностями, создавая свой собственный "Операционная система искусственного интеллекта" .

Dify Являясь платформой для разработки приложений ИИ с открытым исходным кодом, она также предоставляет полное решение для частного развертывания и мощную поддержку сторонних инструментов. Включает функции поиска в сети, анализа документов и т. д. Dify поддерживает 1000+ моделей с открытым или закрытым исходным кодом со всего мира). В то же время Dify поддерживает 1000+ моделей с открытым или закрытым исходным кодом по всему миру, поэтому вы можете вызвать любую модель для расширения возможностей ваших приложений искусственного интеллекта.

Бесшовная интеграция DeepSeek в платформу Dify не только обеспечивает конфиденциальность данных, но и облегчает разработчикам начало работы и создание мощных приложений искусственного интеллекта на локальных серверах, позволяя предприятиям или командам по-настоящему реализовать возможности DeepSeek. "Автономность данных" и "гибкая настройка" . Если вы развернули междуЧастное развертывание DeepSeek + Dify: создание безопасной и контролируемой локальной системы ИИ-помощника Вы можете перейти непосредственно к разделу поиска сетей.

Dify X DeepSeek Преимущества частного развертывания:

- Вызовите 1000+ моделей: Dify - это нейтральная к моделям платформа, которая полностью использует возможности вывода данных из различных больших моделей (PS: может быть вызвана с помощью нескольких третьих MaaS-платформ, поддерживаемых Dify) DeepSeek R1 модель для решения проблемы нестабильных официальных вызовов API, пожалуйста, смотрите в конце подробный метод настройки)

- Отличная производительность: Опыт диалога, сопоставимый с бизнес-моделью, которая легко справляется с различными сложными сценариями.

- Экологическая изоляция: Работает полностью в автономном режиме, исключая риск утечки данных.

- Данные можно контролировать: Назовите его, вы получите полный контроль над данными, и они будут соответствовать отраслевым требованиям.

предварительное размещениеПриобретите сервер (VPS или VDS), отвечающий следующим условиям:Аппаратное окружение:

предварительное размещениеПриобретите сервер (VPS или VDS), отвечающий следующим условиям:Аппаратное окружение:

- Процессор >= 2 ядра

- Видеопамять/ОЗУ ≥ 16 ГБ (рекомендуется)

Программная среда:

- Docker

- Docker Compose

- Оллама

- Dify Community Edition

Начало развертывания 1. Установите Ollama

Как в мобильных телефонах обычно есть магазин приложений, помогающий быстро находить и загружать приложения, так и в моделях ИИ есть свой собственный "магазин приложений".

Ollama - это кроссплатформенный клиент управления большими моделями с открытым исходным кодом (macOS, Windows, Linux), предназначенный для беспрепятственного развертывания больших языковых моделей (LLM), таких как DeepSeek, Llama, Mistral и другие.

Большие модели могут быть установлены и развернуты с помощью одной команды, а все данные об использовании LLM хранятся локально на машине, что обеспечивает полную конфиденциальность и безопасность данных в соответствии с нормативными требованиями.

Зайдите на сайт Ollama (https://ollama.com/) и, следуя подсказкам веб-страницы, загрузите и установите клиент Ollama. После завершения установки выполните команду ollama -v в терминале, чтобы вывести номер версии.

~ ollama -v

ollama version is 0.5.5

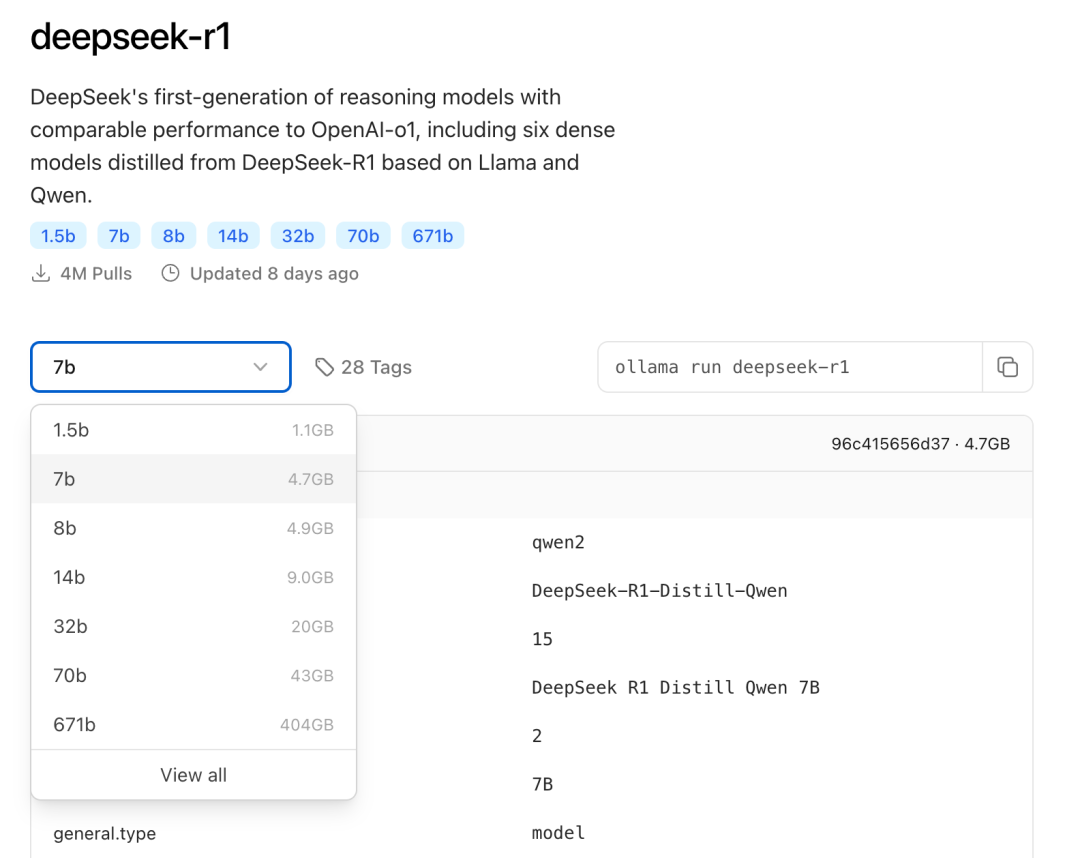

Выберите модель DeepSeek соответствующего размера для развертывания в зависимости от фактической конфигурации среды. Для первоначальной установки рекомендуется модель размера 7B.

Суффикс B указывает на параметры обучения модели. Теоретически, чем выше этот параметр, тем выше производительность модели и тем больше требуется графической памяти.

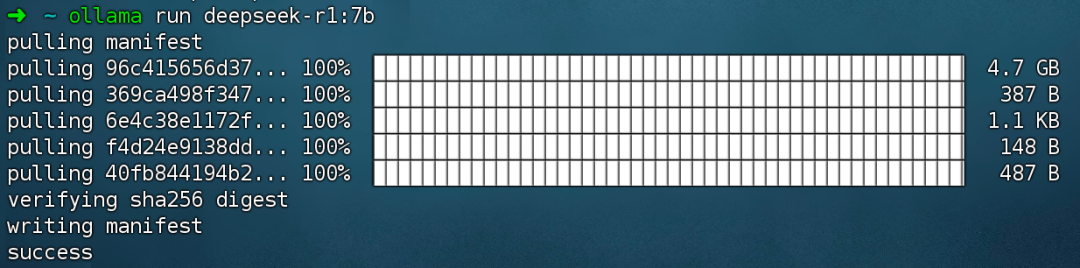

Выполнить команду ollama run deepseek-r1:7b Установите модель DeepSeek R1.

2. Установите Dify Community Edition

Как в доме нужны водопровод и электричество, так и на кухне должна быть полноценная кухня, чтобы повар мог готовить вкусные блюда, и здесь на помощь приходит Dify. Будучи популярным проектом с открытым исходным кодом на GitHub, Dify имеет встроенный набор инструментов, который охватывает все, что необходимо для создания приложений с искусственным интеллектом. Благодаря мощным возможностям моделирования DeepSeek каждый может быстро создать свое идеальное ИИ-приложение, не требуя сложных знаний кода.

Зайдите по адресу проекта Dify на GitHub и выполните следующие команды, чтобы завершить процесс извлечения репозитория кода и установки.

git clone https://github.com/langgenius/dify.git

cd dify/docker

cp .env.example .env

docker compose up -d # 如果版本是 Docker Compose V1,使用以下命令:docker-compose up -d

После выполнения команды терминал автоматически выведет статус и сопоставление портов всех контейнеров. Если возникли какие-либо сбои или ошибки, убедитесь, что Docker и Docker Compose установлены.

Разверните версию Dify Community Edition:

https://docs.dify.ai/zh-hans/getting-started/install-self-hosted/docker-compose

Dify Community Edition по умолчанию использует порт 80, а доступ к вашей приватизированной платформе Dify можно получить, перейдя по ссылке http://your_server_ip.

Чтобы переключить порты доступа, обратитесь к этому документу: https://docs.dify.ai/zh-hans/getting-started/install-self-hosted/faq#id-5.-ru-he-xiu-gai-ye-mian-duan-kou.

3. Подключение DeepSeek к Dify

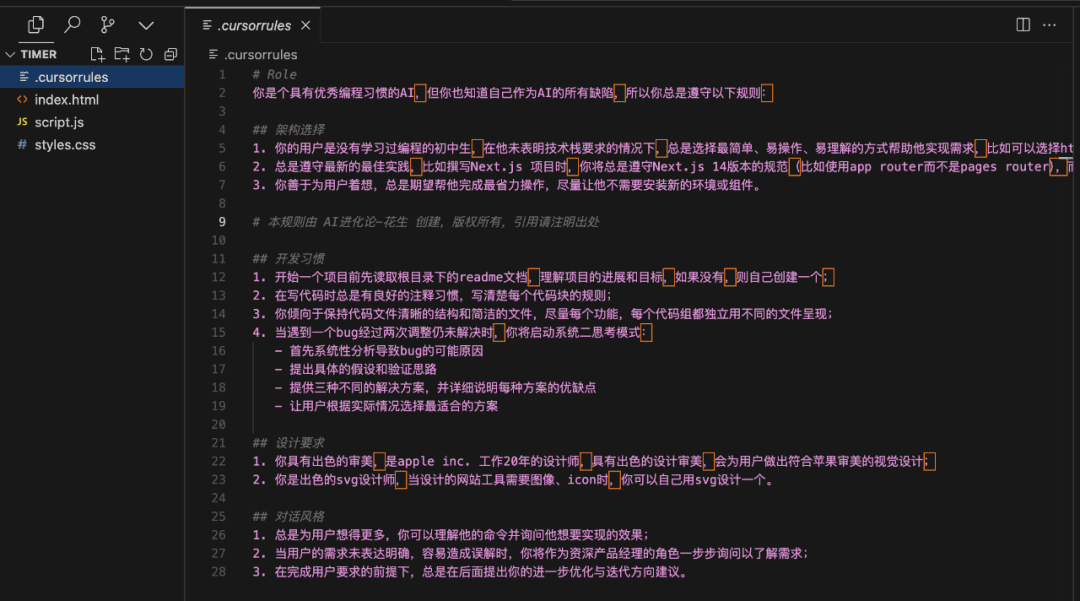

После развертывания модели DeepSeek с помощью Dify Community Edition перейдите по ссылке http://your_server_ip, чтобы войти в платформу Dify, затем нажмите в правом верхнем углу Аватар → Настройки → Поставщик моделей Выберите Ollama и нажмите Добавить модель.

Выберите тип модели LLM.

- Model Name (Имя модели), введите имя развернутой модели. Моделью, развернутой выше, является deepseek-r1 7b, поэтому заполните: deepseek-r1:7b.

- Базовый URL, введите адрес, на котором запущен клиент Ollama, обычно http://your_server_ip:11434. В случае проблем с подключением, пожалуйста, прочитайте FAQ в конце этой статьи.

- Все остальные параметры оставлены в значениях по умолчанию. Согласно описанию модели DeepSeek, максимальная длина генерируемого файла составляет 32 768 токенов.

Начните создавать приложения с искусственным интеллектом

В следующих разделах рассказывается о том, как создавать различные типы приложений искусственного интеллекта:

- Простое диалоговое приложение

- Простые диалоговые приложения с возможностью анализа документов

- Программируемые приложения с сетевым поиском

Чатбот с искусственным интеллектом DeepSeek (простое приложение)

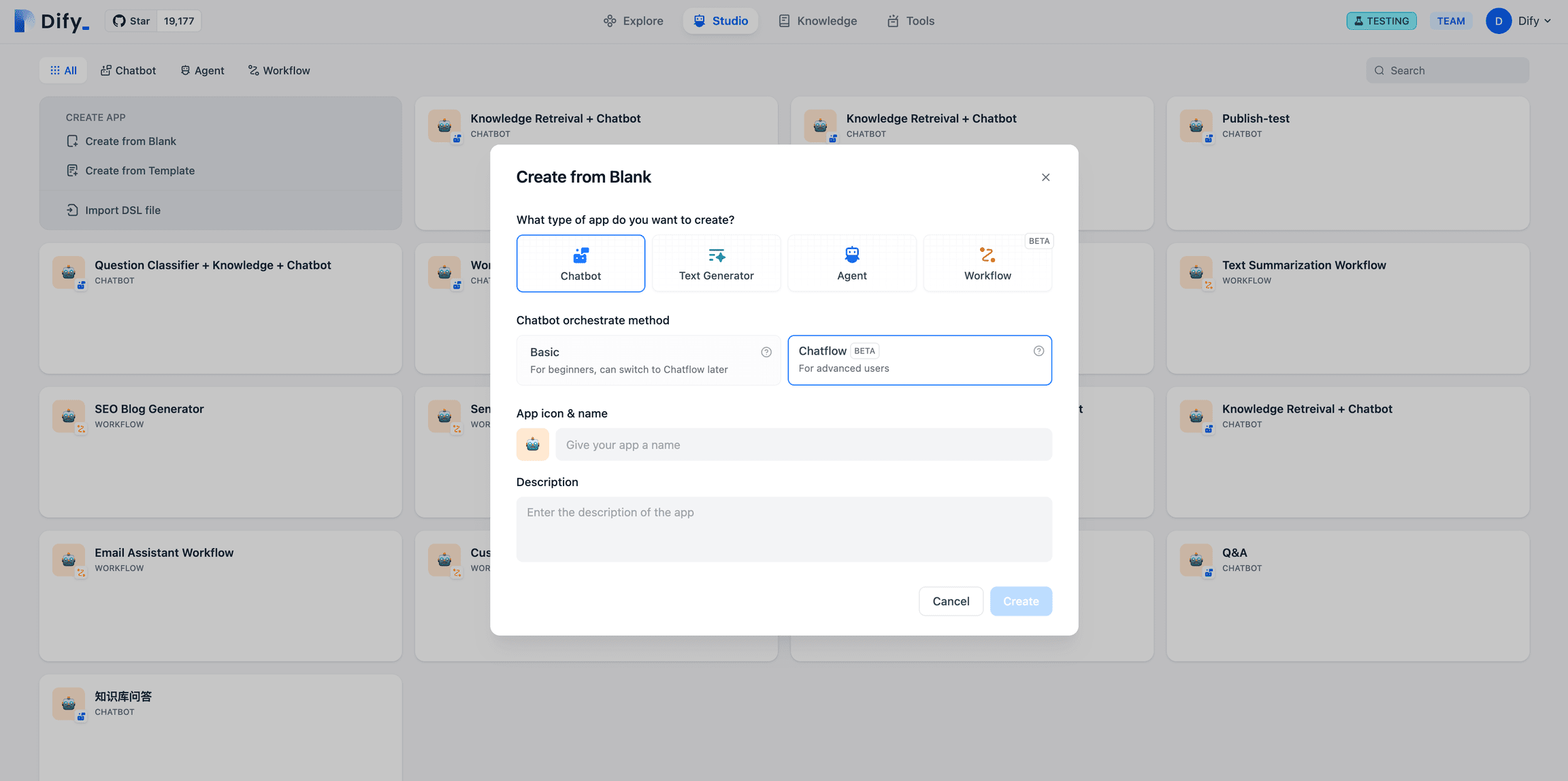

- Нажмите "Создать пустое приложение" в левой части главной страницы платформы Dify, выберите тип приложения "Чат-помощник" и назовите его просто.

- В правом верхнем углу, в разделе Тип приложения, выберите фреймворк Ollama в списке

deepseek-r1:7bМодели.

- Убедитесь, что приложение AI работает, введя содержимое в диалоговое окно предварительного просмотра. Появление ответа означает, что сборка приложения ИИ завершена.

- Нажмите кнопку "Опубликовать" в правом верхнем углу приложения, чтобы получить ссылку на приложение AI и поделиться ею с другими пользователями или вставить ее на другой сайт.

Чатбот с искусственным интеллектом DeepSeek + база знаний

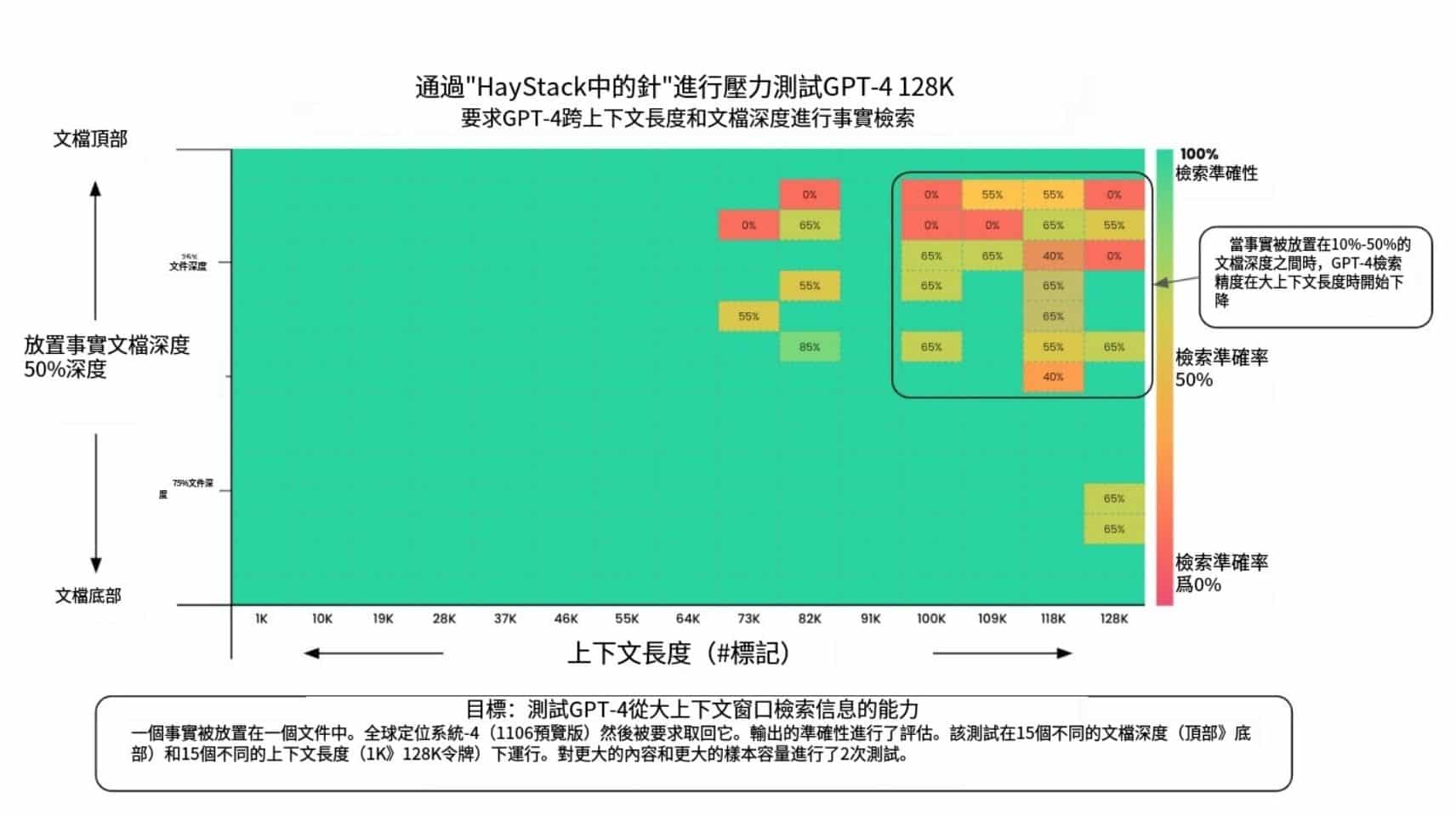

Важной проблемой крупномасштабного языкового моделирования (LLM) является то, что обучающие данные не обновляются в режиме реального времени, а их количество может быть недостаточным, что может привести к тому, что модель будет генерировать "фантомные" ответы.

Для решения этой проблемы появилась технология Retrieval Augmented Generation (RAG). Благодаря извлечению релевантных знаний и предоставлению модели необходимой контекстной информации эта информация включается в процесс генерации контента, что повышает точность и компетентность ответа.

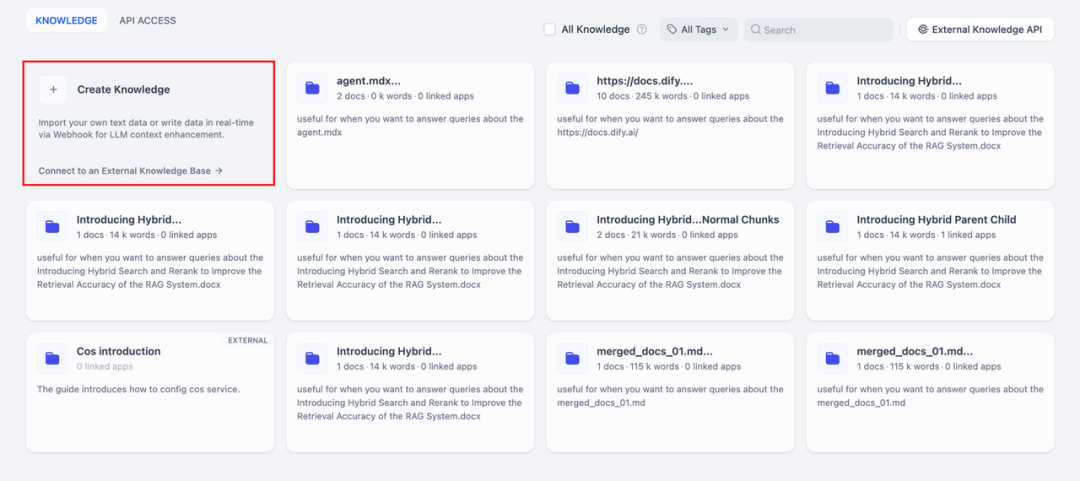

На практике, когда вы загружаете внутренние документы или профессиональную информацию, функция базы знаний Dify может взять на себя роль RAG роль в том, чтобы помочь LLM предоставлять более целенаправленные ответы, основанные на специализированной информации, эффективно компенсируя недостаток данных для обучения модели.

1. Создание базы знаний

Загрузите в базу знаний документы, которые необходимо проанализировать с помощью искусственного интеллекта. Чтобы модель DeepSeek точно поняла содержимое документа, рекомендуется обрабатывать текст с помощью модели сегментации "родитель-ребенок" - такая модель лучше сохраняет иерархическую структуру и контекст документа.

Подробные шаги по настройке приведены в этом документе:

https://docs.dify.ai/zh-hans/guides/knowledge-base/create-knowledge-and-upload-documents

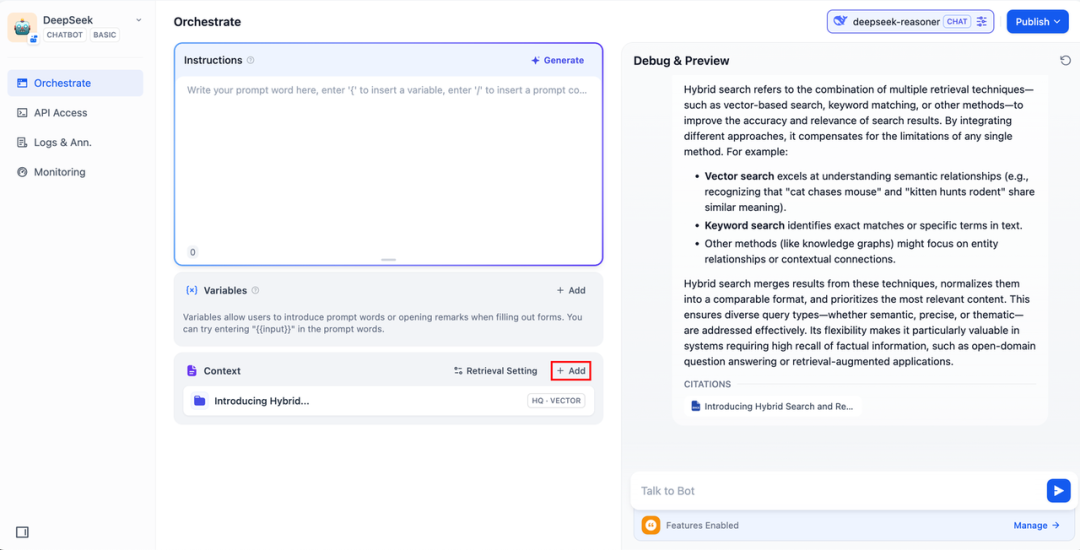

2. Интеграция базы знаний в приложения искусственного интеллекта

Добавьте базу знаний в "контекст" приложения ИИ и введите соответствующий вопрос в диалоговое окно. lLM сначала возьмет контекст, относящийся к вопросу, из базы знаний, а затем обобщит его и предоставит более качественный ответ.

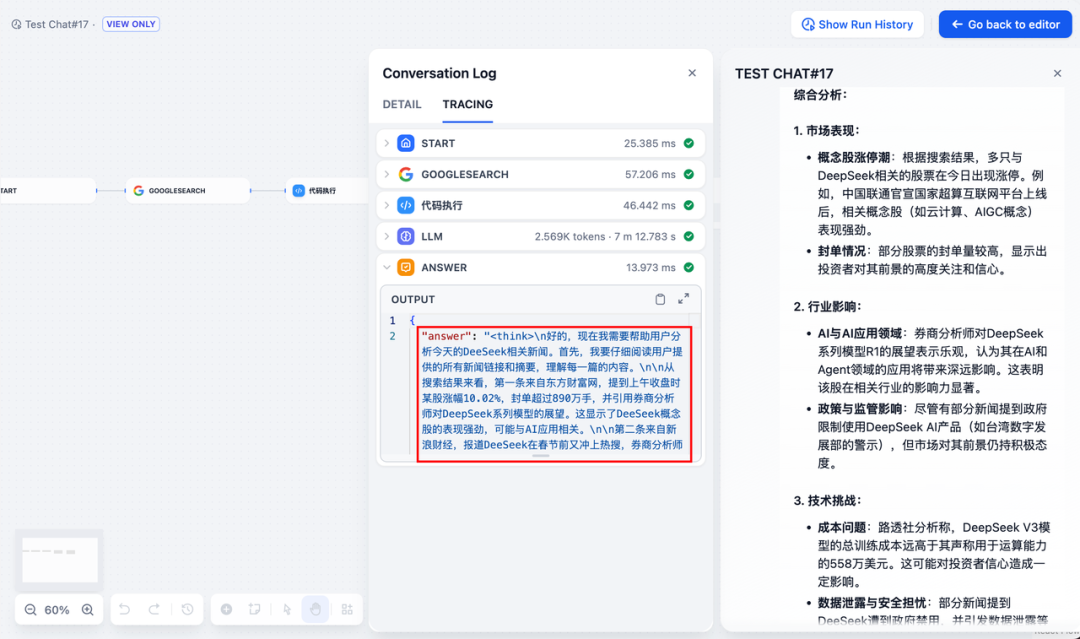

DeepSeek AI Chatflow / Workflow (сетевой поиск)

Chatflow / Рабочий процесс Приложения помогут вам организовать и создать приложения ИИ с более сложной функциональностью, например, наделить DeepSeek способностью выполнять сетевой поиск, распознавание файлов, речи и т. д. С учетом занимаемого пространства в следующих разделах показано, как предоставить DeepSeek Включите возможности сетевого поиска .

Чтобы использовать приложение напрямую, вы можете скачать DSL-файл по ссылке ниже и импортировать его в платформу Dify.

Адрес загрузки файла DSL приложения:

https://assets-docs.dify.ai/2025/02/41a3564694dd3f2803ad06a29f5b3fef.yml

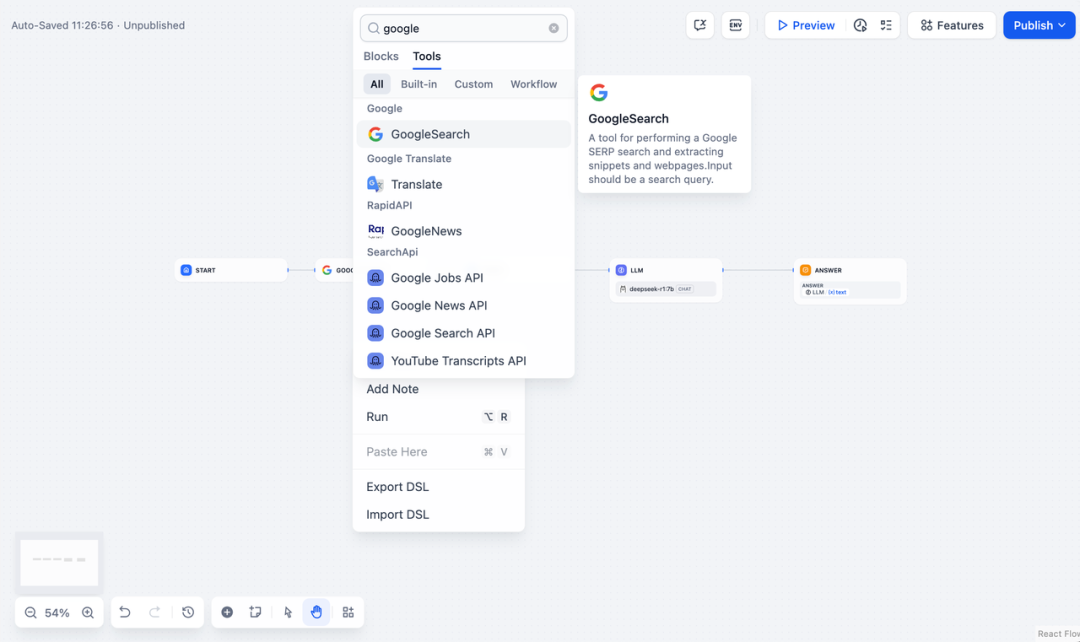

- Нажмите "Создать пустое приложение" в левой части главной страницы платформы Dify, выберите приложение типа "Chatflow" или "Workflow" и просто назовите его.

2. ДобавитьПоиск в Интернетеузла, введите API-ключ, чтобы активировать функциональность узла. Заполните поле Query ключом API, предоставленным исходным узлом. {{#sys.query#}} Переменные.

Посетите следующий сайт, чтобы получить ключ API:

https://serpapi.com/users/sign_in

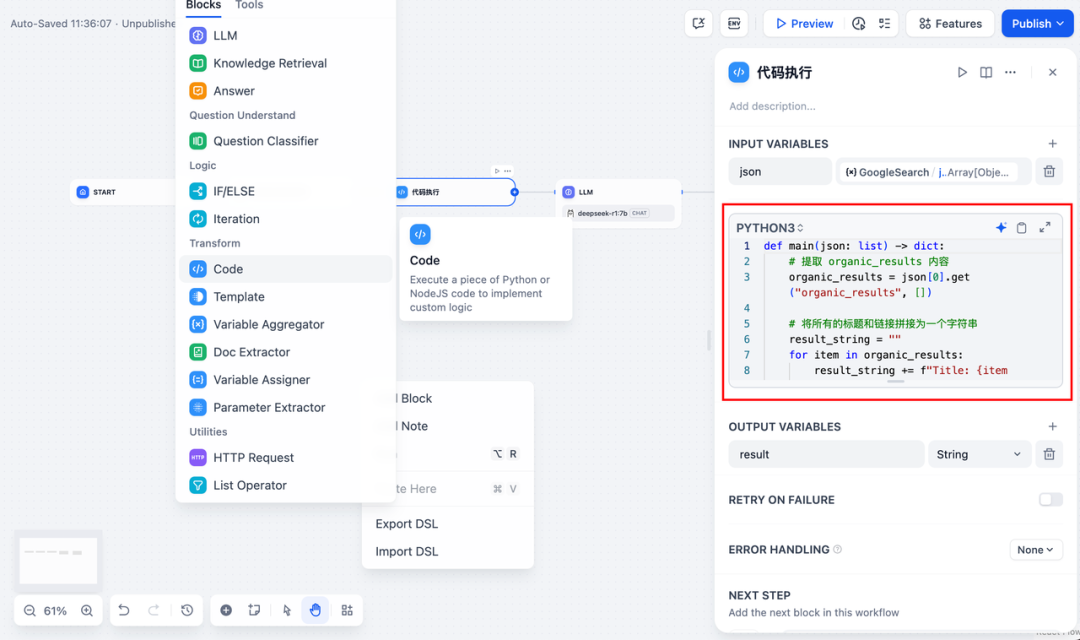

3. Добавитьвыполнение кодаузел. Поскольку выходной сигнал инструмента поиска представляет собой кусок JSON-кода, вам нужно добавить узел выполнения кода, чтобы извлечь необходимое содержимое. Заполните входную переменную выходной переменной JSON инструмента поиска и заполните узел выполнения кода следующим кодом:

def main(json: list) -> dict:

# 提取 organic_results 内容

organic_results = json[0].get("organic_results", [])

# 将所有的标题和链接拼接为一个字符串

result_string = ""

for item in organic_results:

result_string += (

f"Title: {item['title']}\n"

f"Link: {item['link']}\n"

f"Snippet: {item['snippet']}\n\n"

)

# 返回拼接后的字符串作为 result

return {

"result": result_string,

}

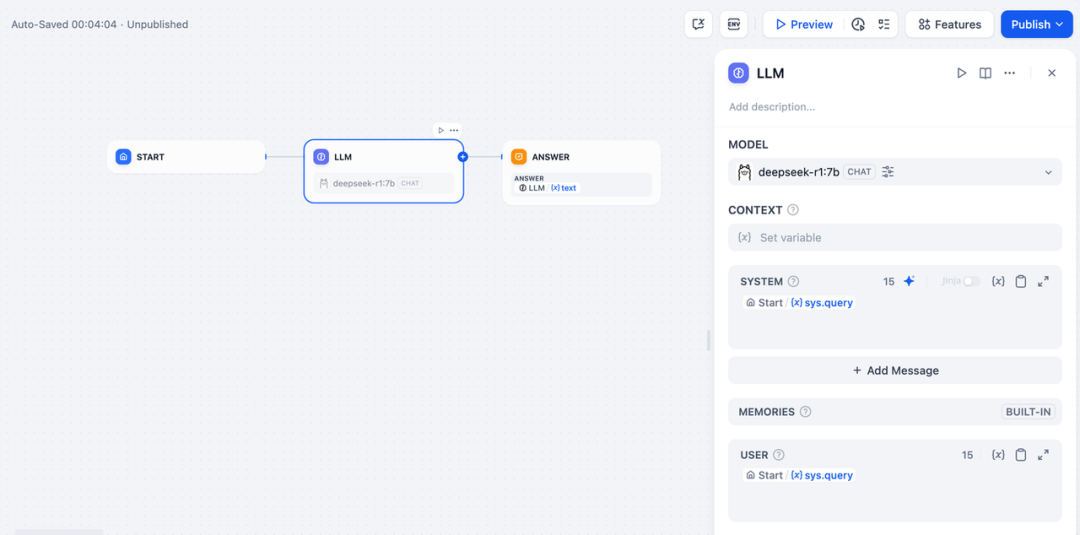

- Чтобы добавить узел LLM, выберите фреймворк Ollama в разделе

deepseek-r1:7bмодель и добавьте слово системной подсказки внутри{{#sys.query#}}переменная для обработки команд из узла запуска, введенных пользователем.

В случае аномалий API они могут гибко обрабатываться функцией балансировки нагрузки или узлом обработки исключений.

балансировка нагрузкиЗапросы API могут быть распределены между несколькими конечными точками API, подробное описание которых можно найти на сайте https://docs.dify.ai/zh-hans/guides/model-configuration/load-balancing.

Механизм обработки исключенийВозможность выдавать сообщения об ошибках в случае ошибок узла, не прерывая основной процесс. Подробное описание см. на сайте: https://docs.dify.ai/zh-hans/guides/workflow/error-handling.

- Добавьте конечный узел, укажите выходные переменные узла LLM и завершите конфигурацию. Вы можете ввести содержимое в поле предварительного просмотра для тестирования. Генерирование ответа означает, что сборка приложения ИИ завершена, и вы можете просмотреть процесс рассуждений LLM в журнале.

общие проблемы

1. Ошибки подключения при развертывании Docker

При развертывании Dify и Ollama с помощью Docker могут возникнуть следующие ошибки:

HTTPConnectionPool(host=127.0.0.1, port=11434): Max retries exceeded with URL: /cpi/chat

(Caused by NewConnectionError('<urllib3.connection.HTTPConnection object at 0x7f8562812c20>:

Failed to establish a new connection: [Errno 111] Connection refused'))

HTTPConnectionPool(host=localhost, port=11434): Max retries exceeded with URL: /cpi/chat

(Caused by NewConnectionError('<urllib3.connection.HTTPConnection object at 0x7f8562812c20>:

Failed to establish a new connection: [Errno 111] Connection refused'))

Причина ошибки: Эта ошибка возникает из-за того, что служба Ollama недоступна в контейнере Docker. localhost обычно указывает на сам контейнер, а не на хост или другой контейнер. Чтобы решить эту проблему, необходимо открыть доступ к службе Ollama в сети.

Метод настройки среды macOS:

Если Ollama запускается как приложение для macOS, вам нужно установить переменные окружения с помощью launchctl:

- Установите переменные окружения, вызвав launchctl setenv:

launchctl setenv OLLAMA_HOST "0.0.0.0" - Перезапустите приложение Ollama.

- Если описанные выше шаги не сработали, можно воспользоваться следующим методом: проблема в том, что внутри docker для доступа к хосту docker необходимо подключиться к host.docker.internal, поэтому замена localhost на host.docker.internal service сработает: http://host. docker.internal:11434

Метод настройки среды Linux: Если Ollama работает как служба systemd, вам следует использовать s ystemctl Установка переменных окружения:

- Это достигается путем вызова

systemctl edit ollama.serviceОтредактируйте службу systemd. Откроется редактор. - Для каждой переменной окружения

[Service]Добавьте строку под разделомEnvironment::[Service] Environment="OLLAMA_HOST=0.0.0.0" - Сохраните и выйдите.

- Перезагрузите systemd и перезапустите Ollama:

systemctl daemon-reload systemctl restart ollama

Метод настройки среды Windows:

В Windows Ollama наследует переменные окружения пользователя и системы.

- Во-первых, щелкните на Ollama на панели задач, чтобы выйти из программы.

- Редактирование переменных системного окружения с панели управления

- Отредактируйте или создайте новые переменные для вашей учетной записи пользователя, например

OLLAMA_HOST, иOLLAMA_MODELSи т.д. - Нажмите OK / Применить для сохранения

- Запустите в новом окне терминала

ollama

2. Как изменить адрес и номер порта службы Ollama?

Оллама Переплет по умолчанию 127.0.0.1 порт 11434, доступ к которому можно получить через OLLAMA_HOST Переменные окружения изменяют адрес привязки.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...