Tarsier: модель понимания видео с открытым исходным кодом для создания высококачественных видеоописаний

Общее введение

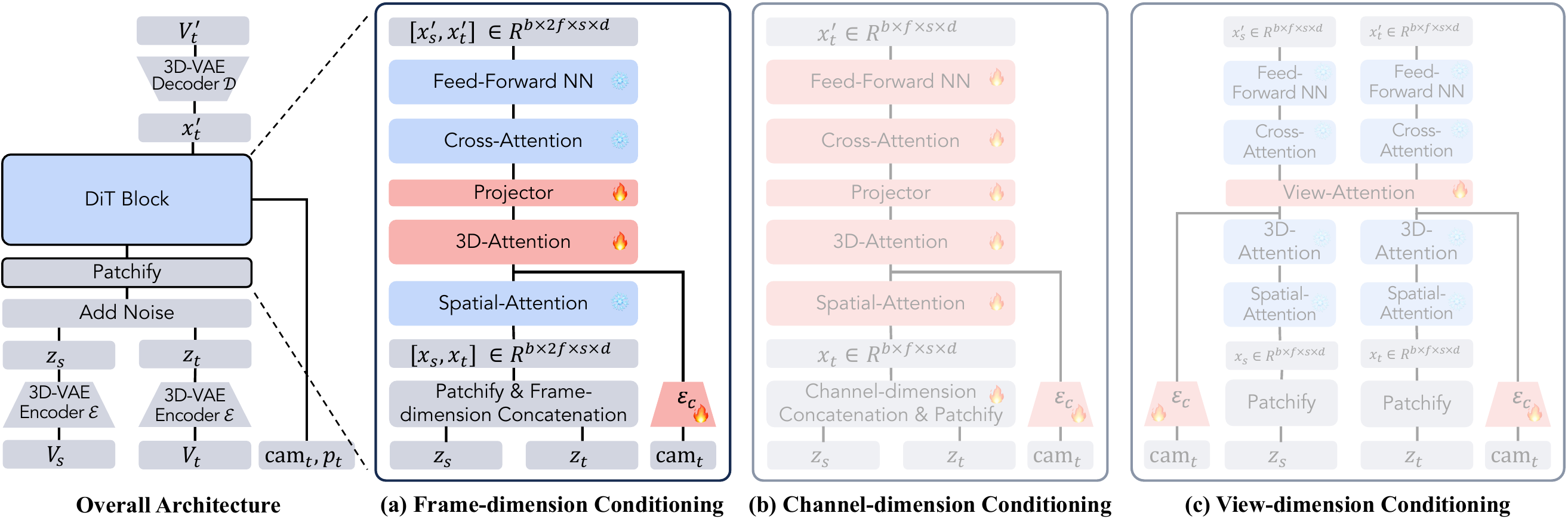

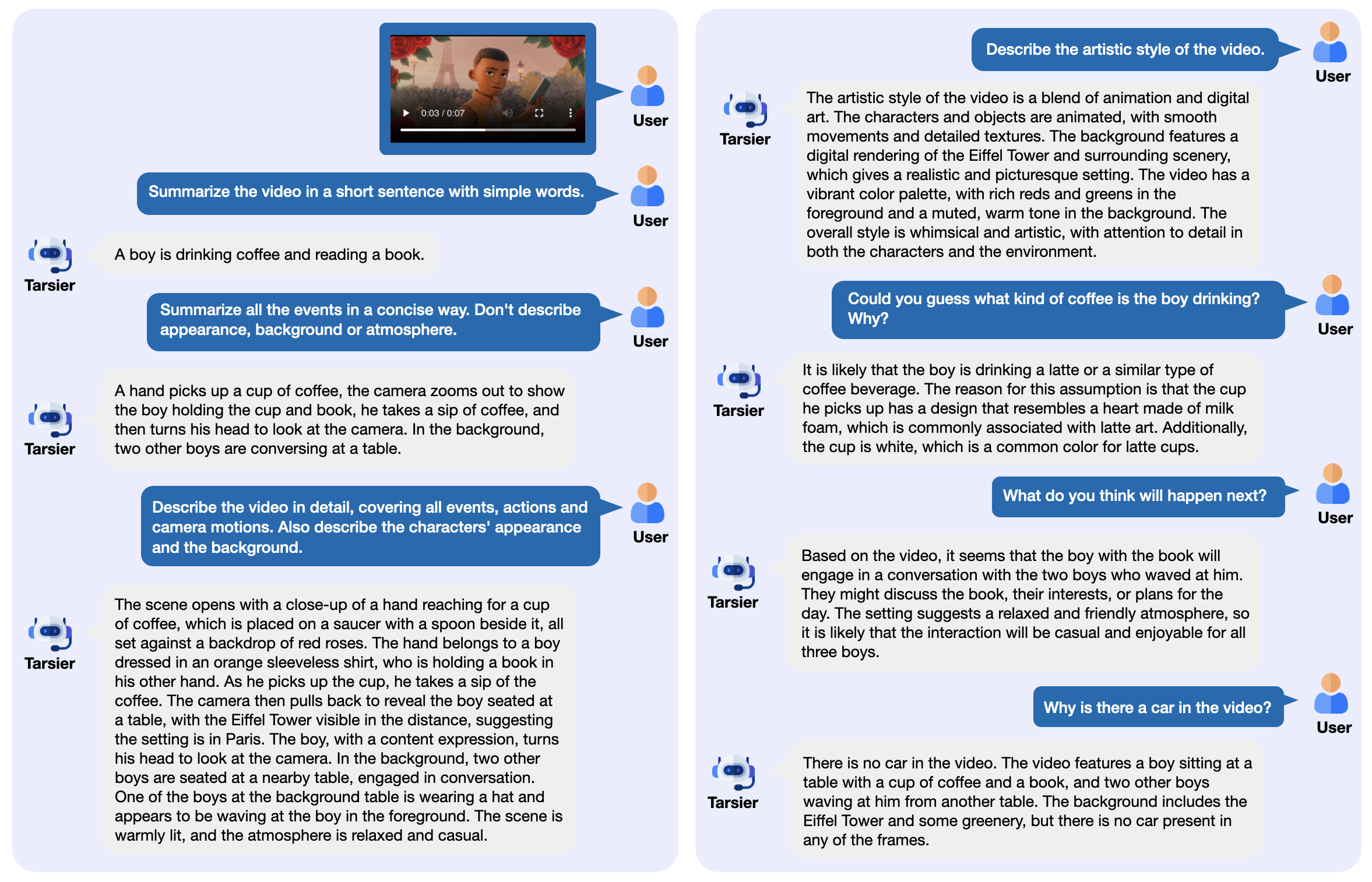

Tarsier - это семейство моделей видеоязыка с открытым исходным кодом, разработанное компанией ByteDance и используемое в основном для создания высококачественных видеоописаний. Оно состоит из простой структуры: CLIP-ViT обрабатывает видеокадры и анализирует временные отношения в сочетании с большой языковой моделью (LLM). Последняя версия, Tarsier2-7B (выпущена в январе 2025 года), достигла высшего уровня в 16 публичных бенчмарках и может конкурировать с такими моделями, как GPT-4o. Tarsier поддерживает описание видео, вопросы и ответы, а также генерацию субтитров с нулевой выборкой, а код, модели и данные находятся в открытом доступе на GitHub. Проект также запустил бенчмарк DREAM-1K для оценки возможностей видеоописания, который содержит 1000 разнообразных видеоклипов.

Список функций

- Генерируйте подробные описания видео: анализируйте видеоконтент и выводите подробный текст.

- Поддержка вопросов и ответов на видео: отвечайте на вопросы, связанные с видео, например, о событиях или деталях.

- Генерация субтитров с нулевой выборкой: создание субтитров для видео без обучения.

- Многозадачное понимание видео: отлично справляется с несколькими задачами, такими как викторина и создание титров.

- Развертывание с открытым исходным кодом: предоставление весов модели и кода для запуска локально или в облаке.

- Предоставляет инструменты оценки: включает набор данных DREAM-1K и методологию оценки AutoDQ.

Использование помощи

Tarsier подходит для пользователей с техническим образованием, таких как разработчики или исследователи. Ниже приведены подробные инструкции по установке и использованию.

Процесс установки

- Подготовка среды

Требуется Python 3.9 или более поздняя версия. Рекомендуется использовать виртуальную среду:

conda create -n tarsier python=3.9

conda activate tarsier

- склад клонов

Загрузите код проекта Tarsier:

git clone https://github.com/bytedance/tarsier.git

cd tarsier

git checkout tarsier2

- Установка зависимостей

Запустите сценарий установки:

bash setup.sh

Это позволит установить все необходимые библиотеки, такие как PyTorch и инструменты Hugging Face.

- Поддержка графического процессора (опционально)

Если у вас есть графический процессор NVIDIA, установите PyTorch с CUDA:

pip install torch torchvision --index-url https://download.pytorch.org/whl/cu118

- Скачать модели

Загрузите модели с сайта Hugging Face, например Tarsier2-7B:

huggingface-cli download omni-research/Tarsier2-7b

Другие модели, такие как Tarsier-34b или Tarsier2-Recap-7b, также доступны по официальным ссылкам.

- Проверка установки

Запустите сценарий быстрого тестирования:

python3 -m tasks.inference_quick_start --model_name_or_path path/to/Tarsier2-7b --input_path assets/videos/coffee.gif

На выходе должно получиться описание видео, например "Мужчина берет кофейную чашку с пенкой в форме сердца и делает глоток".

Основные функции

Создайте описание видео

- перейти

- Подготовьте видеофайл (поддерживаются такие форматы, как MP4, GIF и т.д.).

- Выполнить команду:

python3 -m tasks.inference_quick_start --model_name_or_path path/to/Tarsier2-7b --instruction "Describe the video in detail." --input_path your/video.mp4

- Выходные данные отображаются в терминале, например, описание действий и сцен в видео.

- принимать к сведению

- Слишком длинные видео могут потребовать больше памяти, поэтому мы рекомендуем сначала протестировать короткое видео.

- Настраиваемые параметры, такие как частота кадров (см.

configs/tarser2_default_config.yaml).

Видео вопросы и ответы

- перейти

- Укажите вопросы и видеоролики:

python3 -m tasks.inference_quick_start --model_name_or_path path/to/Tarsier2-7b --instruction "视频里的人在做什么?" --input_path your/video.mp4

- Выдайте прямой ответ, например, "Он пьет кофе".

- привлекать внимание к чему-л.

- Вопросы должны быть конкретными и не допускать двусмысленности.

- Поддержка китайского и других языков, лучше всего работает китайский.

Генерация субтитров с нулевым образцом

- перейти

- Измените файл конфигурации, чтобы включить режим субтитров (

configs/tarser2_default_config.yamlустанавливатьtask: caption). - Бег:

python3 -m tasks.inference_quick_start --model_name_or_path path/to/Tarsier2-7b --config configs/tarser2_default_config.yaml --input_path your/video.mp4

- Выводит короткие субтитры, например "Пить кофе в одиночестве".

Развертывание местных служб

- перейти

- Установите vLLM (рекомендуется версия 0.6.6):

pip install vllm==0.6.6

- Начните обслуживание:

python -m vllm.entrypoints.openai.api_server --model path/to/Tarsier2-7b

- Вызывается с помощью API:

curl http://localhost:8000/v1/completions -H "Content-Type: application/json" -d '{"prompt": "描述这个视频", "video_path": "your/video.mp4"}'

- vantage

- Видео можно обрабатывать партиями.

- Легкая интеграция в другие системы.

Функциональное управление

Оценка DREAM-1K

- перейти

- Загрузите набор данных DREAM-1K:

wget https://tarsier-vlm.github.io/DREAM-1K.zip

unzip DREAM-1K.zip

- Оперативная оценка:

bash scripts/run_inference_benchmark.sh path/to/Tarsier2-7b output_dir dream

- На выходе получаются метрики, такие как оценки F1, которые показывают качество описания.

Оценка AutoDQ

- перейти

- Обеспечьте установку ChatGPT зависимости (требуется настройка Azure OpenAI).

- Запустите сценарий оценки:

python evaluation/metrics/evaluate_dream_gpt.py --pred_dir output_dir/dream_predictions

- Выводит автоматизированный оценочный балл, измеряющий точность описания.

Часто задаваемые вопросы

- нарушение монтажа: Проверьте версию Python и сеть, обновите pip (

pip install -U pip). - Медленная загрузка модели: Убедитесь, что у вас достаточно места на диске, рекомендуется не менее 50 ГБ.

- Отсутствие выхода GPU: Беги

nvidia-smiУбедитесь, что CUDA работает правильно.

Опыт работы в Интернете

- интервью Онлайн-демонстрация Tarsier2-7BЕсли вы хотите протестировать описание и функцию вопросов и ответов, загрузите видео.

Выполнив эти шаги, вы сможете легко справляться с задачами, связанными с видео, с помощью Tarsier. Будь то создание описаний или развертывание сервисов - все просто и эффективно.

сценарий применения

- Составление видеоматериалов

Работники СМИ могут использовать Tarsier для создания кратких видеозаписей и быстрой организации отснятого материала. - Учебная видеопомощь

Преподаватели могут создавать субтитры или тесты для видеокурсов, чтобы повысить эффективность преподавания и обучения. - Короткий видеоанализ

Маркетологи могут анализировать содержание коротких видеороликов, таких как TikTok, и извлекать из них ключевые сообщения для продвижения.

QA

- Какие форматы видео поддерживаются?

Поддержка MP4, GIF, AVI и т.д., если FFmpeg может их декодировать. - Каковы требования к оборудованию?

Минимум 16 ГБ оперативной памяти и 4 ГБ видеопамяти, рекомендуется графический процессор NVIDIA (например, 3090). - Есть ли он в продаже?

Да, Tarsier использует лицензию Apache 2.0, и коммерческое использование разрешено в соответствии с условиями.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие посты

Нет комментариев...