Qwen2.5-Max на основе архитектуры MoE полностью превосходит DeepSeek V3

Обзор моделей

В последние годы обучение больших моделей на основе архитектуры Mixture of Experts (MoE) стало важным направлением исследований в области искусственного интеллекта. Команда Qwen недавно выпустила модель Qwen2.5-Max, в которой используется более 20 триллионов токенов данных предварительного обучения и усовершенствованная схема пост-обучения, и совершила прорыв в масштабировании применения архитектуры MoE. Прогресс. Модель теперь доступна на сайтеИнтерфейс APIвозможноЧат с друзьямиплатформа для опыта.

Технические характеристики

1. Инновации в архитектуре моделей

- Оптимизация с помощью гибридной экспертной системыЭффективное распределение вычислительных ресурсов с помощью механизмов динамической маршрутизации

- Мультимодальная масштабируемостьПоддерживает множество типов входных и выходных данных, таких как текст, структурированные данные и т.д.

- повышение контекстуальностиМаксимальный объем ввода: 30 720 лексем, можно генерировать непрерывный текст объемом до 8 192 лексем.

2. Основная функциональная матрица

| функциональное измерение | Технические индикаторы |

|---|---|

| Поддержка нескольких языков | Охват 29 языков (включая китайский/английский/французский/испанский и т.д.) |

| вычислительные возможности | Сложные математические операции и генерация кода |

| Структурированная обработка | Формирование и разбор данных в формате JSON/Table |

| понимание контекста | Генерация конкатенации текста длиной 8 тыс. лексем |

| пригодность к применению | Диалоговые системы/анализ данных/рассуждения на основе знаний |

Оценка производительности

Сравнение командных моделей

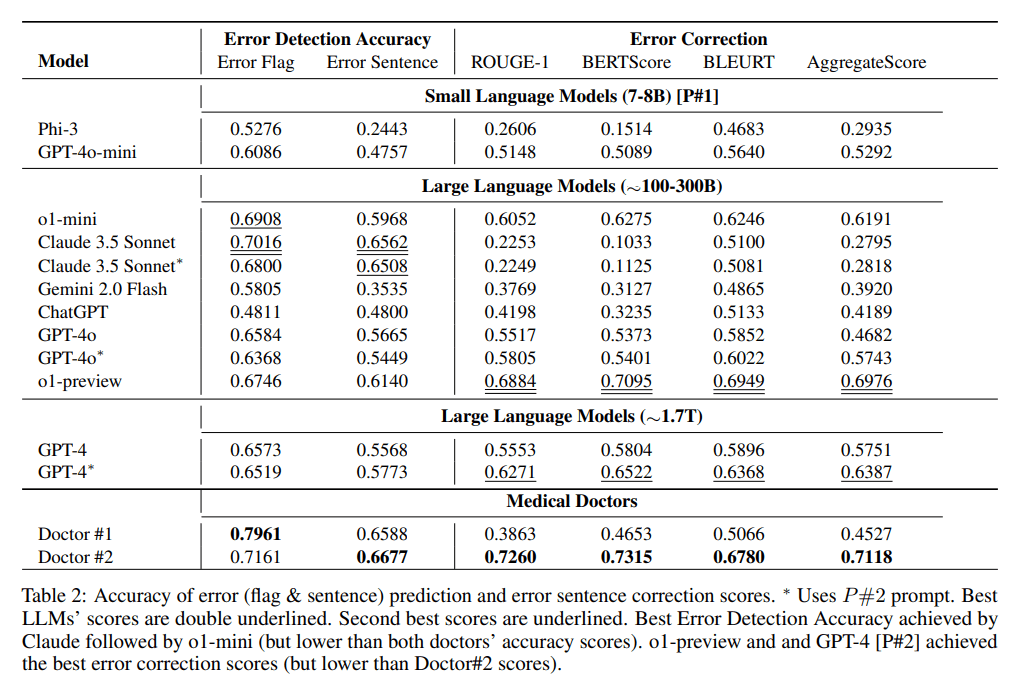

Qwen2.5-Max демонстрирует значительную конкурентоспособность в таких эталонных тестах, как MMLU-Pro (тест на знание университета), LiveCodeBench (оценка способностей к программированию) и Arena-Hard (симуляция человеческих предпочтений):

Данные тестирования показывают, что модель превосходит DeepSeek V3 в измерениях способности к программированию (LiveCodeBench) и интегрированных рассуждений (LiveBench), а также достигает высшего уровня в тесте GPQA-Diamond на рассуждения высокого порядка.

Сравнение базовых моделей

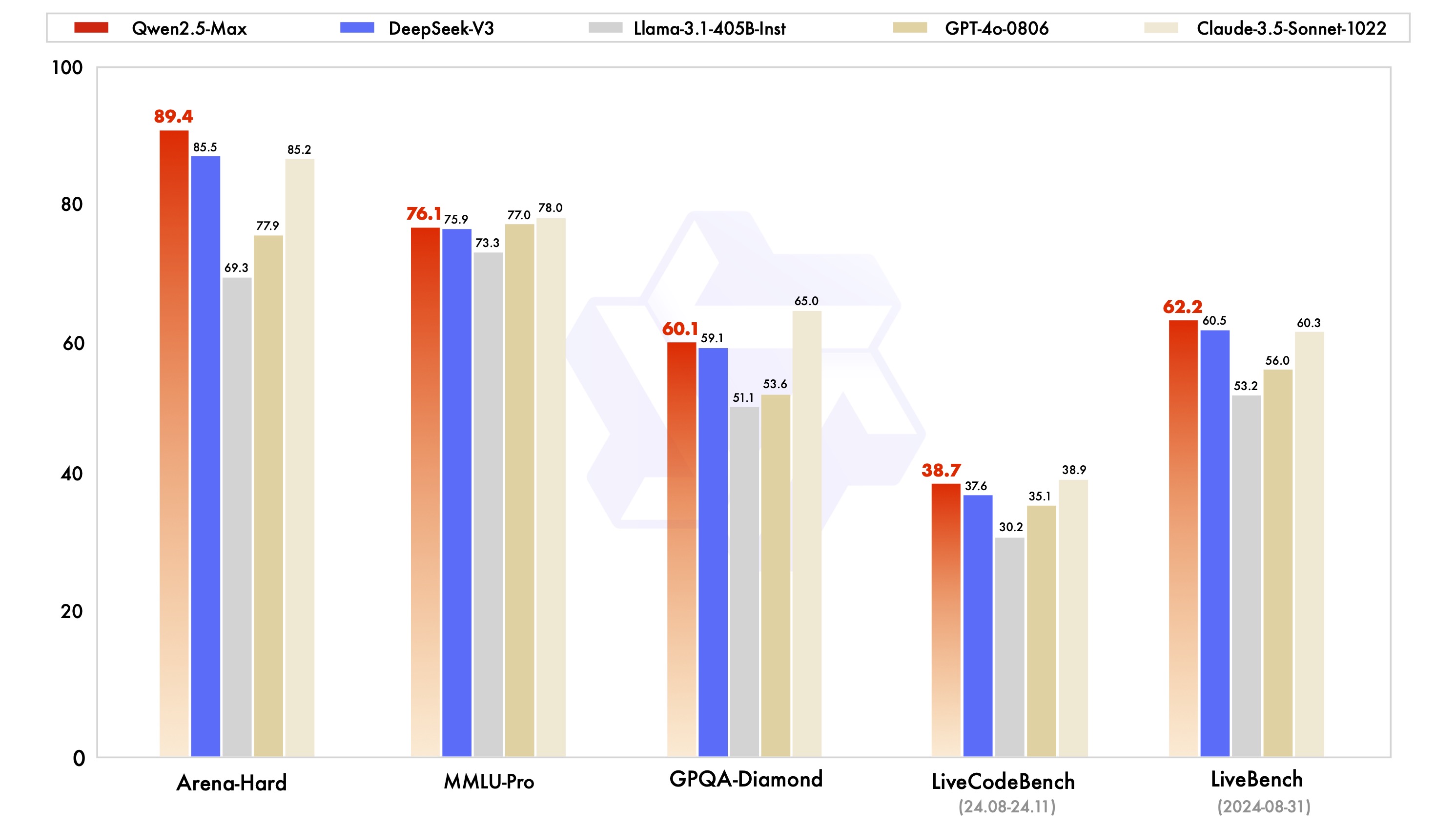

По сравнению с основными моделями с открытым исходным кодом, Qwen2.5-Max демонстрирует технические преимущества на уровне базовых возможностей:

При сравнении Llama-3.1 со шкалой параметров 405B и Qwen2.5-72B с 720B параметрами, Qwen2.5-Max сохраняет лидерство в большинстве тестовых элементов, подтверждая эффективность архитектуры MoE при масштабировании модели.

Доступ и использование

1. доступ к облачному API

from openai import OpenAI

import os

client = OpenAI(

api_key=os.getenv("API_KEY"),

base_url="https://dashscale.aliyuncs.com/compatible-mode/v1",

)

response = client.chat.completions.create(

model="qwen-max-2025-01-25",

messages=[

{'role':'system', 'content':'设定AI助手角色'},

{'role':'user', 'content':'输入查询内容'}

]

)

2. Интерактивный опыт

- интервьюДемонстрационный космос с обнимающимися лицами

- Запуск кнопки Run для загрузки модели

- Взаимодействие в режиме реального времени с помощью поля ввода текста

3. развертывание предприятия

- зачислениеСчет Алиюн

- Запуск платформы для обслуживания крупных моделей

- Создание ключей API для интеграции в систему

Направление эволюции технологии

Текущая версия постоянно оптимизируется в следующих областях:

- Стратегии повышения качества данных после обучения

- Совместная работа нескольких специалистов для оптимизации эффективности

- Ускорение рассуждений с низким потреблением ресурсов

- Разработка мультимодального расширенного интерфейса

прогноз на будущее

Постоянное улучшение масштаба данных и параметров модели может эффективно повысить уровень интеллекта модели. Далее мы продолжим исследования, в дополнение к масштабированию предварительного обучения, мы будем активно инвестировать в масштабирование обучения с подкреплением, надеясь достичь интеллекта, превосходящего человеческий, и подтолкнуть ИИ к исследованию неизвестной сферы.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...