Извлечение предложения.

Оригинал: TheПоиск по плотным иксам: какую зернистость поиска следует использовать?Сайт

Примечание: Этот метод подходит для небольшого количества моделей, таких как серия OPENAI, серия Claude, Mixtral, Yi, qwen и так далее.

рефераты

В задачах обработки естественного языка (NLP) с открытым доменом плотный поиск стал важным методом получения релевантных контекстуальных знаний или знаний о мире. Когда мы используем обученные плотные ретриверы для поиска корпораций во время вывода, часто упускается из виду выбор единицы поиска, то есть гранулярность, с которой индексируется корпус, например, документы, параграфы или предложения. Мы обнаружили, что выбор единицы поиска существенно влияет на производительность поиска, а также на выполнение последующих задач. В отличие от традиционного подхода, использующего абзацы или предложения, мы вводим новую единицу поиска - предложения - для интенсивного поиска. Пропозиции определяются как атомарные выражения в тексте, каждое из которых содержит уникальный факт и представлено в кратком, самодостаточном формате естественного языка. Мы эмпирически сравнили различные уровни детализации поиска. Наши результаты показывают, что поиск по предложениям значительно превосходит традиционные подходы, основанные на абзацах или предложениях, при поиске по плотному тексту. Кроме того, поиск по предложениям повышает производительность последующих задач, связанных с вопросно-ответными заданиями (QA), поскольку найденный текст более компактно содержит информацию, относящуюся к вопросу, сокращая потребность в длинных входных лексемах и минимизируя включение нерелевантной информации.

1 Введение

Плотные ретриверы - это класс методов, используемых для доступа к внешним источникам информации для решения наукоемких задач. Прежде чем мы сможем использовать обученный плотный ретривер для извлечения информации из корпуса, необходимо принять важное решение о единице поиска - т. е. о том, с какой степенью детализации мы будем сегментировать и индексировать полученный корпус в наших рассуждениях. На практике выбор единиц поиска, например, документов, фрагментов абзацев или предложений фиксированной длины и т. д., обычно предопределен тем, как была создана или обучена модель плотного поиска.

В этой статье мы исследуем вопрос, которому не уделялось должного внимания в рассуждениях о плотном поиске: на какой гранулярности следует сегментировать и индексировать корпус поиска? Мы обнаружили, что выбор подходящей гранулярности поиска во время рассуждения может быть простой, но эффективной стратегией для улучшения производительности плотных ретриверов как для поиска, так и для последующих задач.

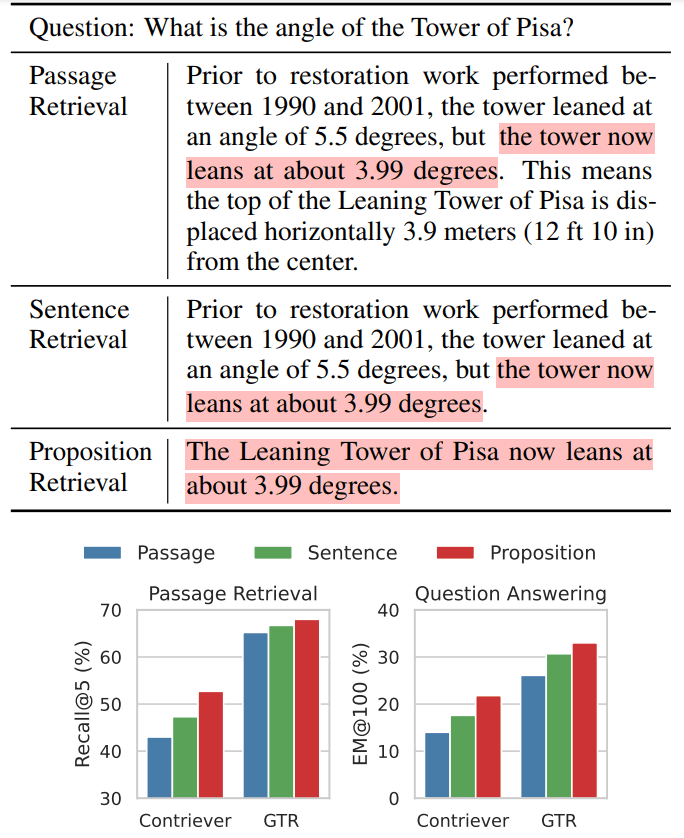

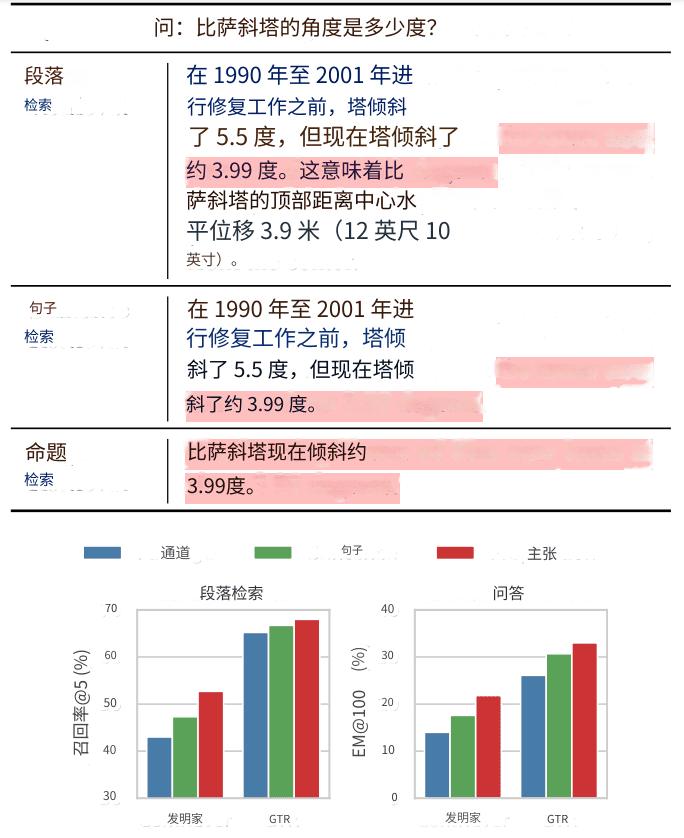

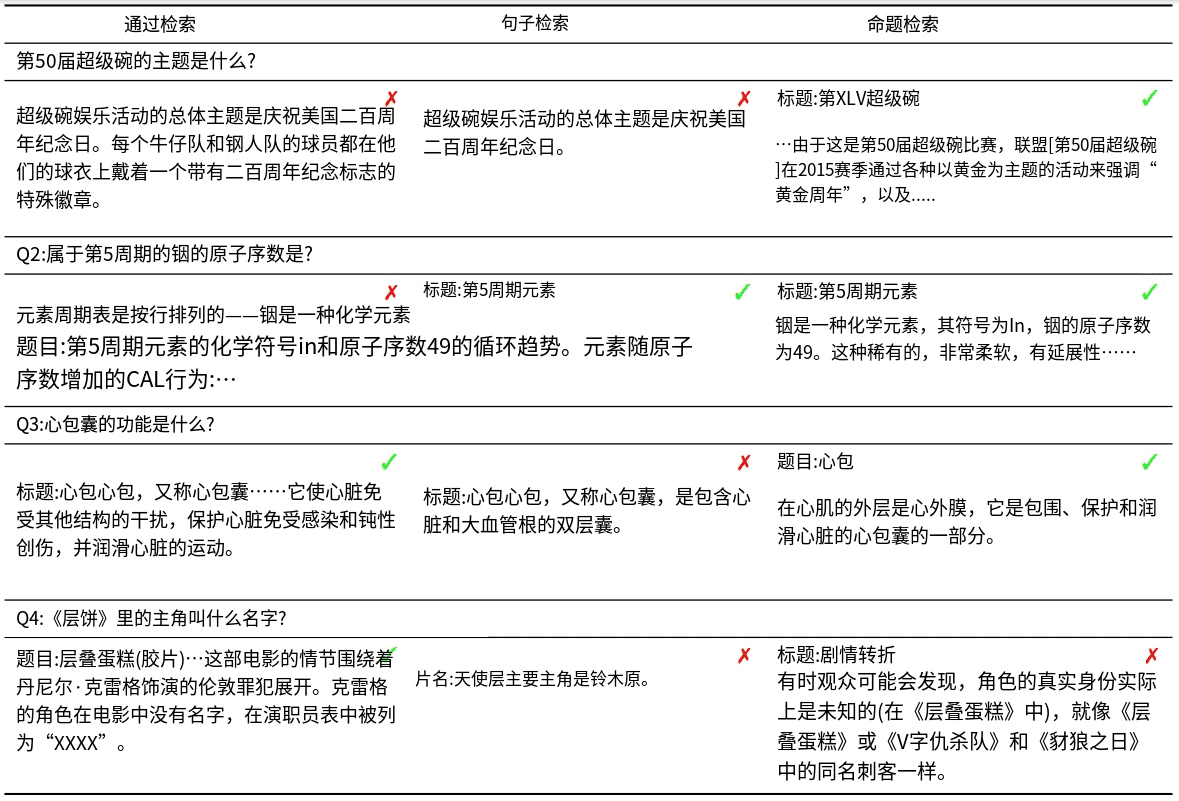

Мы проиллюстрируем нашу интуицию на примере вопросов и ответов (QA) в открытой области (табл. 1).

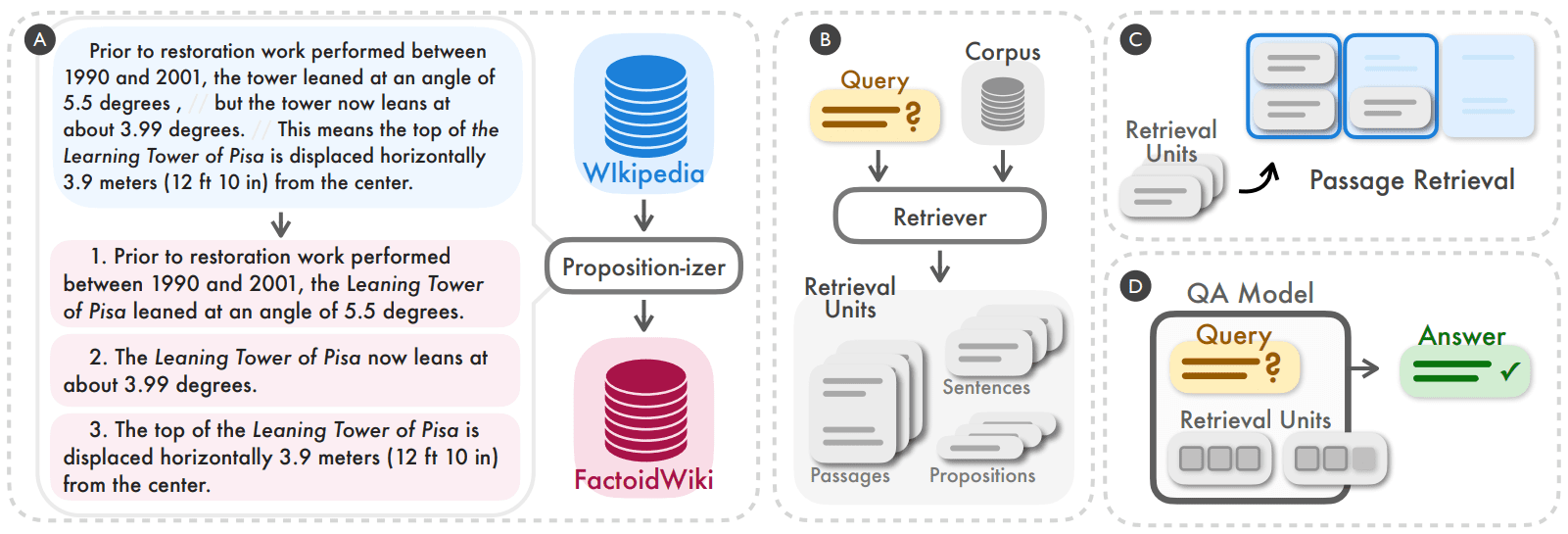

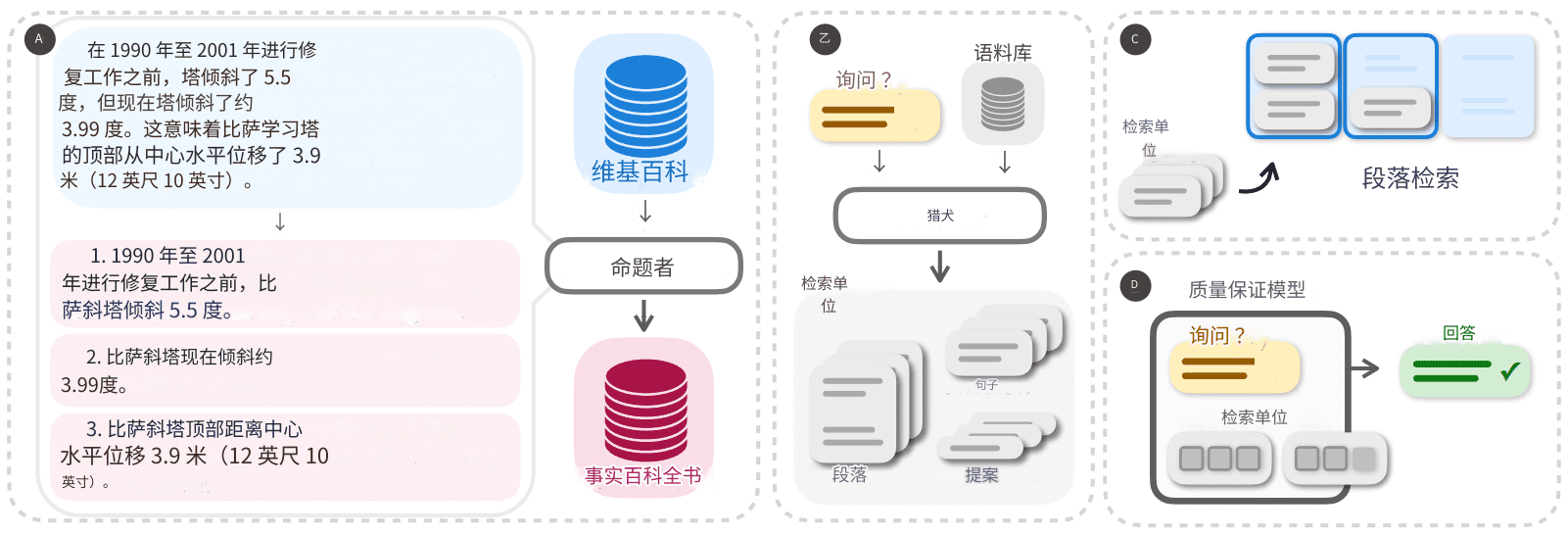

Таблица 1 Рисунок 1: Примеры трех градаций поиска в тексте Википедии при интенсивном поиске

Вверху: Демонстрация того, что текст Википедии может быть разделен на три различные поисковые единицы при использовании метода плотного поиска.

ВТОРОЙ: Мы заметили, что поиск с помощью предложений (пропозиций) дал наилучшие результаты как в задачах поиска абзацев, так и в задачах поиска вопросов-ответов (QA) в открытом домене. Например, в качестве базовых ретриверов использовались Contriever (Izacard et al., 2022) или GTR (Ni et al., 2022). Выделены разделы, содержащие ответы на вопросы.

В этом примере показано, как одна и та же модель извлекает текст на трех разных уровнях детализации. Теоретически отрывки, представляющие более крупный уровень детализации, могут содержать больше релевантной информации для вопроса. Однако абзацы часто содержат дополнительные детали, которые могут отвлекать внимание ретривера и языковой модели последующей задачи (например, период восстановления и горизонтальное перемещение в примере в таблице 1). Индексация на уровне предложений, с другой стороны, обеспечивает более детальный подход, но не решает эту проблему полностью. Это связано с тем, что предложения могут быть сложными и составными, и, как правило, они не являются самодостаточными, в них отсутствует необходимая контекстная информация для оценки релевантности запроса документу.

Чтобы устранить недостатки традиционных поисковых единиц (например, абзацев или предложений), мы предлагаем использовать предложения в качестве новой поисковой единицы для интенсивного поиска. Предложения определяются как атомарные выражения в тексте, каждое из которых содержит уникальный факт и представлено в кратком, самодостаточном формате естественного языка. Пример предложения приведен в таблице 1. Предложение описывает информацию о текущем угле наклона Пизанской башни в самодостаточном виде и точно отвечает на вопрос. Более подробное определение и описание мы приводим в разделе II.

Чтобы подтвердить эффективность использования предложений в качестве единиц поиска для плотного вывода ретриверов, мы сначала обработали и проиндексировали англоязычную Википедию, разбив все документы на предложения, которые мы называем FACTOIDWIKI. Затем мы провели эксперименты на пяти различных открытых наборах данных QA и эмпирически сравнили производительность шести двухкодерных ретриверов, когда Википедия индексируется по абзацам, предложениям и предложенным нами предложениям. производительность шести двухкодировочных ретриверов при индексации по абзацам, предложениям и предложениям. Наша оценка носит двойной характер: мы изучаем как производительность поиска, так и влияние на последующие задачи QA. Примечательно, что наши результаты показывают, что поиск на основе предложений превосходит подходы, основанные на предложениях и абзацах, в плане обобщения, как обсуждается в разделе V. Это говорит о том, что предложения выступают в качестве компактных и насыщенных содержанием контекстов, которые позволяют специалистам по плотному поиску получать доступ к точной информации, сохраняя при этом правильный контекст. Улучшение среднего запоминания @20 для поиска на основе отрывков составляет +10,1 для плотного ретривера без контроля и +2,2 для контролируемого ретривера. Кроме того, мы наблюдаем явное преимущество в эффективности последующего контроля качества при использовании поиска на основе предложений, как подробно описано в разделе VI. Учитывая типично ограниченную длину входных лексем в языковой модели, предложения по своей сути обеспечивают более высокую плотность информации, относящейся к вопросу.

Основной вклад нашей работы заключается в следующем:

- Мы предлагаем использовать предложения в качестве поисковых единиц при индексировании поискового корпуса, чтобы улучшить производительность интенсивного поиска.

- Мы представляем FACTOIDWIKI - обработанный дамп английской Википедии, в котором каждая страница разбита на несколько грануляций: абзацы по 100 слов, предложения и пропозиции.

Рисунок 2. Мы обнаружили, что сегментирование и индексирование поискового корпуса на пропозициональном уровне может быть простой и эффективной стратегией для улучшения обобщающих характеристик плотных ретриверов при рассуждениях (A, B). Мы эмпирически сравнили производительность плотного ретривера при поиске и выполнении заданий с открытым доменом "вопрос-ответ" при работе на уровне 100 слов в абзаце, предложении или пропозиции (C, D).

2 Предложения как единицы поиска

Цель нашего исследования - эмпирически понять, как гранулярность поискового корпуса влияет на производительность плотной модели поиска. В дополнение к широко используемым единицам поиска, таким как 100-словные абзацы или предложения, мы предлагаем использовать предложения в качестве альтернативного выбора единицы поиска. Здесь предложения представляют собой атомарные выражения смысла в тексте и определяются следующими тремя принципами.

- Каждая пропозиция должна соответствовать уникальному фрагменту смысла в тексте, а комбинация всех пропозиций будет представлять семантику всего текста.

- Пропозиция должна быть минимальной, т. е. ее нельзя разбить на отдельные пропозиции.

- Предложения должны быть контекстуальными и самодостаточными. Предложения должны содержать весь необходимый контекст из текста (например, совместные ссылки), чтобы объяснить их значение.

Использование предложений в качестве единиц поиска было вдохновлено рядом недавних работ, в которых удалось успешно представить и оценить семантику текстов на пропозициональном уровне. Мы демонстрируем понятие пропозиций и то, как абзац может быть разделен на множество пропозиций, на примере левой части рисунка 2. Абзац содержит три предложения, каждое из которых соответствует уникальному факту о Пизанской башне: угол до реставрации, текущий угол и горизонтальное смещение. В каждое предложение включен необходимый контекст из отрывка, чтобы смысл предложения можно было интерпретировать независимо от исходного текста. Например, упоминание башни в первом предложении разбирается как ее полное название - Пизанская Наклонная башня. Мы ожидаем, что каждое предложение будет точно описывать контекстуализированный атомарный факт, поэтому наша интуиция подсказывает, что предложения подойдут в качестве поисковых единиц для решения задач информационного поиска.

3 FACTOIDWIKI: индексация и поиск на пропозициональном уровне в Википедии

Мы эмпирически сравнили использование 100-словных абзацев, предложений и пропозиций в качестве поисковых единиц в Википедии. Википедия является широко используемым источником поиска в наукоемких задачах НЛП. Чтобы обеспечить справедливое сравнение с разной степенью детализации, мы обработали дампы английской Википедии 2021-10-13, как это было сделано в работе Bohnet et al. (2022). Мы разделили текст каждого документа на три различных градации: абзацы по 100 слов, предложения и пропозиции. Мы используем ту же гранулярность вПриложение Aсодержит подробную информацию о корпусе сегментации на уровне абзацев и предложений.

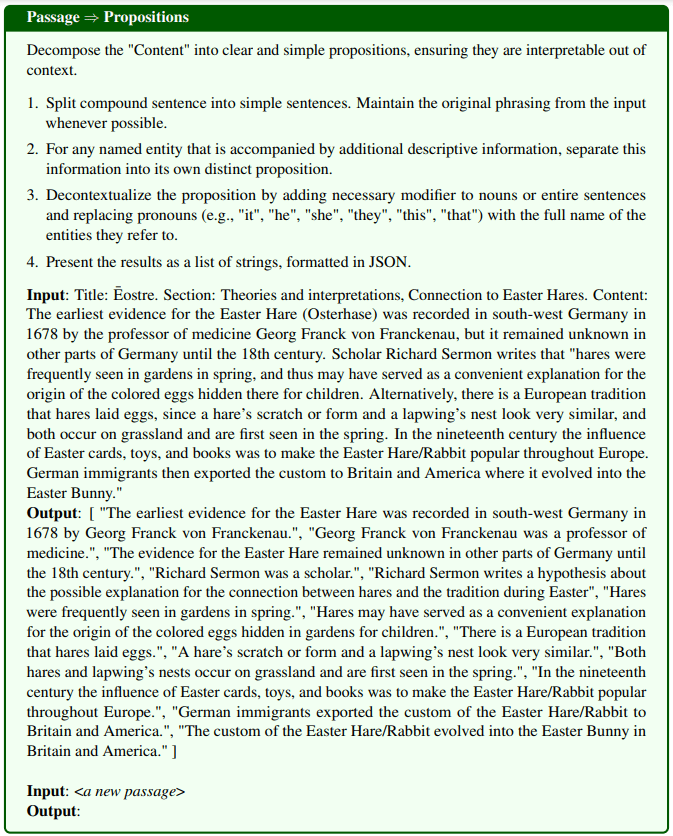

Перефразированный отрывок является пропозициональным:Чтобы разделить страницы Википедии на предложения, мы настроили модель генерации текста, которую назвали Propositionizer. Пропозиционист принимает на вход абзац и генерирует список предложений в этом абзаце. Следуя подходу Чена и др. (2023b), мы обучаем пропозиционер с помощью двухэтапного процесса дистилляции. Сначала мы используем инструкцию GPT-4, которая содержит определения пропозиций и 1 пример демонстрации. Мы приводим подробное описание подсказок на рисунке 8. Мы начинаем с набора из 42 тысяч отрывков и используем GPT-4 для создания начального набора пар отрывок-предложение. Затем мы используем этот набор для точной настройки модели FlanT5-large.

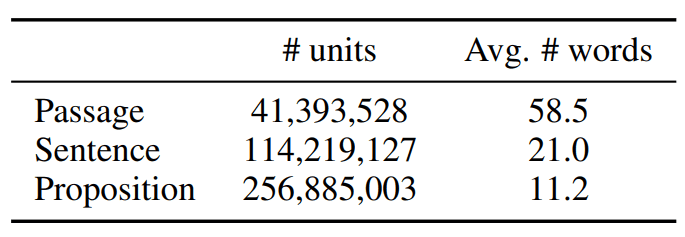

Мы называем обработанный корпус FACTOIDWIKI. Статистика FACTOIDWIKI приведена в таблице 1.

Таблица 1: Статистические данные о текстовых единицах в дампе данных английской Википедии на 13 октября 2021 года

4 Экспериментальная установка

Чтобы оценить влияние трех вариантов единиц поиска, мы провели эксперименты с пятью различными наборами QA на FACTOIDWIKI с открытым доменом. Для каждого набора данных мы оценивали эффективность поиска абзацев и последующей ОК, когда плотный ретривер использовал Википедию, проиндексированную с разной степенью детализации.

4.1 Наборы данных QA в открытом домене

Мы проводим оценку на пяти различных открытых наборах данных QA, использующих Википедию в качестве источника поиска: Natural Questions (NQ) (Kwiatkowski et al., 2019), TriviaQA (TQA) (Joshi et al., 2017), Web Questions ( WebQ) (Berant et al., 2013), SQuAD (Rajpurkar et al., 2016) и Entity Questions (EQ) (Sciavolino et al., 2021).

4.2 Модели плотного поиска

Мы сравниваем производительность следующих шести моделей плотного поиска с контролем и без контроля. Здесь под супервизорными моделями понимаются модели, которые обучаются в период обучения с использованием

Вручную маркированные пары запрос-параграф в качестве контролируемых моделей и наоборот.

- SimCSE это кодер на основе BERT, обученный на случайно выбранных немаркированных предложениях из Википедии.

- Вкладчик Contriever обучается путем сравнения контрастных пар, созданных на основе пар документов из немаркированных данных Википедии и веб-страниц.

- DPR это двухкодерная модель на основе BERT, отлаженная на пяти открытых наборах данных QA, включая четыре набора, использованные в нашей оценке (NQ, TQA, WebQ и SQuAD).

- ANCE Использовались те же настройки, что и для DPR, и модель обучалась методом приближенной оценки отрицательного контраста ближайших соседей (ANCE), основанным на жестком отрицательном методе обучения.

- TAS-B представляет собой двухкодерную BERT-базовую модель, полученную из модели учителя с перекрестным обучением внимания и отлаженную на MS MARCO.

- GTR это кодировщик на основе T5, предварительно обученный на парах немаркированных данных проверки качества на онлайн-форумах и отлаженный на MS MARCO и Natural Question.

4.3 Оценка поиска по параграфам

Мы оцениваем эффективность поиска на уровне абзаца при индексировании корпуса на уровне абзаца, предложения или пропозиции. Для поиска на уровне предложений мы следуем схеме, представленной в Lee et al. (2021b), где оценка абзаца основана на максимальной оценке сходства между запросом и всеми предложениями или пропозициями в абзаце. На практике мы сначала извлекаем немного больше единиц текста, сопоставляем каждую единицу с исходным абзацем и возвращаем k самых уникальных абзацев. В качестве метрики оценки мы используем recall @k, которая определяется как процент вопросов, на которые найден правильный ответ в первых k найденных отрывках.

4.4 Оценка качества на нижнем потоке

Чтобы понять, как использование различных единиц поиска влияет на решение задач QA с открытым доменом, мы оценили использование модели поиска в режиме "получить - прочитать". В режиме "извлекать - читать" модель поиска сначала извлекает k текстовых единиц по заданному запросу. Затем эти k найденных текстовых единиц используются в качестве входных данных для модели читателя вместе с запросом, чтобы получить окончательный ответ. Обычно выбор k ограничивается ограничением на максимальную длину входных данных или вычислительным бюджетом модели чтения, который увеличивается с ростом числа входных лексем.

Поэтому мы используем модель оценки, в которой максимальное количество извлекаемых слов ограничено l = 100 или 500, т. е. в модель читателя вводятся только первые l слов из извлечения на уровне абзаца, предложения или предложения. Мы оцениваем процент вопросов, на которые предсказанный ответ точно совпадает с истинным ответом (EM). Мы называем нашу метрику EM@l. Для нашей оценки мы используем модель читателя T5-large size UnifiedQA-v2.

5 Результаты: поиск параграфов

В этом разделе мы приводим результаты выполнения задачи поиска. Наши результаты показывают, что, хотя ни одна из моделей не была обучена на данных на уровне предложений, все модели поиска демонстрируют сравнимую или превосходящую производительность по сравнению с поиском на основе абзацев или предложений, когда корпус индексируется на уровне предложений.

5.1 Производительность поиска по параграфам

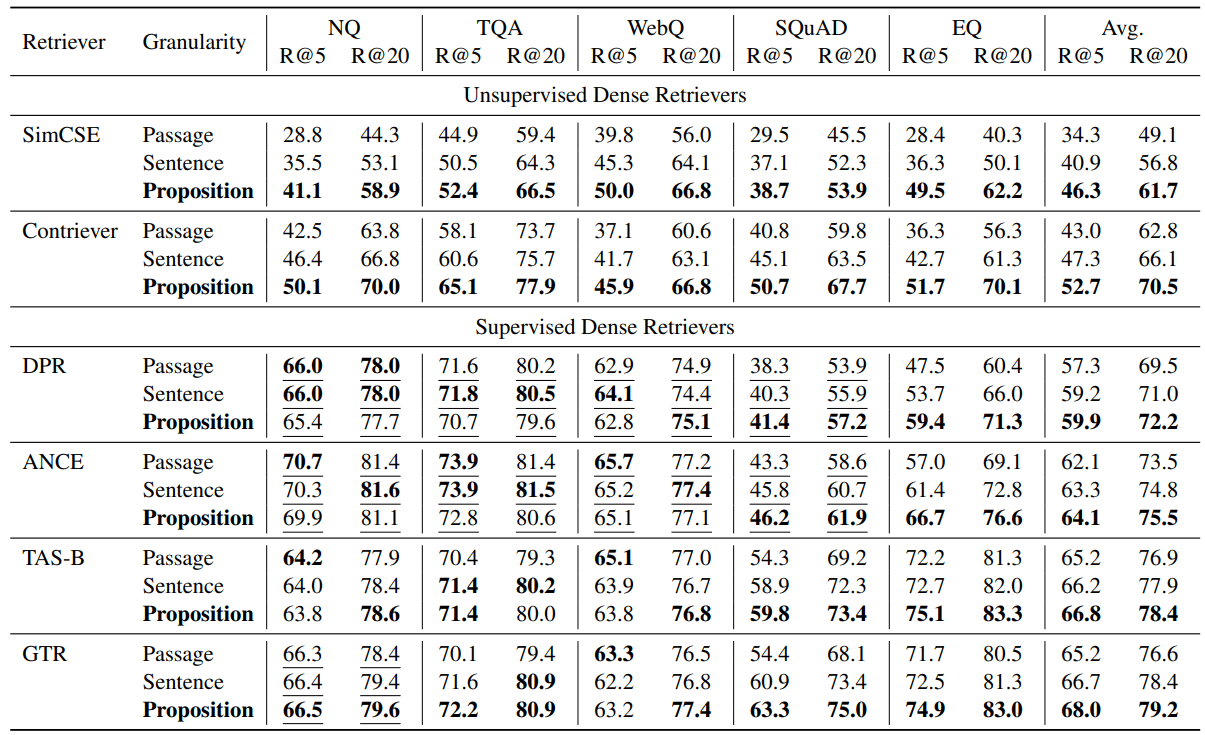

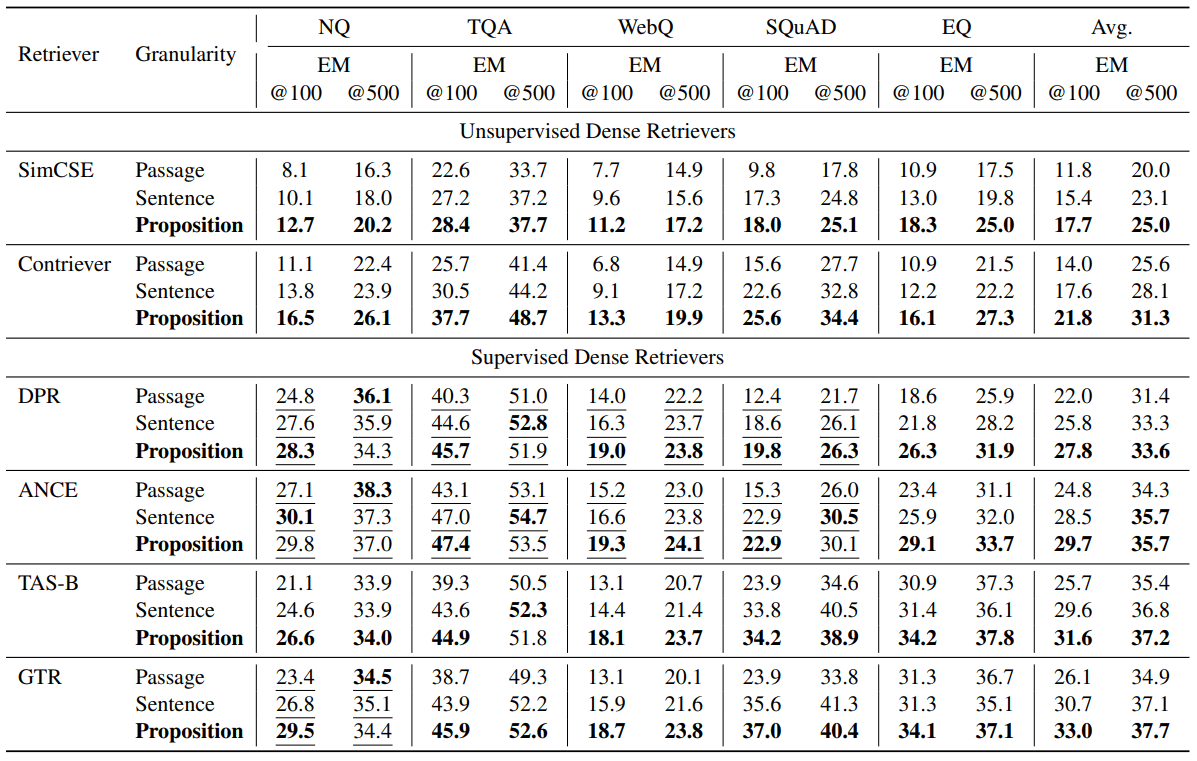

Результаты оценки представлены в таблице 2. Мы видим, что поиск на основе предложений превосходит поиск на основе предложений или абзацев в большинстве задач как для неуправляемых, так и для управляемых ретриверов.

Во всех протестированных интенсивных ретриверах поиск на основе предложений неизменно превосходит поиск на основе предложений и абзацев в среднем по пяти наборам данных. Для неуправляемых ретриверов, т. е. SimCSE и Contriever, мы видим среднее улучшение Recall@5 на +12,0 и +9,3 по пяти наборам данных (относительное улучшение на 35,01 TP3T и 22,51 TP3T).

Для контролируемых ретриверов поиск на уровне предложений все еще показывает среднее преимущество, но улучшение меньше. Мы предполагаем, что это связано с тем, что эти ретриверы обучаются на парах запрос-параграф. Например, для DPR и ANCE, которые обучены на NQ, TQA, WebQ и SQuAD, мы наблюдаем, что поиск на основе предложений и предложений немного хуже, чем поиск на основе абзацев во всех трех наборах данных, кроме SQuAD. Как показано в таблице 2, на NQ, TQA и WebQ производительность всех контролируемых ретриверов для трех градаций поиска сопоставима.

Однако на наборах данных, которые модель ретривера не видела во время обучения, мы наблюдали явное преимущество поиска на основе предложений. Например, на SQuAD или EntityQuestions мы видим, что поиск на основе предложений значительно превосходит две другие гранулярности. Мы видим относительное улучшение Recall@5 для 17-25% на относительно слабых ретриверах, таких как DPR и EntityQuestions для ANCE. Кроме того, Recall@5 для поиска на основе предложений на SQuAD улучшается больше всего на TAS-B и GTR, с относительным улучшением на 10-16%.

Таблица 2: Эффективность извлечения абзацев (recall @k = 5, 20) на пяти различных наборах данных Q&A с открытым доменом, когда предварительно обученный плотный ретривер работает с тремя различными грануляциями в корпусе извлечения. Подчеркивание указывает на то, что обучающая сегментация целевого набора данных включена в обучающие данные плотного ретривера.

5.2 Поиск на основе предложений ⇒ лучшее межзадачное обобщение

Наши результаты показывают, что преимущества поиска на основе предложений наиболее очевидны в условиях межзадачного обобщения. Мы наблюдаем, что поиск на основе предложений дает больший прирост производительности при межзадачном обобщении на SQuAD и EntityQuestions.

Чтобы лучше понять источники улучшений, мы провели дополнительный анализ EntityQuestions. Поскольку в EntityQuestions представлены вопросы, направленные на длиннохвостые атрибуты сущностей, мы исследовали, как на эффективность поиска влияет популярность целевой сущности в вопросе, то есть как часто она встречается в Википедии, на трех различных уровнях детализации. Мы оценили популярность каждой сущности, используя следующий метод. Учитывая поверхностную форму сущности, мы используем BM25 для извлечения первых 1000 релевантных отрывков из Википедии. В качестве оценки популярности сущности мы используем количество ее появлений в первых 1000 абзацах. Из 20 000 тестовых запросов в EntityQuestion около 251 TP3T целевых сущностей имеют значение популярности меньше или равное 3.

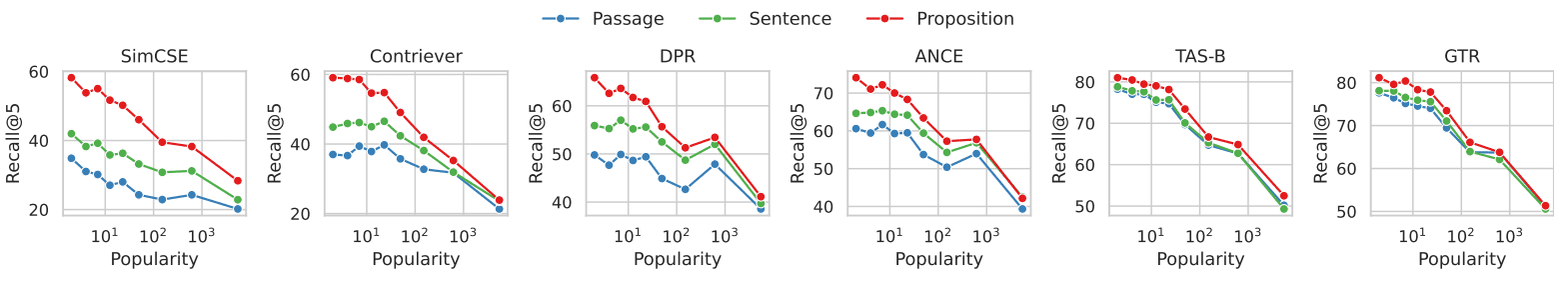

На рисунке 3 показана связь между эффективностью поиска по абзацам и популярностью целевых сущностей в каждой задаче. По всем шести плотным ретриверам мы видим, что поиск на основе предложений демонстрирует большее преимущество над поиском на основе абзацев для задач, в которых сущности встречаются реже. Разрыв в производительности уменьшается по мере роста популярности сущностей. Наши результаты свидетельствуют о том, что улучшение производительности поиска на основе предложений в основном связано с запросами, нацеленными на длиннохвостую информацию. Это повторяет наше наблюдение о том, что поиск на основе предложений улучшает межзадачные обобщающие характеристики плотных ретриверов.

Рисунок 3. Сравнение эффективности поиска документов с популярностью целевой сущности каждого вопроса в наборе данных EntityQuestions

В наборе данных EntityQuestions популярность каждого вопроса (т. е. меньшие значения указывают на то, что сущность встречается реже, и наоборот) оценивалась по частоте встречаемости сущности в первых 1000 отрывках, найденных с помощью BM25.

Для запросов, содержащих менее распространенные сущности, мы видим, что поиск по предложениям демонстрирует больше преимуществ по сравнению с поиском по сущностям.

6 Результат: КК на открытом поле

В этом разделе мы исследуем, как выбор гранулярности поиска влияет на последующие задачи QA с открытым доменом. Мы показываем сильное влияние поиска на основе предложений на производительность последующей QA в условиях retrieve-then-read, когда количество лексем поиска, вводимых в модель QA читателя, ограничено l = 100 или 500 слов. Мы наблюдаем, что производительность QA по средней метрике EM@l выше у всех ретриверов при использовании предложений в качестве единиц поиска.

6.1 Качество работы

В таблице 3 приведены результаты оценки. В разных ретриверах мы наблюдаем более высокую эффективность QA по средней метрике EM@l при использовании предложений в качестве единиц поиска. Неконтролируемые ретриверы SimCSE и Contriever улучшили свои показатели EM@100 на +5,9 и +7,8 соответственно (относительные улучшения для 50% и 55%). Наблюдаемые ретриверы DPR, ANCE, TAS-B и GTR улучшили показатели EM@100 на +5,8, +4,9, +5,9 и +6,9 соответственно (относительные улучшения для 26%, 19%, 22% и 26%). Как и при оценке поиска абзацев, мы обнаружили, что поиск на основе предложений более выгоден с точки зрения последующей проверки качества, особенно если ретривер не обучен на целевом наборе данных. В других случаях поиск на основе предложений все еще выгоден, но с меньшим средним отрывом.

Таблица 3: Результаты викторины в открытом домене (EM = точное совпадение) в условиях чтения после извлечения, когда количество извлеченных слов, передаваемых в модель чтения викторины, было ограничено l = 100 или 500. В качестве модели чтения мы использовали UnifiedQA V2 (Khashabi et al., 2022). В качестве входных данных в модель читателя передавались первые l слов из соединенных верхних найденных единиц текста. Подчеркивание указывает на то, что обучающая сегментация целевого набора данных была включена в обучающие данные плотного ретривера. В большинстве случаев мы видим, что использование меньших единиц поиска приводит к лучшей производительности в вопросах и ответах.

6.2 Предложение ⇒ более высокая плотность информации, относящейся к вопросу

Интуитивно понятно, что преимущество предложений перед предложениями или абзацами в качестве поисковых единиц заключается в том, что найденные предложения имеют более высокую плотность информации, релевантной запросу. При использовании более тонких единиц поиска правильный ответ на запрос с большей вероятностью появится в первой строке поисковой выдачи.

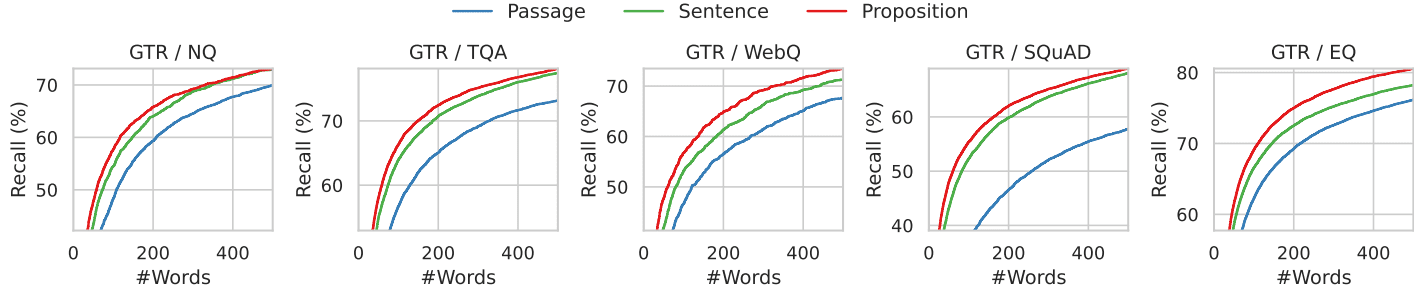

Мы проиллюстрируем это явление с помощью анализа, представленного на рисунке 4. Здесь мы рассматриваем положение правильного ответа в первых l найденных словах. В частности, мы подсчитали количество золотых ответов в первых l словах, найденных ретривером GTR, при использовании Википедии, проиндексированной с тремя различными гранулярностями.

Результаты представлены на рисунках 4 и 7, где l варьируется от 0 до 500, охватывая все пять наборов данных. При фиксированном бюджете найденных слов пропозициональный поиск имеет более высокий коэффициент успешности, чем методы поиска предложений и абзацев в диапазоне первых 100-200 слов, что соответствует примерно 10 предложениям, 5 предложениям или 2 абзацам. При дальнейшем увеличении количества слов показатели запоминания для трех градаций сближаются, поскольку вся информация, относящаяся к вопросу, содержится в найденном тексте.

Рис. 4: Вспоминание ответа "золотого стандарта", когда извлекаемый текст ограничивается первыми k словами, для ретривера GTR. Более тонкий поиск имеет более высокий уровень запоминания во всех диапазонах количества слов.

6.3 Примеры ошибок

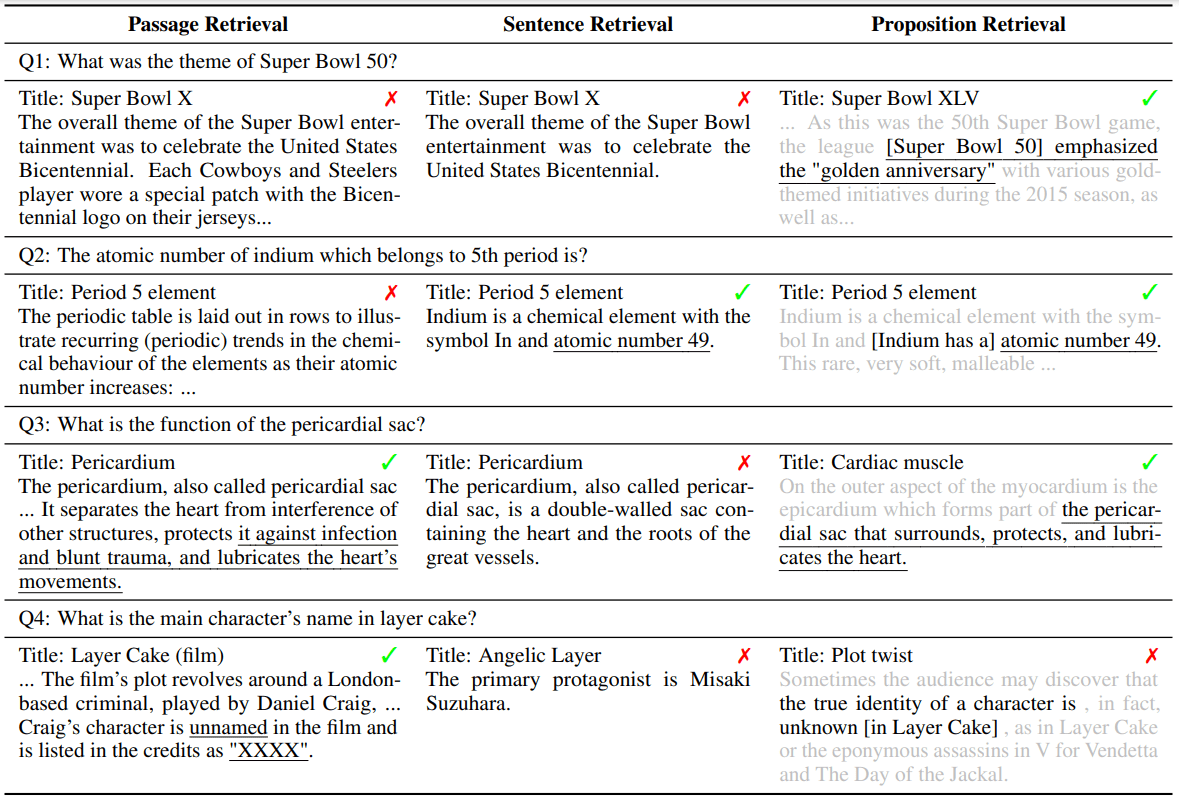

Чтобы понять источники ошибок на каждой грануле поиска, мы приводим и обсуждаем четыре типичных примера ошибок в таблице 4. В каждом примере показаны проблемы, найденные ретривером GTR на трех гранулярностях, и соответствующие им текстовые единицы top-1.

При поиске на уровне канала неоднозначность сущностей или ссылок на них представляет собой проблему для плотного поиска, что подтверждает результаты исследования (Min et al., 2020). Например, в примере Q1 вопрос запрашивает "Super Bowl 50", но найденная статья и предложение указывают на "Super Bowl 5". В примере Q2 при поиске по абзацам не удалось найти раздел, в котором упоминается правильный "номер атома". Вместо этого в первой найденной статье "атомный номер" упоминается в другом контексте, не имеющем отношения к вопросу. При поиске по предложениям могут возникнуть проблемы, аналогичные проблемам поиска по абзацам, как в примере Q1, а еще одной проблемой поиска по предложениям является отсутствие контекста. В примере Q3 поиск по предложению не удался, потому что в правильном предложении найденной статьи слово "это" используется для обозначения перикардиального мешка.

Поиск на основе предложений решает эту проблему, гарантируя, что каждая единица поиска содержит только один факт с необходимым контекстом в предложении. Однако поиск на основе предложений сталкивается с проблемой многоходовых рассуждений, включающих анализ текстов на большом расстоянии. В примере Q4 найденные отрывки описывают имена актеров и роли, которые они играют, соответственно. Ни одно из предложений не содержало ни вопросов, ни ответов.

Таблица 4: Примеры случаев, когда первая по рангу текстовая единица, найденная на каждой грануле поиска, не дает правильного ответа. Подчеркнутый текст - правильный ответ. Серый текст - это контекст предложения, но он используется только в иллюстративных целях и не предоставляется ретриверу и последующей модели вопросов и ответов.

7 Похожие работы

В последних работах по плотным ретриверам обычно используется архитектура с двумя кодировщиками. В двойных кодировщиках каждый запрос и документ кодируются отдельно как низкоразмерный вектор признаков, а корреляция между ними измеряется с помощью непараметрической функции сходства между встроенными векторами. Из-за ограниченной выразительности функции сходства модели с двойным кодированием обычно имеют низкую способность к обобщению на новые задачи, особенно при недостатке обучающих данных. По этой причине в предыдущих исследованиях использовались такие методы, как увеличение объема данных, непрерывное предварительное обучение, обучение с учетом задач, гибридный поиск с разреженными и плотными данными или гибридная стратегия поиска для улучшения межзадачных обобщающих характеристик плотных ретриверов.

Наша работа частично мотивирована отголосками многовекторного поиска, например, ColBERT, DensePhrase (Lee et al., 2021a,b), ME-BERT, MVR, в которых модель поиска учится кодировать единицы-кандидаты в несколько векторов, чтобы увеличить репрезентативность модели и улучшить гранулярность поиска. Наша работа сосредоточена на настройках, которые не обновляют плотную модель ретривера или ее параметры. Мы показываем, что разбиение корпуса извлечений на более тонкие предложения может быть простой и ортогональной стратегией для улучшения обобщающей способности двухкодерного плотного ретривера во время вывода.

Идея использования предложений в качестве единиц текстового представления восходит к пирамидальному подходу в автоматической оценке дайджестов (Nenkova and Passonneau, 2004), когда сгенерированные моделью дайджесты оцениваются по каждому предложению. Извлечение предложений из текста - давняя задача в НЛП, причем ранние формулировки фокусировались на структурированных представлениях предложений, например, извлечение открытой информации, маркировка семантических ролей. Более поздние исследования успешно извлекают пропозиции в форме естественного языка, используя большие языковые модели с меньшим количеством подсказок или точную настройку меньших моделей.

Поиск-чтение, или, в более широком смысле, генерация с расширением поиска, недавно стала популярной парадигмой для вопросов и ответов в открытом домене. В то время как ранние работы предоставляли читателям до 100 найденных отрывков, количество допустимого контекста значительно сократилось (например, до первых 10) при использовании более современных крупноязычных моделей из-за их ограниченной длины контекстного окна и неспособности обрабатывать длинные контексты. В последнее время предпринимаются попытки улучшить качество контекстов читателей путем фильтрации или сжатия найденных документов. Наша работа эффективно решает эту проблему за счет использования новой поисковой единицы - предложения, которое не только сокращает длину контекста, но и обеспечивает более высокую плотность информации.

8 Заключение

Мы предлагаем использовать предложения в качестве единиц поиска для индексирования корпораций, чтобы улучшить производительность плотного поиска во время вывода. В ходе экспериментов на пяти открытых наборах данных QA с использованием шести различных интенсивных ретриверов мы обнаружили, что поиск на основе предложений превосходит поиск на основе абзацев или предложений как по точности поиска абзацев, так и по производительности последующего QA при фиксированных бюджетах на поиск слов. Мы представляем FACTOIDWIKI, индексированную версию английской Википедии, в которой текст с 6 миллионов страниц разбит на 250 миллионов предложений. Мы надеемся, что FACTOIDWIKI и наши выводы, сделанные в этой статье, будут способствовать будущим исследованиям в области информационного поиска.

ограничения

Наше текущее исследование гранулярности поискового корпуса имеет следующие ограничения. (1) Корпус ретриверов - Наше исследование фокусируется только на Википедии как корпусе ретриверов, поскольку большинство открытых наборов данных QA используют Википедию в качестве корпуса ретриверов. (2) Типы оцениваемых плотных ретриверов - В текущей версии этой статьи мы оцениваем только шесть популярных плотных ретриверов, большинство из которых используют архитектуру с двойным кодировщиком или двойным кодировщиком. В будущих версиях мы включим и обсудим результаты для более широкого спектра плотных ретриверов. (3) Язык - наше текущее исследование ограничено английской Википедией. Изучение других языков мы оставляем для будущих работ.

A Обработка корпуса

Дамп англоязычной Википедии, использованный в данном исследовании, был опубликован Bohnet et al. в 2022 году и был выбран для использования, поскольку он был отфильтрован для удаления графиков, таблиц и списков и организован в виде абзацев. Датировка дампа - 13 октября 2021 года. Для данного исследования мы разделили Википедию на три поисковые единицы: блоки абзацев по 100 слов, предложения и пропозиции. Мы использовали жадный метод для разбиения абзацев на блоки по 100 слов. Мы сегментировали только в конце предложений, чтобы гарантировать, что каждый блок абзацев содержит полные предложения. По мере обработки абзацев мы добавляем предложения одно за другим. Если включение следующего предложения приведет к тому, что блок абзацев превысит 100 слов, мы начинаем новый блок абзацев с этого предложения. Однако если конечный блок абзацев состоит менее чем из 50 слов, мы объединяем его с предыдущим, чтобы избежать слишком маленьких фрагментов. Далее мы разбиваем каждый абзац на предложения с помощью широко используемой модели Python SpaCy en_core_web_lg. Кроме того, наша модель Propositionizer декомпозирует каждый абзац на предложения. В общей сложности мы разложили 6 миллионов страниц на 41,39 миллиона абзацев, 11,42 миллиона предложений и 257 миллионов пропозиций. В среднем абзац содержит 6,3 предложения, а предложение - 2,3 предложения.

B Обучение предлагающих

Мы использовали GPT-4 для создания списка предложений из заданного отрывка с помощью подсказки, как показано на рисунке 8. После фильтрации в общей сложности 42 857 пар были использованы для тонкой настройки модели Flan-T5-Large. Мы назвали модель Propositionizer. Мы использовали оптимизатор AdamW с размером партии 64, скоростью обучения 1e-4 и затуханием веса 1e-4, и обучались в течение 3 циклов. Чтобы сравнить эффективность предложений, сгенерированных разными моделями, мы создали набор для разработки и метрику оценки. Набор для разработки содержит дополнительные 1000 пар образцов, собранных GPT-4 по той же методике, что и набор для обучения. Мы оцениваем качество предсказанных предложений по баллам F1 для двух наборов предложений. Вдохновившись оценками F1 для двух наборов маркеров в BertScore, мы разработали оценки F1 для двух наборов предложений. Пусть P = {p1, ... , pn} обозначает множество помеченных предложений, ˆP = {ˆp1, ... , ˆpm} обозначает множество предсказанных предложений. Мы используем sim(pi, ˆpj) для обозначения сходства между двумя предложениями. Теоретически можно использовать любую метрику текстового сходства. Мы решили использовать BertScore в качестве функции sim, поскольку хотим, чтобы наша метрика отражала семантические различия между предложениями. Мы определяем:

Recall = 1 / |P| ∑(max(sim(pi, ˆpj)) для ˆpj в ˆP) Precision = 1 / |ˆP| ∑(max(sim(pi, ˆpj)) для pi в P) F1 = 2 * Precision * Recall / (Precision + Recall)

Вот графическое объяснение оценки F1: recall представляет собой процент предложений в маркированном наборе, которые похожи на предложения в сгенерированном наборе, precision представляет собой процент предложений в сгенерированном наборе, которые похожи на предложения в маркированном наборе, а F1 - это согласованное среднее значение recall и precision. F1 равен 1, если два набора идентичны, и 0, если любые два предложения семантически различны.

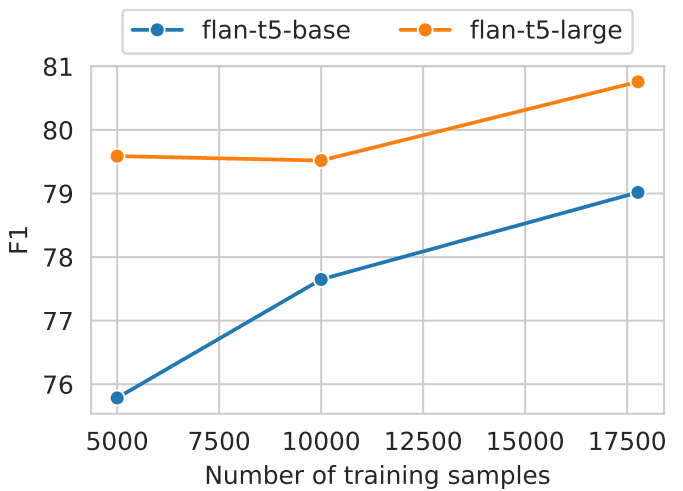

Мы провели сравнительный анализ базовой и большой моделей Flan-T5, которые были обучены на разных объемах данных (как показано на рис. 5). Результаты исследования показывают, что более крупные модели в сочетании с большим объемом обучающих данных дают лучшие результаты. Пропозициональный анализатор достиг значения F1 0,822. После ручной проверки сгенерированных предложений мы сочли их удовлетворительными.

Рис. 5: Производительность декомпозиции пропозиционального уровня для моделей разного размера и количества обучающих данных.

C Автономный индекс

Мы закодировали полученные единицы в виде вкраплений с помощью пакетов pyserini и faiss. Мы кодировали каждую единицу текста с помощью нескольких графических процессоров, сгруппированных в 1 миллион единиц с размером партии 64. После предварительной обработки вкраплений мы провели все эксперименты, используя точный поиск с внутренним произведением (faiss.IndexFlatIP). Чистый индекс FACTOIDWIKI имеет размер около 768 ГБ. Чтобы уменьшить нагрузку на память, встраивание разбито на 8 фрагментов. Каждый фрагмент выполняет приблизительный поиск ближайшего соседа перед объединением всех результатов. Хотя количество предложений в шесть раз превышает количество переходов, с помощью эффективных методов индексирования можно добиться сублинейного времени поиска по отношению к общему количеству векторов. Более того, использование параллелизма GPU и распределенного индексирования значительно сокращает время онлайн-поиска. Таким образом, при правильной реализации мы можем сделать пропозициональный поиск практичным и эффективным вариантом.

D Модель ретривера

Для реализации модели мы использовали пакеты transformers и sentence-transformers. Мы использовали следующие контрольные точки, опубликованные на HuggingFace: SimCSE (princeton-nlp/unsup-simcse-bert-base-uncased), Contriever (facebook/contriever), DPR (facebook/dpr- ctx_encoder-multiset-base, facebook/dpr-question_encoder-multiset-base), ANCE (castorini/ance-dpr-context-multi, castorini/ance-dpr- question-multi,), TAS-B (sentence-transformers/msmarco-distilbert-base-tas-b) и GTR (sentence-transformers/gtr-t5-base).

E Дополнительные результаты

В разделе 5.2 мы покажем преимущества поиска на основе предложений перед поиском на основе предложений, особенно в эквалайзерах, где количество сущностей уменьшается. Мы используем количество вхождений в первые 1000 абзацев, найденных BM25, в качестве косвенного показателя распространенности, а не количество гиперссылок на сущности, как в Sciavolino et al. (2021). В результате на графике зависимости производительности от популярности (рис. 6) видны некоторые различия между нашими результатами и результатами Sciavolino et al. (2021). Например, некоторые сущности неоднозначны (например, 1992 год, телесериал). В этом случае количество вхождений поверхностной формы сущности велико. В то же время на вопросы, связанные с нечеткими сущностями, трудно ответить, что приводит к низкой запоминаемости. В разделе 6.2 мы рассмотрим запоминание ответов в извлеченном тексте в зависимости от длины контекста. Далее мы показываем динамику производительности шести плотных ретриверов, как показано на рис. 7. Результаты показывают, что запоминание предложений неизменно лучше, чем предложений и абзацев. Полученные нами результаты позволяют сделать вывод о том, что плотность единиц, относящихся к вопросу, в предложениях выше, чем в предложениях и абзацах.

Рисунок 8: Подсказки для генерации предложений из статей с помощью GPT-4.

Разложите "содержание" на четкие и простые предложения, обеспечив их интерпретацию

контекста.

1. Разделите сложное предложение на простые предложения. Сохраните исходную фразу из исходного текста

по возможности.

2. для любой названной сущности, которая сопровождается дополнительной описательной информацией, отделите ее

Информация превращается в отдельное предложение.

3. Деконтекстуализируйте предложение, добавляя необходимый модификатор к существительным или целым предложениям

и заменяя местоимения (например, "это", "он", "она", "они", "этот", "тот") на полное название

сущности, на которые они ссылаются.

4. Представьте результаты в виде списка строк, отформатированных в JSON.Вход. Название: Eostre. Раздел: Теории и интерпретации, Связь с пасхальными зайцами. Содержание: ¯

Самое раннее свидетельство о пасхальном зайце (Osterhase) было зафиксировано на юго-западе Германии в

1678 года профессором медицины Георгом Франком фон Франкенау, но она оставалась неизвестной в

В других частях Германии вплоть до XVIII в. Ученый Ричард Сермон пишет, что "зайцы были

часто встречается в садах весной и, таким образом, может служить удобным объяснением для

В качестве альтернативы существует европейская традиция "черных яиц", которые являются самыми распространенными в мире, и самыми распространенными в Соединенных Штатах.

что зайцы откладывают яйца, поскольку заячьи царапины или форма гнезда зайца и гнезда ласточки очень похожи, и

Оба вида встречаются на лугах и впервые появляются весной. В XIX веке влияние

Пасхальные открытки, игрушки и книги должны были сделать пасхального зайца/кролика популярным во всей Европе.

Затем немецкие иммигранты перевезли этот обычай в Британию и Америку, где он превратился в

Пасхальный кролик".

Выход. ["Самые ранние свидетельства о пасхальном зайце были зафиксированы в юго-западной Германии в

1678 г. Георг Франк фон Франкенау.", "Георг Франк фон Франкенау был профессором.

медицина.", "Доказательства существования пасхального зайца оставались неизвестными в других частях Германии

до XVIII века.", "Ричард Сермон был ученым.", "Ричард Сермон пишет гипотезу.

о возможном объяснении связи между зайцами и традицией празднования Пасхи".

"Зайцев часто видели в садах весной", "Зайцы могли служить удобным

объяснение происхождения цветных яиц, спрятанных в садах для детей.", "Существует

Европейская традиция гласила, что зайцы откладывают яйца.", "Заячья царапина или форма и гнездо ласточки выглядят очень

похожи.", "Гнезда и зайцев, и лазоревок встречаются на лугах и впервые замечены весной.", "Гнезда и зайцев, и лазоревок встречаются на лугах и впервые замечены весной.".

"В XIX веке влияние пасхальных открыток, игрушек и книг было направлено на то, чтобы сделать Пасху

Заяц/кролик, популярный во всей Европе.", "Немецкие иммигранты экспортировали обычай

Пасхальный заяц/кролик в Британии и Америке.", "Обычай пасхального зайца/кролика превратился в

Пасхальный кролик в Британии и Америке"].Вход. <a new passage>

Выход.

Разбейте "контент" на четкие и простые идеи, чтобы убедиться, что они имеют смысл, если вырвать их из первоначального контекста.

1. Разбейте сложносочиненные предложения на простые и, по возможности, сохраните исходную формулировку.

2. для конкретных сущностей с дополнительной описательной информацией эта информация выделяется в отдельные утверждения.

3. Вырывать утверждения из контекста, добавляя необходимые модификаторы к существительным или целым предложениям, или заменяя местоимения (например, "это", "он", "она", "они", "этот", "тот") полным именем сущности, к которой они относятся.

4. Представьте результаты в виде списка строк и используйте формат JSON.Вход:Название: Eostre. Глава: теории и объяснения, со ссылками на пасхального кролика. Содержание: Самое раннее свидетельство о пасхальном зайце (Osterhase) было зафиксировано Георгом Франком фон Франкенау в 1678 году на юго-западе Германии, но в остальной Германии он был неизвестен до XVIII века. Ученый Ричард Сермон пишет: "Зайцев часто видели в садах весной, поэтому они могли использоваться как удобное объяснение происхождения цветных яиц, которые дети находили в своих садах". Кроме того, в Европе существует традиция, что зайцы откладывают яйца, потому что их царапины или формы очень похожи на гнезда пшеничных птиц, а сами они встречаются на лугах и впервые обнаруживаются весной". В XIX веке под влиянием пасхальных открыток, игрушек и книг пасхальный кролик стал популярен во всей Европе. Затем этот обычай был перенесен немецкими иммигрантами в Англию и Соединенные Штаты, где он превратился в пасхального кролика, каким мы его знаем сейчас".

Выход:["Самые ранние свидетельства, касающиеся пасхального кролика, были найдены Георгом Франком фон Франкенау на юго-западе Германии в 1678 году." , "Георг Франк фон Франкенау был профессором медицины." , "Только в XVIII веке люди в других частях Германии начали узнавать об этих доказательствах ассоциации с пасхальным зайцем." , "Ричард Сермон был ученым." , "Ричард Сермон выдвинул гипотезу о возможных объяснениях традиционной связи зайца с Пасхой.", "Зайцев часто можно встретить в садах в весеннее время.", "Зайцы могут быть простыми животными." , "Зайцы могут быть простым объяснением того, почему дети находят крашеные яйца в своих садах". , "В Европе существует традиционное мнение, что зайцы откладывают яйца". , "Заячья почесуха или форма чрезвычайно похожа на гнездо пшеничной птицы: оба вида встречаются на лугах и впервые обнаруживаются весной" . , "В XIX веке пасхальный кролик стал широко известен в Европе благодаря популярности пасхальных открыток, игрушек и книг." , "Немецкие иммигранты привезли обычай пасхального кролика в Англию и Соединенные Штаты." , "В Англии и Соединенных Штатах обычай с пасхальным кроликом постепенно превратился в того пасхального кролика, которого мы знаем сейчас". ]Вход: <新的段落>

Выход:

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...