Модели нового поколения OpenAI столкнулись с большим препятствием, бывший главный научный сотрудник раскрывает новый маршрут

Крупноязычная модель нового поколения Orion от OpenAI, возможно, столкнулась с беспрецедентно узким местом. По данным The Information, сотрудники OpenAI утверждают, что прирост производительности модели Orion не оправдал ожиданий, а прирост качества "гораздо меньше", чем при обновлении GPT-3 до GPT-4.

Кроме того, в некоторых задачах Orion не так стабилен, как его предшественник GPT-4. Несмотря на более широкие лингвистические возможности Orion, производительность программирования может не превзойти GPT-4. сокращение ресурсов для обучения высококачественным текстовым и другим данным усложнило поиск высококачественных обучающих данных, что замедлило разработку больших языковых моделей (LLM).

Мало того, в будущем обучение будет требовать еще больших вычислительных затрат, как денежных, так и электрических, а это значит, что стоимость разработки Orion и последующих больших языковых моделей значительно возрастет. Исследователь openAI Ноам Браун недавно заявил на конференции TED AI, что более совершенные модели могут оказаться "экономически невыполнимыми":

Неужели мы действительно собираемся тратить сотни миллиардов или триллионы долларов на обучение моделей? В какой-то момент закон масштабирования нарушится.

OpenAI создал команду под руководством Ника Райдера, которая будет изучать, как справиться с растущим дефицитом обучающих данных и как долго будут действовать законы масштабирования больших моделей.

Ноам Браун

Законы масштабирования - одно из основных предположений в ИИ: пока есть больше обучаемых данных и больше вычислительной мощности для управления процессом обучения, производительность большой языковой модели может продолжать улучшаться с той же скоростью. Вкратце, закон масштабирования описывает связь между входными ресурсами (объем данных, вычислительная мощность, размер модели) и производительностью модели на выходе. То есть степень повышения производительности при вложении большего количества ресурсов в большую языковую модель.

Например, обучение большой языковой модели можно сравнить с производством автомобиля: изначально завод небольшой, с несколькими станками и несколькими рабочими, и на этом этапе каждый дополнительный станок или рабочий приводит к значительному увеличению выпуска, поскольку дополнительные ресурсы напрямую преобразуются в производительность. Однако по мере роста фабрики увеличение объема производства на одну дополнительную машину или рабочего снижается, возможно, из-за усложнения управления или менее эффективного взаимодействия рабочих.

Когда завод достигает определенного размера, добавление большего количества машин или рабочих может привести к более ограниченному увеличению объема производства, и в этот момент завод может приблизиться к пределу своих ресурсов, таких как земля и логистика. Именно с такой дилеммой столкнулась модель Orion: по мере увеличения размера модели (аналогично увеличению количества машин и рабочих) улучшение производительности модели очень значительно на ранних и среднесрочных этапах, но на более поздних этапах, даже если размер модели или объем обучающих данных увеличивается, улучшение производительности становится меньше. Это явление известно как "удар о стену".

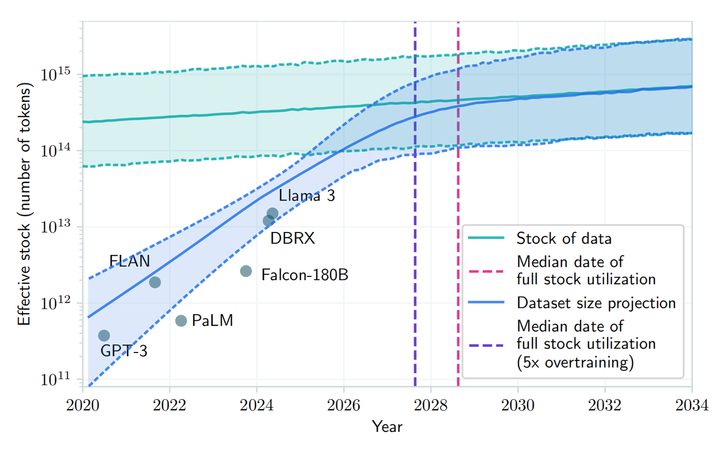

Согласно статье, опубликованной на сайте arXiv, прогнозируется, что разработка больших языковых моделей может исчерпать ресурсы общедоступных человеческих текстов в период с 2026 по 2032 год из-за растущего спроса и ограниченной доступности общедоступных человеческих текстовых данных. Несмотря на указание на "экономические проблемы", связанные с обучением будущих моделей, Норм Браун возражает против этого, утверждая, что "развитие ИИ не замедлится в ближайшее время".

Исследователи OpenAI в целом разделяют эту точку зрения, и хотя действие закона масштабирования может замедлиться, на общее развитие ИИ оптимизация времени вывода и улучшения после обучения существенно не повлияют.Генеральный директор Meta Марк Цукерберг, генеральный директор OpenAI Сэм Альтман и другие руководители компаний-разработчиков ИИ также публично заявляли, что традиционные пределы закона масштабирования еще не достигнуты и что они продолжают развивать дорогостоящие центры обработки данных для повышения производительности предварительно обученных моделей. CEO Meta Марк Цукерберг, CEO OpenAI Сэм Альтман и другие руководители компаний-разработчиков ИИ также публично заявляли, что традиционные границы закона масштабирования еще не достигнуты и что они по-прежнему развивают дорогостоящие центры обработки данных для повышения производительности предварительно обученных моделей.

Питер Велиндер, вице-президент по продуктам OpenAI, также написал в социальных сетях, что "люди недооценивают силу вычислений в тестовое время". Вычисления в тестовое время (TTC) - это концепция машинного обучения, которая обозначает вычисления, происходящие при развертывании модели для выполнения выводов или предсказаний на основе новых входных данных, отдельно от вычислений, происходящих во время обучения. Этап обучения - это процесс, в ходе которого модель изучает шаблоны данных, а этап тестирования - это процесс, в ходе которого модель применяется к реальным задачам.

Традиционные модели машинного обучения обычно предсказывают новые экземпляры данных без дополнительных вычислений после того, как они были обучены и развернуты. Однако некоторые более сложные модели, например некоторые типы моделей глубокого обучения, могут потребовать дополнительных вычислений во время тестирования (время вывода). Модель 'o1', разработанная OpenAI, использует этот тип модели вывода. Индустрия ИИ в целом смещает акцент на этап оптимизации модели после завершения начального обучения.

Питер Велиндер

Илья Суцкевер, один из основателей OpenAI, в недавнем интервью агентству Reuters признал, что повышение эффективности этапа предварительного обучения, на котором используются большие объемы немаркированных данных для обучения моделей ИИ пониманию лингвистических паттернов и структур, достигло своего пика. "2010-е годы были эпохой экспансии, а сейчас мы снова возвращаемся к эпохе исследований и открытий", - сказал он. Он также отметил: "Повышение точности сейчас важно как никогда".

Запуск "Ориона" запланирован на 2025 год, и OpenAI назвала его "Орион" вместо "GPT-5", возможно, намекая на совершенно новую революцию. Несмотря на то, что в настоящее время его "сложно создать" из-за теоретических ограничений, все же ожидается, что этот "новорожденный" принесет революционные возможности для макромоделирования ИИ.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...