Оценка применения моделей вывода в модульных системах RAG

В этой статье мы представляем недавнюю работу Kapa.ai над системой OpenAI Retrieval-Augmented Generation (RAG) в контексте o3-mini Краткий отчет об исследовании этимологической модели рассуждений.

Kapa.ai - это ИИ-ассистент, работающий на основе крупномасштабной языковой модели (LLM), которая RAG Этот процесс интегрирован с базой знаний, что позволяет отвечать на технические вопросы пользователей и обрабатывать заявки на техническую поддержку.

Создание и поддержка стабильной и универсальной системы RAG - непростая задача. Многие параметры и настройки влияют на качество конечного результата, и между этими факторами существует сложное взаимодействие:

- Шаблоны слов для кия

- Размер контекста

- Расширение запросов

- кусок

- повторный заказ

- Подождите!

При внесении изменений в систему RAG, особенно при интеграции новой модели, пересмотр и оптимизация этих параметров необходимы для поддержания хорошей производительности. Однако эта задача не только занимает много времени, но и требует большого опыта для успешного выполнения.

напоминать DeepSeek-R1 Новые модели рассуждений, такие как o3-mini от OpenAI, достигли впечатляющих результатов, используя встроенные подсказки Chain-of-Thought (CoT), чтобы "думать" о проблеме, рассуждать шаг за шагом и даже самокорректироваться при необходимости. Сообщается, что модели лучше справляются со сложными задачами, требующими логических рассуждений и проверяемых ответов. Похожие статьи:DeepSeek R1 в RAG: обобщение практического опыта , иПолучены результаты генерации кода на уровне проекта! o3/Claude 3.7 лидирует, R1 находится в верхнем эшелоне!

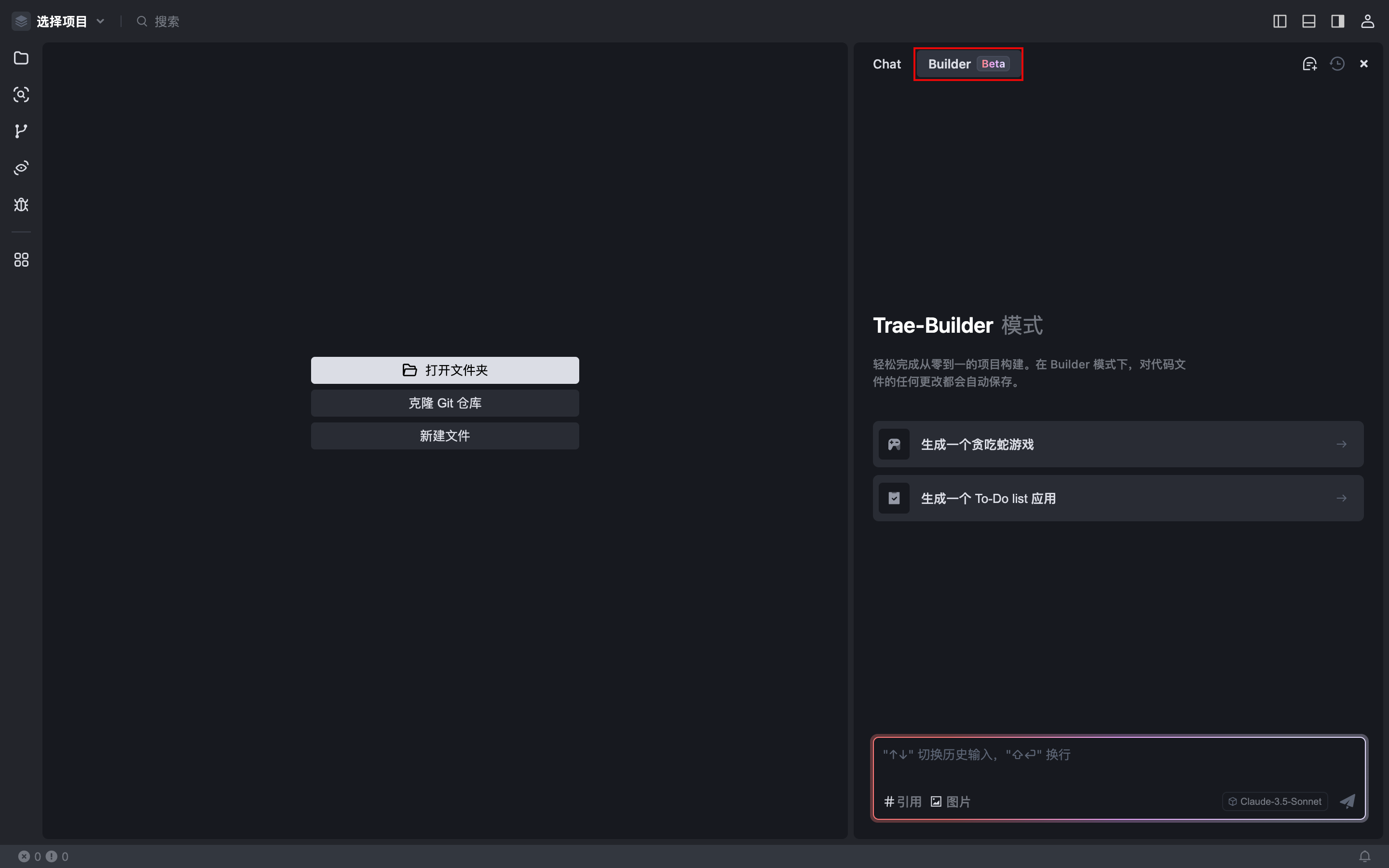

Поэтому Kapa.ai предлагает идею: если модели умозаключений могут декомпозировать сложные проблемы и самокорректироваться, можно ли применить их к процессам RAG для решения таких задач, как расширение запросов, поиск и упорядочивание документов? Создав набор инструментов для поиска информации и передав его моделям вывода, можно построить более адаптивную систему, которая уменьшит необходимость ручной настройки параметров.

Эту парадигму иногда называют модульной генерацией с расширением поиска (Modular Retrieval-Augmented Generation, Modular RAG). В этой статье мы рассказываем о результатах последних исследований Kapa.ai по рефакторингу стандартного процесса RAG в процесс, основанный на модели вывода.

предположим, что...

Основная цель Kapa.ai - упростить процесс RAG и уменьшить зависимость от ручной настройки параметров. Основными компонентами процесса RAG являются плотное встраивание и поиск документов. Типичный высокоуровневый процесс RAG выглядит следующим образом:

- Получение подсказок от пользователя.

- Предварительная обработка запросов для улучшения поиска информации.

- Релевантные документы находятся путем поиска сходства в векторных базах данных.

- Упорядочите результаты и используйте наиболее релевантные документы.

- Сгенерируйте ответ.

Каждый этап процесса оптимизируется с помощью эвристики, такой как правила фильтрации и сортировки для определения приоритетности важных данных. Эти жестко закодированные оптимизации определяют поведение процесса, но также ограничивают его адаптивность.

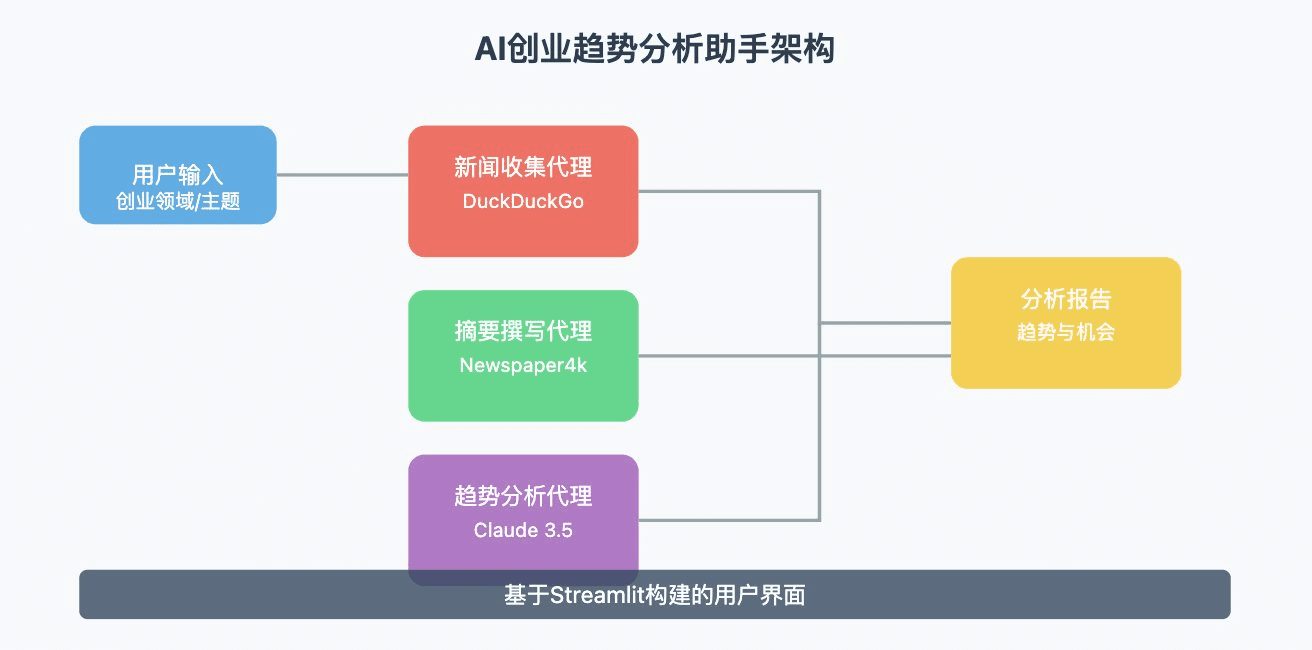

Для того чтобы модель вывода могла использовать различные компоненты процесса RAG, Kapa.ai пришлось настроить систему по-другому. Вместо того чтобы определять линейную последовательность шагов, каждый компонент рассматривается как отдельный модуль для вызова модели.

В этой архитектуре вместо того, чтобы следовать фиксированному процессу, модели с возможностью рассуждения могут управлять своим собственным рабочим процессом, что повышает степень динамичности. Используя инструменты, модели могут решать, когда и как часто выполнять полный или упрощенный поиск, а также какие параметры поиска использовать. В случае успеха этот подход может заменить традиционные механизмы оркестровки RAG, такие как LangGraph.

Кроме того, более модульная система имеет ряд дополнительных преимуществ:

- Отдельные модули можно заменять или модернизировать без полной перестройки всего процесса.

- Более четкое разделение обязанностей облегчает управление отладкой и тестированием.

- Различные модули (например, ретриверы с различными вкраплениями) могут быть протестированы и заменены для сравнения производительности.

- Модули могут быть расширены независимо для различных источников данных.

- Потенциально это может позволить Kapa.ai создавать различные модули, адаптированные под конкретные задачи или домены.

Наконец, Kapa.ai также хочет изучить, может ли этот подход помочь более эффективно "отсекать" неправомерные или не относящиеся к теме запросы. Самые сложные случаи обычно связаны с двусмысленностью, т. е. неясно, имеет ли запрос отношение к продукту. Злоупотребляющие запросы часто специально разрабатываются так, чтобы избежать обнаружения. Хотя с более простыми случаями уже можно эффективно справляться, Kapa.ai надеется, что модель выводов поможет выявлять и устранять более сложные проблемы на более ранних этапах.

испытательная установка

Чтобы поэкспериментировать с этим рабочим процессом, Kapa.ai создала систему RAG в песочнице, содержащую необходимые компоненты, статические данные и набор оценок с LLM в качестве эксперта. В одной конфигурации Kapa.ai использовала типичный фиксированный линейный процесс с жестко закодированными оптимизациями.

Для модульного процесса RAG Kapa.ai использовала модель o3-mini в качестве модели вывода и запустила различные конфигурации процесса при различных политиках, чтобы оценить, какие подходы работают, а какие нет:

- Использование инструмента: Kapa.ai пытается предоставить модели полный доступ ко всем инструментам и всему процессу, а также пытается ограничить использование инструментов комбинацией одного инструмента с фиксированным линейным процессом.

- Подсказки и параметризация: Kapa.ai тестировала как открытые подсказки с минимальными инструкциями, так и сильно структурированные подсказки. Kapa.ai также экспериментировала с различными степенями предварительной параметризации вызовов инструментов, вместо того чтобы позволить модели самой определять свои параметры.

Во всех тестах, проведенных Kapa.ai, количество вызовов инструментов было ограничено максимум 20 - для каждого конкретного запроса модель позволяет использовать не более 20 вызовов инструментов. Kapa.ai также провела все тесты при средней и высокой силе вывода:

- Средний: Более короткие шаги CoT (Цепочка мыслей)

- Выше: Более длинные шаги CoT с более подробным обоснованием

В общей сложности Kapa.ai провела 58 оценок различных модульных конфигураций RAG.

в конце концов

Результаты экспериментов оказались неоднозначными. В некоторых конфигурациях Kapa.ai наблюдала скромные улучшения, в частности, в генерации кода и, в ограниченной степени, в факторизации. Однако ключевые показатели, такие как качество поиска информации и извлечение знаний, остались практически неизменными по сравнению с традиционным рабочим процессом Kapa.ai, настраиваемым вручную.

В процессе тестирования постоянно возникает проблема, связанная с тем, что рассуждения по цепочке мыслей (CoT) увеличивают время задержки. Хотя более глубокие рассуждения позволяют модели декомпозировать сложные запросы и самокорректироваться, это обходится в дополнительное время, необходимое для итеративных вызовов инструментов.

Самой большой проблемой, выявленной Kapa.ai, является "ошибка вывода ≠ опыта": модель вывода, несмотря на способность мыслить пошагово, не имеет априорного опыта использования инструмента поиска. Даже при наличии строгих подсказок ей было сложно получить качественные результаты и отличить хорошие результаты от плохих. Модель часто не решалась использовать инструменты, предоставляемые Kapa.ai, что напоминает эксперименты, которые Kapa.ai проводила в прошлом году с моделью o1. Это подчеркивает более широкую проблему: модели умозаключений хороши в решении абстрактных задач, но оптимизация использования инструментов без предварительного обучения остается нерешенной задачей.

Основные выводы

- Эксперимент выявил очевидное "заблуждение рассуждения ≠ опыта": сама модель рассуждения не "понимает" инструмент поиска. Она понимает функцию и назначение инструмента, но не знает, как его использовать, в то время как человек обладает этим негласным знанием после использования инструмента. В отличие от традиционных процессов, где опыт закодирован в эвристике и оптимизации, модель рассуждений должна быть явно обучена тому, как эффективно использовать инструмент.

- Хотя модель o3-mini способна работать с большими контекстами, Kapa.ai отмечает, что она не обеспечивает значительного улучшения по сравнению с такими моделями, как 4o или Sonnet, в плане извлечения знаний. Простое увеличение размера контекста не является панацеей для повышения эффективности поиска.

- Увеличение силы умозаключений модели лишь незначительно повысит точность фактов. Наборы данных kapa.ai ориентированы на технический контент, имеющий отношение к реальным случаям использования, а не на задачи математических соревнований или сложные задачи по кодированию. Влияние силы умозаключений может варьироваться в зависимости от области и давать разные результаты для наборов данных, содержащих более структурированные или сложные с вычислительной точки зрения запросы.

- Одной из областей, в которой модель преуспела, является генерация кода, что говорит о том, что модели вывода могут быть особенно хорошо приспособлены к областям, требующим структурированного, логического вывода, а не чистого поиска.

- Модели рассуждений не обладают знаниями, связанными с инструментами.

Рассуждения ≠ эмпирическое заблуждение

Ключевой вывод экспериментов заключается в том, что модель вывода не обладает естественными знаниями, специфичными для конкретного инструмента. В отличие от тонко настроенных процессов RAG, которые кодируют логику поиска в заранее определенные шаги, модели умозаключений обрабатывают каждый вызов поиска с нуля. Это приводит к неэффективности, нерешительности и неоптимальному использованию инструментов.

Чтобы смягчить эту проблему, можно рассмотреть несколько возможных стратегий. Дальнейшее совершенствование стратегии подсказки, т. е. составление инструкций по использованию инструмента таким образом, чтобы обеспечить более четкое руководство для модели, может быть полезным. Предварительное обучение или тонкая настройка моделей для работы с инструментами также может ознакомить их с конкретными механизмами поиска.

Кроме того, можно рассмотреть гибридный подход, когда предопределенные эвристики решают определенные задачи, а модели вывода выборочно вмешиваются, когда это необходимо.

Эти идеи пока находятся на стадии предположений, но они указывают на то, как преодолеть разрыв между способностью рассуждать и реальной реализацией инструментов.

резюме

Хотя модульный RAG, основанный на выводах, не показал значительных преимуществ по сравнению с традиционными процессами в контексте сценариев использования Kapa.ai, эксперимент дал ценное представление о его возможностях и ограничениях. Гибкость модульного подхода остается привлекательной. Он позволяет повысить адаптивность, упростить модернизацию и динамически адаптироваться к новым моделям или источникам данных.

В перспективе ряд перспективных технологий заслуживает дальнейшего изучения:

- Используйте различные стратегии подсказки и предварительное обучение/настройку, чтобы улучшить понимание модели и ее взаимодействие с инструментом поиска.

- Используйте модели рассуждений стратегически в определенных частях процесса, например, для конкретных случаев использования или задач, таких как ответы на сложные вопросы или генерация кода, вместо того чтобы организовывать весь рабочий процесс.

На данном этапе модели рассуждений, подобные o3-mini, не превзошли традиционные процессы RAG для основных задач поиска в разумных временных пределах. По мере развития моделей и стратегий использования инструментов модульные системы RAG, основанные на рассуждениях, могут стать жизнеспособной альтернативой, особенно для областей, требующих динамических, логически сложных рабочих процессов.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...