Mistral выпускает Mistral Small 3 с открытым исходным кодом: по производительности он сравнится с GPT-4o и превзойдет Llama 3

Мистраль Малый 3: протокол Apache 2.0, 81% MMLU, 150 жетонов/сек.

Сегодня компания Mistral AI выпустила Mistral Small 3, оптимизированную под латентность модель с 24 миллиардами параметров, и опубликовала ее под протоколом Apache 2.0.

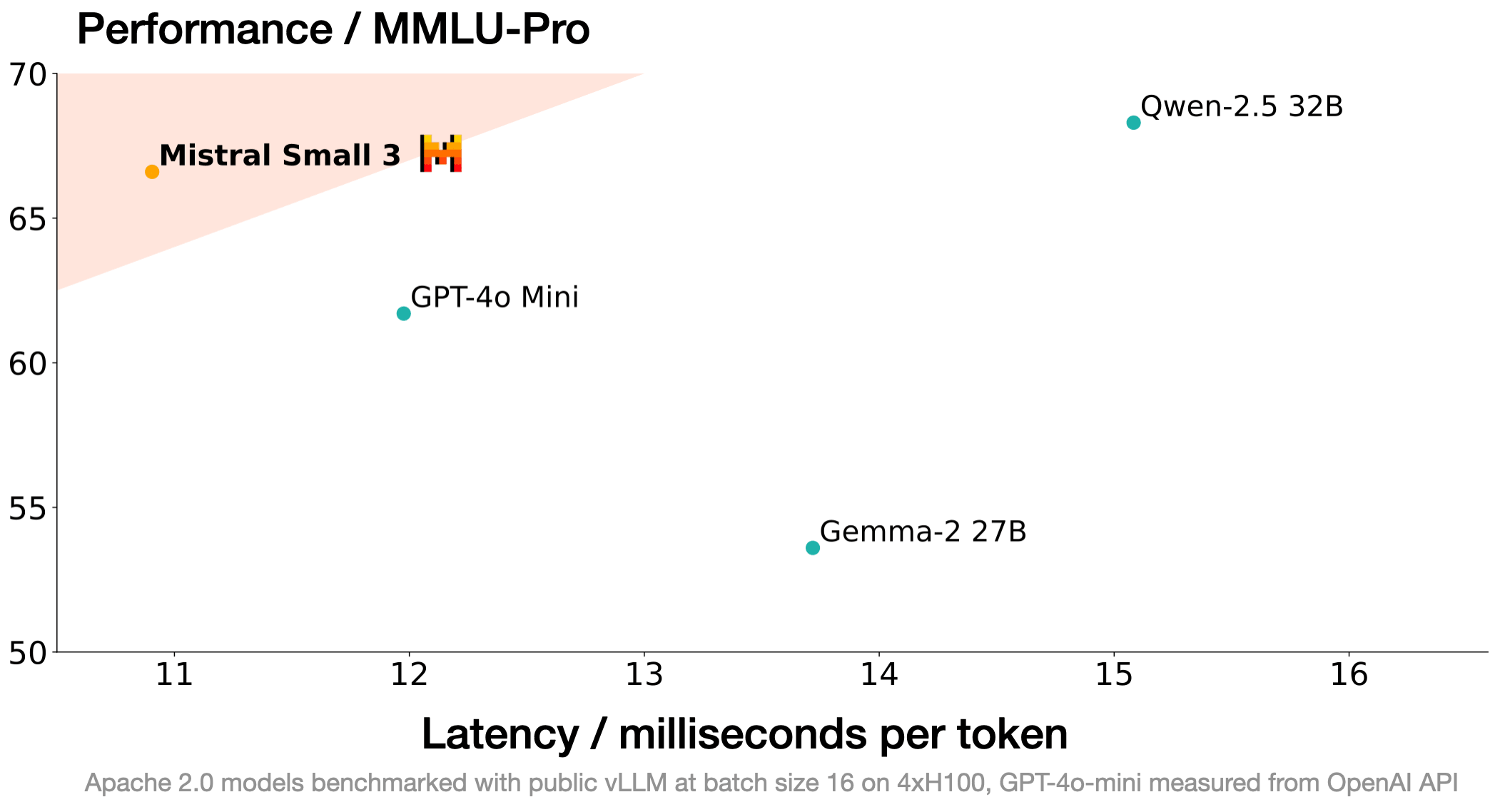

Mistral Small 3 сравним с более крупными моделями, такими как Llama 3.3 70B или Qwen 32B, и является отличной альтернативой с открытым исходным кодом непрозрачным проприетарным моделям, таким как GPT4o-mini. Mistral Small 3 сравним с инструкцией Llama 3.3 70B, но более чем в 3 раза быстрее на том же оборудовании.

Mistral Small 3 - это предварительно обученная модель с точной настройкой инструкций, разработанная для удовлетворения потребностей '80%' в задачах генеративного ИИ, требующих сильных лингвистических способностей и выполнения инструкций с очень низкой задержкой.

Мистраль ИИ Эта новая модель была разработана для насыщения производительности в масштабе, пригодном для локального развертывания. В частности, Mistral Small 3 имеет гораздо меньше слоев, чем конкурирующие модели, что значительно сокращает время распространения вперед. С точностью MMLU более 81% и задержкой 150 токенов/секунду Mistral Small является самой эффективной моделью такого рода на сегодняшний день.

Mistral AI выпускает контрольные точки предварительного обучения и тонкой настройки инструкций в соответствии с протоколом Apache 2.0. Эти контрольные точки могут послужить мощной основой для ускорения прогресса. Обратите внимание, что Mistral Small 3 обучается без использования обучения с подкреплением (RL) и синтетических данных, и поэтому является более эффективным в процессе создания модели, чем Deepseek R1 (отличная и дополняющая технология с открытым исходным кодом!). Mistral AI с нетерпением ждет, когда сообщество с открытым исходным кодом примет и настроит ее. Она может послужить отличной базовой моделью для создания кумулятивной способности к рассуждениям.Mistral AI с нетерпением ждет, когда сообщество с открытым исходным кодом примет и настроит ее.

спектакли

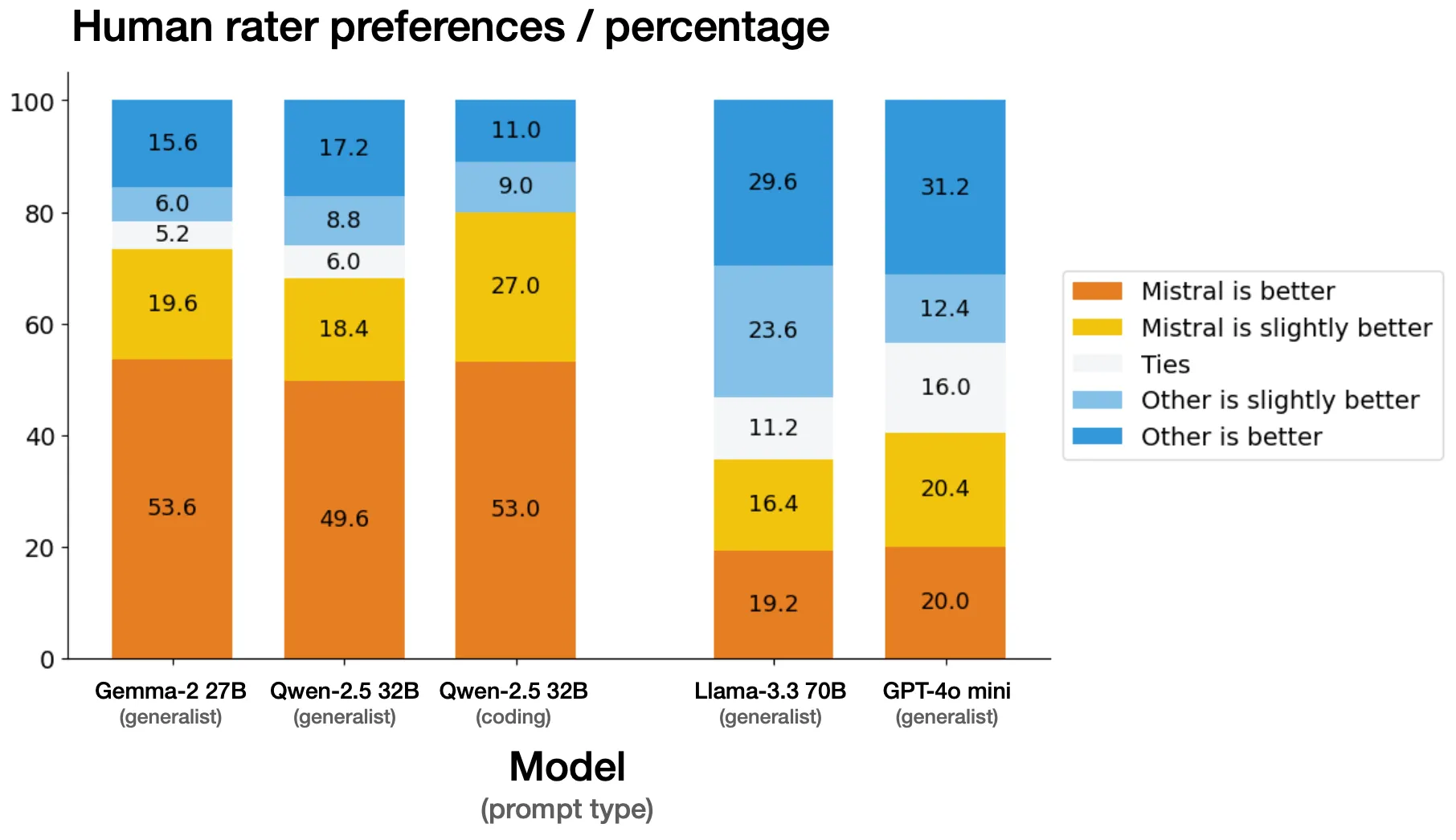

ручная оценка

Компания Mistral AI провела параллельную оценку набора из более чем 1 000 собственных кодов и общих подсказок с внешним сторонним поставщиком. Перед экспертами стояла задача выбрать предпочтительный ответ модели из анонимного результата, сгенерированного Mistral Small 3, в сравнении с другой моделью. Mistral AI осознает, что в некоторых случаях эталоны человеческих суждений будут значительно отличаться от общедоступных эталонов, но Mistral AI предприняла дополнительные усилия, чтобы убедиться в справедливости оценки. действительны.

директивная функция

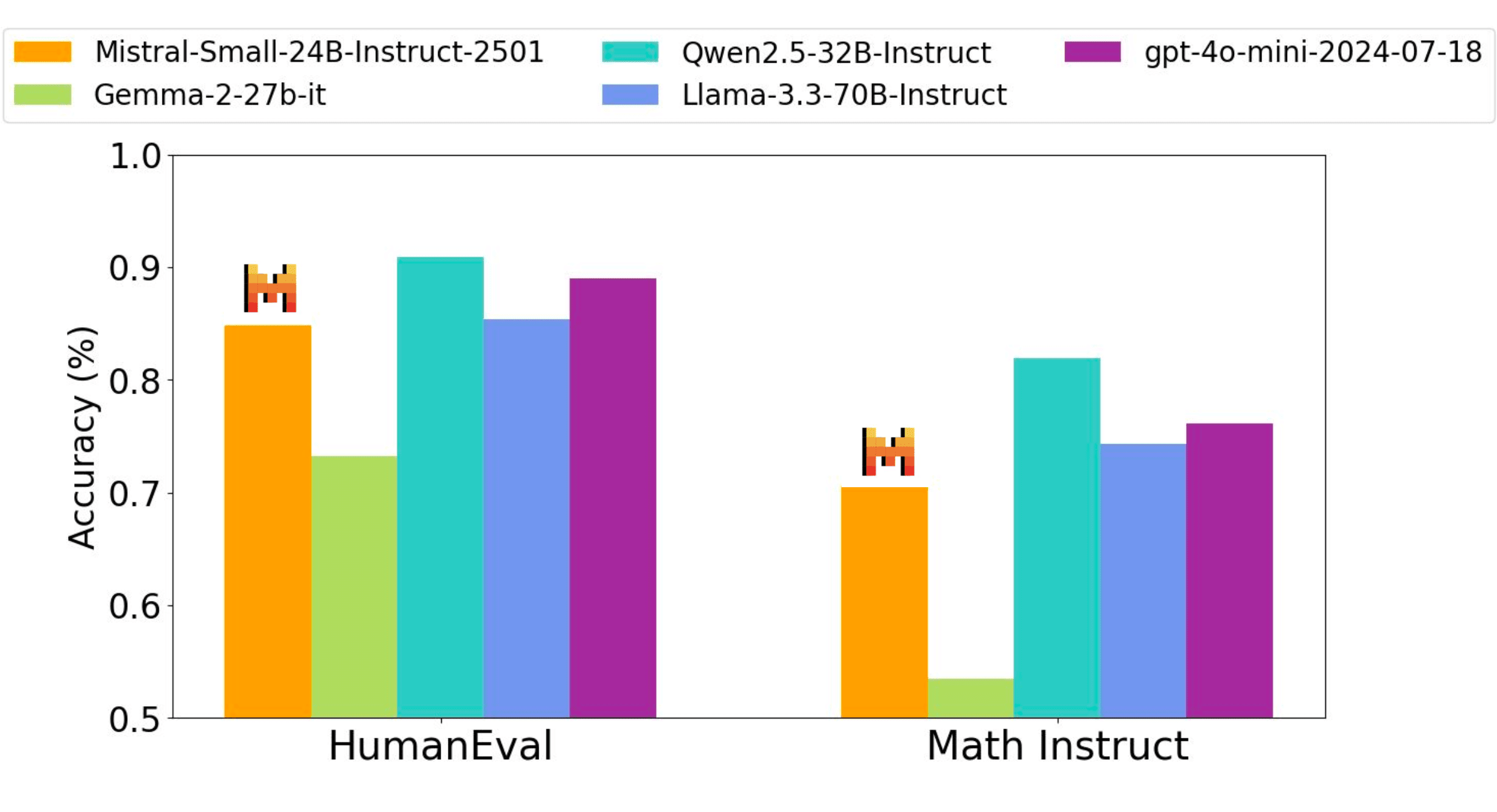

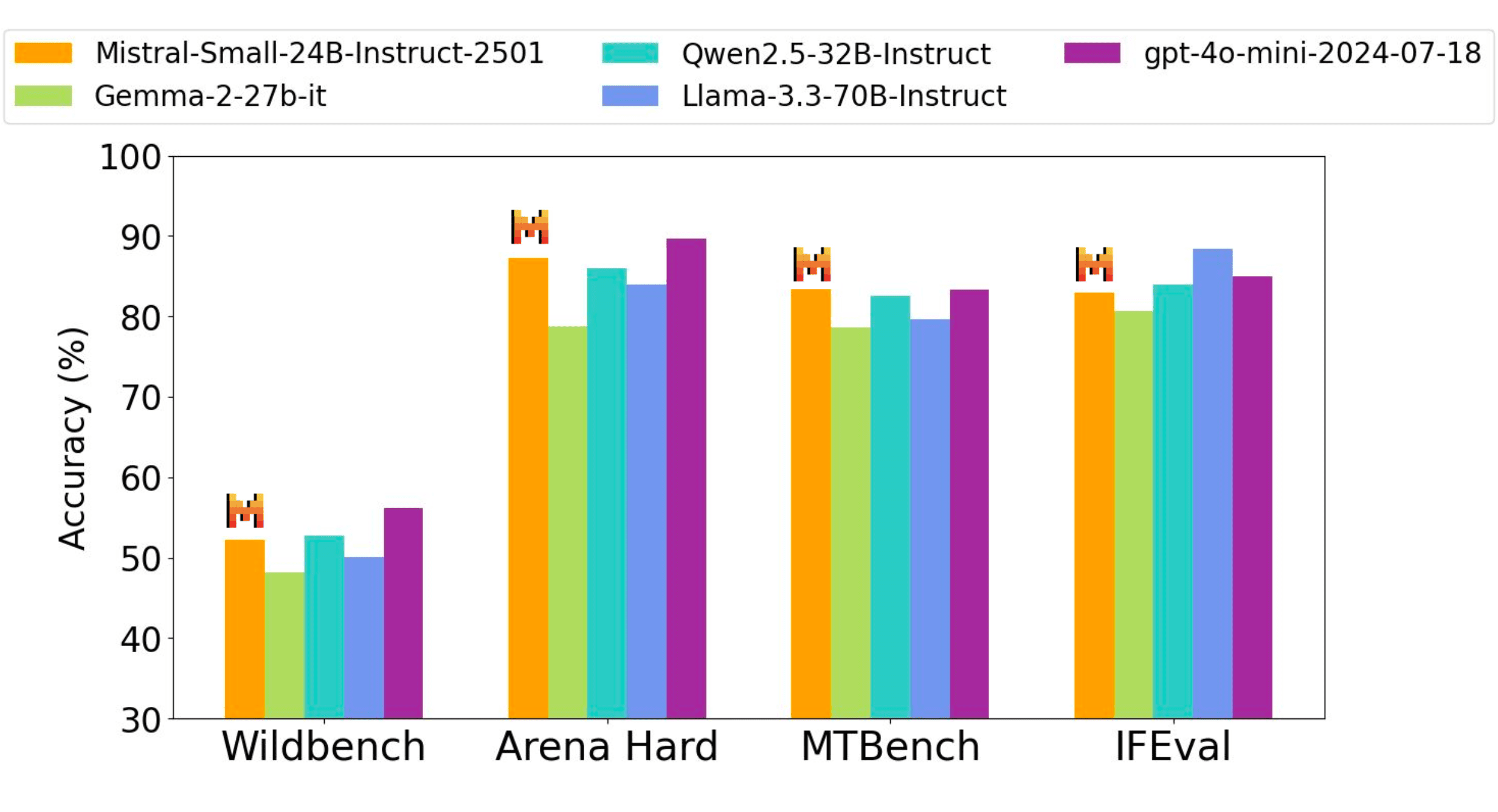

Модель тонкой настройки инструкций Mistral AI имеет конкурентное преимущество перед открытыми моделями взвешивания, которые в три раза больше, а также собственной моделью GPT4o-mini в тестах по коду, математике, общим знаниям и следованию инструкциям.

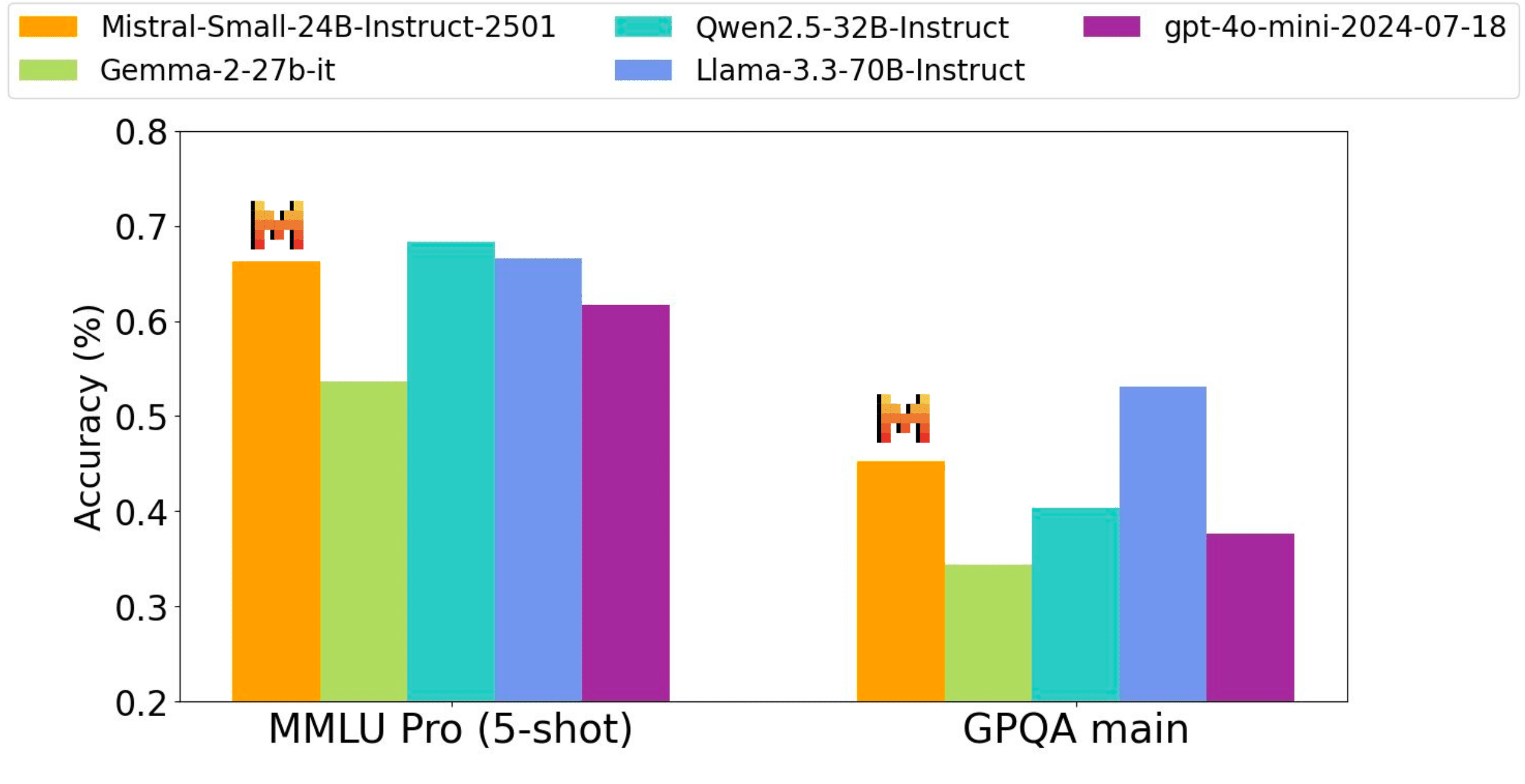

Точность производительности всех бенчмарков получена в ходе одного и того же внутреннего процесса оценки - поэтому цифры могут незначительно отличаться от ранее заявленных (Qwen2.5-32B-Instruct, Llama-3.3-70B-Instruct, Gemma-2-27B-IT). wildbench, Arena hard и Wildbench, Arena hard и MTBench Судейские оценки на основе gpt-4o-2024-05-13.

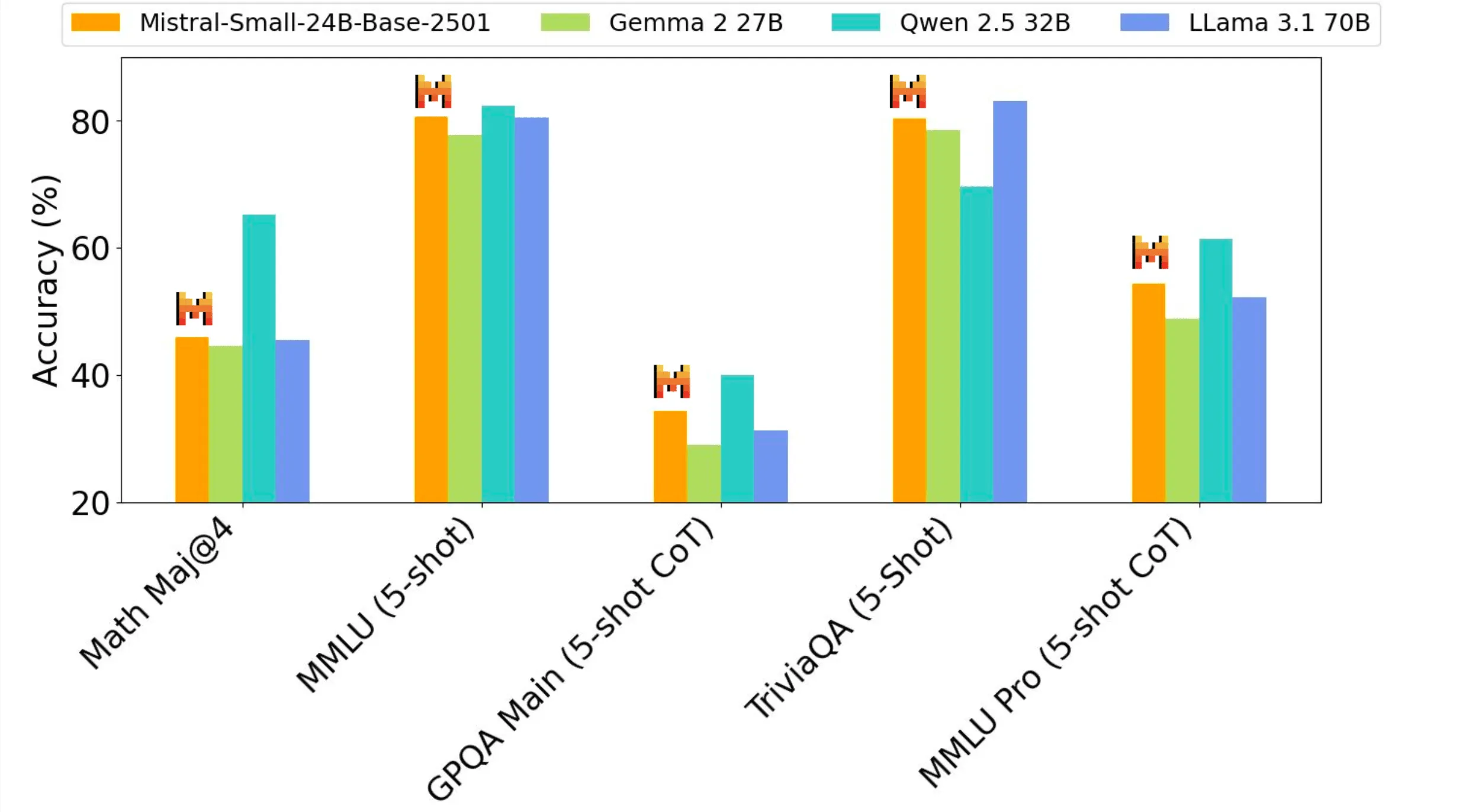

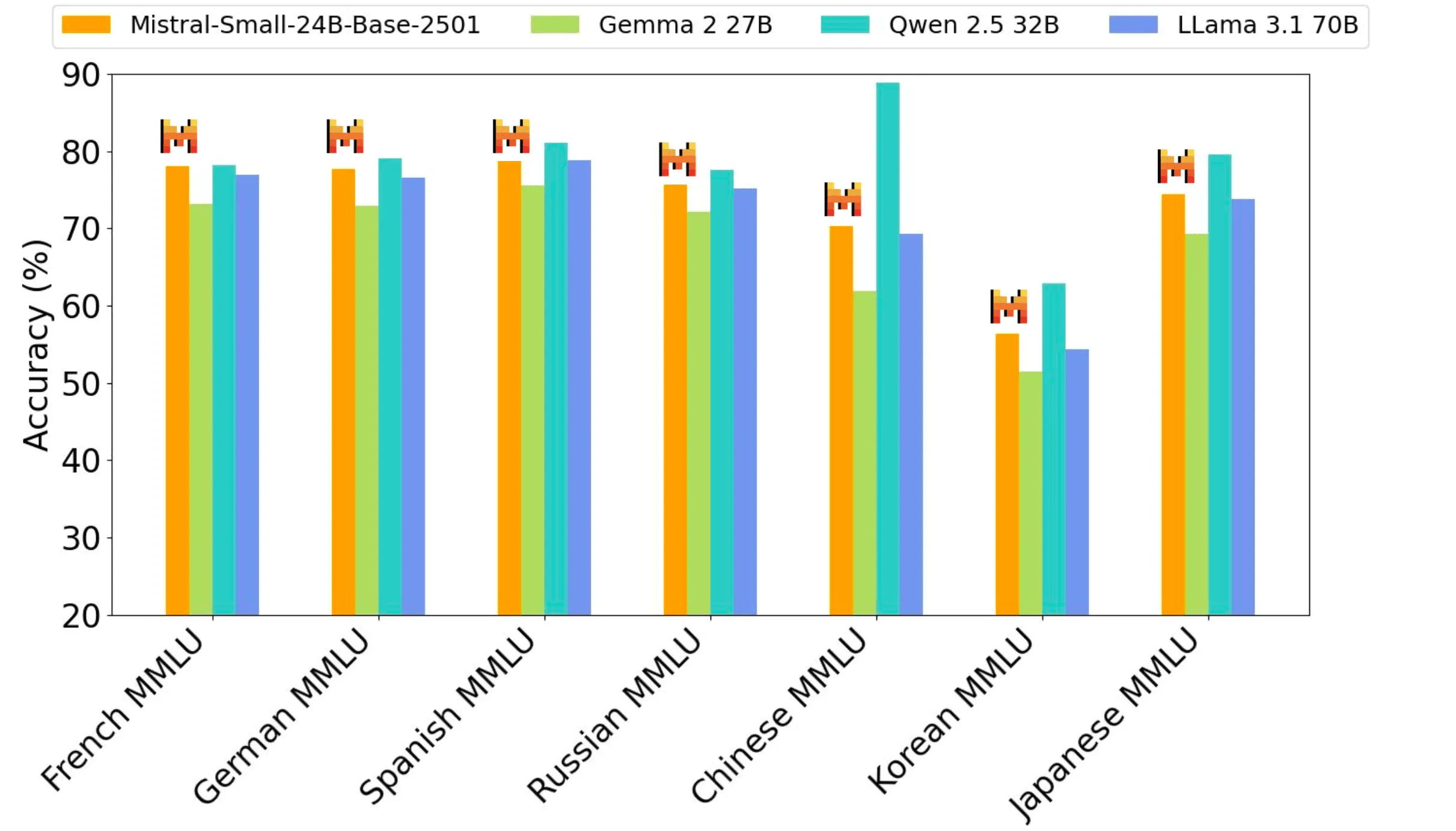

Предтренировочные показатели

Модель Mistral Small 3, имеющая размер 24B, обладает лучшими характеристиками для своего размерного класса и может сравниться с моделями в три раза больше, такими как Llama 3.3 70B.

Когда использовать Mistral Small 3

Среди клиентов и сообщества Mistral AI есть несколько уникальных примеров использования предварительно обученных моделей в таких масштабах:

- Диалоговая помощь с быстрой реакцией: Mistral Small 3 отлично справляется со сценариями, требующими быстрых и точных ответов. К ним относятся многие сценарии виртуальных помощников, в которых пользователи ожидают мгновенной обратной связи и взаимодействия практически в режиме реального времени.

- Вызовы функций с низкой задержкой: Mistral Small 3 может быстро выполнять функции при использовании в качестве части автоматизации или рабочего процесса агента.

- Тонкая настройка для создания экспертов по конкретным вопросам: Mistral Small 3 можно точно настроить, чтобы сфокусироваться на определенных областях и создать высокоточных экспертов по конкретным вопросам. Это особенно полезно в таких областях, как юридическая консультация, медицинская диагностика и техническая поддержка, где критически важны знания в конкретной области.

- Локальные рассуждения: особенно полезны для любителей и организаций, работающих с конфиденциальной или служебной информацией. При количественном анализе Mistral Small 3 может работать в частном порядке на одной RTX 4090 или Macbook с 32 ГБ оперативной памяти.

Клиенты Mistral AI оценивают Mistral Small 3 в различных отраслях, включая:

- Используется клиентами финансовых служб для выявления мошенничества

- Используется медицинскими работниками для сортировки клиентов

- Робототехнические, автомобильные и производственные компании для команд и управления на устройствах

- Горизонтальные варианты использования межклиентского взаимодействия включают виртуальное обслуживание клиентов, анализ настроений и отзывов.

Использование Mistral Small 3 на ваших любимых технологических стеках

Mistral Small 3 теперь доступен на сайте la Plateforme в качестве mistral-small-latest возможно mistral-small-2501 Текст предоставляется в виде модели Mistral AI. Обратитесь к документации Mistral AI, чтобы узнать, как использовать модели Mistral AI для генерации текста.

Mistral AI также рада сотрудничать с Hugging Face, Ollama, Kaggle, Together AI и Fireworks AI, чтобы сделать модель доступной на их платформах, начиная с сегодняшнего дня:

- Обнимающееся лицо (базовая модель)

- Оллама

- Kaggle

- Вместе AI

- Фейерверк AI

- Скоро появится в NVIDIA NIM, Amazon SageMaker, Groq, Databricks и Snowflake!

Путь вперед

Mistral Small 3 дополняет крупные открытые модели вывода, такие как недавно выпущенный DeepSeek, и может использоваться в качестве мощной базовой модели, чтобы вывести возможности вывода на первый план.

Помимо всего прочего, в ближайшие недели будут выпущены малые и средние модели Mistral с расширенными возможностями рассуждений. Если вы хотите присоединиться к путешествию Mistral AI (Mistral AI набирает сотрудников), или пойти дальше, взломав Mistral Small 3 и сделав его лучше прямо сейчас!

Модель Mistral с открытым исходным кодом

Mistral AI подтверждает обязательство Mistral AI использовать протокол Apache 2.0 для общих моделей, поскольку Mistral AI постепенно отказывается от использования моделей, лицензированных MRL . Как и в Mistral Small 3, весовые модели будут доступны для загрузки и локального развертывания, их можно будет свободно модифицировать и использовать в любых условиях. Модели также будут доступны через бессерверные API на la Plateforme, платформах Mistral AI для локального и VPC развертывания, кастомизации и оркестровки, а также партнерам Mistral AI по выводу и облачным вычислениям. Предприятия и разработчики, которым требуется специальная функциональность (повышенная скорость и контекст, знания, специфические для конкретной области, модели для конкретных задач (например, завершение кода)), могут рассчитывать на дополнительные коммерческие модели, дополняющие вклад Mistral AI в сообщество.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...