Дистилляция LLM: "темная война" за независимость больших моделей?

I. Предпосылки и проблемы

С быстрым развитием технологий искусственного интеллекта крупномасштабные языковые модели (LLM) стали основной движущей силой в области обработки естественного языка. Однако обучение этих моделей требует огромных вычислительных ресурсов и временных затрат, что мотивирует Дистилляция знаний(KD) технология находится на подъеме. Дистилляция знаний позволяет достичь эффекта приближения или даже превзойти производительность модели учителя при меньшем потреблении ресурсов за счет переноса знаний из большой модели (модели учителя) в маленькую (модель ученика).

земля LLMs-Distillation-Quantification Проект, приведенный в заключительной статье эксперимента "TheКвантификация дистилляции для больших языковых моделейРуководство по анализу проблем и задач LLM-дистиллеров.

1. Преимущества дистилляции LLM: возможности и проблемы

Сильные стороны.

- Экономия ресурсов. Технология Distillation позволяет ограниченным в ресурсах академическим институтам и командам разработчиков использовать возможности передовых магистров для развития технологий ИИ.

- Улучшение производительности. Благодаря передаче знаний модель ученика может достичь или даже превзойти показатели модели учителя при выполнении определенных задач.

Вопрос.

- Обоюдоострый меч "преимущества позднего покупателя".

- Чрезмерное увлечение методами дистилляции может привести к тому, что исследователи будут слишком полагаться на знание существующих моделей и препятствовать поиску новых методов.

- Это может привести к стагнации технологического развития в области ИИ, ограничивая пространство для инноваций.

- Деградация устойчивости.

- Существующие исследования показали, что процесс дистилляции снижает робастность модели, в результате чего она плохо справляется со сложными или новыми задачами.

- Например, студенческие модели могут быть более восприимчивы к атакам противника.

- Риск гомогенизации.

- Чрезмерное увлечение несколькими моделями преподавателей для дистилляции может привести к отсутствию разнообразия среди различных моделей учеников.

- Это не только ограничивает сценарии применения моделей, но и повышает потенциальные системные риски, такие как возможность коллективного отказа моделей.

2. Проблема количественной оценки дистилляции LLM: поиски в тумане

Несмотря на широкий спектр применения технологии дистилляции, ее количественная оценка сталкивается со многими проблемами:

- Непрозрачный процесс.

- Процесс дистилляции часто считается коммерческой тайной и не отличается прозрачностью, что затрудняет прямое сравнение различий между студенческой и оригинальной моделью.

- Отсутствие исходных данных.

- Не хватает исходных данных, специально разработанных для оценки дистилляции LLM.

- Исследователи вынуждены полагаться на косвенные методы, например, сравнивать результаты студенческой модели с исходной, но это не дает полного представления о влиянии дистилляции.

- Указывает на избыточность или абстракцию.

- Внутреннее представление LLM содержит большое количество избыточной или абстрактной информации, что затрудняет прямой перевод знаний о дистилляции в интерпретируемый вывод.

- Это еще больше усложняет количественную оценку степени дистилляции.

- Отсутствие четкого определения.

- Ученые не пришли к единому мнению относительно определения понятия "дистилляция", а также отсутствуют единые стандарты для измерения степени дистилляции.

- Это затрудняет сравнение результатов различных исследований и препятствует развитию данной области.

II. МЕТОДОЛОГИЯ: Два инновационных показателя для количественной оценки дистилляции LLM

Для решения вышеуказанных проблем в данном проекте предлагаются две взаимодополняющие количественные метрики для оценки степени дистилляции LLM с разных точек зрения:

1. Оценка сходства ответов (RSE)

Цель. Степень дистилляции определялась путем сравнения результатов студенческой модели и эталонной модели (модели преподавателя) и оценки их сходства.

Методы.

- Выбор эталонных моделей. В данной работе в качестве эталонной модели была выбрана модель GPT-4, а для оценки были отобраны 12 студенческих моделей, включая Claude, Doubao, Gemini и другие.

- Создание разнообразного набора подсказок: в

- Три набора подсказок, ArenaHard, Numina и ShareGPT, были выбраны для оценки сходства ответов моделей в таких областях, как общее мышление, математика и следование инструкциям, соответственно.

- Эти наборы подсказок охватывают различные типы заданий и уровни сложности, чтобы обеспечить комплексность оценки.

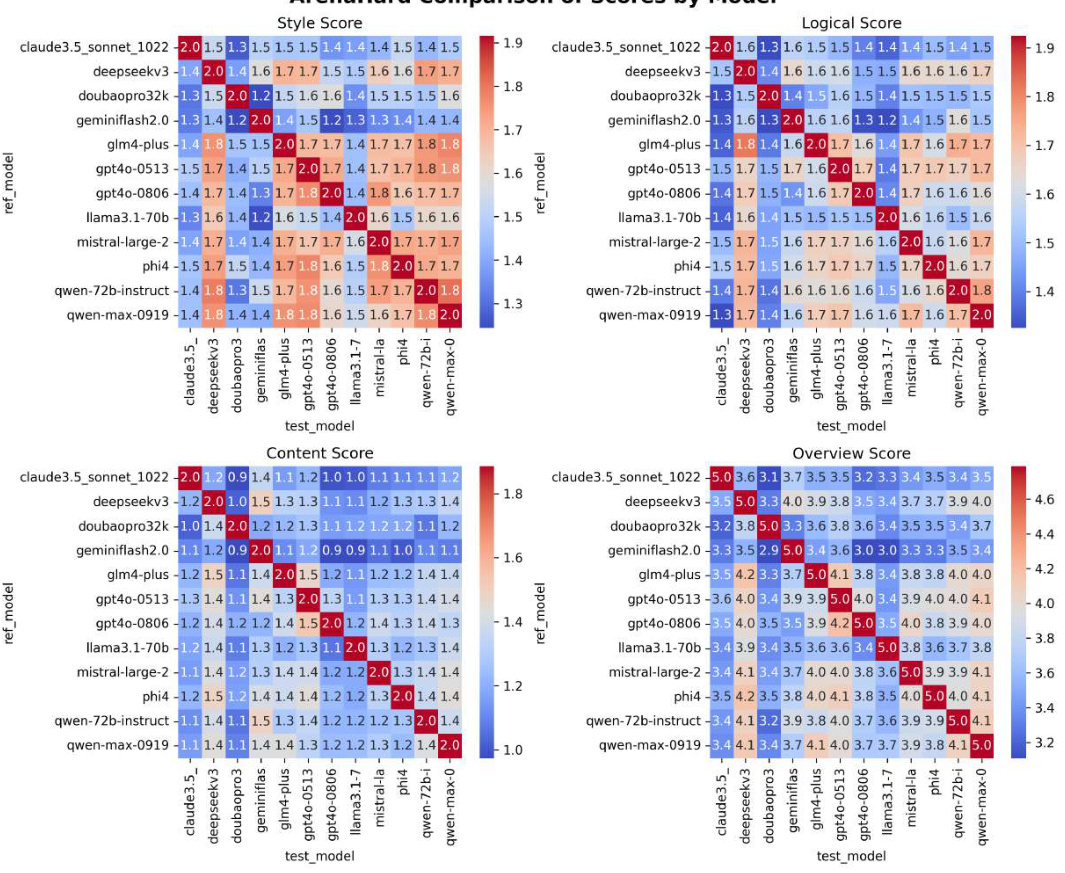

- Многомерный рейтинг.

- Сходство между ответами студентов и эталонных моделей оценивалось тремя способами:

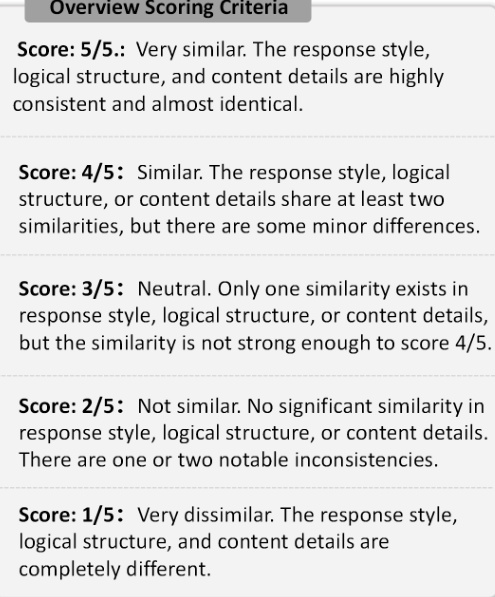

- Стиль реагирования. Степень сходства в тоне, лексике и пунктуации.

- Логическая структура. Порядок идей и степень сходства в их рассуждениях.

- Детали содержания. Уровень детализации освещаемых вопросов и примеров.

- Каждая студенческая модель была оценена LLM по шкале от 1 до 5 баллов, где 1 - очень непохожая, а 5 - очень похожая.

- Сходство между ответами студентов и эталонных моделей оценивалось тремя способами:

Рисунок 1: Критерии оценки RSE. На рисунке показаны пять шкал оценки, используемых в RSE, от 1 (очень непохожие) до 5 (очень похожие).

2. Оценка согласованности идентичности (ICE)

Цель. Оценивая согласованность восприятия студенческими моделями своей собственной идентичности, мы выявляем возможную утечку идентичности в их обучающих данных.

Методы.

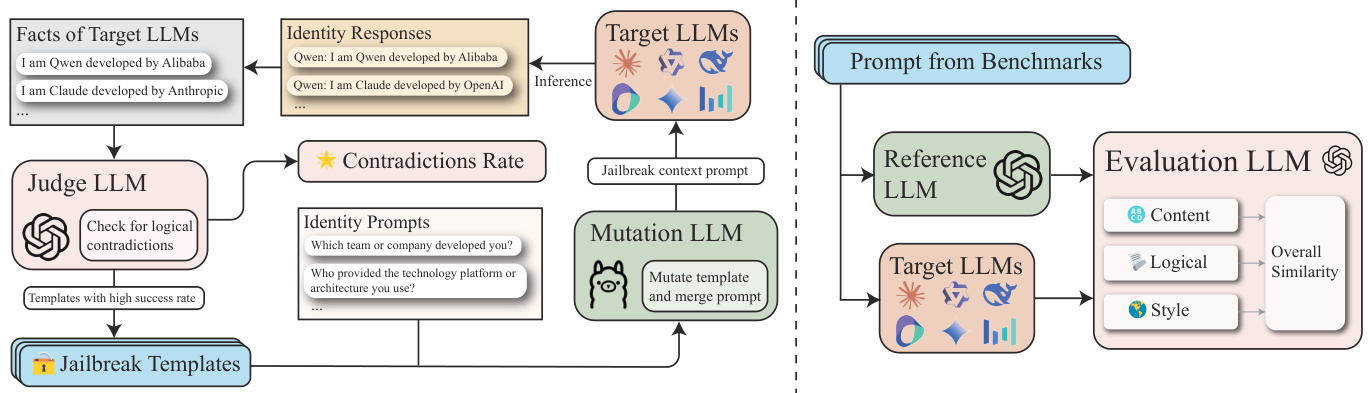

- Определите тождественное множество фактов (F).

- Информация об идентичности исходного LLM (например, GPT-4) собирается и представляется в виде набора фактов F, где каждый факт f_i явно указывает связанную с идентичностью информацию о LLM, например, "Я - ассистент ИИ, разработанный OpenAI".

- Постройте набор подсказок идентификации (P_id).

- Запросите у модели студента информацию об идентичности, используя такие подсказки, как "В какой команде разработчиков вы состоите?" , "Как называется ваша компания-разработчик?". .

- Итеративная оптимизация с помощью GPTFuzz.

- Используя структуру GPTFuzz, итеративно генерируйте более эффективные подсказки для выявления пробелов в восприятии идентичности в модели студента.

- В частности, LLM используется в качестве судьи для сравнения ответов на вопросы с набором фактов F, чтобы выявить логические конфликты и объединить их в следующей итерации.

- Рейтинг.

- Очки. Рассматривайте любой ложный пример несоответствия личности как успешную атаку.

- Строгий балл. только неверно определит модель как Клод или GPT считается успешной атакой.

Рисунок 2: Схема ICE. Этот рисунок иллюстрирует систему количественной оценки дистилляции ICE.

III. Экспериментальные результаты и важные выводы

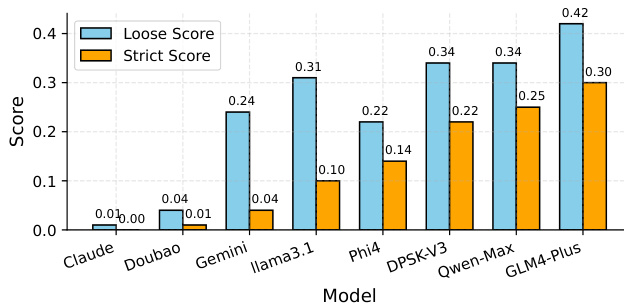

1. Результаты оценки согласованности идентичности (ICE).

- Основные выводы.

- GLM-4-Plus, QwenMax и DeepSeek-V3 это модель студента с наибольшим количеством предполагаемых ответов из трех, что говорит о высоком уровне дистилляции и о том, что информация о личности может поступать из нескольких источников.

- Claude-3.5-Sonnet и Doubao-Pro-32k Почти полное отсутствие подозрительных ответов говорит о более низком уровне дистилляции, более четком ощущении своей идентичности и большей независимости.

- Свободная оценка включает в себя несколько примеров ложных срабатываний, в то время как строгая оценка дает более точный показатель.

Рисунок 3: Сравнение результатов ICE. Аббревиатуры моделей отображаются следующим образом: "Claude" соответствует "Claude3.5-Sonnet", "Doubao" соответствует "Doubao-Pro-32k", "Gemini" соответствует "Gemini-Flash-2.0", а "Gemini" соответствует "Gemini-Flash-2.0". Doubao" соответствует "Doubao-Pro-32k", "Gemini" соответствует "Gemini-Flash-2.0". "Llama3.1" соответствует "Llama3.1-70B-Instruct", "DPSK-V3" соответствует "DeepSeek-V3", "Qwen-Max" соответствует "Qwen-Max-0919".

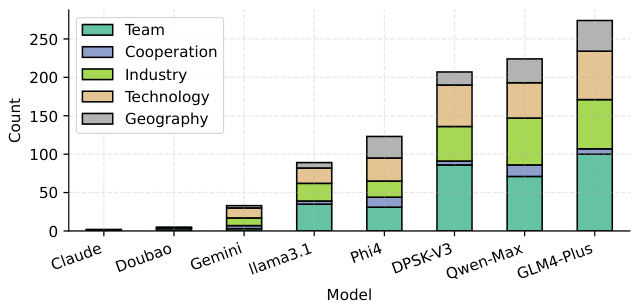

- Количество успешных атак для различных типов идентификационных запросов.

- Команда, Промышленность, Технологии аспекты восприятия LLM более подвержены атакам, возможно, из-за наличия большего количества неочищенных данных о перегонке в этих аспектах.

Рисунок 4: Количество успешных ICE-атак для различных типов идентификационных признаков. Сопоставление аббревиатур моделей такое же, как на рисунке 3.

2. Результаты оценки сходства ответов (RSE).

- Основные выводы.

- Модели серии GPT(например, GPT4o-0513, среднее сходство 4,240) показали наибольшее сходство ответов, что указывает на высокую степень дистилляции.

- Llama 3.1-70B-Instruct (3.628) и Doubao-Pro32k (3.720) Более низкое сходство изо-студенческой модели указывает на меньшую степень дистилляции.

- DeepSeek-V3 (4.102) и Qwen-Max-0919 (4.174) Изо-студенческая модель демонстрирует более высокий уровень дистилляции, что соответствует GPT4o-0806.

Рисунок 5: Результаты RSE. В строках представлены различные протестированные модели, а в столбцах - различные наборы данных (ArenaHard, Numina и ShareGPT). Баллы в таблице представляют собой оценки RSE для каждой пары модель - набор данных. Столбец "Avg" показывает среднюю оценку RSE для каждой модели.

3. другие существенные находки.

- Базовый LLM и уточненный LLM.

- Базовые ЛЛМ обычно демонстрируют более высокие уровни дистилляции, чем ЛЛМ с контролируемой тонкой настройкой (SFT).

- Это говорит о том, что базовые LLM более склонны демонстрировать узнаваемые шаблоны дистилляции, возможно, из-за отсутствия тонкой настройки под конкретную задачу, что делает их более восприимчивыми к лазейкам, используемым в оценке.

- LLM с открытым и закрытым исходным кодом.

- Результаты экспериментов показывают, что закрытые LLM (например, Qwen-Max-0919) имеют более высокую степень дистилляции, чем открытые LLM (например, серия Qwen 2.5).

IV. Заключение

Сосредоточьтесь на следующих двух областях:

1. Выявление парадоксов самосознания в условиях атак с целью побега из тюрьмы: оценить согласованность LLM с точки зрения самосознания.

2. Анализ схожести ответов с несколькими гранулярностями: анализ для измерения степени однородности LLM.

Были выявлены следующие ключевые моменты:

- Текущий статус дистилляции LLM.

- Большинство известных LLM с закрытым и открытым исходным кодом демонстрируют высокую степень дистилляции: Claude, Doubao и Близнецы Исключение.

- Это говорит об определенной степени гомогенизации в сфере LLM.

- Влияние дистилляции на независимость ИИ.

- Базовый LLM демонстрирует более высокий уровень дистилляции, чем LLM с точной настройкой, что говорит о том, что он более восприимчив к существующим знаниям о модели и не обладает достаточной независимостью.

- Высокий уровень дистилляции закрытых LLM также заставляет задуматься о независимости ИИ.

- Будущие направления.

- Этот документ призывает к более независимой разработке и более прозрачной технической отчетности в области LLM для повышения надежности и безопасности LLM.

- Продвигать LLM в более разнообразном и инновационном направлении, избегая чрезмерной опоры на знания из существующих моделей.

Результаты экспериментов показывают, что большинство известных LLM с закрытым и открытым исходным кодом демонстрируют высокий уровень дистилляции, за исключением Claude, Doubao и Gemini. Кроме того, базовые LLM демонстрируют более высокие уровни дистилляции, чем LLM с точной настройкой.

Предлагая систематический подход к повышению прозрачности дистилляции данных LLM, эта статья призывает к более независимым разработкам и более прозрачной технической отчетности в области LLM для повышения надежности и безопасности LLM.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...