LiteLLM: Python SDK для унифицированного вызова нескольких API Big Model, мультиплатформенный инструмент для вызова и управления LLM

Общее введение

LiteLLM - это Python SDK и прокси-сервер, разработанный BerriAI для упрощения и унификации вызова и управления несколькими API больших языковых моделей (LLM). Он поддерживает более 100 API больших моделей, включая OpenAI, HuggingFace, Azure и т. д., и унифицирует их в формат OpenAI, что упрощает разработчикам переключение и управление между различными сервисами ИИ. LiteLLM позволяет пользователям вызывать более 100 API LLM в формате OpenAI через прокси-сервер и Python SDK, что значительно повышает эффективность и гибкость разработки.

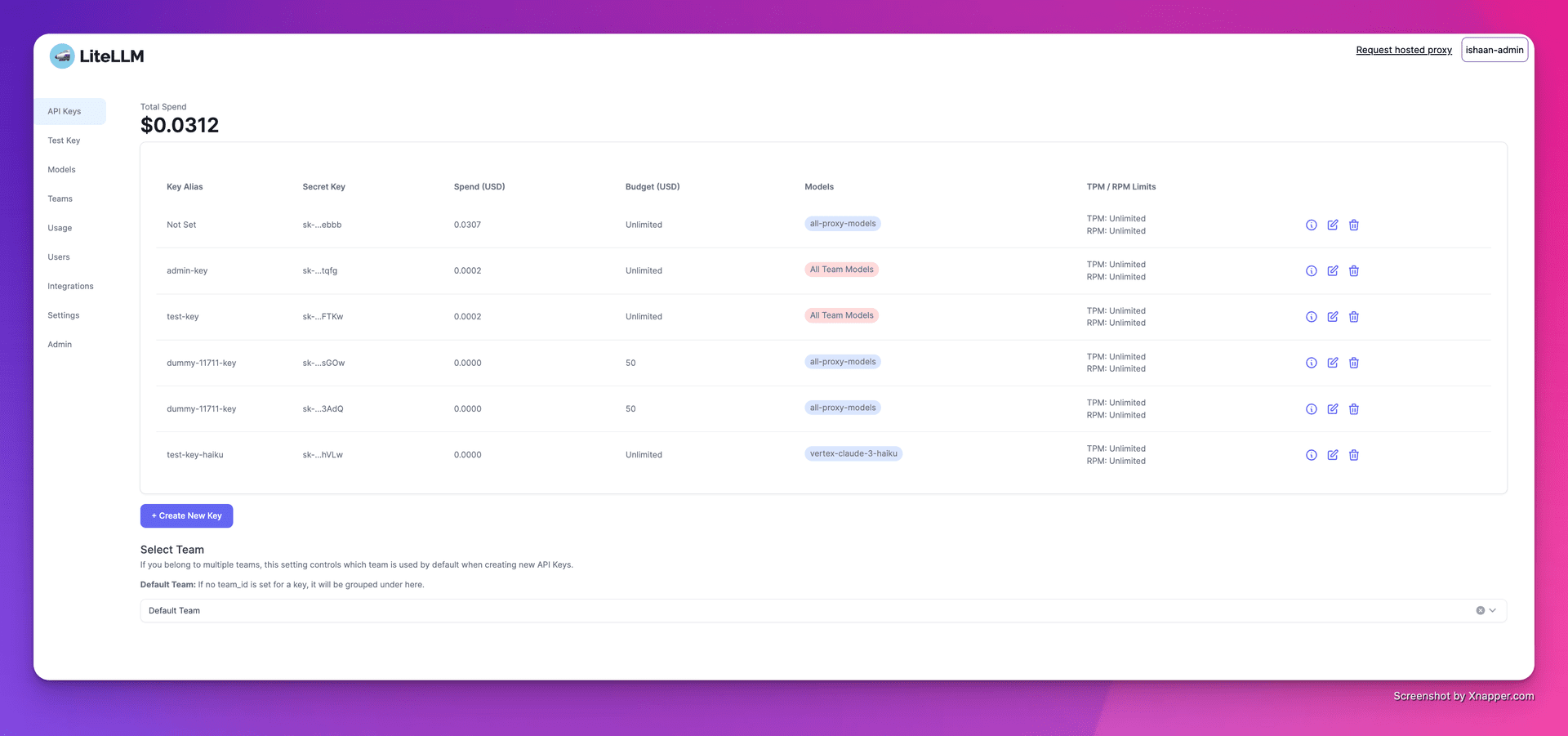

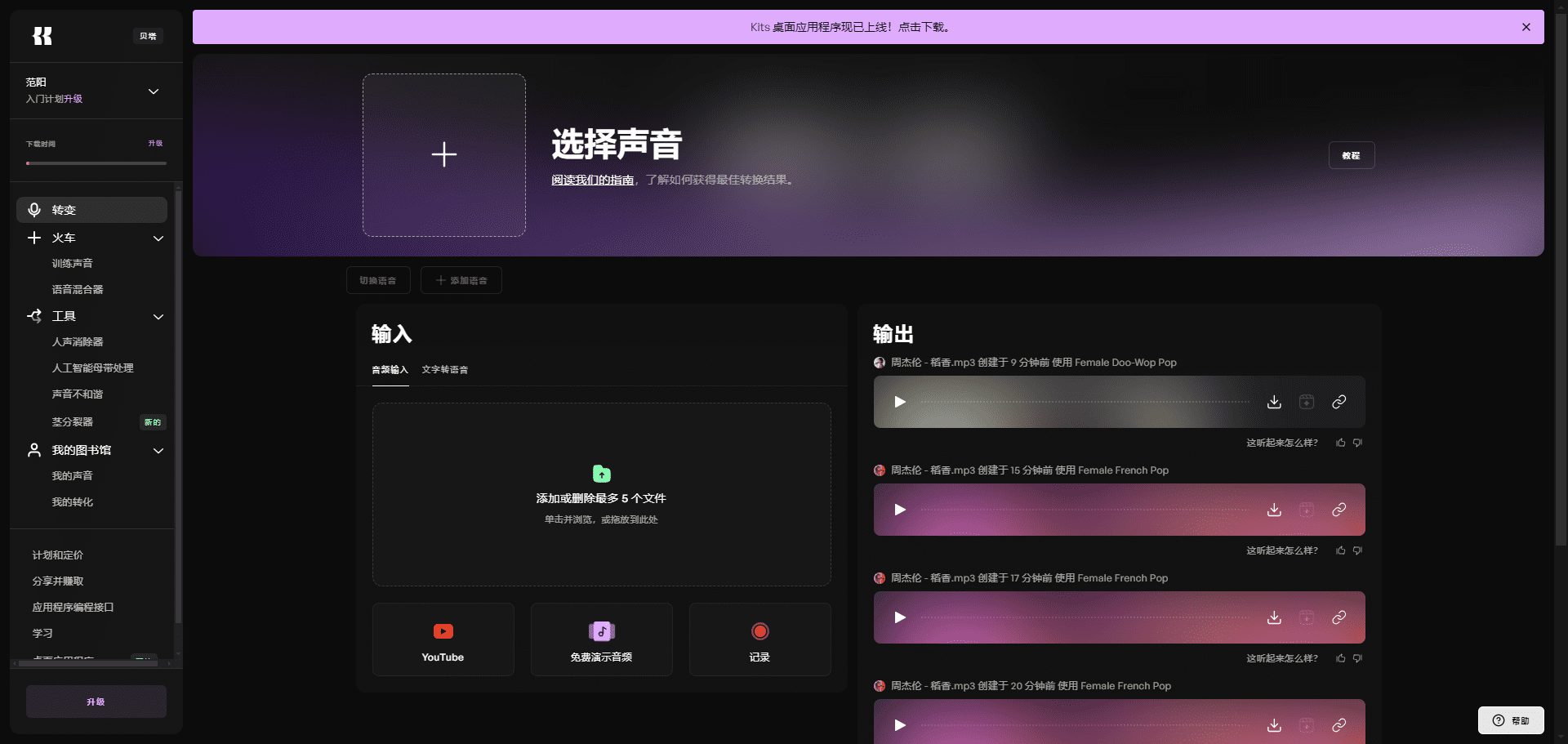

1. Создание ключей

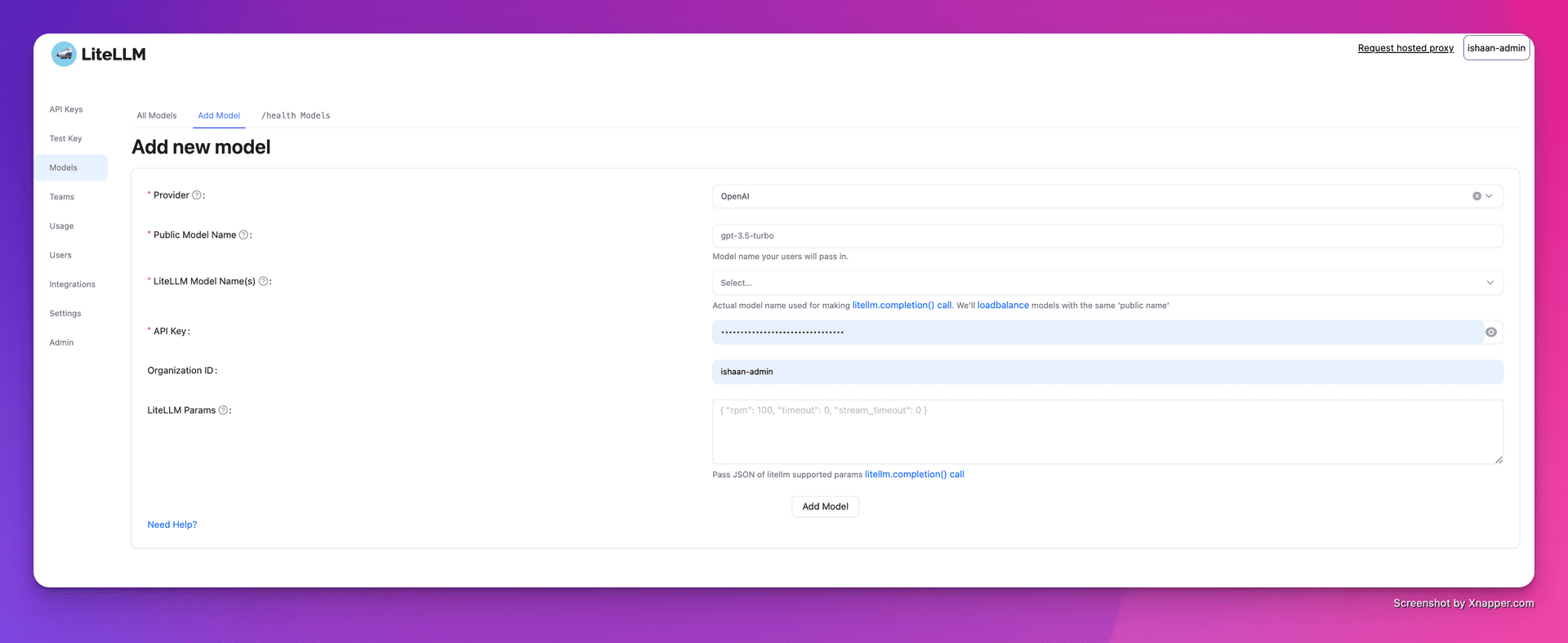

2. Добавление моделей

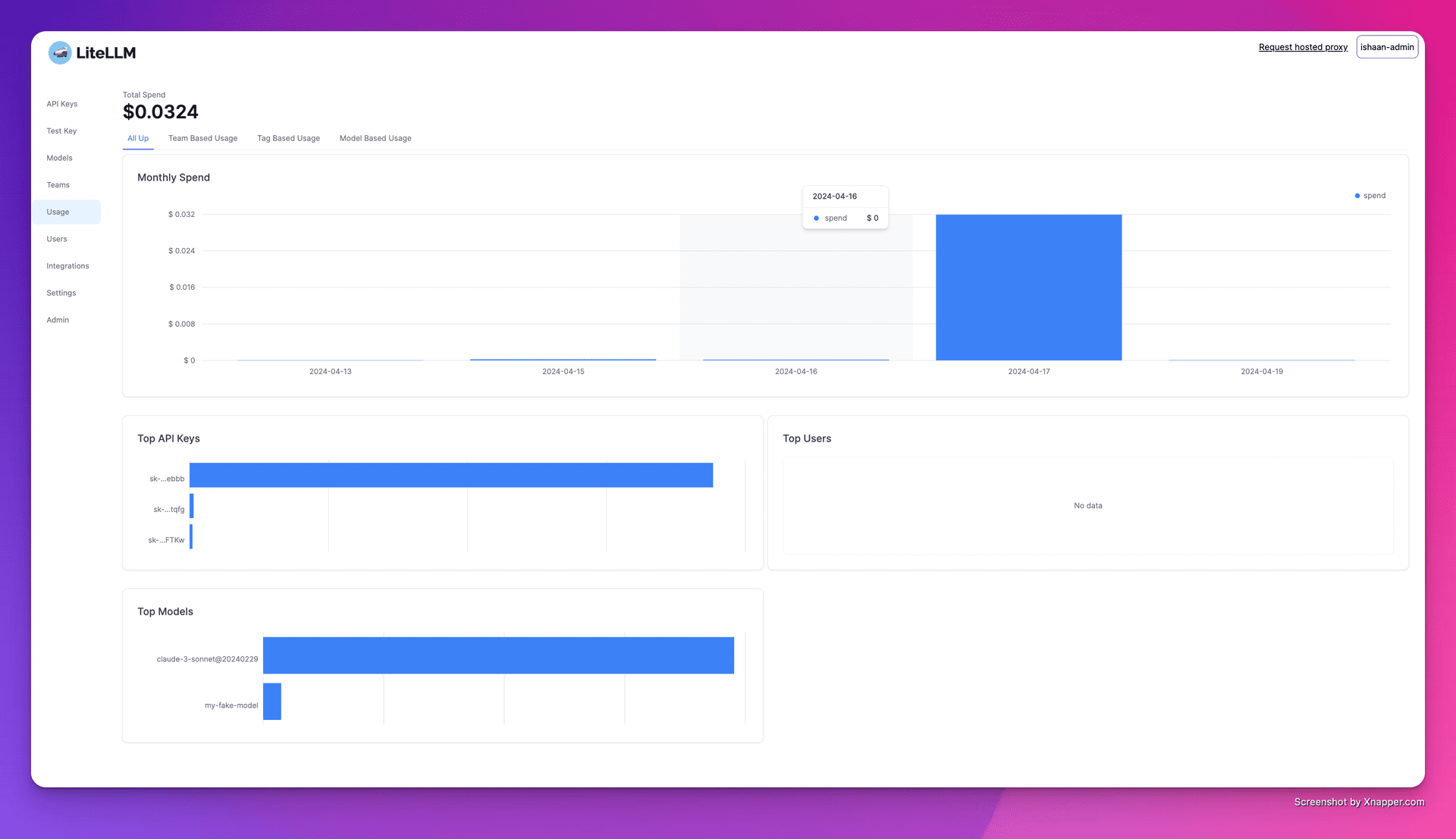

3. Отслеживание расходов

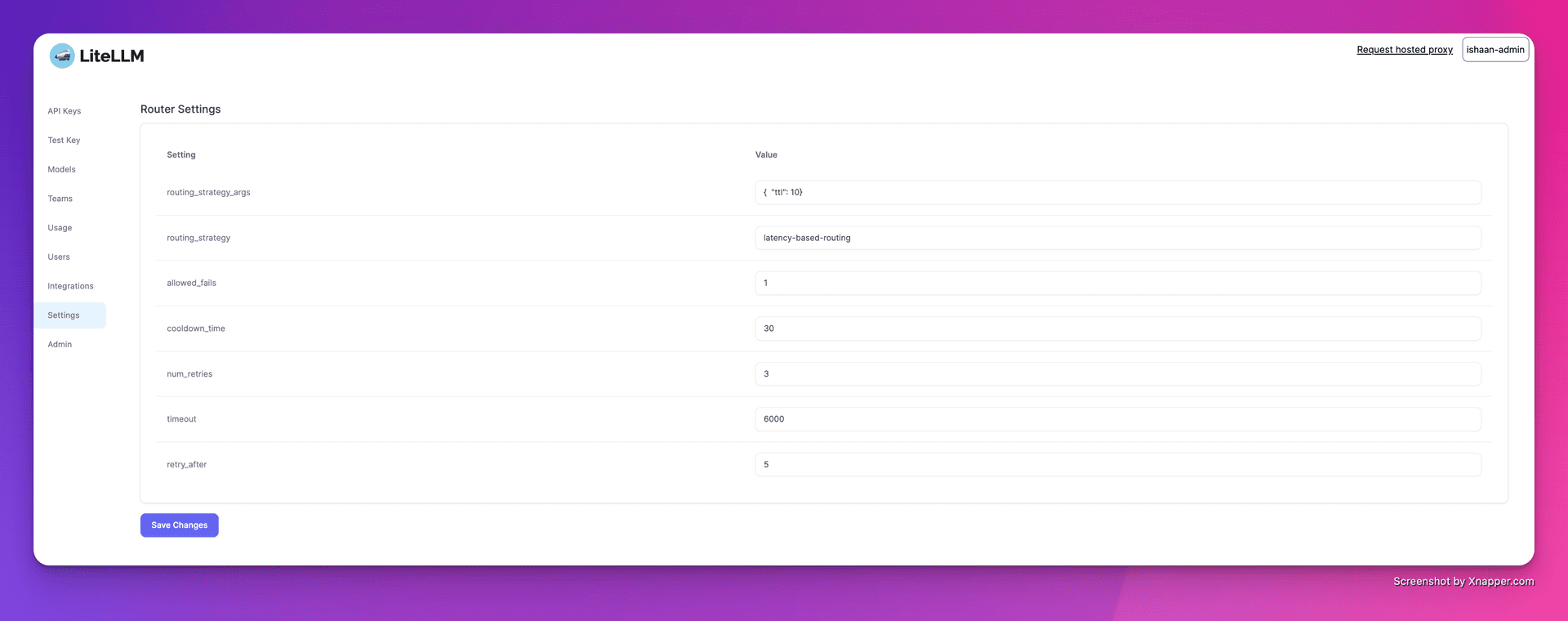

4. Настройка балансировки нагрузки

Список функций

- Поддержка нескольких платформ: Поддерживает множество LLM-провайдеров, таких как OpenAI, Cohere, Anthropic и другие. Поддерживает более 100 API-вызовов больших моделей.

- стабильная версия: Предоставляет стабильные образы Docker, прошедшие нагрузочное тестирование в течение 12 часов. Поддерживает установку ограничений по бюджету и частоте запросов.

- прокси-сервер: Унифицированный вызов нескольких LLM API через прокси-сервер, унифицированное преобразование формата API в формат OpenAI.

- Python SDK: Для упрощения процесса разработки предоставляется Python SDK.

- потоковый ответ: Поддержка потоковой передачи ответов модели возврата для улучшения пользовательского опыта.

- функция обратного вызова: Поддержка нескольких обратных вызовов для удобного протоколирования и мониторинга.

Использование помощи

Установка и настройка

- Установка Docker: Убедитесь, что Docker установлен в вашей системе.

- Вытягивание зеркал: Использование

docker pullКоманда извлекает стабильный образ LiteLLM. - Запуск прокси-сервера::

cd litellm echo 'LITELLM_MASTER_KEY="sk-1234"' > .env echo 'LITELLM_SALT_KEY="sk-1234"' > .env source .env poetry run pytest . - Настройка клиента: Задайте в коде адрес прокси-сервера и ключ API.

import openai client = openai.OpenAI(api_key="your_api_key", base_url="http://0.0.0.0:4000") response = client.chat.completions.create(model="gpt-3.5-turbo", messages=[{"role": "user", "content": "Hello, how are you?"}]) print(response)

Функции использования

- модель вызова: через

model=<provider_name>/<model_name>Вызов моделей от разных поставщиков. - потоковый ответ: Настройки

stream=TrueПолучите потоковый ответ.response = await acompletion(model="gpt-3.5-turbo", messages=messages, stream=True) for part in response: print(part.choices.delta.content or "") - Настройка обратных вызовов: Настройте функции обратного вызова для регистрации входов и выходов.

litellm.success_callback = ["lunary", "langfuse", "athina", "helicone"]

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...