LazyLLM: инструмент разработки с открытым исходным кодом Shangtang для создания мультиинтеллектуальных приложений для тела

Общее введение

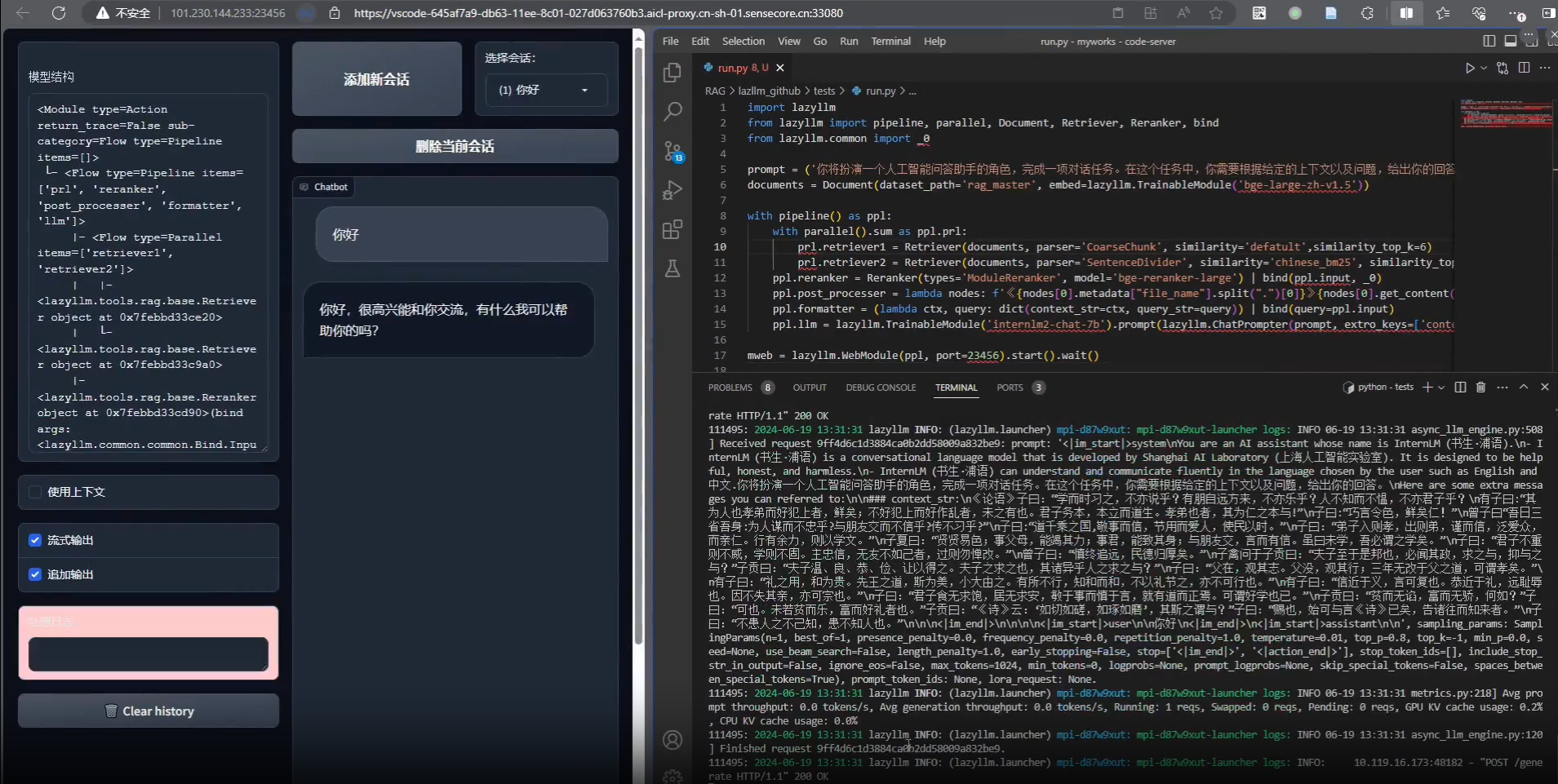

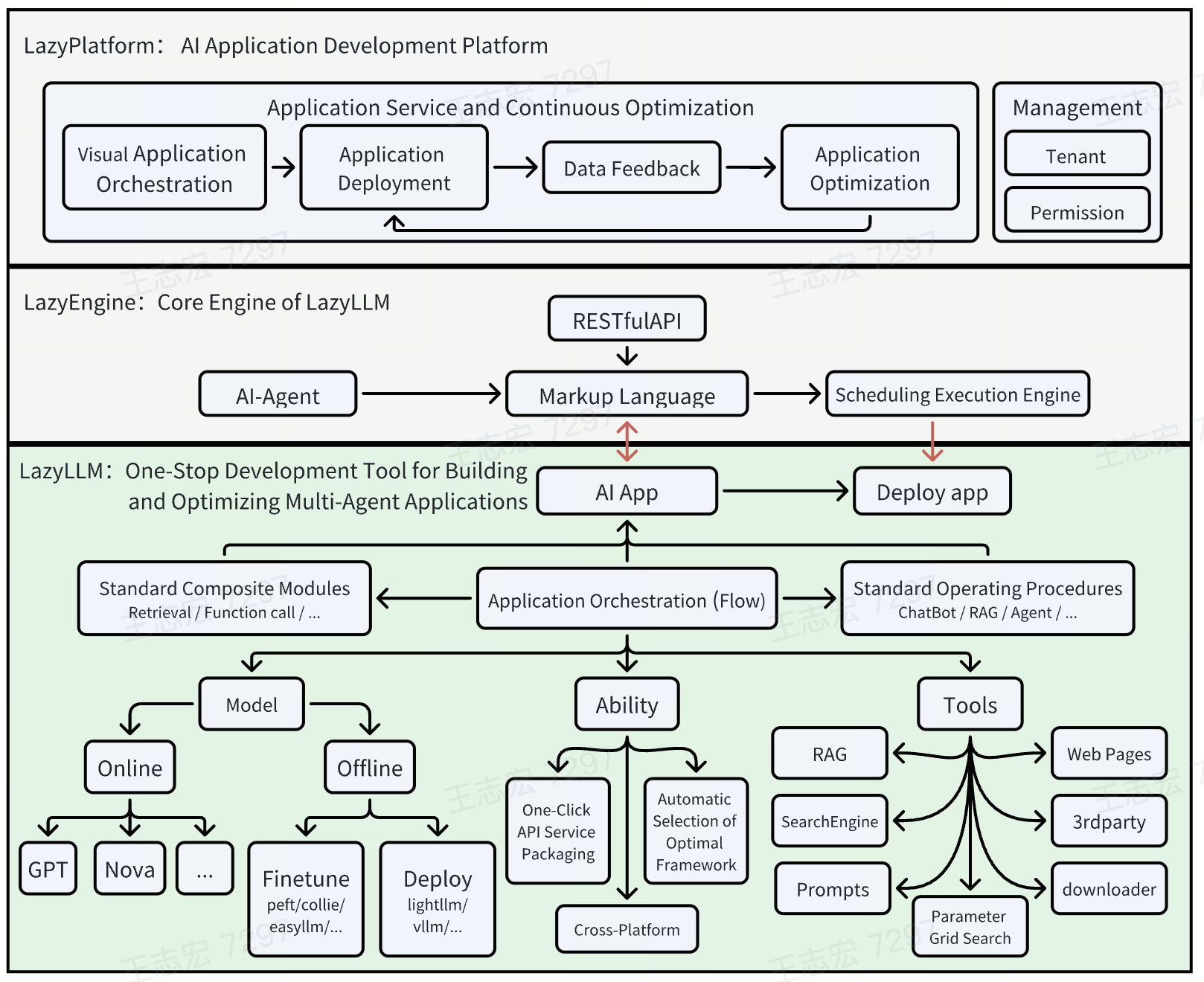

LazyLLM - это инструмент с открытым исходным кодом, разработанный командой LazyAGI и направленный на упрощение процесса разработки приложений с большим количеством интеллектуальных моделей. Он помогает разработчикам быстро создавать сложные ИИ-приложения и экономить время на утомительных инженерных настройках благодаря развертыванию в один клик и легким механизмам шлюзов. Независимо от того, начинающий вы или опытный разработчик, LazyLLM обеспечивает поддержку: новички могут легко начать работу с готовыми модулями, в то время как эксперты могут достичь продвинутой разработки с помощью гибких функций настройки. Инструмент подчеркивает эффективность и практичность, интегрируя предпочтительные компоненты, чтобы обеспечить создание готовых к производству приложений с минимальными затратами. В настоящее время на GitHub насчитывается более 1100 звезд, сообщество активно и постоянно обновляется.

Список функций

- Развертывание сложных приложений одним щелчком мыши: Поддерживает полный процесс от проверки прототипа до выпуска продукции с автоматизированной конфигурацией сервисов субмодуля.

- Кросс-платформенная совместимость: Адаптация к пустым серверам, машинам разработки, кластерам Slurm и публичным облакам без изменения кода.

- Управление потоками данных (Flow): Предоставляет предопределенные процессы, такие как Pipeline и Parallel, для простой организации сложной логики приложения.

- модульный компонент: Поддержка кастомизации и расширений, интеграция пользовательских алгоритмов или инструментов сторонних производителей.

- Облегченный механизм шлюза: Упростите запуск службы и настройку URL для более эффективной разработки.

- Поддержка развития мультиразведки: Быстрое создание приложений, содержащих множество агентов ИИ, приспособленных к решению больших модельных задач.

Использование помощи

Процесс установки

LazyLLM - это проект с открытым исходным кодом на базе Python, процесс установки прост и понятен. Вот подробные шаги:

Подготовка к защите окружающей среды

- Проверка системных требований: Убедитесь, что на вашем устройстве установлен Python 3.8 или выше.

- Установка Git: Если у вас не установлен Git, вы можете использовать инструмент командной строки, такой как

apt-get install gitвозможноbrew install git) Установка. - Создание виртуальной среды (необязательно, но рекомендуется)::

python -m venv lazyllm_env source lazyllm_env/bin/activate # Linux/Mac lazyllm_env\Scripts\activate # Windows

Загрузка и установка

- Клонирование репозитория GitHub::

git clone https://github.com/LazyAGI/LazyLLM.git cd LazyLLM - Установка зависимостей::

- Выполните следующую команду для установки необходимых библиотек:

pip install -r requirements.txt - Если вы столкнулись с конфликтом зависимостей, попробуйте обновить pip:

pip install --upgrade pip

- Выполните следующую команду для установки необходимых библиотек:

- Проверка установки::

- Запустите код примера, чтобы убедиться в успешной установке:

python -m lazyllm --version - Если возвращается номер версии (например, v0.5), установка завершена.

- Запустите код примера, чтобы убедиться в успешной установке:

Дополнительно: развертывание Docker

- LazyLLM поддерживает упаковку образов Docker в один клик:

- Установите Docker (см. официальный сайт: https://docs.docker.com/get-docker/).

- Запустите его в корневом каталоге проекта:

docker build -t lazyllm:latest . docker run -it lazyllm:latest

Как использовать

В основе LazyLLM лежит возможность быстрого создания приложений искусственного интеллекта за счет модульности и управления потоками данных. Ниже представлено подробное руководство по использованию ключевых функций:

Особенность 1: развертывание сложных приложений одним щелчком мыши

- процедура::

- Подготовка файла конфигурации приложения: Создать

config.yamlОпределите модули и сервисы. Например:modules: - name: llm type: language_model url: http://localhost:8000 - name: embedding type: embedding_service url: http://localhost:8001 - Начальные услуги::

python -m lazyllm deploy - проверка состояния: Получите доступ к журналу, чтобы убедиться в правильности работы всех модулей.

- Подготовка файла конфигурации приложения: Создать

- Описание: Эта функция автоматически соединяет подмодули через легкий шлюз, избавляя от необходимости вручную настраивать URL-адреса и делая ее идеальной для быстрого создания прототипов.

Особенность 2: кроссплатформенная совместимость

- процедура::

- Назначенные платформы: Добавьте параметры в командную строку, например:

python -m lazyllm deploy --platform slurm - Коммутационные среды: Не нужно менять код, просто замените

--platformпараметры (например.cloudвозможноbare_metal).

- Назначенные платформы: Добавьте параметры в командную строку, например:

- сценарий примененияРазработчики могут плавно переходить в облако после локального тестирования, чтобы сократить усилия по адаптации.

Функция 3: Управление потоками данных (Flow)

- процедура::

- Определение потока данных: Вызов предопределенного потока в сценарии Python. например, для создания конвейера:

from lazyllm import pipeline flow = pipeline( step1=lambda x: x.upper(), step2=lambda x: f"Result: {x}" ) print(flow("hello")) # 输出 "Result: HELLO" - Выполнение сложных процессов: Многозадачность в сочетании с Parallel или Diverter:

from lazyllm import parallel par = parallel( task1=lambda x: x * 2, task2=lambda x: x + 3 ) print(par(5)) # 输出 [10, 8]

- Определение потока данных: Вызов предопределенного потока в сценарии Python. например, для создания конвейера:

- Описание: Flow предоставляет стандартизированные интерфейсы для сокращения дублирования преобразования данных и поддержки совместной разработки между модулями.

Функция 4: Модульная настройка компонентов

- процедура::

- Регистрация пользовательских функций::

from lazyllm import register @register def my_function(input_text): return f"Processed: {input_text}" - Интеграция в приложения: Вызывается в конфигурации потока или развертывания

my_function.

- Регистрация пользовательских функций::

- Расширенное использование: Поддержка регистрации команд Bash для разработки гибридных сценариев.

Советы и рекомендации

- регулировка компонентов во время тестирования: Дополнения во время выполнения

--verboseчтобы просмотреть подробный журнал:python -m lazyllm deploy --verbose - Поддержка общества: Вы можете оставить отзыв на GitHub Issues, и команда своевременно ответит на него.

- обновление: Регулярно обновляйте код:

git pull origin main

Выполнив эти шаги, вы сможете быстро приступить к работе с LazyLLM и создавать приложения от простых прототипов до крупных моделей на уровне производства.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...