GPUStack: управление кластерами GPU для запуска больших языковых моделей и быстрой интеграции общих сервисов вывода для LLM.

Общее введение

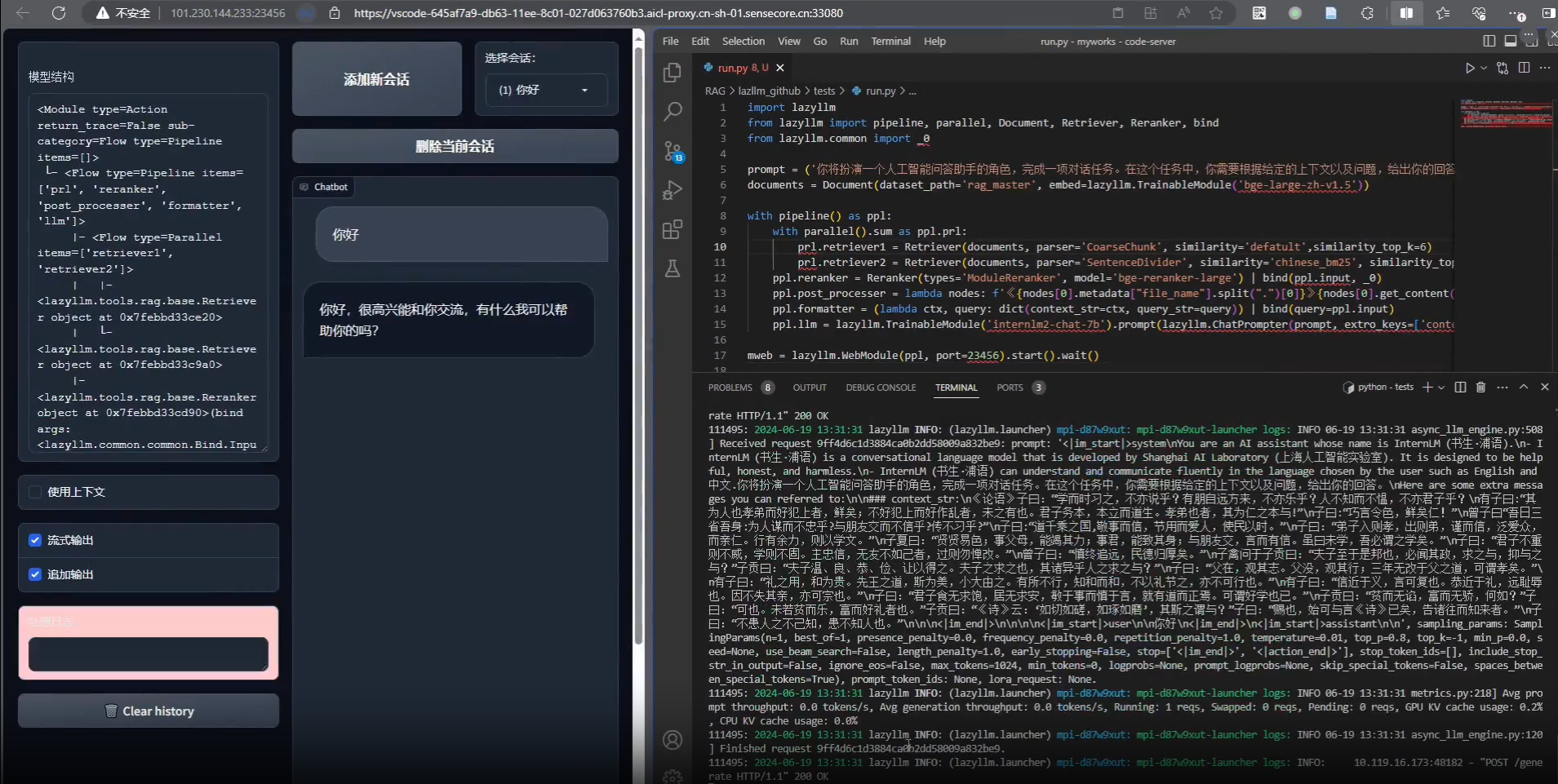

GPUStack - это инструмент управления кластером GPU с открытым исходным кодом, предназначенный для работы с большими языковыми моделями (LLM). Он поддерживает широкий спектр оборудования, включая Apple MacBooks, Windows PC и Linux-серверы, и позволяет легко масштабировать количество GPU и узлов для удовлетворения растущих вычислительных потребностей. GPUStack предоставляет возможности распределенного анализа, поддерживает одноузловой мульти-GPU и многоузловой анализ и сервисы, а также совместим с OpenAI API, что упрощает управление пользователями и ключами API и мониторинг производительности и использования GPU в режиме реального времени. Он совместим с OpenAI API, упрощает управление пользователями и ключами API, а также отслеживает производительность и использование GPU в режиме реального времени. Легкий дизайн пакета Python обеспечивает минимум зависимостей и операционных накладных расходов, что делает его идеальным для разработчиков и исследователей.

Список функций

- Поддержка широкого спектра аппаратных средств: совместимость с Apple Metal, NVIDIA CUDA, Ascend CANN, Moore Threads MUSA и др.

- Распределенные выводы: поддерживаются выводы и сервисы для одного узла с несколькими GPU и нескольких узлов.

- Несколько бэкендов для вывода: поддержка llama-box (llama.cpp) и vLLM.

- Легкие пакеты Python: минимум зависимостей и операционных накладных расходов.

- OpenAI Compatible API: предоставляет API-сервисы, совместимые со стандартом OpenAI.

- Управление ключами пользователей и API: упрощает управление ключами пользователей и API.

- Мониторинг производительности GPU: отслеживайте производительность и загрузку GPU в режиме реального времени.

- Мониторинг использования токенов и скорости: эффективное управление использованием токенов и ограничением скорости.

Использование помощи

Процесс установки

Linux или MacOS

- Откройте терминал.

- Выполните следующую команду, чтобы установить GPUStack:

curl -sfL https://get.gpustack.ai | sh -s -

- После установки GPUStack будет запущен как служба в системе systemd или launchd.

Windows (компьютер)

- Запустите PowerShell от имени администратора (избегайте использования PowerShell ISE).

- Выполните следующую команду, чтобы установить GPUStack:

Invoke-Expression (Invoke-WebRequest -Uri "https://get.gpustack.ai" -UseBasicParsing).Content

Руководство по использованию

первоначальная настройка

- Доступ к пользовательскому интерфейсу GPUStack: открыть в браузере

http://myserver. - Используйте имя пользователя по умолчанию

adminи начальный пароль для входа в систему. Метод получения начального пароля:- Linux или MacOS: запустите

cat /var/lib/gpustack/initial_admin_password. - Windows: работает

Get-Content -Path "$env:APPDATA\gpustack\initial_admin_password" -Raw.

- Linux или MacOS: запустите

Создание ключей API

- После входа в GPUStack UI нажмите на "API Keys" в навигационном меню.

- Нажмите кнопку "Новый ключ API", введите имя и сохраните его.

- Скопируйте сгенерированный API-ключ и сохраните его должным образом (он виден только в момент создания).

Использование API

- Установка переменных окружения:

export GPUSTACK_API_KEY=myapikey

- Используйте curl для доступа к API, совместимым с OpenAI:

curl http://myserver/v1-openai/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer $GPUSTACK_API_KEY" \

-d '{

"model": "llama3.2",

"messages": [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "Hello!"}

],

"stream": true

}'

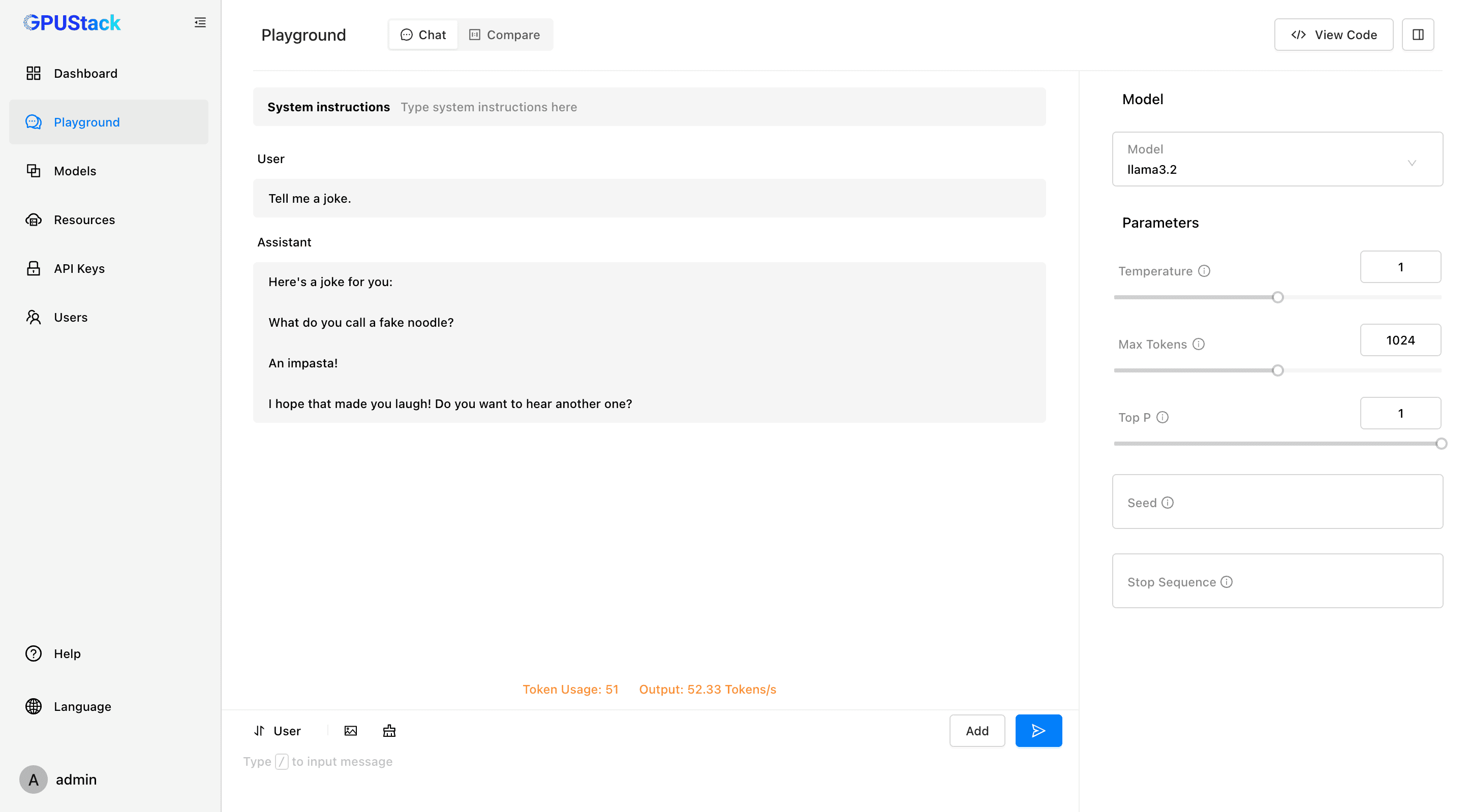

Беги и общайся

- Выполните следующую команду в терминале, чтобы пообщаться с моделью llama3.2:

gpustack chat llama3.2 "tell me a joke."

- Нажмите "Playground" в пользовательском интерфейсе GPUStack, чтобы начать взаимодействие.

Мониторинг и управление

- Контролируйте производительность и загрузку GPU в режиме реального времени.

- Управляйте ключами пользователей и API, отслеживайте использование токенов и их стоимость.

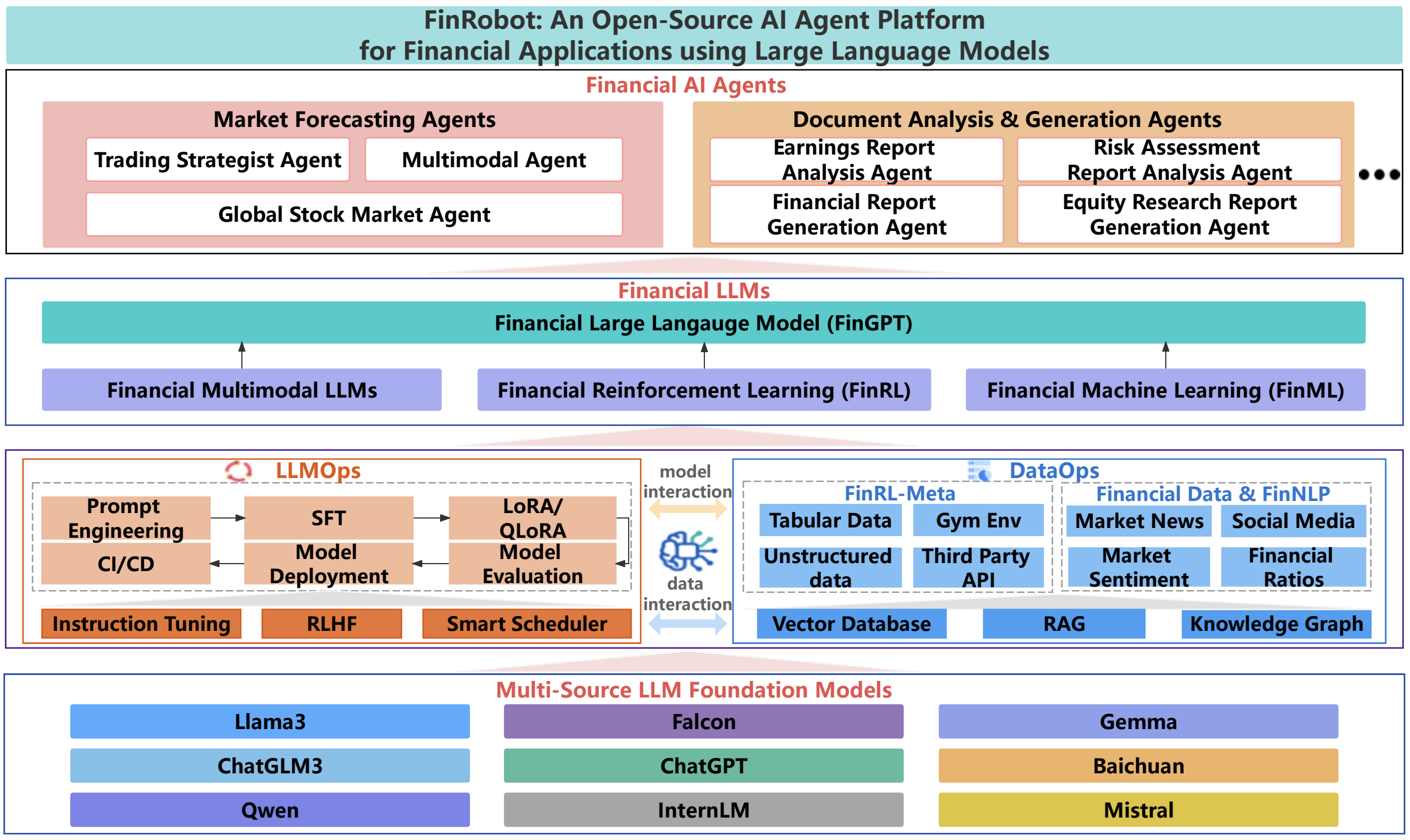

Поддерживаемые модели и платформы

- Поддерживаемые модели: LLaMA, Mistral 7B, Mixtral MoE, Falcon, Baichuan, Yi, Deepseek, Qwen, Phi, Grok-1 и другие.

- Поддерживаемые мультимодальные модели: Llama3.2-Vision, Pixtral, Qwen2-VL, LLaVA, InternVL2 и другие.

- Поддерживаемые платформы: macOS, Linux, Windows.

- Поддерживаемые ускорители: Apple Metal, NVIDIA CUDA, Ascend CANN, Moore Threads MUSA, в будущем планируется поддержка AMD ROCm, Intel oneAPI, Qualcomm AI Engine.

Документация и сообщество

- Официальная документация: посетить Документация GPUStack Получите полное руководство и документацию по API.

- Путеводитель по вкладам: Чтение Руководство по внесению взносов Узнайте, как вы можете внести свой вклад в GPUStack.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...