Технический отчет Гемма 3 Китайская версия

Гемма 3 Краткое изложение ключевых сообщений

I. Ключевые показатели

| параметры | информация |

|---|---|

| размер модели | От 100 миллионов до 27 миллиардов параметров в четырех вариантах: 1B, 4B, 12B, 27B |

| построить | на основании Трансформатор Специфическая архитектура декодера, унаследованная от Gemma 2, с рядом улучшений |

| мультимодальные возможности | Поддерживает ввод текста и изображений, используя специальный визуальный кодер SigLIP для кодирования изображений в 256 мягких тегов |

| Длина контекста | Модель 1B поддерживает 32K тегов, остальные модели - 128K тегов. |

| механизм внимания | Схема чередования локального и глобального слоев внимания 5:1 с локальным слоем, охватывающим 1024 лексемы |

| Методы обучения | Предварительное обучение с использованием дистилляции знаний и доработка инструкций с использованием усовершенствованных методов посттренинга |

| Данные предварительного обучения | Количество данных для предварительного обучения: 1B модель 2T лексем, 4B модель 4T лексем, 12B модель 12T лексем, 27B модель 14T лексем |

| многоязычие | Сравнение использования Близнецы 2.0 Тот же классификатор SentencePiece с 262 тыс. записей в словаре, поддерживает несколько языков |

| Количественная поддержка | Доступны версии квантования в различных стандартных форматах, включая int4 на канал, int4 на блок и toggle fp8. |

| Инфраструктура обучения | Тренировки с TPUv4, TPUv5e и TPUv5p со стратегией чередования состояний и репликации данных оптимизатора ZeRO-3 |

| углеродный след | Предварительно рассчитанный углеродный след составляет 1497,13 тонн CO2e, поэтому центры обработки данных Google являются углеродно-нейтральными! |

II. Преимущества

- Отличное мультимодальное понимание

- В Gemma 3 встроен визуальный кодер, который способен обрабатывать текстовые и графические данные и отлично справляется с мультимодальными задачами.

- Хорошо справляется с заданиями визуального тестирования, такими как DocVQA, InfoVQA, TextVQA и другими, особенно с заданиями, связанными с пониманием документов и чтением текста на изображениях.

- По сравнению с PaliGemma 2, Gemma 3 лучше справляется с задачами на понимание документов, такими как DocVQA и InfoVQA.

- Использование технологии Pan & Scan (P&S) позволяет Gemma 3 обрабатывать изображения с разрешением, близким к естественному, что еще больше повышает эффективность выполнения задач, связанных с визуальным языком.

- В Gemma 3 встроен визуальный кодер, который способен обрабатывать текстовые и графические данные и отлично справляется с мультимодальными задачами.

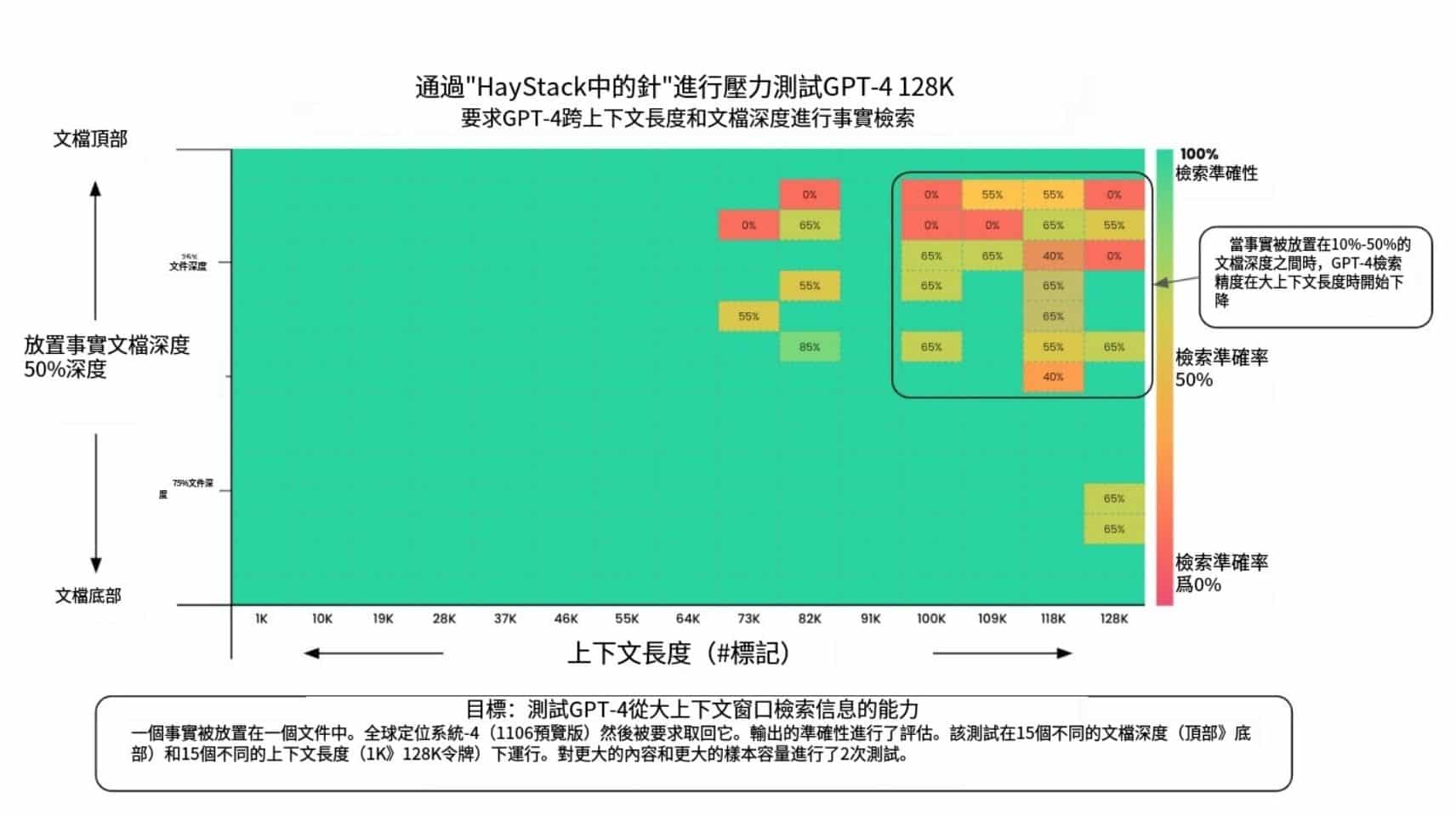

- Мощная обработка длинных контекстов

- Поддержка длины контекста в 128 тыс. лексем (32 тыс. для моделей 1B) является преимуществом при работе с длинными текстовыми задачами.

- Хорошо показывает себя в длинных контекстных бенчмарках, таких как RULER и MRCR.

- Схема чередования локального и глобального слоев внимания, а также короткодействующая конструкция локального слоя позволяют эффективно контролировать потребление памяти KV-кэшем, сохраняя при этом возможность обработки длинных контекстов.

- Поддержка длины контекста в 128 тыс. лексем (32 тыс. для моделей 1B) является преимуществом при работе с длинными текстовыми задачами.

- Развитие многоязычия

- Использование более сбалансированного неанглоязычного лексикона и увеличение объема обучения на многоязычных данных.

- Отлично работает в многоязычных бенчмарках, таких как MGSM, Global-MMLU-Lite и WMT24++.

- Отличная производительность в межъязыковых тестах и задачах генерации индийских языков, таких как XQuAD и IndicGenBench.

- Использование более сбалансированного неанглоязычного лексикона и увеличение объема обучения на многоязычных данных.

- Повышение уровня математики, мышления и навыков кодирования

- Посттренировочные методы оптимизированы для развития математических навыков, умений рассуждать и кодировать.

- Отличная производительность в MATH, GSM8K, HumanEval и других математических и кодовых бенчмарках.

- Отлично справляется с многозадачными тестами на понимание языка, такими как MMLU, MMLU-Pro и AGIEval.

- Посттренировочные методы оптимизированы для развития математических навыков, умений рассуждать и кодировать.

- Высокая эффективность моделирования

- Модели 1B и 4B имеют меньший размер параметров и подходят для развертывания на устройствах с ограниченными ресурсами.

- При использовании метода усредненного объединения стоимость миграции моделей Gemma 3 4B и 12B примерно в 10 раз ниже, чем моделей PaliGemma 2 9B и 27B при одинаковом разрешении входов визуального кодера.

III. Недостатки

- Ограниченные знания в области химической, биологической, радиологической и ядерной (CBRN)

- Гемма 3 показала низкие результаты при оценке знаний о ХБРЯ из-за отсутствия материалов, связанных с ХБРЯ, в данных предварительной подготовки.

- Это означает, что в сценариях применения, включающих области CBRN, Gemma 3 может не предоставить точную и надежную информацию.

- Возможные узкие места в производительности при обработке изображений высокого разрешения

- Хотя методы P&S могут облегчить проблемы, связанные с неквадратным соотношением сторон и высоким разрешением изображений, частое обрезание и масштабирование изображений может повлиять на скорость вывода.

- Gemma 3 может столкнуться с проблемами производительности в приложениях, требующих обработки изображений сверхвысокого разрешения или задач технического зрения в реальном времени.

- Понимание отдельных областей может быть недостаточным

- Несмотря на то, что Gemma 3 отлично разбирается в ряде областей, она может иметь ограниченное представление о некоторых узкоспециализированных областях (например, юридических, медицинских и т.д.).

- Это требует дальнейшей тонкой настройки или адаптации к конкретным условиям применения.

- Существуют определенные риски для памяти и конфиденциальности

- Большие языковые модели рискуют генерировать текст, который появляется в обучающих данных, и Gemma 3 - не исключение.

- Несмотря на то, что объем памяти Gemma 3 меньше, чем у предыдущих моделей, с конфиденциальной информацией все равно нужно обращаться осторожно, чтобы не нарушить конфиденциальность пользователя.

- Необходимо улучшить способность рассуждать о сложных причинно-следственных связях

- Джемма 3 может не справиться с заданиями, связанными со сложными причинно-следственными связями.

- Это требует дальнейших исследований и доработки модели для улучшения ее производительности в задачах причинно-следственных рассуждений.

Джемма 3 Рейтинг

Серия моделей Gemma 3 состоит из четырех версий, для каждой из которых открыты исходные тексты базовой версии с предварительным обучением (pt suffix version, обозначающий предварительное обучение) и версии с точной настройкой инструкций (it suffix version, обозначающий точную настройку инструкций), что означает, что всего открыты исходные тексты восьми версий большой модели.

Максимальный размер параметров Gemma 3-27B IT с точностью fp16 составляет 54,8 ГБ, 27 ГБ после квантования INT8 при наличии двух 4090, а квантование INT4 требует 14 ГБ видеопамяти, что вполне достаточно для одного 4090.

И эта версия модели очень хорошо себя зарекомендовала, набрав 1 338 баллов (по состоянию на 8 марта 2025 года) на анонимной арене Big Models (Chatbot Arena), заняв 9-е место в мире после модели o1-2024-12-17 и опередив такие модели, как Qwen 2.5-Max и DeepSeek V3.

Согласно официальному заявлению Google, эта серия Gemma 3 является значительным обновлением: модель Gemma 3-4B по уровню моделирования близка к Gemma 2-27B, а Gemma 3-27B - к Gemini 1.5-Pro!

Джемма 3 Опыт работы Местоположение

https://aistudio.google.com/prompts/new_chat?model=gemma-3-27b-it

https://ollama.com/library/gemma3

резюме

Gemma 3 - это мощная мультимодальная модель большого языка, которая превосходит других в мультимодальном понимании, обработке длинных контекстов, многоязычных возможностях, математике, рассуждениях и коде. Однако ей еще есть куда расти в области знаний о ХБРЯ, обработки изображений высокого разрешения, понимания специфики области, памяти и рисков конфиденциальности, а также сложных причинно-следственных связей.

Полный технический отчет:https://storage.googleapis.com/deepmind-media/gemma/Gemma3Report.pdf

Мы представили Gemma 3, мультимодальное расширение семейства легких моделей Gemma с открытым исходным кодом и размером параметров от 100 миллионов до 27 миллиардов. В этой версии появились возможности визуального восприятия, поддержка большего количества языков и увеличенная длина контекста - поддержка не менее 128 тысяч лексем. Мы также внесли улучшения в архитектуру модели, чтобы уменьшить объем кэш-памяти KV, который резко возрастает с увеличением длины контекста. Это достигается за счет увеличения соотношения слоев локального и глобального внимания и сохранения короткого диапазона локального внимания. Модель Gemma 3 обучается с помощью дистилляции знаний и превосходит Gemma 2 как в предварительно обученной, так и в версии с точной настройкой инструкций. В частности, наш новый подход к пост-обучению значительно улучшает математику, чат, соблюдение инструкций и многоязычные возможности, делая Gemma3-4B -IT сравнимой по производительности с Gemma2-27B-IT, а Gemma3-27B-IT - с Gemini-1.5-Pro в бенчмарках. Мы предоставляем все модели сообществу.

1. Введение

Мы представляем последнюю версию языковой модели Gemma с открытым исходным кодом (Gemma Team, 2024a), которая была разработана совместно с семейством пограничных моделей Gemini (Gemini Team, 2023). Эта новая версия сопоставима по размеру с Gemma 2 (Gemma Team, 2024b) и добавляет модель с 1 миллиардом параметров. Эти модели предназначены для работы на стандартном оборудовании потребительского класса, таком как мобильные телефоны, ноутбуки и высокопроизводительные графические процессоры. Этот выпуск привносит несколько новых возможностей в семейство Gemma, а именно мультимодальность, длинные контексты и многоязычие, сохраняя при этом производительность предыдущих выпусков или превосходя ее.

С точки зрения мультимодальности, большинство моделей Gemma 3 совместимы с пользовательским визуальным кодером SigLIP (Zhai et al., 2023). Языковая модель рассматривает изображения как последовательности мягких лексем, закодированных в SigLIP. Мы сокращаем затраты на обработку изображений путем сжатия визуального вложения в 256 векторов фиксированного размера. Кодировщик работает с фиксированным разрешением, но мы черпаем вдохновение из LLaVA (Liu et al., 2024) для достижения гибкого разрешения с помощью подхода "панорамирования и сканирования" (P&S).

Вторым важным архитектурным усовершенствованием является увеличение размера контекста до 128K токенов без ущерба для производительности. Одной из проблем, связанных с длинными контекстами, является увеличение объема памяти в кэше KV во время вывода. Чтобы уменьшить эту проблему, мы чередуем несколько локальных слоев между каждым глобальным слоем и устанавливаем размах локальных слоев всего в 1024 токена. Таким образом, длинными контекстами занимается только глобальный слой, и на каждые 5 локальных слоев приходится 1 глобальный слой.

Подход к оптимизации предварительного обучения аналогичен подходу Gemma 2, но с некоторыми изменениями в архитектурном дизайне. Мы используем тот же дезамбигуатор, что и в Gemini 2.0, а также пересмотрели стратегию смешивания данных, чтобы улучшить многоязыковые возможности моделей, а также внедрили понимание изображений. Все модели Gemma 3 были обучены методом дистилляции знаний (Hinton et al., 2015).

В процессе посттренингового обучения мы фокусируемся на улучшении математических навыков, умения рассуждать и общаться в чате, а также на интеграции новых возможностей Gemma 3, длинных контекстов и ввода изображений. Мы используем новый подход к посттренинговому обучению, чтобы улучшить все способности к математике, кодированию, общению, выполнению команд и многоязычию. Полученная в результате модель тонкой настройки инструкций Gemma 3 является одновременно мощной и универсальной, значительно превосходя свою предшественницу в бенчмарках.

В следующих разделах мы даем краткий обзор нашей модели, включая архитектуру, а также методы предварительного и последующего обучения. Мы также приводим подробную оценку по различным количественным и качественным эталонным тестам. Мы обсуждаем подходы к безопасному ответственному развертыванию и описываем более широкие последствия Gemma 3, ее ограничения и преимущества.

Здесь приведена разбивка расходов и чаевых на основе чеков:

1.Определите стоимость нарезанного мяса:В чеке указано "1x Zurcher Geschnetzeltes + Rosti" за 36,50 CHF. Это нарезанное мясо с гарниром из жареного картофеля (Rosti). 2. Это блюдо из нарезанного мяса с гарниром из жареного картофеля (Rosti). 2.Рассчитайте наконечник для 18%:Сумма чаевых = 36,5 швейцарских франков * 0,18 = 6,57 швейцарских франков 3.Рассчитайте общую сумму:Итого = 36,50 CHF + 6,57 CHF = 43,07 CHF

2. Архитектура модели

Модель Gemma 3 использует ту же общую архитектуру трансформатора, специфичную для декодера, что и предыдущие поколения моделей (Vaswani et al., 2017), при этом большинство архитектурных элементов схожи с первыми двумя версиями Gemma. Мы используем метод Grouped Query Attention (GQA) (Ainslie et al., 2023), а также пост-нормализацию и пре-нормализацию с RMSNorm (Zhang and Sennrich, 2019). Вдохновленные Dehghani et al. (2023), Wortsman et al. (2023) и командой Chameleon (2024), мы заменяем мягкие пробки Gemma 2 нормализацией QK. В этом разделе мы выделим несколько ключевых отличий от предыдущих поколений моделей.

5:1 Локальное/глобальное чередование слоев. Мы чередовали локальное самовнимание со скользящим окном (Beltagy et al., 2020) и глобальное самовнимание (Luong et al., 2015), чередуя 1 глобальный слой на каждые 5 локальных слоев, начиная с локального слоя в качестве первого слоя модели.

| моделирование | визуальный кодировщик | Параметры встраивания | Невстраиваемые параметры |

|---|---|---|---|

| 1B | 0 | 302M | 698M |

| 4B | 417M | 675M | 3,209M |

| 12B | 417M | 1,012M | 10,759M |

| 27B | 417M | 1,416M | 25,600M |

Длинный контекст. Модели Gemma 3 поддерживают длину контекста в 128 тыс. лексем, за исключением модели 1B, которая имеет длину контекста в 32 тыс. мы увеличиваем базовую частоту RoPE глобального слоя самовнимания с 10 тыс. до 1M, а частоту локального слоя оставляем на уровне 10 тыс. мы используем процесс, аналогичный позиционной интерполяции Чена и др. (2023), для расширения диапазона глобального слоя самовнимания.

2.1 Зрительные модальности

Визуальный кодировщик. Мы использовали 400M вариант кодера SigLIP (Zhai et al., 2023), визуальный трансформатор (Dosovitskiy, 2020), обученный на варианте потерь CLIP (Radford et al., 2021). В качестве входного сигнала кодер Gemma взял квадратное изображение, измененное до размера 896x896, и был настроен на данных задачи Visual Assistant. Для простоты мы разделили визуальный кодер между моделями 4B, 12B и 27B и сохранили его в замороженном состоянии во время обучения.

Панорамирование и сканирование (P&S). Визуальный кодер Gemma работает с фиксированным разрешением 896x896. При работе с изображениями с неквадратным соотношением сторон и высоким разрешением это может привести к искажению изображения, в результате чего текст становится нечитаемым или мелкие объекты исчезают. Мы решаем эту проблему с помощью адаптивного алгоритма разбиения на окна во время вывода. Этот алгоритм разбивает изображение на одинаковые по размеру не перекрывающиеся блоки, которые охватывают все изображение, и изменяет его размер до 896x896 пикселей для передачи кодировщику. Окно применяется только при необходимости и контролирует максимальное количество обрезков. Это оптимизация только для вывода, которую можно отключить, чтобы ускорить вывод.

| Осколки | ||||

|---|---|---|---|---|

| моделирование | типология | Количество чипов | серия данных | копии |

| 1B | TPUv5e | 512 | 16 16 | 2 |

| 4B | TPUv5e | 2048 | 16 16 | 8 |

| 12B | TPUv4 | 6144 | 16 16 | 24 |

| 27B | TPUv5p | 6144 | 24 8 | 32 |

2.2 Предварительное обучение

Мы следовали схожему с Gemma 2 рецепту предварительной подготовки с дистилляцией знаний.

Учебные данные. Мы предварительно обучили нашу модель на немного большем бюджете тегов, чем Gemma 2, т.е. мы использовали 14 Т тегов для обучения Gemma 3 27B, 12 Т тегов для обучения версии 12B, 4 Т тегов для обучения 4B и 2 Т тегов для обучения 1B. Увеличение количества тегов было сделано для учета сочетания изображений и текста, использованных во время предварительного обучения. Мы также увеличили количество многоязычных данных, чтобы улучшить языковой охват. Мы добавили одноязычные и параллельные данные и использовали стратегию, вдохновленную Chung et al. (2023), для решения проблемы дисбаланса в языковом представлении.

Разделители. Мы используем тот же лексер, что и в Gemini 2.0: лексер SentencePiece с разделенными цифрами, сохранением пробельных символов и кодировкой на уровне байтов (Kudo and Richardson, 2018). Полученный словарь содержит 262 тыс. записей. Этот лексер более сбалансирован для неанглийских языков.

Фильтрация. Мы используем методы фильтрации, чтобы снизить риск генерации нежелательного или небезопасного дискурса и удалить определенную личную информацию и другие конфиденциальные данные. Мы обеззараживаем оценочный набор в предтренировочной смеси данных и снижаем риск рецитации, минимизируя распространение чувствительных результатов. Мы также применяем шаг перевзвешивания качества, вдохновленный Sachdeva et al. (2024), чтобы уменьшить количество некачественных данных.

Дистилляция знаний. Мы выбираем 256 логитов на токен и взвешиваем их в соответствии с вероятностями учителей. Студенты узнают распределение учителей по этим выборкам с помощью потери перекрестной энтропии. Целевое распределение учителей устанавливается с нулевой вероятностью для невыбранных логитов и перенормируется.

| Оригинал (GB) | Количественные показатели (GB) | |||

|---|---|---|---|---|

| Модель 1B | bf16 2.0 | 0.5 | 0.7 1.0 | |

| +KV | 2.9 | 1.4 | 1.6 1.9 | |

| 4B | 8.0 | 2.6 | 2.9 4.4 | |

| +KV | 12.7 | 7.3 | 7.6 9.1 | |

| 12B | 24.0 | 6.6 | 7.1 12.4 | |

| +KV | 38.9 | 21.5 | 22.0 27.3 | |

| 27B | 54.0 | 14.1 | 15.3 27.4 | |

| +KV | 72.7 | 32.8 | 34.0 46.1 |

2.3 Количественный тренинг восприятия

В дополнение к оригинальным контрольным точкам мы предоставляем количественные версии моделей в различных стандартных форматах. Эти версии получаются путем тонкой настройки каждой модели за небольшое количество шагов (обычно 5 000) с помощью Quantitative Awareness Training (QAT) (Jacob et al., 2018). В качестве целей мы используем вероятности неквантифицированных контрольных точек и корректируем данные, чтобы они соответствовали распределениям до и после обучения. Основываясь на наиболее популярных движках количественного вывода с открытым исходным кодом (например, llama.cpp), мы сосредоточились на трех весовых представлениях: per-channel int4, per-block int4 и toggle fp8. В таблице 3 мы приводим отпечатки памяти исходной и квантифицированной моделей для различных весовых представлений, а также с KV-кэшем и без него для длины последовательности маркеров 32k.

2.4 Вычислительная инфраструктура

Мы обучаем наши модели с помощью TPUv4, TPUv5e и TPUv5p, как показано в таблице 2. Каждая конфигурация модели оптимизирована таким образом, чтобы минимизировать время шага обучения. Для визуального кодера мы предварительно вычисляем вкрапления для каждого изображения и обучаем непосредственно с использованием вкраплений, не увеличивая стоимость обучения языковой модели.

Состояния оптимизатора разделяются с помощью реализации ZeRO-3 (Ren et al., 2021). Для многоподового обучения мы выполняем репликацию данных в сети центра обработки данных re

| (текстовый) контекст | форматирование |

|---|---|

| пользовательские раунды | пользователь |

| поворот модели | модель |

| Конец раунда | |

| Пример обсуждения: | |

| Пользователь: Кто ты? Модель: Меня зовут Джемма! Пользователь: Что такое 2+2? Модель: 2+2=4. | |

| Входная модель: | |

| [BOS]пользователь Кто вы? модель Меня зовут Джемма! пользователь | |

| Что такое 2+2? | |

| 2+2=4. | Выход модели: |

2.5 Углеродный след

Углеродный след предварительно обученной модели Gemma 3 составляет 1497,13 тонн CO2e. Этот показатель рассчитан на основе данных о почасовом потреблении энергии нашими центрами обработки данных TPU и расширен с учетом дополнительной энергии, расходуемой на создание и обслуживание центров обработки данных. Центры обработки данных Google являются углеродно-нейтральными, что достигается за счет сочетания энергоэффективности, закупок возобновляемой энергии и компенсации выбросов углекислого газа. Эта углеродная нейтральность распространяется на наши тренировки и машины, которые их выполняют.

3. Тонкая настройка команд

Предварительно обученная модель была преобразована в модель тонкой настройки команд с помощью усовершенствованного метода пост-обучения (см. табл. 6).

навык

Наш подход к посттренинговому обучению опирается на улучшенную версию Knowledge Distillation (Agarwal et al., 2024; Anil et al., 2018; Hinton et al., 2015) от крупного IT-факультета, а также на этап тонкой настройки RL на основе улучшенных версий BOND (Sessa et al., 2024), WARM (Ram et al., 2024b) и WARP (Ram et al. , 2024a) на этапе тонкой настройки RL.

Расширенные цели обучения

Мы используем различные функции вознаграждения, чтобы улучшить полезность, математику, кодирование, рассуждения, следование инструкциям и многоязычие, минимизируя при этом вред для модели. Это включает в себя обучение на взвешенных агрегированных моделях вознаграждения, обученных на данных обратной связи с людьми (Ram et al., 2024b), обратную связь при выполнении кода (Gehring et al., 2024) и реальные вознаграждения за решение математических задач (DeepSeek-AI, 2025; Lambert et al., 2024).

Фильтрация данных

Мы тщательно оптимизируем данные, используемые для посттренинга, чтобы добиться максимальной эффективности модели. Мы отфильтровываем результаты работы модели, которые отображают определенную личную информацию, являются небезопасными или токсичными, неправильно идентифицированные данные и дублирующие примеры. Включение подмножества данных, способствующих лучшему контекстуальному присвоению, модерации и отбраковке для минимизации иллюзий, также улучшает производительность по фактическим метрикам без ухудшения производительности модели по другим метрикам.

[BOS] Маркировка

Для моделей PT и IT, в которых текст начинается с тега [BOS], его необходимо добавить явно, поскольку текст "[BOS]" не будет сопоставлен с тегом [BOS]. Например, в Flax есть опция add_bos = True для автоматического добавления этой лексемы при разбиении слов. В таблице 4 приведен пример форматирования ИТ-модели.

Форматирование ПТ и ИТ

Все модели используют один и тот же дизамбигуатор, при этом некоторые управляющие лексемы предназначены для форматирования ИТ. Ключевое различие заключается в том, что PT-модели выводят маркер в конце генерации, в то время как IT-модели выводят маркер в конце генерации, как показано для IT в Таблице 4. Поэтому тонкая настройка любого из типов моделей также требует добавления соответствующих тегов конца оборота.

| рейтинги | моделирование | Эло | 95% CI | либерализация | типология | Параметры #/1 активация # |

|---|---|---|---|---|---|---|

| 1 | Grok-3-Preview-02-24 | 1412 | +8/-10 | |||

| 1 | GPT-4.5-Preview | 1411 | +11/-11 | |||

| 3 | Gemini-2.0-Flash-Thinking-Exp-01-21 | 1384 | +6/-5 | |||

| 3 | Gemini-2.0-Pro-Exp-02-05 | 1380 | + 5/-6 | |||

| 3 | ChatGPT-4o-latest (2025-01-29) | 1377 | + 5/-4 | |||

| 6 | DeepSeek-R1 | 1363 | +8/-6 | быть | Министерство энергетики | 671B/37B |

| 6 | Gemini-2.0-Flash-001 | 1357 | +6/-5 | |||

| 8 | 01-2024-12-17 | 1352 | + 4/-6 | |||

| 9 | Gemma-3-27B-IT | 1338 | +8/-9 | быть | сжатый | 27B |

| 9 | Qwen2.5-Max | 1336 | + 7/-5 | |||

| 9 | 01-превью | 1335 | +4/-3 | |||

| 9 | 03-мини-высокий | 1329 | +8/-6 | |||

| 13 | DeepSeek-V3 | 1318 | +8/-6 | быть | Министерство энергетики | 671B/37B |

| 14 | GLM-4-Plus-0111 | 1311 | +8/-8 | |||

| 14 | Qwen-Plus-0125 | 1310 | +7/-5 | |||

| 14 | Клод 3.7 Сонет | 1309 | + 9/-11 | |||

| 14 | Gemini-2.0-Flash-Lite | 1308 | +5/-5 | |||

| 18 | Step-2-16K-Exp | 1305 | + 7/-6 | |||

| 18 | 03-мини | 1304 | + 5/-4 | |||

| 18 | 0л-мини | 1304 | +4/-3 | |||

| 18 | Gemini-1.5-Pro-002 | 1302 | +3/-3 | |||

| 28 | Meta-Llama-3.1-405B-Instruct-bf16 | 1269 | +4/-3 | быть | сжатый | 405B |

| 38 | Llama-3.3-70B-Instruct | 1257 | +5/-3 | быть | сжатый | 70B |

| 39 | Qwen2.5-72B-Инструкция | 1257 | +3/-3 | быть | сжатый | 72B |

| 59 | Джемма-2-27Б-ит | 1220 | +3/-2 | быть | сжатый | 27B |

Таблица 5 | Оценка ИТ-моделей Gemma 3 27B в Chatbot Arena (Chiang et al., 2024). Все модели оценивались человеком вслепую, бок о бок. Каждой модели присваивался балл в соответствии с системой оценок Эло. Данные Gemma-3-27B-IT - это предварительные результаты, полученные 8 марта 2025 г. Модели Gemma-3-27B-IT оценивались в Chatbot Arena (Chiang et al., 2024) человеком.

4. Окончательная оценка модели

В этом разделе мы оцениваем ИТ-модель с помощью серии автоматизированных бенчмарков и человеческих оценок, а также статических бенчмарков, таких как MMLU.

4.1 Арена чатботов LMSYS

В этом разделе мы покажем, насколько хорошо наша модель IT 27B работает на LMSys В ходе слепой оценки бок о бок с другими современными моделями в Chatbot Arena (Chiang et al., 2024). Мы приводим оценки Elo в таблице 5. Gemma 3 27B IT (1338) - лучшая модель в топ-10, и ее результаты выше, чем у других не думающих открытых моделей, таких как DeepSeek-V3 (1318), LLaMA 3 405B (1257) и Qwen2.5-70B (1257), которые являются гораздо более крупными моделями. Наконец, у Gemma 3 значительно более высокий показатель Elo, чем у Gemma 2, - 1220. Обратите внимание, что в оценках Elo не учитываются визуальные способности, в то время как ни одна из вышеперечисленных моделей их не учитывает.

4.2 Стандартизированный бенчмаркинг

В таблице 6 мы показываем производительность нашей финальной модели в различных бенчмарках по сравнению с предыдущими итерациями модели и Gemini 1.5. Мы не проводим прямого сравнения с внешними моделями, которые часто сообщают о своих собственных оценочных установках, поскольку их запуск в нашей установке не гарантирует справедливого сравнения. Мы рекомендуем читателям следить за сторонними статическими таблицами лидеров для более справедливого сравнения различных моделей. В приложении мы приводим дополнительные оценки наших моделей на других бенчмарках.

| Близнецы 1.5 | Близнецы 2.0 | Джемма 2 | Джемма 3 | ||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| Вспышка | Про | Вспышка | Про | 2B | 9B | 27B | 1B | 4B | 12B | 27B | |||

| MMLU-Pro | 67.3 | 75.8 | 77.6 | 79.1 | 15.6 | 46.8 | 56.9 | 14.7 | 43.6 | 60.6 | 67.5 | ||

| LiveCodeBench | 30.7 | 34.2 | 34.5 | 36.0 | 1.2 | 10.8 | 20.4 | 1.9 | 12.6 | 24.6 | 29.7 | ||

| Bird-SQL (dev) | 45.6 | 54.4 | 58.7 | 59.3 | 12.2 | 33.8 | 46.7 | 6.4 | 36.3 | 47.9 | 54.4 | ||

| GPQA Diamond | 51.0 | 59.1 | 60.1 | 64.7 | 24.7 | 28.8 | 34.3 | 19.2 | 30.8 | 40.9 | 42.4 | ||

| SimpleQA | 8.6 | 24.9 | 29.9 | 44.3 | 2.8 | 5.3 | 9.2 | 2.2 | 4.0 | 6.3 | 10.0 | ||

| Заземление FACTS | 82.9 | 80.0 | 84.6 | 82.8 | 43.8 | 62.0 | 62.4 | 36.4 | 70.1 | 75.8 | 74.9 | ||

| MATH | 77.9 | 86.5 | 90.9 | 91.8 | 27.2 | 49.4 | 55.6 | 48.0 | 75.6 | 83.8 | 89.0 | ||

| HiddenMath | 47.2 | 52.0 | 63.5 | 65.2 | 1.8 | 10.4 | 14.8 | 15.8 | 43.0 | 54.5 | 60.3 | ||

| MMMU (val) | 62.3 | 65.9 | 71.7 | 72.7 | 48.8 | 59.6 | 64.9 |

Таблица 6 | Сравнение производительности Gemini 1.5, Gemini 2.0 и Gemma 2 с моделью Instruction Trimming (IT) в бенчмарках с нулевой выборкой.

5. абляционные исследования

В этом разделе мы сосредоточимся на влиянии архитектурных изменений и новых визуальных возможностях некоторых из новых моделей.

5.1 Определение предтренировочного потенциала

Мы используем несколько стандартных эталонов в качестве тестов во время предварительного обучения, чтобы убедиться, что наши модели отражают общие возможности. На рисунке 2 мы сравниваем качество предварительно обученных моделей Gemma 2 и 3 по этим общим возможностям, а именно: наука, код, фактология, многоязычие, рассуждение и видение. Детали производительности для различных публичных эталонов, используемых в этих графиках, приведены в Приложении. В целом, мы видим, что, несмотря на добавление зрения, новая версия улучшила свои показатели в большинстве категорий. Особенно нас беспокоит многоязычность этой версии, которая напрямую влияет на качество наших моделей. Однако, несмотря на использование методов обеззараживания, всегда существует риск загрязнения этих зондов (Mirzadeh et al., 2024), что затрудняет получение более четких выводов.

5.2 Локальный: глобальный слой внимания

Мы измерили влияние изменений в локальном и глобальном слоях самовнимания на производительность и расход памяти во время умозаключений.

Местный: глобальный тариф. На рис. 3 мы сравниваем различные соотношения слоев локального и глобального внимания. В модели Gemma 2 используется 1:1, а в Gemma 3 - 5:1. мы видим, что изменение этого соотношения мало влияет на загадочность.

Размер раздвижного окна. На рисунке 4 мы сравниваем недоумение при различных размерах скользящего окна для различных конфигураций соотношения глобального и локального в слое локального внимания. Скользящее окно может быть значительно уменьшено без ущерба для сложности.

Влияние на кэш-память KV. На рис. 5 мы показываем баланс между моделью и кэш-памятью KV в контексте 32 тыс. тегов. Мы рассматриваем модель 2B с различными соотношениями локального и глобального и размерами скользящего окна (sw). Мы сравниваем ее с глобально уникальной конфигурацией, которая является стандартной конфигурацией, используемой в Gemma 1 и Llama. Мы наблюдаем, что конфигурация "глобальная уникальность" приводит к затратам памяти в 60%, в то время как использование скользящего окна 1:3 и 1024 (sw=1024На рисунке 6 мы рассчитали использование памяти KV-кэша в зависимости от длины контекста, используя нашу архитектуру 2B (**L:G=5:1, sw=1024**) с "глобально уникальной" моделью 2B.

5.3 Включение длинных контекстов

Вместо того чтобы обучать 128 тыс. последовательностей с нуля, мы предварительно обучили наши модели использовать 32 тыс. последовательностей, а затем масштабировали модели 4B, 12B и 27B до 128 тыс. лексем в конце предварительного обучения при повторном масштабировании RoPE (Chen et al., 2023). Мы обнаружили, что масштабный коэффициент 8 хорошо работает на практике. Примечательно, что по сравнению с Gemma 2 мы также увеличили базовую частоту RoPE для глобального слоя самовнимания с 10k до 1M, сохранив частоту локального слоя самовнимания на уровне 10k. На рис. 7 мы показываем эффект недоумения для различных длин контекста. Наша модель обобщается до 128k, но недоумение быстро уменьшается при дальнейшем масштабировании.

5.4 Маленькие и большие учителя

Общий вывод заключается в том, что для обучения небольшой модели лучше всего отбирать материал у небольшого учителя.

Мы подозреваем, что это связано с тем, что в таких исследованиях обычно используются менее качественные учителя, что перевешивает преимущества использования более качественных учителей. Мы обучаем студентов с помощью двух учителей разного размера, одного большого и одного маленького, в течение разных периодов обучения. На рисунке 8 мы видим, что при короткой продолжительности обучения лучше работает учитель меньшего размера, но при более длительном обучении тенденция меняется на противоположную.

5.5 Визуальный кодировщик

Влияние разрешения изображения. Мы используем визуальный кодер, основанный на SigLIP (Zhai et al., 2023). Визуальный кодер заморожен, и обучается только языковая модель. Каждое изображение в этих мультимодальных данных представлено 256 токенами изображений из соответствующего визуального кодера. Поэтому кодировщики с более высоким разрешением используют усреднение, чтобы сократить свой выход до 256 лексем. Например, кодер с разрешением 896 имеет на выходе среднее объединение 4x4. Как показано в таблице 7, кодер с более высоким разрешением превосходит кодер с меньшим разрешением.

Панорамирование и сканирование (P&S). P&S позволяет получать изображения с соотношением сторон и разрешением, близкими к родным. Как и ожидалось, способность обрабатывать изображения с разрешением, близким к естественному, очень полезна для задач, требующих чтения текста на изображении, что особенно важно для моделей визуального языка.

6. Память и конфиденциальность

Большие языковые модели могут создавать почти копии некоторых текстов, используемых в обучении (Biderman et al. 2023; Carlini et al. 2021, 2022; Ippolito et al. 2022; Nasr et al. 2023). В ряде предыдущих отчетов были опубликованы результаты проверок, в которых этот риск оценивается количественно путем измерения коэффициента запоминания (Anil et al. 2023; Chowdhery et al. 2022; Gemini team 2023, 2024; Gemma team 2024a,b; LLaMa team 2024). Этот "коэффициент запоминания "1 определяется как отношение генерации модели, соответствующей обучающим данным, ко всей генерации модели при следующих настройках. Для его измерения мы следуем методу, описанному в Gemma Team (2024b). В частности, мы делаем подвыборку из равномерно распределенной большей части обучающих данных и проверяем возможность извлечения этого контента с помощью префикса длиной 50 и суффикса длиной 50 (Nasr et al., 2023). Текст представлялся как "полная память", если все лексемы в продолжении совпадали с исходным суффиксом, или как "близкая память", если они совпадали в пределах расстояния редактирования 10%.

На рисунке 9 сравниваются скорости запоминания моделей Gemma и Gemini; модели расположены в обратном хронологическом порядке, слева - последняя модель Gemma 3. Мы видим, что модель Gemma 3 запоминает длинные тексты с гораздо меньшей скоростью, чем предыдущая модель (обратите внимание на логарифмическую ось y). Мы наблюдаем лишь небольшие различия в скорости запоминания между моделями 4B, 12B и 27B, причем 1B запоминает меньше, чем другие более крупные модели. Кроме того, мы обнаружили, что большая часть текста характеризуется как приблизительная память, причем относительное увеличение приблизительной памяти по сравнению с полной памятью составляет примерно 24 раза.

Мы также исследуем частоту, с которой поколение может содержать личную информацию. Для выявления потенциальной личной информации мы используем сервис Google Cloud Sensitive Data Protection (SDP).2 SDP использует широкий спектр правил обнаружения для выявления текста, который может содержать личную информацию.SDP рассчитан на высокий коэффициент отзыва и не учитывает контекст, в котором может появляться информация, что приводит к большому количеству ложных срабатываний. В результате мы можем переоценить истинное количество личной информации, содержащейся в выдаче.SDP также предлагает широкий диапазон уровней серьезности: низкий, средний и высокий. Мы классифицируем текст как личную информацию, если SDP относит его к любому уровню серьезности. Мы видим, что все модели Gemma 3 не содержат личной информации в выходных данных. Это говорит о том, что доля личных данных в результатах, классифицированных как воспоминания, ниже нашего порога обнаружения.

7. ответственность, безопасность, охрана

Ответственность, безопасность и защита являются важнейшими факторами при разработке моделей Gemma. Чтобы свести к минимуму воздействие на пользователей Gemma 3, мы продолжаем внедрять усовершенствованные процессы внутренней безопасности, которые проходят через весь рабочий процесс разработки, в соответствии с последними моделями ИИ Google (Gemini Team, 2024). Основное внимание уделяется мерам безопасности во время обучения, а также надежной и прозрачной оценке новых функций преобразования изображений в текст.

7.1 Управление и оценка

Наш подход к оценке выгод и рисков Gemma повторяет подход, изложенный в Gemma 1 (Gemma Team, 2024a), и учитывает изменения в моделях поддержки. Мы по-прежнему считаем, что открытость ИИ может распространить преимущества этих технологий на общество в целом, но при этом необходимо оценивать риск причинения вреда как на индивидуальном, так и на институциональном уровне (Weidinger et al., 2021). С момента выхода первого релиза Gemma мы увидели, что эти модели стали основой для нескольких социально полезных приложений, таких как наш собственный ShieldGemma 2, классификатор безопасности изображений 4B, построенный с использованием Gemma 3, который представляет собой готовое решение для обеспечения безопасности изображений, выводящее метки безопасности для категорий опасного контента, сексуальной эксплуатации и насилия.

Выпуск модели Gemma 3 требует особого внимания к изменениям в возможностях модели и тщательного мониторинга эволюционирующих рисков существующих мультимодальных LLM (Lin et al., 2024), а также понимания того, как модель используется в природе. Хотя мы пока не получили ни одного сообщения о вредоносном использовании Gemma, мы по-прежнему готовы расследовать любые подобные сообщения и сотрудничать с научными кругами и сообществом разработчиков, а также проводить собственный мониторинг для выявления подобных случаев.

Несмотря на расширенные возможности, мы считаем, что данный релиз окажет незначительное влияние на общую картину рисков, учитывая наличие более надежных открытых моделей.

7.2 Политика безопасности и меры по ее снижению во время обучения

Одним из основных принципов подхода к безопасности Gemma является соответствие политике безопасности Google, согласованной с моделью Gemini (Gemini Team, 2023). Они призваны помочь предотвратить создание нашими моделями вредоносного контента, т. е:

- Сексуальное насилие над детьми и их эксплуатация

- Раскрытие персональной информации, которая может нанести вред (например, номера социального страхования)

- Язык вражды и притеснения

- Опасный или вредоносный контент (включая пропаганду членовредительства или обучение вредным действиям)

- порнография

- Медицинские рекомендации, противоречащие научному или медицинскому консенсусу

Мы проводим обширную фильтрацию безопасности данных предварительного обучения, чтобы снизить вероятность того, что контрольные точки предварительного обучения и тонкой настройки будут создавать вредоносный контент. Для тонкой настройки моделей мы также используем SFT и RLHF, чтобы отвести модели от нежелательного поведения.

7.3 Оценка гарантий

Мы также подвергаем наши ИТ-модели ряду базовых оценок, чтобы понять, какой потенциальный вред могут нанести наши модели. Поскольку мы продвигаем открытые модели, мы также признаем, что необратимость высвобождения веса требует тщательной оценки рисков. Наши внутренние процессы безопасности разработаны соответствующим образом, и для предыдущих моделей Gemma мы также провели оценку возможностей, связанных с экстремальными рисками (Phuong et al., 2024; Shevlane et al., 2023). Продолжая разрабатывать и распространять открытые модели, мы будем следовать этой эвристике, тщательно оценивая, что более надежная модель обычно обеспечивает достаточное покрытие для менее надежной модели. Поэтому мы отдали предпочтение упрощенному набору оценок для Gemma 3, оставив углубленную оценку возможностей опасности для ситуаций, когда конкретная модель может иметь потенциально более высокий риск (как описано ниже для оценки ХБРЯ). Мы сбалансировали скорость разработки с целенаправленным тестированием безопасности, чтобы обеспечить целенаправленность и эффективность наших оценок, соблюдая при этом наши обязательства, изложенные в Frontier Safety Framework.

Базовая оценка

Базовая проверка фиксирует частоту нарушения политик безопасности моделью, используя большое количество синтетических агрессивных пользовательских запросов и человеческий эксперт, отмечающий ответы о том, нарушены политики или нет. В целом, Gemma 3 имеет очень низкий уровень нарушения политик безопасности.

Знание химических, биологических, радиологических и ядерных материалов (CBRN)

Ввиду более высокой эффективности выполнения заданий, связанных с STEM, мы оценивали знания, связанные с биологическими, радиологическими и ядерными рисками, используя закрытые вопросы с множественным выбором на основе знаний во внутреннем наборе данных. Для оценки знаний в области химии мы оценили химические опасности с помощью закрытого подхода, основанного на знаниях, разработанного Макнайтом и др. Наша оценка показала, что модель Gemma 3 имеет низкий уровень знаний в этих областях.

7.4 Наш ответственный открытый подход к моделированию

Разработка безопасных, надежных и ответственных приложений требует системного подхода, направленного на снижение рисков, связанных с каждым конкретным случаем использования и средой. Мы продолжим использовать оценки и меры по снижению безопасности, пропорциональные потенциальным рискам наших моделей, и будем делиться ими с сообществом только тогда, когда будем уверены, что преимущества явно перевешивают прогнозируемые риски.

8. обсуждение и выводы

В этой работе мы представляем Gemma 3, последний представитель семейства языковых моделей Gemma с открытым исходным кодом для работы с текстом, изображениями и кодом. В этом выпуске мы сосредоточились на добавлении понимания изображений и длинных контекстов, а также на улучшении многоязыковых возможностей и способностей, связанных с STEM. Размер и архитектура нашей модели рассчитаны на совместимость со стандартным оборудованием, и большинство наших архитектурных улучшений направлены на то, чтобы приспособить это оборудование, сохранив при этом производительность.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...