CoD: Chain of Density

Оригинальный текст:https://arxiv.org/pdf/2309.04269

Скорочтение:От разреженного к плотному: генерация абстракций GPT-4 с помощью цепочек подсказок о плотности

Собраны в:Обобщите знания о часто используемых подсказках

рефераты

Определение "правильного" объема информации для включения в автоматизированное текстовое резюме - сложная задача. Хорошее резюме должно быть подробным и ориентированным на сущность, но при этом не должно быть слишком длинным и сложным для понимания. Чтобы лучше понять этот компромисс, мы предложили метод подсказки под названием "Цепочка плотности" (CoD), с помощью которого GPT-4 может генерировать все более плотные резюме. Мы обнаружили, что резюме, сгенерированные с помощью CoD, более абстрактны, более сходятся и имеют меньший уклон в сторону открытия, чем резюме GPT-4, сгенерированные с помощью обычных подсказок. Используя исследование предпочтений человека в отношении 100 статей CNN/DailyMail, мы обнаружили, что люди предпочитают более плотные аннотации, чем аннотации GPT-4, сгенерированные с помощью обычных подсказок, и что их плотность почти сопоставима с плотностью аннотаций, написанных вручную.

1. Введение

За последние годы методы автоматического подведения итогов проделали большой путь, во многом благодаря смене парадигмы с контролируемой тонкой настройки на подсказки с нулевой выборкой с использованием крупномасштабных языковых моделей (LLM). Например, GPT-4 может достичь тонкого контроля над характеристиками резюме (например, длиной, темой и стилем) с помощью хорошо продуманных подсказок без дополнительного обучения.

Однако плотность информации в резюме - это тот аспект, который часто упускается из виду. Теоретически, как сжатие другого текста, резюме должно содержать большую концентрацию информации, чем исходный документ. Однако вопрос о плотности резюме остается открытым. Если резюме содержит недостаточно информации, оно будет несущественным; если оно содержит слишком много информации, оно может стать трудным для понимания без увеличения общей длины. Для передачи большего объема информации в рамках фиксированного бюджета на токены требуется сочетание абстракции, сжатия и объединения. Существует предел объема, который можно выделить для дополнительной информации, прежде чем она станет непонятной или даже фактически неверной.

2. цепные сигналы плотности (CoD)

2.1 Цели

Нашей целью было создать набор резюме GPT-4 с различной плотностью информации, контролируя при этом длину, которая, как было показано, является сильным фактором, сбивающим с толку при оценке резюме. Для этого мы разработали единую подсказку Chained Density (CoD), с помощью которой генерируется начальное резюме и постепенно увеличивается его плотность. В частности, за фиксированное количество раундов из исходного текста выделяется уникальный набор значимых сущностей, которые встраиваются в предыдущее резюме без увеличения его длины. Первая сводка не содержит большого количества сущностей, так как она фокусируется только на 1-3 начальных сущностях.

2.2 Данные

Мы случайным образом выбрали 100 статей из тестового набора резюме CNN/DailyMail для создания резюме CoD.

2.3 Контрольные точки

Для сравнения мы сравнили статистику рефератов CoD с рефератами, написанными вручную в виде пустых точек, и рефератами GPT-4, составленными с использованием общих подсказок:

- Обычные советы:: "Напишите очень краткое резюме статьи объемом не более 70 слов".

Мы установили требуемую длину токена, чтобы она соответствовала длине дайджеста CoD (как показано в таблице ниже).

2.4 Примеры советов

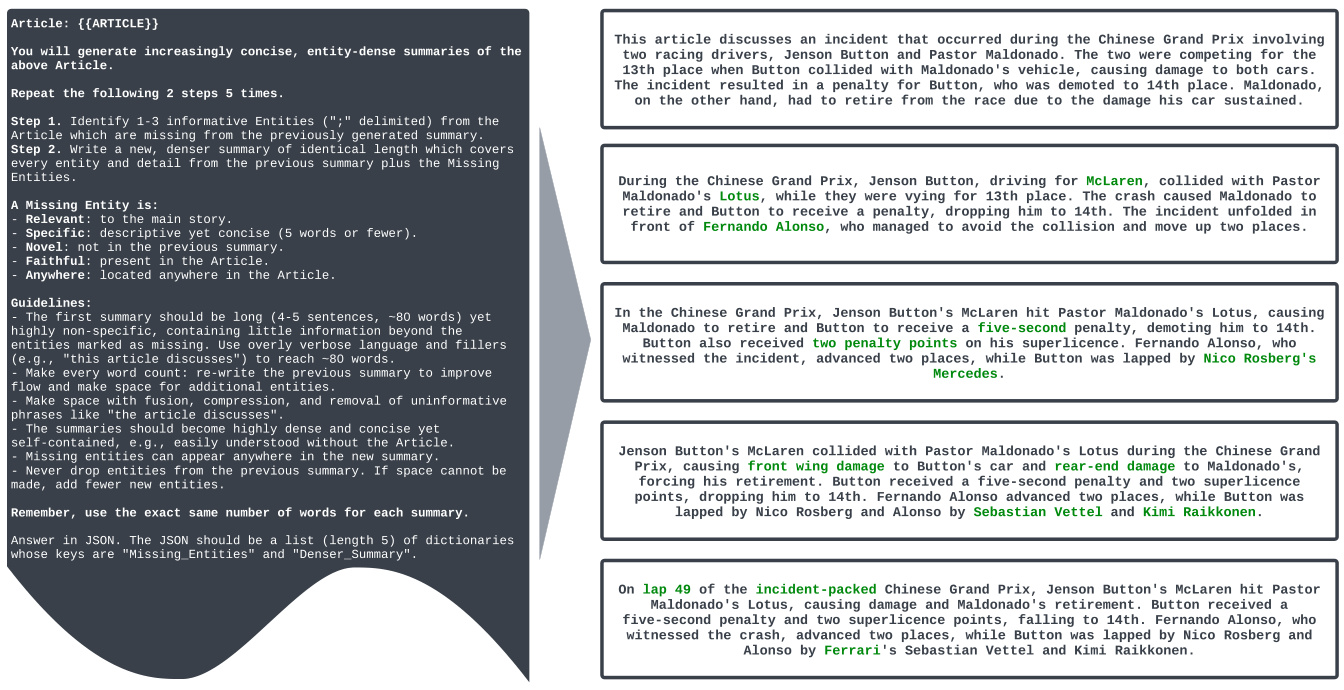

Ниже приведен пример подсказки CoD:

请生成一个非常简短的摘要,不超过70个单词。然后,逐步添加1-3个缺失的重要实体,而不增加长度。

Пример полной подсказки в CoD (оригинал на английском языке).

Article: {{ ARTICLE }}

You will generate increasingly concise, entity-dense summaries of the above article.

Repeat the following 2 steps 5 times.

Step 1. Identify 1-3 informative entities (";" delimited) from the article which are missing from the previously generated summary.

Step 2. Write a new, denser summary of identical length which covers every entity and detail from the previous summary plus the missing entities.

A missing entity is:

- relevant to the main story,

- specific yet concise (5 words or fewer),

- novel (not in the previous summary),

- faithful (present in the article),

- anywhere (can be located anywhere in the article).

Guidelines:

- The first summary should be long (4-5 sentences, ~80 words) yet highly non-specific, containing little information beyond the entities marked as missing. Use overly verbose language and fillers (e.g., "this article discusses") to reach ~80 words.

- Make every word count: rewrite the previous summary to improve flow and make space for additional entities.

- Make space with fusion, compression, and removal of uninformative phrases like "the article discusses".

- The summaries should become highly dense and concise yet self-contained, i.e., easily understood without the article.

- Missing entities can appear anywhere in the new summary.

- Never drop entities from the previous summary. If space cannot be made, add fewer new entities.

Remember, use the exact same number of words for each summary.

Answer in JSON. The JSON should be a list (length 5) of dictionaries whose keys are "Missing_Entities" and "Denser_Summary".

Объяснение слов.

Эта подробная подсказка для CoD предназначена для того, чтобы направить GPT-4 на постепенное создание более плотных сводок. Основная идея заключается в том, чтобы добавлять новые ключевые объекты в сводку в каждом раунде с помощью итеративного процесса, сохраняя при этом длину сводки неизменной. Давайте разберемся, из каких частей состоит это ключевое слово:

Article: {{ ARTICLE }}: Это место для содержания статьи, которую вы хотите обобщить.{{ ARTICLE }}.You will generate increasingly concise, entity-dense summaries of the above article.: Это основная часть директивы, которая сообщает модели, что ее цель - генерировать все более краткие и насыщенные сущностями резюме.Repeat the following 2 steps 5 times.: Указание числа итераций равным 5 означает, что модель будет повторять следующие два шага в течение пяти раундов, постепенно увеличивая плотность сводок.Step 1. Identify 1-3 informative entities (";" delimited) from the article which are missing from the previously generated summary.: Шаг 1: Определите отсутствующие объекты. Модель должна идентифицировать от одной до трех информативных сущностей из оригинальной статьи, которые не должны встречаться в ранее сгенерированных аннотациях. Сущности разделяются точкой с запятой;Разделение.Step 2. Write a new, denser summary of identical length which covers every entity and detail from the previous summary plus the missing entities.: Шаг 2: Создайте более плотное резюме. Модель должна сгенерировать новую сводку на основе предыдущей, включив в нее недостающие сущности, определенные на шаге 1. Очень важно, чтобы новая сводка была точно такой же длины, как и предыдущая, что заставляет модель сжимать и объединять информацию, чтобы учесть новые сущности.A missing entity is::: Определяет критерии для "отсутствующих сущностей", чтобы обеспечить высокое качество и релевантность отобранных сущностей:- relevant to the main story: Относится к основному сюжету статьи.- specific yet concise (5 words or fewer):: Конкретно и кратко, не более пяти слов.- novel (not in the previous summary): Отсутствует в предыдущих сводках.- faithful (present in the article): В статье должно быть все по-настоящему.- anywhere (can be located anywhere in the article): Может быть расположен в любом месте статьи.

Guidelines:: Для более детального инструктирования модели по выполнению задачи создания сводки предусмотрен ряд руководств:- The first summary should be long (4-5 sentences, ~80 words) yet highly non-specific...: Руководство для первого резюме: Первое резюме должно быть более длинным (~80 слов, 4-5 предложений), но менее информативным, его основная цель - заложить основу для последующих итераций. Допускается использование избыточного языка и слов-заполнителей.- Make every word count: rewrite the previous summary to improve flow and make space for additional entities.: упростить язык:: Акцент на необходимости переписать предыдущие резюме, чтобы оптимизировать лингвистическое выражение и освободить место для включения новых сущностей.- Make space with fusion, compression, and removal of uninformative phrases like "the article discusses".: техника масштабирования пространства:: Явно укажите использование таких методов, как слияние, сжатие и удаление неинформативных фраз для сжатия резюме.- The summaries should become highly dense and concise yet self-contained, i.e., easily understood without the article.: Краткие цели в области качества:: Итоговое резюме должно быть очень плотным и кратким, но в то же время самодостаточным, т.е. содержание резюме можно понять, не читая оригинального текста.- Missing entities can appear anywhere in the new summary.: физическое местоположение:: Вновь добавленные сущности могут появиться в любом месте новой сводки.- Never drop entities from the previous summary. If space cannot be made, add fewer new entities.: Резервирование субъектов:: Подчеркните, что сущности из предыдущих сводок никогда не должны удаляться. Если места недостаточно, новые сущности можно добавлять в редких случаях.- Remember, use the exact same number of words for each summary.: униформа:: Еще раз подчеркните необходимость последовательности в длине резюме, составляемых в каждом раунде.Answer in JSON. The JSON should be a list (length 5) of dictionaries whose keys are "Missing_Entities" and "Denser_Summary".: формат вывода: Требуйте, чтобы модель выводила результаты в формате JSON. JSON должен представлять собой список из 5 словарей, каждый из которых содержит ключи "Missing_Entities" (отсутствующие сущности, добавленные в этом раунде) и "Denser_Summary" (более плотная сводка, созданная в этом раунде).

Рисунок 1:: Подсказки и примерный вывод цепной плотности (CoD). На каждом этапе к предыдущему резюме добавляется 1-3 дополнительных детали (сущности) без увеличения длины. Существующий контент переписывается (например, сжимается, объединяется), чтобы освободить место для новых сущностей. Половина аннотаторов (2/4) предпочли предпоследнюю аннотацию, остальные - последнюю.

Пример реального рабочего использования слов подсказки CoD:

Предположим, у нас есть новостная статья "Визит президента США Джо Байдена в Польшу", и мы хотим сгенерировать серию резюме разной плотности, используя подсказки CoD.

Шаг 1: Подготовьтесь к публикации статьи

Во-первых, нам нужно подготовить содержание новостной статьи, например:

美国总统乔·拜登 неожиданно 抵达波兰进行访问,与波兰总统安杰伊·杜达举行会晤。此次访问正值俄乌冲突一周年之际,预计两国领导人将讨论地区安全、对乌克兰的进一步支持以及加强北约东翼等议题。拜登的访问是对波兰在支持乌克兰难民和向乌克兰提供军事援助方面所做努力的肯定。此外,拜登还计划在华沙就俄乌冲突发表重要讲话,并会见在波兰的美军士兵。

Шаг 2: Создайте API-запрос (на примере API OpenAI)

Для отправки запроса мы будем использовать OpenAI API (или другой API, поддерживающий модель GPT-4). В теле запроса будет содержаться слово подсказки CoD и файл {{ ARTICLE }} Замените его содержанием подготовленной статьи.

{

"model": "gpt-4",

"prompt": "Article: 美国总统乔·拜登 неожиданно 抵达波兰进行访问,与波兰总统安杰伊·杜达举行会晤。此次访问正值俄乌冲突一周年之际,预计两国领导人将讨论地区安全、对乌克兰的进一步支持以及加强北约东翼等议题。拜登的访问是对波兰在支持乌克兰难民和向乌克兰提供军事援助方面所做努力的肯定。此外,拜登还计划在华沙就俄乌冲突发表重要讲话,并会见在波兰的美军士兵。\nYou will generate increasingly concise, entity-dense summaries of the above article.\n\nRepeat the following 2 steps 5 times.\n\nStep 1. Identify 1-3 informative entities (\";\" delimited) from the article which are missing from the previously generated summary.\nStep 2. Write a new, denser summary of identical length which covers every entity and detail from the previous summary plus the missing entities.\n\nA missing entity is:\n- relevant to the main story, \n- specific yet concise (5 words or fewer), \n- novel (not in the previous summary), \n- faithful (present in the article), \n- anywhere (can be located anywhere in the article).\n\nGuidelines:\n\n- The first summary should be long (4-5 sentences, ~80 words) yet highly non-specific, containing little information beyond the entities marked as missing. Use overly verbose language and fillers (e.g., \"this article discusses\") to reach ~80 words.\n- Make every word count: rewrite the previous summary to improve flow and make space for additional entities.\n- Make space with fusion, compression, and removal of uninformative phrases like \"the article discusses\".\n- The summaries should become highly dense and concise yet self-contained, i.e., easily understood without the article. \n- Missing entities can appear anywhere in the new summary.\n- Never drop entities from the previous summary. If space cannot be made, add fewer new entities. \n\nRemember, use the exact same number of words for each summary.\nAnswer in JSON. The JSON should be a list (length 5) of dictionaries whose keys are \"Missing_Entities\" and \"Denser_Summary\".",

"max_tokens": 1000, // 确保模型有足够的token生成完整JSON输出

"temperature": 0.7// 可调整temperature控制生成结果的随机性

}

Шаг 3: Отправка API-запроса и получение JSON-ответа

Отправьте приведенный выше запрос в формате JSON на конечную точку OpenAI API. API возвращает ответ в формате JSON, содержащий сводку по пяти различным плотностям и недостающим сущностям, добавленным на каждом шаге.

Шаг 4: Разбор JSON-ответа и использование дайджеста

Разбирает ответ в формате JSON, возвращенный API. Вы получите список JSON, похожий на:

{

"Missing_Entities": [],

"Denser_Summary": "This article discusses a visit. It is about a president visiting a country. The president is American. The country is Poland. This is related to international relations. The visit is happening during a time of conflict. This conflict involves Russia and Ukraine. The visit aims to show support and discuss important matters. More details will be provided."

},

{

"Missing_Entities": ["Joe Biden"; "Andrzej Duda"],

"Denser_Summary": "U.S. President Joe Biden visited Poland and met with Polish President Andrzej Duda. This visit is about international relations and is happening during the Russia-Ukraine conflict. They will discuss support and security. More details are expected."

},

{

"Missing_Entities": ["one-year anniversary of the Russia-Ukraine conflict"; "regional security"; "support for Ukraine"],

"Denser_Summary": "U.S. President Joe Biden met Polish President Andrzej Duda in Poland on the one-year anniversary of the Russia-Ukraine conflict. They discussed regional security and support for Ukraine, focusing on international relations."

},

{

"Missing_Entities": ["strengthening NATO's eastern flank"; "support for Ukrainian refugees"; "military aid to Ukraine"],

"Denser_Summary": "On the Russia-Ukraine conflict's one-year anniversary, U.S. President Joe Biden visited Poland, meeting President Andrzej Duda to discuss regional security, support for Ukraine (including refugees and military aid), and strengthening NATO's eastern flank."

},

{

"Missing_Entities": ["Warsaw"; "major speech"; "U.S. troops in Poland"],

"Denser_Summary": "To mark the Russia-Ukraine conflict's one-year mark, U.S. President Joe Biden visited Warsaw, Poland, meeting President Andrzej Duda to discuss regional security, Ukrainian refugee and military aid support, strengthening NATO's eastern flank, and Biden's planned major speech and meeting with U.S. troops in Poland."

}

]

Вы можете выбрать нужную плотность конспектов в зависимости от ваших потребностей. Например, если вам нужен очень короткий конспект, вы можете выбрать первый или второй; если вам нужен более подробный, но все же краткий конспект, вы можете выбрать четвертый или пятый.

Практические сценарии применения:

- Агрегация новостей и рекомендация контента: предоставление сводок различной плотности для разных пользователей или платформ для удовлетворения различных информационных потребностей.

- Информационный поиск: отображение различной плотности аннотаций в результатах поиска, чтобы помочь пользователям быстро оценить релевантность статей.

- Помощь в понимании прочитанного: помогает читателям понять содержание текста от начала до конца, постепенно увеличивая плотность резюме.

- Генерация контента для социальных сетей: создание резюме различной длины и плотности для различных платформ социальных сетей (например, Twitter, Facebook).

Выполнив все вышеперечисленные действия, вы сможете эффективно использовать подсказки CoD на практике для создания высококачественных многомерных текстовых резюме с помощью GPT-4.

3. статистические данные

3.1 Прямая статистика

В таблице 1 мы вычисляем лексемы с помощью NLTK, измеряем уникальные сущности с помощью Spacy и вычисляем плотность сущностей в виде коэффициентов. Кинга CoD в значительной степени следует фиксированному бюджету лексем. Фактически, второй шаг приводит к сокращению в среднем на 5 лексем (с 72 до 67), поскольку из изначально длинного резюме удаляются ненужные слова. Плотность сущностей выросла - с начального значения 0,089, которое было ниже, чем у человека и обычного GPT-4 (0,151 и 0,122, соответственно), - до 0,167 после 5 шагов уплотнения.

| Шаги CoD | Токен | вещь, имеющая материальное существование (в отличие от концептуального, виртуального или сетевого существования) | Плотность (E/T) |

|---|---|---|---|

| 1 | 72 | 6.4 | 0.089 |

| 2 | 67 | 8.7 | 0.129 |

| 3 | 67 | 9.9 | 0.148 |

| 4 | 69 | 10.8 | 0.158 |

| 5 | 72 | 12.1 | 0.167 |

| человечество | 60 | 8.8 | 0.151 |

| Генерал ГПТ-4 | 70 | 8.5 | 0.122 |

3.2 Косвенная статистика

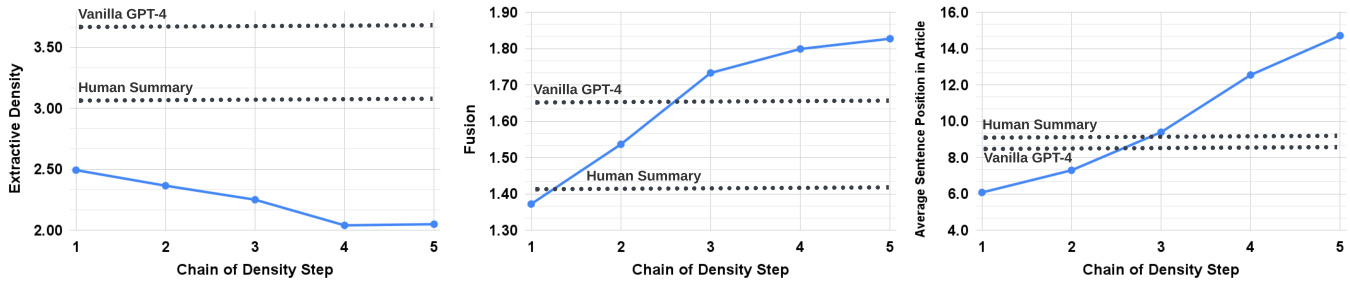

С каждым шагом CoD абстракция должна увеличиваться, поскольку реферат итеративно переписывается, чтобы освободить место для каждой дополнительной сущности. Мы измеряем абстракцию с помощью плотности извлечения: средней квадратичной длины извлеченных фрагментов. Аналогично, уровень слияния должен монотонно расти по мере добавления сущностей в реферат фиксированной длины. Мы оцениваем слияние как среднее количество исходных предложений, выровненных по каждому предложению реферата. Для выравнивания мы используем метод относительного усиления ROUGE, который выравнивает исходные предложения с целевыми предложениями до тех пор, пока относительное усиление ROUGE добавленных предложений не перестанет быть положительным. Мы также ожидаем, что распределение содержания - позиция в статье, из которой было взято содержание резюме, - изменится. В частности, мы ожидаем, что аннотации CoD будут изначально демонстрировать сильную предвзятость к началу статьи (Lead Bias), но постепенно начнут вводить сущности из середины и конца статьи. Чтобы измерить это, мы используем выравнивание при слиянии и измеряем средний ранг предложения среди всех выровненных исходных предложений. Рисунок 2 подтверждает эти гипотезы: по мере увеличения шага переписывания абстракция увеличивается (левая панель), скорость слияния возрастает (средняя панель), и аннотации начинают включать контент из середины и конца статьи (правая панель). Интересно, что все аннотации CoD более абстрактны, чем написанные вручную и базовые аннотации.

Рисунок 2: Рефераты, созданные CoD, становятся все более абстрактными, при этом демонстрируя большую сходимость и меньшую предвзятость к началу.

4. Результаты

4.1 Предпочтения людей

Чтобы лучше понять компромиссы, представленные в аннотациях к CoD, мы провели исследование на основе предпочтений с балльной оценкой по GPT-4.

| Шаги CoD | Процент голосов за первое место (отдельные аннотаторы) | сложите все | ||

|---|---|---|---|---|

| 1 | 3.0 2.0 | 13.0 | 17.4 | 8.3 |

| 2 | 25.0 28.0 | 43.0 | 31.4 | 30.8 |

| 3 | 22.0 28.0 21.0 | 24.4 | 23.0 | |

| 4 | 29.0 25.0 13.0 | 26.7 | 22.5 | |

| 5 | 21.0 17.0 10.0 | 16.3 | 15.5 |

Таблица 1:: CoD сводка процентов голосов за первое место по шагам. Исходя из совокупности предпочтений, шаги CoD имеют множественное число 2, медиану 3 и ожидаемое значение 3,06.

Во-первых, мы сообщаем о низком значении каппы Флейсса (Fleiss, 1971) - 0,112, что говорит о том, что тонкие различия между резюме и характер задания носят субъективный характер. В недавних исследованиях также отмечалось низкое согласие на уровне экземпляров при оценке резюме на основе GPT (Goyal et al., 2022).

Однако на уровне системы начинают проявляться некоторые тенденции. Для 3 из 4 аннотаторов шаг 1 CoD получил наибольшую долю голосов за первое место из 100 примеров (28%, 43% и 31,4%, соответственно). Тем не менее, в совокупности 61% (23,0+22,5+15,5), занявших первое место, включали ≥3 шагов денсификации. Медианное число предпочтительных шагов CoD находилось посередине (3), а желаемый шаг составлял 3,06.

Исходя из средней плотности аннотаций этапа 3, можно сделать вывод, что плотность предпочтительных сущностей среди кандидатов на CoD составляет около 0,15. Как видно из таблицы 1, эта плотность соответствует плотности аннотаций, написанных вручную (0,151), но значительно выше, чем у аннотаций, созданных с помощью обычного запроса GPT-4 (0,122).

4.2 Автоматические индикаторы

Было показано, что GPT-4 в качестве оценщика адекватно соответствует человеческому мнению (Fu et al., 2023; Liu et al., 2023a) и даже может превзойти краудсорсинговых работников в некоторых задачах аннотирования (Gilardi et al., 2023). В дополнение к человеческой оценке мы попросили GPT-4 оценить резюме CoD по шкале от 1 до 5 по следующим параметрам: количество информации, качество, связность, атрибутивность и общий уровень. Определения информативности, качества и атрибутивности взяты из работы Aharoni et al. (2023), а связности - из работы Fabbri et al. (2021). Общая цель - отразить совместное качество. Советы, использованные для получения оценок по каждому измерению, см. в Приложении A. Таблица 3 показывает, что плотность коррелирует с информативностью, но существует предел, и пик приходится на шаг 4 (4,74). Показатели отсутствия статей: качество и связность - снизились после шагов 2 и 1 соответственно. Все рефераты считались приписанными к исходной статье. Общие оценки были смещены в пользу более плотных и информативных аннотаций, причем самые высокие оценки были получены на этапе 4. В среднем, первый и последний этапы CoD были наименее предпочтительными, в то время как три средних этапа имели близкие показатели (4,78, 4,77 и 4,76 соответственно).

В Приложении A мы сообщаем о самой высокой корреляции общей метрики на уровне резюме с человеческой оценкой (корреляция Пирсона 0,31), но отмечаем, что общая корреляция остается низкой - это явление также наблюдалось в исследовании Дойча и др. (2022), когда резюме были схожего качества.

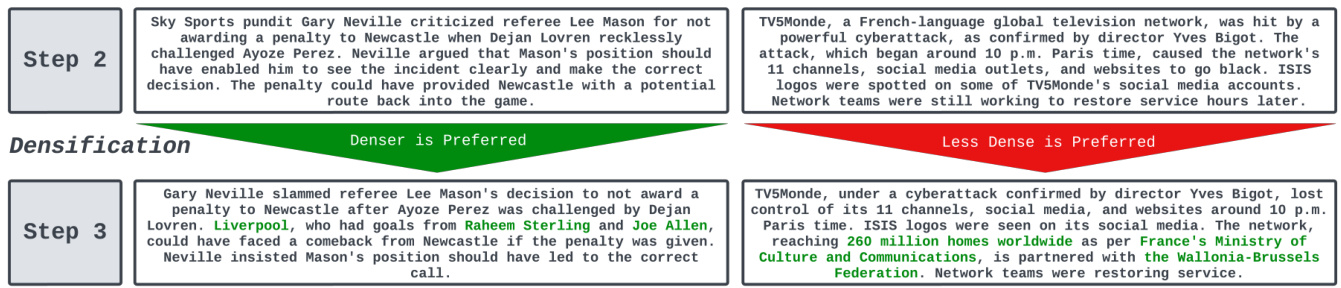

4.3 Качественный анализ

Существует четкий компромисс между связностью/читабельностью аннотаций и количеством информации, которую они содержат. Чтобы проиллюстрировать это, на рисунке 4 мы показываем два шага CoD: один конспект улучшен за счет большей детализации, а другой скомпрометирован. В среднем, средний вариант CoD лучше всего достигает этого баланса, но мы оставляем за будущей работой точное определение и количественную оценку этого компромисса.

Рисунок 4Примеры предпочтительных для человека этапов денсификации (слева) и пример непочтительных (справа). Для левого примера предпочтительным является нижнее резюме, поскольку добавление "Ливерпуля" и автора гола тематически релевантно. Во втором резюме есть место для разумного сжатия, например, синтеза "потенциальных путей возвращения в игру" в "контратаки". Справа добавление более подробной информации о "ТВМонде" не компенсирует неловкое слияние сущностей ("Кибератака" и "Ив Биго"), которое было прямым следствием того, что пришлось подтянуть предыдущее резюме.

5. сопутствующая работа

Резюме GPT

Goyal et al. (2022) провели сравнительный анализ GPT-3 при составлении резюме новостных статей и обнаружили, что люди предпочитают резюме GPT-3 предыдущему базовому уровню с контролем, который не отражал существующие метрики, основанные на ссылках и отсутствии ссылок.Zhang et al. (2023) обнаружили, что благодаря обращению к фрилансерам за высококачественными резюме, нулевые рефераты GPT-3 были сопоставимы с человеческими показателями.

Сводка на основе сущностей

Нараян и др. (2021) предлагают генерировать цепочки сущностей в качестве этапа планирования для контролируемой тонкой настройки модели обобщения, в отличие от ключевых слов (Li et al., 2020; Dou et al., 2021) или чисто извлеченных единиц (Dou et al., 2021; Adams et al., 2023a). Сущности также были включены в экстракты в качестве формы контроля (Liu and Chen, 2021; He et al., 2022; Maddela et al., 2022) для повышения достоверности (Nan et al., 2021; Adams et al., 2022) и в качестве единиц оценки (Cao et al., 2022; Adams et al., 2023b).

6. Заключение

Мы исследовали влияние уплотнения аннотаций на предпочтения людей в отношении общего качества. Мы обнаружили, что определенный уровень уплотнения приветствуется, однако трудно сохранить читабельность и связность, когда рефераты содержат слишком много сущностей. Мы выложили в открытый доступ тестовый набор с аннотациями, а также больший неаннотированный обучающий набор для дальнейшего изучения темы аннотаций фиксированной длины и переменной плотности.

7. Ограничения

Мы проанализировали CoD только для одной области, т.е. для сводок новостей. Аннотации не демонстрируют согласованности на высоком уровне сводок, но начинают демонстрировать тенденции на уровне системы, что согласуется с предыдущими работами по оценке на основе LLM (Goyal et al., 2022). Наконец, GPT-4 - это модель с закрытым исходным кодом, поэтому мы не смогли поделиться весами модели. Однако мы опубликовали все данные оценки, аннотации и 5 000 неаннотированных CoD для последующего использования, например, для извлечения плотностей в модели с открытым исходным кодом, такие как LLAMA-2 (Touvron et al., 2023).

библиография

(список литературы здесь не приводится)

Индикаторы GPT-4

Для оценки GPT-4 в стиле Лайкерта мы используем следующий шаблон подсказки.

摘要: {{摘要}} {{定义}}

Ниже приведены примеры определений, представленных для каждого показателя качества.

- объём информации:: Информативные аннотации отражают важную информацию из статьи и представляют ее в точной и краткой форме.

- масса (в физике):: Качественные резюме легко понять и осмыслить.

- консистенция: Последовательные аннотации хорошо структурированы и организованы.

- причитающийся: Вся ли информация в резюме полностью соответствует статье?

- общее предпочтение: Хорошая аннотация должна передавать основные идеи статьи в краткой, логичной и последовательной манере.

Указы на качество и связность не включают указания на статьи. Эти определения были адаптированы из предыдущих работ по аннотированию рефератов: (Fabbri et al., 2021; Aharoni et al., 2023).

| измерение (матем.) | актуальность |

|---|---|

| объём информации | 0.215 |

| масса (в физике) | 0.120 |

| консистенция | 0.178 |

| причитающийся | 0.245 |

| зонт | 0.311 |

Таблица 2Коэффициенты корреляции Пирсона между предпочтениями людей и оценками по шкале Лайкерта GPT-4.

мета-оценка

Чтобы вычислить корреляции на уровне резюме, мы сначала преобразовали данные о предпочтениях в вектор, указывающий количество раз, когда данное резюме получало голос за первое место. В таблице 4 показано, что, как это не удивительно, подсказки, предназначенные для учета общих оценок резюме, имеют самую высокую общую корреляцию Пирсона с общими предпочтениями (0,31), но общая корреляция остается низкой.

резюме

В данной работе исследуется, как GPT-4 может быть использован для создания все более плотных аннотаций с помощью метода Chained Density Cueing (CoD). Выяснилось, что определенный уровень плотности повышает качество рефератов, но слишком высокая плотность ухудшает читабельность и связность. Исследовательская группа подтвердила этот вывод с помощью исследований предпочтений людей и автоматизированной оценки GPT-4, а также выложила в открытый доступ соответствующие аннотированные и неаннотированные данные аннотаций, предоставив ценный ресурс для будущих исследований.

Краткое изложение ключевых моментов:

- Цепные сигналы плотности (CoD): Создавайте более плотные резюме, постепенно добавляя недостающие сущности без увеличения длины.

- физическая плотность: Используя плотность сущностей в качестве меры информативности аннотаций, было обнаружено, что человеческие предпочтения приближаются к плотности аннотаций, написанных вручную.

- Абстрактность и интеграция: CoD генерирует рефераты, которые являются более абстрактными и конвергентными, и с меньшей предвзятостью к началу.

- предпочтение человека: Люди предпочитают более плотные, чем обычно, резюме GPT-4, но слишком большая плотность снижает читабельность.

- Автоматизированная оценка: Результаты автоматизированной оценки GPT-4 в целом соответствовали предпочтениям человека, но общая корреляция была низкой.

Будущие направления исследований:

- Более точное определение компромиссов:: Будущие исследования могли бы более точно определить и количественно оценить компромисс между информационным содержанием и читабельностью.

- Мультидисциплинарные приложения:: Применить методологию CoD к другим областям, таким как научные статьи, техническая документация и т. д., чтобы подтвердить ее универсальность.

- Улучшения в моделировании:: Изучите, как можно улучшить моделирование для повышения удобочитаемости при сохранении высокого уровня информативности.

Благодаря этой работе мы видим, что ИИ добился впечатляющего прогресса в обработке и создании текстов, но все еще сталкивается с проблемой баланса между информативностью и читабельностью. В будущем, по мере развития технологий, у нас есть основания полагать, что создаваемые ИИ рефераты станут еще более интеллектуальными и удобными для пользователей.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...