Клод 3.7 Сонет и код Клода: передовые рассуждения и агентское кодирование

Антропология Сегодня компания выпустила Клод 3.7 Sonnet ^1^, которая является не только самой интеллектуальной моделью Anthropic на сегодняшний день, но и первой гибридной моделью рассуждений на рынке. claude 3.7 Sonnet обеспечивает как практически мгновенные ответы, так и более глубокое, пошаговое мышление, и процесс мышления доступен пользователю. Пользователь API также имеет тонкий контроль над тем, о чем думает модель. продолжительность времени.

Claude 3.7 Sonnet демонстрирует особенно значительные улучшения в кодировании и фронтенд-веб-разработке. Модель сопровождается Claude Code, инструментом командной строки для агентного кодирования, который в настоящее время доступен в ограниченном исследовательском предварительном просмотре и позволяет разработчикам делегировать широкий спектр инженерных задач Клоду прямо из терминала.

Claude 3.7 Sonnet теперь поддерживается во всех тарифных планах Claude (включая Free, Pro, Team и Enterprise), а также в Anthropic API, Amazon Bedrock и Google Cloud Vertex AI. Расширенный режим мышления доступен на всех платформах, кроме бесплатной версии Claude. Расширенный режим мышления доступен на всех платформах, кроме бесплатной версии Claude.

Цены на Claude 3.7 Sonnet остаются такими же, как и у его предшественника, как в стандартном, так и в расширенном режиме: за миллион вводимых данных жетоны 3 за миллион выходных жетонов и 15 долларов за миллион выходных жетонов - включая жетоны мышления.

Клод 3.7 Сонет: передовые рассуждения переходят в практическую плоскость

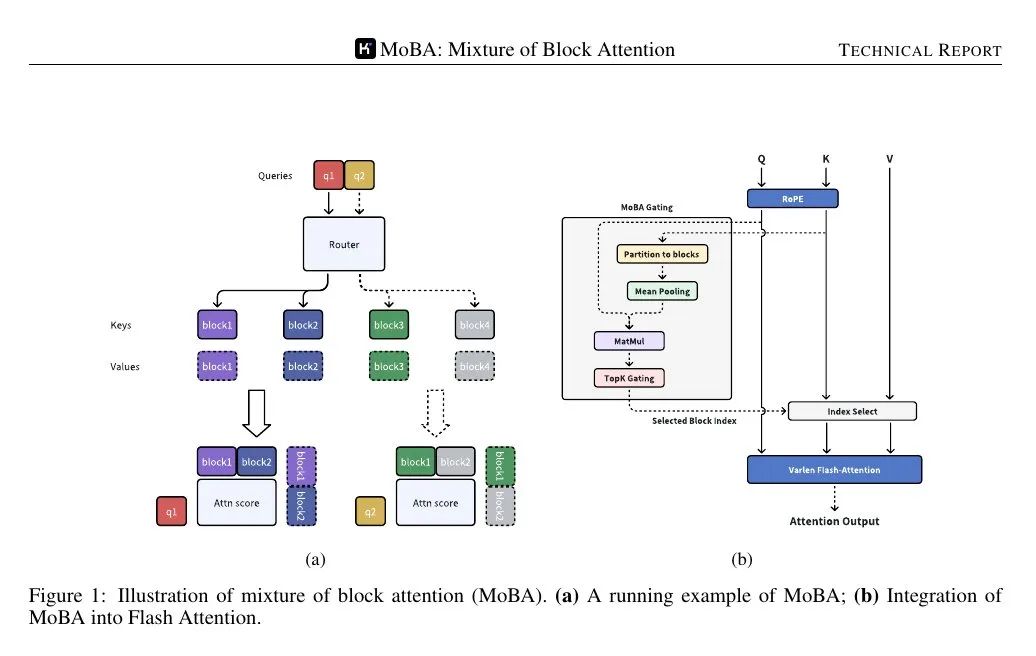

Anthropic разработал Claude 3.7 Sonnet с философией, отличной от других моделей рассуждений. Подобно тому, как люди используют один и тот же мозг для быстрой реакции и глубокого мышления, Anthropic считает, что рассуждения должны быть неотъемлемой частью передовой модели, а не полностью отдельной моделью. Такой единый подход также создает более плавный опыт для пользователей.

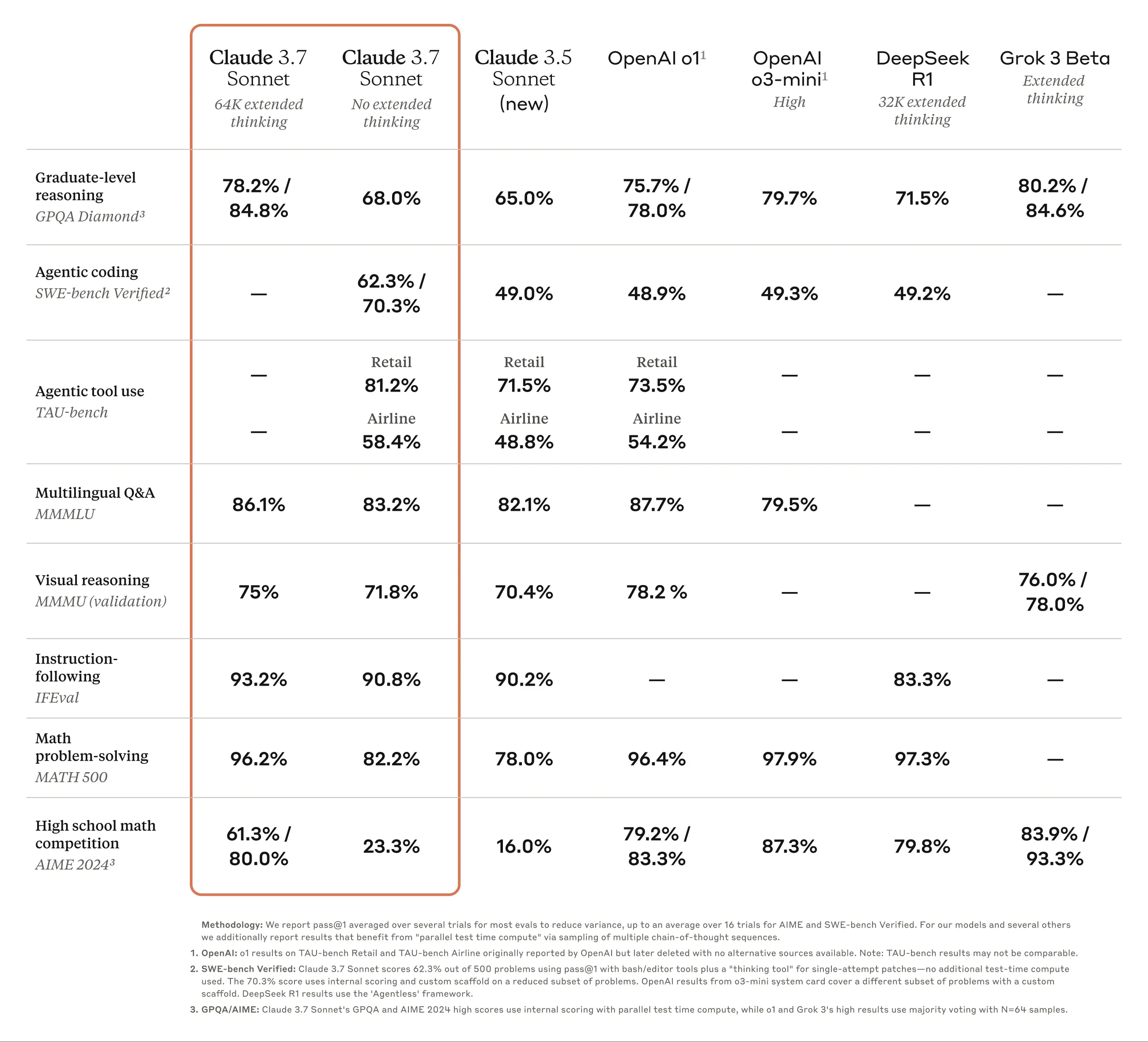

Claude 3.7 Sonnet воплощает эту идею несколькими способами. Во-первых, Claude 3.7 Sonnet сочетает в себе обычный LLM и модель вывода: пользователь может выбирать, когда модель отвечает быстро в стандартном режиме, а когда думает дольше, прежде чем ответить. В стандартном режиме Claude 3.7 Sonnet представляет собой обновленную версию Claude 3.5 Sonnet. В режиме расширенного мышления модель размышляет, прежде чем ответить, что улучшает ее производительность в математике, физике, выполнении команд, кодировании и многих других задачах. Anthropic обнаружила, что модель получает подсказки примерно одинаково в обоих режимах.

Во-вторых, при использовании Claude 3.7 Sonnet через API пользователь также имеет возможность думать о том. бюджет: Пользователь может сказать Claude придумать до N лексем, а значение N может быть установлено как ограничение на вывод до 128K лексем. Это дает пользователю гибкость в выборе между скоростью (и стоимостью) и качеством ответа.

В-третьих, во время разработки модели вывода Anthropic немного уменьшила фокус на математических и компьютерных конкурсных темах в направлении оптимизации, а вместо этого больше сосредоточилась на реальных сценариях применения, чтобы лучше отразить, как бизнес-пользователи на самом деле используют LLM.

Первые тесты доказали, что Клод лидирует во всех аспектах кодирования: Cursor отмечает, что Клод снова стал лидером в реальных задачах кодирования, значительно улучшив свои показатели в различных областях - от работы со сложными базами кода до продвинутых инструментов, а Cognition обнаружила, что Клод превосходит все другие модели, когда речь идет о планировании изменений кода и обработке обновлений всего стека. Vercel подчеркивает превосходную точность Claude в сложных рабочих процессах агентов, а Replit Успешно внедрив Claude для создания сложных веб-приложений и информационных панелей с нуля, чего трудно добиться в других моделях, Canva оценила, что Claude постоянно создает готовый к производству код, который не только лучше спроектирован, но и значительно сокращает количество ошибок.

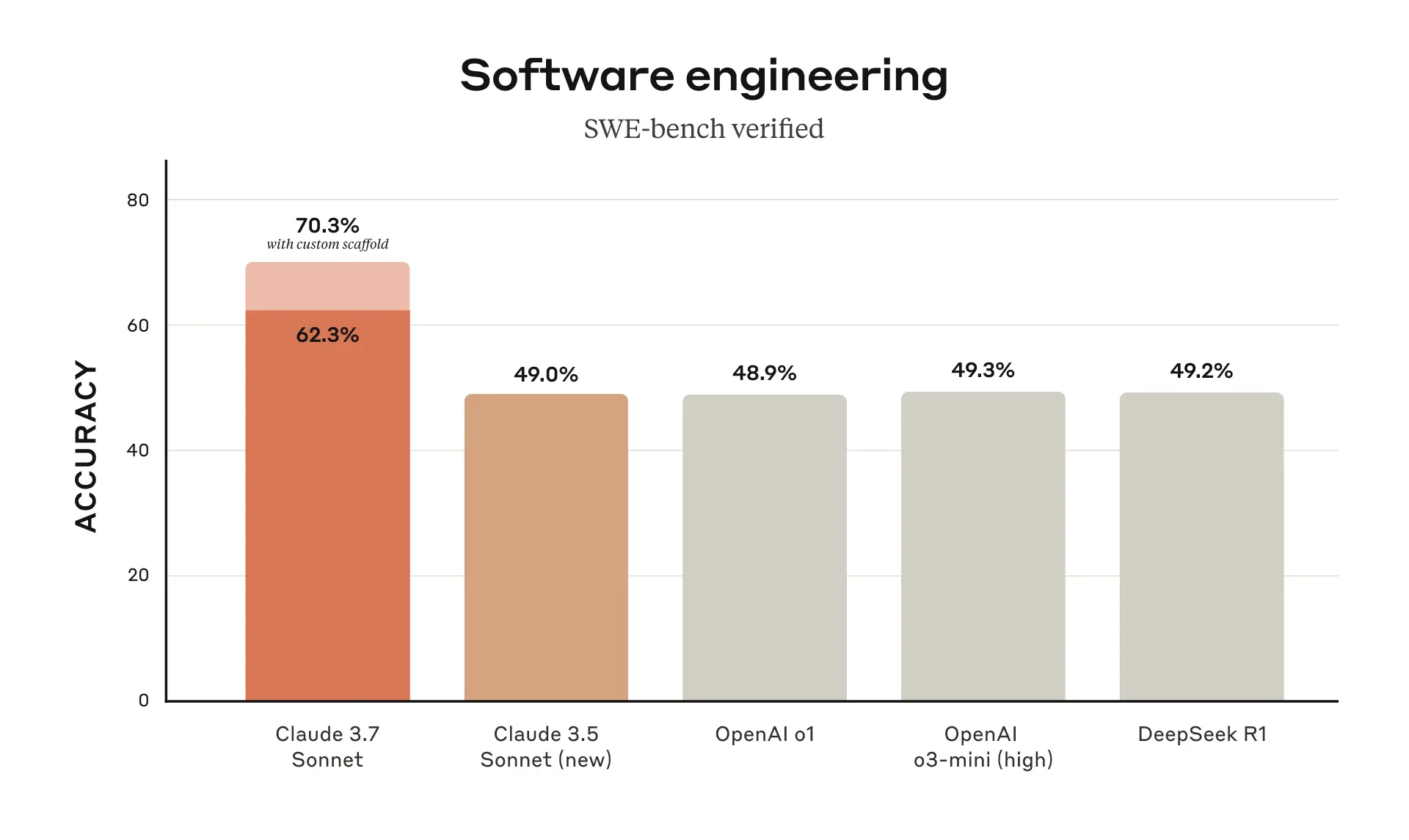

Клод 3.7 Sonnet достиг наилучшей производительности в SWE-bench Verified, эталоне, который измеряет способность моделей ИИ решать реальные программные задачи. Более подробную информацию о строительных лесах см. в Приложении.

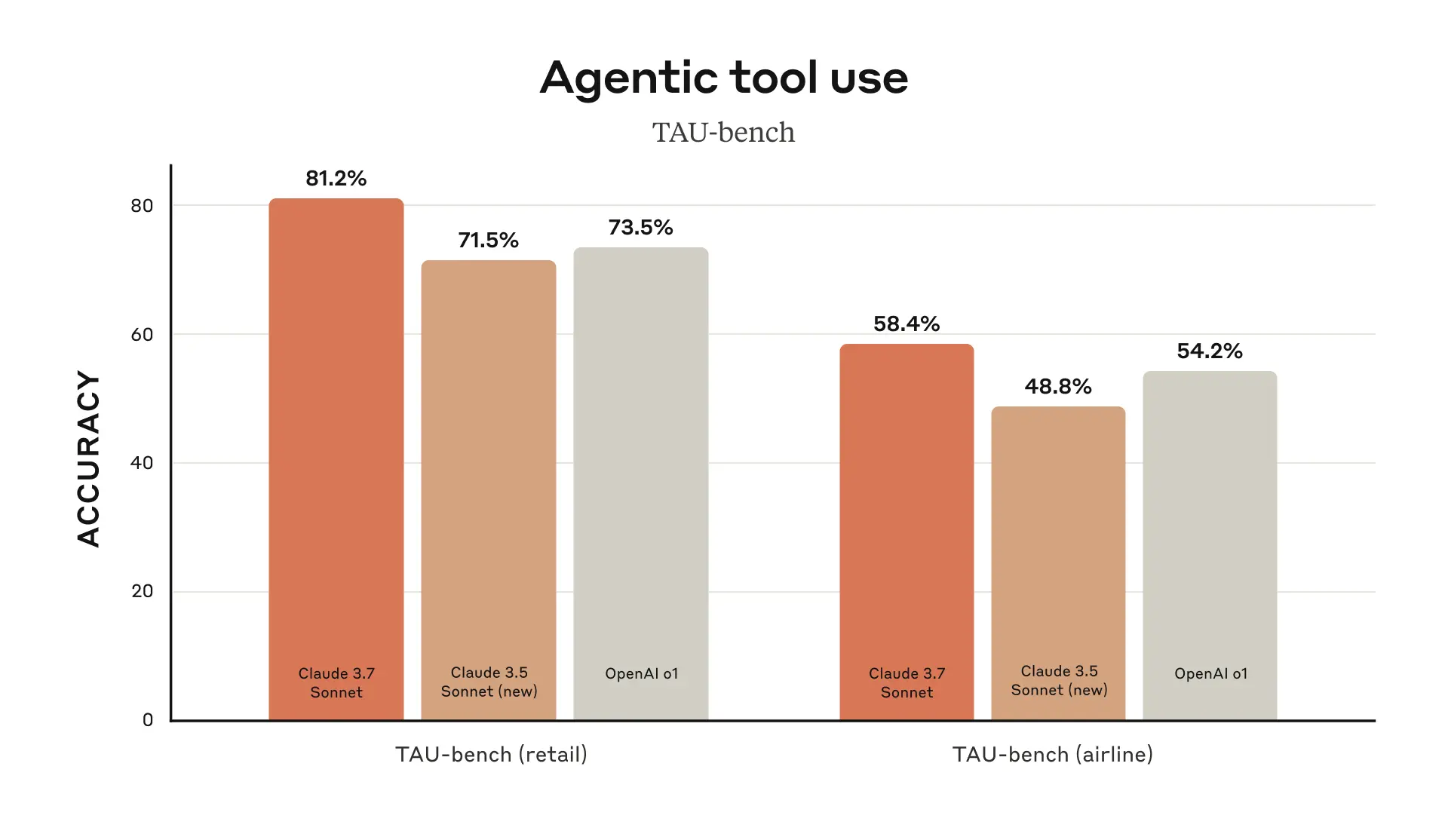

Клод 3.7 Sonnet показал наилучшие результаты в TAU-bench, системе для тестирования производительности агентов ИИ в сложных реальных задачах, включающих взаимодействие пользователя и инструментов. Более подробную информацию о строительных лесах см. в Приложении.

Claude 3.7 Sonnet превосходит все остальные модели в выполнении инструкций, обобщенных рассуждениях, мультимодальных способностях и агентном кодировании, а расширенный режим мышления значительно повышает его производительность в математике и естественных науках. Помимо традиционных эталонов, Claude 3.7 Sonnet даже превосходит все предыдущие модели в тестах игры Pokémon.

Claude Code: новый помощник для разработчиков

С июня 2024 года Sonnet является моделью, которую выбирают разработчики по всему миру. Теперь Anthropic доступен в ограниченной предварительной версии для исследований Код Клода -- Первый агентский инструмент кодирования от Anthropic для расширения возможностей разработчиков.

Claude Code - это активный коллаборатор, который ищет и читает код, редактирует файлы, пишет и запускает тесты, комментирует код и публикует его на GitHub, а также использует инструменты командной строки, информируя пользователей на каждом шагу.

Claude Code еще находится на ранней стадии разработки, но уже стал незаменимым инструментом для команды Anthropic, особенно для разработки, управляемой тестами, отладки сложных проблем и масштабного рефакторинга. В ходе раннего тестирования Claude Code смог за одну операцию выполнить задачи, на которые вручную обычно уходило более 45 минут, что значительно сократило время разработки и административные расходы.

В ближайшие недели Anthropic планирует постоянно вносить улучшения на основе пользовательского опыта, в том числе повысить надежность вызовов инструментов, добавить поддержку длительных команд, улучшить рендеринг в приложении и расширить понимание возможностей Claude.

Цель Anthropic при запуске Claude Code - лучше понять, как разработчики кодируют Claude, чтобы в дальнейшем усовершенствовать модель. Присоединившись к этому предварительному просмотру, пользователи получат доступ к тем же мощным инструментам, которые Anthropic использует для создания и улучшения Claude, а отзывы пользователей будут напрямую влиять на его дальнейшее развитие.

Работа с Клодом над кодовой базой

Anthropic также улучшил работу с кодом на Claude.ai, а интеграция с GitHub от Anthropic теперь доступна на всех тарифных планах Claude, что позволяет разработчикам подключать свои репозитории кода непосредственно к Claude.

Claude 3.7 Sonnet - лучшая модель кодирования Anthropic на сегодняшний день. Благодаря более глубокому пониманию личных, рабочих и открытых проектов пользователей, она становится еще более сильным партнером для исправления ошибок, разработки новых функций и создания документации для самых важных проектов GitHub.

Ответственное строительство

Anthropic провела обширное тестирование и оценку Claude 3.7 Sonnet, а также привлекла внешних экспертов, чтобы убедиться, что он соответствует стандартам Anthropic по безопасности, надежности и защищенности. Claude 3.7 Sonnet также более тонко различает вредные и доброкачественные запросы, чем его предшественник, при этом количество ненужных отказов сократилось на 45%.

В этой версии системной карты представлены последние данные о безопасности по нескольким категориям, подробно описана оценка политики ответственного расширения Anthropic, которую другие лаборатории ИИ и исследователи могут применить в своей работе. В системной карте также рассматриваются новые риски, связанные с использованием компьютеров, в частности атаки с использованием оперативной инъекции, и объясняется, как Anthropic оценивает эти уязвимости и обучает Клода противостоять им и смягчать их последствия. Кроме того, в системной карте рассматриваются потенциальные преимущества моделей вывода для безопасности: возможность понять, как модели принимают решения, и действительно ли выводы моделей заслуживают доверия и надежны. Для получения дополнительной информации читайте полный текст системной карты.

с нетерпением жду

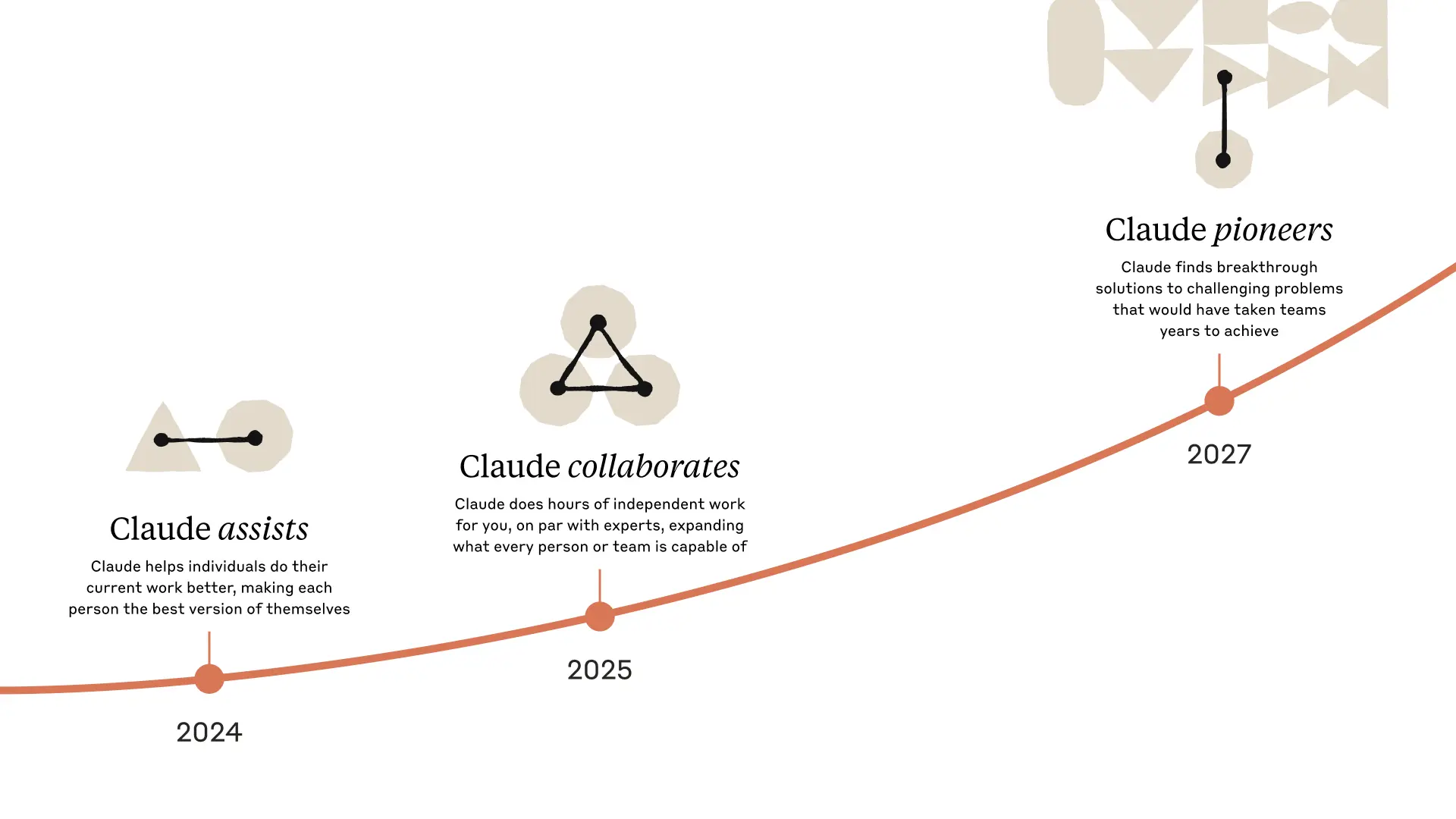

Выпуск Claude 3.7 Sonnet и Claude Code знаменует собой важный шаг в направлении создания по-настоящему мощных систем искусственного интеллекта. Благодаря способности глубоко рассуждать, работать автономно и эффективно сотрудничать они ведут нас в будущее, где ИИ сможет обогатить и расширить человеческие достижения.

Anthropic с нетерпением ждет, когда пользователи смогут познакомиться с этими новыми возможностями, и с нетерпением ждет, когда пользователи смогут увидеть, что они создадут. Anthropic всегда приветствует [обратную связь](mailto: feedback@anthropic.com) от пользователей, чтобы Anthropic мог продолжать улучшать и развивать модели Anthropic.

приложение

^1 ^ Уроки именования.

Оценка источников данных

TAU-bench

Информация о строительных лесах

Эти показатели были получены благодаря добавлению в "Политику агента авиакомпании" приложения с подсказками, которое предписывало Клоду лучше использовать инструмент "планирование". В этом режиме Anthropic побуждает модель записывать ход своих мыслей в течение нескольких раундов взаимодействия при решении задач, чтобы полностью использовать свои навыки рассуждения, что является отклонением от обычного режима мышления Anthropic. Чтобы учесть дополнительный расход жетонов Клода из-за использования большего количества шагов мышления, Anthropic увеличил максимальное количество шагов (с точки зрения завершения модели) с 30 до 100 (большинство взаимодействий было завершено в течение 30 шагов, и только одно взаимодействие превысило 50 шагов).

Кроме того, результаты TAU-бенча для Claude 3.5 Sonnet (new) отличались от тех, что были получены Anthropic во время первоначального релиза, из-за незначительных улучшений в наборе данных с тех пор. Anthropic повторно провёл тест на обновлённом наборе данных, чтобы более точно сравнить его с Claude 3.7 Sonnet. для более точного сравнения с Claude 3.7 Sonnet.

SWE-bench Проверено

Информация о строительных лесах

Существует множество подходов к решению открытых агентных задач, таких как SWE-bench. Некоторые подходы переносят большую часть сложности (например, решение о том, какие файлы исследовать или редактировать и какие тесты запускать) на более традиционное программное обеспечение, оставляя только основную языковую модель для генерации кода в заранее определенных местах или для выбора из более ограниченного набора операций.Agentless (Xia et al., 2024) - это подход к Deepseek R1 Популярный фреймворк, часто используемый для оценки Aide и других моделей, расширяет возможности агента с помощью механизмов поиска документов с подсказкой и встраиванием, локализации патчей и выборки отбраковки best-of-40 для регрессионного тестирования. В других моделях (например, Aide) модель дополняется дополнительными вычислениями в тестовое время в виде повторных попыток, best-of-N или Monte Carlo Tree Search (MCTS).

Для Claude 3.7 Sonnet и Claude 3.5 Sonnet (новинка) Anthropic использует более простой подход с минимальным количеством строительных лесов. В этом подходе модель сама решает, какие команды запускать и какие файлы редактировать в одной сессии. Основной результат "без расширенного мышления" pass@1 в Anthropic - это просто оснащение модели двумя описанными здесь инструментами - утилитой bash и инструментом редактирования файлов, работающим через строку. - Утилита bash и инструмент редактирования файлов, работающий через подстановку строк, а также "инструмент планирования", о котором Anthropic упоминает в результатах TAU-bench. Из-за ограничений инфраструктуры на собственной инфраструктуре Anthropic удалось решить только 489/500 задач (т. е. золотое решение прошло тест). Для получения ванильного результата pass@1 Anthropic посчитал 11 нерешаемых задач как неудачи, чтобы привести их в соответствие с официальной таблицей лидеров. В целях прозрачности Anthropic отдельно опубликовал тестовые случаи, которые не сработали на инфраструктуре Anthropic.

Для "высоковычислительных" чисел Anthropic использует дополнительную сложность и параллельные вычисления времени тестирования, как показано ниже:

- Антропные образцы несколько параллельных попыток с использованием вышеупомянутых лесов

- Anthropic отбрасывает патчи, которые повреждают видимые регрессионные тесты в репозитории, подобно методу выборки отказов, используемому Agentless; обратите внимание, что Anthropic не использует информацию о скрытых тестах.

- Затем Anthropic проранжировала оставшиеся попытки, используя модель подсчета баллов, аналогичную результатам Anthropic GPQA и AIME, описанным в исследовательской статье, и отобрала лучшие попытки для отправки.

Это дает результат 70.3% на подмножестве из n=489 проверенных задач, работающих на инфраструктуре Anthropic. Без этого эшафота Claude 3.7 Sonnet показал результат 63.7% на SWE-bench Verified, используя то же подмножество. 11 тестовых случаев, с которыми внутренняя инфраструктура Anthropic несовместима, перечислены ниже:

- scikit-learn__scikit-learn-14710

- django__django-10097

- psf__requests-2317

- sphinx-doc__sphinx-10435

- sphinx-doc__sphinx-7985

- sphinx-doc__sphinx-8475

- matplotlib__matplotlib-20488

- astropy__astropy-8707

- astropy__astropy-8872

- sphinx-doc__sphinx-8595

- sphinx-doc__sphinx-9711

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие посты

Нет комментариев...