Установка Dify и интеграция Ollama и Xinference

В этой статье описывается установка Dify через Docker, а затем интеграция Оллама и XInference, а также с помощью Dify Быстрое создание приложения на основе базы знаний и викторины.

- I. Введение в Dify

- Установка Dify

- III. Dify добавляет вопросы и ответы по модели Ollama

- IV. Викторина на основе базы знаний Dify

- V. Ссылки на документацию

I. Введение в Dify

Dify это платформа для разработки приложений с открытым исходным кодом Large Language Modelling (LLM), предназначенная для быстрого создания и развертывания генеративных приложений ИИ. Вот ключевые особенности и функциональные возможности Dify [1]:

- Объединение концепций Backend as Service и LLMOps Dify объединяет концепции Backend as Service и LLMOps, позволяя разработчикам быстро создавать генеративные ИИ-приложения производственного уровня.

- Поддержка нескольких моделей Dify поддерживает сотни собственных моделей LLM с открытым исходным кодом, включая GPT, Mistral, Llama3 и другие, легко интегрируя модели от различных поставщиков решений и самостоятельных решений.

- Интуитивно понятный интерфейс оркестровки подсказок Dify предоставляет интуитивно понятную IDE для написания подсказок, сравнения производительности моделей и добавления дополнительных функций, таких как преобразование голоса для приложений, основанных на чате.

- Высококачественный двигатель RAG : Dify имеет широкий ассортимент RAG Функциональные возможности охватывают все этапы - от ввода документов до их поиска - и поддерживают извлечение текста из документов распространенных форматов, таких как PDF, PPT и др.

- Интеграция системы агентов : Пользователь может использовать вызов функции LLM или ReAct Определите агентов и добавьте к ним готовые или пользовательские инструменты. Dify предлагает более 50 встроенных инструментов, таких как Google Search, DELL-E, Stable Diffusion и WolframAlpha.

- Гибкая организация процессов : Dify предоставляет мощную визуальную канву для создания и тестирования надежных рабочих процессов ИИ, позволяя разработчикам интуитивно проектировать и оптимизировать процессы ИИ.

- Комплексные средства мониторинга и анализа Dify предоставляет инструменты для мониторинга и анализа журналов и производительности приложений, а разработчики могут постоянно улучшать подсказки, наборы данных и модели на основе производственных данных и аннотаций.

- внутренняя часть как услуга : Все функции Dify поставляются с API, поэтому Dify легко интегрировать в вашу собственную бизнес-логику.

Установка Dify

Скопируйте код Dify с Github в локальное хранилище [2].

git clone https://github.com/langgenius/dify.git

Перейдите в каталог docker исходного кода dify и скопируйте переменные окружения.

cd dify/docker

cp .env.example .env

Установите приложение с помощью docker compose.

docker compose up -d

Войдите в контейнер ollama и запуститеqwen2:7bМодели.

root@ip-172-31-30-167:~/dify/docker# docker pull ollama/ollama

root@ip-172-31-83-158:~/dify/docker# docker run -d --gpus=all -v ollama:/root/.ollama -p 11434:11434 --name ollama --restart always -e OLLAMA_KEEP_ALIVE=-1 ollama/ollama

root@ip-172-31-83-158:~/dify/docker# docker exec -it ollama bash

root@b094349fc98c:/# ollama run qwen2:7b

III. Dify добавляет вопросы и ответы по модели Ollama

Войдите на домашнюю страницу Dify через публичный IP-адрес EC2 плюс порт 80 и создайте учетную запись администратора.

Войдите в систему через учетную запись администратора.

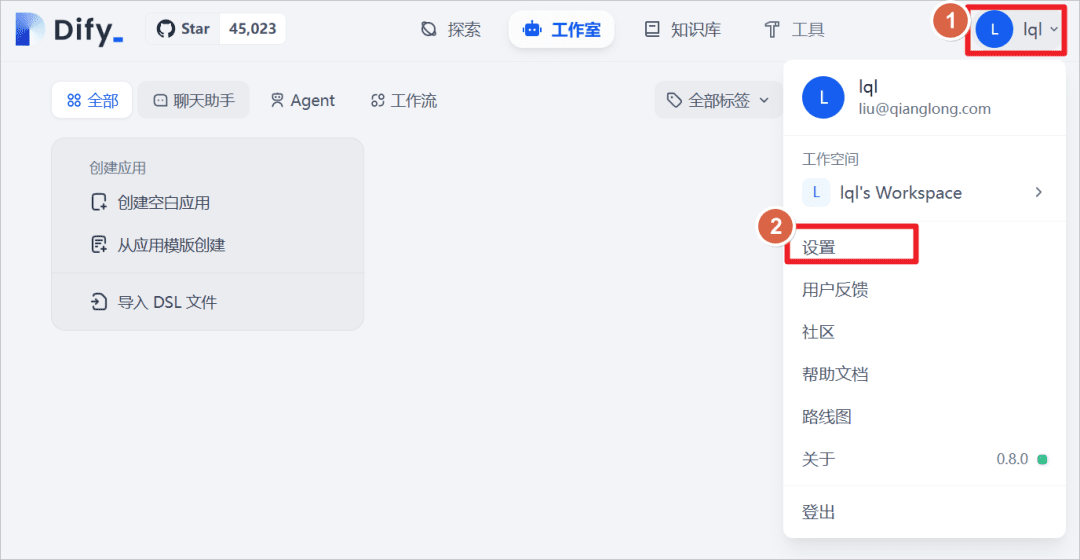

Нажмите Пользователь - Настройки.

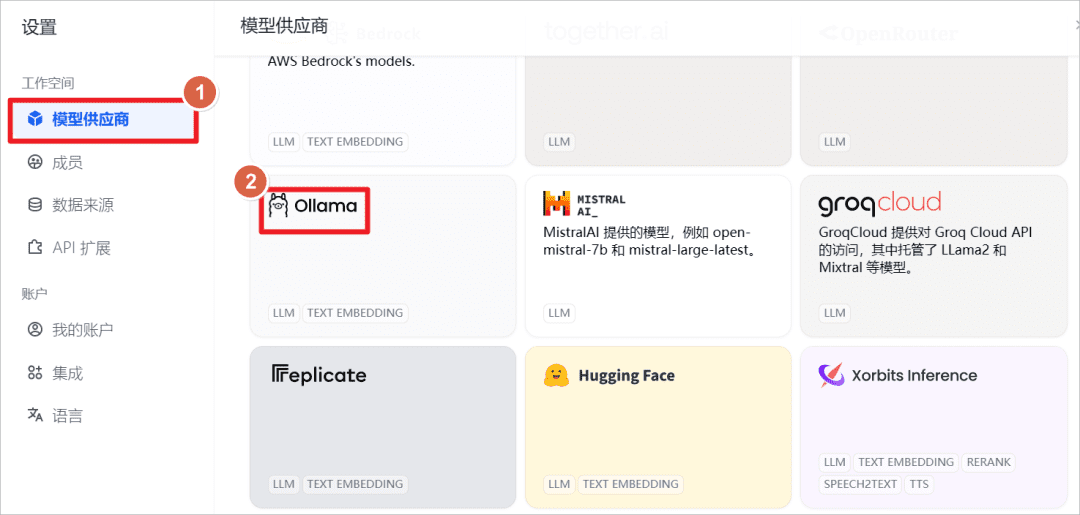

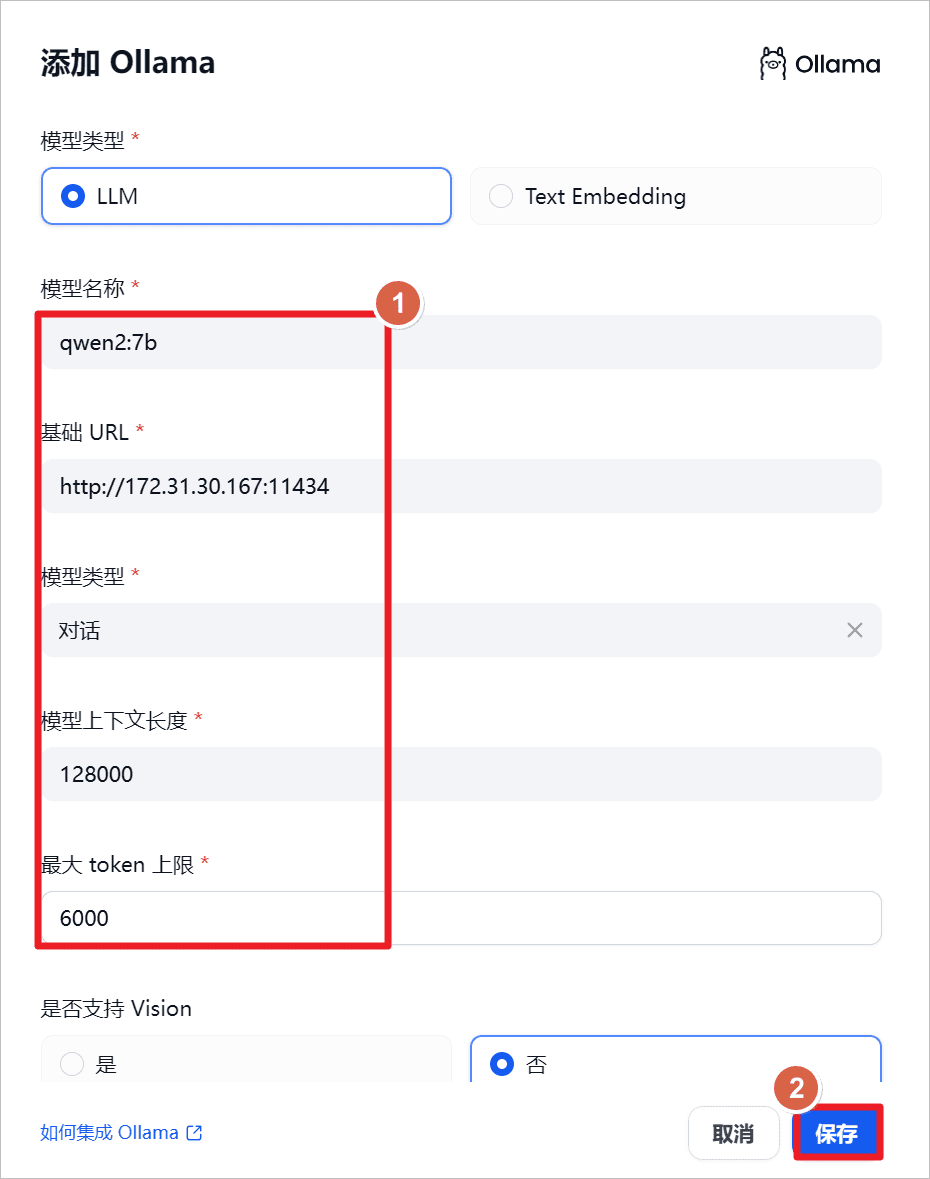

Добавьте модель Ollama.

увеличитьqwen2:7bПоскольку Ollama запускается локально, установите URL на локальный IP-адрес, а порт - на порт114341(математика) род

"qwen2-7b-instruct поддерживает 131 072 токена контекстов, используя YARN, технику экстраполяции длины расширенной модели, и для обеспечения нормального использования и нормального вывода рекомендуется, чтобы API ограничивал пользовательский ввод до 128 000 и вывод до 6 144"[3].

"

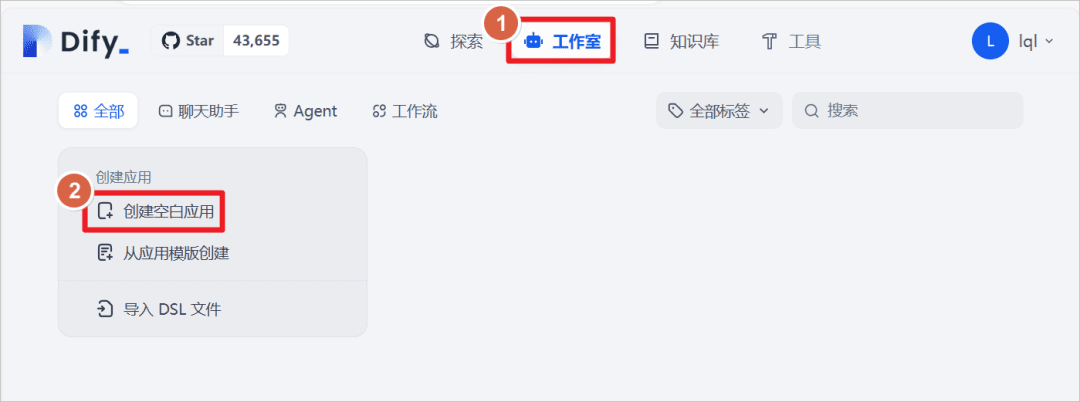

Нажмите на Студия - Создать пустое приложение

Создайте приложение типа "Помощник чата" и задайте ему имяQwen2-7BНажмите кнопку Создать.

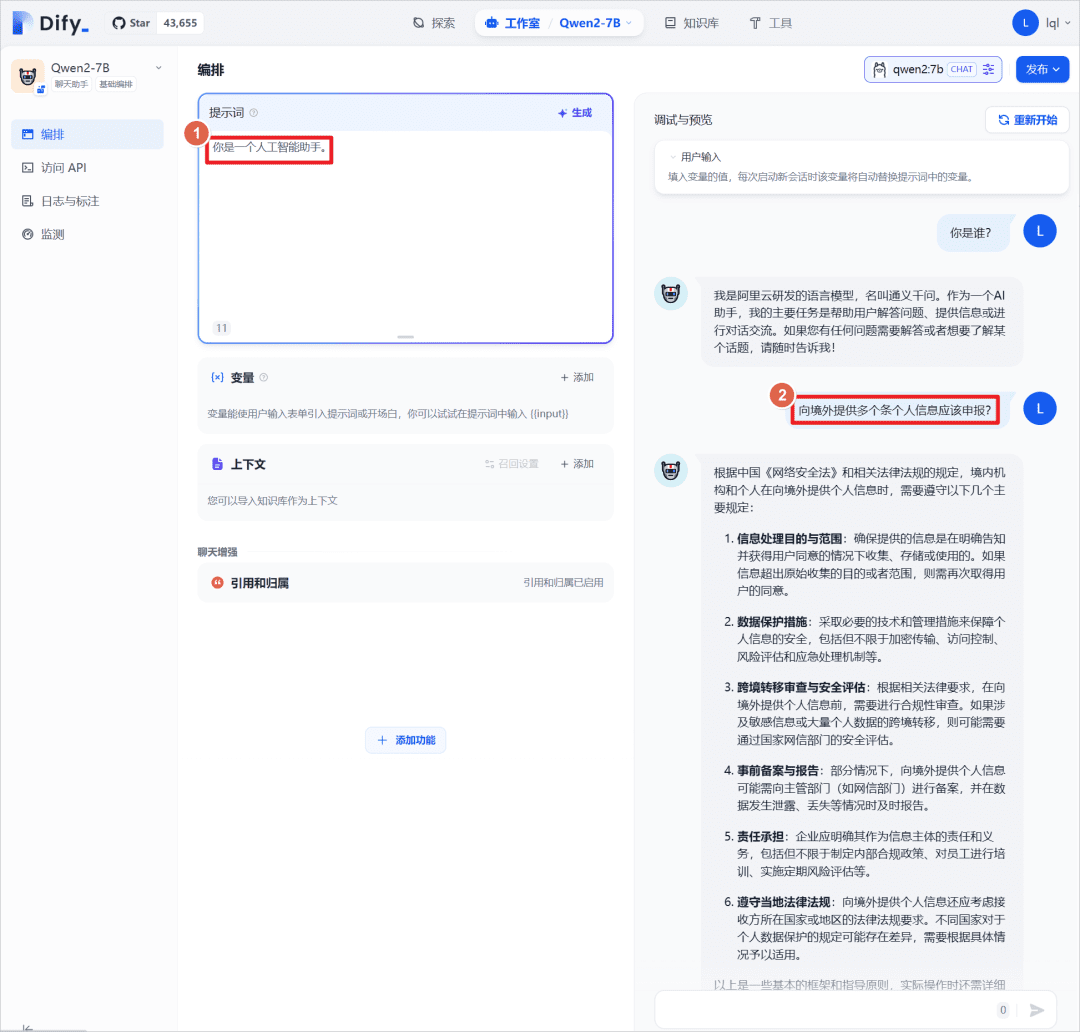

Установка подсказки "Вы - помощник ИИ" для приложения может быть использована в сочетании сQwen2:7BПроведите диалоговый тест, здесь с самой большой моделью, без введения внешней базы знаний, которая будет введена позже для сравнения результатов ответов.

IV. Викторина на основе базы знаний Dify

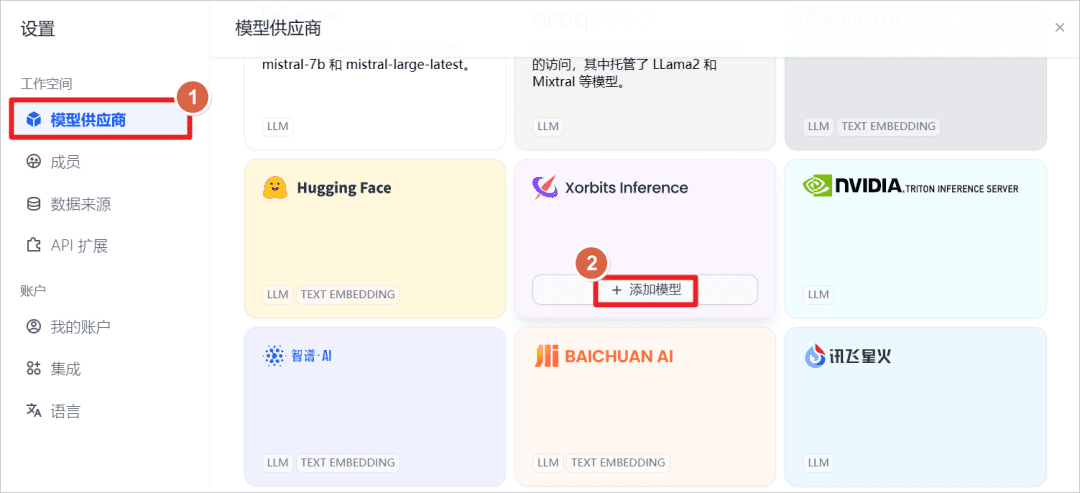

увеличитьXorbits InferenceПредставленные модели.

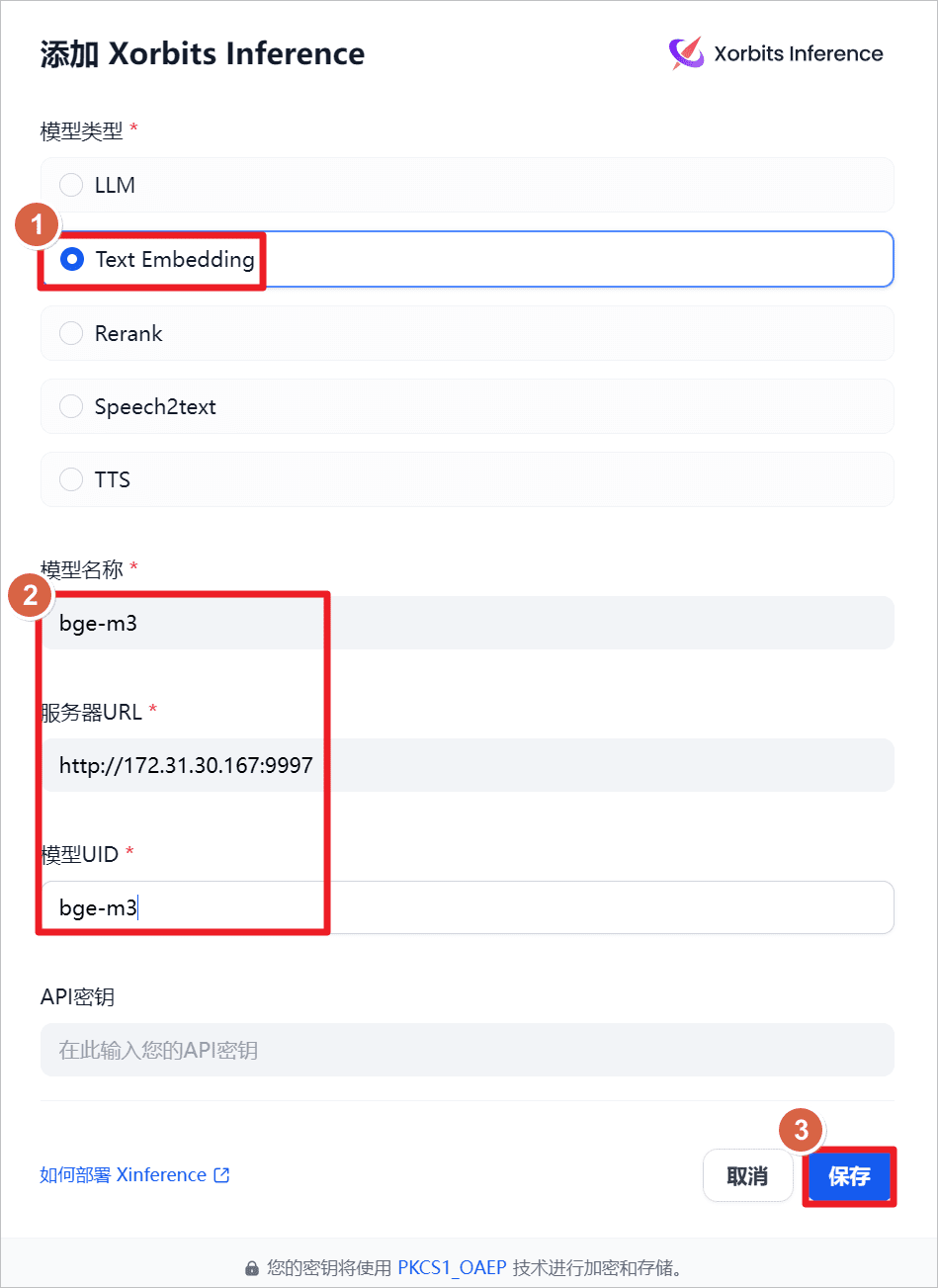

увеличитьText Embeddingт.е. модель встраивания текста, название модели -bge-m3URL-адрес сервераhttp://172.31.30.167:9997(здесь указан IP локальной машины, он может быть установлен и на других машинах, достаточно сети и доступности порта), предварительно запустил XInference на локальной машине и запустилbge-m3модель (см. предыдущее сообщение).

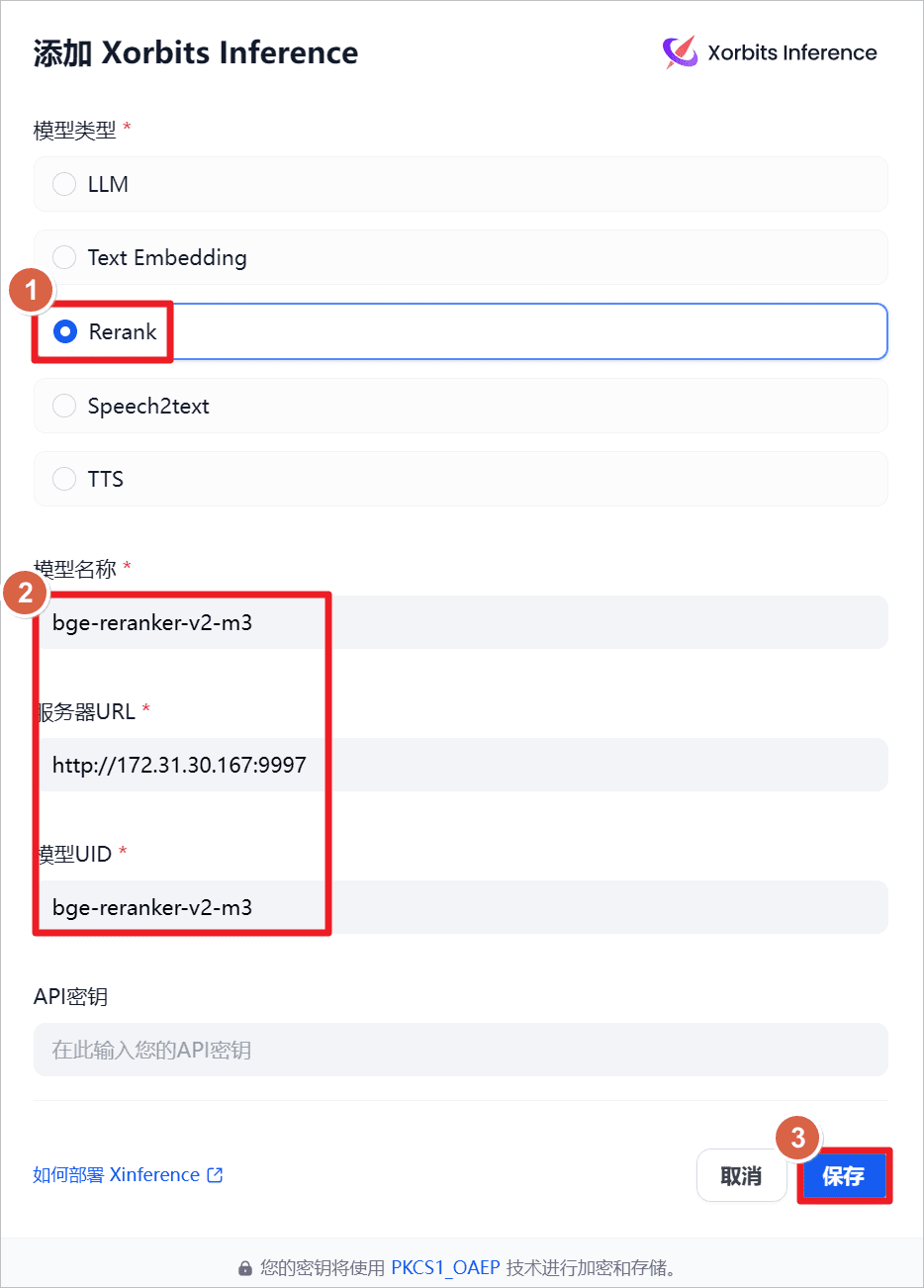

увеличитьRerankт.е. модель перестройки, название модели -bge-reraker-v2-m3URL-адрес сервераhttp://172.31.30.167:9997(здесь указан IP локальной машины, он может быть установлен и на других машинах, достаточно сети и доступности порта), предварительно запустил XInference на локальной машине и запустилbge-reraker-v2-m3модель (см. предыдущее сообщение).

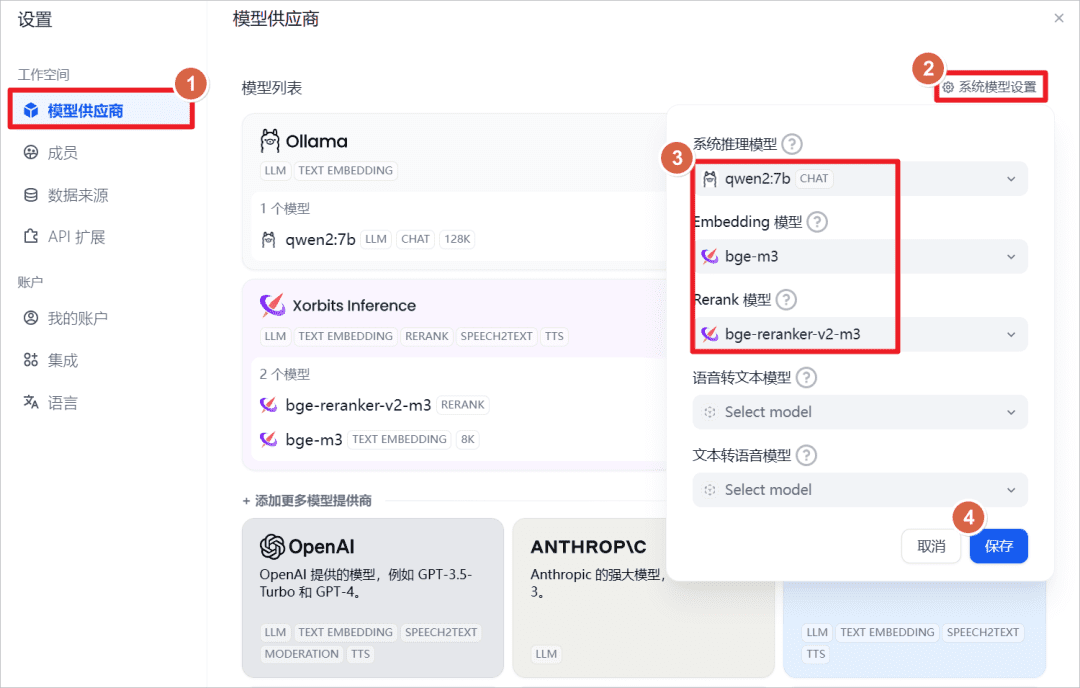

Просмотр настроек системы по умолчанию.

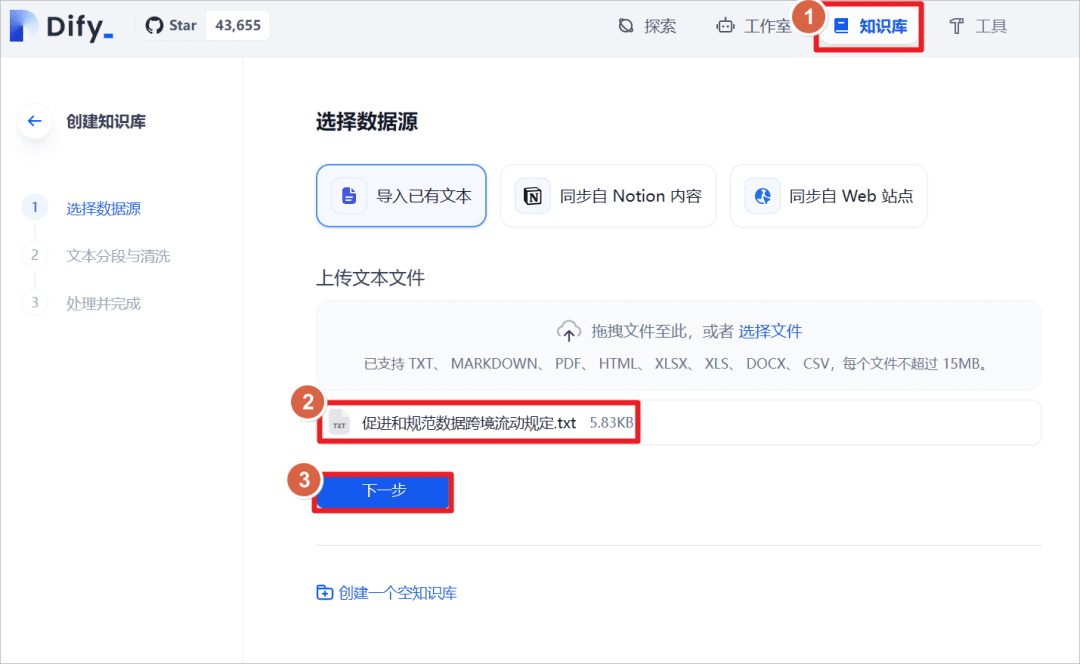

Нажмите "База знаний" - "Импорт существующего текста" - "Загрузить текстовый файл" - выберите документ "Положения о содействии и регулировании трансграничного потока данных".

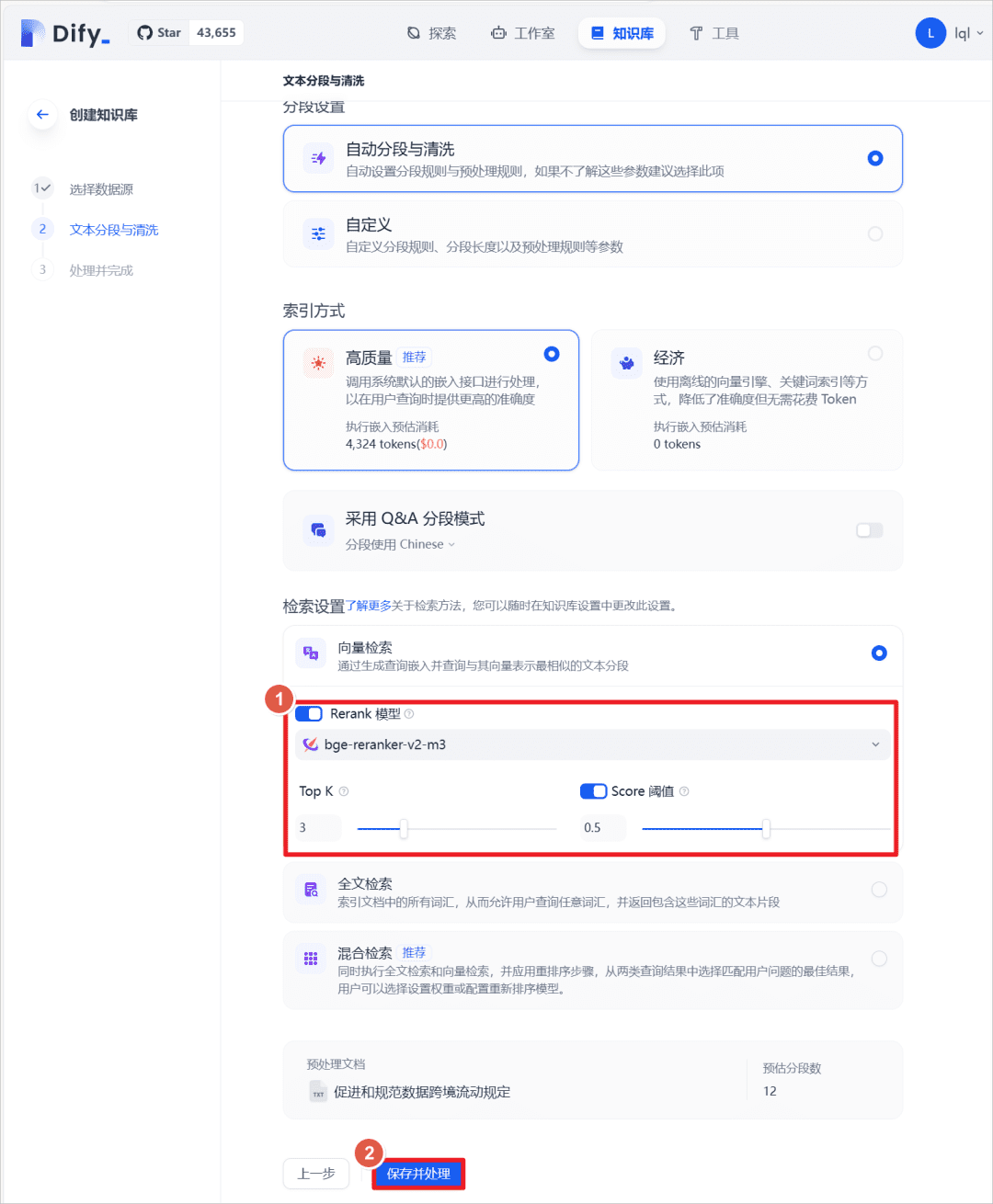

После успешного импорта установите метод извлечения текста и включитеRerankмодель, выберитеbge-reranker-v2-m3модель, включите по умолчаниюScoreПорог равен 0,5 (т.е. текстовые совпадения ниже 0,5 балла не вспоминаются и не добавляются в контекст более крупной модели).

В предыдущем приложении чата добавьте базу знаний, созданную выше, и повторно задайте тот же вопрос более крупной модели, и вы увидите, что модель ответила в сочетании с базой знаний.

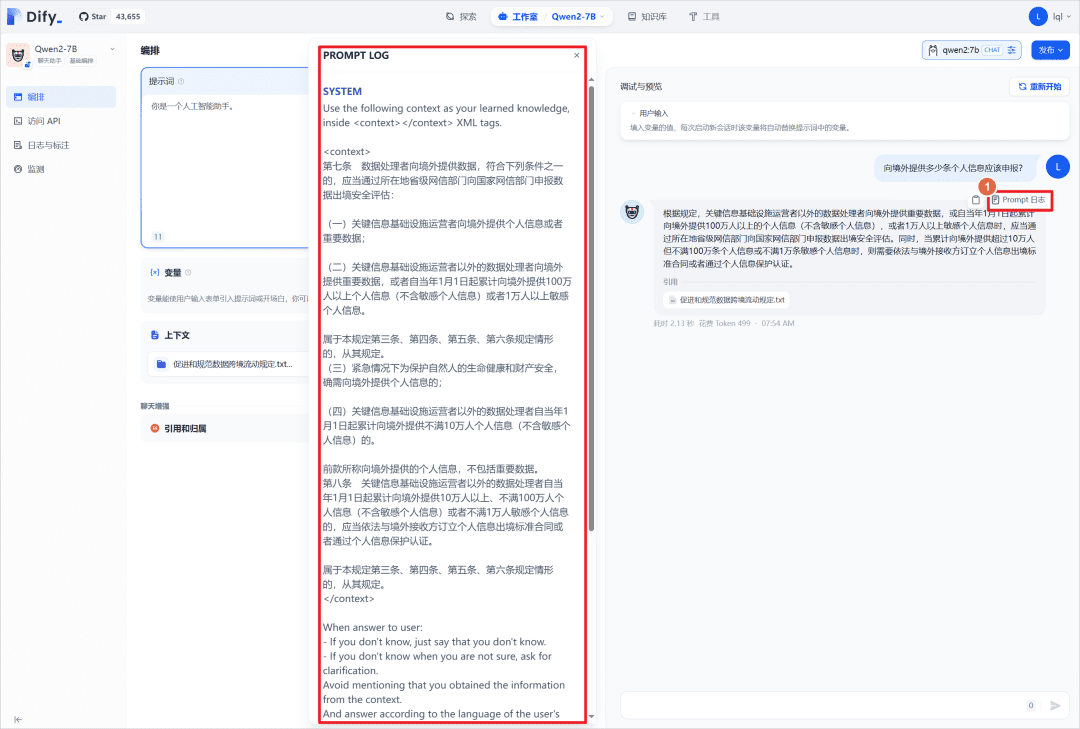

Вы можете щелкнуть "Журнал подсказок", чтобы просмотреть файл журнала, а также просмотреть системные подсказки, которые помещают соответствующее содержимое базы знаний в<context></context>Средний.

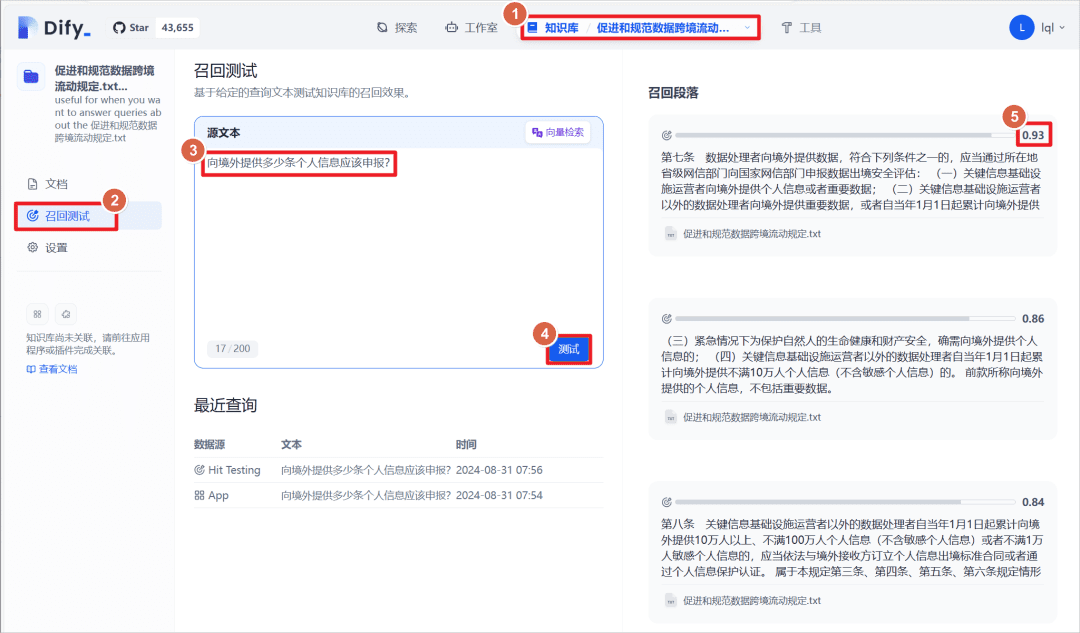

Щелкните на созданной базе знаний - нажмите на "Тест на отзыв", вы можете ввести абзац текста, чтобы сопоставить текст в базе знаний с совпадающим текстом, совпадающий текст имеет весовой балл, порог, установленный выше, составляет 0,5, то есть больше этого балла будет отображаться как "Абзац на отзыв ".

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...