综合介绍

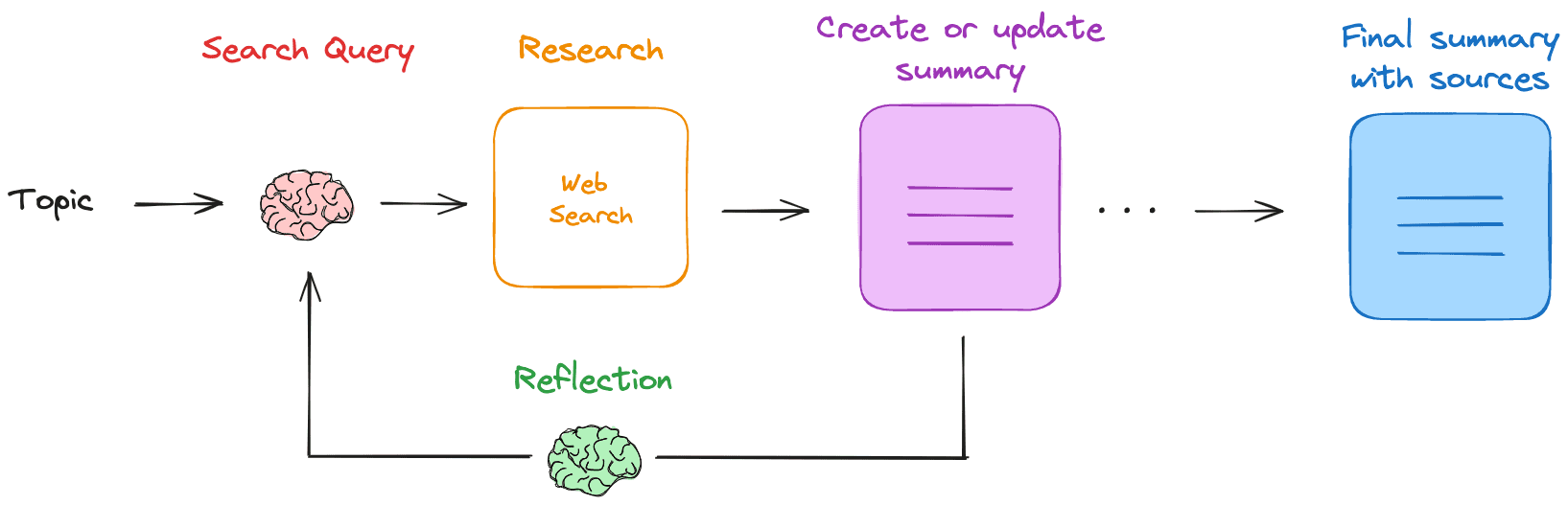

Research Rabbit 是一个基于本地LLM(大语言模型)的网页研究和总结助手。用户提供研究主题后,Research Rabbit 会生成搜索查询,获取相关网页结果,并总结这些结果。它会反复进行这一过程,填补知识空白,最终生成包含所有来源的Markdown总结。该工具完全在本地运行,确保数据隐私和安全。

功能列表

- 生成搜索查询:根据用户提供的主题生成搜索查询。

- 网页搜索:使用配置的搜索引擎(如Tavily)查找相关资源。

- 总结结果:使用本地LLM总结网页搜索结果。

- 反思总结:识别知识空白并生成新的搜索查询。

- 迭代更新:反复进行搜索和总结,逐步完善研究内容。

- 本地运行:所有操作均在本地进行,确保数据隐私。

- Markdown总结:生成包含所有来源的最终Markdown总结。

使用帮助

安装流程

- 拉取本地LLM:从Ollama拉取所需的本地LLM,例如

ollama pull llama3.2。 - 获取Tavily API密钥:注册Tavily并获取API密钥,设置环境变量

export TAVILY_API_KEY=<your_tavily_api_key>。 - 克隆仓库:运行

git clone https://github.com/langchain-ai/research-rabbit.git克隆仓库。 - 安装依赖:进入项目目录并运行

uvx --refresh --from "langgraph-cli[inmem]" --with-editable . --python 3.11 langgraph dev安装依赖。 - 启动助手:启动LangGraph服务器,访问

http://127.0.0.1:2024查看API文档和Web UI。

使用流程

- 配置LLM:在LangGraph Studio Web UI中设置要使用的本地LLM名称(默认

llama3.2)。 - 设置研究深度:配置研究迭代的深度(默认3次)。

- 输入研究主题:在配置标签中输入研究主题,启动研究助手。

- 查看过程:助手会生成搜索查询,进行网页搜索,使用LLM总结结果,并反复进行这一过程。

- 获取总结:研究完成后,助手会生成包含所有来源的Markdown总结,用户可以查看和编辑。

主要功能操作

- 生成搜索查询:输入研究主题后,助手会自动生成搜索查询。

- 网页搜索:助手使用配置的搜索引擎查找相关资源。

- 总结结果:助手使用本地LLM对搜索结果进行总结,生成初步报告。

- 反思总结:助手会识别总结中的知识空白,生成新的搜索查询,继续研究。

- 迭代更新:助手会反复进行搜索和总结,逐步完善研究内容。

- 生成Markdown总结:研究完成后,助手会生成包含所有来源的最终Markdown总结,用户可以查看和编辑。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...