综合介绍

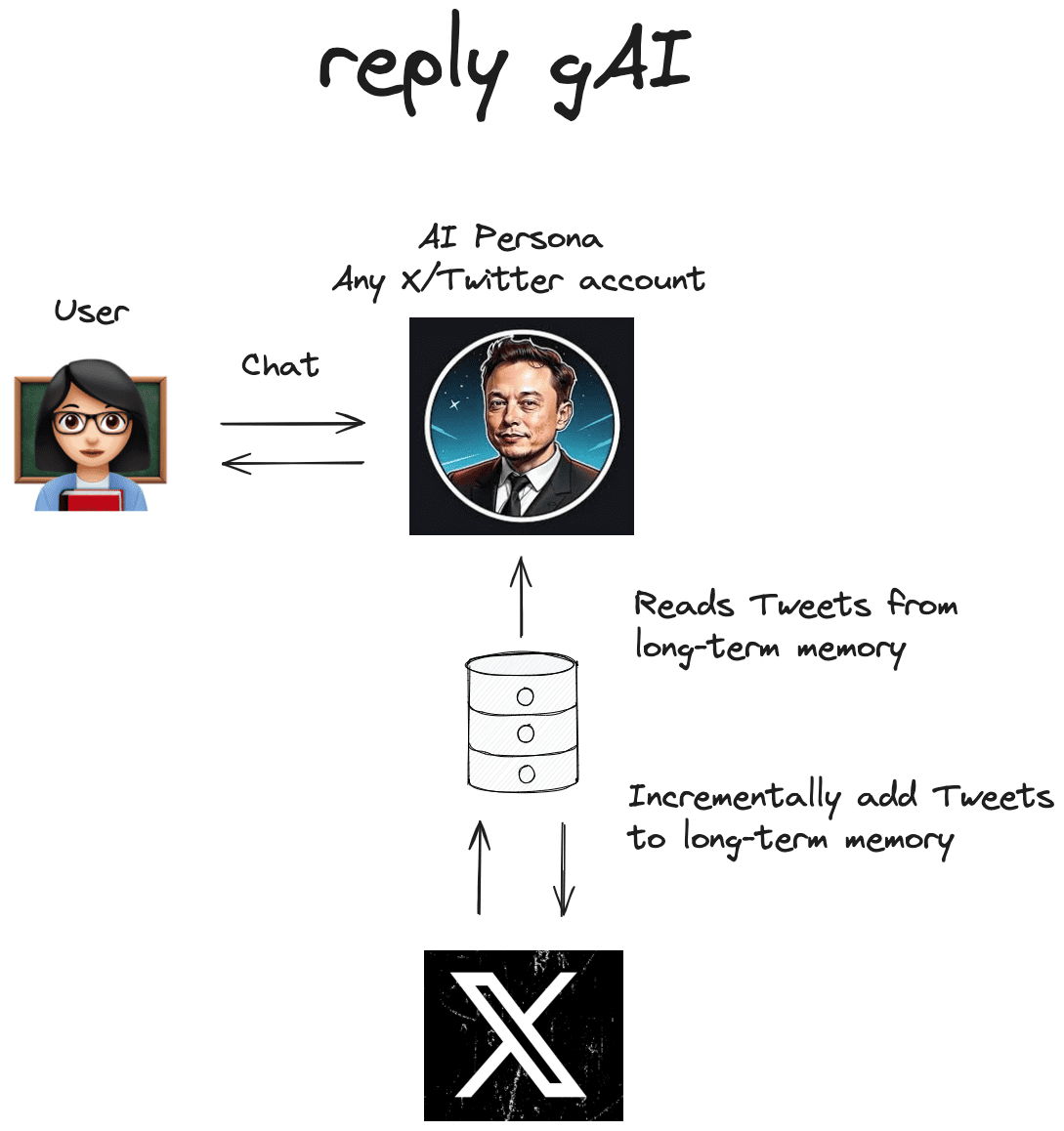

Reply gAI 是一个基于 LangChain 的 AI 工具,旨在为任意 X(原 Twitter)用户创建 AI 克隆。该工具通过自动收集用户的推文,并将其存储在长期记忆中,利用检索增强生成(RAG)技术生成与用户独特写作风格和观点相匹配的回复。Reply gAI 通过 LangGraph 创建工作流,模仿 X 用户的写作风格,确保生成的回复具有上下文相关性和个性化特点。用户可以通过配置 API 密钥和指定 X 用户句柄,轻松启动和使用该工具。

功能列表

- 自动收集 X 用户的推文并存储在长期记忆中

- 利用 RAG 技术生成与用户写作风格匹配的回复

- 支持通过 LangGraph 创建工作流

- 提供本地运行的 LangGraph 服务器进行开发和持久化存储

- 支持语义搜索和上下文相关的回复生成

- 提供可视化界面查看存储的推文

使用帮助

安装流程

- 克隆仓库:

git clone https://github.com/langchain-ai/reply_gAI.git

cd reply_gAI

- 安装依赖:

pip install -r requirements.txt

- 配置 API 密钥:

export ANTHROPIC_API_KEY=<your_anthropic_api_key>

export ARCADE_API_KEY=<your_arcade_api_key>

export ARCADE_USER_ID=<your_arcade_user_id>

- 启动 LangGraph 服务器:

uvx --refresh --from "langgraph-cli [inmem]" --with-editable . --python 3.11 langgraph dev

使用流程

- 在配置选项卡中添加任意 X 用户的句柄。

- 通过 LangGraph Studio 可视化界面查看和管理存储的推文。

- 与指定用户的 AI 克隆进行互动,生成个性化回复。

主要功能操作

- 推文收集:使用 Arcade API X 工具包从指定 X 用户获取过去 7 天的推文,并存储在 LangGraph 服务器的内存存储中。

- 回复生成:利用 RAG 技术,根据存储的推文生成上下文相关的回复,模仿用户的写作风格。

- 长时记忆:推文存储在本地运行的 LangGraph 服务器中,使用 Postgres 进行持久化存储。

- 可视化管理:通过 LangGraph Studio 查看和管理存储的推文,确保回复生成使用最新和相关的数据。

详细操作流程

- 推文收集:系统自动刷新推文,确保使用最新数据生成回复。

- 回复生成:根据推文内容和用户写作风格生成个性化回复,确保上下文相关性。

- 长时记忆管理:推文存储在 LangGraph 服务器中,支持语义搜索和上下文相关的回复生成。

- 可视化界面:通过 LangGraph Studio 查看和管理存储的推文,确保数据的可视化和易用性。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...