综合介绍

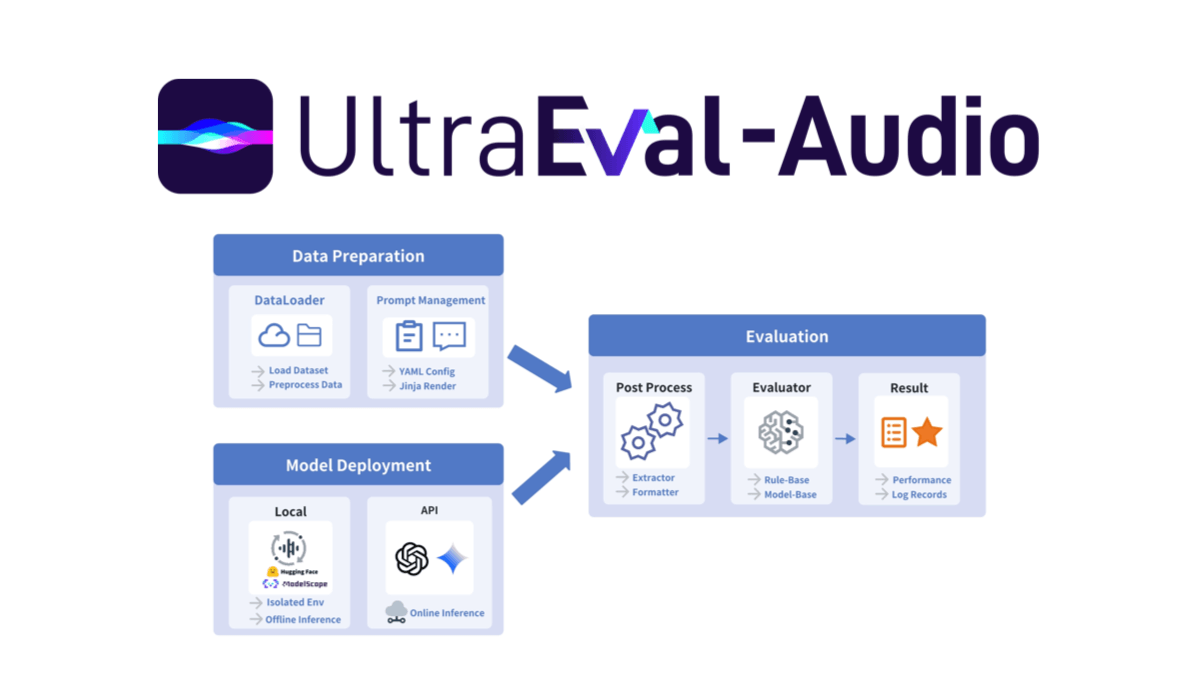

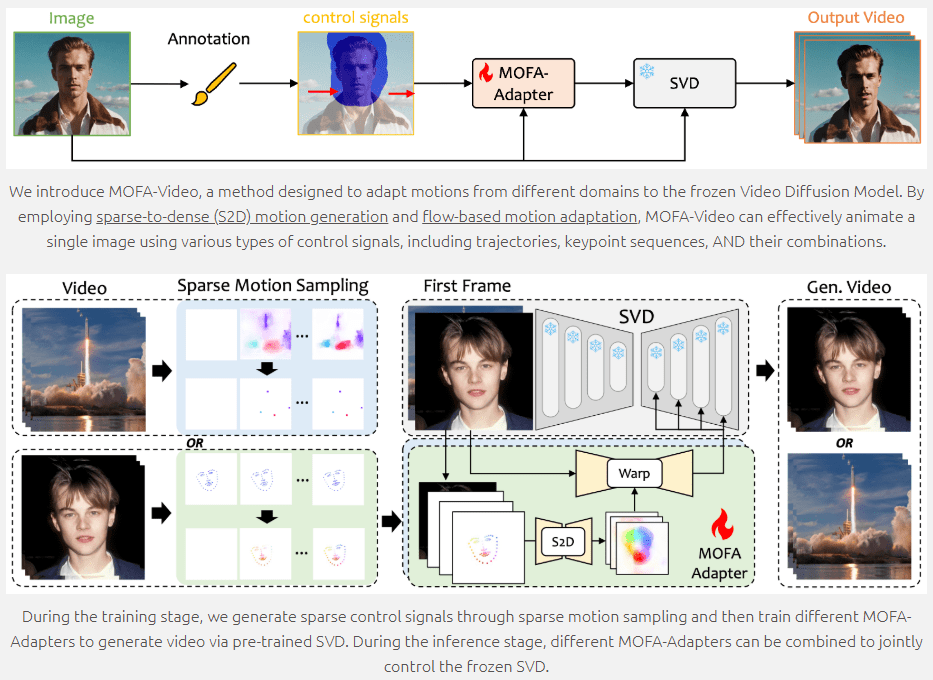

MOFA-Video 是一个先进的图像动画生成工具,利用生成运动场适配技术,将静态图像转换为动态视频。该项目由东京大学和腾讯 AI 实验室合作开发,并将在 2024 年欧洲计算机视觉会议(ECCV)上展示。MOFA-Video 支持多种控制信号,包括轨迹、关键点序列及其组合,能够实现高质量的图像动画效果。用户可以通过 GitHub 仓库获取代码和相关资源,轻松上手使用。

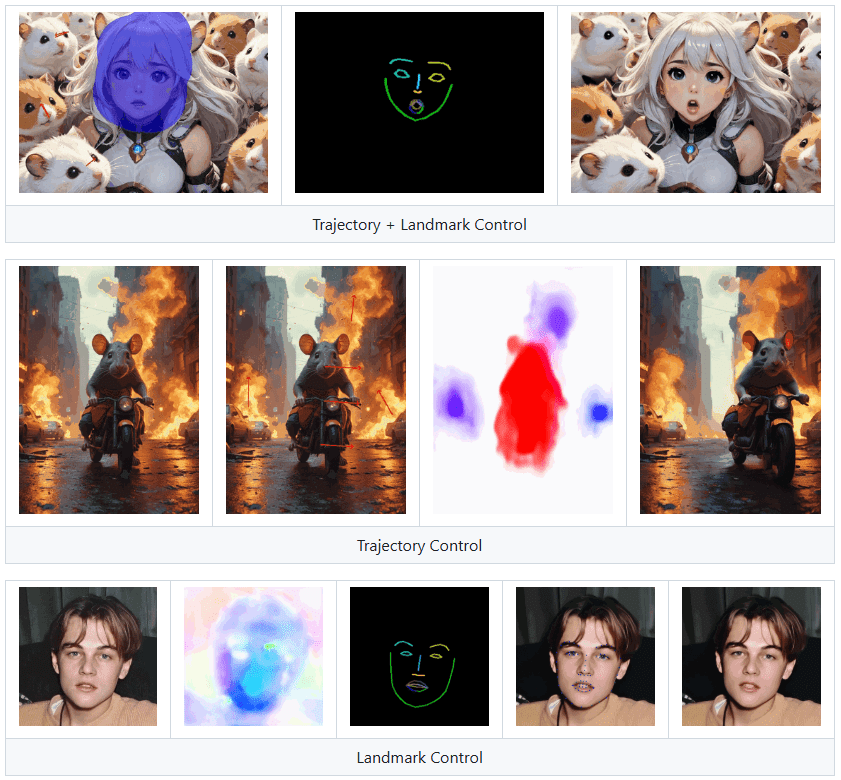

Landmark Control可以让图像中的人物说话,但不适合作为克隆数字人使用。

功能列表

- 图像动画生成:将静态图像转换为动态视频

- 多种控制信号:支持轨迹、关键点序列及其组合

- 运动场适配:通过稀疏到密集的运动生成和基于流的运动适配实现动画

- 训练和推理脚本:提供训练和推理的完整代码

- Gradio 演示:在线演示和检查点下载

- 开源代码:在 GitHub 上公开代码和资源

使用帮助

环境设置

- 克隆仓库

git clone https://github.com/MyNiuuu/MOFA-Video.git

cd ./MOFA-Video

- 创建并激活 Conda 环境

conda create -n mofa python==3.10

conda activate mofa

- 安装依赖

pip install -r requirements.txt

pip install opencv-python-headless

pip install "git+https://github.com/facebookresearch/pytorch3d.git"

- 下载检查点 从 HuggingFace 仓库下载检查点,并将其放置在

./MOFA-Video-Hybrid/models/cmp/experiments/semiauto_annot/resnet50_vip+mpii_liteflow/checkpoints目录下。

使用 Gradio 演示

- 使用音频驱动面部动画

cd ./MOFA-Video-Hybrid

python run_gradio_audio_driven.py

- 使用参考视频驱动面部动画

cd ./MOFA-Video-Hybrid

python run_gradio_video_driven.py

Gradio 界面将显示相关指示,请按照界面上的说明进行推理操作。

训练和推理

MOFA-Video 提供了完整的训练和推理脚本,用户可以根据需要进行自定义训练和推理。详细的使用说明请参考 GitHub 仓库中的 README 文件。

主要功能操作流程

- 图像动画生成:上传静态图像,选择控制信号(轨迹、关键点序列或其组合),点击生成按钮,即可生成动态视频。

- 多种控制信号:用户可以选择不同的控制信号组合,实现更加丰富的动画效果。

- 运动场适配:通过稀疏到密集的运动生成和基于流的运动适配技术,确保动画效果的流畅性和自然性。

MOFA-Video 提供了丰富的功能和详细的使用说明,用户可以根据自己的需求进行图像动画生成和自定义训练,轻松实现高质量的图像动画效果。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...