综合介绍

LLManager 是一个开源的智能审批管理工具,基于 LangChain 的 LangGraph 框架开发,专注于自动化处理审批请求,同时结合人类审核优化决策。它通过语义搜索、少样本学习和反思机制,从历史审批中学习,提升审批准确性。用户可通过 Agent Inbox 查看和响应请求,支持自定义审批和拒绝标准,适配多种语言模型(如 OpenAI、Anthropic)。LLManager 适用于企业预算审批、项目管理和合规审查等场景,代码托管于 GitHub,开发者可自由扩展功能。工具强调 AI 与人类协作,兼顾效率和可靠性。

功能列表

- 自动化审批:根据用户定义的审批和拒绝标准,自动生成审批建议。

- 人类审核:支持人工接受、修改或拒绝 AI 生成的审批结果,确保决策准确。

- 语义搜索:从历史请求中提取 10 个语义相似的样本,提升审批的上下文相关性。

- 少样本学习:基于历史审批数据,优化模型的未来决策能力。

- 反思机制:分析被修改的审批结果,生成反思报告,改进模型表现。

- 模型自定义:支持 OpenAI、Anthropic 等模型,需支持工具调用功能。

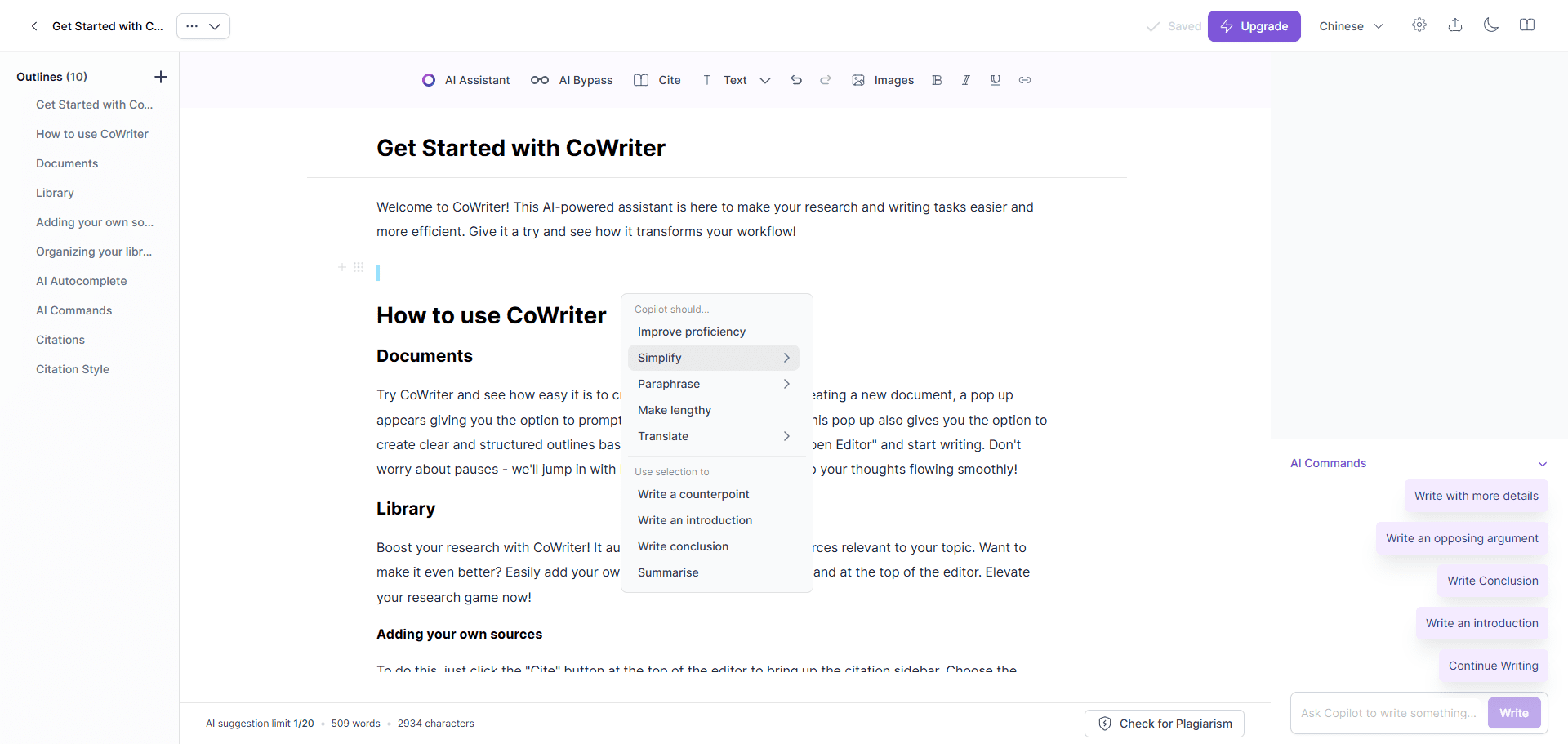

- Agent Inbox 交互:提供直观界面,用于查看、响应和管理审批请求。

- 动态提示构建:根据请求动态调整提示,适配多样化的审批场景。

- 端到端评估:运行测试用例,验证工作流的可靠性和准确性。

使用帮助

安装流程

LLManager 是基于 LangChain 和 LangGraph 的开源项目,需本地部署。以下是详细安装步骤:

- 克隆代码库:

在终端运行以下命令,获取 LLManager 代码:git clone https://github.com/langchain-ai/llmanager.git cd llmanager - 安装依赖:

确保系统已安装 Python 3.11 或更高版本,以及 Node.js(用于 Yarn)。创建虚拟环境并安装依赖:python3 -m venv venv source venv/bin/activate yarn install默认依赖包括 LangChain 和 Anthropic/OpenAI 集成包。若使用其他模型(如 Google GenAI),需额外安装:

yarn install @langchain/google-genai - 配置环境变量:

复制示例环境文件并填写必要信息:cp .env.example .env编辑

.env文件,添加 LangSmith API 密钥和 Anthropic API 密钥(若使用 Anthropic 模型):LANGCHAIN_PROJECT="default" LANGCHAIN_API_KEY="lsv2_..." LANGCHAIN_TRACING_V2="true" LANGSMITH_TEST_TRACKING="true" ANTHROPIC_API_KEY="your_anthropic_key"LangSmith 用于追踪和调试,建议启用。

- 启动开发服务器:

运行以下命令,启动 LangGraph 服务器:yarn dev服务器默认运行在

http://localhost:2024。生产环境中,需部署到云服务器并更新 URL。

使用方法

LLManager 的核心是通过 Agent Inbox 管理和响应审批请求。以下是详细操作流程:

- 运行端到端评估:

- 执行以下命令,生成新审批助手并运行 25 个测试用例:

yarn test:single evals/e2e.int.test.ts - 终端会输出新助手的 UUID,记录此 ID 用于 Agent Inbox 配置。

- 若需复用同一助手,可修改

evals/e2e.int.test.ts,使用固定助手 ID。

- 执行以下命令,生成新审批助手并运行 25 个测试用例:

- 配置审批规则:

- 在

config.json中设置审批和拒绝标准。例如:{ "approvalCriteria": "请求需包含详细预算和时间表", "rejectionCriteria": "缺少必要文件或预算超标", "modelId": "anthropic/claude-3-7-sonnet-latest" } - 未设置规则时,LLManager 会基于历史数据学习,但设置规则可加速模型适应。

modelId支持provider/model_name格式,如openai/gpt-4o或anthropic/claude-3-5-sonnet-latest。

- 在

- 使用 Agent Inbox:

- 访问 dev.agentinbox.ai,点击“Add Inbox”。

- 输入以下信息:

- Assistant/Graph ID:端到端评估生成的 UUID。

- Deployment URL:

http://localhost:2024(开发环境)。 - Name:自定义名称,如

LLManager。

- 提交后刷新 Inbox,查看待处理请求。

- 对于每个请求,Agent Inbox 显示:

- AI 生成的审批建议和推理报告。

- 操作选项:接受、修改(编辑建议或说明)或拒绝(提供理由)。

- 修改或接受的请求会自动存入少样本示例库,用于优化后续审批。

- 查看和优化审批历史:

- 在 Agent Inbox 中,点击已处理请求,可查看审批详情、AI 推理报告和人工修改记录。

- 系统通过语义搜索,从历史记录中提取相似请求,作为上下文输入模型。

- 被修改的请求会触发反思机制,生成反思报告,存入反思库,用于改进模型。

特色功能操作

- 语义搜索:新请求到达时,系统从历史记录中提取 10 个语义相似的请求(包括请求内容、最终答案和说明),作为提示上下文,提升审批准确性。

- 反思机制:

- 若人工仅修改说明(答案正确但推理有误),触发

explanation_reflection节点,分析推理错误并生成新反思。 - 若答案和说明均被修改,触发

full_reflection节点,分析整体错误并生成反思。 - 反思报告存入反思库,优化后续推理。

- 若人工仅修改说明(答案正确但推理有误),触发

- 动态提示构建:根据请求内容和历史数据,动态调整提示内容,确保审批适配多样化场景。

- 模型切换:通过修改

config.json中的modelId,切换至支持工具调用的模型(如openai/gpt-4o),需确保已安装对应集成包。

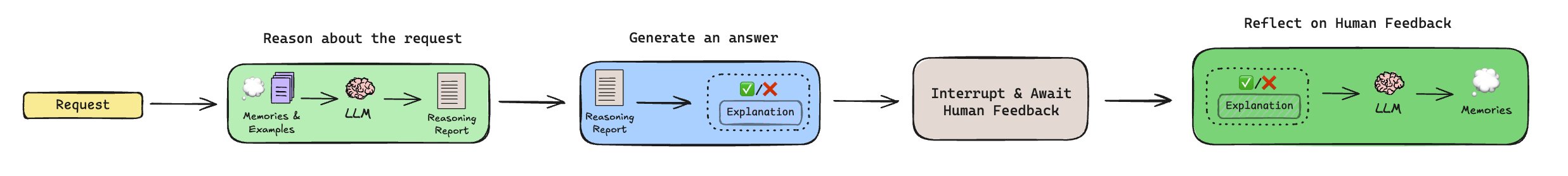

工作流详解

LLManager 的审批流程包括以下步骤:

- 推理(Reasoning):

- 提取历史反思和少样本示例(通过语义搜索)。

- 生成推理报告,分析请求是否应批准,但不做最终决定。

- 生成答案(Generate Answer):

- 结合推理报告和上下文,生成最终审批建议(批准或拒绝)及说明。

- 人类审核(Human Review):

- 暂停工作流,等待人工通过 Agent Inbox 审核。

- 人工可接受、修改或拒绝建议,修改内容存入少样本示例库。

- 反思(Reflection):

- 若建议被修改,触发反思机制,生成改进建议。

- 未修改的请求跳过此步骤。

注意事项

- 确保 LangSmith API 密钥有效,开发和生产环境均需稳定网络。

- 非 OpenAI/Anthropic 模型需安装额外集成包,参考 LangChain 文档。

- 生产部署需将 LangGraph 服务器迁移至云端,并更新 Agent Inbox 的 URL。

应用场景

- 企业预算审批

LLManager 自动化处理员工的预算申请,基于预设规则(如预算上限、项目类型)生成建议。财务团队通过 Agent Inbox 审核,修改或确认结果,减少重复性工作。 - 项目任务分配

项目经理使用 LLManager 审批任务分配请求。系统分析任务优先级和资源需求,生成分配建议。经理人工审核,确保任务分配高效合理。 - 合规性审查

LLManager 检查提交的文档是否符合法规要求,标记潜在问题。合规团队通过 Inbox 确认或调整结果,提升审查效率。 - 客户请求管理

客服团队使用 LLManager 审批客户退款或服务请求。系统根据历史数据生成建议,团队人工审核,确保决策公平且一致。

QA

- LLManager 支持哪些模型?

支持 OpenAI、Anthropic 等模型,需支持工具调用功能。非默认模型需安装对应 LangChain 集成包,如@langchain/google-genai。 - 如何复用同一助手?

修改evals/e2e.int.test.ts,使用固定助手 ID,或在运行评估前搜索现有 ID,避免生成新助手。 - 生产环境中如何部署?

将 LangGraph 部署至云服务器,更新 Agent Inbox 的 Deployment URL。使用 LangSmith 监控工作流表现。 - 如何自定义工作流?

编辑推理子图(调整提示生成逻辑)或反思子图(控制反思生成规则),适配特定审批场景。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...