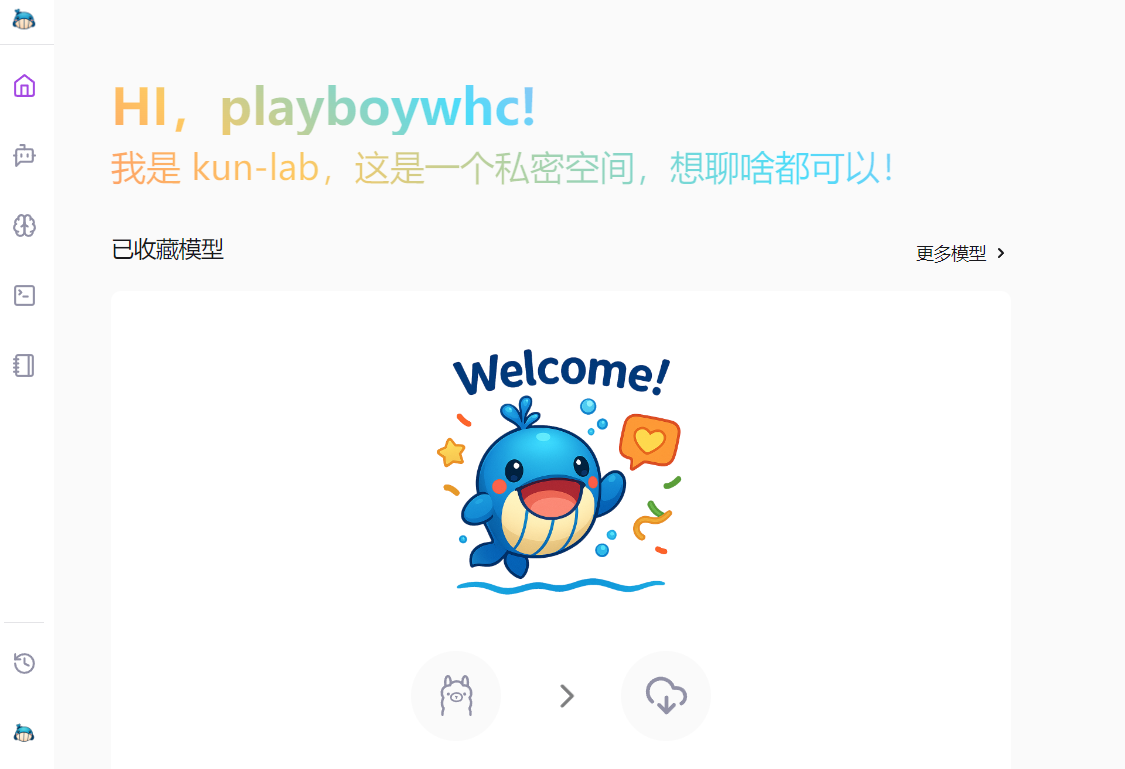

综合介绍

kun-lab 是一款基于 Ollama 的开源 AI 对话应用,专注于提供轻量、快速的本地化智能对话体验。它支持 Windows、macOS 和 Linux(目前以 Windows 为主),无需复杂配置即可使用。用户可以与 AI 进行流畅的多轮对话,解析文档,识别图片,甚至联网搜索答案。所有数据存储在本地,保障隐私安全。kun-lab 还提供代码渲染、提示词模板和多语言界面,适合开发者、学生或需要高效 AI 工具的用户。

功能列表

- 智能对话:支持多轮实时对话,AI 响应流畅,可联网搜索更全面答案。

- 文档解析:上传 PDF、DOC、PPT、TXT 文件,AI 理解内容并回答问题。

- 图片识别:识别 JPG、PNG 图片,提取文字或分析场景,支持多轮对话。

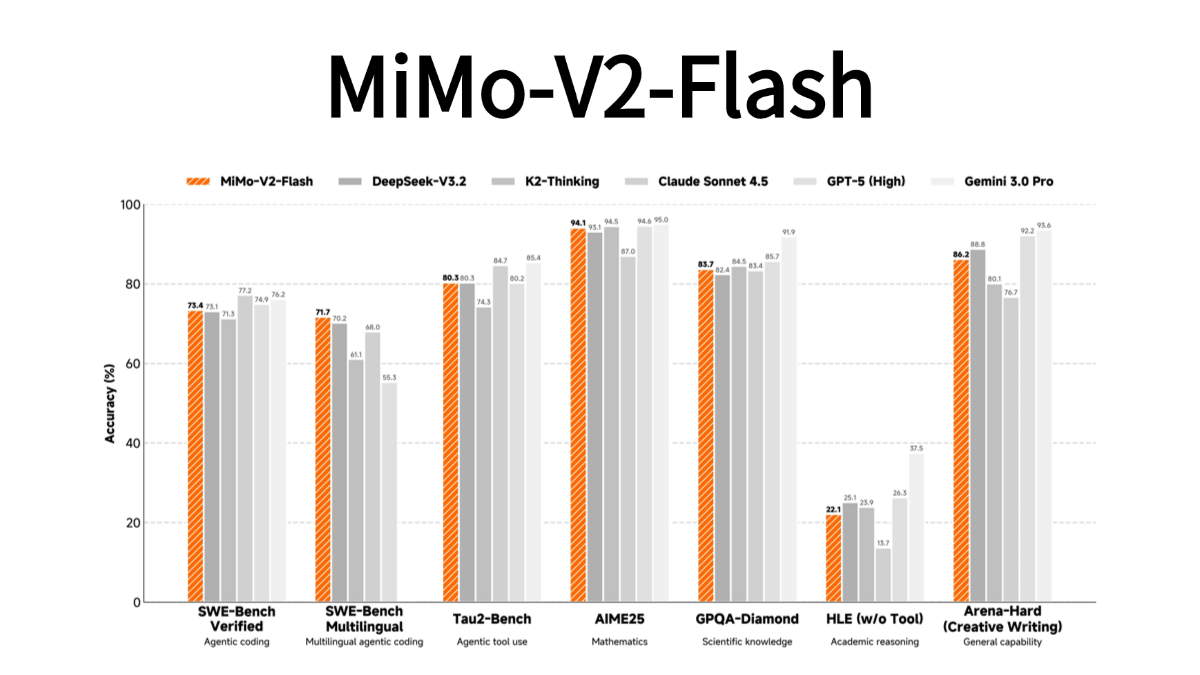

- 模型管理:轻松切换 Ollama 或 Hugging Face 模型,支持 GGUF 和 safetensors 格式。

- 提示词模板:内置模板并支持自定义,方便激发 AI 创造力。

- 代码渲染:自动高亮多种编程语言代码,展示清晰。

- 快速笔记:支持 Markdown 语法,实时预览并一键导出。

- 多用户支持:允许多人同时登录,各自拥有独立对话空间。

- 多语言界面:支持中文、英文等语言,操作更友好。

使用帮助

kun-lab 是一款功能丰富的 AI 对话工具,基于 Ollama 运行,操作简单,适合本地使用。以下详细介绍安装流程、核心功能操作及上手步骤,帮助用户快速掌握。

安装 kun-lab

kun-lab 提供桌面应用和源码部署两种方式。目前桌面应用仅支持 Windows,源码部署支持 Windows、macOS 和 Linux。

方式 1:桌面应用(推荐)

- 访问 GitHub 发布页面(https://github.com/bahamutww/kun-lab/releases)。

- 下载适合你的系统安装包:

- Windows:

.exe文件。 - macOS:

.dmg文件(未来支持)。 - Linux:

.AppImage或.deb文件(未来支持)。

- Windows:

- 双击安装包,按提示完成安装。

- 安装后,点击桌面图标运行 kun-lab,无需额外配置。

- 启动后,选择语言(默认支持中文),进入主界面。

方式 2:源码部署

如果你想自定义或开发,需安装环境并运行代码。以下是详细步骤:

- 准备环境:

- 确保系统为 Windows、macOS 或 Linux。

- 安装 Python 3.10 或更高版本(下载:https://www.python.org)。

- 安装 Node.js 20.16.0 或更高版本(下载:https://nodejs.org)。

- 安装 Ollama 并启动服务(参考:https://ollama.com)。

- 克隆仓库:

git clone https://github.com/bahamutww/kun-lab.git cd kun-lab - 创建虚拟环境:

python -m venv venv .\venv\Scripts\activate # Windows # source venv/bin/activate # macOS/Linux - 安装后端依赖:

cd backend pip install -r requirements.txt - 安装前端依赖:

cd frontend npm install - 配置环境变量:

cp .env.example .env- 用文本编辑器打开

.env文件,按需修改配置(如端口号)。

- 用文本编辑器打开

- 启动应用:

python run_dev.py - 打开浏览器,访问 http://localhost:5173,开始使用。

核心功能操作

以下介绍 kun-lab 的主要功能及具体操作流程,确保用户能轻松上手。

1. 智能 AI 对话

- 开始对话:

- 打开 kun-lab,点击“聊天对话”或“新对话”。

- 在模型列表选择一个模型(默认有 Ollama 提供的模型)。

- 输入问题,AI 会实时响应。

- 联网搜索:

- 若问题需要最新信息,勾选“开启网络搜索”。

- AI 会结合网页数据回答,答案更全面。

- 管理历史记录:

- 对话自动保存,点击侧边栏“历史记录”查看。

- 可删除或导出某次对话。

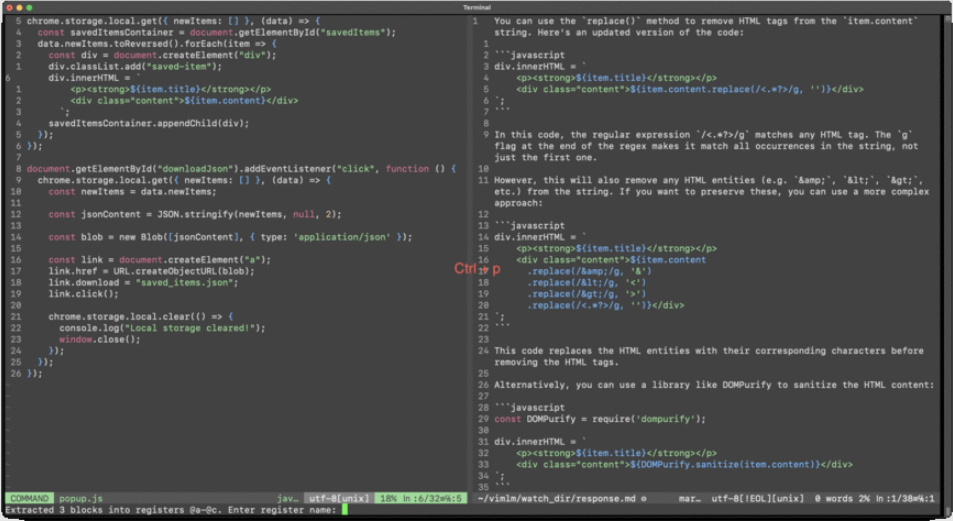

- 代码支持:

- 输入代码相关问题,AI 以高亮格式展示代码。

- 支持 Python、JavaScript 等多种语言。

2. 文档解析

- 上传文档:

- 点击“文档对话”页面。

- 点击“上传”按钮,选择 PDF、DOC、PPT 或 TXT 文件。

- 文件解析后,AI 显示文档概要。

- 提问:

- 在对话框输入与文档相关的问题。

- AI 根据内容回答,支持上下文关联。

- 检索内容:

- 输入关键词,AI 快速定位文档中的相关部分。

- 点击结果跳转到原文位置。

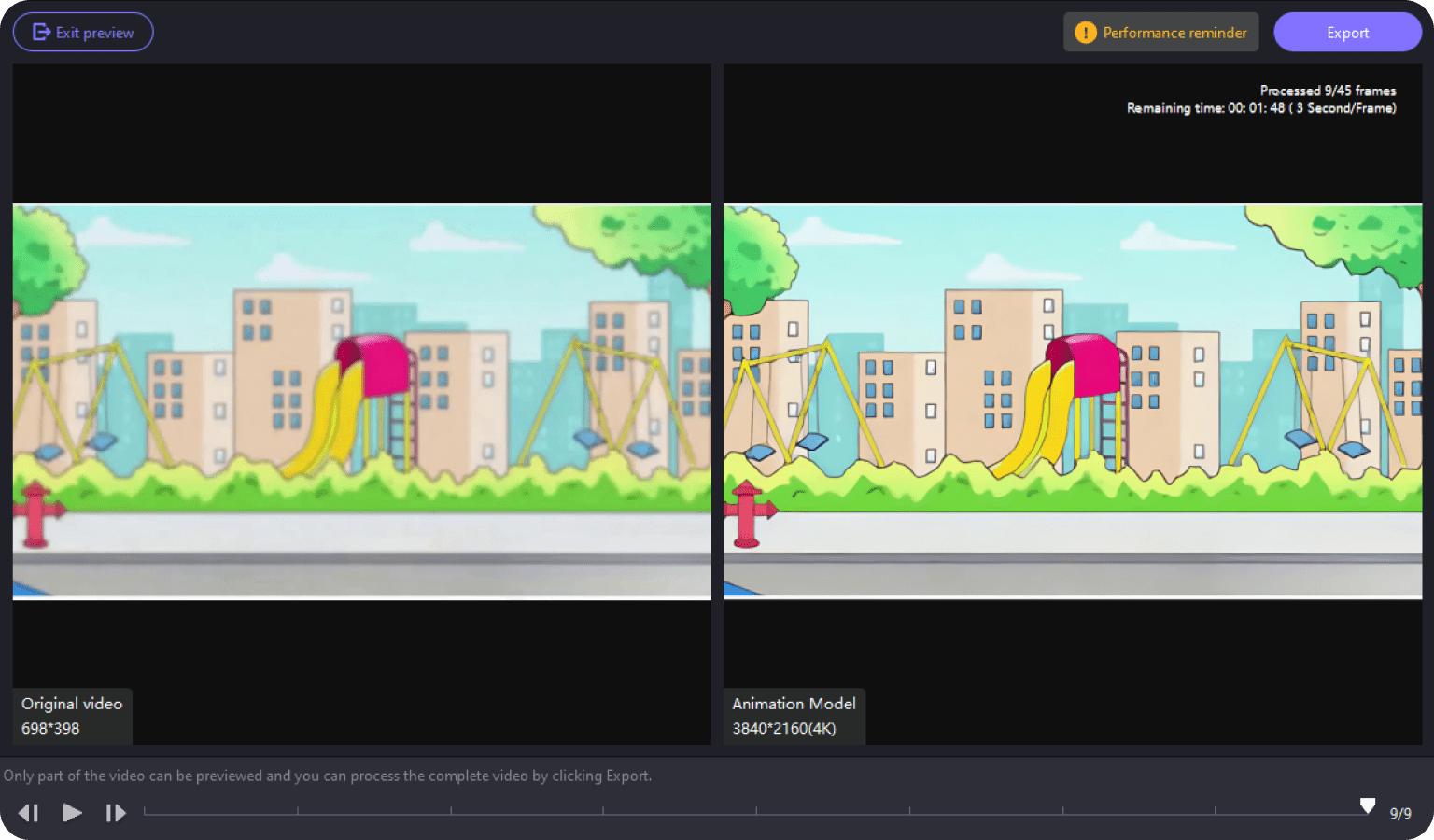

3. 图片识别

- 上传图片:

- 进入“图片对话”页面。

- 点击“上传图片”,选择 JPG、PNG 或 JPEG 文件。

- AI 自动识别场景或提取文字。

- 多轮对话:

- 基于图片提问,如“这个图片里有什么?”。

- AI 回答后,可继续深入提问。

- OCR 功能:

- 若图片含文字,AI 会提取并显示。

- 可复制文字或基于文字提问。

4. 模型管理

- 拉取模型:

- 进入“模型库”页面。

- 点击“拉取模型”。

- 输入命令,如

ollama run qwq:32b或ollama run hf.co/Qwen/QwQ-32B-GGUF:Q2_K。 - 等待下载完成,模型即可使用。

- 切换模型:

- 在对话页面,点击模型下拉菜单。

- 选择已下载的模型,立即切换。

- 自定义模型:

- 点击“自定义”按钮。

- 输入模型名称和系统提示词(如“扮演数学老师”)。

- 选择基础模型,点击“创建”。

5. 提示词管理

- 使用模板:

- 打开“提示词”页面。

- 浏览内置模板,如“写文章大纲”或“代码调试”。

- 点击模板,直接应用到对话。

- 自定义提示词:

- 点击“新建提示词”。

- 输入名称和内容,保存后可分类管理。

- 快速应用:

- 在对话时,选择提示词,AI 按设定响应。

6. 快速笔记

- 创建笔记:

- 点击“笔记”页面。

- 输入 Markdown 格式内容,如标题、列表或代码。

- 右侧实时预览效果。

- 导出笔记:

- 点击“导出”按钮,保存为

.md文件。 - 可分享或导入其他工具。

- 点击“导出”按钮,保存为

注意事项

- 确保 Ollama 服务运行,否则 AI 功能不可用。

- 首次拉取模型可能需要时间,建议检查网络连接。

- 本地存储数据占用空间较大,定期清理历史记录。

- 若遇到问题,查看 GitHub 的

issues页面或提交反馈。

通过以上步骤,用户可以轻松安装并使用 kun-lab 的各项功能。无论是对话、文档解析还是图片分析,操作都直观便捷。

应用场景

- 个人学习助手

学生可以用 kun-lab 解析课件或教材,提问疑点,AI 会详细解答。上传数学讲义,AI 可一步步解释公式。 - 开发者工具

程序员可以用 kun-lab 调试代码或学习新语言。输入代码片段,AI 提供优化建议,并高亮展示。 - 文档整理

职场人士可以用文档解析功能快速总结报告。上传长篇 PPT,AI 提取关键点,生成简洁笔记。 - 创意探索

创作者可以用提示词模板生成故事或设计灵感。上传草图,AI 分析并提出改进建议。

QA

- kun-lab 需要联网吗?

核心功能本地运行,无需联网。联网搜索功能可选,需手动开启。 - 支持哪些文档格式?

支持 PDF、DOC、PPT、TXT 文件,未来可能扩展更多格式。 - 如何添加新模型?

在“模型库”页面输入ollama run命令,拉取 Ollama 或 Hugging Face 模型。 - 数据安全吗?

所有数据存储在本地,不上传云端,确保隐私安全。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...