综合介绍

KTransformers:专为突破大模型推理瓶颈而生的高性能 Python 框架。 它不仅仅是一个简单的模型运行工具,更是一套 极致的性能优化引擎 和 灵活的接口赋能平台。 KTransformers 致力于从底层提升大模型推理效率,通过先进的内核优化、强大的并行策略 (多GPU、稀疏注意力) 等核心技术,显著加速模型推理速度,降低硬件门槛。

超越简单的模型运行,KTransformers 提供的是全方位的性能提升和应用拓展能力。 用户不仅可以获得媲美原生 Transformers 的兼容接口,无缝迁移现有项目,更能轻松构建符合 OpenAI 和 Ollama 标准的 RESTful API 服务,快速集成到各类应用中。 同时,我们还提供了开箱即用的 ChatGPT 风格网页界面,方便用户快速体验和测试模型效果,无需繁琐配置。

KTransformers 专为对性能有更高要求的用户设计。 无论你是追求极致推理速度的开发者,需要高效部署大模型应用的工程师,还是希望在本地轻松体验高性能大模型的用户,KTransformers 都能为你提供强大的支持,助你充分释放大模型的潜能,驱动创新应用。

核心优势:

- 极致性能: 内核级优化和并行策略带来数量级的推理速度提升。

- 灵活接口: 提供 Transformers 兼容接口、RESTful API 和网页界面,满足不同应用场景需求。

- 广泛兼容: 支持多 GPU、多种 CPU 架构和多种主流大模型,适应多样化硬件和模型选择。

- 易用性与可定制性并存: 既有开箱即用的便捷性,又提供丰富的配置选项,满足高级用户的深度优化需求。

功能列表

- 高性能 Transformers 兼容接口 : 提供与 Transformers 库完全兼容的接口,零成本迁移现有项目,即刻享受性能提升。

- 灵活易用的 RESTful API 服务 : 遵循 OpenAI 和 Ollama 标准,快速构建可扩展的 API 服务,轻松集成到各种应用和平台。

- 开箱即用的 ChatGPT 风格网页界面 : 提供友好的交互式界面,零代码快速体验和测试模型性能,方便演示和验证。

- 多GPU 并行计算引擎 : 充分释放多 GPU 算力,线性提升推理速度,大幅缩短响应时间。

- 内核级深度性能优化 : 采用先进内核优化技术,从底层挖掘硬件潜力,实现模型推理性能的质的飞跃。

- 智能稀疏注意力框架 : 支持块稀疏注意力机制,大幅降低内存占用,并支持 CPU 高效解码,突破硬件瓶颈。

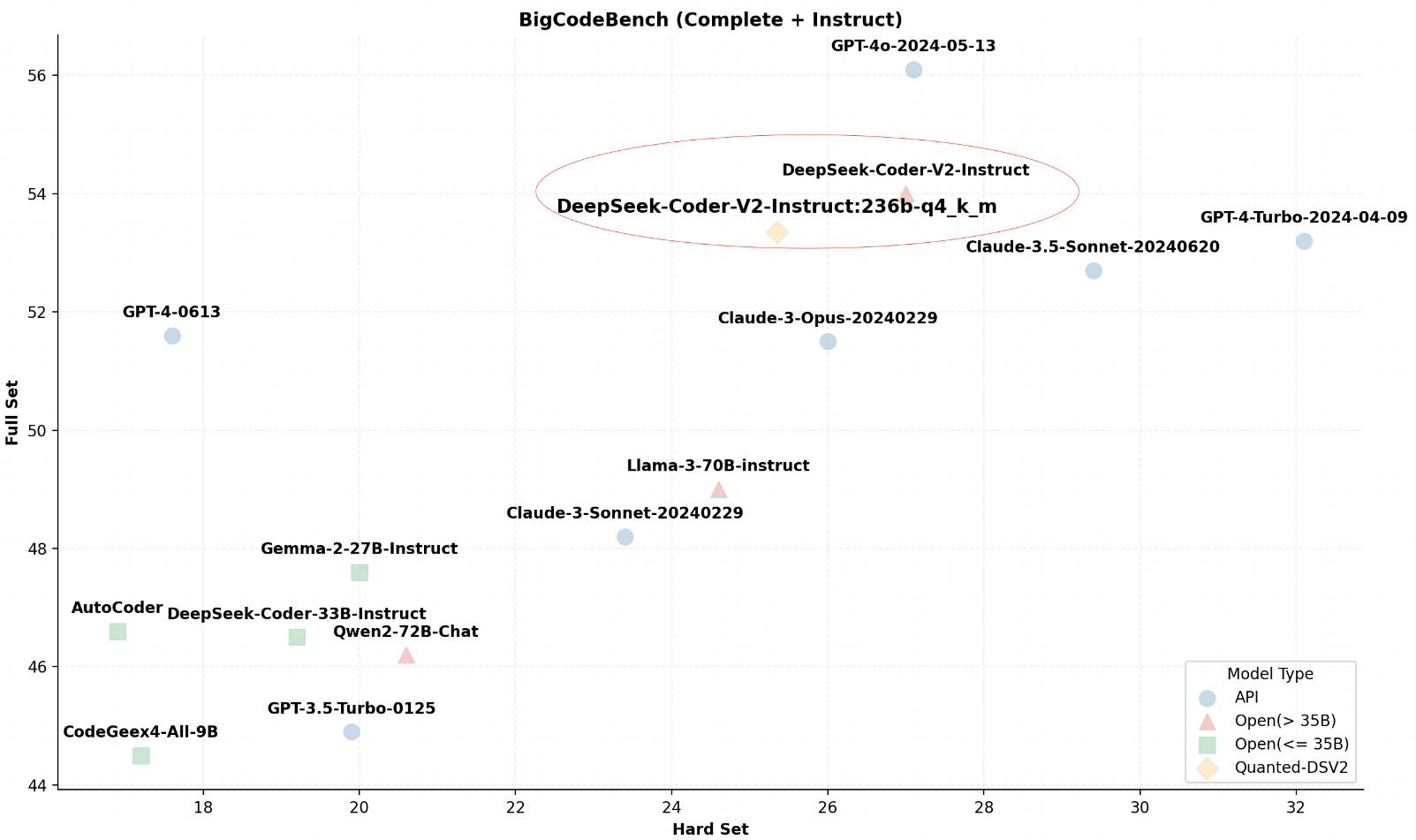

- 广泛的大模型生态支持 : 兼容 InternLM、DeepSeek-Coder 等多种主流大模型 (持续扩展中),灵活选择最佳模型方案。

- 轻量级本地高性能推理 : 无需昂贵专业硬件,在普通桌面环境即可实现卓越推理性能,降低使用门槛。

使用帮助

安装

- 克隆仓库 :

git clone https://github.com/kvcache-ai/ktransformers.git

cd ktransformers

- 安装依赖 :

pip install -r requirements-local_chat.txt

- 安装KTransformers :

python setup.py install

快速上手

- 加载模型 :

from ktransformers import KTransformers

model = KTransformers(model_name="your_model_name")

- 推理示例 :

input_text = "你好,KTransformers!"

output = model.infer(input_text)

print(output)

- 使用RESTful API : 启动API服务:

python -m ktransformers.api

发送请求:

curl -X POST "http://localhost:8000/infer" -d '{"text": "你好,KTransformers!"}'

高级功能

- 多GPU支持 :编辑项目根目录下的配置文件

config.yaml,指定多GPU设置,提升推理速度。 - 稀疏注意力 :在项目根目录下的配置文件

config.yaml中添加稀疏注意力配置,优化内存使用,尤其适用于资源受限的环境。 - 本地推理 :在项目根目录下的配置文件

config.yaml中指定内存和显存参数,在本地桌面环境下进行高效推理,支持24GB VRAM和150GB DRAM。

配置详解

- 配置多GPU : 编辑配置文件

config.yaml:

gpu:

- id: 0 # GPU 设备索引 0

- id: 1 # GPU 设备索引 1

- 启用稀疏注意力 : 在配置文件中添加:

attention:

type: sparse

- 本地推理设置 : 在配置文件中指定内存和显存参数:

memory:

vram: 24GB # 显存限制 (GB),根据实际情况调整

dram: 150GB # 内存限制 (GB),根据实际情况调整© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...