Java에서 올라마 API 사용

이 문서에서는 Ollama 이 문서는 개발자가 Ollama의 기능을 빠르게 익히고 최대한 활용할 수 있도록 돕기 위해 작성되었습니다. 애플리케이션 내에서 직접 Ollama API를 호출하거나 Spring AI 컴포넌트에서 Ollama를 호출할 수 있으며, 이 문서를 학습하면 프로젝트에 Ollama를 쉽게 통합할 수 있습니다.

I. 환경 준비

Java에서 Ollama API를 사용하려면 다음 환경과 도구가 준비되어 있는지 확인하세요:

- JDK(Java 개발 키트) JDK 버전 1.8 이상을 설치합니다.

- 구축 도구 프로젝트 종속성 관리를 위해 Maven이나 Gradle과 같은 도구를 사용하세요.

- HTTP 클라이언트 라이브러리 Apache HttpClient 또는 OkHttp와 같은 적합한 HTTP 클라이언트 라이브러리를 선택합니다.

II. 올라마 직접 사용

github에는 애플리케이션에 Ollama를 쉽게 통합할 수 있는 타사에서 개발한 많은 컴포넌트가 있습니다. Asedem 예를 들어 다음 3단계를 따를 수 있습니다(여기서는 프로젝트 관리를 위해 maven을 사용함):

- pom.xml에 올라마 종속성 추가하기

<repositories>

<repository>

<id>jitpack.io</id>

<url>https://jitpack.io</url>

</repository>

</repositories>

<dependencies>

<dependency>

<groupId>com.github.Asedem</groupId>

<artifactId>OllamaJavaAPI</artifactId>

<version>master-SNAPSHOT</version>

</dependency>

</dependencies>

- 올라마 초기화하기

// 默认情况下,它将连接到 localhost:11434

Ollama ollama = Ollama.initDefault();

// 对于自定义值

Ollama ollama = Ollama.init("http://localhost", 11434);

- 올라마 사용

- 대화

String model = "llama2:latest"; // 指定模型

String prompt = "为什么天空是蓝色的?"; // 提供提示

GenerationResponse response = ollama.generate(new GenerationRequest(model, prompt));

// 打印生成的响应

System.out.println(response.response());

- 로컬 모델 나열

List<Model> models = ollama.listModels(); // 返回 Model 对象的列表

- 모델 정보 표시

ModelInfo modelInfo = ollama.showInfo("llama2:latest"); // 返回 ModelInfo 对象

- 복제 모델

boolean success = ollama.copy("llama2:latest", "llama2-backup"); // 如果复制过程成功返回 true

- 모델 삭제

boolean success = ollama.delete("llama2-backup"); // 如果删除成功返回 true

스프링 AI로 올라라마 호출하기

Spring AI 소개

Spring AI는 AI 엔지니어링을 위해 설계된 애플리케이션 프레임워크입니다. 핵심 기능은 다음과 같습니다:

- 여러 AI 서비스 제공업체에 걸친 API 지원: Spring AI는 여러 AI 서비스 제공업체의 채팅, 텍스트-이미지 변환 및 임베디드 모델과의 상호 작용을 지원하는 이식 가능한 API 세트를 제공합니다.

- 동기식 및 스트리밍 API 옵션: 프레임워크는 동기식 및 스트리밍 API를 지원하여 개발자에게 유연한 상호 작용 방법을 제공합니다.

- 모델별 기능 액세스: 개발자가 구성 매개변수를 통해 모델별 기능에 액세스하여 보다 세분화된 제어를 할 수 있습니다.

Spring AI 사용

- pom.xml에 Spring AI 종속성 추가하기

<dependencies>

<dependency>

<groupId>io.springboot.ai</groupId>

<artifactld>spring-ai-ollama-spring-boot-starter</artifactld>

<version>1.0.3</version>

</dependency>

</dependencies>

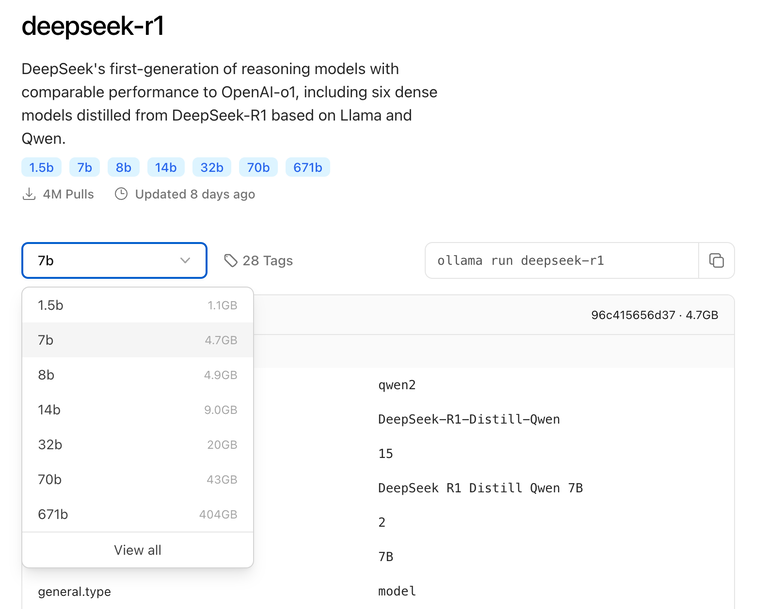

참고: IDEA를 사용하여 프로젝트를 만들 때 다음 그림과 같이 종속성을 직접 지정하면 시스템이 자동으로 pom.xml 파일을 완성하므로 수동으로 수정할 필요가 없습니다:

- Spring AI 및 Ollama에 대한 구성을 Spring Boot 애플리케이션의 구성 파일에 추가하세요. 예시:

ai:

ollama:

base-url: http://localhost:11434

chat:

options:

model: llama3.1:latest

- 텍스트 생성 또는 대화에 Ollama를 사용하세요:

먼저 Ollama API를 호출할 Spring Boot 컨트롤러를 생성합니다:

import jakarta.annotation.Resource;

import org.springframework.ai.chat.model.ChatResponse;

import org.springframework.ai.chat.prompt.Prompt;

import org.springframework.ai.ollama.OllamaChatModel;

import org.springframework.ai.ollama.api.OllamaOptions;

import org.springframework.web.bind.annotation.RequestMapping;

import org.springframework.web.bind.annotation.RequestParam;

import org.springframework.web.bind.annotation.RestController;

@RestController

public class OllamaController {

@Resource

private OllamaChatModel ollamaChatModel;

@RequestMapping(value = "/ai/ollama")

public Object ollama(@RequestParam(value = "msg")String msg){

ChatResponse chatResponse=ollamaChatModel.call(new Prompt(msg, OllamaOptions.create()

.withModel("llama3.1:latest")//指定使用哪个大模型

.withTemperature(0.5F)));

System.out.println(chatResponse.getResult().getOutput().getContent());

return chatResponse.getResult().getOutput().getContent();

}

}

그런 다음 프로젝트를 실행하고 브라우저에 URL을 입력합니다. http://localhost:8080/ai/ollama?msg="提示词" 결과는 아래와 같습니다:

참조 문서

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...