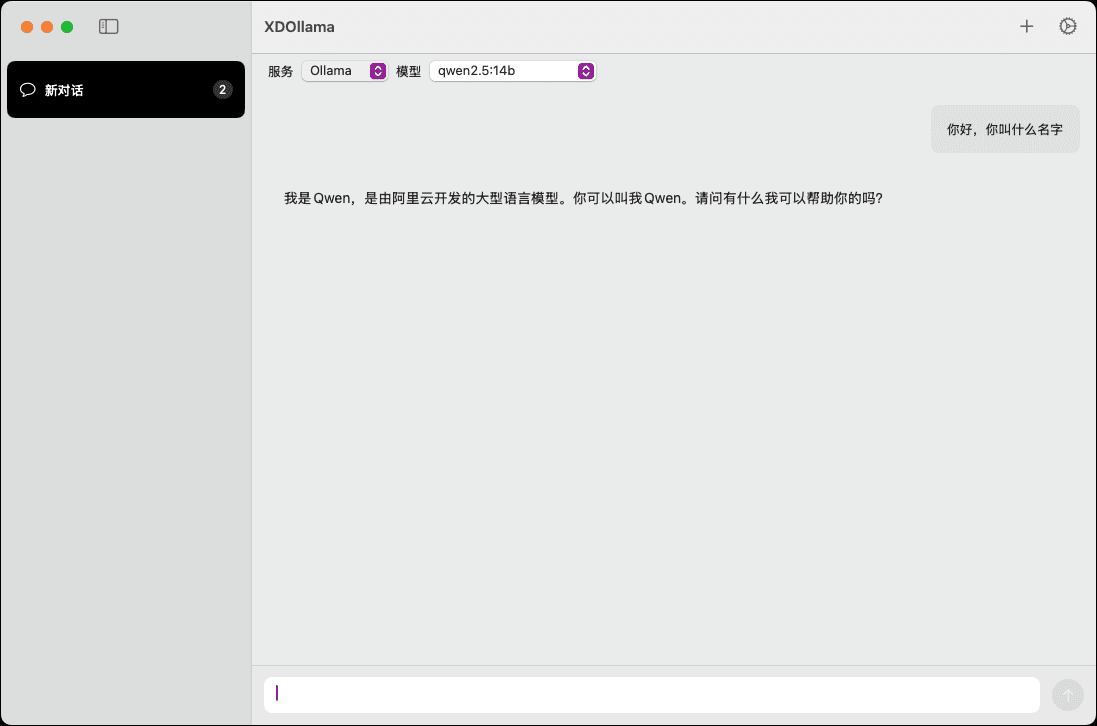

XDOllama: MacOS에서 Ollama\Dify\Xinference를 빠르게 호출할 수 있는 AI 모델 인터페이스입니다.

일반 소개

XDOllama는 MacOS 사용자를 위해 설계된 데스크톱 애플리케이션으로 Ollama, Dify 및 Xinference 이 애플리케이션을 통해 사용자는 간소화된 인터페이스와 조작 프로세스를 통해 로컬 또는 온라인 AI 모델을 쉽게 호출할 수 있습니다. 이 애플리케이션을 통해 사용자는 간소화된 인터페이스와 조작 프로세스를 통해 로컬 또는 온라인 AI 모델을 쉽게 호출할 수 있어 업무 효율성과 경험이 향상됩니다.

기능 목록

- 로컬 Ollama 모델링

- 온라인 올라마 모델 호출하기

- 로컬 Xinference 모델 호출

- 온라인 Xinference 모델 호출

- 로컬 Dify 어플라이언스

- 온라인 Dify 애플리케이션 호출

- 여러 AI 프레임워크 지원

- 사용하기 쉬운 인터페이스 디자인

- 효율적인 모델 호출 속도

도움말 사용

설치 프로세스

- DMG 파일을 다운로드합니다.

- 더블클릭하여 다운로드한 DMG 파일을 엽니다.

- XDOllama.app을 응용 프로그램 폴더로 드래그합니다.

- 설치가 완료되면 애플리케이션을 열면 바로 사용할 수 있습니다.

사용 가이드라인

- XD올라마 애플리케이션을 엽니다.

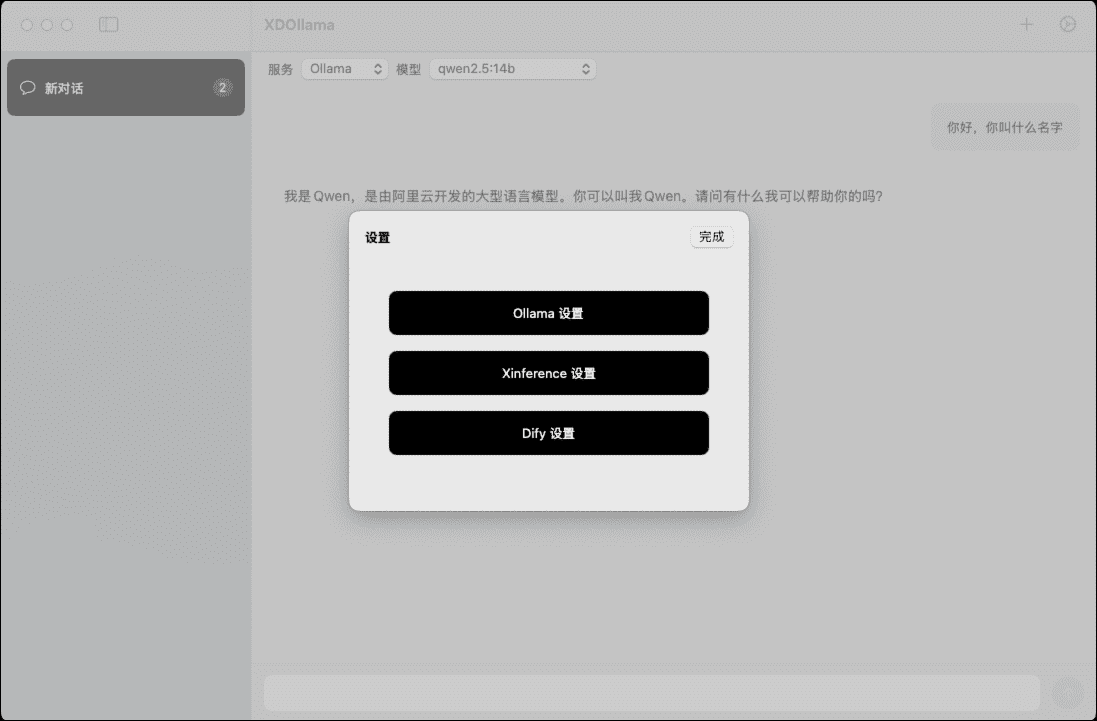

- 호출할 AI 모델(올라마, 디파이 또는 신퍼런스)을 선택합니다.

- 호출 방법(로컬 또는 온라인)을 선택합니다.

- 메시지에 따라 관련 매개변수와 설정을 입력합니다.

- '호출' 버튼을 클릭하고 모델이 로드되고 실행될 때까지 기다립니다.

- 모델 출력을 보고 사용합니다.

세부 기능 작동 흐름

로컬 올라마 모델 호출하기

- 메인 화면에서 '올라마'를 선택합니다.

- '로컬' 호출 방법을 선택합니다.

- 모델 경로와 매개변수를 입력합니다.

- '통화' 버튼을 클릭하고 모델이 로드될 때까지 기다립니다.

- 모델 출력을 확인합니다.

온라인 올라마 모델 호출하기

- 메인 화면에서 '올라마'를 선택합니다.

- '온라인' 호출 방법을 선택합니다.

- 온라인 모델의 URL과 매개 변수를 입력합니다.

- '통화' 버튼을 클릭하고 모델이 로드될 때까지 기다립니다.

- 모델 출력을 확인합니다.

로컬 Xinference 모델 호출

- 메인 화면에서 'Xinference'를 선택합니다.

- '로컬' 호출 방법을 선택합니다.

- 모델 경로와 매개변수를 입력합니다.

- '통화' 버튼을 클릭하고 모델이 로드될 때까지 기다립니다.

- 모델 출력을 확인합니다.

온라인 Xinference 모델 호출

- 메인 화면에서 'Xinference'를 선택합니다.

- '온라인' 호출 방법을 선택합니다.

- 온라인 모델의 URL과 매개 변수를 입력합니다.

- '통화' 버튼을 클릭하고 모델이 로드될 때까지 기다립니다.

- 모델 출력을 확인합니다.

로컬 Dify 애플리케이션 호출

- 메인 화면에서 'Dify'를 선택합니다.

- '로컬' 호출 방법을 선택합니다.

- 애플리케이션 경로와 매개변수를 입력합니다.

- '통화' 버튼을 클릭하고 애플리케이션이 로드될 때까지 기다립니다.

- 애플리케이션 출력을 확인합니다.

온라인 Dify 애플리케이션 호출

- 메인 화면에서 'Dify'를 선택합니다.

- '온라인' 호출 방법을 선택합니다.

- 온라인 신청서의 URL과 매개변수를 입력합니다.

- '통화' 버튼을 클릭하고 애플리케이션이 로드될 때까지 기다립니다.

- 애플리케이션 출력을 확인합니다.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...