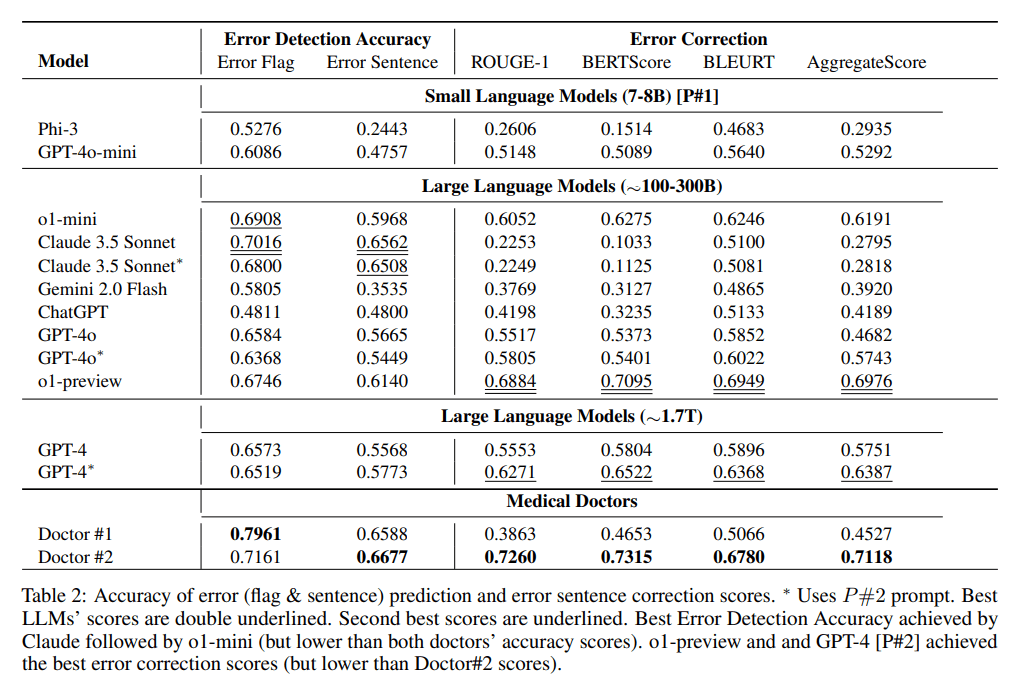

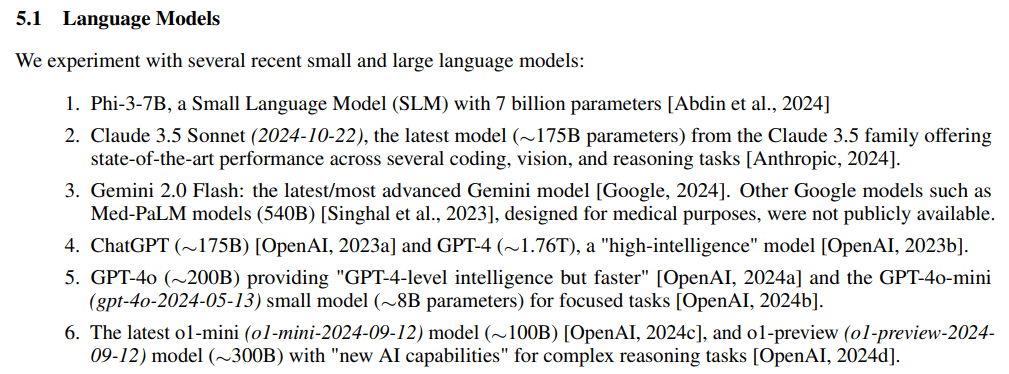

주류 클로즈 소스 LLM의 파라미터 크기에 대한 논의가 계속되고 있으며, 2024년 마지막 2일에 Microsoft에서 다음과 같은 기사를 발표했습니다.임상 노트에서 의료 오류 감지 및 수정추측실험참조 표준MEDEC 연구는 실수로 매개변수의 규모를 직접적으로 놓쳤습니다:o1-preview, GPT-4.GPT-4o 및클로드 3.5 소네트.

논문 주소: https://arxiv.org/pdf/2412.19260v1

실험의 실험 부분에서는 큰 모델 매개변수 스케일을 3개의 블록으로 나눕니다:7-8B, ~100-300B, ~1.7T그러나 (아닌)GPT-4o-mini첫 번째 슬롯에 8B만 배치된 것은 다소 믿기지 않습니다.

요약

- Claude 3.5 소네트(2024-10-22), ~175B

- ChatGPT, ~175B

- GPT-4, 약 1.76T

- GPT-4o, ~200B

- GPT-4o-mini(gpt-4o-2024-05-13) 전용 8B

- 최신 o1-mini(o1-mini-2024-09-12) 전용 100B

- O1-PREVIEW (O1-PREVIEW-2024-09-12) ~ 300B

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...