일반 소개

Together AI는 생성형 AI 모델에 중점을 둔 플랫폼으로, 모델 학습, 미세 조정, 추론에 이르는 모든 서비스를 제공합니다. 사용자는 Together AI의 고효율 추론 엔진과 GPU 클러스터를 활용하여 다양한 오픈 소스 모델을 빠르게 배포하고 실행할 수 있습니다. 이 플랫폼은 다양한 AI 애플리케이션 요구 사항을 충족하기 위해 여러 모델 아키텍처를 지원합니다.

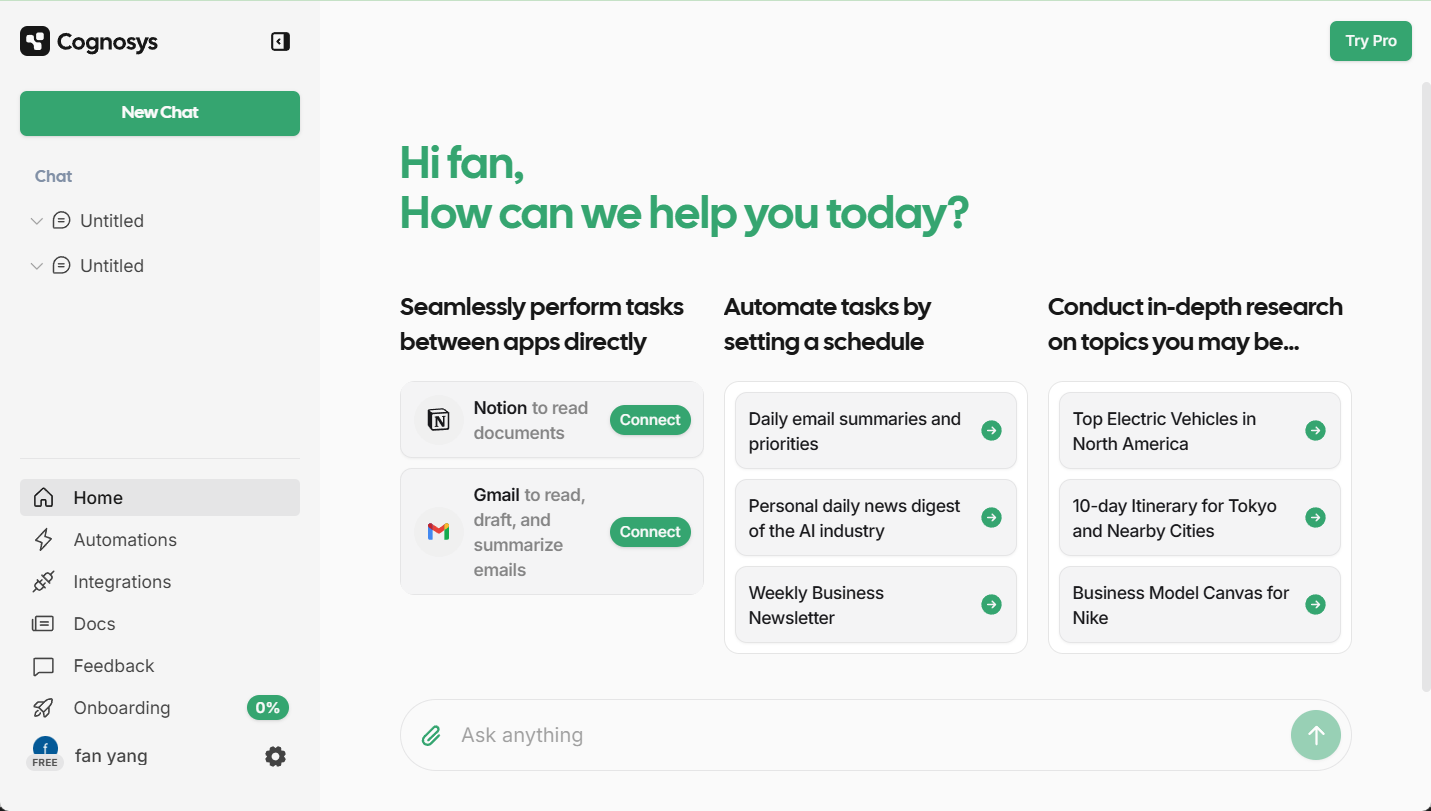

대형 모델 채팅 데모 인터페이스

기능 목록

- 추론 API100개 이상의 오픈 소스 모델에 대한 추론을 지원하며 서버리스 및 전용 인스턴스 모델을 모두 제공합니다.

- 미세 조정 기능데이터 소유권을 유지하면서 사용자가 자신의 데이터를 사용하여 생성 AI 모델을 미세 조정할 수 있습니다.

- GPU 클러스터대규모 모델 학습을 지원하기 위해 16~1000개 이상의 GPU로 구성된 최첨단 클러스터를 제공합니다.

- 맞춤형 모델 교육최첨단 모델을 처음부터 학습하고 여러 모델 아키텍처를 지원합니다.

- 멀티모달 모델이미지 인식, 이미지 추론, 이미지 생성 등을 지원합니다.

- 효율적인 추론 엔진플래시어텐션-3, 플래시 디코딩 등 최신 추론 기술을 통합하여 빠르고 정확한 추론 서비스를 제공합니다.

도움말 사용

설치 및 사용

- 등록 및 로그인::

- Together AI 웹사이트(https://www.together.ai/)를 방문하여 '구축 시작하기' 버튼을 클릭하여 등록하세요.

- 등록이 완료되면 계정에 로그인하고 사용자 제어판으로 이동합니다.

- 서비스 선택::

- 제어판에서 추론 API, 미세 조정 기능 또는 GPU 클러스터 등 사용해야 하는 서비스 모듈을 선택합니다.

- 필요에 따라 서버리스 또는 전용 인스턴스 모드를 선택합니다.

- 추론 API 사용::

- 실행해야 하는 오픈 소스 모델(예: Llama-3, RedPajama 등)을 선택합니다.

- Together AI에서 제공하는 API 인터페이스를 통해 모델을 애플리케이션에 통합하세요.

- Together AI의 임베디드 엔드포인트를 사용하여 나만의 RAG 애플리케이션을 구축하세요.

- 미세 조정 기능::

- 데이터 집합을 업로드하고 미세 조정이 필요한 모델을 선택합니다.

- 미세 조정 매개변수를 구성하여 미세 조정 프로세스를 시작합니다.

- 미세 조정이 완료되면 미세 조정된 모델을 다운로드하여 배포합니다.

- GPU 클러스터 사용량::

- 원하는 GPU 클러스터 크기를 선택하고 하드웨어 매개변수를 구성합니다.

- 트레이닝 데이터와 모델 코드를 업로드하여 트레이닝을 시작합니다.

- 학습이 완료되면 추론 또는 추가 미세 조정을 위해 학습된 모델을 다운로드합니다.

- 맞춤형 모델 교육::

- 사용자 지정 모델 학습 모듈을 선택하여 모델 아키텍처 및 학습 매개변수를 구성합니다.

- 데이터 세트를 업로드하고 트레이닝 프로세스를 시작합니다.

- 교육이 완료되면 배포 및 추론을 위해 모델을 다운로드합니다.

워크플로

- 제어판 액세스하기로그인 후 제어판으로 이동하여 원하는 서비스 모듈을 선택합니다.

- 구성 매개변수필요에 따라 추론, 미세 조정 또는 학습 매개변수를 구성합니다.

- 데이터 업로드: 필요한 데이터 세트 또는 모델 코드를 업로드합니다.

- 임무 시작추론, 미세 조정 또는 교육 작업을 시작하고 작업 진행 상황을 실시간으로 모니터링합니다.

- 결과 다운로드작업이 완료되면 애플리케이션 통합을 위해 모델 또는 추론 결과를 다운로드합니다.

일반적인 문제

- 적합한 모델을 선택하는 방법은 무엇인가요?

- 텍스트 생성, 이미지 인식 등과 같은 애플리케이션 시나리오에 따라 적절한 오픈 소스 모델을 선택합니다.

- 미세 조정 중에 오류가 발생하면 어떻게 하나요?

- 데이터 세트 형식과 매개변수 구성을 확인하고 공식 문서를 참조하여 조정할 수 있습니다.

- GPU 클러스터 사용 중 성능이 저하되나요?

- 하드웨어 구성이 요구 사항을 충족하는지 확인하고 교육 매개변수를 조정하여 효율성을 개선하세요.

사용 가능한 모델

| 서버리스 엔드포인트 | 작성자 | 유형 | 가격(1M당) 토큰) | |

|---|---|---|---|---|

| 메타 라마 3.2 11B 비전 인스트럭트 터보 | ||||

| 메타 | 채팅 | $0.18 | ||

| 메타 라마 3.2 90B 비전 인스트럭트 터보 | ||||

| 메타 | 채팅 | $1.20 | ||

| Qwen2.5 7B 인스트럭트 터보 | ||||

| Qwen | 채팅 | $0.30 | ||

| Qwen2.5 72B 인스트럭트 터보 | ||||

| Qwen | 채팅 | $1.20 | ||

| FLUX.1 [빠른] | ||||

| 블랙 포레스트 랩 | 이미지 | 가격 보기 | ||

| FLUX 1.1 [프로] | ||||

| 블랙 포레스트 랩 | 이미지 | 가격 보기 | ||

| FLUX.1 [프로] | ||||

| 블랙 포레스트 랩 | 이미지 | 가격 보기 | ||

| FLUX.1 [슈넬] 무료 | ||||

| 블랙 포레스트 랩 | 이미지 | 가격 보기 | ||

| 메타 라마 3.2 3B 인스트럭트 터보 | ||||

| 메타 | 채팅 | $0.06 | ||

| 메타 라마 비전 무료 | ||||

| 메타 | 채팅 | 무료 | ||

| 메타 라마 가드 3 11B 비전 터보 | ||||

| 메타 | 중재 | $0.18 | ||

| 메타 라마 3.1 8B 인스트럭트 터보 | ||||

| 메타 | 채팅 | $0.18 | ||

| Mixtral-8x22B Instruct v0.1 | ||||

| 미스트랄라이 | 채팅 | $1.20 | ||

| Stable Diffusion XL 1.0 | ||||

| 안정성 AI | 이미지 | 가격 보기 | ||

| 메타 라마 3.1 70B 인스트럭트 터보 | ||||

| 메타 | 채팅 | $0.88 | ||

| 메타 라마 3.1 405B 인스트럭트 터보 | ||||

| 메타 | 채팅 | $3.50 | ||

| 그리프 마이토맥스 L2 라이트(13B) | ||||

| Gryphe | 채팅 | $0.10 | ||

| Salesforce 라마 등급 V1(8B) | ||||

| 세일즈포스 | 재순위 | $0.10 | ||

| 메타 라마 가드 3 8B | ||||

| 메타 | 중재 | $0.20 | ||

| 메타 라마 3 70B 인스트럭트 터보 | ||||

| 메타 | 채팅 | $0.88 | ||

| 메타 라마 3 70B 인스트럭트 라이트 | ||||

| 메타 | 채팅 | $0.54 | ||

| 메타 라마 3 8B 인스트럭트 라이트 | ||||

| 메타 | 채팅 | $0.10 | ||

| 메타 라마 3 8B 인스트럭트 터보 | ||||

| 메타 | 채팅 | $0.18 | ||

| 메타 라마 3 70B 인스트럭트 참조 | ||||

| 메타 | 채팅 | $0.90 | ||

| 메타 라마 3 8B 인스트럭트 참조 | ||||

| 메타 | 채팅 | $0.20 | ||

| 큐원 2 인스트럭트(72B) | ||||

| Qwen | 채팅 | $0.90 | ||

| 젬마-2 인스트럭트(27B) | ||||

| Google 인터넷 회사 | 채팅 | $0.80 | ||

| 젬마-2 인스트럭트(9B) | ||||

| 구글 | 채팅 | $0.30 | ||

| 미스트랄 (7B) 인스트럭트 v0.3 | ||||

| 미스트랄라이 | 채팅 | $0.20 | ||

| Qwen 1.5 채팅(110B) | ||||

| Qwen | 채팅 | $1.80 | ||

| 메타 라마 가드 2 8B | ||||

| 메타 | 중재 | $0.20 | ||

| WizardLM-2(8x22B) | ||||

| 마이크로 소프트 | 채팅 | $1.20 | ||

| DBRX Instruct | ||||

| 데이터브릭 | 채팅 | $1.20 | ||

| DeepSeek LLM 채팅 (67B) | ||||

| DeepSeek | 채팅 | $0.90 | ||

| 젬마 인스트럭트(2B) | ||||

| Google 인터넷 회사 | 채팅 | $0.10 | ||

| 미스트랄(7B) 인스트럭트 v0.2 | ||||

| 미스트랄라이 | 채팅 | $0.20 | ||

| Mixtral-8x7B Instruct v0.1 | ||||

| 미스트랄라이 | 채팅 | $0.60 | ||

| Mixtral-8x7B v0.1 | ||||

| 미스트랄라이 | 언어 | $0.60 | ||

| Qwen 1.5 채팅(72B) | ||||

| Qwen | 채팅 | $0.90 | ||

| 라마 가드 (7B) | ||||

| 메타 | 중재 | $0.20 | ||

| 누스 에르메스 2 - 믹스트랄 8x7B-DPO | ||||

| NousResearch | 채팅 | $0.60 | ||

| 미스트랄(7B) 인스트럭트 | ||||

| 미스트랄라이 | 채팅 | $0.20 | ||

| 미스트랄 (7B) | ||||

| 미스트랄라이 | 언어 | $0.20 | ||

| LLaMA-2 채팅(13B) | ||||

| 메타 | 채팅 | $0.22 | ||

| LLaMA-2 채팅(7B) | ||||

| 메타 | 채팅 | $0.20 | ||

| LLaMA-2(70B) | ||||

| 메타 | 언어 | $0.90 | ||

| 코드 라마 인스트럭트(34B) | ||||

| 메타 | 채팅 | $0.78 | ||

| 업스테이지 SOLAR Instruct v1(11B) | ||||

| 업스테이지 | 채팅 | $0.30 | ||

| M2-BERT-Retrieval-32k | ||||

| 함께 | 임베딩 | $0.01 | ||

| M2-BERT-Retrieval-8k | ||||

| 함께 | 임베딩 | $0.01 | ||

| M2-BERT-Retrieval-2K | ||||

| 함께 | 임베딩 | $0.01 | ||

| UAE-Large-V1 | ||||

| WhereIsAI | 임베딩 | $0.02 | ||

| BAAI-Bge-Large-1p5 | ||||

| BAAI | 임베딩 | $0.02 | ||

| BAAI-Bge-Base-1p5 | ||||

| BAAI | 임베딩 | $0.01 | ||

| MythoMax-L2(13B) | ||||

| Gryphe | 채팅 | $0.30 |

사용 예

모델 추론의 예

import os

import requests

url = "https://api.together.xyz/v1/chat/completions"

payload = {

"model": "mistralai/Mixtral-8x7B-Instruct-v0.1",

"max_tokens": 512,

"temperature": 0.7,

"top_p": 0.7,

"top_k": 50,

"repetition_penalty": 1

}

headers = {

"accept": "application/json",

"content-type": "application/json",

"Authorization": "Bearer TOGETHER_API_KEY"

}

response = requests.post(url, json=payload, headers=headers)

print(response.text)

모델 미세 조정의 예

import os

import requests

url = "https://api.together.xyz/v1/fine-tune"

payload = {

"model": "togethercomputer/llama-2-70b-chat",

"data": "path/to/your/data",

"epochs": 3,

"batch_size": 8

}

headers = {

"accept": "application/json",

"content-type": "application/json",

"Authorization": "Bearer TOGETHER_API_KEY"

}

response = requests.post(url, json=payload, headers=headers)

print(response.text)© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...