초록

대규모 언어 모델(LLM)은 성능이 뛰어나지만 사실과 다른 정보를 생성하거나 착각하는 경향이 있습니다. 이러한 문제 때문에 LLM이 근거를 포함하는 콘텐츠를 생성하도록 유도하는 속성 텍스트 생성에 대한 연구가 활발히 진행되고 있습니다. 이 논문에서는 Think&Cite라는 새로운 프레임워크를 제안하고 통합 검색을 통해 속성 텍스트 생성을 다단계 추론 문제로 공식화합니다. 특히, LLM의 자기반성적 기능을 활용하여 MCTS의 중간 상태를 반영함으로써 트리 확장 과정을 안내하는 자기 가이드 몬테카를로 트리 검색(SG-MCTS)을 제안합니다. 신뢰할 수 있고 포괄적인 피드백을 제공하기 위해, 생성 및 속성 관점에서 루트 노드에서 현재 상태까지의 트리 검색 진행 상황을 측정하는 PRM(Progress Reward Model)을 도입했습니다. 세 가지 데이터 세트에 대해 광범위한 실험을 실시한 결과, 이 방법이 기준 방법보다 훨씬 뛰어난 성능을 보였습니다.

1 소개

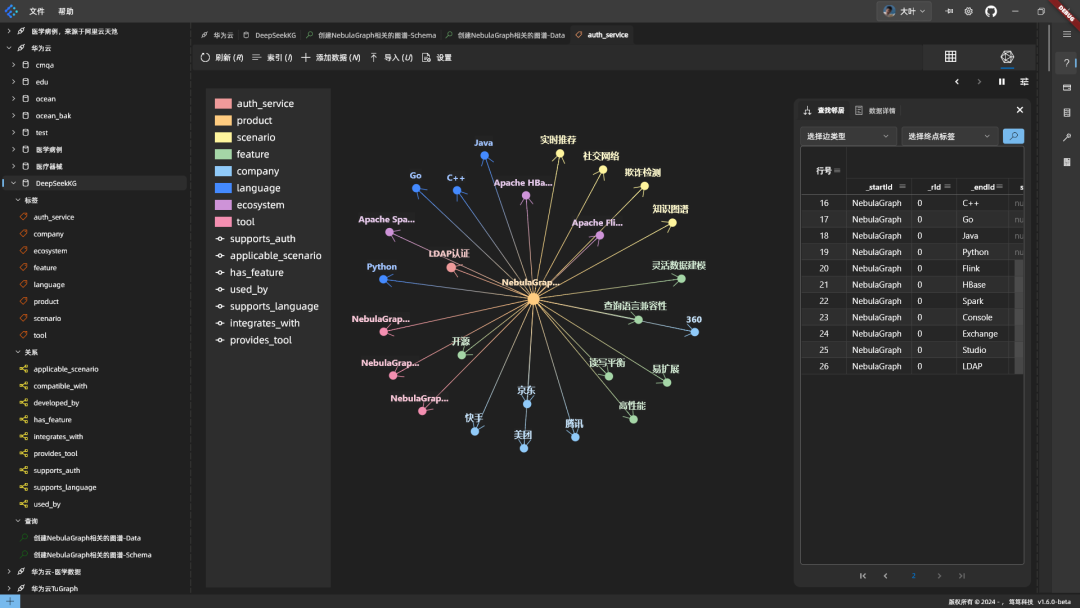

대규모 언어 모델(LLM)은 많은 자연어 처리 작업에서 우수한 성능을 발휘합니다(Zhao et al., 2023). 이러한 발전에도 불구하고 LLM은 종종 착각과 부정확한 정보를 포함하는 응답을 생성합니다(Ji et al., 2023; Huang et al., 2023; Zhang et al., 2023). 이러한 문제는 신뢰성을 떨어뜨리고, 더 중요한 것은 LLM에 대한 사용자의 신뢰를 떨어뜨립니다. LLM의 신뢰성을 개선하기 위해 그림 1과 같이 LLM이 텍스트 내 인용을 포함하는 응답을 생성하여 증거를 제공할 수 있도록 하는 차세대 패러다임인 속성 텍스트 생성이 제안되었습니다(Gao et al., 2023b).

그림 1: 질문이 주어지면 모델은 말뭉치의 구절을 근거로 인용하여 텍스트를 생성합니다.

대부분의 기존 연구(Slobodkin 외., 2024; Sun 외., 2024; Fierro 외., 2024)는 텍스트를 생성할 때 단순히 LLM에 인용을 제공하라는 메시지를 표시합니다. 또한, 주석이 달린 인용이 포함된 텍스트가 포함된 대량의 지도 학습 데이터에 대해 LLM을 미세 조정하려는 다른 연구(Li et al., 2024; Huang et al., 2024)도 있습니다. 이러한 최근의 노력에도 불구하고 신뢰할 수 있는 인용이 포함된 충실한 콘텐츠를 생성하는 방법을 학습하는 LLM의 개발은 여전히 미해결 과제로 남아 있습니다. 첫째, 기존 방식은 '시스템 1'로 특징 지을 수 있는 자동 회귀적 생성 패러다임을 사용하는데, 이는 빠르고 본능적인 사고 방식이지만 정확도가 충분하지 않습니다(Kahneman, 2011). 따라서 중간 생성 오류(예: 잘못된 표현이나 잘못된 인용)가 발생하면 최종 응답이 잘못될 수 있습니다. 복잡한 추론 연구(Zhang et al., 2024; Wang et al., 2024)에서 영감을 받아 보다 심도 있고 신중하며 논리적인 사고가 필요한 외부 증거 인용을 위한 '시스템 2' 패러다임의 모델을 개발하고자 했습니다(Kahneman, 2011). 둘째, 속성 텍스트 생성은 종종 긴 텍스트 생성을 수반합니다. liu 등(2023)은 기존 LLM에 대한 긴 응답에는 종종 지원되지 않는 진술과 부정확한 인용문이 포함되어 있음을 발견했습니다. 우리는 이전 연구에서 명시적인 생성 계획의 부족이 이러한 시스템의 발전을 저해했다고 주장합니다.

이 백서에서는 검색 알고리즘을 속성 텍스트 생성에 통합하기 위한 새로운 프레임워크인 Think&Cite를 소개합니다. 우리는 생성 작업을 반복적인 사고-표현-참조 패러다임을 통해 모델이 각 단계에서 문장을 생성하는 다단계 추론 문제로 개념화합니다. 이 생성 과정을 개선하기 위해 두 가지 혁신으로 기존 MCTS를 확장한 자기 가이드 몬테카를로 트리 검색(SG-MCTS)을 제안합니다. 첫째, 우리의 접근 방식은 LLM의 자기 반영 기능을 활용하여 실시간으로 MCTS의 중간 상태를 반영함으로써 트리 확장 프로세스를 안내하고 불충분한 추론 경로를 능동적으로 피합니다. 이는 최종 결과 또는 전체 궤적에 주로 반영하는 기존 연구와는 대조적입니다. 둘째, 루트 노드에서 현재 상태까지 트리 탐색의 진행 상황을 생성 및 속성 관점에서 측정하는 진행 보상 모델(PRM)을 제안합니다. 개별 단계만 평가하는 것과 달리, 진행률 기반 보상 모델은 신뢰할 수 있고 포괄적인 평가를 제공하여 MCTS 검색 프로세스를 안내합니다.

저희가 아는 한, 트리 검색 알고리즘을 속성 텍스트 생성 작업에 적용한 것은 이번이 처음입니다. 저희는 접근 방식의 효율성을 검증하기 위해 세 가지 데이터 세트에 대해 광범위한 실험을 실시했습니다. 그 결과, 우리 모델이 이전의 힌트나 미세 조정된 기준선보다 훨씬 뛰어난 성능을 발휘하는 것으로 나타났습니다.

2 관련 작업

어트리뷰션이 포함된 텍스트 생성. 어트리뷰션이 포함된 텍스트 생성에는 언어 생성 기능이 뛰어난 대규모 언어 모델(LLM)이 사용되어 왔습니다(Gao et al., 2023b; Huang et al., 2024; Sun et al., 2024; Li et al., 2024; Slobodkin et al., 2024). 어트리뷰션이 포함된 텍스트 생성용 LLM은 크게 두 가지로 분류할 수 있습니다. 생성된 저작물은 크게 두 가지 범주로 나눌 수 있습니다. 첫 번째 유형은 더 높은 보상을 얻기 위해 LLM이 지지적이고 관련성 있는 인용을 생성하도록 학습시키는 선호도 학습(Li et al., 2024)과 강화 학습(Huang et al., 2024)을 사용하여 LLM을 미세 조정하는 것입니다. 그러나 이 접근 방식은 주석이 달린 텍스트 내 인용으로 고품질 데이터 세트를 대조하기 위해 사람에게 의존합니다. 또 다른 종류의 작업은 어트리뷰션 후 생성 계획(Slobodkin 외, 2024)이나 외부 검증자를 사용하여 생성 안내(Sun 외, 2024)를 통해 어트리뷰션이 포함된 텍스트를 생성하도록 LLM에 직접 지시하는 것입니다. 그러나 이러한 접근 방식은 자동 회귀 방식으로 텍스트와 인용을 생성하기 때문에 부정확한 중간 생성은 후속 프로세스에서 실패하기 쉽습니다. 이와는 대조적으로, 우리의 접근 방식은 여러 경로를 고려하기 위해 점진적 보상이 있는 자기 가이드 트리 검색을 제안합니다.

트리 검색을 사용한 LLM: 트리 검색 알고리즘과 LLM의 통합은 상당한 주목을 받고 있습니다. 최근 연구에서는 추론 중 LLM의 성능을 향상시키기 위해 트리 검색 방법을 사용하는 방법을 조사했습니다(Zhang et al., 2024; Wang et al., 2024; Ye and Ng, 2024). Sutton(2019)은 다른 방법보다 학습 및 검색에서 스케일링의 우월성을 강조했습니다. 경험적 증거에 따르면 추론 시간 계산을 확장하면 추가 훈련 없이도 LLM 성능을 크게 향상시킬 수 있습니다(Brown et al., 2024; Snell et al., 2024).검색(Hart et al., 1968)과 몬테카를로 트리 검색(MCTS)(Browne et al., 2012)이 계획 기법으로 사용됩니다. 복잡한 추론 문제를 푸는 LLM의 성능을 향상시키기 위해 사용됩니다. 이러한 검색 알고리즘은 강화 학습(Silver et al., 2017)과 알파고와 같은 실제 응용 분야에서 널리 사용되어 왔습니다(Silver et al., 2016). 본 연구는 트리 검색 알고리즘(즉, 몬테카를로 트리 검색)을 최초로 적용하여 어트리뷰션이 있는 텍스트 생성 작업을 해결한 것입니다. 또한, 트리 확장을 개선하기 위해 LLM의 반사력에 의존하는 자가 가이드 MCTS를 제안합니다.

3 문제의 공식화

우리가 제안한 프레임워크는 사전 훈련된 LLM M을 허용하는 것을 목표로 합니다.θ 출력 콘텐츠의 증거가 되는 텍스트 내 인용을 사용하여 응답을 생성하는 것을 어트리뷰션이 포함된 텍스트 생성이라고 합니다(Slobodkin et al., 2024; Gao et al., 2023a).

공식적으로, 입력 문제 X와 텍스트 구절의 말뭉치 D가 주어지면, 모델 Mθ 응답을 생성해야 함 y = (y 1 , ... , y T ), 응답은 T 문장으로 구성되며, 각 문장은 yt C로 표시된 D의 단락 목록 참조t = {C t,1 , ... , C t,m } 더 많은 인용을 결합할 경우 얻을 수 있는 이점이 제한적이기 때문에(Gao et al., 2023b), 이 논문에서는 문장당 최대 3개의 인용을 허용하며(m ≤ 3), 인용은 [1][2] 등의 대괄호로 묶어 표시합니다. 또한 문제가 세계 지식과 관련되어 있고 LLM의 대부분의 문장이 여러 사실을 포함하고 증거로 인용을 뒷받침해야 하는 지식 집약적인 시나리오에 초점을 맞춥니다. 이전 연구(Gao 외., 2023b; Piktus 외., 2021)에 따라 말뭉치 D를 100단어 단락으로 나누어 검색하기 때문에 사람이 검증하기 쉽고 관련 없는 정보가 너무 많이 포함되지 않습니다.

반복적인 "생각-표현-인용" 패러다임을 통해 두 가지 혁신을 통해 기존 MCTS를 확장한 자기 가이드 몬테카를로 트리 검색(SG-MCTS)을 제안합니다. 이러한 생성 프로세스를 향상시키기 위해 두 가지 혁신을 통해 고전적인 MCTS를 확장한 자기 가이드 몬테카를로 트리 검색(SG-MCTS)을 제안합니다. 첫째, 우리의 접근 방식은 LLM의 자기 반영 기능을 활용하여 실시간으로 MCTS의 중간 상태를 반영함으로써 트리 확장 과정을 안내하고 부족한 추론 경로를 능동적으로 피할 수 있도록 합니다. 이는 최종 결과 또는 전체 궤적에 주로 반영하는 기존 연구와는 대조적입니다. 둘째, 루트 노드에서 현재 상태까지 트리 탐색의 진행 과정을 생성 진행과 어트리뷰션 진행이라는 두 가지 측면에서 측정하기 위해 진행 보상 모델(PRM)을 제안합니다. 진행률 기반 보상 모델은 개별 단계만 평가하는 것에 비해 신뢰성 있고 종합적인 평가를 제공하여 MCTS 검색 프로세스를 안내할 수 있습니다.

저희가 아는 한, 어트리뷰션이 포함된 텍스트 생성 작업에 트리 검색 알고리즘을 적용한 것은 이번이 처음입니다. 저희는 접근 방식의 효과를 검증하기 위해 세 가지 데이터 세트에 대해 광범위한 실험을 수행했습니다. 그 결과, 우리 모델이 이전의 단서 기반 및 미세 조정된 기준선보다 훨씬 뛰어난 성능을 발휘하는 것으로 나타났습니다.

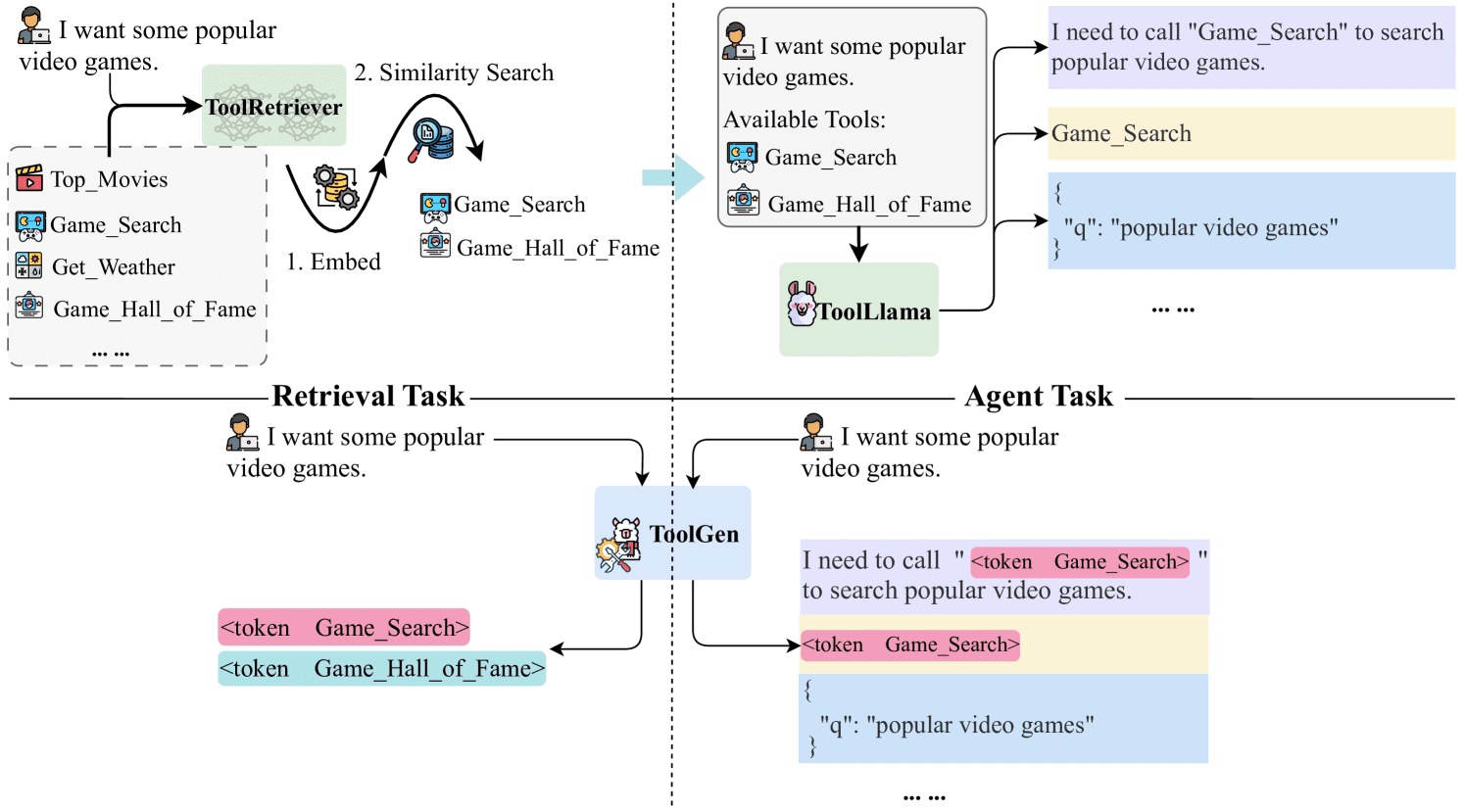

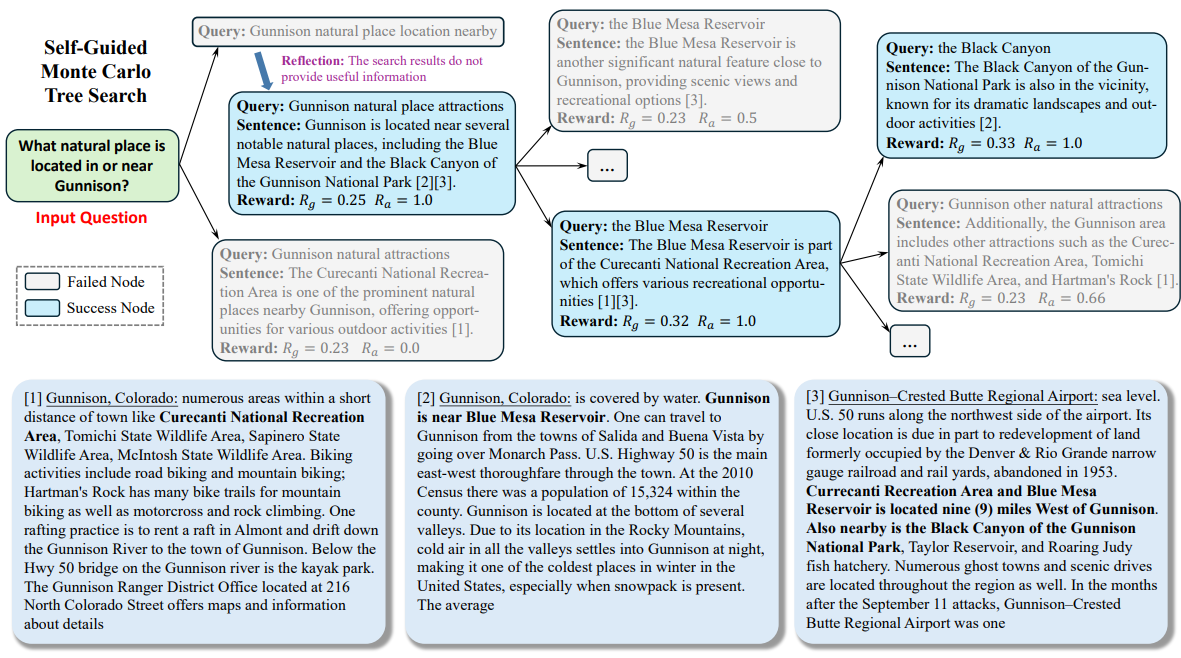

그림 2: 우리가 제안한 Think&Cite 접근 방식의 전체 프레임워크.

4 방법론

제안된 THINK&CITE 프레임워크는 여러 생성 경로를 계획하고 검색하기 위해 SG-MCTS(Self-Guided Monte Carlo Tree Search)를 사용하는 속성 텍스트 생성용 언어 에이전트와 검색 과정에 대한 점근적으로 세분화된 신호를 제공하기 위해 PRM(Progress Reward Modelling)을 기반으로 구축됩니다. 그림 2는 이러한 접근 방식의 전체 아키텍처를 보여줍니다.

4.1 속성 텍스트 생성 에이전트

이전 연구(야오 외, 2022; 첸 외, 2023)에서 영감을 받아 어트리뷰션이 포함된 텍스트 생성 작업을 해결하기 위한 언어 에이전트를 개발하여 LLM의 추론 및 계획 기능을 활용하는 반복적인 사고-언어화-인용 프로세스를 수행합니다.

반복적 사고-언어화-인용. 에이전트는 세 번째 문장을 생성하기 위해 먼저 검색 쿼리 q로 생성할 다음 청사진(예: 콘텐츠 주제 또는 초록)에 대해 능동적으로 사고합니다. t 그런 다음 에이전트는 검색 도구를 사용하여 검색 작업(즉, "검색: {쿼리}"와 같이)을 통해 주어진 말뭉치 D에서 가장 관련성이 높은 상위 K개의 단락 D를 검색합니다. 그런 다음 에이전트는 검색 도구를 사용하여 검색 작업(즉, "검색: {쿼리}"와 같이)을 통해 주어진 말뭉치 D에서 가장 관련성이 높은 상위 K개의 단락 D를 검색합니다. t . 검색된 구절을 기반으로 에이전트는 생성 작업(즉, "생성: {문장}"과 같은)을 통해 D의 텍스트를 참조합니다.t 단락 C 목록t 문장을 표현하려면 y t . 기록 쿼리, 검색된 단락, 생성된 문장 및 인용(H = {(q i , D i , y i , C i )}^t^ i=1 )는 다음 단계의 사고와 표현을 위한 컨텍스트로 사용됩니다. 에이전트가 작업을 해결했다고 판단하면 '종료'를 출력하여 프로세스를 종료할 수 있습니다. 이러한 방식으로 에이전트는 다양한 정보를 신중하게 계획하고 검색할 수 있으며, 정적인 참조 말뭉치에 의존했던 이전 작업과 달리 생성 과정이 진행됨에 따라 콘텐츠 초점의 변화를 동적으로 고려할 수 있습니다(Slobodkin et al., 2024; Huang et al. ..., 2024)와는 다릅니다. 또한 이 패러다임은 반복 검색 강화 생성에 대한 최근 연구(Jiang et al., 2023; Shao et al., 2023)와 유사하지만, 본 연구는 다음 세대를 위한 콘텐츠 청사진을 예측하여 관련 정보를 검색하고 생성된 텍스트의 적절한 위치에 병합하기 위해 적절한 참조를 신중하게 선택하는 모델을 요구한다는 점에서 다릅니다.

4.2 셀프 가이드 몬테카를로 트리 검색

우리는 어트리뷰션이 포함된 텍스트 생성을 다단계 추론 문제로 공식화하여 모델이 텍스트의 어트리뷰션에 대해 신중하게 고려합니다. 몬테카를로 트리 검색은 많은 의사 결정 작업에 효과적인 검색 알고리즘으로 자리 잡았습니다(Silver et al., 2016; Ye et al., 2021). 이 연구에서는 LLM의 자기반사 기능을 활용하여 MCTS의 검색 프로세스를 안내하는 자기 가이드 몬테카를로 트리 검색(SG-MCTS)을 제안합니다. 이전 연구(Shinn et al., 2023; Zhou et al., 2024; Yu et al., 2024)는 일반적으로 최종 결과 또는 전체 궤적을 반영하는데, 이는 비효율적이고 희박합니다. 이와는 대조적으로, 우리의 접근 방식은 실시간으로 트리 확장을 유도하고 잘못된 생성 경로를 적극적으로 무시하기 위해 MCTS의 중간 상태를 비판하고 반영하는 것을 목표로 합니다.

일반적으로 MCTS는 전략 모델 π를 기반으로 합니다.θ 일반적으로 LLM M인 검색 트리 T를 구축합니다. θ . 이 트리에서 노드 st = [q t , D t , y t , C t ] 는 검색 쿼리 q를 포함한 t번째 트리 레벨의 상태를 나타냅니다. t D t 표현식 y의 문장t 및 인용된 단락 C t . 루트 노드 s0 = [x]는 입력 문제를 나타냅니다. 각 반복에서 SG-MCTS는 선택, 반사 유도 확장, 평가 및 역전파의 네 단계를 따릅니다.

선택 단계. 선택 단계는 검색 트리 T에서 노드 s를 식별하는 것을 목표로 합니다.t 를 추가합니다. 트리에 적용된 상위 신뢰도 제약(UCT) 알고리즘(Kocsis and Szepesvári, 2006)은 UCT 점수가 가장 높은 최상의 노드를 선택하는 데 사용됩니다:

UCT(s) t ) = V(s) t ) + w √(ln N(p)/N(s)) t )) (1)

여기서 V(s t )는 평가 단계 s에서 추정됩니다.t 가치 함수(예상 보상), N(s) t )는 st 는 방문 횟수, w는 대조 탐색의 가중치, p는 st 를 부모 노드에 추가합니다.

반사 유도 확장 단계 . 확장 단계에서는 여러 후속 노드 s를 생성하여 t+1 선택된 노드는 생각-언어화-인용 프로세스에 의해 확장됩니다. t 생각 단계에서는 먼저 검색 쿼리 q̂로 청사진을 생성합니다. t+1 다음 문장의 제목과 내용을 추출하여 단락 D̂를 검색하는 데 사용합니다. t+1 . 그러나 전략 모델은 확장 단계에서 비특정적이거나 관련 없는 쿼리를 생성하여 후속 증거 검색을 방해하고 궁극적으로 잘못된 문장을 생성할 수 있는 등 잘못될 수 있습니다. 따라서 저희는 반사 단계, 여기서 전략 모델은 문제 X와 검색된 구절 D̂를 기반으로 합니다.t+1 반사적 문의 q̂t+1 를 클릭하여 오류를 식별합니다:

u = M θ (q̂ t+1 , D̂ t+1 , x), (2)

여기서 반영 텍스트 U에는 검색의 특정 측면에 대한 제안(예: 쿼리가 검색 주제에 더 초점을 맞춰야 한다는 제안)이 포함되어 있습니다. 전략 모델은 리플렉션을 기반으로 새 쿼리 q를 재구성합니다.t+1 를 클릭하여 관련 단락 D를 검색합니다. t+1 ::

q t+1 , Dt+1 = M θ (u, q̂ t+1 , D̂ t+1 , H), (3)

여기서 H는 기록 추적입니다. 위의 프로세스는 모델이 검색된 증거가 뒷받침된다고 판단하거나 최대 반복 횟수에 도달할 때까지 반복할 수 있습니다. 마지막으로, 언어화 및 인용 단계는 D에서 추출됩니다.t+1 다음 문장을 생성합니다. t+1 그리고 정확한 인용 C t+1 ::

y t+1 , Ct+1 = M θ (q t+1 , D t+1 , H). (4)

새 노드는 쿼리, 검색된 말뭉치, 생성된 문장 및 인용된 단락으로 구성되며, s로 표시됩니다.t+1 = [q t+1 , D t+1 , y t+1 , C t+1 ] 일반적인 MCTS의 단순 확장과 비교했을 때, 우리의 접근 방식은 결함이 있는 확장 노드를 개선하여 낮은 품질의 생성을 방지합니다. MCTS 트리는 점진적으로 구축되므로 다음 작업의 품질을 개선하면 모델이 넓은 검색 공간에서 더 유리한 경로를 탐색할 수 있으므로 트리의 전반적인 검색 품질이 향상됩니다.

평가 단계. 평가 단계는 진행 보상 모델(4.3절 참조)을 사용하여 새로운 확장 노드 s를 계산하는 것을 목표로 합니다.t+1 R(s)의 예상 보상 t+1 ). 진행률 평가에는 생성 및 어트리뷰션이라는 두 가지 측면이 포함됩니다. 진행률 인센티브 생성 Rg 지금까지 생성된 문장의 측정 y 1 , ... , yt+1 텍스트의 품질에 따라 달라집니다. 진행 보상 Ra 생성된 문장 평가하기 y 1 , ... , yt+1 및 인용된 단락 C 1 , ... , Ct+1 의 어트리뷰션 일관성을 고려합니다. 마지막으로, 총 보상은 이 둘의 합으로 계산됩니다. t+1 ) = R g + R a .

역전파 단계. 역전파 단계에서는 새 노드 st+1 R(s)에 대한 보상 t+1 )는 부모 노드 s로 다시 전파됩니다. t 루트 노드에서 부모 노드까지 경로의 각 노드를 업데이트합니다. 0 , s 1 , ... , st 값 함수의

N new (s i ) = N old (s i ) + 1, 0 ≤ i ≤ t (5)

V new (s i ) = (V old (s i )N old (s i ) + R(s t+1 )) / N new (s i ) (6)

여기서 N old (s i ) 및 V old (s i )는 노드 si 이전에 액세스한 카운트 및 값 함수의 값을 반환합니다.

4.3 진행 보상 모델

기존의 결과 보상 모델(Cobbe 외, 2021; Hosseini 외, 2024)과 프로세스 보상 모델(Lightman 외, 2024; Dai 외, 2024)은 최종 결과 또는 중간 단계를 평가하는 데 초점을 맞췄습니다. 이 연구에서는 다음 단계를 수행한 후 루트 s에서 측정 트리 검색을 제안합니다.0 상태로t+1 진행 상황. 어트리뷰션이 있는 텍스트에는 텍스트 콘텐츠와 그 인용이 포함되므로, 생성된 텍스트 콘텐츠의 품질과 인용의 관련성을 각각 평가하기 위해 생성 진행률 보상과 어트리뷰션 진행률 보상이라는 두 가지 측면의 진행률 보상을 설계했습니다.

4.3.1 진행률 인센티브 생성하기

직접 선호도 최적화(DPO)에서 마커 수준의 로그 비율은 다음과 같이 해석할 수 있습니다(Rafailov et al., 2023).

최대 엔트로피 강화 학습(RL) 공식 하에서 암시적 마커 수준의 보상을 제공합니다. 따라서 기존 DPO 정렬 모델을 활용하여 다음 문장 y의 생성을 측정할 것을 제안합니다.t+1 사후 생성된 문장 y1:t+1 = y 1 , ... , yt+1 R의 품질 점수 g .

구체적으로, 우리는 문장 수준의 마르코프 결정 과정(MDP)을 정의합니다.t = (x, y 1 , ... , y t )는 지금까지 생성된 입력과 문장을 나타내고 초기 상태 s0 = x는 입력 문제입니다. 액션 at = yt+1 는 다음 생성될 문장을 나타냅니다. 따라서 RLHF 최적화 목표는 문장 수준에서 최대 엔트로피 RL 문제로 다시 작성할 수 있습니다:

E 에서πθ(-|st)~ [∑^T^t=1 r'(s t , a t )] + βE s0x~ [H(π θ (-|s 0 ))],

여기서 문장 수준 보상 함수 r'은 다음과 같이 계산할 수 있습니다:

r'(s t , a t ) = { βlog π ref (a t |s t ), st+1 끝이 아닙니다.

{ r'(y|x) + βlog π ref (a t |s t ) 만약 s t+1 라인의 끝입니다.

최대 엔트로피 RL 공식은 최적의 값 함수 V와 Q 함수를 다음과 같이 도출합니다:

Q(s) t , a t ) = r'(s t , a t ) + V(s t+1 ),

V(s) t ) = 로그 ∑a exp(Q(s t , a)), t ≤ T 일 때 .

따라서 최적의 정책 π는 다음과 같이 도출됩니다:

⇒ βlog π(a t |s t ) = Q(s) t , a t ) - V(s t ),

⇒ βlog (π(a t |s t ) / π ref (a t |s t )) = V(s) t+1 ) - V(s t ).

이를 통해 DPO 전략을 사용하여 보상의 부분 합계를 도출하여 부분 응답을 공식화하도록 동기를 부여했습니다.1:t+1 진행률 인센티브 R g ::

∑^t^k=0 βlog (π(a k |s k ) / π ref (a k |s k )) = V(s) t+1 ) - V(s 0 ),

⇒ R g (y 1:t+1 ) = ∑^t^k=0 wk 로그 (π(y k+1 |x, y 1:k ) / π ref (y k+1 |x, y 1:k )),

여기서 y1:k y를 나타냅니다. 1 , ... , y k wk = 1 / (t+1)은 각 문장 수준의 로그 확률 비율의 가중치입니다.

4.3.2 속성 진행 보상

이전 연구(Gao et al., 2023b)에서 사용된 두 가지 인용 메트릭인 인용 회수율과 정확도를 사용하여 어트리뷰션 진행 보상 R을 표현합니다. a .

특히 인용 리콜은 부분적인 응답을 측정합니다.1:t+1 해당 인용 구절이 뒷받침할 수 있는 문장의 수입니다. 인용된 구절이 모델 응답을 도출할 수 있는지 확인하기 위해 NLI 모델(Honovich et al., 2022)을 사용했습니다. 각 문장에 대해i (1 ≤ i ≤ t + 1), 우리는 Ci 에 인용된 구절은 전제로서 결합되고 생성된 문장은 y입니다.i 를 NLI 모델의 가정으로 사용합니다. 전제에 가정이 포함된 경우 인용 회수율을 1로 설정하고 그렇지 않은 경우 0으로 설정합니다. 인용 정밀도는 해당 문장을 뒷받침하는 인용의 비율을 평가합니다. 위와 동일한 NLI 모델을 사용하여 정확도 점수를 계산합니다. 각 인용 c i,j 만약 (1) Ci y의 모든 인용에는 생성된 문장 y가 포함됩니다.i 및 (2) Ci \ {c i,j 문장에서 y를 빼고 }를 입력합니다. i 그렇지 않으면 정밀도 점수가 0으로 설정됩니다. 각 인용에 대해 정밀도 점수(0 또는 1)를 계산하고 모든 인용에 대해 평균을 냅니다. 마지막으로 F1 점수를 어트리뷰션 진행 보상 R로 계산합니다. a (y 1:t+1 , C 1 , ... , C t+1 )를 사용하여 생성된 문장과 인용된 구절 간에 균형 잡힌 어트리뷰션 품질 지표를 제공합니다.

5 실험

5.1 실험 설정

데이터 세트. 평가를 위해 (1) 다양한 측면을 다루기 위해 여러 개의 답변이 필요한 모호한 질문이 포함된 긴 형식의 QA 데이터 세트인 ASQA(Stelmakh et al., 2022), (2) 각 질문에 대한 답변이 여러 개로 구성된 사실적 QA 데이터 세트인 QAMPARI(Amouyal et al. 2022), 각 질문에 대한 답변이 서로 다른 구절에서 추출된 엔티티 목록인 사실적 QA 데이터세트, (3) ELI5(Fan et al., 2019), 어떻게/왜/무엇 질문을 포함하는 긴 형식의 QA 데이터세트. ASQA와 QAMPARI의 경우, 대부분의 질문은 Wikipedia를 통해 답을 찾을 수 있으므로 2018/12/20 Wikipedia 스냅샷을 코퍼스로 사용합니다. ELI5의 경우, 질문의 주제가 다양하기 때문에 Sphere(Piktus et al., 2021)(Common Crawl의 필터링된 버전)를 코퍼스로 사용합니다. Gao et al. (2023b)에 따라 Wikipedia와 Sphere에는 GTR(Ni et al., 2022)을 사용합니다. BM25 (Robertson et al., 2009)을 사용하여 각 질문에 대해 처음 100개의 구절을 코퍼스로 검색합니다. 자세한 내용은 부록 A를 참조하세요.

평가 지표. 저희는 원래 ALCE 벤치마크 테스트의 평가 지표를 사용합니다. 출력의 정확성을 평가하기 위해 ASQA의 정확히 일치(EM) 리콜, QAMPARI의 리콜-5, ELI5의 문장 리콜을 사용하여 출력에서 황금 정답(핵심 정보)의 비율을 측정합니다. 또한 생성된 답안에서 정답의 비율을 측정하기 위해 QAMPARI 데이터 세트에 대한 정확도 지표로 정밀도를 계산합니다. 산출물의 인용 품질을 평가하기 위해 산출물에서 인용한 구절에서 추론할 수 있는 문장의 비율을 측정하는 인용 회수율과 산출물 문장을 뒷받침할 수 있는 인용의 비율을 측정하는 인용 정밀도를 계산합니다.

기준선. 저희의 접근 방식은 다음을 기준으로 비교합니다. ChatGPT 및 GPT-40을 다음 기준선과 비교합니다:

바닐라 RAG 모델에 주어진 첫 5개의 문단을 기반으로 응답을 생성하고 그에 따라 인용하도록 직접 지시했습니다. 우리는 두 개의 프레젠테이션에 컨텍스트 학습을 사용합니다(Brown et al., 2020).

요약/스니펫 RAG는 전체 텍스트가 아닌 단락의 요약 또는 스니펫을 제공합니다. 모델은 처음 10개의 단락 요약 또는 스니펫을 기반으로 인용이 포함된 응답을 생성합니다.

Interact를 사용하면 모델이 요약/스니펫 RAG 메서드에서 특정 단락의 전체 텍스트에 추가로 액세스할 수 있습니다. 모델은 "확인: 문서 [1] [2]" 동작을 제시하여 해당 문서의 전체 텍스트를 가져올 수 있습니다.

인라인 검색을 사용하면 모델이 "검색: {쿼리}"라는 작업을 요청하여 상위 100개에서 가장 관련성이 높은 단락을 검색할 수 있습니다. 이 방법은 직접 비교를 수행한다는 점에서 우리와 유사합니다.

ReRank는 각 질문에 대해 4개의 답변을 무작위로 추첨하고 인용 회상 메트릭에 따라 가장 좋은 답변을 선택합니다.

위의 기준은 (Gao et al., 2023b)에 보고된 바와 같이 원래의 ALCE 벤치마크 테스트에 적용되어 평가되었습니다. 또한, 우리의 접근 방식을 어트리뷰션이 있는 텍스트 생성에 대한 이전 연구와 비교합니다.FG-Reward(Huang et al., 2024)는 세분화된 보상을 훈련 신호로 사용하여 LLaMA-2-7B(Touvron et al., 2023)를 미세 조정하여 귀속 가능한 응답을 생성할 것을 제안합니다.VTG(Sun et al., 2024)는 변화하는 메모리와 2계층 검증자를 사용하여 귀속 가능한 응답을 생성하고,VTG(Sun et al., 2024)는 변화하는 메모리와 2계층 검증자를 사용하여 귀속 가능한 반응을 생성할 것을 제안합니다. 2024)는 진화하는 메모리와 2계층 검증기를 사용하여 생성 모델(즉, text-davinci-003)을 안내하고, APO(Li et al., 2024)는 선호도 쌍 데이터 세트를 수집하고 어트리뷰션이 포함된 텍스트 생성을 위해 LLaMA-2-13B에 선호도 최적화를 적용했습니다.

구현 세부 사항. 저희는 접근 방식의 성능을 평가하기 위해 전략 모델로 LLaMA-3.1-8B-Instruct와 GPT-40을 사용합니다. 보상 모델의 경우, 생성적 진행률 보상을 계산하기 위해 DPO 모델인 Llama-3-8B-SFR-Iterative-DPO-R¹을 사용하고, 귀인적 진행률 보상을 계산하기 위해 NLI 모델인 T5-XXL-TRUE-NLI-Mixture(Honovich et al., 2022)를 사용합니다. 각 검색 쿼리에 대해, 말뭉치에서 상위 3개 구절을 후보 참조 D로 검색합니다. t . UCT 알고리즘(방정식 1)에서 가중치 w는 0.2로 설정됩니다. SG-MCTS의 경우 각 부모 노드에 대해 3개의 하위 노드를 확장하고 최대 트리 레벨을 6으로, MCTS의 최대 반복 횟수를 30으로 설정합니다.

5.2 주요 결과

표 1은 세 가지 데이터 세트에 대한 방법과 기준선의 결과를 보여줍니다.

첫째, 요약이나 스니펫을 사용하면 정확도를 향상시킬 수 있지만 세 가지 검색 증강 생성(RAG) 방법은 중간 정도의 성능을 보이는 것을 관찰할 수 있습니다. 그러나 이러한 개선은 단락 정보가 고도로 압축되기 때문에 인용 품질에 대한 대가가 따르며, ReRank는 세 데이터 세트에서 인용 품질을 일관되게 개선합니다(예: 바닐라 RAG는 ASQA에서 73.61 TP3T에서 84.81 TP3T로 인용 회수율을 향상시킴). 직접 비교하자면, 인라인 검색은 우리의 접근 방식과 비슷하지만 다른 큐 기준선에 비해 성능이 더 나쁩니다. 이는 증거 품질과 관련성을 고려하지 않고 단순히 검색 쿼리를 요청하기 때문입니다.

둘째, 주석이 달린 인용이 있는 지도 학습 데이터에 대한 LLM을 미세 조정함으로써 FG-Reward와 APO는 ASQA 및 ELI5 데이터 세트에서 인용 품질이 향상되었지만 QAMPARI에서는 성능이 향상되지 않았습니다. 또한 VTG는 생성적 검증자와 인메모리 검증자를 사용하여 증거의 논리적 지원을 평가함으로써 강력한 인용 품질(예: ASQA에서 86.71 TP3T의 인용 리콜)을 이끌어 냈습니다. 그러나 미세 조정된 LLM은 지도 학습 데이터의 품질과 양에 의해 제한되며, 근거를 뒷받침하는 증거를 올바른 출처에 연결하는 데 상당한 비용이 필요합니다. 또한 이러한 방법은 여전히 자동 회귀 생성에 의존하는데, 이는 빠르지만 정확도가 떨어지는 사고 방식입니다. 따라서 중간 생성 오류(예: 허위 진술 또는 부적절한 인용)가 발생하면 최종 응답에 문제가 발생할 수 있습니다.

| ASQA | QAMPARI | ELI5 | |

|---|---|---|---|

| 정확성 | 인용 | 정확성 | 인용 |

| EM Rec. | Rec. | Prec. | 리콜-5 |

| ChatGPT | |||

| 바닐라 래그 | 40.4 | 73.6 | 72.5 |

| ReRank 사용 | 40.2 | 84.8 | 81.6 |

| 요약 RAG | 43.3 | 68.9 | 61.8 |

| 인터랙트와 함께 | 39.1 | 73.4 | 66.5 |

| 스니펫 RAG | 41.4 | 65.3 | 57.4 |

| 인터랙트 | 41.2 | 64.5 | 57.7 |

| 인라인 검색 | 32.4 | 58.3 | 58.2 |

| GPT-40 | |||

| 바닐라 래그 | 41.3 | 68.5 | 75.6 |

| ReRank 사용 | 42.1 | 83.4 | 82.3 |

| 요약 RAG | 46.5 | 70.2 | 67.2 |

| 인터랙트와 함께 | 48.1 | 73.1 | 72.8 |

| 스니펫 RAG | 45.1 | 68.9 | 66.5 |

| 인터랙트 | 45.2 | 67.8 | 66.7 |

| 인라인 검색 | 40.3 | 65.7 | 66.9 |

| FG-보상 | 40.1 | 77.8 | 76.3 |

| VTG | 41.5 | 86.7 | 80.0 |

| APO | 40.5 | 72.8 | 69.6 |

| 우리(LLaMA) | 45.2 | 82.3 | 80.6 |

| 우리(GPT-40) | 50.1 | 89.5 | 87.1 |

표 1: 세 가지 데이터 세트에 대한 속성 텍스트 생성의 평가 결과. "Rec." 및 "Prec."는 정확도와 정확도의 약어입니다. 굵은 글꼴과 밑줄이 그어진 글꼴은 각각 각 데이터 세트에서 가장 좋은 결과와 두 번째로 좋은 결과를 나타냅니다.

마지막으로, 우리의 접근 방식은 세 가지 데이터 세트 모두에서 이전의 모든 접근 방식을 크게 능가합니다. Think&Cite는 속성 텍스트 생성 작업을 다단계 추론 문제로 공식화하고 최상의 솔루션을 찾기 위해 느리고 신중한 반영 모드를 도입합니다. Think&Cite는 자체 가이드 MCTS 알고리즘을 제안함으로써 LLM의 자기 반영 기능을 활용하여 트리 확장 프로세스를 안내합니다. 또한 제안된 진행 보상 모델은 모델이 더 나은 답변을 탐색할 수 있도록 포괄적이고 신뢰할 수 있는 피드백을 제공할 수 있습니다.

5.3 추가 분석

다른 데이터 세트에서도 비슷한 결과를 얻었으므로 GPT-40을 사용하여 ASQA에 대한 추가 분석 결과를 보고합니다.

삭제 연구. 제안한 프레임워크의 효과를 검증하기 위해 제거를 위한 주요 설계 요소를 분석했습니다. (1) SG-MCTS를 없애고 단계별로 직접 답을 생성하는 경우, (2) 반영 단계를 없애고 바닐라 MCTS 알고리즘을 사용하는 경우, (3) GP 보상을 없애고 진행 보상 R을 생성할 필요가 없는 경우 등 네 가지 변형을 설계했습니다. g (4) AP 보상 없음 획득 진행 보상 제거 R a 결과는 표 2에 나와 있습니다. 결과는 표 2에 나와 있습니다. 모든 변형 방식이 원래 방식보다 성능이 저하되어 각 구성 요소의 효율성을 나타냅니다. 특히 SG-MCTS를 사용하지 않은 경우의 성능이 현저히 떨어지며, 이는 어트리뷰션과 함께 검색 알고리즘을 텍스트 생성에 통합하는 것이 매우 유용하다는 것을 시사합니다. 바닐라 MCTS(반영 없음)를 사용하면 검색된 결과를 반영하지 않고 잘못된 참조를 도입하기 때문에 인용 품질이 더 나빠집니다. 마찬가지로, GP 리워드가 없는 경우와 AP 리워드가 없는 경우 모두 성능이 저하되므로 생성 및 인용 품질 검사가 모두 필수적임을 시사합니다.

| 방법 | 정확성 | 인용 |

|---|---|---|

| EM Rec. | Rec. | Prec. |

| Think&Cite | 50.1 | 89.5 |

| w/oSG-MCTS | 42.1 | 78.2 |

| 반사 없음 | 46.5 | 83.6 |

| GPReward 포함 | 47.1 | 86.2 |

| w/oAPReward | 46.7 | 81.3 |

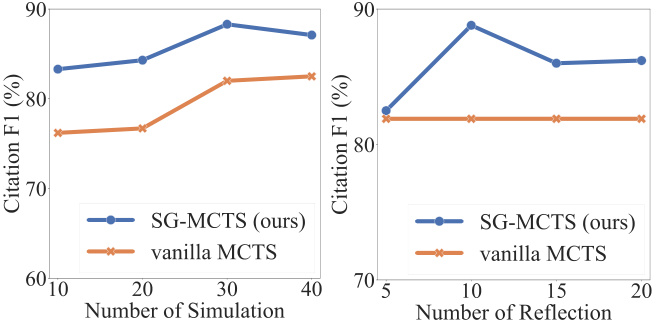

자기 성찰과 시뮬레이션. 각 시뮬레이션에서 SG-MCTS는 네 가지 주요 단계를 따르며, 오류 쿼리를 비판하고 개선함으로써 확장의 중간 상태의 품질을 개선하기 위해 자체 반영을 사용합니다. 반영의 효과를 확인하기 위해 최대 시뮬레이션 횟수를 늘렸을 때와 최대 반영 연산 횟수를 늘렸을 때의 성능을 비교했습니다. 먼저 최대 시뮬레이션 수를 {10, 20, 30, 40}으로 변경하고 최대 반영 횟수를 10으로 고정했습니다. 마찬가지로 최대 반영 횟수를 {5, 10, 15, 20}으로 변경하고 최대 시뮬레이션 수를 30으로 고정했습니다. 그림 3에 인용 회수율과 정밀도에 따른 F1 점수를 표시했습니다. 이 그림은 시뮬레이션 횟수와 반영 횟수를 모두 늘리면 어트리뷰션을 통한 텍스트 생성의 성능이 향상됨을 보여줍니다. 이는 더 광범위한 탐색이 올바른 생성을 찾을 확률을 높이기 때문에 예상되는 결과입니다. 그러나 더 많은 반사 단계는 모델을 "과도하게 생각"하여 노이즈를 유발하고 성능 저하로 이어질 수 있으며, 부모 노드에서 잘못된 검색이 발생하여 확장된 자식 노드의 추론 프로세스가 잘못된 경로를 따라 계속될 수 있기 때문에 SG-MCTS는 반사 없이 바닐라 MCTS보다 성능이 저하될 수 있습니다. 리플렉션 단계는 불충분한 쿼리로 인한 잘못된 검색을 개선하여 후속 탐색이 보다 정확하게 진행될 수 있도록 합니다.

그림 3: 시뮬레이션 횟수(왼쪽) 또는 반사 단계 수(오른쪽)에 대한 ASQA 결과.

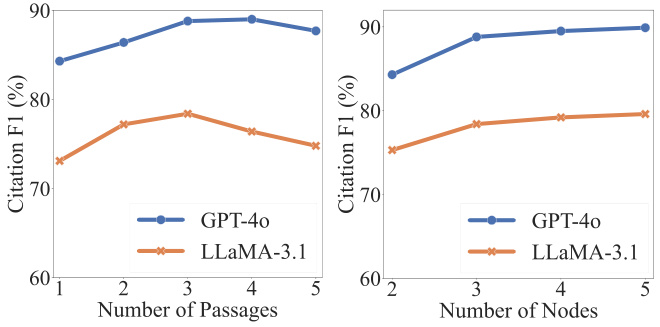

하이퍼파라미터 분석. 정확성과 인용 품질에 중요한 두 가지 하이퍼파라미터는 각 쿼리 qt 검색된 단락 수 | D t | 및 트리 검색의 확장 자식 노드 st+1 검색된 단락 수입니다. 그림 4에서 볼 수 있듯이, 처음에는 검색되는 단락 수를 늘리면 인용의 품질을 향상시킬 수 있습니다. 그러나 특정 임계값 이상으로 증가하면 성능이 저하되는데, 이는 주로 더 많은 문단을 병합하면 생성된 콘텐츠의 신뢰성에 부정적인 영향을 미치는 노이즈가 발생하기 때문입니다. 반면에 확장된 노드 수를 늘리면 나중에 안정화되기는 하지만 지속적으로 개선되는 것을 관찰할 수 있습니다. 노드를 더 많이 확장하면 계산 비용이 증가하므로 각 부모 노드에 대해 3개의 자식을 추출합니다.

그림 4: 단락 수(왼쪽) 또는 확장 노드 수(오른쪽)에 대한 ASQA 결과.

5.4 사례 연구

저희 방법의 전체 워크플로우에 대한 이해를 돕기 위해 ASQA에서 정성적 분석을 수행했습니다. 부록 C에 그 예가 나와 있습니다. 검색 프로세스 전반에 걸쳐 LLM은 입력 문제를 루트 노드로 취급하고 검색 트리를 점차적으로 확장하여 종료 상태에 도달합니다. 그림과 같이 모델은 먼저 구절을 검색하기 위해 쿼리(예: "인근 거니슨 자연 명소의 위치")를 생성합니다. 구절에 질문에 답하는 데 필요한 유효한 정보가 포함되어 있지 않으므로 모델은 이를 반영하여 검색을 위한 새로운 쿼리(예: "거니슨 자연 명소 위치")를 제안합니다. 검색된 단락을 기반으로 모델은 문장을 생성하고 두 번째 및 세 번째 단락을 참조합니다(예: "[2][3]"). 다단계 생성 프로세스에 따라 모델은 주제에 대해 깊이 생각하고 정확한 인용이 포함된 신뢰할 수 있는 콘텐츠를 출력할 수 있습니다.

6 결론

이 연구에서는 트리 검색이 통합된 속성 텍스트 생성을 위한 새로운 프레임워크인 Think&Cite를 소개합니다. Think&Cite는 반복적인 생각-표현-인용 생성 패러다임에 기반합니다. 생성 프로세스를 개선하기 위해 LLM의 자기 반영 기능을 활용하여 트리 확장을 유도하기 위해 MCTS의 중간 상태를 비판하고 수정하는 자기 가이드 몬테카를로 트리 검색을 제안합니다. 또한 트리 탐색의 진행 상황을 측정하고 신뢰할 수 있는 피드백을 제공하기 위해 진행 보상 모델을 제안합니다. 세 가지 데이터 세트에 대한 광범위한 실험을 통해 우리가 제안한 Think&Cite가 기존의 힌트 및 미세 조정 방법보다 성능이 뛰어나다는 것을 보여줍니다.

제한 사항

실험의 범위는 트리 기반 검색 방법의 상당한 계산 비용으로 인해 제한되었습니다. 향후 연구에서는 더 넓은 범위의 속성 텍스트 생성 데이터 세트를 탐색할 수 있습니다. 본 모델에서는 몬테카를로 트리 검색이 자동 생성에 사용됩니다. 향후 연구에서는 제안된 프레임워크의 일반성과 견고성을 평가하기 위해 추가적인 검색 알고리즘을 탐색할 수 있습니다.

부록

데이터 집합

세 가지 데이터 세트로 구성된 ALCE 벤치마크에서 우리의 접근 방식을 평가합니다. 구체적으로 ASQA 데이터셋(Stelmakh 외., 2022)에는 948개의 질문과 Wikipedia에서 찾을 수 있는 답변이 포함되어 있고, QAMPARI 데이터셋(Amouyal 외., 2022)에는 Wikipedia에 기반한 1,000개의 질문이 포함되어 있으며, ELI5 데이터셋(Fan 외., 2019)에는 1,000개의 질문과 답변이 포함되어 있습니다. 질문이 포함되어 있으며, 그 답변은 Sphere(Piktus et al., 2021)에서 찾을 수 있습니다. 이 세 가지 데이터 세트에 대한 자세한 내용은 표 3에 나와 있습니다.

| 데이터 집합 | 코퍼스(# 구절) | 문제 유형 |

|---|---|---|

| ASQA | 위키피디아(2100만) | 사실 |

| QAMPARI | 위키피디아(2100만) | 사실(표) |

| ELI5 | 구체 (899 백만) | 이유/방법/내용 |

B 팁

샘플이 적은 학습 방식으로 속성 텍스트를 생성하기 위해 셀프 가이드 트리 검색을 수행하도록 LLM에 지시했습니다. ASQA, QAMPARI 및 ELI5 데이터 세트의 문맥 학습 단서는 각각 표 4, 5 및 6에 나와 있으며, 이러한 단서에서 먼저 LLM의 반복적 사고 표현 참조 패러다임에서 네 가지 연산을 정의했습니다. 그런 다음 ALCE 벤치마크와 일치하도록 선택된 네 가지 문맥적 예시를 구성했습니다(Gao et al., 2023b).

C 사례 연구

그림 5에는 ASQA의 예가 나와 있습니다.

목표는 제공된 검색 결과만을 사용하여 주어진 질문에 대한 정확하고 흥미롭고 간결한 답변을 작성하고 이를 올바르게 인용하는 것입니다. 공정하고 저널리즘적인 어조를 사용하세요. 모든 사실에 대해서는 항상 인용을 명시하세요. 네 가지 작업을 사용할 수 있습니다:

- """검색: 키워드"""는 몇 가지 키워드를 요청하고 검색 및 생성 기록을 기반으로 가장 관련성이 높은 문서를 검색합니다.

- """반영: 아이디어"""" 그리고 질문에 대한 답변으로 유효한 문서를 찾지 못한 경우 검색 결과에 반영합니다.

- """출력: 문장"""은 검색된 문서를 기반으로 긴 답변을 출력합니다. 답안에는 [1][2][3]을 사용하여 올바르게 인용합니다. 문장당 최소 1개, 최대 3개의 문서를 인용합니다. 여러 문서가 해당 문장을 뒷받침하는 경우 가장 충분한 문서 하위 집합만 인용됩니다.

- """종료"""를 누르면 퀴즈 작업이 종료됩니다.

다음은 몇 가지 예입니다:

질문 : 최장 거리 슛 기록은 누가 세웠나요?

검색 : 최장 거리 촬영 기록

문서[1](캡션: 데이비드 애커스)는 63야드 필드골을 크로스바를 넘어 차 넣으며 최장 필드골 기록을 세웠습니다.

문서[2] (제목: 더크 보르고 노네) 더크 보르고 노네, 더크 로널드 보르고 노네 (1968 년 1 월 9 일 출생)는 전 국가대표 ...

문서[3] (제목: 러셀 엘크세벤) 콜로라도 대학교와의 경기. 경기 초반의 문제에도 불구하고 ...

반영 : 검색 결과가 질문에 답할 수 있는 유효한 정보를 제공하지 않았습니다. NFL에서 가장 긴 필드 골 기록을 검색하는 것이 좋습니다.

검색 : NFL 최장 필드 골 기록

문서[4](제목: 필드 골) 자신의 엔드존을 향해 슛합니다. NFL 역사상 가장 긴 필드 골은 64야드이며, 이 기록은 ...에 의해 수립되었습니다.

문서 [5](제목: 필드 골 범위)의 양쪽 엔드 존은 66야드에 불과했습니다. 실내 축구를 하던 스카치아는 64야드 슛을 시도했는데...

문서[6] (제목: 사격 범위) 이 업적은 공식 기록이 아닙니다. 위의 모든 사격이 성공했습니다...

결과 : NFL 경기 최장 필드골 기록은 맷 프레이터[4]가 세운 64야드입니다.

검색 : 모든 수준의 대회, 대학에서 가장 긴 샷 기록

문서[7](제목: 필드 골) 자신의 엔드존을 향해 슛합니다. NFL 역사상 가장 긴 필드 골은 64야드이며, 이 기록은 ...에 의해 수립되었습니다.

문서[8] (제목: 샷의 범위) 35~40야드 라인(맞바람이 불 때 더 가깝게)은 일반적으로 더 위험한 샷을 시도합니다...

문서[9] (제목: 필드 골 범위) NFL, 1989년부터 NCAA에 의해 금지됨)은 68야드, 파브리지오 스카치아...

산출 : 그러나 모든 수준의 대회에서 가장 긴 필드 골 기록은 1976년 애빌린 크리스천 대학교와 이스트 텍사스 주립 대학교[8] 간의 축구 경기에서 대학 키커 오베 요한슨이 차 넣은 69야드입니다. 끝.

목표는 제공된 검색 결과만을 사용하여 주어진 질문에 대한 정확하고 흥미롭고 간결한 답변을 작성하고 이를 올바르게 인용하는 것입니다. 공정하고 저널리즘적인 어조를 사용하세요. 모든 사실에 대해서는 항상 인용을 명시하세요. 네 가지 작업을 사용할 수 있습니다:

- """검색: 키워드"""는 몇 가지 키워드를 요청하고 검색 및 생성 기록을 기반으로 가장 관련성이 높은 문서를 검색합니다.

- """반영: 아이디어"""" 그리고 질문에 대한 답변으로 유효한 문서를 찾지 못한 경우 검색 결과에 반영합니다.

- """출력: 문장"""은 검색된 문서를 기반으로 긴 답변을 출력합니다. 답안에는 [1][2][3]을 사용하여 올바르게 인용합니다. 문장당 최소 1개, 최대 3개의 문서를 인용합니다. 여러 문서가 해당 문장을 뒷받침하는 경우 가장 충분한 문서 하위 집합만 인용됩니다.

- """종료"""를 누르면 퀴즈 작업이 종료됩니다.

다음은 몇 가지 예입니다:

질문 : 네빌 슈트는 어떤 책을 저술했나요?

검색 : 네빌 슈트 테마 사회 장애

문서[1] (제목: 네빌 슈트) 초기 단계. 축하드립니다." 작가로서의 명성 덕분에 정보부에서는 그를 ...

문서 [2] (제목: 네빌 슈트) 주제는 계급('외로운 길', '착륙'), 인종 등 사회적 장벽을 넘나드는 것입니다...

문서[3] (제목: 네빌 슈트) 항공기 건설 회사, 에어스피드 주식회사. 그의 소설은 인기를 얻었지만 더 유명해졌습니다 ...

산출물 : 검은 그루터기 너머 [2], 외로운 길 [2], 체스판 [2], 음습한 곳에서 [2], 공구실 관리인 [2], 굽은 길 주변 [2].

검색 : 네빌 슈트 심플 가독성 스타일

문서[4] (네빌 슈트) 항공기 건설 회사, 에어스피드 주식회사. 그의 소설은 인기가 높아졌지만 더 유명해졌습니다 ...

문서[5] (바둑판) 버마의 사람들", 이 두 가지가 이 책의 핵심입니다. 슈트는 책 판매에 대해 걱정하고 있습니다...

문서[6] (젖은) 그는 단편 소설 "곤도르의 호기심 공화국"에서 투표 아이디어를 여러 번 사용했습니다....

반영 : 검색 결과가 질문에 답하는 데 유용한 정보를 제공하지 않았습니다. 1950년대 네빌 슈트의 책을 검색하는 것이 좋습니다.

검색 : 네빌 슈테의 1950년대 도서

문서[7] (네빌 슈트) 초기 단계. 축하합니다." 작가로서의 명성 덕분에 정보부에서는 그를 다음과 같은 곳으로 보냈습니다.

문서 [8] (네빌 슈트) 계급('외로운 길', '착륙'), 인종('체스판') 등 사회적 장벽을 넘어서는 것이 주제입니다...

문서[9] (네빌 슈트) 항공기 건설 회사, 에어스피드 주식회사. 그의 소설은 인기가 높아졌지만 더 유명해졌습니다 ...

산출 : 말라잔 [7], 스티븐 모리스 [7].

닫기

목표는 제공된 검색 결과만을 사용하여 주어진 질문에 대한 정확하고 흥미롭고 간결한 답변을 작성하고 이를 올바르게 인용하는 것입니다. 공정하고 저널리즘적인 어조를 사용하세요. 모든 사실에 대해서는 항상 인용을 명시하세요. 네 가지 작업을 사용할 수 있습니다:

- """검색: 키워드"""는 몇 가지 키워드를 요청하고 검색 및 생성 기록을 기반으로 가장 관련성이 높은 문서를 검색합니다.

- """반영: 아이디어"""" 그리고 질문에 대한 답변으로 유효한 문서를 찾지 못한 경우 검색 결과에 반영합니다.

- """출력: 문장"""은 검색된 문서를 기반으로 긴 답변을 출력합니다. 답안에는 [1][2][3]을 사용하여 올바르게 인용합니다. 문장당 최소 1개, 최대 3개의 문서를 인용합니다. 여러 문서가 해당 문장을 뒷받침하는 경우 가장 충분한 문서 하위 집합만 인용됩니다.

- """종료"""를 누르면 퀴즈 작업이 종료됩니다.

다음은 몇 가지 예입니다:

질문 : 양극성 장애의 원인은 무엇인가요?

검색 : 양극성 장애란 무엇인가요?

문서 [1](제목: 양극성 장애 II형) 개인의 지각 및 행동 경계 설정에 관한 연구. 이 연구는 다음과 같은 내용을 시사합니다.

문서 [2] (제목: 양극성 장애의 생물학) 이 영역에 위치한 뇌 영역은 양극성 장애의 메커니즘으로 가설됩니다...

문서 [3](제목: 양극성 장애의 생물학) 극성에 관계없이. 양극성 장애에서 염증이 보고되었습니다...

반영 : 검색 결과가 질문에 대한 답변에 유효한 정보를 제공하지 않았습니다. 양극성 장애의 증상을 검색하는 것이 좋습니다.

검색 : 양극성 장애의 증상은 무엇인가요? 얼마나 오래 지속되나요?

문서 [4] (제목: 양극성 장애 | 의학사전에서의 정의) 양극성 장애 | 양극성 장애의 정의...

문서 [5](제목: 조증과 양극성 장애)는 하루 또는 며칠 만에 우울한 상태에서 "매우 행복"한 상태로 바뀔 수 있습니다.

문서 [6] (제목: 개인용 - 아담 슈워츠) 개인용 2014 아담 슈워츠 정보는 광범위하며 다음을 포함합니다...

산출 : 양극성 장애는 행복감에서 우울증에 이르는 극심한 기분 변화를 일으키는 기분 장애입니다 [4]. 기분 변화는 며칠에서 몇 달까지 지속될 수 있습니다[5].

검색 : 양극성 장애의 원인은 무엇인가요?

문서 [7] (제목: 양극성 장애) 양극성 장애는 일반적으로 개인이 우울증을 나타내는 주기적 장애입니다...

문서 [8] (제목: 우울증 양극성 장애 증상 2019 | 우울증 극복하기) 우울증 양극성 장애 증상 2019.

문서[9] (제목: 정신 장애)에는 부모의 거부, 부모의 따뜻함 부족 등 부모의 요인이 포함될 수 있습니다...

결과 : 이 질병을 일으키는 정확한 요인은 아직 확실하지 않지만 유전학이 주요 요인으로 생각됩니다 [7].

닫기

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...