일반 소개

타르시에는 주로 고품질 동영상 설명을 생성하는 데 사용되는 ByteDance에서 개발한 오픈 소스 동영상 언어 모델 제품군입니다. CLIP-ViT가 비디오 프레임을 처리하고 대규모 언어 모델(LLM)과 함께 시간적 관계를 분석하는 간단한 구조로 구성되어 있습니다. 최신 버전인 Tarsier2-7B(2025년 1월 출시)는 16개 공개 벤치마크에서 최상위권에 올랐으며 GPT-4o 등의 모델과 경쟁할 수 있습니다. Tarsier는 동영상 설명, Q&A, 제로 샘플 자막 생성 등을 지원하며 코드, 모델, 데이터는 GitHub에서 공개되어 있습니다. 이 프로젝트는 또한 1000개의 다양한 동영상 클립이 포함된 동영상 설명 기능을 평가하기 위한 DREAM-1K 벤치마크를 출시했습니다.

기능 목록

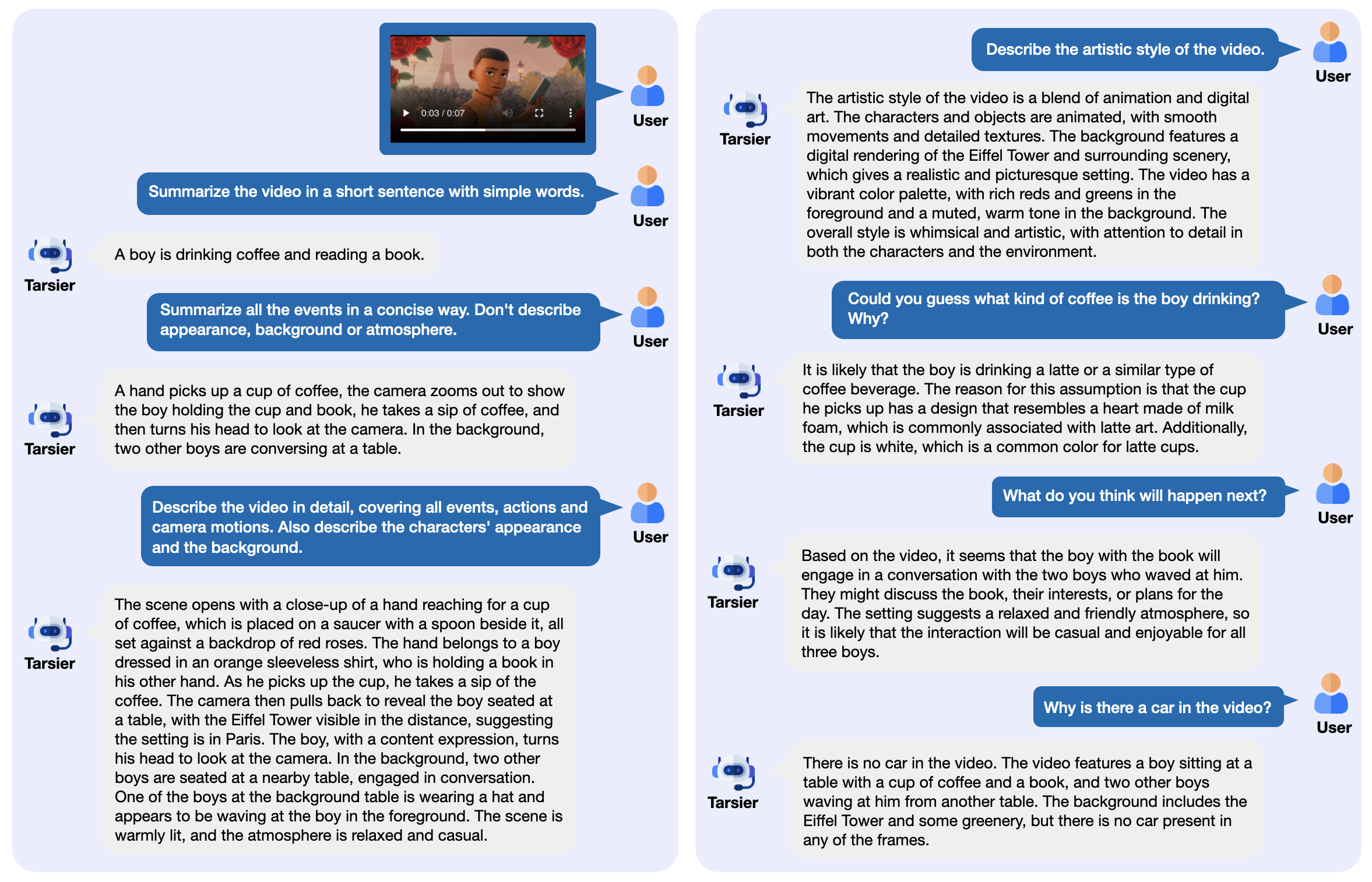

- 자세한 동영상 설명 생성: 동영상 콘텐츠를 분석하고 자세한 텍스트를 출력합니다.

- 동영상 Q&A 지원: 이벤트나 세부 정보 등 동영상 관련 질문에 답변합니다.

- 제로 샘플 자막 생성: 교육 없이도 동영상 자막을 생성할 수 있습니다.

- 멀티태스킹 비디오 이해력: 퀴즈 및 캡션과 같은 여러 작업에 탁월합니다.

- 오픈 소스 배포: 로컬 또는 클라우드에서 실행할 모델 가중치와 코드를 제공합니다.

- 평가 도구 제공: DREAM-1K 데이터 세트 및 AutoDQ 평가 방법론이 포함됩니다.

도움말 사용

타르시에는 개발자나 연구원 등 기술적 배경 지식이 있는 사용자에게 적합합니다. 자세한 설치 및 사용 지침은 아래에 나와 있습니다.

설치 프로세스

- 환경 준비하기

Python 3.9 이상이 필요합니다. 가상 환경을 권장합니다:

conda create -n tarsier python=3.9

conda activate tarsier

- 클론 창고

타르시에 프로젝트 코드를 다운로드하세요:

git clone https://github.com/bytedance/tarsier.git

cd tarsier

git checkout tarsier2

- 종속성 설치

설치 스크립트를 실행합니다:

bash setup.sh

파이토치 및 허깅 페이스의 도구와 같은 필요한 모든 라이브러리가 설치됩니다.

- GPU 지원(선택 사항)

NVIDIA GPU를 사용하는 경우 CUDA와 함께 PyTorch를 설치하세요:

pip install torch torchvision --index-url https://download.pytorch.org/whl/cu118

- 모델 다운로드

허깅 페이스에서 모델을 다운로드합니다(예: 타르시에2-7B):

huggingface-cli download omni-research/Tarsier2-7b

공식 링크에서 타르시에-34b 또는 타르시에2-Recap-7b와 같은 다른 모델도 사용할 수 있습니다.

- 설치 확인

빠른 테스트 스크립트를 실행합니다:

python3 -m tasks.inference_quick_start --model_name_or_path path/to/Tarsier2-7b --input_path assets/videos/coffee.gif

출력은 "한 남자가 하트 모양의 거품이 있는 커피잔을 들고 한 모금 마신다"와 같은 동영상에 대한 설명이어야 합니다.

주요 기능

동영상 설명 생성

- 이동

- 동영상 파일을 준비합니다(MP4, GIF 등의 형식 지원).

- 실행 명령을 실행합니다:

python3 -m tasks.inference_quick_start --model_name_or_path path/to/Tarsier2-7b --instruction "Describe the video in detail." --input_path your/video.mp4

- 비디오의 동작과 장면을 설명하는 등의 출력이 터미널에 표시됩니다.

- 다음 사항에 유의하십시오.

- 동영상이 너무 길면 더 많은 메모리가 필요할 수 있으므로 먼저 짧은 동영상으로 테스트하는 것이 좋습니다.

- 프레임 속도와 같은 조정 가능한 매개변수(

configs/tarser2_default_config.yaml).

동영상 Q&A

- 이동

- 질문 및 동영상을 지정합니다:

python3 -m tasks.inference_quick_start --model_name_or_path path/to/Tarsier2-7b --instruction "视频里的人在做什么?" --input_path your/video.mp4

- 예를 들어 "그는 커피를 마시고 있어요"와 같이 직접 대답을 출력합니다.

- STH에 주목하세요.

- 질문은 구체적이고 모호하지 않아야 합니다.

- 중국어 및 기타 언어 지원, 중국어가 가장 잘 작동합니다.

샘플 자막 생성 제로

- 이동

- 자막 모드를 사용하도록 설정 파일을 수정합니다(

configs/tarser2_default_config.yaml설정task: caption). - 실행 중입니다:

python3 -m tasks.inference_quick_start --model_name_or_path path/to/Tarsier2-7b --config configs/tarser2_default_config.yaml --input_path your/video.mp4

- "혼자 커피 마시기"와 같은 짧은 자막을 출력합니다.

로컬 서비스 배포

- 이동

- vLLM(권장 버전 0.6.6)을 설치합니다:

pip install vllm==0.6.6

- 서비스를 시작합니다:

python -m vllm.entrypoints.openai.api_server --model path/to/Tarsier2-7b

- API로 호출됩니다:

curl http://localhost:8000/v1/completions -H "Content-Type: application/json" -d '{"prompt": "描述这个视频", "video_path": "your/video.mp4"}'

- vantage

- 동영상은 일괄 처리할 수 있습니다.

- 다른 시스템과 쉽게 통합할 수 있습니다.

주요 기능 작동

DREAM-1K 평가

- 이동

- DREAM-1K 데이터 세트를 다운로드하세요:

wget https://tarsier-vlm.github.io/DREAM-1K.zip

unzip DREAM-1K.zip

- 운영 평가:

bash scripts/run_inference_benchmark.sh path/to/Tarsier2-7b output_dir dream

- 출력에는 설명의 품질을 보여주는 F1 점수와 같은 메트릭이 포함됩니다.

AutoDQ 평가

- 이동

- 설치 확인 ChatGPT 종속성(Azure OpenAI 구성 필요).

- 평가 스크립트를 실행합니다:

python evaluation/metrics/evaluate_dream_gpt.py --pred_dir output_dir/dream_predictions

- 설명 정확도를 측정하는 자동화된 평가 점수를 출력합니다.

자주 묻는 질문

- 설치 실패파이썬 버전 및 네트워크 확인, pip 업그레이드(

pip install -U pip). - 느린 모델 로딩디스크 공간이 충분한지 확인합니다(최소 50GB 권장).

- GPU 출력 없음: 실행

nvidia-smiCUDA가 제대로 작동하는지 확인합니다.

온라인 경험

- 인터뷰 타르시에2-7B 온라인 데모설명과 Q&A 기능을 테스트하려면 동영상을 업로드하세요.

이 단계를 통해 Tarsier로 동영상 작업을 쉽게 처리할 수 있습니다. 설명을 생성하든 서비스를 배포하든 간단하고 효율적으로 처리할 수 있습니다.

애플리케이션 시나리오

- 비디오 콘텐츠 데이터 정렬

미디어 작업자는 타르시에를 사용하여 동영상 요약을 생성하고 영상을 빠르게 정리할 수 있습니다. - 교육용 비디오 지원

교사는 코스 비디오에 자막이나 퀴즈를 생성하여 교수 및 학습을 향상시킬 수 있습니다. - 짧은 동영상 분석

마케팅 담당자는 TikTok과 같은 짧은 동영상의 콘텐츠를 분석하고 홍보를 위한 핵심 메시지를 추출할 수 있습니다.

QA

- 어떤 동영상 포맷이 지원되나요?

FFmpeg가 디코딩할 수 있는 MP4, GIF, AVI 등을 지원합니다. - 하드웨어 요구 사항은 무엇인가요?

최소 16GB RAM 및 4GB 비디오 메모리, NVIDIA GPU 권장(예: 3090). - 상업적으로 이용 가능한가요?

예, Tarsier는 Apache 2.0 라이선스를 사용하며 약관에 따라 상업적 사용이 허용됩니다.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...