FastGPT는 즉시 사용 가능한 데이터 처리, 모델 호출 및 기타 기능을 제공하는 LLM 모델을 기반으로 하는 지식 기반 Q&A 시스템으로, Circle Cloud 팀에서 개발했습니다. FastGPT는 깃허브에서 19.4천 개의 별을 받았습니다.

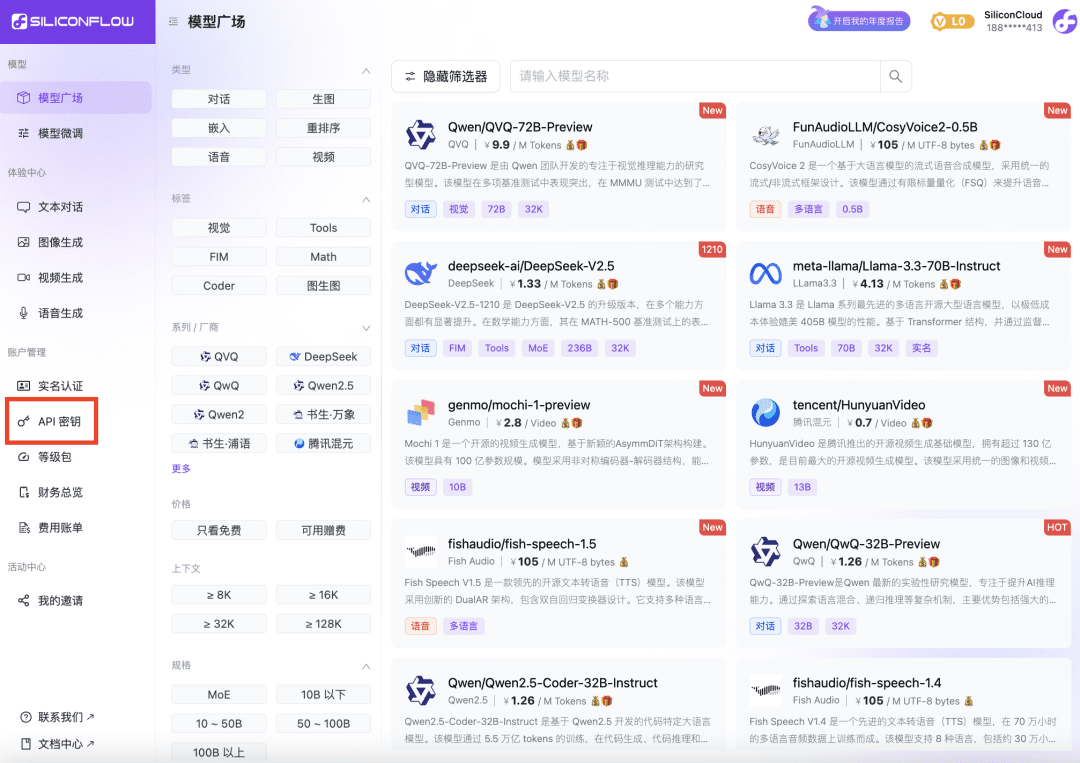

실리콘 플로우의 실리콘 클라우드는 자체 가속 엔진을 갖춘 대형 모델 클라우드 서비스 플랫폼으로, 실리콘 클라우드는 사용자가 저렴하고 빠른 방법으로 오픈 소스 모델을 테스트하고 사용할 수 있도록 도와줍니다. 실제 경험에 따르면 모델의 속도와 안정성이 매우 우수하고 언어, 벡터, 재정렬, TTS, STT, 매핑, 비디오 생성 등 수십 가지 모델을 포괄하는 다양성이 풍부하여 FastGPT의 모든 모델 요구를 충족할 수 있습니다.

이 문서는 실리콘클라우드 모델만을 사용하여 로컬 개발에 FastGPT를 배포하는 솔루션을 제시하기 위해 FastGPT 팀에서 작성한 튜토리얼입니다.

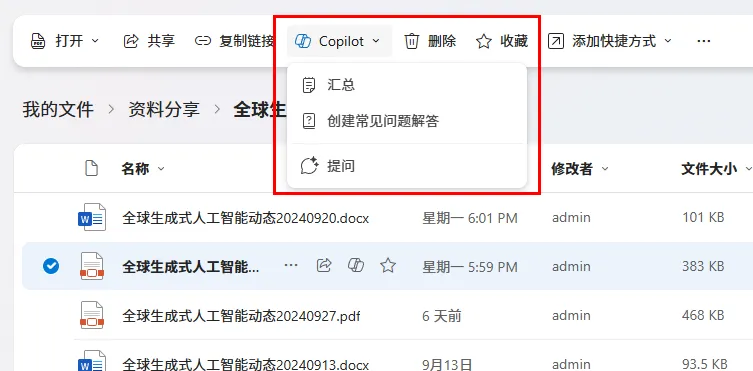

1 실리콘클라우드 플랫폼 API 키 얻기

- SiliconCloud 웹사이트를 열고 계정을 등록/로그인합니다.

- 등록을 완료한 후 API 키를 열고 새 API 키를 생성한 후 키를 클릭하여 나중에 사용할 수 있도록 복사합니다.

2 FastGPT 환경 변수 수정하기

OPENAI_BASE_URL=https://api.siliconflow.cn/v1 # 填写 SiliconCloud 控制台提供的 Api Key CHAT_API_KEY=sk-xxxxxx

FastGPT 개발 및 배포 문서: https://doc.fastgpt.cn

3 FastGPT 구성 파일 수정하기

실리콘클라우드의 모델은 FastGPT 구성으로 선택되었습니다. 여기서는 Qwen2.5 72b를 순수 언어 및 비전 모델로 구성하고, 벡터 모델로 bge-m3를 선택하고, 재배치 모델로 bge-reranker-v2-m3를 선택했습니다. 음성 모델로는 fish-speech-1.5를 선택하고 음성 입력 모델로는 SenseVoiceSmall을 선택합니다.

참고: 리랭크 모델은 여전히 API 키를 사용하여 한 번만 구성해야 합니다.

{

"llmModels": [

{

"provider": "Other", // 模型提供商,主要用于分类展示,目前已经内置提供商包括:https://github.com/labring/FastGPT/blob/main/packages/global/core/ai/provider.ts, 可 pr 提供新的提供商,或直接填写 Other

"model": "Qwen/Qwen2.5-72B-Instruct", // 模型名(对应OneAPI中渠道的模型名)

"name": "Qwen2.5-72B-Instruct", // 模型别名

"maxContext": 32000, // 最大上下文

"maxResponse": 4000, // 最大回复

"quoteMaxToken": 30000, // 最大引用内容

"maxTemperature": 1, // 最大温度

"charsPointsPrice": 0, // n积分/1k token(商业版)

"censor": false, // 是否开启敏感校验(商业版)

"vision": false, // 是否支持图片输入

"datasetProcess": true, // 是否设置为文本理解模型(QA),务必保证至少有一个为true,否则知识库会报错

"usedInClassify": true, // 是否用于问题分类(务必保证至少有一个为true)

"usedInExtractFields": true, // 是否用于内容提取(务必保证至少有一个为true)

"usedInToolCall": true, // 是否用于工具调用(务必保证至少有一个为true)

"usedInQueryExtension": true, // 是否用于问题优化(务必保证至少有一个为true)

"toolChoice": true, // 是否支持工具选择(分类,内容提取,工具调用会用到。)

"functionCall": false, // 是否支持函数调用(分类,内容提取,工具调用会用到。会优先使用 toolChoice,如果为false,则使用 functionCall,如果仍为 false,则使用提示词模式)

"customCQPrompt": "", // 自定义文本分类提示词(不支持工具和函数调用的模型

"customExtractPrompt": "", // 自定义内容提取提示词

"defaultSystemChatPrompt": "", // 对话默认携带的系统提示词

"defaultConfig": {}, // 请求API时,挟带一些默认配置(比如 GLM4 的 top_p)

"fieldMap": {} // 字段映射(o1 模型需要把 max_tokens 映射为 max_completion_tokens)

},

{

"provider": "Other",

"model": "Qwen/Qwen2-VL-72B-Instruct",

"name": "Qwen2-VL-72B-Instruct",

"maxContext": 32000,

"maxResponse": 4000,

"quoteMaxToken": 30000,

"maxTemperature": 1,

"charsPointsPrice": 0,

"censor": false,

"vision": true,

"datasetProcess": false,

"usedInClassify": false,

"usedInExtractFields": false,

"usedInToolCall": false,

"usedInQueryExtension": false,

"toolChoice": false,

"functionCall": false,

"customCQPrompt": "",

"customExtractPrompt": "",

"defaultSystemChatPrompt": "",

"defaultConfig": {}

}

],

"vectorModels": [

{

"provider": "Other",

"model": "Pro/BAAI/bge-m3",

"name": "Pro/BAAI/bge-m3",

"charsPointsPrice": 0,

"defaultToken": 512,

"maxToken": 5000,

"weight": 100

}

],

"reRankModels": [

{

"model": "BAAI/bge-reranker-v2-m3", // 这里的model需要对应 siliconflow 的模型名

"name": "BAAI/bge-reranker-v2-m3",

"requestUrl": "https://api.siliconflow.cn/v1/rerank",

"requestAuth": "siliconflow 上申请的 key"

}

],

"audioSpeechModels": [

{

"model": "fishaudio/fish-speech-1.5",

"name": "fish-speech-1.5",

"voices": [

{

"label": "fish-alex",

"value": "fishaudio/fish-speech-1.5:alex",

"bufferId": "fish-alex"

},

{

"label": "fish-anna",

"value": "fishaudio/fish-speech-1.5:anna",

"bufferId": "fish-anna"

},

{

"label": "fish-bella",

"value": "fishaudio/fish-speech-1.5:bella",

"bufferId": "fish-bella"

},

{

"label": "fish-benjamin",

"value": "fishaudio/fish-speech-1.5:benjamin",

"bufferId": "fish-benjamin"

},

{

"label": "fish-charles",

"value": "fishaudio/fish-speech-1.5:charles",

"bufferId": "fish-charles"

},

{

"label": "fish-claire",

"value": "fishaudio/fish-speech-1.5:claire",

"bufferId": "fish-claire"

},

{

"label": "fish-david",

"value": "fishaudio/fish-speech-1.5:david",

"bufferId": "fish-david"

},

{

"label": "fish-diana",

"value": "fishaudio/fish-speech-1.5:diana",

"bufferId": "fish-diana"

}

]

}

],

"whisperModel": {

"model": "FunAudioLLM/SenseVoiceSmall",

"name": "SenseVoiceSmall",

"charsPointsPrice": 0

}

}

4 FastGPT 재부팅

5 경험 테스트

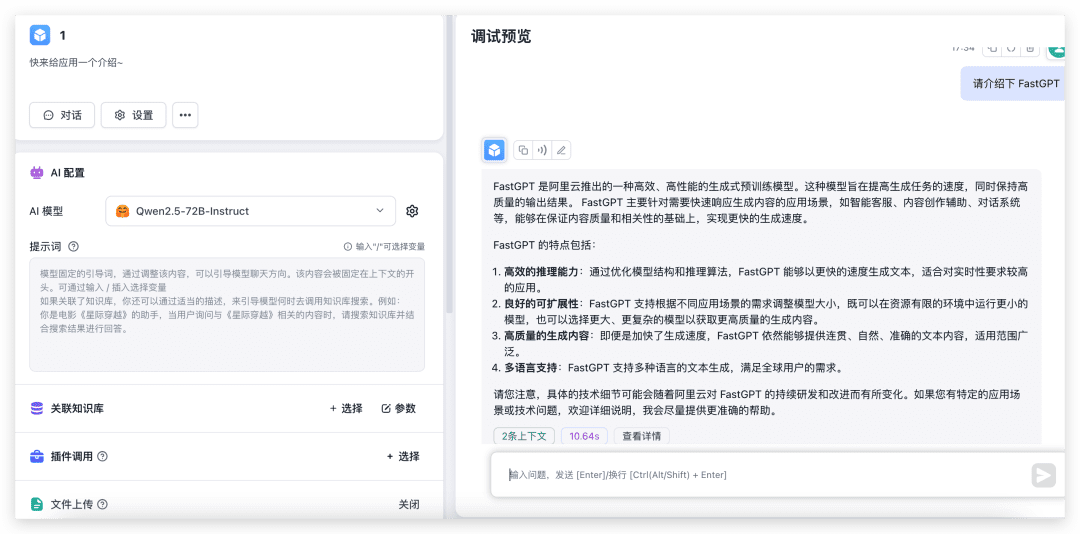

대화 및 사진 인식 테스트

간단한 애플리케이션을 새로 만들고 해당 모델을 선택한 다음 이미지 업로드를 켜서 테스트해 보세요.

보시다시피 72B의 모델은 성능이 매우 빠르며 환경 구성은 말할 것도없고 로컬 4090이 몇 개 없으면 출력이 30 초가 걸릴까 두렵습니다.

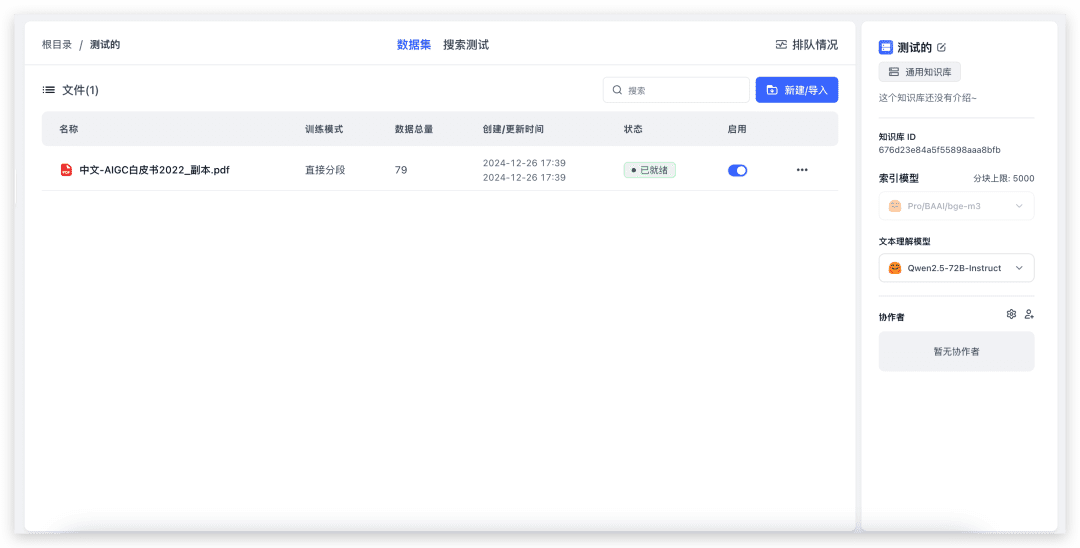

지식창고 가져오기 및 지식창고 퀴즈 테스트

새 지식창고를 만듭니다(벡터 모델이 하나만 구성되어 있으므로 페이지에 벡터 모델 선택 항목이 표시되지 않습니다).

로컬 파일을 가져오려면 파일을 선택하고 다음 단계로 넘어가면 됩니다. 79개의 인덱스가 있고 완료하는 데 약 20초가 걸렸습니다. 이제 지식창고 퀴즈를 테스트해 보겠습니다.

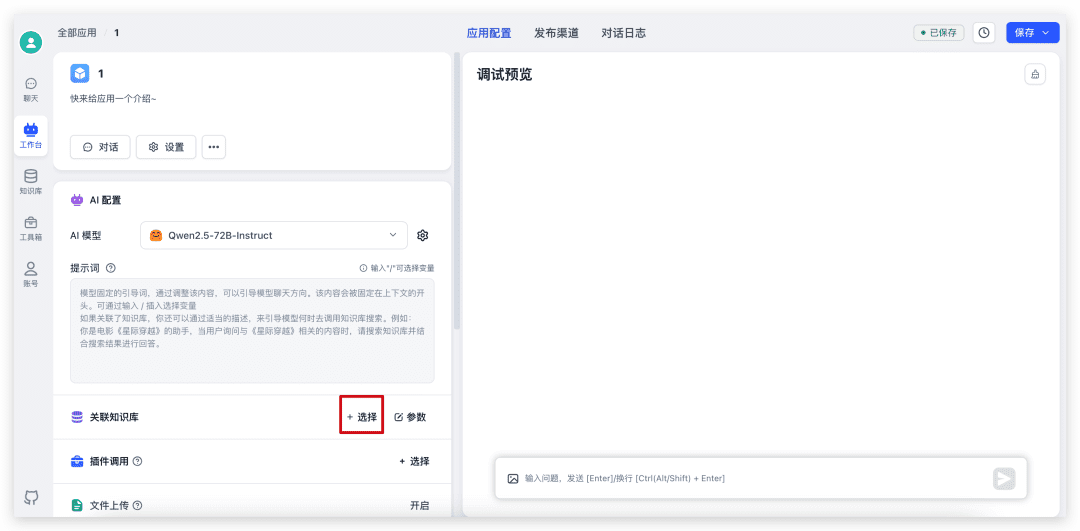

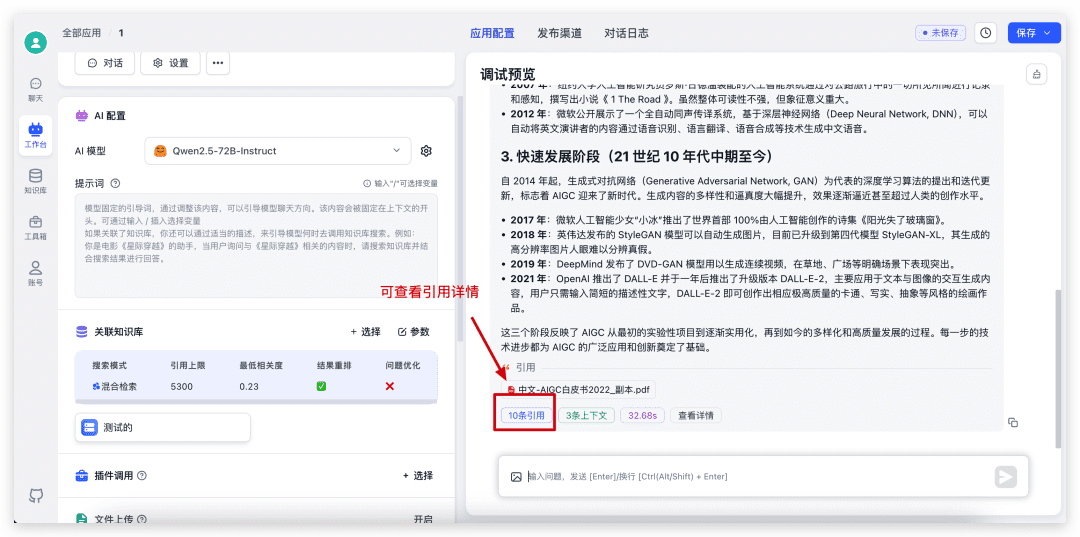

먼저 방금 만든 애플리케이션으로 돌아가서 지식창고를 선택하고 매개변수를 조정한 다음 대화를 시작합니다.

대화가 완료되면 하단의 인용을 클릭하여 인용 세부 정보를 확인하고 구체적인 검색 및 재정렬 점수를 확인합니다.

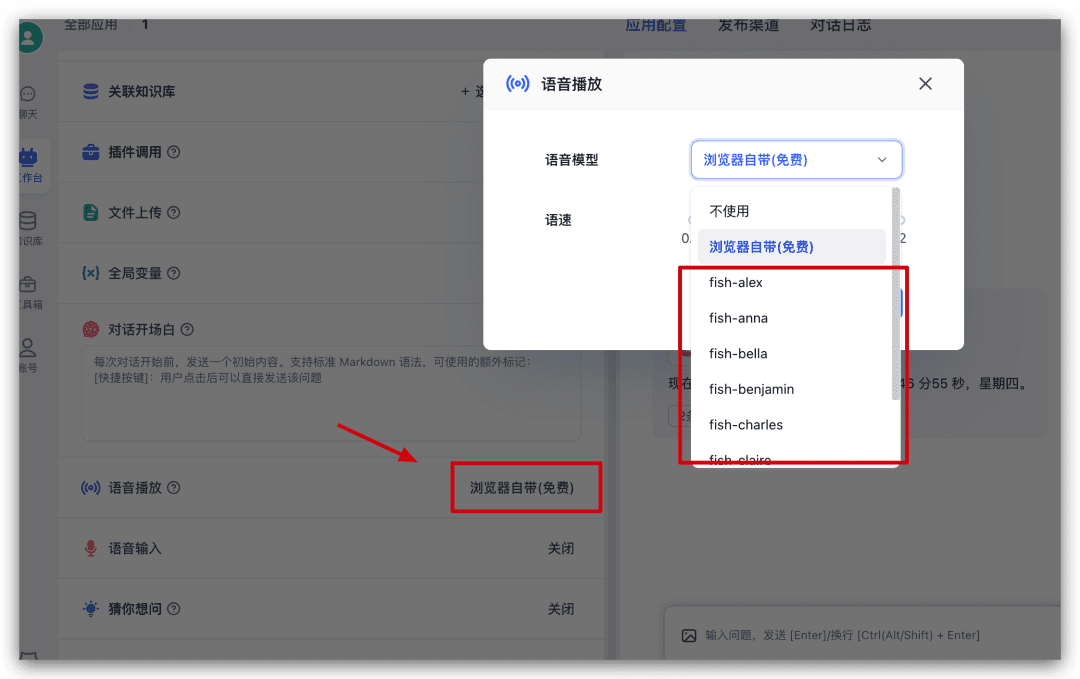

음성 재생 테스트

방금 앱에서 계속 진행하여 구성 왼쪽에서 음성 재생을 찾아 클릭한 다음 팝업 창에서 음성 모델을 선택하고 사용해 보세요.

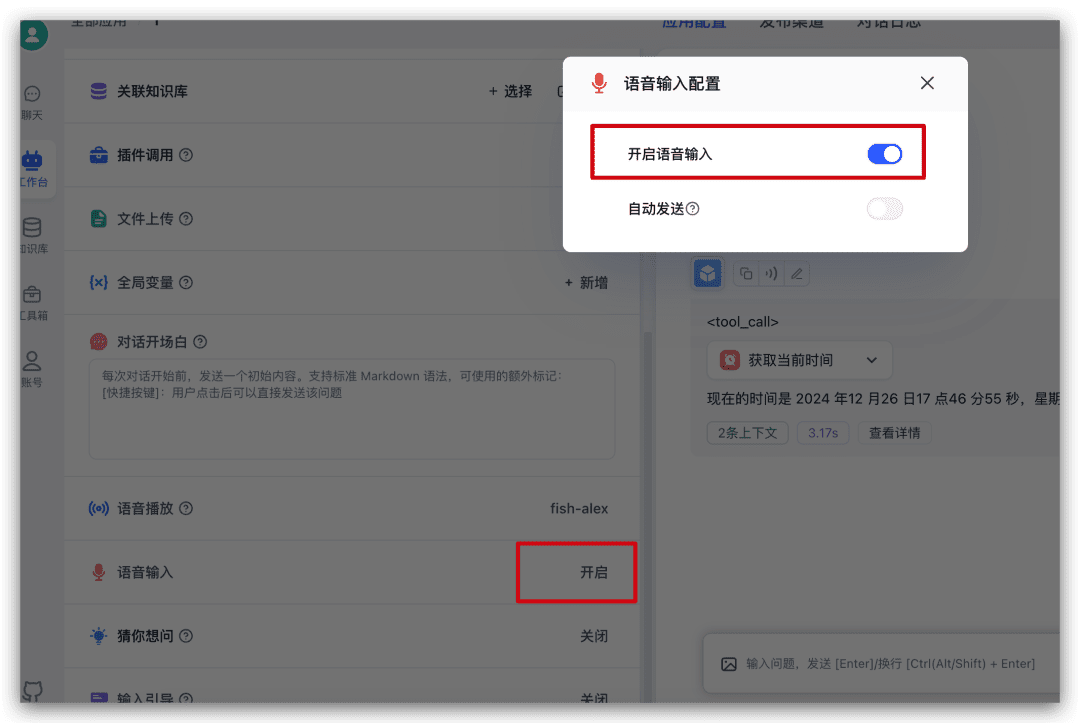

언어 입력 테스트

방금 앱의 왼쪽 구성에서 음성 입력을 찾아 클릭한 후 팝업 창에서 언어 입력을 활성화하세요.

이 기능을 켜면 대화 입력 상자에 마이크 아이콘이 추가되며, 이를 클릭하여 음성 입력을 할 수 있습니다.

요약

오픈 소스 모델을 빠르게 경험하고 싶거나 FastGPT를 빠르게 사용하고 싶고 다른 서비스 제공업체에서 모든 종류의 API 키를 신청하고 싶지 않다면 SiliconCloud의 모델을 선택하여 빠르게 경험할 수 있습니다.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...