모델 개요

최근 몇 년 동안 전문가 혼합(MoE) 아키텍처를 기반으로 한 대규모 모델 학습은 인공지능 분야에서 중요한 연구 방향이 되었으며, Qwen 팀은 최근 20조 개 이상의 사전 학습 데이터와 개선된 사후 학습 체계를 사용하는 Qwen2.5-Max 모델을 출시하여 MoE 아키텍처의 확장 적용에 획기적인 성과를 거두었습니다. 진행 상황. 이 모델은 이제 다음을 통해 사용할 수 있습니다.API 인터페이스어쩌면Qwen 채팅경험을 위한 플랫폼입니다.

기술적 특성

1. 모델 아키텍처의 혁신

- 하이브리드 전문가 시스템 최적화동적 라우팅 메커니즘을 통한 컴퓨팅 리소스의 효율적인 할당

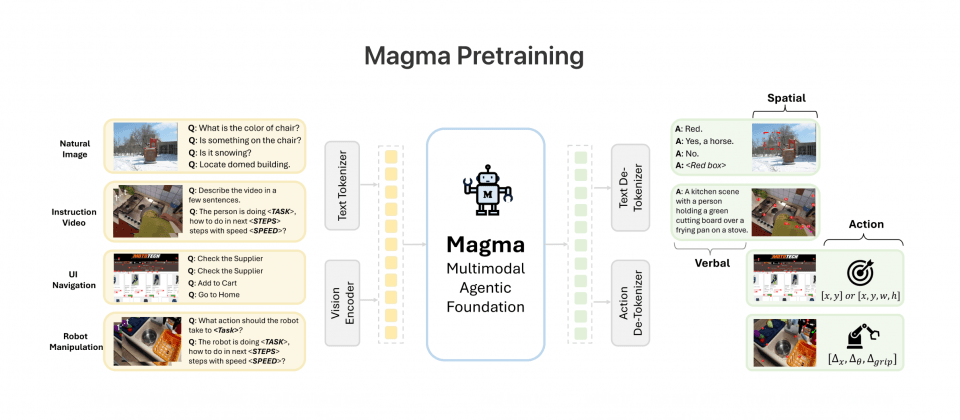

- 멀티모달 확장성텍스트, 구조화된 데이터 등 다양한 유형의 입력 및 출력을 지원합니다.

- 컨텍스트화 향상최대 입력: 30,720개 토큰, 최대 8,192개 토큰까지 연속 텍스트 생성 가능.

2. 핵심 기능 매트릭스

| 기능적 차원 | 기술 지표 |

|---|---|

| 다국어 지원 | 29개 언어 지원(중국어/영어/프랑스어/스페인어 등 포함) |

| 계산 기능 | 복잡한 수학적 연산 및 코드 생성 |

| 구조화된 처리 | JSON/테이블 데이터 생성 및 구문 분석 |

| 문맥 이해 | 8K 토큰 긴 텍스트 연결 생성 |

| 애플리케이션 적합성 | 대화 시스템/데이터 분석/지식 기반 추론 |

성능 평가

명령 모델 비교

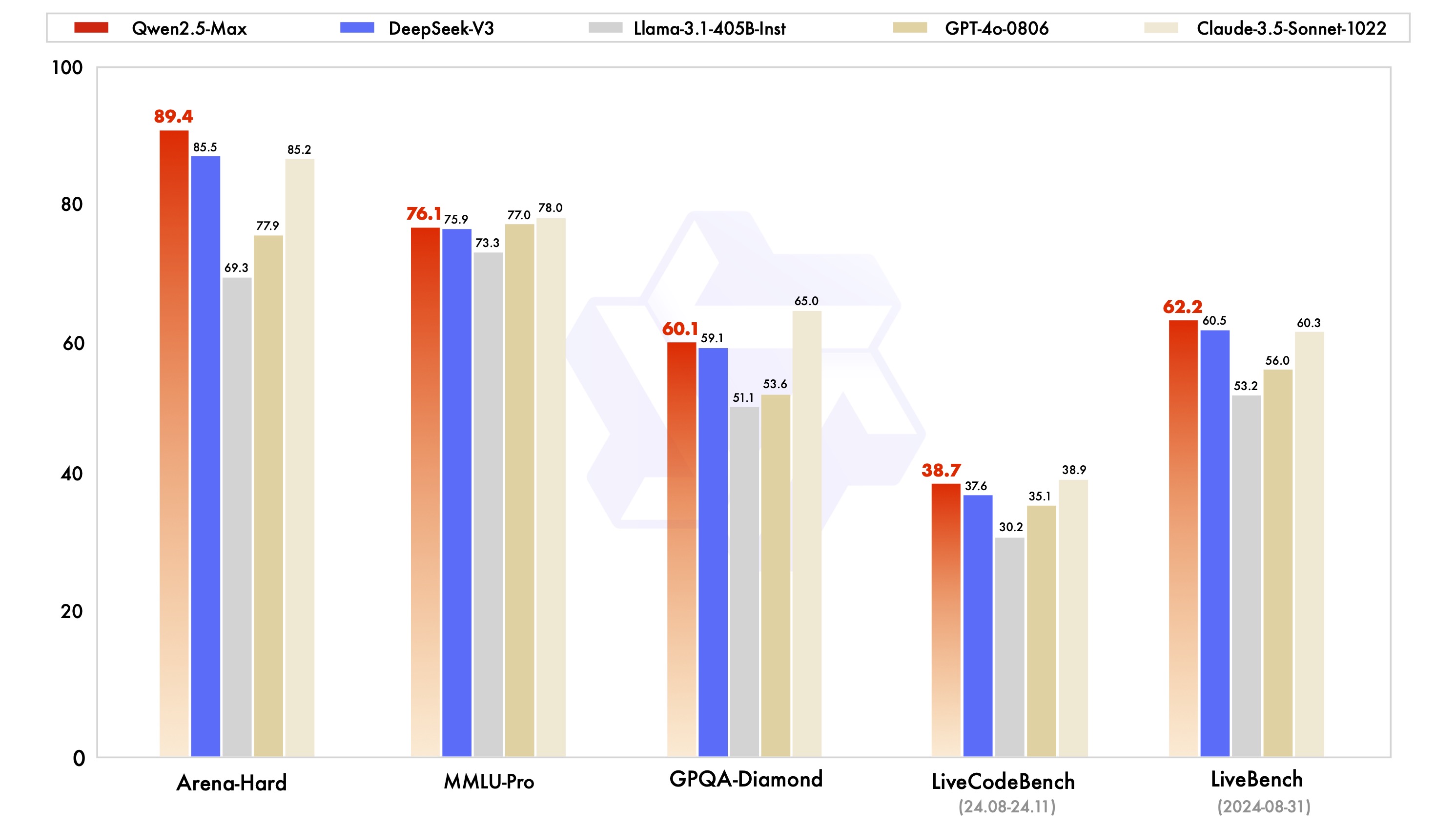

Qwen2.5-Max는 MMLU-Pro(대학 지식 테스트), LiveCodeBench(프로그래밍 능력 평가), Arena-Hard(인간 선호도 시뮬레이션) 등의 벤치마크 테스트에서 상당한 경쟁력을 입증했습니다:

테스트 데이터에 따르면 이 모델은 프로그래밍 능력(LiveCodeBench) 및 통합 추론(LiveBench) 부문에서 DeepSeek V3보다 성능이 뛰어나며 GPQA-Diamond 고차 추론 테스트에서 최고 수준에 도달했습니다.

기본 모델 비교

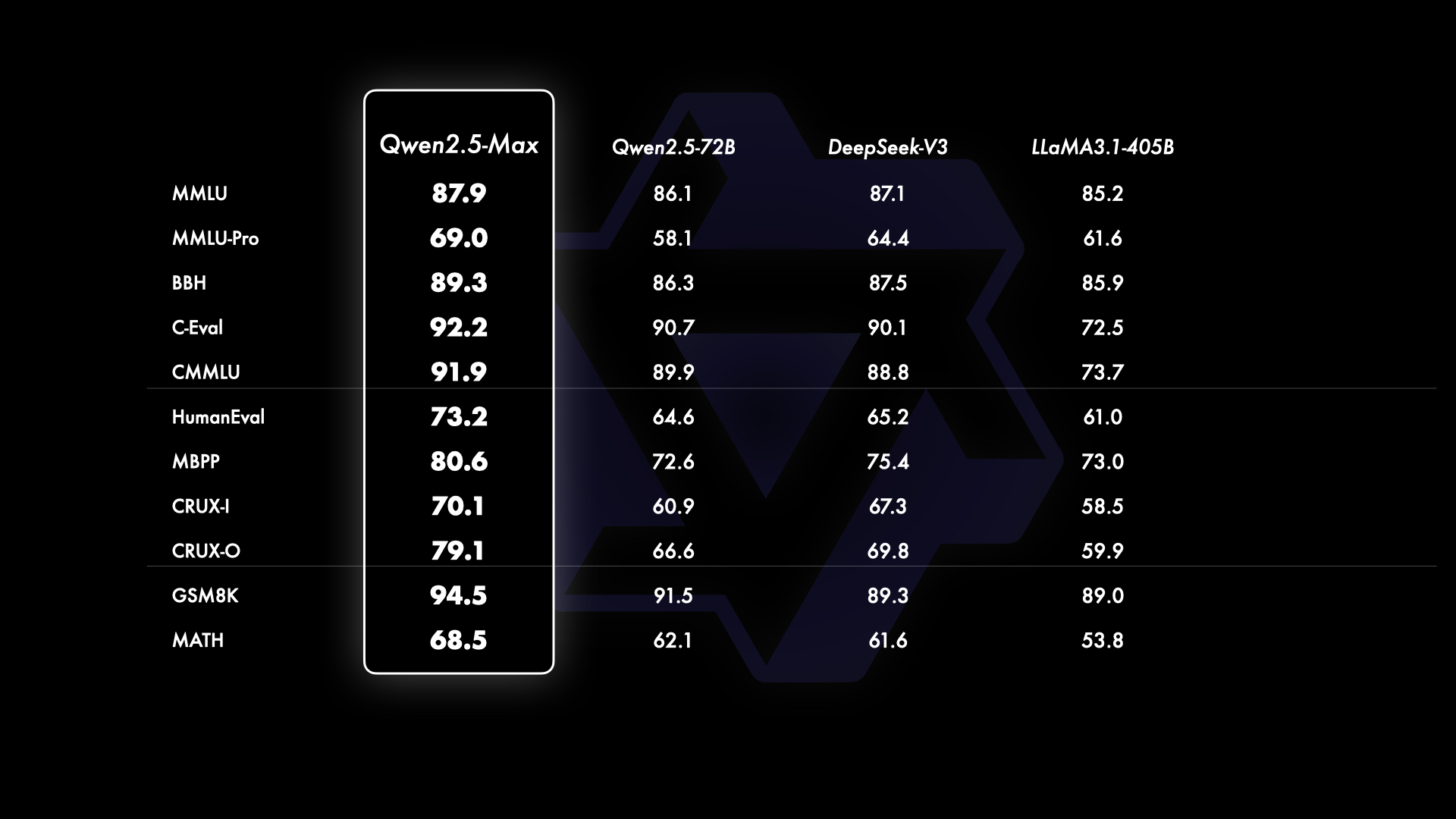

메인스트림 오픈 소스 모델과 비교했을 때 Qwen2.5-Max는 기본 기능 수준에서 기술적 이점을 보여줍니다:

405B 매개변수 규모의 Llama-3.1과 720B 매개변수 규모의 Qwen2.5-72B를 비교하면, 대부분의 테스트 항목에서 Qwen2.5-Max가 우위를 유지하여 모델 확장에 있어 MoE 아키텍처의 효율성을 검증했습니다.

액세스 및 사용

1. 클라우드 API 액세스

from openai import OpenAI

import os

client = OpenAI(

api_key=os.getenv("API_KEY"),

base_url="https://dashscale.aliyuncs.com/compatible-mode/v1",

)

response = client.chat.completions.create(

model="qwen-max-2025-01-25",

messages=[

{'role':'system', 'content':'设定AI助手角色'},

{'role':'user', 'content':'输入查询内容'}

]

)

2. 인터랙티브 경험

- 인터뷰허깅 페이스 데모 공간

- 실행 버튼을 실행하여 모델 로드

- 텍스트 입력 상자를 통한 실시간 상호작용

3. 엔터프라이즈 배포

- 등록알리윤 계정

- 대형 모델 서비스 플랫폼 출시

- 시스템 통합을 위한 API 키 생성

기술 발전 방향

현재 버전은 다음 영역에서 지속적으로 최적화되고 있습니다:

- 교육 후 데이터 품질 개선 전략

- 효율성 최적화를 위한 여러 전문가 협업

- 낮은 리소스 소비 추론 가속화

- 멀티모달 확장 인터페이스 개발

향후 전망

데이터 규모와 모델 파라미터 규모를 지속적으로 개선하면 모델의 지능 수준을 효과적으로 향상시킬 수 있습니다. 다음으로는 사전 학습의 확장 외에도 강화 학습의 확장에 적극적으로 투자하여 인간을 뛰어넘는 지능을 달성하고 AI가 미지의 영역을 탐험할 수 있도록 노력할 것입니다.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...