최근 많은 기대를 모았던 Qwen2.5-VL Qwen2.5-VL 시리즈의 새로운 멤버인 Qwen2.5-VL-32B-Instruct가 출시되었습니다. 이 320억 개 매개변수 규모의 멀티모달 시각 언어 모델은 Qwen2.5-VL 시리즈의 장점을 계승하고 강화 학습 및 기타 기술을 통해 더욱 최적화되어 특히 복잡한 추론과 사용자 경험에서 상당한 성능 향상을 달성했습니다.

올해 1월 말, Qwen 팀은 Qwen2.5-VL 시리즈 모델을 출시하여 커뮤니티의 광범위한 관심과 긍정적 인 피드백을 빠르게 얻은 것으로 이해됩니다. 커뮤니티의 기대에 부응하고 멀티모달 모델링 기술 개발을 지속적으로 촉진하기 위해 팀은 몇 달 동안 Qwen2.5-VL 시리즈를 신중하게 다듬어 왔으며 마침내 더 많은 개발자와 연구자에게 혜택을 제공하기 위해 Apache 2.0 프로토콜을 사용하여 오픈 소스인 이 새로운 Qwen2.5-VL-32B-Instruct 모델을 출시했습니다.

여러 지표에서 이전 세대 및 유사 모델을 능가하는 성능의 비약적 향상

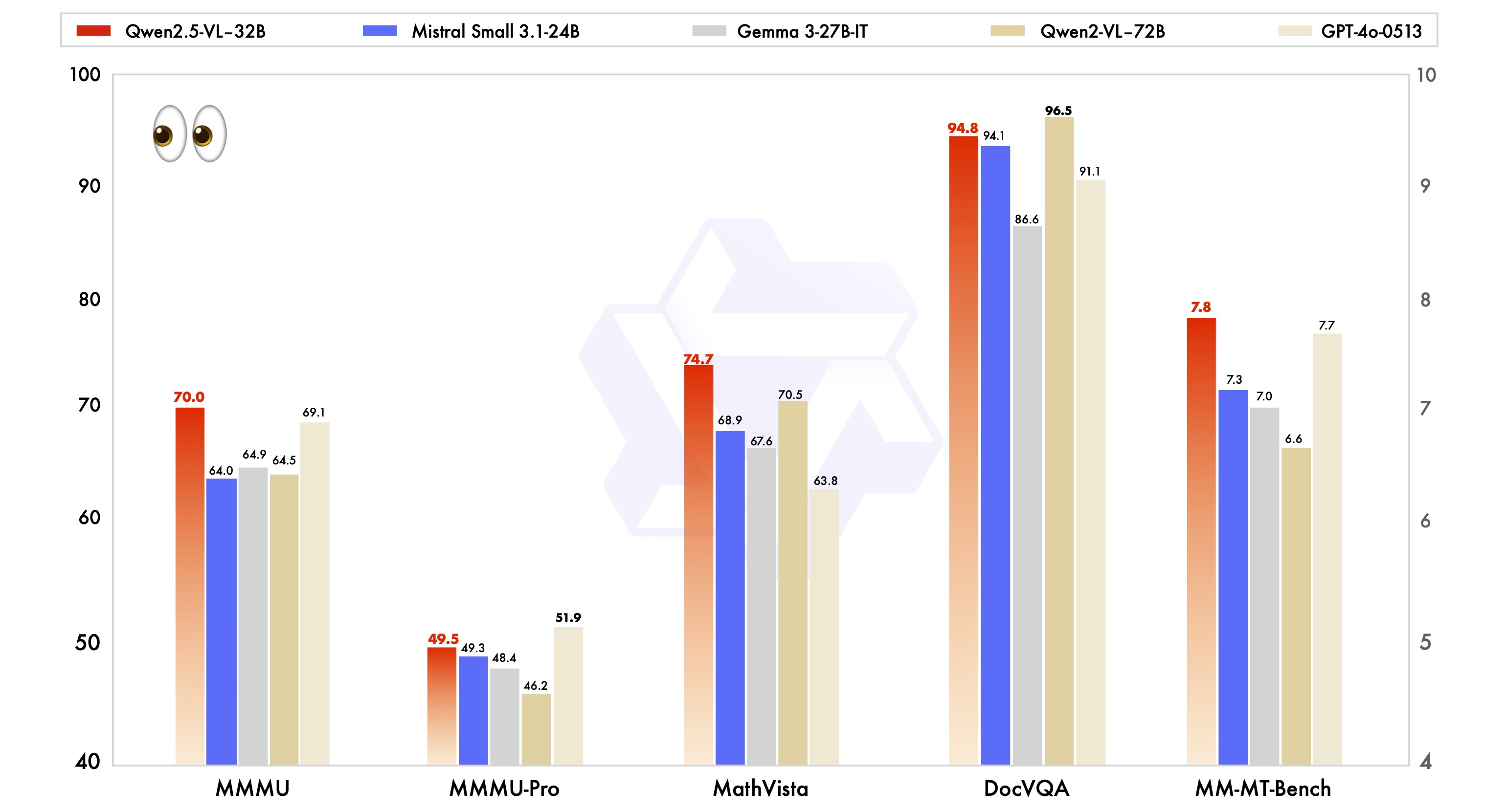

공식 데이터에 따르면 Qwen2.5-VL-32B-Instruct 모델은 이전에 출시된 Qwen2.5-VL 시리즈에 비해 여러 주요 성능 지표에서 상당한 개선을 달성한 것으로 나타났습니다.

첫째, 주관적인 사용자 선호도 측면에서 새 모델은 출력 스타일을 조정하여 답글을 보다 상세하고 표준화된 형식으로 만들어 사람의 읽기 습관과 선호도에 더 부합하도록 했습니다. 즉, 사용자는 사용 중에 더욱 부드럽고 자연스러운 상호작용을 경험할 수 있습니다.

둘째, 수학적 추론 능력 측면에서 Qwen2.5-VL-32B-Instruct 모델은 복잡한 수학 문제 해결의 정확성에서 상당한 진전을 이루었습니다. 이는 모델이 논리적 추론 및 계산 능력 측면에서 효과적으로 향상되었으며 심층적 사고와 정확한 계산이 필요한 작업에 더 잘 대처할 수 있음을 나타냅니다.

또한 Qwen2.5-VL-32B-Instruct 모델은 이미지의 세분화된 이해와 추론에서 더 큰 강점을 보여줍니다. 이미지 구문 분석의 정밀도, 콘텐츠 인식의 폭, 시각적 논리 추론의 깊이 등 새로운 모델은 더 높은 수준을 보여주며 이미지 정보를 더 정확하고 세심하게 분석할 수 있습니다.

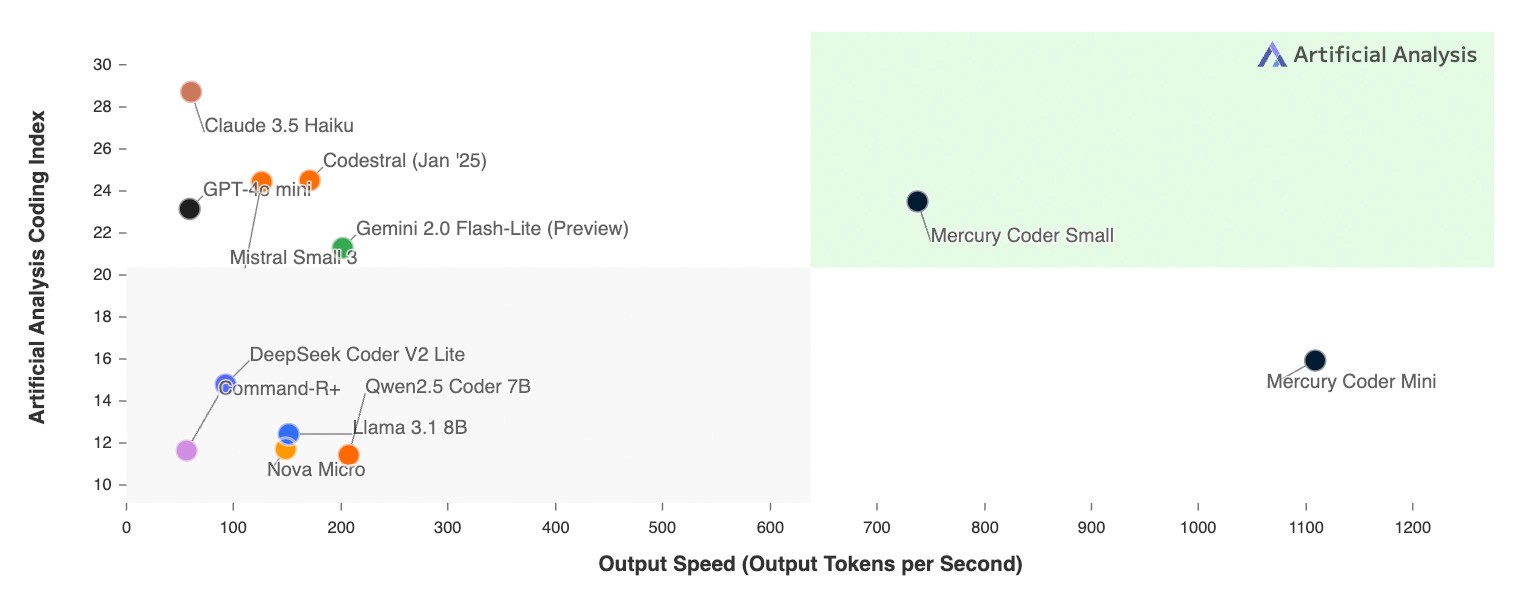

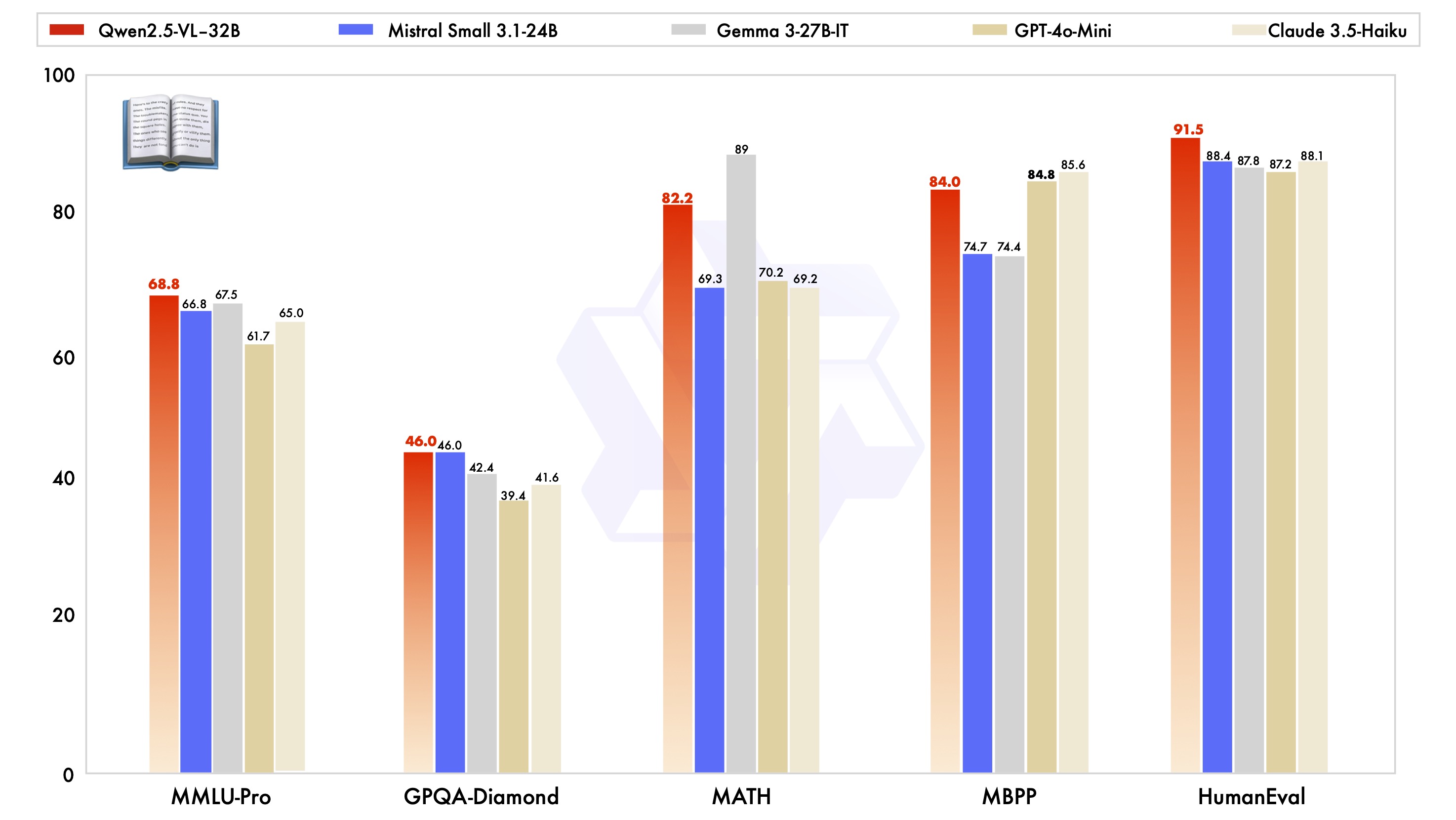

Qwen2.5-VL-32B-Instruct 모델의 성능 이점을 입증하기 위해 Mistral-Small-3.1-24B 및 Gemma-3-27B-IT를 포함한 동일한 크기의 업계 선도 모델에 대해서도 테스트했습니다. 그 결과, Qwen2.5-VL-32B-Instruct 모델은 많은 멀티모달 작업에서 분명한 이점을 보여주었으며 일부 지수는 더 큰 규모의 Qwen2-VL-72B-Instruct 모델을 능가하는 것으로 나타났습니다. 특히 복잡한 다단계 추론을 강조하는 MMMU, MMMU-Pro, MathVista와 같은 작업에서 Qwen2.5-VL-32B-Instruct 모델의 뛰어난 성능이 인상적입니다. 주관적인 사용자 경험에 초점을 맞춘 MM-MT-Bench 벤치마크에서도 이 모델은 이전 모델인 Qwen2-VL-72B-Instruct에 비해 상당한 발전을 이루었습니다.

Qwen2.5-VL-32B-Instruct 모델은 시각적 기능 측면에서 우수한 성능을 발휘할 뿐만 아니라 일반 텍스트 기능 측면에서도 동일한 축척 모델 중 최적의 수준을 달성한다는 점을 언급할 가치가 있습니다.

기술 하이라이트: 동적 해상도, 효율적인 비주얼 인코더

Qwen2.5-VL 시리즈 모델은 또한 기술 아키텍처에서 일련의 혁신과 업그레이드를 특징으로 합니다.

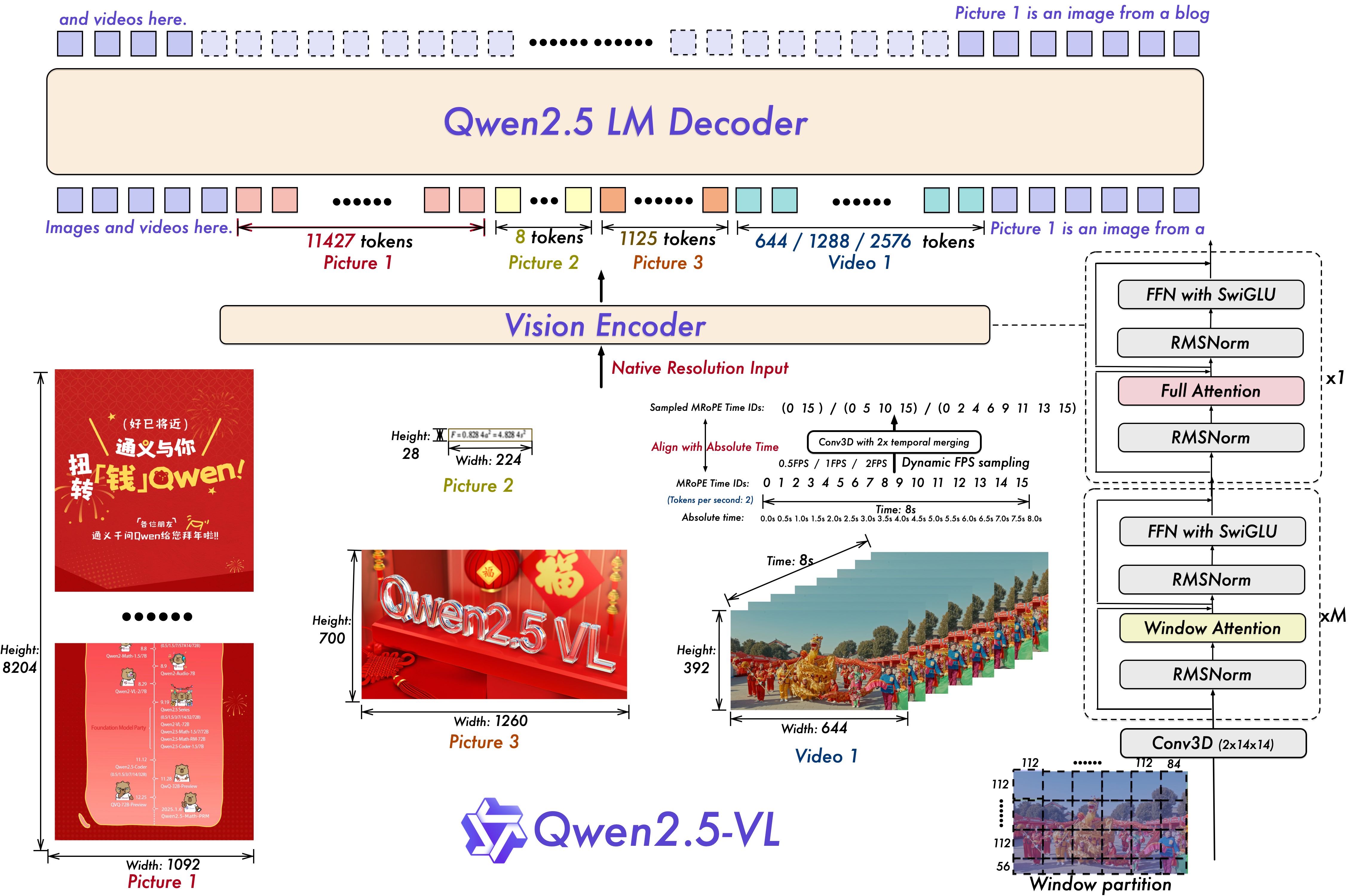

비디오 이해를 위해 모델은 동적 해상도 및 프레임 속도 학습 기법을 사용하며, 동적 FPS 샘플링을 도입하여 샘플링 속도가 다른 비디오 콘텐츠를 이해할 수 있도록 합니다. 한편, 다중 상대 위치 인코딩(mRoPE)은 시간적 차원에서 업데이트되고 ID 및 절대 시간 정렬과 결합되어 모델이 시계열 및 속도 정보를 학습하여 비디오의 주요 순간을 포착할 수 있게 해줍니다.

비전 인코더의 경우, Qwen2.5-VL 시리즈 모델은 간소화되고 효율적인 비전 인코더를 사용하며, 이 비전 인코더는 ViT(비전) 인코더에서 사용할 수 있습니다. 트랜스포머)는 전략적으로 Qwen2.5 LLM에 윈도우 주의 메커니즘을 도입하고, 이를 SwiGLU 및 RMSNorm과 같은 최적화와 결합하여 ViT 아키텍처를 Qwen2.5 LLM의 아키텍처와 더욱 일관되게 만들어 모델 학습 및 추론 속도를 효과적으로 개선했습니다.

멀티모달 애플리케이션 혁신을 위한 오픈 소스 포함

Qwen2.5-VL-32B-Instruct 모델의 오픈 소스 릴리스는 의심할 여지없이 멀티모달 시각 언어 분야에 새로운 활력을 불어넣을 것입니다. 이 모델을 기반으로 개발자와 연구자들은 이미지 및 동영상 콘텐츠 이해, 지능형 에이전트, 크로스 모달 콘텐츠 생성 등과 같은 보다 심층적인 연구를 수행하고 보다 광범위한 애플리케이션을 개발할 수 있습니다.

이제 사용자가 빠르게 시작할 수 있도록 자세한 코드 샘플과 지침이 포함된 Qwen2.5-VL-32B-Instruct 모델을 Hugging Face Transformers 및 ModelScope에서 사용할 수 있으며, Qwen 팀은 계속해서 커뮤니티의 피드백에 집중하여 Qwen2.5-VL 시리즈를 최적화하고 개선할 것이라고 밝혔습니다. Qwen2.5-VL 시리즈 모델은 커뮤니티 피드백에 지속적으로 주의를 기울이고 최적화 및 개선하여 멀티모달 기술 개발에 기여할 것입니다.

Qwen2.5-VL-32B-Instruct 모델을 체험하고 싶은 경우 다음과 같은 방법으로 빠르게 시작할 수 있습니다:

환경 구성

호환성을 보장하기 위해 사용자가 소스에서 트랜스포머 라이브러리를 빌드하는 것이 좋습니다:

pip install git+https://github.com/huggingface/transformers accelerate빠른 시작 코드 예시(🤗 트랜스포머 사용).

from transformers import Qwen2_5_VLForConditionalGeneration, AutoTokenizer, AutoProcessor

from qwen_vl_utils import process_vision_info

# 加载模型

model = Qwen2_5_VLForConditionalGeneration.from_pretrained(

"Qwen/Qwen2.5-VL-32B-Instruct", torch_dtype="auto", device_map="auto"

)

# 加载 processor

processor = AutoProcessor.from_pretrained("Qwen/Qwen2.5-VL-32B-Instruct")

# 构建 messages

messages = [

{

"role": "user",

"content": [

{

"type": "image",

"image": "https://qianwen-res.oss-cn-beijing.aliyuncs.com/Qwen-VL/assets/demo.jpeg",

},

{"type": "text", "text": "Describe this image."},

],

}

]

# 预处理

text = processor.apply_chat_template(

messages, tokenize=False, add_generation_prompt=True

)

image_inputs, video_inputs = process_vision_info(messages)

inputs = processor(

text=[text],

images=image_inputs,

videos=video_inputs,

padding=True,

return_tensors="pt",

)

inputs = inputs.to("cuda")

# 模型推理

generated_ids = model.generate(**inputs, max_new_tokens=128)

generated_ids_trimmed = [

out_ids[len(in_ids) :] for in_ids, out_ids in zip(inputs.input_ids, generated_ids)

]

output_text = processor.batch_decode(

generated_ids_trimmed, skip_special_tokens=True, clean_up_tokenization_spaces=False

)

print(output_text)

Qwen2.5-VL-32B-Instruct 모델의 출시는 의심할 여지없이 멀티모달 시각 언어 모델 분야에서 새로운 혁신을 가져올 것이며, 성능, 기술 및 오픈 소스에서의 장점은 멀티모달 기술의 인기와 적용을 가속화 할 것으로 예상되며 업계의 지속적인 관심을받을 가치가 있습니다.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...