일반 소개

Ovis(오픈 비전)는 알리바바 국제 디지털 커머스 그룹의 AIDC-AI 팀이 개발하고 깃허브에서 호스팅하는 오픈 소스 멀티모달 대규모 언어 모델(MLLM)로, 혁신적인 구조적 임베딩 정렬 기술을 사용하여 시각 및 텍스트 데이터를 효율적으로 병합하고 이미지, 텍스트, 동영상 등의 멀티모달 입력을 지원하며 해당 출력 콘텐츠를 생성하는 데 사용됩니다. 2025년 3월, Ovis는 뛰어난 소형화 성능, 향상된 추론 기능, 고해상도 이미지 및 비디오 처리 기능을 제공하는 Ovis2 제품군(1B~34B 매개변수 스케일)을 출시했습니다. 개발자와 연구자를 대상으로 하는 이 프로젝트는 상세한 문서와 코드를 제공하고 오픈 소스 협업을 강조하며 이미 커뮤니티에서 주목을 받고 있습니다.

기능 목록

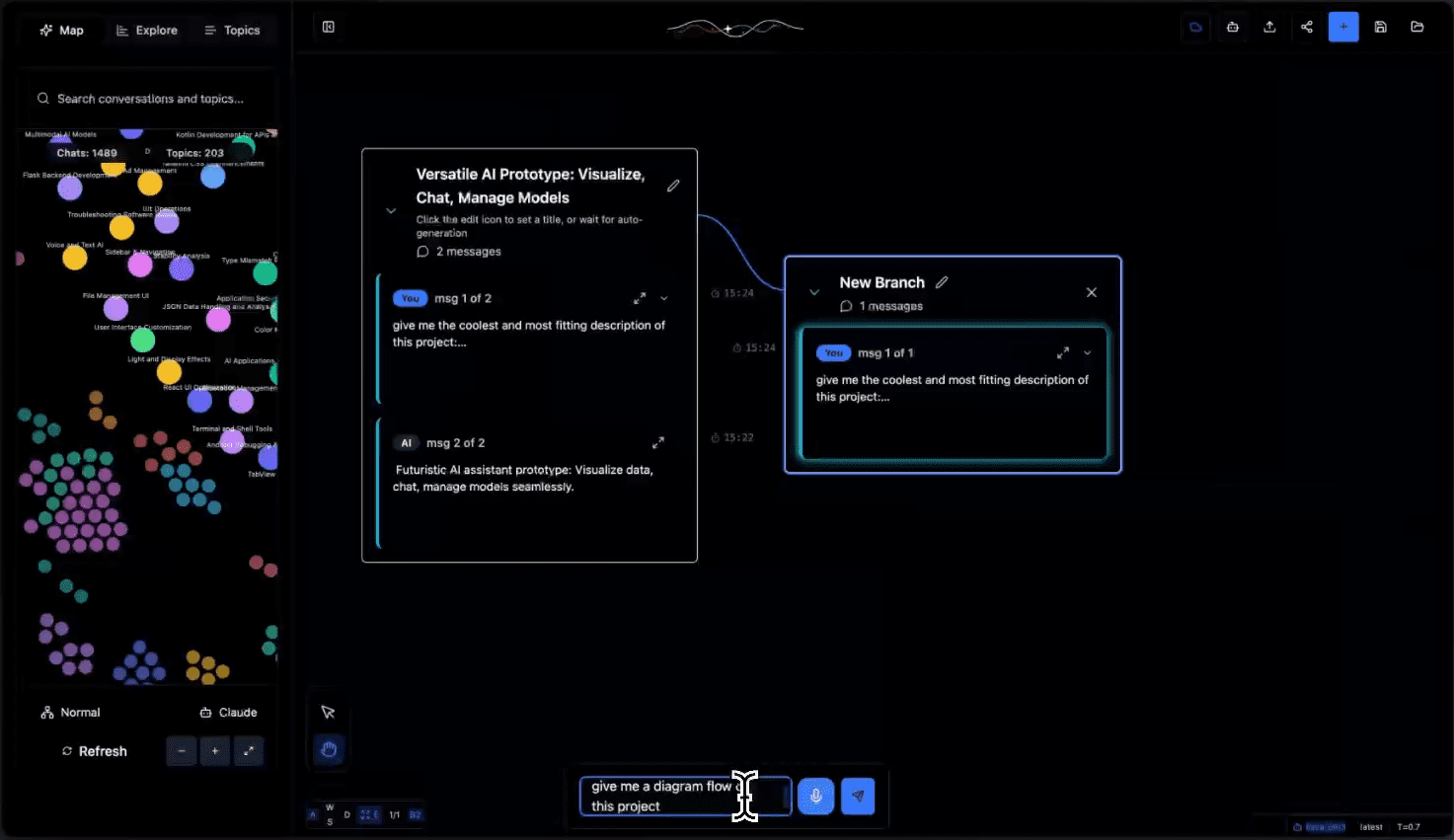

- 멀티모달 입력 지원이미지, 텍스트, 동영상 등 여러 입력 유형을 처리합니다.

- 시각적 텍스트 정렬이미지 또는 동영상 콘텐츠와 정확하게 일치하는 텍스트 설명을 생성합니다.

- 고해상도 이미지 처리고해상도 이미지를 지원하고 디테일을 유지하도록 최적화되었습니다.

- 비디오 및 다중 그래프 분석비디오 프레임 시퀀스 및 여러 이미지의 순차 처리를 지원합니다.

- 향상된 추론 능력인스트럭션 튜닝 및 DPO 교육을 통해 논리적 추론을 강화하세요.

- 다국어 OCR 지원다국어 이미지 텍스트를 인식하고 처리합니다.

- 여러 모델 옵션다양한 하드웨어에 맞게 1B~34B의 파라미터를 가진 모델을 사용할 수 있습니다.

- 정량적 버전 지원예: 작동 임계값을 낮추기 위한 GPTQ-Int4 모델.

- 라디오 인터페이스 통합웹 상호작용을 위한 직관적인 인터페이스를 제공합니다.

도움말 사용

설치 프로세스

Ovis 설치는 아래에 자세히 설명된 대로 특정 Python 환경 및 라이브러리에 따라 달라집니다:

- 환경 준비

- Git 및 Anaconda가 설치되어 있는지 확인합니다.

- Ovis 리포지토리를 복제합니다:

git clone git@github.com:AIDC-AI/Ovis.git - 가상 환경을 만들고 활성화합니다:

conda create -n ovis python=3.10 -y conda activate ovis

- 종속 설치

- 프로젝트 카탈로그로 이동합니다:

cd Ovis - 설치 종속성(

requirements.txt):pip install -r requirements.txt - Ovis 패키지를 설치합니다:

pip install -e . - (선택 사항) 가속 라이브러리 설치(예: 플래시 어텐션):

pip install flash-attn==2.7.0.post2 --no-build-isolation

- 프로젝트 카탈로그로 이동합니다:

- 환경 검증

- PyTorch 버전(2.4.0 권장)을 확인하세요:

python -c "import torch; print(torch.__version__)"

- PyTorch 버전(2.4.0 권장)을 확인하세요:

Ovis 사용 방법

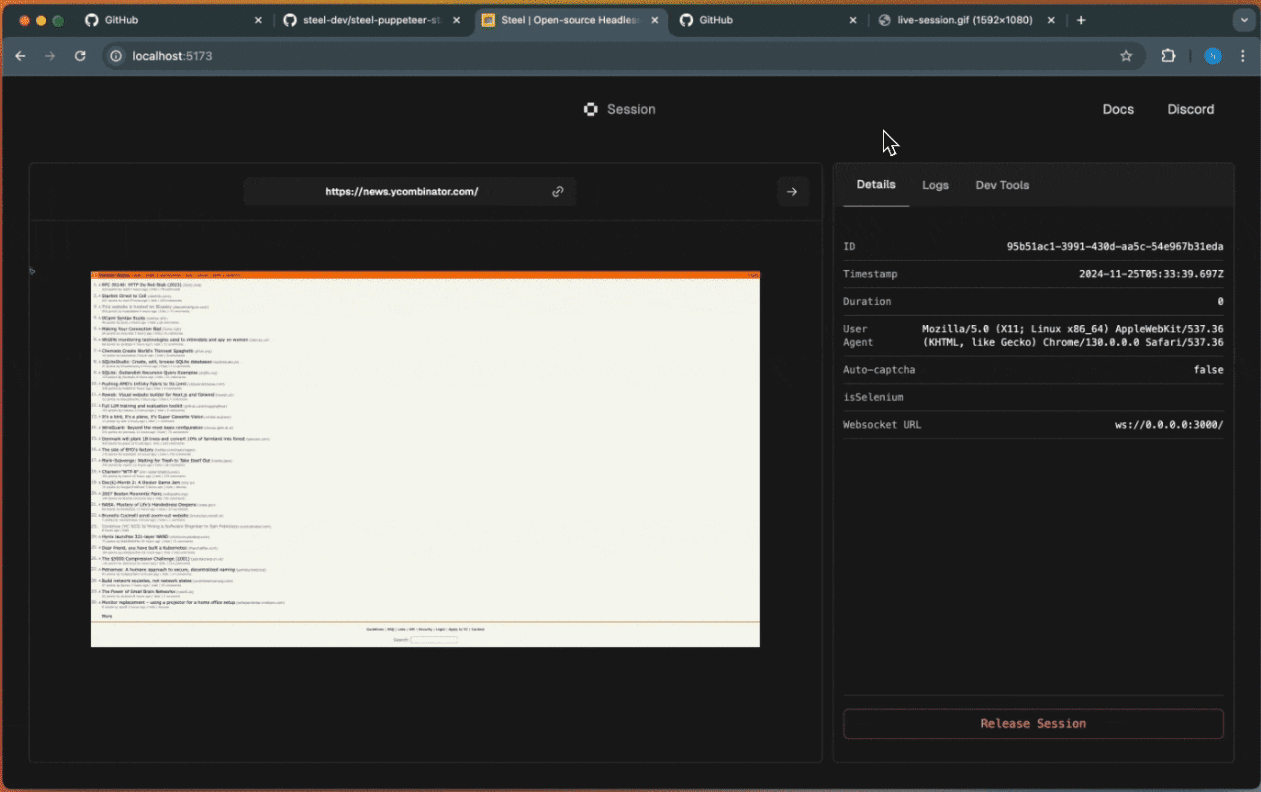

Ovis는 명령줄 추론과 Gradio 인터페이스 작업을 모두 지원하며, 자세한 가이드는 여기를 참조하세요:

명령줄 추론

- 모델 및 입력 준비하기

- 허깅 페이스에서 모델을 다운로드합니다(예: Ovis2-8B):

git clone https://huggingface.co/AIDC-AI/Ovis2-8B - 입력 파일 준비(예: 이미지)

example.jpg를 클릭하고 "이 사진을 설명하세요"라는 메시지가 표시됩니다.

- 허깅 페이스에서 모델을 다운로드합니다(예: Ovis2-8B):

- 추론 실행

- 스크립트 만들기

run_ovis.py::import torch from PIL import Image from transformers import AutoModelForCausalLM # 加载模型 model = AutoModelForCausalLM.from_pretrained( "AIDC-AI/Ovis2-8B", torch_dtype=torch.bfloat16, multimodal_max_length=32768, trust_remote_code=True ).cuda() # 获取 tokenizer text_tokenizer = model.get_text_tokenizer() visual_tokenizer = model.get_visual_tokenizer() # 处理输入 image = Image.open("example.jpg") text = "描述这张图片" query = f"<image>\n{text}" prompt, input_ids, pixel_values = model.preprocess_inputs(query, [image]) attention_mask = torch.ne(input_ids, text_tokenizer.pad_token_id) # 生成输出 with torch.inference_mode(): output_ids = model.generate( input_ids.unsqueeze(0).cuda(), pixel_values=[pixel_values.cuda()], attention_mask=attention_mask.unsqueeze(0).cuda(), max_new_tokens=1024 ) output = text_tokenizer.decode(output_ids[0], skip_special_tokens=True) print("输出结果:", output) - 스크립트를 실행합니다:

python run_ovis.py

- 스크립트 만들기

- 결과 보기

- 출력 예: "푸른 하늘을 배경으로 잔디밭에 서 있는 강아지의 사진입니다."

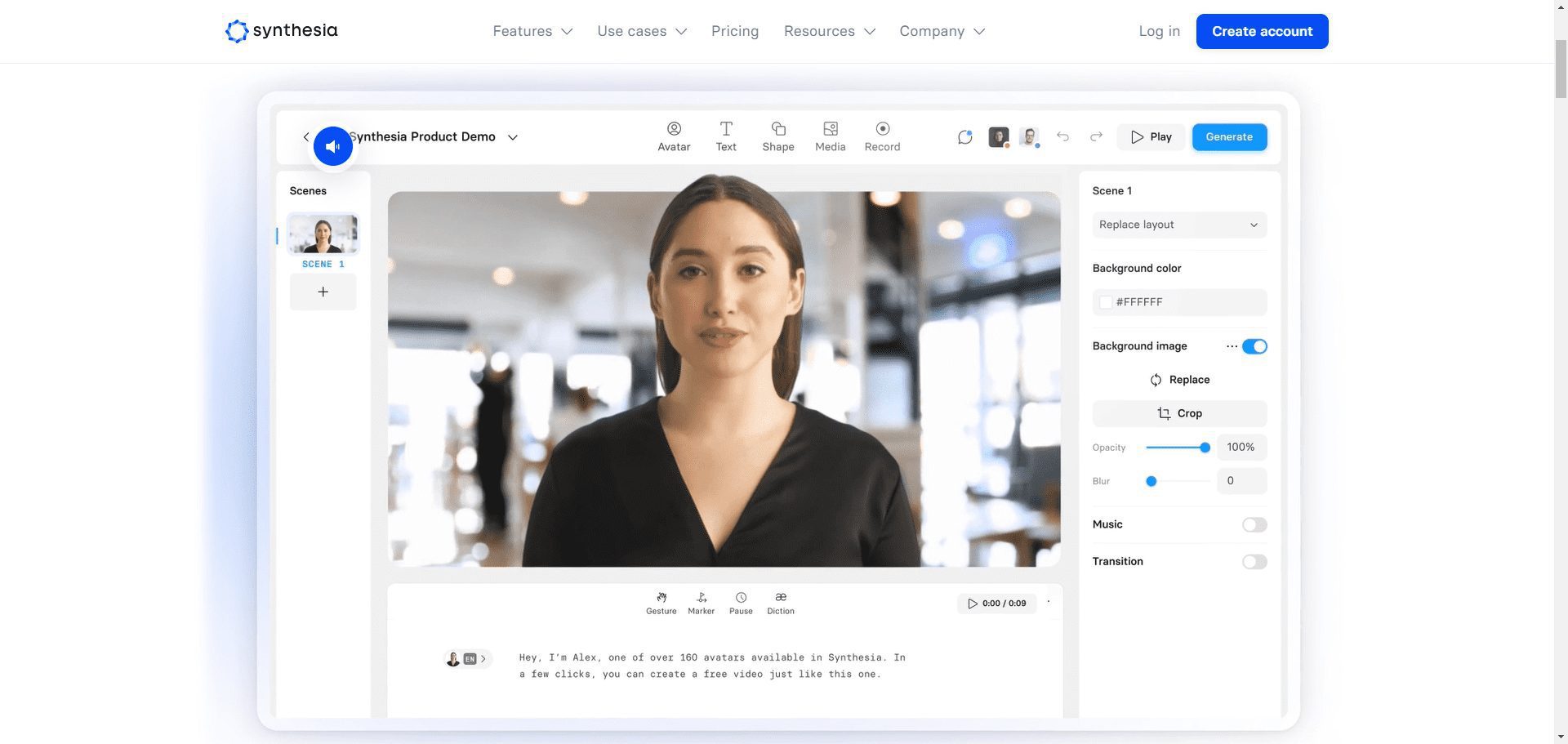

라디오 인터페이스 작동

- 서비스 시작

- Ovis 카탈로그에서 실행하세요:

python ovis/serve/server.py --model_path AIDC-AI/Ovis2-8B --port 8000 - 로드 대기 중, 액세스 중

http://127.0.0.1:8000.

- Ovis 카탈로그에서 실행하세요:

- 인터페이스 작동

- 인터페이스에 사진을 업로드합니다.

- "이 사진에 무엇이 있나요?"와 같은 프롬프트를 입력합니다. .

- 제출을 클릭하여 생성된 결과를 확인합니다.

주요 기능

고해상도 이미지 처리

- 절차: 고해상도 이미지를 업로드하면 모델이 자동으로 분할됩니다(최대 분할 수 9개).

- take아트웍 분석 및 지도 해석과 같은 작업에 적합합니다.

- 하드웨어 권장 사항OS에 새로 추가된 16GB 그래픽 메모리는 원활한 작동을 보장하는 최신 기능입니다.

비디오 및 다중 그래프 분석

- 절차::

- 다음과 같은 비디오 프레임 또는 여러 이미지를 준비합니다.

[Image.open("frame1.jpg"), Image.open("frame2.jpg")]. - 에서 추론 코드를 수정합니다.

pixel_values매개 변수는 여러 이미지의 목록입니다.

- 다음과 같은 비디오 프레임 또는 여러 이미지를 준비합니다.

- take비디오 클립 또는 연속 이미지 시퀀스를 분석합니다.

- 샘플 출력"첫 번째 프레임은 거리, 두 번째 프레임은 보행자".

다국어 OCR 지원

- 절차: 여러 언어로 된 텍스트가 포함된 이미지를 업로드하고 "이미지에서 텍스트 추출"이라는 메시지를 입력합니다.

- take문서 스캔, 이미지 텍스트 번역.

- 결과의 예중국어와 영어가 혼합된 텍스트를 추출하고 설명을 생성합니다.

향상된 추론 능력

- 절차"사진에 사람이 몇 명인가요?"와 같은 복잡한 질문을 입력하세요. 단계별로 설명해 주세요"와 같이 복잡한 질문을 입력합니다.

- take:: 교육, 데이터 분석 작업.

- 샘플 출력:: "그림에 두 사람이 있는데, 첫 번째 단계는 왼쪽에 있는 한 사람을 관찰하는 것이고 두 번째 단계는 오른쪽에 있는 두 번째 사람을 관찰하는 것입니다."라고 설명합니다.

주의

- 하드웨어 요구 사항Ovis2-1B는 4GB의 비디오 메모리가 필요하며, Ovis2-34B는 다중 GPU(48GB 이상)를 권장합니다.

- 모델 호환성메인스트림 LLM(예: Qwen2.5) 및 ViT(예: aimv2) 지원.

- 커뮤니티 피드백이슈는 GitHub 이슈에 제출할 수 있습니다.

Ovis2 이미지 역전파 프롬프트 워드 원클릭 설치 프로그램

Ovis2-4B 및 Ovis2-2B 모델 기준.

Quark: https://pan.quark.cn/s/23095bb34e7c

바이두: https://pan.baidu.com/s/12fWAbshwKY8OYcCcv_5Pkg?pwd=2727

비밀번호의 압축을 풀고 jian27에서 직접 찾으세요.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...