OpenAI는 최근 개발자가 더욱 강력하고 지능적인 음성 비서를 구축할 수 있도록 설계된 차세대 오디오 모델링 API를 출시했다고 발표했습니다. 이 이니셔티브는 음성 상호작용 기술 분야의 주요 발전으로 간주되며, 인간과 컴퓨터의 음성 상호작용이 보다 자연스럽고 효율적인 새로운 단계로 나아갈 것임을 예고합니다.

이번 릴리스에는 더욱 향상된 음성-텍스트 모델과 더욱 표현력이 뛰어난 텍스트 음성 변환 모델이라는 두 가지 주요 업데이트가 포함되어 있으며, 특히 복잡한 억양, 시끄러운 환경, 다양한 음성 속도가 있는 까다로운 시나리오에서 정확성과 신뢰성에 대한 새로운 기준을 제시한다고 OpenAI는 주장합니다. 특히 복잡한 억양, 시끄러운 환경, 다양한 음성 속도와 같은 까다로운 시나리오에서 성능 개선이 두드러집니다. 즉, 새로운 모델은 고객 콜센터나 회의록 트랜스크립션과 같은 애플리케이션에서 트랜스크립션의 품질과 효율성을 획기적으로 개선할 수 있습니다.

특히, OpenAI는 처음으로 개발자가 텍스트 음성 변환 모델에 특정 방식으로 말하도록 지시할 수 있습니다. 예를 들어 개발자는 모델을 "공감하는 고객 서비스 상담원처럼 말하기"로 설정하여 음성 비서에 전례 없는 개인화 범위를 제공할 수 있습니다. 이 기능은 보다 인간적인 고객 서비스부터 창의적인 스토리텔링에 이르기까지 다양한 시나리오를 위한 새로운 문을 열어줍니다.

OpenAI는 2022년에 첫 번째 오디오 모델인 Whisper를 출시했으며, 그 이후로 모델의 지능, 정확성 및 신뢰성을 개선하기 위해 지속적으로 투자해 왔습니다. 이번 새로운 오디오 모델 출시는 이러한 오랜 노력의 정점입니다. 이제 개발자는 API를 통해 더욱 정확한 음성-텍스트 변환 시스템을 구축할 수 있을 뿐만 아니라 더욱 독특하고 생생한 텍스트 음성 변환 사운드를 구현할 수 있습니다.

차세대 음성-텍스트 변환 모델: GPT-4O-Transcribe 및 GPT-4O-MINI-Transcribe

OpenAI는 이전 모델보다 더 최신 모델인 gpt-4o-transcribe와 gpt-4o-mini-transcribe를 새롭게 출시했습니다. Whisper 모델에서는 단어 오류율(WER), 언어 인식 및 정확도가 크게 개선되었습니다.

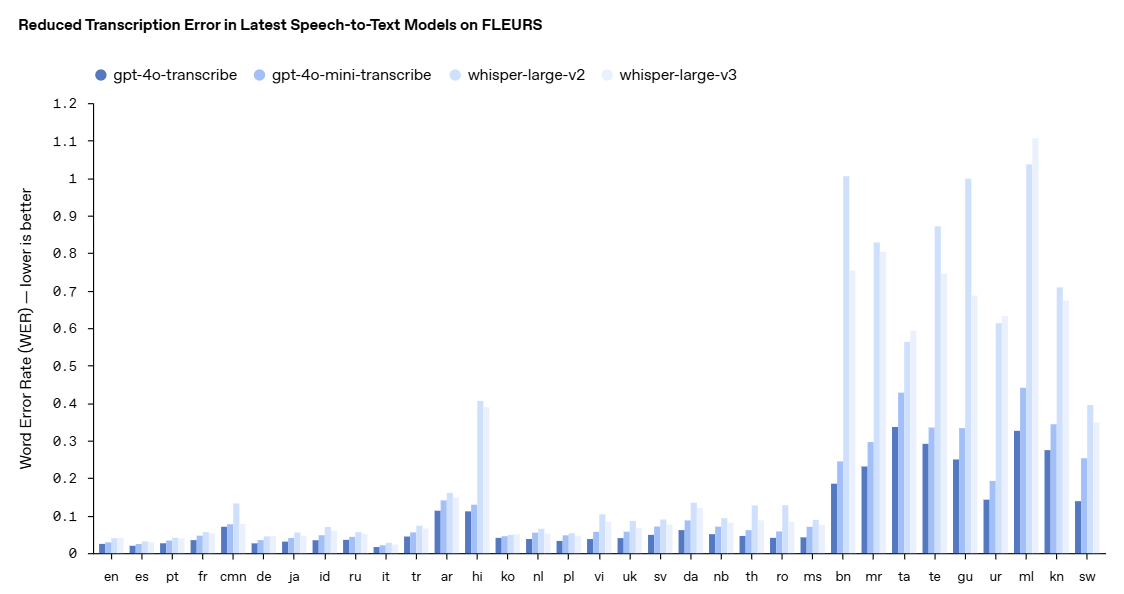

- 단어 오류율(WER)은 참조 성적표와 비교하여 잘못 전사된 단어의 비율을 계산하여 음성 인식 모델의 정확도를 측정하며, WER이 낮을수록 오류가 적다는 것을 의미합니다. 당사의 최신 음성-텍스트 변환 모델은 100개 이상의 언어에 대해 수동으로 전사된 오디오 샘플을 사용하는 다국어 음성 벤치마크인 FLEURS(학습 평가 오브 스피치 유니버설 레프리케이션 위드 소 샘플)를 비롯한 다양한 벤치마크에서 낮은 WER을 달성했습니다. 이 결과는 더 높은 전사 정확도와 더 강력한 언어 커버리지를 보여줍니다. 여기에서 볼 수 있듯이 당사 모델은 모든 언어 평가에서 Whisper v2 및 Whisper v3보다 일관되게 우수한 성능을 보였습니다.

gpt-4o-transcribe는 여러 권위 있는 벤치마크에서 Whisper 모델보다 단어 오류율이 뛰어난 성능을 입증했습니다. 단어 오류율은 음성 인식 모델의 정확도를 나타내는 주요 척도로, 값이 낮을수록 오류가 적다는 것을 의미하며 OpenAI는 이러한 개선이 다양한 고품질 오디오 데이터 세트를 사용한 강화 학습 및 대규모 중간 학습의 목표 혁신에 따른 결과라고 설명합니다.

그 결과 새로운 음성-텍스트 모델은 특히 악센트, 시끄러운 환경, 다양한 음성 속도와 같은 복잡한 상황을 처리할 때 음성 뉘앙스를 더 잘 포착하고 오인식을 줄이며 전사 안정성을 개선할 수 있습니다. 이러한 모델은 현재 음성-텍스트 변환 API에서 사용할 수 있습니다.

성능 향상을 보다 시각적으로 보여주기 위해 OpenAI는 FLEURS(Few-shot Learning Evaluation of 유니버설 수동으로 전사한 오디오 샘플을 사용하여 100개 이상의 언어를 대상으로 하는 다국어 음성 벤치마크인 FLEURS(Representations of Speech) 벤치마크의 결과입니다. 결과에 따르면 OpenAI의 새로운 모델은 언어 간 평가에서 Whisper v2와 Whisper v3보다 단어 오류율이 낮았으며, 더 높은 전사 정확도와 더 넓은 언어 커버리지를 보여주었습니다.

차세대 텍스트 음성 변환 모델: GPT-4O-MINI-TTS

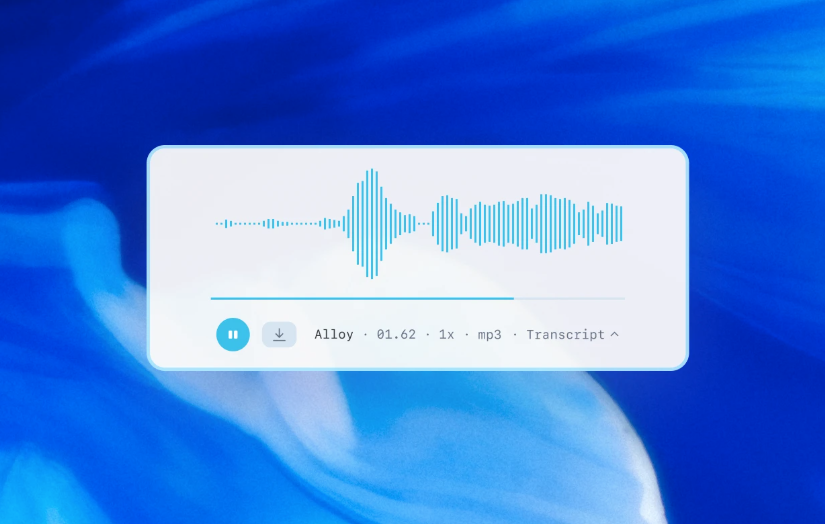

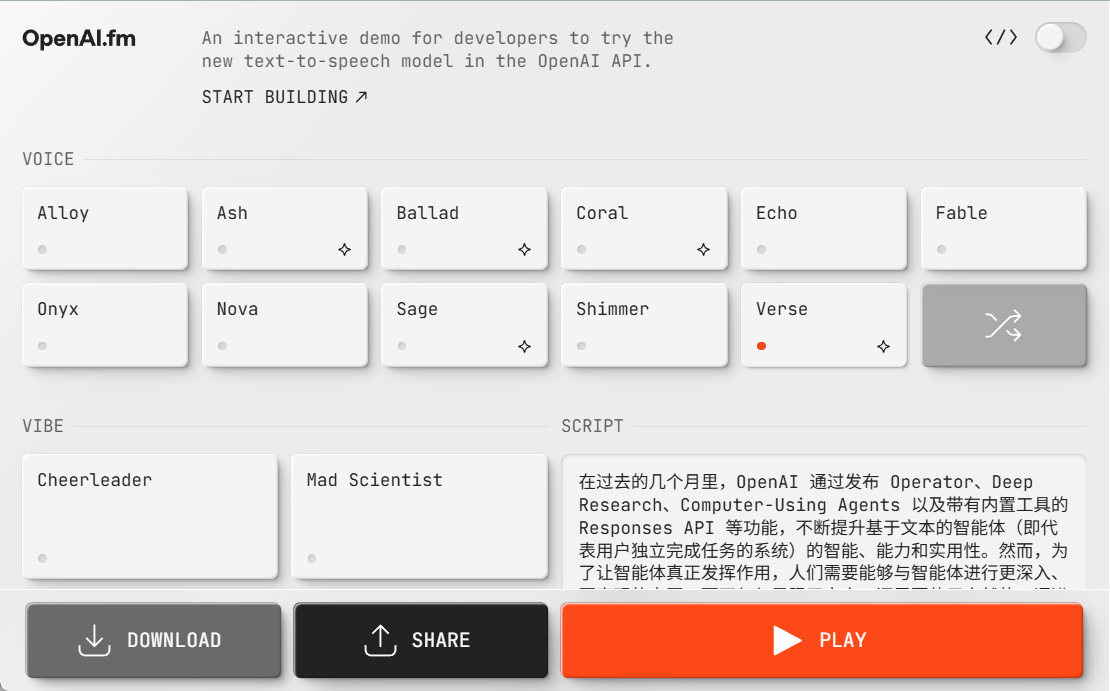

OpenAI는 음성-텍스트 모델 외에도 새로운 gpt-4o-mini-tts 텍스트-음성 모델도 도입했는데, 이 모델의 가장 큰 특징은 제어 기능이 향상되었다는 점입니다. 개발자는 모델이 말하는 내용을 제어할 수 있을 뿐만 아니라 모델에 말하는 방법도 지시할 수 있습니다. 이 기능은 고객 서비스에서 크리에이티브 콘텐츠에 이르기까지 다양한 애플리케이션을 통해 사용자 경험을 더욱 맞춤화할 수 있습니다. 이 모델은 텍스트 음성 변환 API에서도 사용할 수 있습니다. 이러한 텍스트 음성 변환 모델은 현재 사전 설정된 합성 음성으로 제한되며, OpenAI는 합성된 사전 설정과 일관성을 유지하기 위해 모니터링합니다.

여기에서 GPT-4O-MINI-TTS를 빠르게 체험해 보세요!

https://www.openai.fm/

모델 이면의 기술 혁신

OpenAI는 새로운 오디오 모델이 GPT-4o 및 GPT-4o-mini 아키텍처를 기반으로 구축되었으며, 모델 성능을 최적화하는 데 중요한 오디오 전용 데이터 세트를 사용하여 대규모로 사전 학습되었다고 밝혔습니다. 이러한 목표에 맞춘 접근 방식을 통해 모델은 음성의 미묘한 차이를 더 깊이 이해하고 다양한 오디오 관련 작업에서 탁월한 성능을 발휘할 수 있습니다.

또한 OpenAI는 대규모 오디오 모델에서 작고 효율적인 모델로 지식을 전송할 수 있도록 지식 정제 기술을 개선했습니다. 고급 셀프 게임 방법을 활용하여 개선된 데이터 세트는 실제 대화 역학을 효과적으로 포착하고 실제 사용자 어시스턴트 상호 작용 시나리오를 복제합니다. 이를 통해 소형 모델이 뛰어난 대화 품질과 반응성을 제공할 수 있습니다.

음성-텍스트 모델링을 위해 OpenAI는 강화 학습(RL) 주도 패러다임을 채택하여 전사 정확도를 한 단계 끌어올렸습니다. 이 접근 방식은 정확도를 크게 향상시키고 착각을 줄여 복잡한 음성 인식 시나리오에서 음성-텍스트 솔루션의 경쟁력을 높입니다.

이러한 기술 발전은 음성 애플리케이션의 성능 향상을 목표로 혁신적인 접근 방식과 실용적인 개선 사항을 결합한 OpenAI가 오디오 모델링 분야에서 이룬 최신의 진전입니다.

API 개방성 및 향후 전망

이 새로운 오디오 모델은 이제 모든 개발자가 사용할 수 있습니다. 이미 텍스트 모델을 사용하여 대화 환경을 구축하고 있는 개발자에게는 음성-텍스트 및 텍스트-음성 모델을 통합하는 것이 음성 비서를 구축하는 가장 쉬운 방법이며, OpenAI는 개발 프로세스를 간소화하기 위해 에이전트 SDK와의 통합도 출시했습니다. 지연 시간이 짧은 음성 대 음성 환경을 구축하려는 개발자에게는 실시간 API의 음성 대 음성 모델을 사용할 것을 권장합니다.

앞으로 OpenAI는 오디오 모델의 지능과 정확성에 더 많은 투자를 계속하고 개발자가 보안 표준을 준수하면서 맞춤형 사운드를 도입해 더욱 개인화된 경험을 구축할 수 있는 방법을 모색할 계획입니다. 또한 OpenAI는 정책 입안자, 연구원, 개발자, 크리에이터들과 합성 사운드가 제시할 수 있는 도전과 기회에 대해 적극적으로 대화하고 있으며, 개발자들이 이러한 향상된 오디오 기능을 사용하여 구축할 혁신적인 애플리케이션에 대해 기대하고 있으며, 개발자들이 멀티 모달 인텔리전트 경험을 구축할 수 있도록 지원하기 위해 비디오를 포함한 다른 양식에 지속적으로 투자할 것이라고 말했습니다.

OpenAI의 차세대 오디오 모델 API 출시는 의심할 여지 없이 음성 인터랙션 기술 개발에 새로운 활력을 불어넣었습니다. 기술의 지속적인 발전과 점점 더 풍부한 애플리케이션 시나리오로 인해 디지털 세상의 미래는 더욱 '듣고 말할 수 있는' 세상이 될 것이며, 인간과 컴퓨터의 상호 작용이 더욱 자연스럽고 원활해질 것이라고 믿어 의심치 않습니다.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...