일반 소개

Ollama 딥 리서처는 LangChain 팀이 개발한 완전한 네이티브 실행 웹 리서치 및 보고서 생성 도우미입니다. Ollama에서 호스팅하는 임의의 대규모 언어 모델(LLM)을 사용하여 사용자가 연구 주제를 입력하면 자동으로 웹 검색 쿼리를 생성하고, 정보를 수집하고, 내용을 요약하고, 소스가 포함된 마크다운 보고서를 생성합니다. 전체 프로세스는 외부 모델을 호출하기 위해 인터넷에 연결할 필요 없이 수행되므로 개인정보가 보호되며 추가 비용도 들지 않습니다. 덕덕고, 타빌리 또는 당혹감 및 기타 검색 도구와 함께 심층적인 조사가 필요한 사용자에게 적합한 조사 주기를 사용자 지정하고 구조화된 보고서를 생성할 수 있습니다. 설치가 간편하고 오픈 소스이며 무료입니다.

기능 목록

- 로컬 운영 언어 모델(LOLM)외부 API 없이 Ollama를 통해 네이티브 LLM을 사용합니다.

- 검색어 자동 생성사용자 테마를 기반으로 정확한 웹 검색어를 생성합니다.

- 웹 정보 수집덕덕고(기본값), 타빌리 또는 퍼플렉서티 검색을 지원합니다.

- 콘텐츠 요약 및 최적화검색 결과를 분석하고, 부족한 부분을 파악하여 요약을 개선하세요.

- 마크다운 보고서 생성모든 소스 인용이 포함된 구조화된 보고서를 출력합니다.

- 연구 깊이 사용자 지정: 사용자가 주기 수를 설정하고 학습 세부 수준을 제어할 수 있습니다.

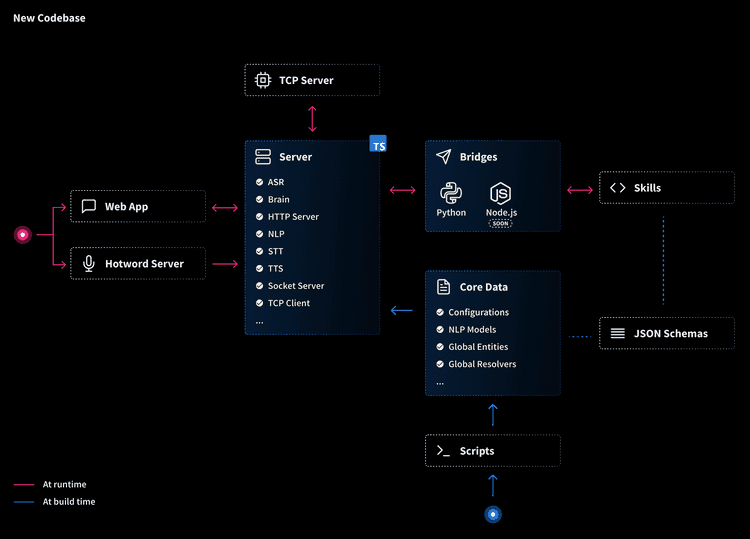

- 워크플로 시각화통해 LangGraph 스튜디오 작업의 각 단계를 확인합니다.

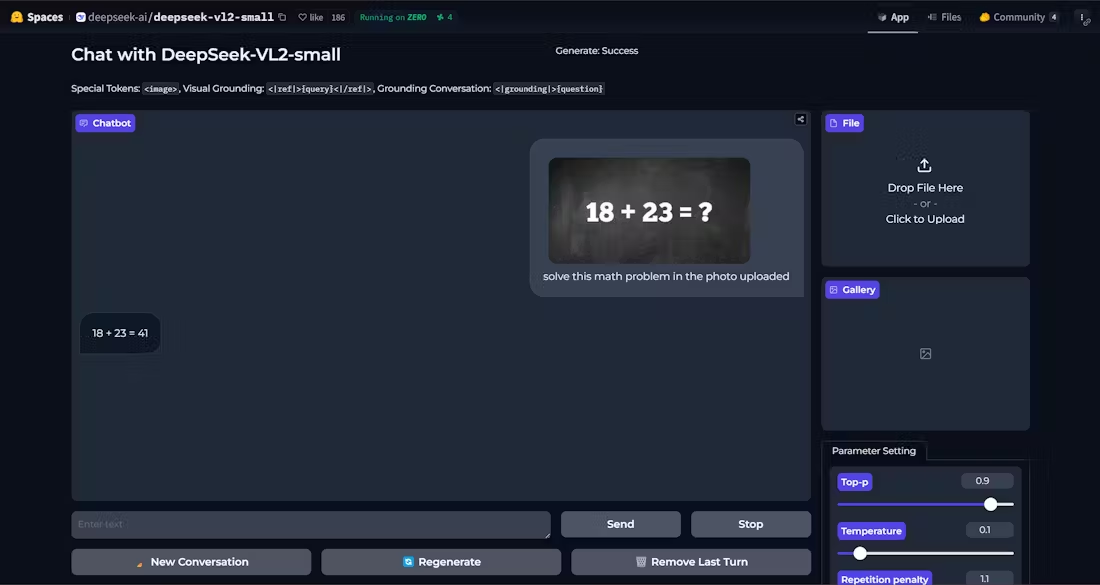

- 여러 모델 지원호환 가능 DeepSeek R1, Llama 3.2 및 기타 모델.

도움말 사용

설치 프로세스

올라마 딥 리서처는 로컬 환경 지원이 필요합니다. 다음은 Mac 및 Windows 사용자를 위한 자세한 단계입니다.

Mac 사용자

- 올라마 설치

- Ollama 웹사이트를 방문하여 Mac 버전의 설치 프로그램을 다운로드하세요.

- 설치 후 터미널을 실행합니다.

ollama --version버전을 확인합니다.

- 풀 모델

- 터미널에 입력합니다:

ollama pull deepseek-r1:8b권장 모델을 다운로드하세요. - 또한 사용 가능

ollama pull llama3.2.

- 터미널에 입력합니다:

- 복제 프로젝트

- 다음 명령을 실행합니다:

git clone https://github.com/langchain-ai/ollama-deep-researcher.git cd ollama-deep-researcher

- 다음 명령을 실행합니다:

- 가상 환경 만들기(권장)

- Python 3.9 이상이 설치되어 있는지 확인합니다. 실행합니다:

python -m venv .venv source .venv/bin/activate

- Python 3.9 이상이 설치되어 있는지 확인합니다. 실행합니다:

- 종속성 설치 및 시작

- 입력:

curl -LsSf https://astral.sh/uv/install.sh | sh uvx --refresh --from "langgraph-cli[inmem]" --with-editable . --python 3.11 langgraph dev - 브라우저를 실행하면 LangGraph Studio(기본값)가 열립니다.

http://127.0.0.1:2024).

- 입력:

Windows 사용자

- 올라마 설치

- 올라마 웹사이트에서 Windows 버전을 다운로드하세요.

- 설치 후 명령줄이 실행됩니다.

ollama --version유효성 검사.

- 풀 모델

- 입력:

ollama pull deepseek-r1:8b.

- 입력:

- 복제 프로젝트

- 실행 중입니다:

git clone https://github.com/langchain-ai/ollama-deep-researcher.git cd ollama-deep-researcher

- 실행 중입니다:

- 가상 환경 만들기

- 파이썬 3.11을 설치("경로에 추가"를 체크한 상태)하고 실행합니다:

python -m venv .venv .venv\Scripts\Activate.ps1

- 파이썬 3.11을 설치("경로에 추가"를 체크한 상태)하고 실행합니다:

- 종속성 설치 및 시작

- 입력:

pip install -e . pip install -U "langgraph-cli[inmem]" langgraph dev - 출시 후 액세스

http://127.0.0.1:2024.

- 입력:

구성 검색 도구(선택 사항)

- DuckDuckGo는 기본적으로 사용되며 API 키가 필요하지 않습니다.

- 만약 Tavily 또는 퍼플렉서티:

- 복사본 만들기

.env.example때문에.env. - 컴파일러

.env키를 추가합니다:TAVILY_API_KEY=your_tavily_key PERPLEXITY_API_KEY=your_perplexity_key - 선택적 구성:

OLLAMA_BASE_URL(기본값)http://localhost:11434).MAX_WEB_RESEARCH_LOOPS(기본값 3).

- 복사본 만들기

사용 방법

- LangGraph Studio 열기

- 서비스를 시작한 후

http://127.0.0.1:2024. - 인터페이스는 왼쪽과 오른쪽 열로 나뉘며 왼쪽에는 구성, 오른쪽에는 입력 및 결과가 표시됩니다.

- 서비스를 시작한 후

- 구성 매개변수

- 검색 도구덕덕고, 타블리 또는 퍼플렉시티 중에서 선택하세요.

- 모델링: 다운로드한 모델의 이름을 입력합니다(예

deepseek-r1:8b). - 주기 횟수학습 깊이 설정, 기본값은 3배입니다.

- 구성을 저장합니다.

- 테마 입력

- 오른쪽의 입력 상자에 '머신 러닝의 미래'와 같은 연구 주제를 입력합니다.

- 연구를 시작하려면 '실행'을 클릭합니다.

- 프로세스 및 결과 보기

- Studio는 쿼리 생성, 검색, 요약 등 각 단계를 표시합니다.

- 완료되면 마크다운 보고서가 프로젝트 폴더의 그래프 상태에 저장됩니다.

주요 기능 작동

- 연구 깊이 조정하기

- 구성 변경

MAX_WEB_RESEARCH_LOOPS횟수를 5로 설정하면 결과는 더 포괄적이지만 시간이 더 많이 소요됩니다.

- 구성 변경

- 검색 도구 토글

- DuckDuckGo 무료이지만 제한된 결과, Tavily 더 자세한 정보(키 필요). 전환 후 서비스를 다시 시작하세요.

- 모델 호환성 확인

- 오류가 보고된 경우(예

KeyError: 'query'), 모델이 JSON 출력을 지원하지 않음을 나타냅니다. 로 전환 DeepSeek R1 (8B) 또는 Llama 3.2.

- 오류가 보고된 경우(예

주의

- 하드웨어 요구 사항8B 모델의 경우 8GB, 13B 모델의 경우 16GB의 메모리가 필요합니다.

- 브라우저 호환성파이어폭스 권장, 사파리에는 보안 경고가 표시될 수 있습니다.

- 오류 감지멈춘 경우 터미널 로그를 확인하여 종속성을 업데이트하거나 모델을 변경해야 할 수 있습니다.

애플리케이션 시나리오

- 학술 연구

- 장면 설명학생들이 '신경망 최적화 방법'을 입력하면 도구가 인용이 포함된 보고서를 검색하고 생성하므로 정보 검색 시간을 절약할 수 있습니다.

- 산업 분석

- 장면 설명2025년까지의 AI 시장 동향"을 통해 의사결정에 도움이 되는 자세한 요약을 확인할 수 있습니다.

- 기술 학습

- 장면 설명개발자가 "파이썬 비동기 프로그래밍"을 입력하면 도구에서 튜토리얼 보고서를 생성하여 자가 학습을 용이하게 합니다.

QA

- 네트워킹을 해야 하나요?

- 로컬 모델은 인터넷 연결이 필요하지 않지만 웹 검색에는 인터넷 연결이 필요합니다. 오프라인인 경우 기존 데이터만 사용할 수 있습니다.

- 중국어를 지원하나요?

- 지원. 중국어 테마를 입력하면 중국어 검색 결과가 생성되지만 검색 도구에 따라 효과가 달라집니다.

- 보고서를 수정할 수 있나요?

- 마크다운 파일을 직접 편집할 수 있습니다.

- JSON 오류가 발생하면 어떻게 해야 하나요?

- 이는 모델이 구조화된 출력을 지원하지 않음을 의미합니다. DeepSeek R1(8B) 또는 Llama 3.2로 다시 시도하세요.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...