실제 세계, 긴 텍스트, 다중 작업에서 '깊은 이해와 추론'을 위한 빅 모델 평가하기

최근 몇 년 동안 긴 텍스트를 위한 대규모 언어 모델 연구에서 상당한 진전이 이루어졌으며, 모델의 컨텍스트 창 길이가 초기 8k에서 128k 또는 1백만 토큰까지 확장되었습니다. 그러나 여전히 중요한 질문이 남아 있습니다: 이러한 모델이 처리하는 긴 텍스트를 진정으로 이해할 수 있을까요? 즉, 긴 텍스트의 정보를 바탕으로 심층적으로 이해하고 학습하며 추론할 수 있을까요?

이 질문에 답하고 심층 이해와 추론을 위한 긴 텍스트 모델의 발전을 추진하기 위해 칭화대학교와 스마트 스펙트럼의 연구팀은 실제 긴 텍스트 멀티태스킹에서 LLM의 심층 이해와 추론 능력을 평가하도록 설계된 벤치마크 테스트인 LongBench v2를 출시했습니다.

긴 텍스트 시나리오에서 추론 시간 계산(예: o1 모델)을 확장하는 것이 어떻게 심층 이해 및 추론 문제를 해결하는 데 도움이 될 수 있는지에 대한 탐구가 LongBench v2를 통해 진전될 것으로 믿습니다.

특수성

LongBench v2에는 긴 텍스트 이해에 대한 기존 벤치마크보다 몇 가지 중요한 기능이 추가되었습니다:

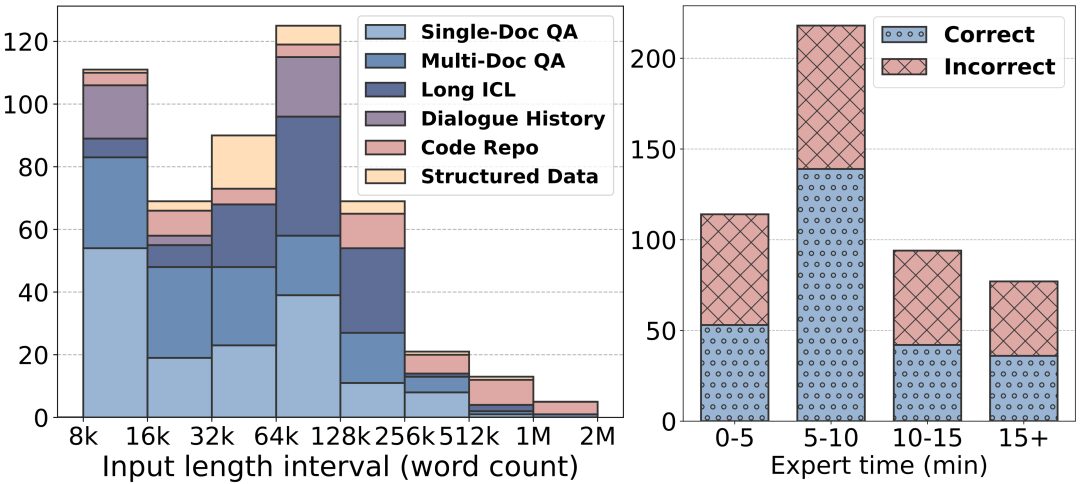

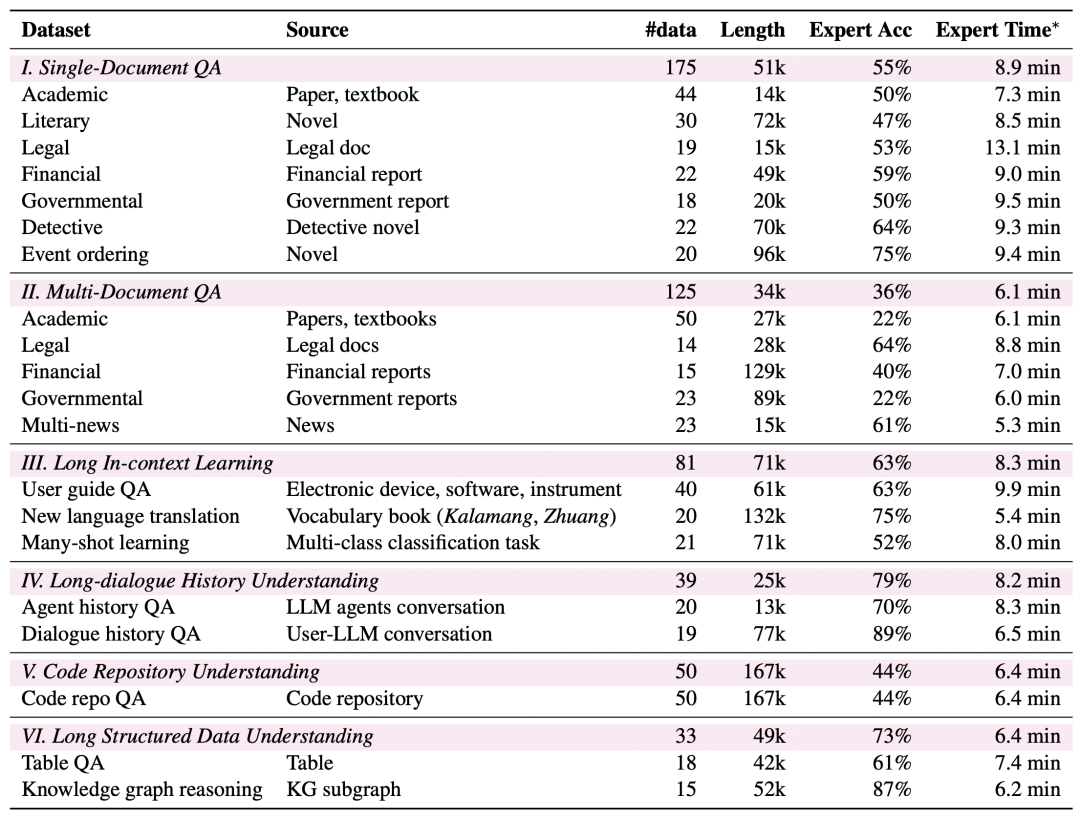

긴 텍스트 길이: LongBench v2의 텍스트 길이는 8k에서 2백만 단어까지 다양하며, 대부분의 텍스트 길이는 128k 미만입니다.

높은 난이도: LongBench v2에는 문서 내 검색 도구를 사용하는 인간 전문가도 단시간에 정답을 맞히기 어려운 503개의 고난도 4지 선다형 문제가 포함되어 있습니다. 인간 전문가들은 15분이라는 제한 시간 동안 평균 53.71 TP3T(무작위 251 TP3T)의 정확도만을 기록했습니다.

광범위한 작업 범위: LongBench v2는 단일 문서 퀴즈, 다중 문서 퀴즈, 긴 텍스트 문맥 학습, 긴 대화 기록 이해, 코드 저장소 이해, 긴 구조화된 데이터 이해 등 6가지 주요 작업 범주와 다양한 실제 시나리오를 다루는 총 20가지 하위 작업을 지원합니다.

더 높은 신뢰성: 평가의 신뢰성을 보장하기 위해 LongBench v2의 모든 문제는 객관식 형식으로 되어 있으며, 데이터의 높은 품질을 보장하기 위해 엄격한 수동 라벨링 및 검토 프로세스를 거칩니다.

데이터 수집 프로세스

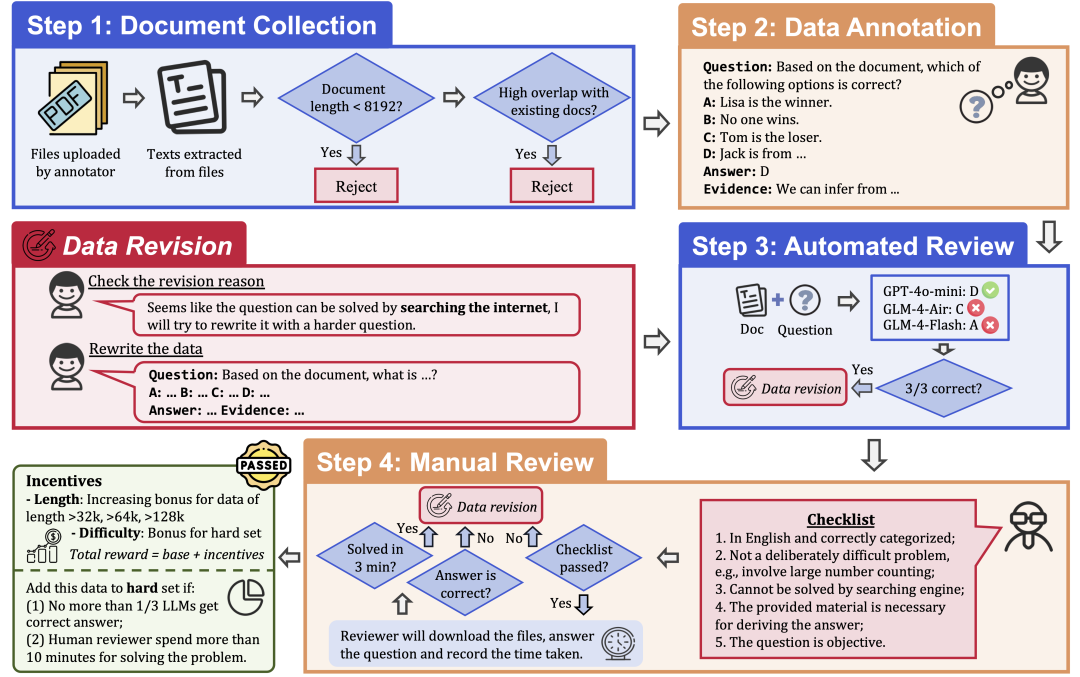

데이터의 품질과 난이도를 보장하기 위해 LongBench v2는 다음 단계로 구성된 엄격한 데이터 수집 프로세스를 채택하고 있습니다:

문서 수집: 다양한 학력과 학점을 가진 명문대 출신 97명의 주석가들을 모집하여 연구 논문, 교과서, 소설 등 개인적으로 읽거나 사용한 장문의 문서를 수집합니다.

데이터 라벨링: 수집된 문서를 기반으로 라벨러는 네 가지 옵션, 정답 및 해당 증거가 포함된 객관식 질문을 던집니다.

자동 검토: 주석이 달린 데이터는 128k 컨텍스트 창이 있는 3개의 LLM(GPT-4o-mini, GLM-4-Air, GLM-4-Flash)을 사용하여 자동으로 검토되었으며, 세 모델 모두 질문에 정답을 맞히면 문제가 너무 단순하여 다시 라벨을 붙일 필요가 있는 것으로 간주했습니다.

인적 검토: 자동 검토를 통과한 데이터는 24명의 전문 인력 전문가가 해당 질문에 대한 답변을 시도하고 질문이 적절한지, 답변이 정답인지 판단하는 인적 검토에 배정됩니다. 전문가가 3분 이내에 질문에 올바르게 답변할 수 있는 경우, 질문이 너무 간단한 것으로 간주되어 라벨을 다시 지정해야 합니다. 또한 전문가가 질문 자체가 부적절하거나 정답이 틀렸다고 판단하는 경우에는 다시 채점하도록 반려됩니다.

데이터 수정: 감사를 통과하지 못한 데이터는 모든 감사 단계를 통과할 때까지 수정할 수 있도록 주석 작성자에게 반환됩니다.

평가 결과

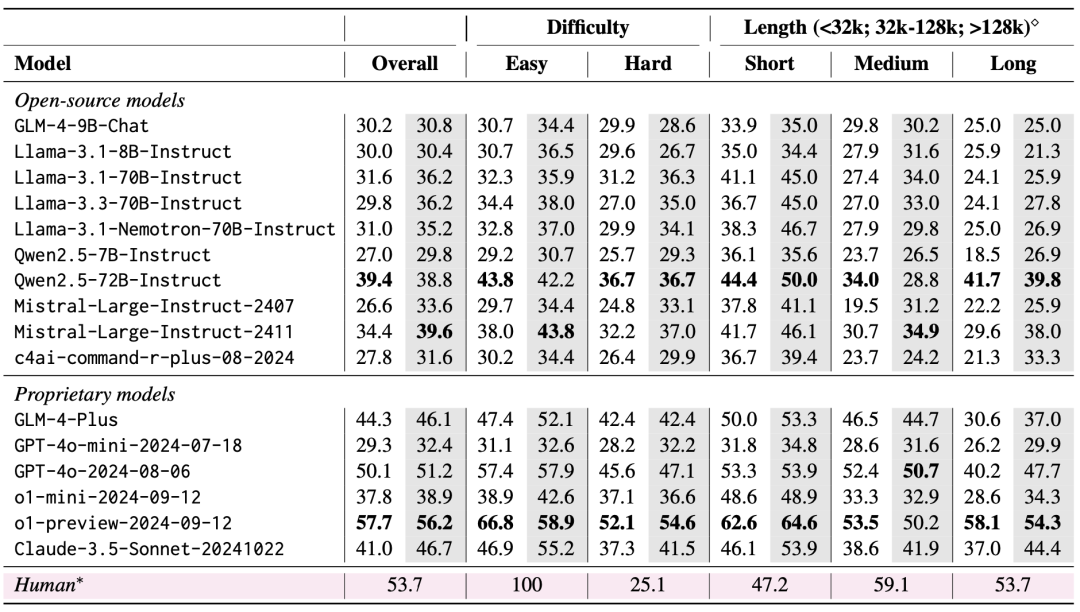

평가에는 제로 샷과 제로 샷+CoT(즉, 모델이 먼저 생각의 사슬을 출력하게 한 다음 선택한 답을 출력하게 하는 방식)의 두 가지 시나리오가 고려되었습니다.

평가 결과, 가장 성능이 좋은 모델도 직접 답변 출력에서 50.1%의 정확도만 달성한 반면, 더 긴 추론 체인을 도입한 o1-preview 모델은 57.7%의 정확도를 달성하여 인간 전문가를 4% 앞서는 것으로 나타나, LongBench v2가 현재 LLM에 큰 도전 과제임을 보여주었습니다. 4%.

1. 추론 시간 계산 확장의 중요성

평가 결과에서 매우 중요한 발견은 추론 시간 계산을 확장함으로써 LongBench v2의 모델 성능을 크게 향상시킬 수 있다는 것입니다. 예를 들어, o1-preview 모델은 GPT-4o에 비해 더 많은 추론 단계를 통합하여 다중 문서 퀴즈, 긴 텍스트 문맥 학습 및 코드 저장소 이해와 같은 작업에서 상당한 개선을 달성했습니다.

이는 LongBench v2가 현재 모델의 추론 능력에 더 많은 요구를 하고 있으며, 추론에 대해 생각하고 추론하는 데 소요되는 시간을 늘리는 것이 이러한 긴 텍스트 추론 문제를 해결하는 데 자연스럽고 중요한 단계인 것으로 보입니다.

2. RAG + 긴 컨텍스트 실험

검색된 블록 수가 특정 임계값(32k 토큰, 512 길이의 약 64개 블록)을 초과하면 두 모델 모두 성능이 크게 향상되지 않거나 심지어 저하되는 것으로 나타났습니다.

이는 단순히 검색되는 정보의 양을 늘리는 것이 항상 성능 향상으로 이어지는 것은 아니라는 것을 시사합니다. 이와는 대조적으로, GPT-4o는 최적의 검색 컨텍스트를 통해 더 긴 검색 컨텍스트를 효율적으로 활용할 수 있습니다. RAG 성능은 128k 검색 길이에서 발생합니다.

요약하자면, RAG는 깊은 이해와 추론이 필요한 긴 텍스트 Q&A 작업, 특히 검색된 블록의 수가 특정 임계값을 초과하는 경우 사용이 제한적입니다. 모델에 검색된 정보에만 의존하는 것이 아니라 더 강력한 추론 기능이 있어야 LongBench v2의 까다로운 문제를 효과적으로 처리할 수 있습니다.

이는 향후 연구 방향도 외부 검색에만 의존하는 것이 아니라 모델 자체의 긴 텍스트 이해력과 추론 능력을 향상시키는 방법에 더 집중해야 한다는 것을 의미합니다.

긴 텍스트 이해와 추론 기술의 한계를 뛰어넘을 것으로 기대되는 LongBench v2. 백서를 읽고 데이터를 사용해 자세히 알아보세요!

홈페이지: https://longbench2.github.io

논문: https://arxiv.org/abs/2412.15204

데이터 및 코드: https://github.com/THUDM/LongBench

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...