일반 소개

LM Speed는 AI 개발자를 위해 특별히 설계된 도구로, lmspeed.net에서 온라인 서비스로 제공됩니다. 핵심 기능은 언어 모델 API의 성능을 테스트하고 분석하여 사용자가 속도 병목 현상을 신속하게 파악하고 호출 전략을 최적화할 수 있도록 지원하는 것입니다. 이 도구는 OpenAI API를 비롯한 다양한 인터페이스를 지원하며 실시간 데이터 모니터링과 상세한 성능 보고서를 제공합니다. 개인 개발자이든 팀 단위든 LM Speed를 사용하면 직관적인 데이터 차트와 자동화된 테스트를 통해 다양한 모델과 공급업체의 성능을 쉽게 비교할 수 있습니다.

기능 목록

- 실시간 성능 모니터링: 초당 처리량과 같은 다차원 데이터를 표시합니다. 토큰 번호(TPoS).

- 종합적인 성능 평가: 첫 번째 토큰 지연 시간, 응답 시간 등과 같은 핵심 지표를 측정합니다.

- 데이터 시각화: 다양한 차트를 생성하여 성능 추세를 시각화하세요.

- 자동화된 스트레스 테스트: 5회 연속 테스트를 통해 신뢰할 수 있는 데이터를 확보합니다.

- 원클릭 보고서 생성: 전문적인 테스트 보고서를 자동으로 생성하고 내보내기 및 공유를 지원합니다.

- URL 매개변수에 대한 빠른 테스트: 수동 입력 없이 링크에서 바로 테스트를 실행합니다.

- 과거 데이터 저장: 테스트 결과를 기록하고 추세 분석을 지원합니다.

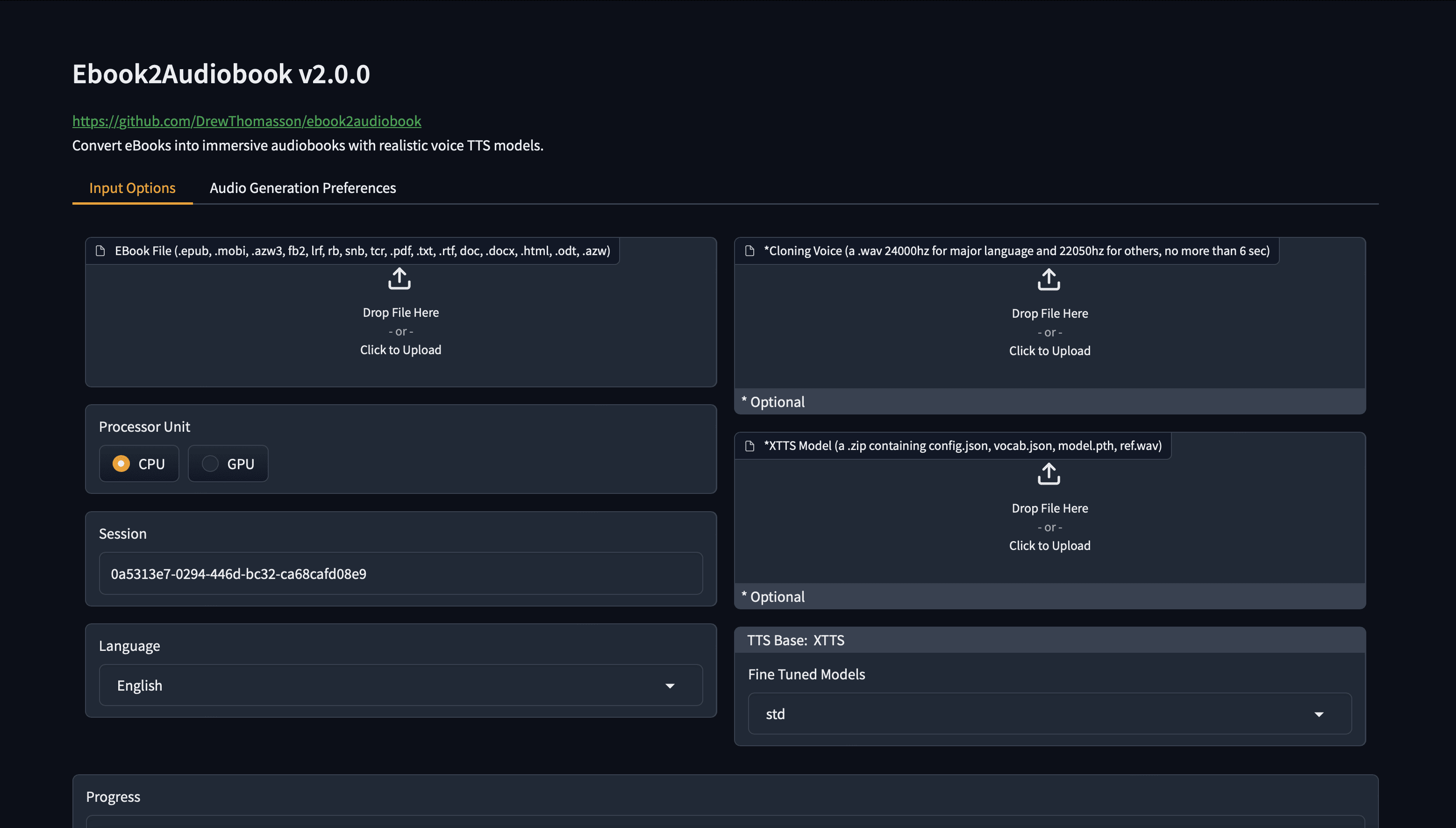

도움말 사용

온라인 서비스 사용

- 웹사이트에 액세스

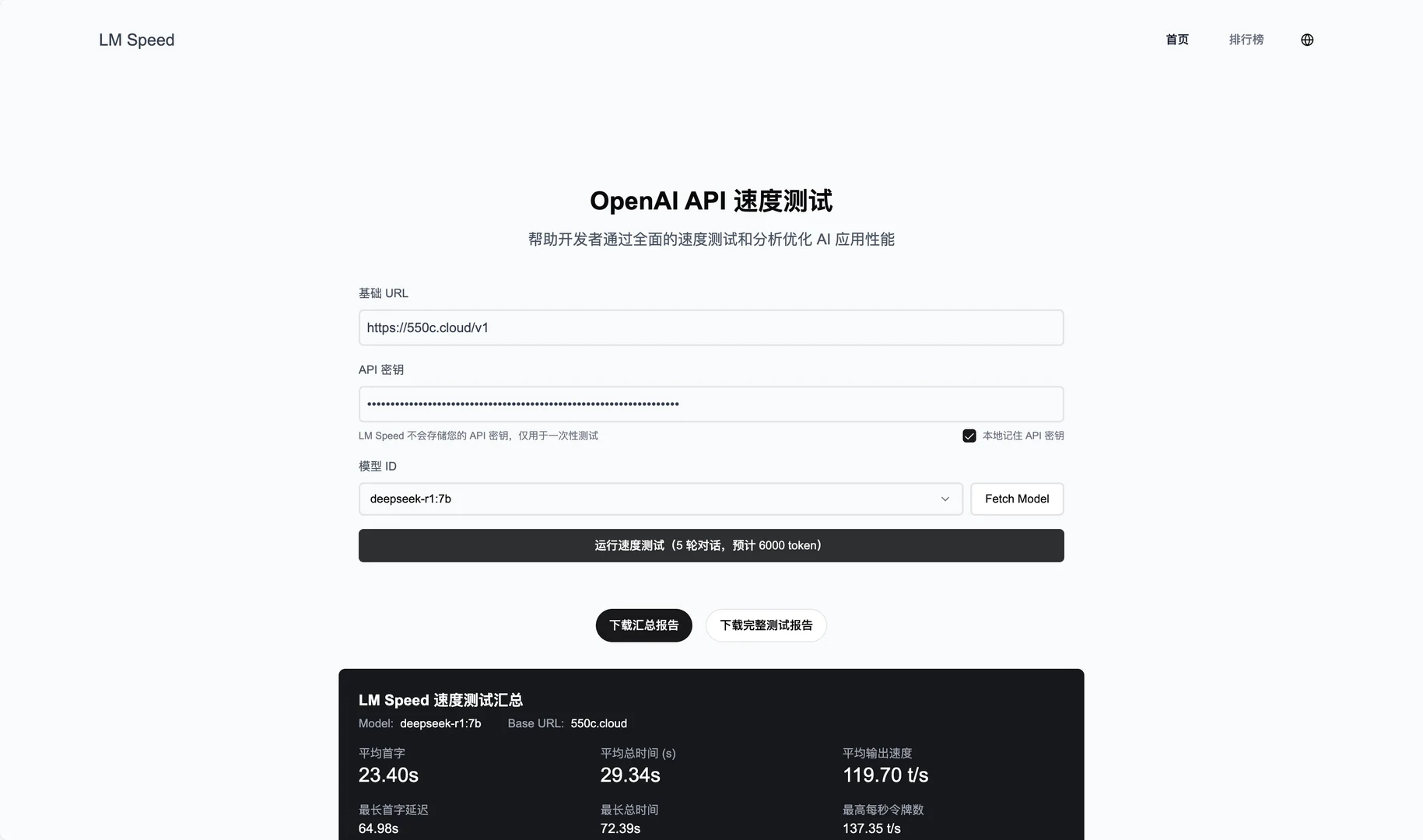

브라우저를 열고 https://lmspeed.net 으로 이동합니다. - 테스트 매개변수 입력

페이지 양식에 다음 정보를 입력하세요:baseUrlAPI 서비스 주소(예https://api.deepseek.com/v1.apiKeyAPI 키.modelId테스트할 모델의 ID, 예를 들어free:QwQ-32B.

- 시작 테스트

"테스트 시작" 버튼을 클릭하면 시스템이 자동으로 5번의 스트레스 테스트를 실행합니다. 테스트가 진행되는 동안 TPoS 및 응답 시간을 포함한 실시간 데이터 업데이트를 확인할 수 있습니다. - 결과 보기

테스트가 완료되면 페이지에 첫 토큰 지연 시간 및 평균 성능과 같은 자세한 그래프와 메트릭이 표시됩니다. '보고서 생성' 버튼을 클릭하여 PDF를 다운로드하거나 팀과 공유할 수 있습니다. - URL 매개변수 빠른 테스트

수동으로 입력하지 않으려면 링크를 사용하여 바로 테스트를 시작할 수 있습니다. 예시:

https://lmspeed.net/?baseUrl=https://api.suanli.cn/v1&apiKey=sk-你的密钥&modelId=free:QwQ-32B

링크를 열면 테스트가 자동으로 시작됩니다. 참고: 보안상의 이유로 URL에 API 키를 직접 전달하지 않는 것이 좋습니다.

로컬 배포 설치 프로세스

- 환경 준비하기

컴퓨터에 Git, Node.js(v16 이상 권장), Docker 및 Docker Compose가 설치되어 있는지 확인하고, 설치되어 있지 않은 경우 먼저 다운로드하여 설치하세요. - 클론 창고

터미널을 열고 다음 명령을 입력하여 코드를 다운로드합니다:

git clone https://github.com/nexmoe/lm-speed.git

cd lm-speed

- 도커 배포

- 설정

docker-compose.yml파일에 공식적으로 제공된 코드를 복사합니다:version: '3.8' services: app: image: nexmoe/lmspeed:latest ports: - "8650:3000" environment: - DATABASE_URL=postgresql://postgres:postgres@db:5432/nexmoe - NODE_ENV=production depends_on: - db restart: always db: image: postgres:16 restart: always environment: POSTGRES_USER: postgres POSTGRES_PASSWORD: postgres POSTGRES_DB: nexmoe volumes: - postgres_data:/var/lib/postgresql/data volumes: postgres_data: - 터미널에서 실행됩니다:

docker-compose up -d - 배포에 성공하면

http://localhost:8650서비스 보기.

- 수동 배포

- 종속성을 설치합니다:

npm install - 환경 변수를 복사하고 구성합니다:

cp .env.example .env컴파일러

.env파일을 열고 데이터베이스 주소와 API 구성을 입력합니다. - 서비스를 시작합니다:

npm run dev - 인터뷰

http://localhost:3000.

주요 기능 작동

- 실시간 모니터링

온라인 테스트 시 페이지에 TPoS 및 응답 시간 변경 사항이 동적으로 표시됩니다. 마우스로 그래프 위로 마우스를 가져가면 정확한 값을 확인할 수 있습니다. - 자동화된 테스트

'테스트 시작'을 클릭하면 시스템이 자동으로 5라운드의 테스트를 진행합니다. 각 라운드의 결과가 기록되고 마지막에 평균값과 변동 범위가 생성되어 API의 안정성을 판단하는 데 도움이 됩니다. - 보고서 내보내기

테스트가 완료되면 '보고서 내보내기'를 클릭하고 PDF 형식을 선택합니다. 보고서에는 테스트 환경, 성능 메트릭 및 그래프가 포함되어 있으며 팀 공유 또는 보관에 적합합니다. - 과거 데이터 분석

온라인 서비스는 테스트 기록을 보관합니다. 로그인한 후 '기록' 페이지로 이동하여 이전 테스트 결과와 성능 추세를 확인하세요.

주의

- API 키가 유효한지 확인하지 않으면 테스트가 실패합니다.

- 로컬에 배포하는 경우 방화벽에 열린 포트(기본값 3000 또는 8650)가 있는지 확인합니다.

- 차트가 느리게 로드되는 경우 네트워크 문제가 있을 수 있으므로 페이지를 새로고침하고 다시 시도하는 것이 좋습니다.

이 단계를 통해 LM Speed를 사용하여 온라인 또는 로컬에서 언어 모델링 API의 성능을 테스트할 수 있습니다. 조작이 간단하고 결과가 명확하며 매우 유용합니다.

애플리케이션 시나리오

- 개발자가 선택하는 API 서비스

LM Speed로 개발자 테스트 DeepSeek 및 Silicon Flow와 같은 API를 사용하여 프로젝트에 가장 적합한 공급업체를 선택할 수 있습니다. - 팀 최적화 모델 호출

AI 팀은 이를 사용하여 부하가 높은 API의 성능을 모니터링하고 호출 전략을 조정하여 애플리케이션 효율성을 개선합니다. - 연구원들이 성능 변동을 분석합니다.

- 연구진은 학술 보고서를 작성하기 위해 다섯 차례의 테스트와 과거 데이터를 통해 다양한 조건에서 모델 성능의 변화를 연구했습니다.

QA

- LM Speed는 어떤 API를 지원하나요?

주로 딥서치, 수안리 등과 같은 OpenAI 형식의 API를 지원합니다. API가 OpenAI SDK와 호환되는 한 테스트할 수 있습니다. - 불안정한 테스트 결과는 어떻게 되나요?

네트워크 연결이 안정적인지 확인하거나 테스트 라운드 횟수를 늘립니다(로컬 배포를 위해 코드를 수정할 수 있음). 결과의 변동 폭이 크다면 API 제공업체에 문제가 있을 수 있습니다. - 결제해야 하나요?

온라인 서비스는 현재 무료이지만 기능이 제한될 수 있습니다. 로컬 배포는 완전히 무료이며 코드는 오픈 소스입니다.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...