일반 소개

LlamaEdge는 로컬 또는 엣지 디바이스에서 대규모 언어 모델(LLM)을 실행하고 미세 조정하는 프로세스를 간소화하기 위해 설계된 오픈 소스 프로젝트입니다. 이 프로젝트는 Llama2 모델 제품군을 지원하며 사용자가 손쉽게 LLM 추론 애플리케이션을 만들고 실행할 수 있는 OpenAI 호환 API 서비스를 제공합니다. LlamaEdge는 Rust 및 Wasm 기술 스택을 활용하여 AI 추론을 위한 강력한 대안을 제공합니다. 사용자는 간단한 명령줄 작업으로 모델을 빠르게 실행하고 필요에 따라 미세 조정 및 확장할 수 있습니다.

기능 목록

- 로컬에서 LLM 실행로컬 또는 엣지 디바이스에서 라마2 시리즈 모델 실행 지원.

- OpenAI 호환 API 서비스채팅, 음성-텍스트, 텍스트-음성, 이미지 생성 등을 지원하는 OpenAI API 호환 서비스 엔드포인트를 제공합니다.

- 크로스 플랫폼 지원다양한 CPU 및 GPU 장치를 지원하며 크로스 플랫폼 Wasm 애플리케이션을 제공합니다.

- 빠른 시작간단한 명령줄 작업을 통해 모델을 빠르게 다운로드하고 실행할 수 있습니다.

- 미세 조정 및 확장사용자는 특정 요구 사항을 충족하기 위해 필요에 따라 소스 코드를 수정하고 확장할 수 있습니다.

- 문서 및 튜토리얼사용자가 빠르게 시작할 수 있도록 자세한 공식 문서와 튜토리얼이 제공됩니다.

도움말 사용

설치 프로세스

- WasmEdge 설치먼저 다음 명령줄을 통해 WasmEdge를 설치해야 합니다:

curl -sSf https://raw.githubusercontent.com/WasmEdge/WasmEdge/master/utils/install_v2.sh | bash

- LLM 모델 파일 다운로드메타 라마 3.2 1B 모델을 예로 들어 다음 명령을 사용하여 다운로드합니다:

curl -LO https://huggingface.co/second-state/Llama-3.2-1B-Instruct-GGUF/resolve/main/Llama-3.2-1B-Instruct-Q5_K_M.gguf

- 라마에이지 CLI 채팅 앱 다운로드다음 명령을 사용하여 크로스 플랫폼 Wasm 애플리케이션을 다운로드합니다:

curl -LO https://github.com/second-state/LlamaEdge/releases/latest/download/llama-chat.wasm

- 채팅 애플리케이션 실행하기다음 명령을 사용하여 LLM과 채팅합니다:

wasmedge --dir .:. --nn-preload default:GGML:AUTO:Llama-3.2-1B-Instruct-Q5_K_M.gguf llama-chat.wasm -p llama-3-chat

기능 작동 흐름

- API 서비스 시작하기API 서비스는 다음 명령어로 시작할 수 있습니다:

wasmedge --dir .:. --env API_KEY=your_api_key llama-api-server.wasm --model-name llama-3.2-1B --prompt-template llama-chat --reverse-prompt "[INST]" --ctx-size 32000

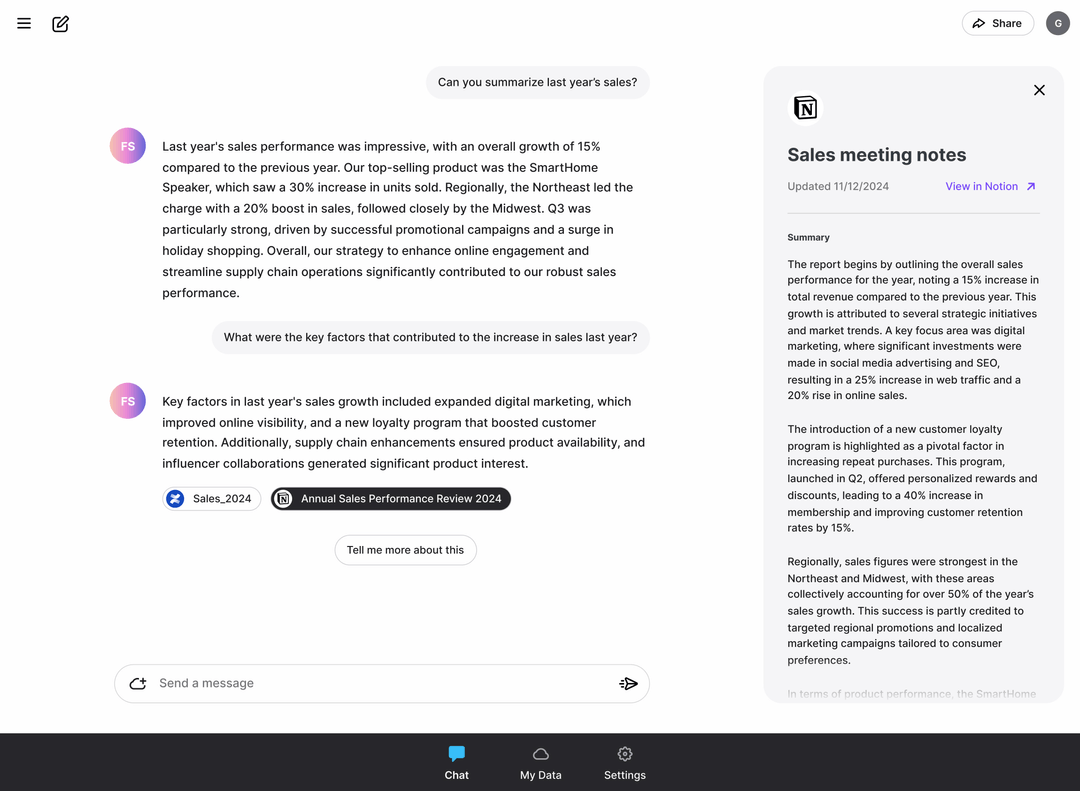

- 웹 인터페이스를 사용하여 LLM과 상호 작용하기API 서비스를 시작한 후 웹 인터페이스를 통해 로컬 LLM과 상호 작용할 수 있습니다.

- 사용자 지정 API 서비스 만들기음성-텍스트, 텍스트-음성, 이미지 생성 등 필요에 따라 사용자 지정 API 서비스 엔드포인트를 만들 수 있습니다.

- 미세 조정 및 확장사용자는 특정 기능 요구 사항을 충족하기 위해 소스 코드의 구성 파일과 매개 변수를 수정할 수 있습니다.

노트북 DeepSeek-R1에서 빠르게 증류를 실행하는 LlamaEdge

DeepSeek-R1은 고급 추론 기능, 비용 효율성, 오픈 소스 가용성으로 OpenAI와 같은 기존 업체에 도전하는 강력하고 다재다능한 AI 모델입니다. 몇 가지 한계가 있지만 혁신적인 접근 방식과 강력한 성능으로 개발자, 연구자, 비즈니스에 매우 유용한 도구입니다. 이 기능을 살펴보고 싶은 분들을 위해 이 모델과 라이트 버전은 Hugging Face 및 GitHub와 같은 플랫폼에서 사용할 수 있습니다.

GPU가 제한된 중국 팀에 의해 훈련된 이 모델은 수학, 코딩, 심지어 상당히 복잡한 추론에도 뛰어납니다. 가장 흥미로운 점은 '라이트' 모델이라는 점인데, 이는 기반이 되는 거대한 모델보다 더 작고 효율적이라는 것을 의미합니다. 이는 사람들이 실제로 사용하고 구축하는 데 더 실용적이기 때문에 중요합니다.

이 문서에서는 다음을 소개합니다.

- 내 기기에서 오픈소스를 실행하는 방법 DeepSeek 모델링

- 최신 DeepSeek 모델을 사용하여 OpenAI 호환 API 서비스를 만드는 방법

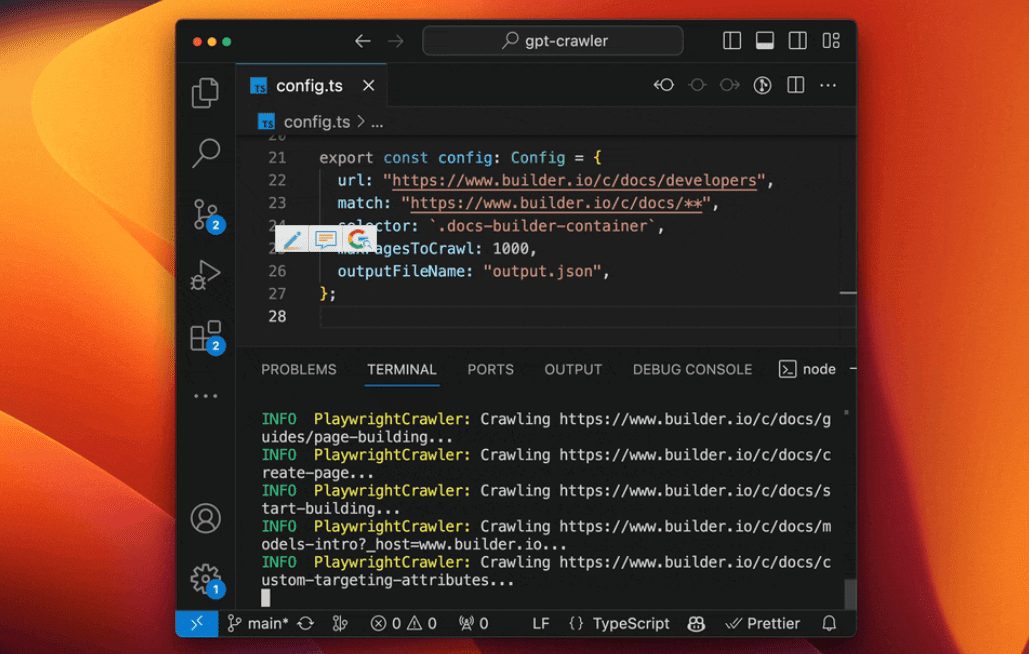

이 모델을 위한 애플리케이션을 개발하고 배포하기 위해 LlamaEdge(Rust + Wasm 기술 스택)를 사용할 것입니다. 복잡한 Python 패키지나 C++ 툴체인을 설치할 필요가 없습니다! 이 기술을 선택한 이유를 알아보세요.

자체 장비에서 DeepSeek-R1-Distill-Llama-8B 모델을 실행하세요!

1단계: 다음 명령줄을 통해 WasmEge를 설치합니다.

curl -sSf https://raw.githubusercontent.com/WasmEdge/WasmEdge/master/utils/install_v2.sh | bash -s -- -v 0.14.1

2단계: 양자화된 DeepSeek-R1-Distill-Llama-8B-GGUF 모델 파일을 다운로드합니다.

모델의 크기가 5.73GB이므로 시간이 다소 걸릴 수 있습니다.

curl -LO https://huggingface.co/second-state/DeepSeek-R1-Distill-Llama-8B-GGUF/resolve/main/DeepSeek-R1-Distill-Llama-8B-Q5_K_M.gguf`

3단계: LlamaEdge API 서버 애플리케이션을 다운로드합니다.

또한 다양한 CPU 및 GPU 장치에서 실행되는 크로스 플랫폼 휴대용 Wasm 애플리케이션입니다.

curl -LO https://github.com/LlamaEdge/LlamaEdge/releases/latest/download/llama-api-server.wasm

4단계: 챗봇 UI 다운로드

를 클릭해 브라우저에서 DeepSeek-R1-Distill-Llama-8B 모델과 상호 작용할 수 있습니다.

curl -LO https://github.com/LlamaEdge/chatbot-ui/releases/latest/download/chatbot-ui.tar.gz tar xzf chatbot-ui.tar.gz rm chatbot-ui.tar.gz

다음으로, 다음 명령 동작 모델을 사용하여 LlamaEdge API 서버를 시작합니다.

wasmedge --dir .:. --nn-preload default:GGML:AUTO:DeepSeek-R1-Distill-Llama-8B-Q5_K_M.gguf \ llama-api-server.wasm \ --prompt-template llama-3-chat \ --ctx-size 8096

그런 다음 브라우저를 열고 http://localhost:8080 을 방문하여 채팅을 시작하세요! 또는 모델에게 API 요청을 보낼 수도 있습니다.

curl -X POST http://localhost:8080/v1/chat/completions \

-H 'accept:application/json' \

-H 'Content-Type: application/json' \

-d '{"messages":[{"role":"system", "content": "You are a helpful assistant."}, {"role":"user", "content": "What is the capital of France?"}], "model": "DeepSeek-R1-Distill-Llama-8B"}'

{"id":"chatcmpl-68158f69-8577-4da2-a24b-ae8614f88fea","object":"chat.completion","created":1737533170,"model":"default","choices":[{"index":0,"message":{"content":"The capital of France is Paris.\n</think>\n\nThe capital of France is Paris.<|end▁of▁sentence|>","role":"assistant"},"finish_reason":"stop","logprobs":null}],"usage":{"prompt_tokens":34,"completion_tokens":18,"total_tokens":52}}

DeepSeek-R1-Distill-Llama-8B용 OpenAI 호환 API 서비스 만들기

라마에지는 가볍고 실행에 데몬이나 sudo 프로세스가 필요하지 않습니다. 자체 애플리케이션에 쉽게 임베드할 수 있습니다! 채팅 및 임베딩 모델을 지원하는 LlamaEdge는 로컬 컴퓨터의 애플리케이션 내부에서 OpenAI API의 대안이 될 수 있습니다!

다음으로 새 함수를 추가하는 방법을 보여드리겠습니다. DeepSeek-R1 모델과 임베딩 모델을 사용하여 전체 API 서버를 시작하면 API 서버는 chat/completions 노래로 응답 embeddings 엔드포인트. 이전 섹션의 단계 외에도 다음과 같이 해야 합니다:

5단계: 임베딩 모델을 다운로드합니다.

curl -LO https://huggingface.co/second-state/Nomic-embed-text-v1.5-Embedding-GGUF/resolve/main/nomic-embed-text-v1.5.f16.gguf

그런 다음 다음 명령줄을 사용하여 채팅 및 임베딩 모델과 함께 LlamaEdge API 서버를 시작할 수 있습니다. 자세한 지침은 문서 - LlamaEdge API 서비스 시작하기를 참조하세요.

wasmedge --dir .:. \ --nn-preload default:GGML:AUTO:DeepSeek-R1-Distill-Llama-8B-Q5_K_M.gguf \ --nn-preload embedding:GGML:AUTO:nomic-embed-text-v1.5.f16.gguf \ llama-api-server.wasm -p llama-3-chat,embedding \ --model-name DeepSeek-R1-Distill-Llama-8B,nomic-embed-text-v1.5.f16 \ --ctx-size 8192,8192 \ --batch-size 128,8192 \ --log-prompts --log-stat

마지막으로, 이 튜토리얼을 따라 OpenAI를 대체하여 다른 에이전트 프레임워크와 LlamaEdge API 서버를 통합할 수 있습니다. 구체적으로 애플리케이션 또는 에이전트 구성에서 OpenAI API를 다음 값으로 대체하세요.

| 구성 옵션 | (될) 가치 |

|---|---|

| 기본 API URL | http://localhost:8080/v1 |

| 모델명(대형 모델) | DeepSeek-R1-Distill-Llama-8B |

| 모델명(텍스트 삽입) | nomic-embed |

여기까지입니다! 지금 라마에지 리포지토리를 방문하여 첫 번째 AI 에이전트를 구축해 보세요! 흥미롭다면 여기에서 리포지토리에 별표를 표시해 주세요. 이 모델 실행에 대해 궁금한 점이 있으시면 리포지토리로 이동하여 질문하거나 데모를 예약하여 여러 기기에서 자체 LLM을 실행해 보세요!

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...