LiteLLM: 여러 빅 모델 API의 통합 호출을 위한 Python SDK, 멀티 플랫폼 LLM 호출 및 관리 도구

일반 소개

LiteLLM은 여러 대규모 언어 모델(LLM) API의 호출과 관리를 간소화하고 통합하기 위해 BerriAI에서 개발한 Python SDK 및 프록시 서버입니다. OpenAI, HuggingFace, Azure 등 100개 이상의 대규모 모델 API를 지원하며, 이를 OpenAI 형식으로 통합하여 개발자가 다양한 AI 서비스 간에 쉽게 전환하고 관리할 수 있도록 지원합니다. 또한 안정적인 Docker 이미지와 상세한 마이그레이션 가이드를 제공하며, LiteLLM은 프록시 서버와 Python SDK를 통해 100개 이상의 LLM API를 OpenAI 형식으로 호출할 수 있어 개발 효율과 유연성을 크게 향상시킵니다.

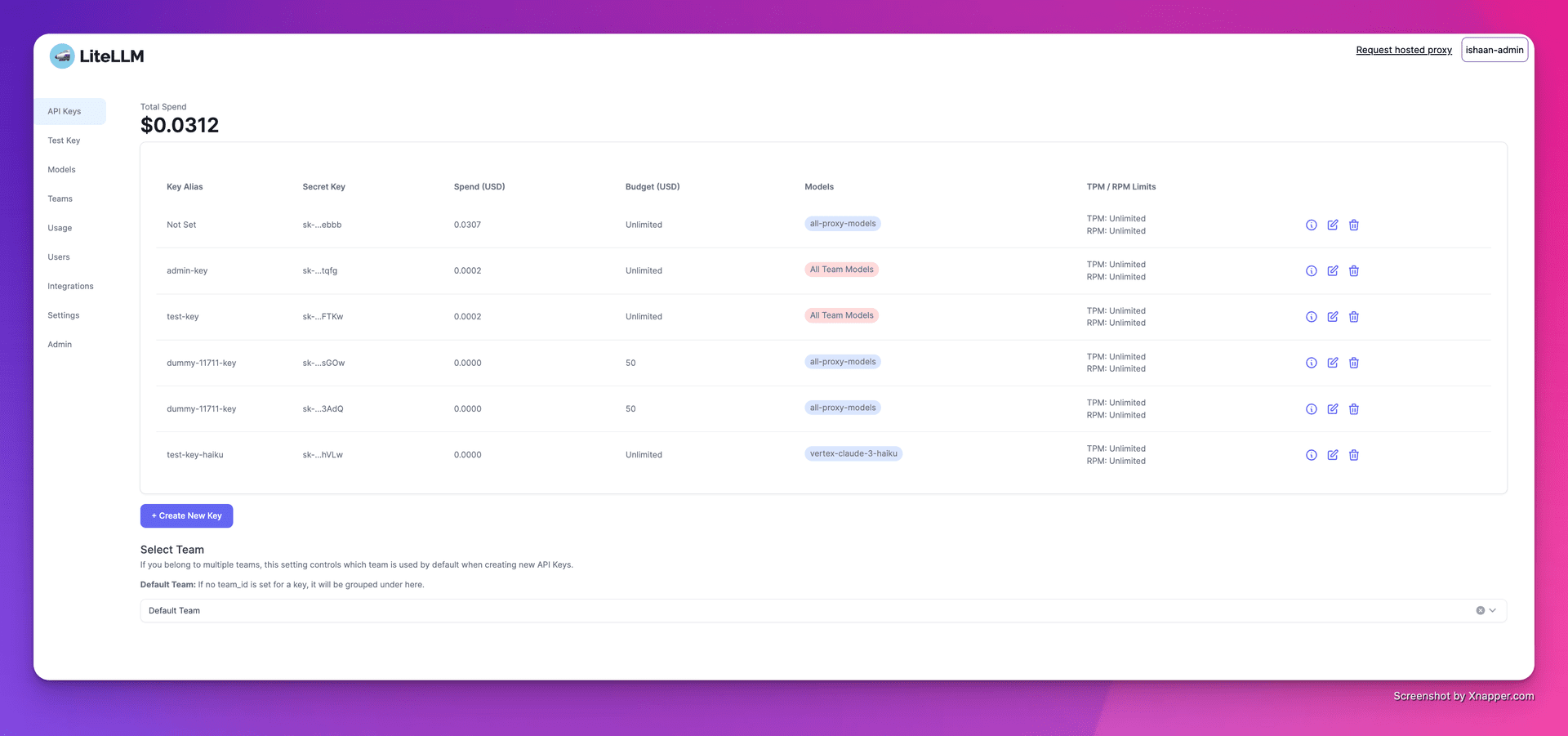

1. 키 만들기

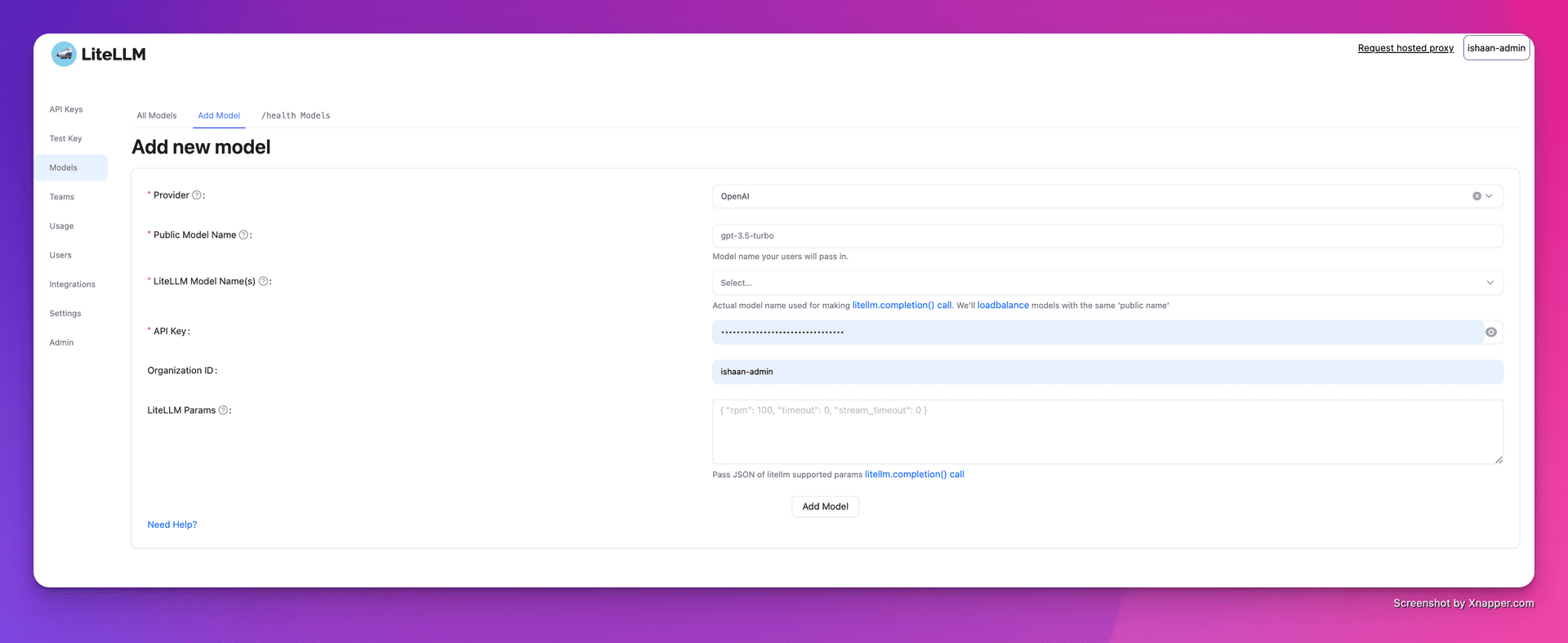

2. 모델 추가하기

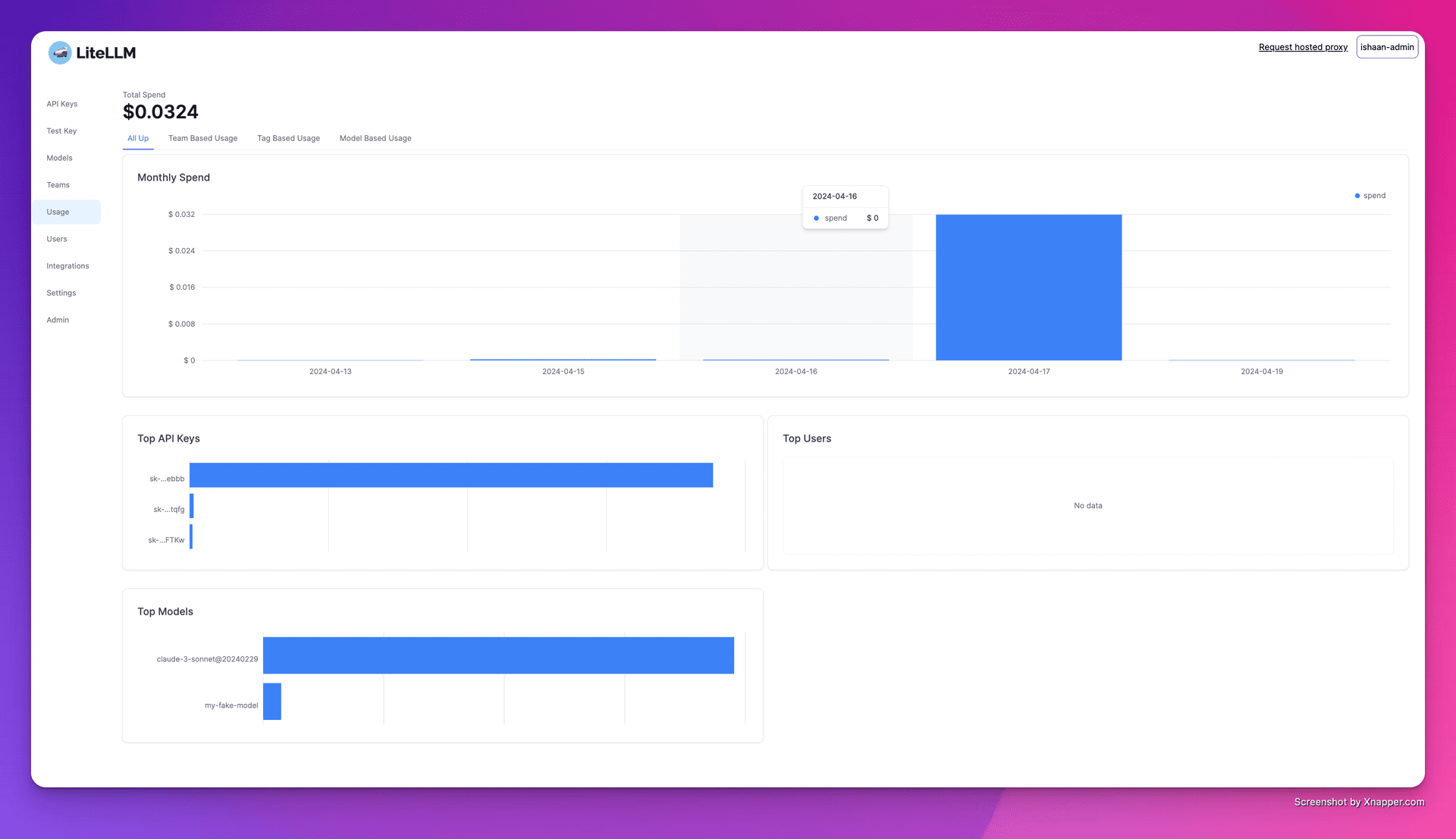

3. 지출 추적

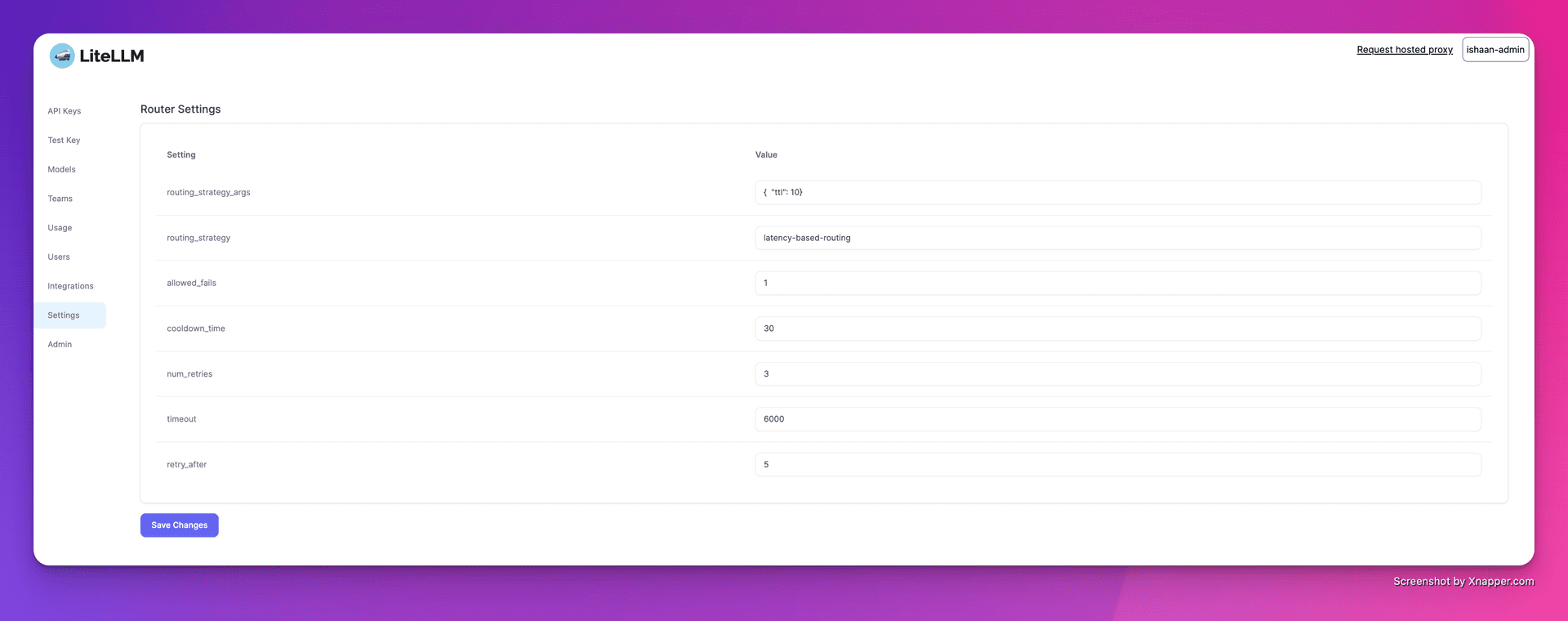

4. 로드 밸런싱 구성

기능 목록

- 멀티 플랫폼 지원OpenAI, Cohere, Anthropic 등 여러 LLM 제공업체를 지원합니다. 100개 이상의 빅 모델 API 호출을 지원합니다.

- 안정 버전12시간 동안 로드 테스트를 거친 안정적인 Docker 이미지를 제공합니다. 예산 및 요청 빈도 제한 설정을 지원합니다.

- 프록시 서버프록시 서버를 통해 여러 LLM API를 통합 호출하고, API 형식을 OpenAI 형식으로 통합 변환합니다.

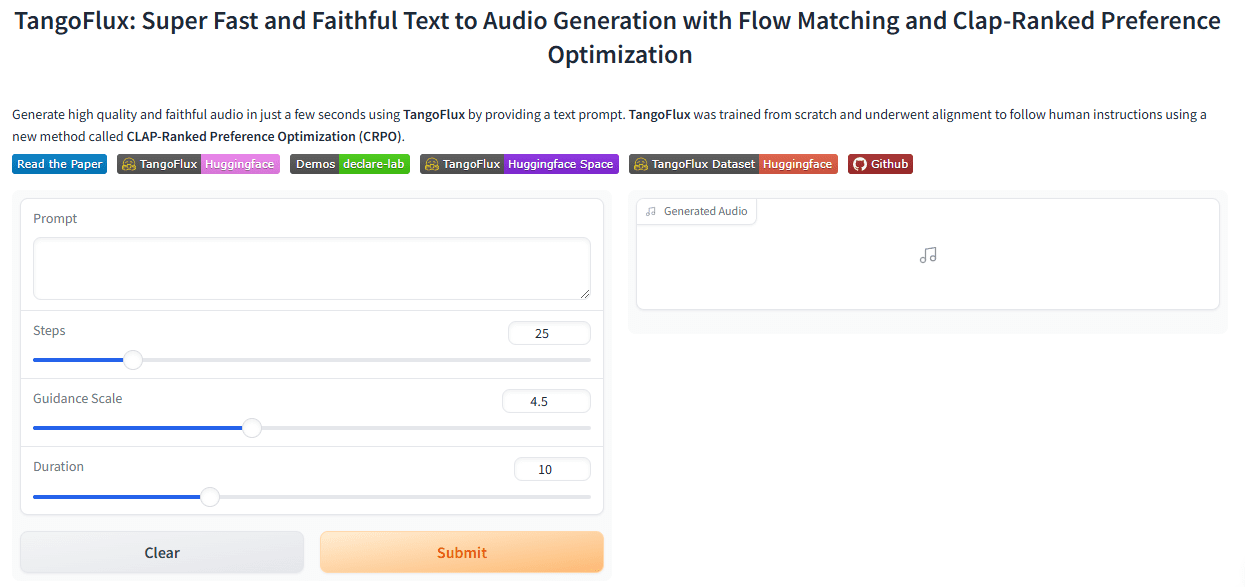

- Python SDK개발 프로세스를 간소화하기 위해 Python SDK가 제공됩니다.

- 스트리밍 응답사용자 경험을 개선하기 위해 반환 모델 응답 스트리밍을 지원합니다.

- 콜백 함수간편한 로깅 및 모니터링을 위해 다중 콜백을 지원합니다.

도움말 사용

설치 및 설정

- Docker 설치시스템에 Docker가 설치되어 있는지 확인합니다.

- 거울 당기기사용

docker pull명령은 LiteLLM의 안정적인 이미지를 가져옵니다. - 프록시 서버 시작하기::

cd litellm echo 'LITELLM_MASTER_KEY="sk-1234"' > .env echo 'LITELLM_SALT_KEY="sk-1234"' > .env source .env poetry run pytest . - 클라이언트 구성코드에서 프록시 서버 주소와 API 키를 설정합니다.

import openai client = openai.OpenAI(api_key="your_api_key", base_url="http://0.0.0.0:4000") response = client.chat.completions.create(model="gpt-3.5-turbo", messages=[{"role": "user", "content": "Hello, how are you?"}]) print(response)

사용 기능

- 호출 모델통해

model=<provider_name>/<model_name>다른 공급업체의 모델에 전화 걸기. - 스트리밍 응답: 설정

stream=True스트리밍 응답을 받습니다.response = await acompletion(model="gpt-3.5-turbo", messages=messages, stream=True) for part in response: print(part.choices.delta.content or "") - 콜백 설정: 입력 및 출력을 기록하는 콜백 함수를 구성합니다.

litellm.success_callback = ["lunary", "langfuse", "athina", "helicone"]

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...