이후(시간) Chatgpt 초창기에는 1억 1,700만 개(117M)였던 LLM(대규모 언어 모델) 파라미터 수가 4세대인 GPT-4에서는 1조 8,000억 개(1800B)로 갱신되는 등 각 회사마다 바닥을 기는 경쟁을 벌이고 있습니다.

Bloom(1760억 개, 176B), 친칠라(700억 개, 70B)와 같은 다른 LLM 모델과 마찬가지로 매개변수의 수도 급증하고 있습니다. 매개변수의 수는 모델의 성능과 기능에 직접적인 영향을 미치며, 매개변수가 많을수록 모델이 더 복잡한 언어 패턴을 처리하고 더 풍부한 문맥 정보를 이해하며 다양한 작업에서 더 높은 수준의 지능을 발휘할 수 있음을 의미합니다.

그러나 이러한 거대한 매개변수는 LLM의 교육 비용과 개발 환경에 직접적인 영향을 미치고 대부분의 일반 연구 회사에서 LLM을 탐색하는 데 제한을 두기 때문에 대형 언어 모델은 점차 대기업 간의 군비 경쟁으로 변질되고 있습니다.

최근 신흥 AI 기업인 텐서오페라(TensorOpera)는오픈 소스 소규모 언어 모델 FOX를 통해 소규모 언어 모델(SLM)이 지능형 분야에서도 충분히 강점을 발휘할 수 있음을 업계에 증명했습니다.

FOX는클라우드 및 엣지 컴퓨팅을 위해 설계된 소규모 언어 모델. 수백억 개의 매개 변수가 있는 대규모 언어 모델과 달리 FOX 16억 개에 불과한 매개변수하지만 여러 작업에서 놀라운 성능을 보여줄 수 있습니다.

논문 제목:

폭스-1 기술 보고서

논문 링크:

https://arxiv.org/abs/2411.05281

텐서오페라란 무엇인가요?

텐서오페라는 캘리포니아 실리콘밸리에 본사를 둔 혁신적인 인공 지능 회사입니다. 이전에 TensorOpera® AI 플랫폼 생성 AI 에코시스템과 TensorOpera® FedML 연방 학습 및 분석 플랫폼을 개발한 바 있습니다. 회사 이름인 텐서오페라는 기술과 예술을 결합한 것으로, 궁극적으로 다중 모드 및 다중 모델 복합 AI 시스템을 개발하겠다는 GenAI의 목표를 상징합니다.

텐서오페라의 공동 창립자이자 CEO인 자레드 카플란 박사는 "FOX 모델은 원래 고성능을 유지하면서 컴퓨팅 리소스 요구 사항을 크게 줄이도록 설계되었습니다. 이를 통해 AI 기술에 더 쉽게 접근할 수 있을 뿐만 아니라 비즈니스의 사용 장벽도 낮출 수 있습니다."라고 말합니다.

폭스 모델은 어떻게 작동하나요?

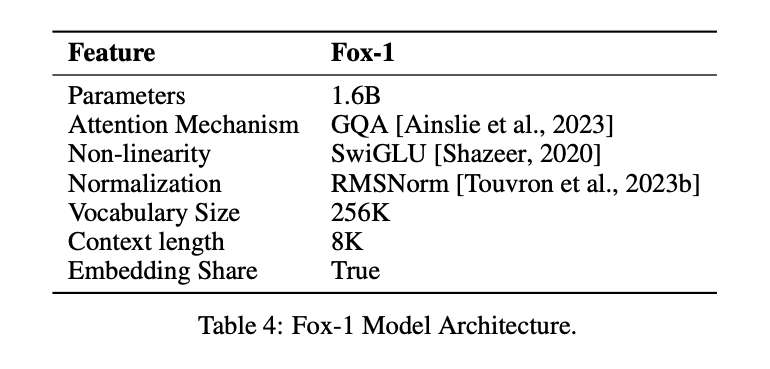

적은 수의 파라미터로 LLM과 동일한 효과를 얻기 위해 Fox-1 모델을 사용합니다.디코더 전용아키텍처를 개선하고 성능 향상을 위한 다양한 개선 사항과 재설계를 도입했습니다. 여기에는 다음이 포함됩니다.

① 네트워크 계층모델 아키텍처 설계에서 더 넓고 얕은 신경망은 더 나은 메모리 기능을 제공하는 반면, 더 깊고 간결한 네트워크는 더 강력한 추론 기능을 제공합니다. 이 원칙에 따라 Fox-1은 대부분의 최신 SLM보다 더 심층적인 아키텍처를 사용합니다. 구체적으로 Fox-1은 32개의 자기 주의적 레이어로 구성되어 있으며, 이는 Gemma-2B(18개 레이어)보다 781 TP3T 더 깊고 StableLM-2-1.6B(24개 레이어) 및 Qwen1.5-1.8B(24개 레이어)보다 331 TP3T 더 깊습니다.

② 공유 임베딩Fox-1은 2,048개의 숨겨진 차원을 사용하여 약 5억 개의 파라미터로 총 256,000개의 어휘를 구축합니다. 대규모 모델은 일반적으로 입력 레이어(어휘에서 임베딩된 표현으로)와 출력 레이어(임베딩된 표현에서 어휘로)에 별도의 임베딩 레이어를 사용합니다. Fox-1의 경우 임베딩 레이어에만 10억 개의 파라미터가 필요합니다. 총 파라미터 수를 줄이기 위해 입력과 출력 임베딩 레이어를 공유하면 가중치 활용도를 극대화할 수 있습니다.

(iii) 사전 정규화Fox-1은 각 변환 레이어의 입력을 정규화하기 위해 RMSNorm을 사용합니다. 최신 대규모 언어 모델에서 사전 정규화를 위해 선호되는 RMSNorm은 LayerNorm보다 더 나은 효율성을 보여줍니다.

④ 로터리 위치 인코딩(RoPE)Fox-1은 기본적으로 최대 8K 길이의 입력 토큰을 허용하며, 더 긴 컨텍스트 창에서 성능을 향상시키기 위해 θ를 10,000으로 설정하여 인코딩하는 회전 위치 인코딩을 사용합니다. 토큰 사이의 상대적 위치 의존성

⑤ 그룹 쿼리 주의(GQA)그룹화된 쿼리 주의는 멀티 헤드 주의 레이어의 쿼리 헤드를 그룹으로 나누어 각각 동일한 키-값 헤드 세트를 공유하며, Fox-1에는 4개의 키-값 헤드와 16개의 주의 헤드를 장착하여 학습 및 추론 속도를 높이고 메모리 사용량을 줄입니다.

모델링 구조 개선 외에도.FOX-1은 토큰화와 트레이닝도 개선했습니다..

품사(중국어 문법)Fox-1은 256K의 어휘 크기를 제공하는 SentencePiece 기반 Gemma 분류기를 사용합니다. 어휘 크기를 늘리면 적어도 두 가지 주요 이점이 있습니다. 첫째, 각 토큰이 더 밀도 높은 정보를 인코딩하기 때문에 문맥에 숨겨진 정보의 길이가 확장됩니다. 예를 들어, 26 크기의 어휘는 [a-z]의 한 글자만 인코딩할 수 있지만 262 크기의 어휘는 두 글자를 동시에 인코딩할 수 있으므로 고정 길이 토큰에 더 긴 문자열을 표현할 수 있습니다. 둘째, 어휘 크기가 클수록 알 수 없는 단어나 구가 발생할 확률이 줄어들어 실제로 더 나은 다운스트림 작업 성능으로 이어지며, Fox-1에서 사용하는 큰 어휘는 주어진 텍스트 코퍼스에 대해 더 적은 수의 토큰을 생성하여 더 나은 추론 성능을 산출합니다.

Fox-1사전 교육 데이터총 3조 개의 텍스트 데이터로 구성된 Redpajama, SlimPajama, Dolma, Pile, Falcon 데이터 세트에서 제공되었습니다. 주의 메커니즘으로 인해 긴 시퀀스에 대한 사전 훈련의 비효율성을 완화하기 위해 Fox-1은 사전 훈련 단계에서 다음과 같은 기능을 도입했습니다.3단계 커리큘럼 학습 전략Fox-1은 적은 비용으로 긴 컨텍스트 기능을 보장하기 위해 훈련 샘플의 청크 길이를 2K에서 8K로 점진적으로 늘리는 3단계 코스 사전 훈련 파이프라인입니다. 3단계 코스 사전 훈련 파이프라인과 일관성을 유지하기 위해 Fox-1은 원시 데이터를 비지도 및 지도 튜닝 데이터 세트와 코드, 웹 콘텐츠, 수학 및 과학 문서와 같은 다양한 도메인의 데이터를 포함한 세 가지 다른 데이터 세트로 재구성합니다.

Fox-1 교육은 세 단계로 나눌 수 있습니다..

- 첫 번째 단계는 사전 훈련 과정에서 약 39%의 총 데이터 샘플로 구성되며, 이 단계에서 1.05조 개의 토큰 데이터 세트가 2,000개의 길이 샘플로 분할되고 배치 크기는 2M이며, 2,000epoch의 선형 웜업이 사용됩니다.

- 두 번째 단계에는 약 59% 샘플과 1조 5,800억 개의 토큰이 포함되며 청크 길이가 2K에서 4K 및 8K로 증가하며, 실제 청크 길이는 데이터 소스에 따라 달라집니다. 두 번째 단계는 가장 오랜 시간이 걸리고 다양한 데이터 세트의 다양한 소스를 포함한다는 점을 고려하여 학습 효율을 높이기 위해 배치 크기도 4M으로 늘렸습니다.

- 마지막으로 세 번째 단계에서는 62억 개의 토큰(전체의 약 0.02%)의 고품질 데이터를 사용하여 Fox 모델을 학습시켜 명령 팔로우, 스몰 토크, 도메인별 Q&A 등과 같은 다양한 다운스트림 작업 기능의 기반을 마련합니다.

Fox-1의 성과는 어땠나요?

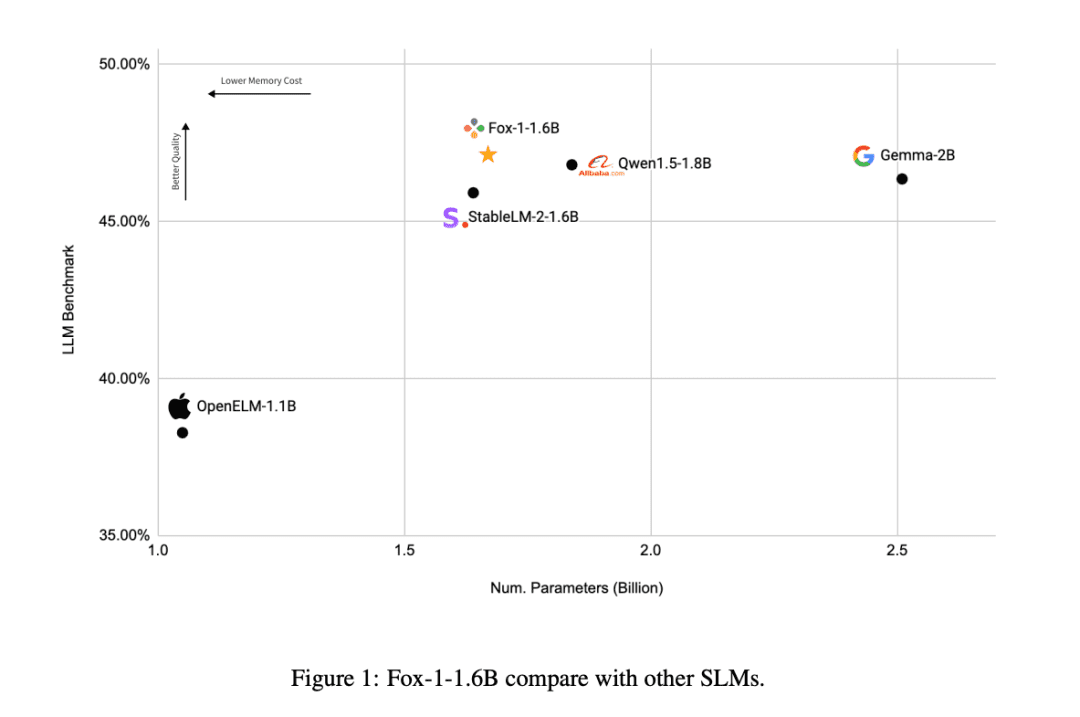

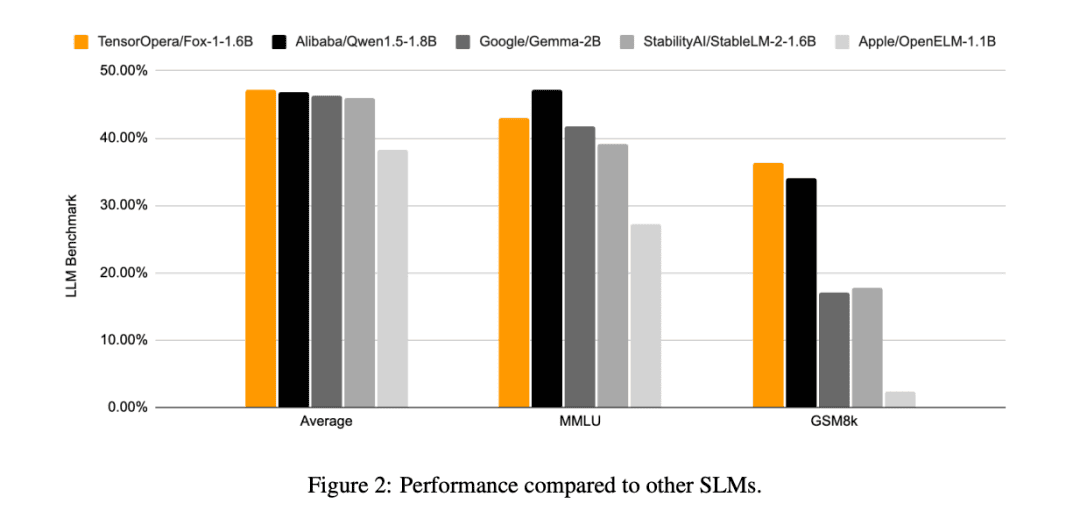

다른 SLM 모델(Gemma-2B, Qwen1.5-1.8B, StableLM-2-1.6B 및 OpenELM1.1B)에 비해 FOX-1은 ARC Challenge(25샷), HellaSwag(10샷), TruthfulQA(0샷), MMLU(5샷), Winogrande(5샷), GSM8k(5샷), GSM8k(5샷) 및 GSM8k(5샷)에서 더 성공적인 결과를 얻었습니다. MMLU(5샷), 위노그란데(5샷), GSM8k(5샷)6개 작업의 벤치마크 평균 점수는 GSM8k에서 가장 높았으며, 훨씬 더 우수했습니다.

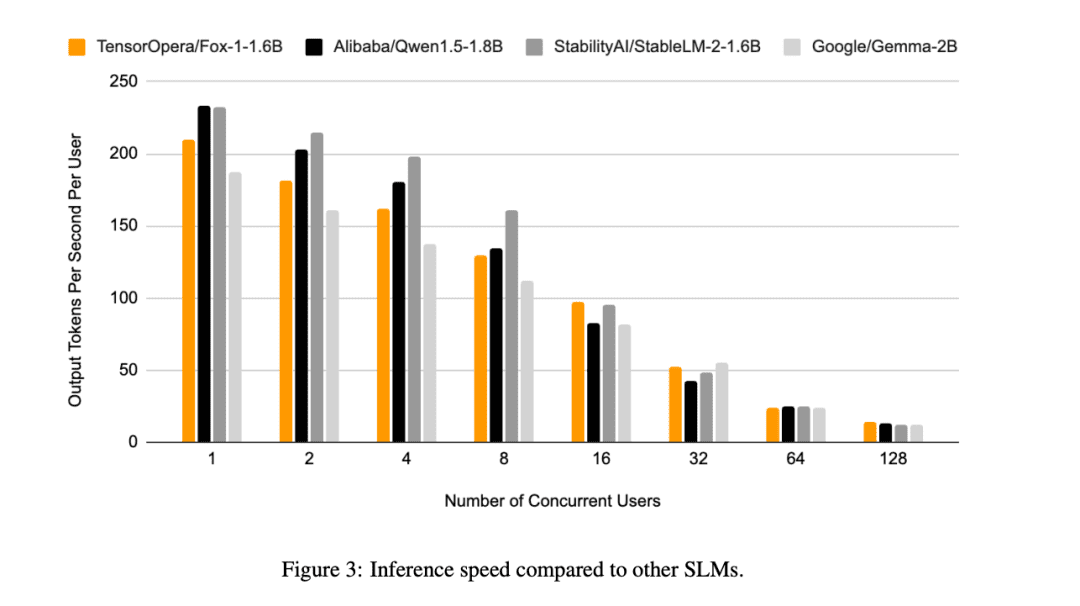

이 외에도, 텐서오페라에서는 폭스-1, 퀀1.5-1.8B, 젬마-2B를 다음과 같이 평가했습니다. vLLM 단일 NVIDIA H100에서 TensorOpera 서비스 플랫폼으로 엔드투엔드 추론의 효율성을 높입니다.

Fox-1은 초당 200개 이상의 토큰 처리량을 달성하여 동일한 배포 환경에서 Gemma-2B를 능가하고 Qwen1.5-1.8B와 비슷한 성능을 발휘합니다. BF16 정밀도에서 Fox-1은 3703MiB의 GPU 메모리만 필요한 반면, Qwen1.5-1.8B, StableLM-2-1.6B 및 Gemma-2B는 각각 4739MiB, 3852MiB 및 5379MiB가 필요합니다.

작은 매개 변수이지만 여전히 경쟁력 있는

현재 모든 AI 기업이 대규모 언어 모델에서 경쟁하고 있는 가운데, TensorOpera는 SLM 영역에서 돌파구를 마련하여 16억 달러만으로 LLM과 유사한 결과를 달성하고 다양한 벤치마크에서 좋은 성과를 거두는 등 다른 접근 방식을 취하고 있습니다.

데이터 리소스가 제한되어 있어도 TensorOpera는 경쟁력 있는 성능으로 언어 모델을 사전 학습할 수 있어 다른 AI 회사가 개발할 수 있는 새로운 사고 방식을 제공합니다.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...