Jina AI는 오픈 웹의 노이즈가 많은 원시 HTML을 깔끔한 마크다운 형식으로 변환하도록 설계된 두 가지 소형 언어 모델인 Reader-LM-0.5B와 Reader-LM-1.5B를 출시했으며, 최대 256K 토큰의 컨텍스트 길이를 지원하고 변환 작업에서 대형 언어 모델과 비슷하거나 더 나은 성능을 보여줍니다. 변환 작업의 성능.

머리말

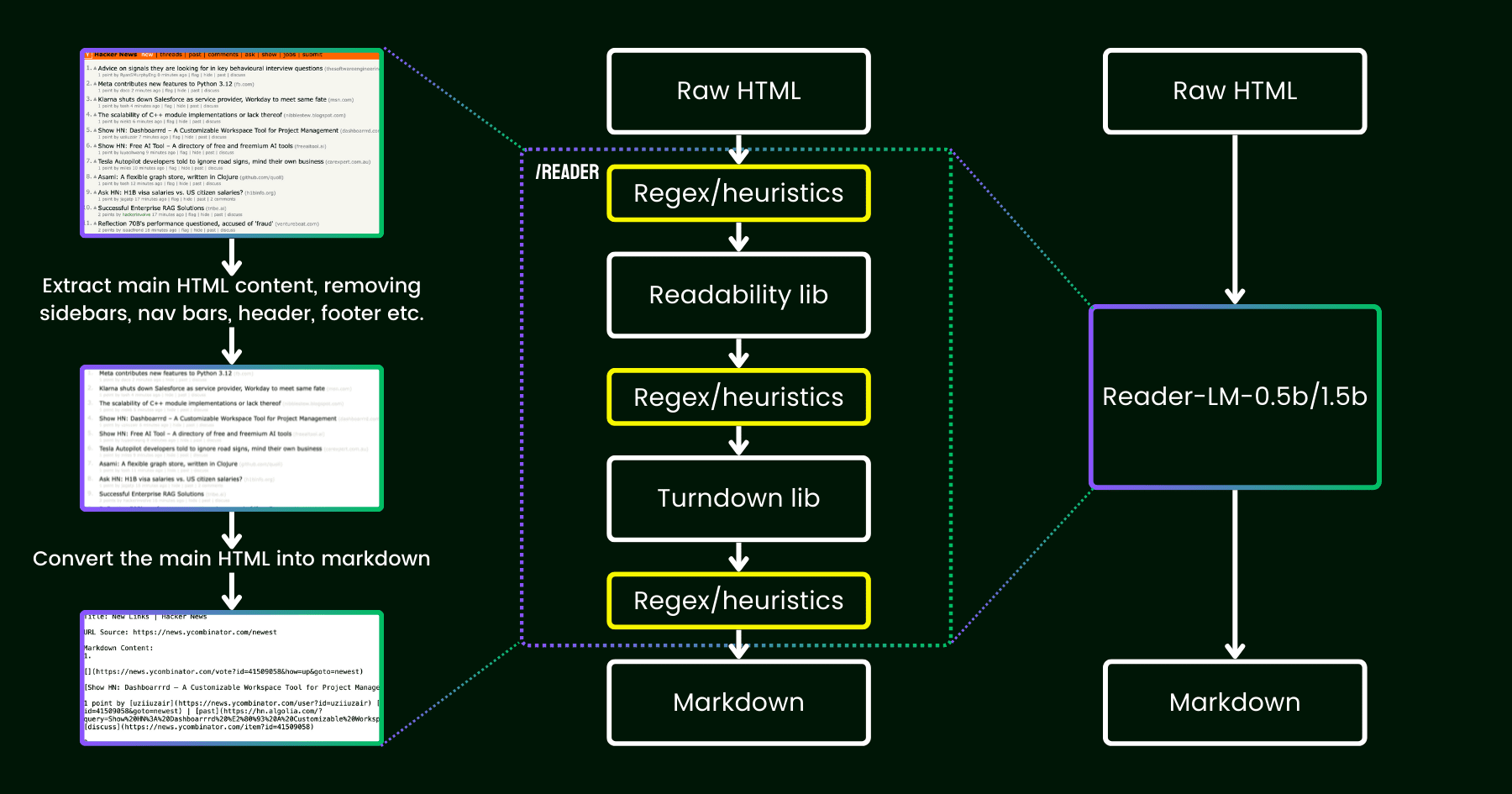

2024년 4월, Jina AI는 모든 URL을 LLM 친화적인 마크다운으로 변환하는 간단한 API인 Jina Reader를 출시했습니다. 이 API는 헤드리스 크롬 브라우저를 사용하여 웹 페이지의 소스 코드를 가져오고, Mozilla의 가독성 패키지를 사용하여 주요 콘텐츠를 추출한 다음, 정리된 HTML을 정규식 및 턴다운 라이브러리를 사용하여 정리된 HTML을 마크다운으로 변환합니다.

출시 후 사용자 피드백을 통해 콘텐츠 품질에 문제가 있다는 지적이 있었고, Jina AI는 기존 파이프라인을 패치하여 이를 해결했습니다.

그 이후로 우리는 더 많은 휴리스틱과 정규식(유지 관리가 점점 더 어려워지고 다국어에 도움이 되지 않음)을 땜질하는 대신 언어 모델을 사용하여 이 문제를 엔드투엔드 방식으로 해결할 수 없을까 하는 질문을 고민해 왔습니다.

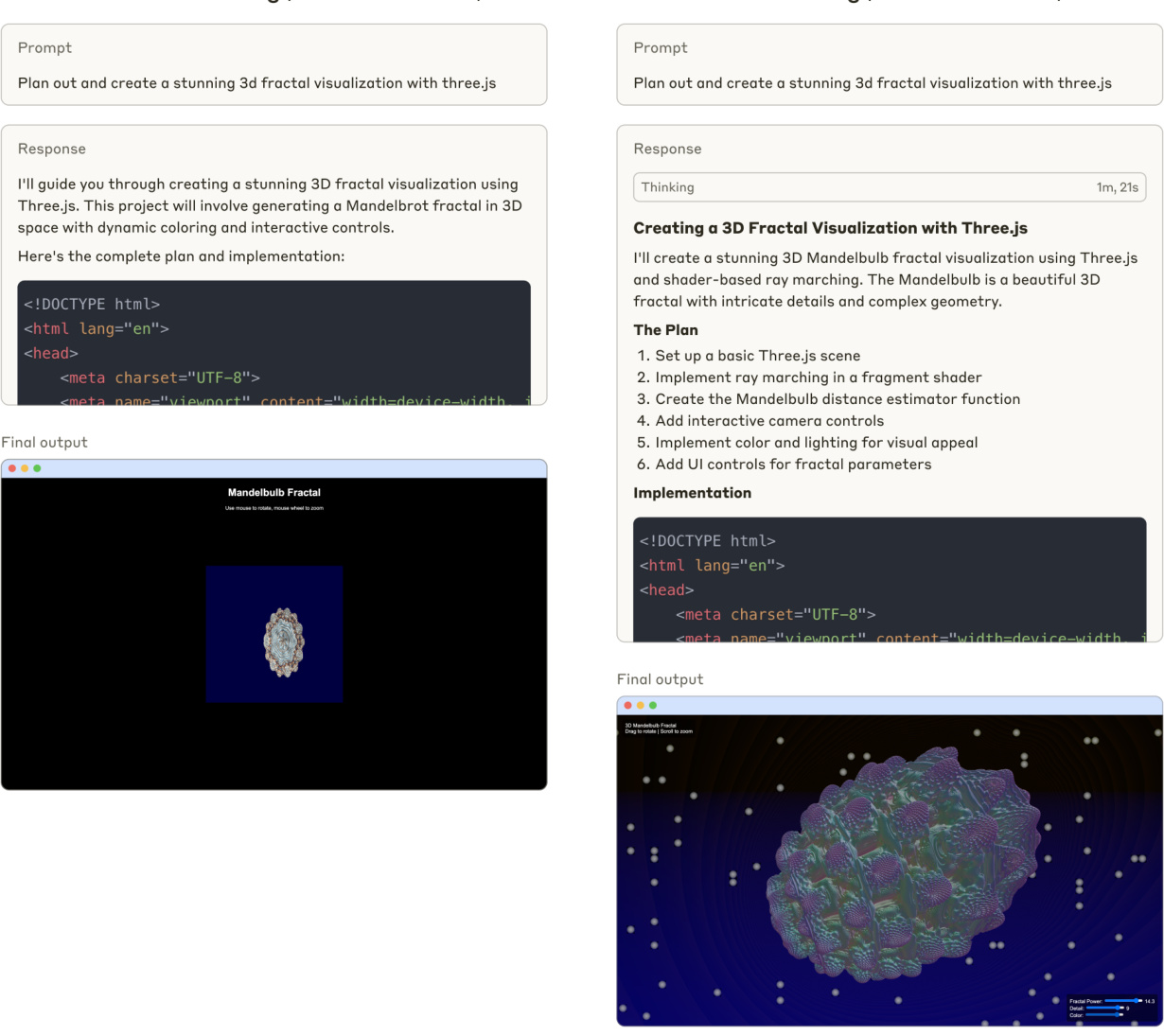

가독성+턴다운+레그엑스 휴리스틱의 파이프라인을 작은 언어 모델로 대체하는 reader-lm을 설명하는 그림입니다.

Reader-LM 정보

2024년 9월 11일 -- 콘텐츠 처리 및 텍스트 변환을 위한 인공 지능 분야의 혁신을 지속적으로 주도하고 있는 Jina AI는 오늘 최신 기술 성과인 Reader-LM-0.5B 및 Reader-LM-1.5B, 두 개의 소규모 언어 모델입니다. 이 모델은 오픈 웹에서 원시 HTML 콘텐츠 처리의 새로운 시대를 열어 복잡한 HTML을 구조화된 마크다운 형식으로 효율적으로 변환하여 빅데이터 시대의 콘텐츠 관리 및 머신러닝 애플리케이션에 강력한 지원을 제공합니다.

획기적인 성능과 효율성

Reader-LM-0.5B 및 Reader-LM-1.5B 모델은 작은 매개변수 크기를 유지하면서 더 큰 언어 모델과 비슷하거나 더 나은 성능을 달성합니다. 최대 256K 토큰의 컨텍스트 길이를 지원하는 이 모델은 인라인 CSS, 스크립트 등과 같은 최신 HTML의 노이즈 요소를 처리하여 깔끔하고 잘 구조화된 마크다운 파일을 생성합니다. 이는 원시 웹 콘텐츠에서 텍스트를 추출하고 변환해야 하는 사용자에게 매우 편리합니다.

사용자 친화적인 실습 경험

Jina AI는 이 문제에 대한 해결책을 Google Colab(0.5B노래로 응답1.5BReader-LM 모델은 사용자가 Reader-LM 노트를 사용해 Reader-LM 모델의 강력한 기능을 쉽게 체험할 수 있도록 설계되었습니다. 다른 버전의 모델을 로드하거나, 처리된 사이트의 URL을 변경하거나, 결과물을 탐색하는 등 사용자는 무료 클라우드 기반 환경에서 이러한 작업을 수행할 수 있습니다. 또한, 곧 Azure 및 AWS 마켓플레이스에서 Reader-LM을 사용할 수 있게 되어 엔터프라이즈 사용자에게 더 많은 통합 및 배포 옵션을 제공할 예정입니다.

기존 모델을 뛰어넘는 성능

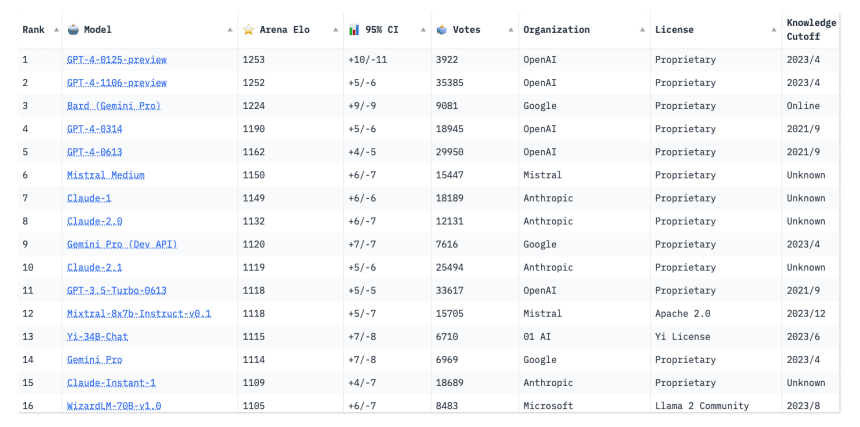

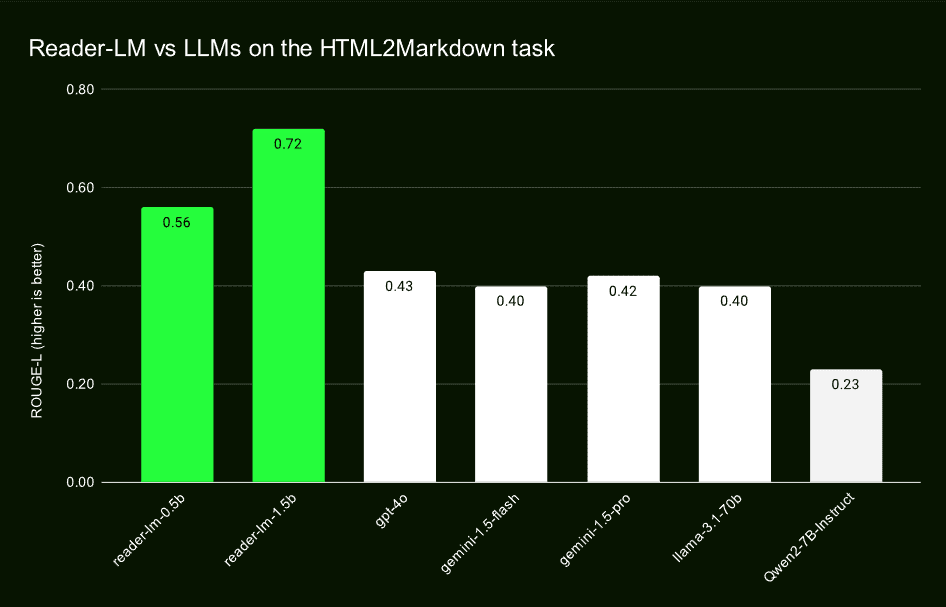

GPT-4o, Gemini-1.5-Flash, Gemini-1.5-Pro, LLaMA-3.1-70B 및 Qwen2-7B-Instruct와 같은 대규모 언어 모델과의 비교 테스트를 통해 Reader-LM은 ROUGE-L, 단어 오류율(WER) 및 다음과 같은 항목에서 우수한 결과를 보였습니다. 토큰 오류율(TER) 등 여러 주요 지표에서 높은 점수를 받았습니다. 이러한 평가는 정확성, 회수율, 깔끔한 마크다운 생성 능력에서 Reader-LM의 리더십을 입증합니다.

정성적 연구로 확인된 이점

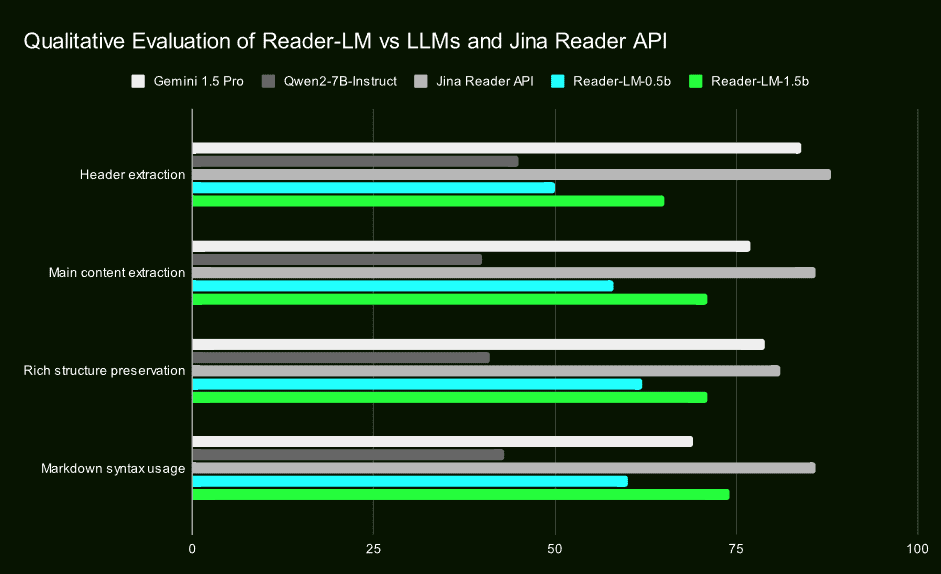

정량적 평가 외에도, Jina AI는 시각적으로 검사된 출력 마크다운에 대한 정성적 연구를 통해 헤드라인 추출, 주요 내용 추출, 구조 유지 및 마크다운 구문 사용에서 Reader-LM의 우수한 성능을 확인했습니다. 이러한 결과는 실제 애플리케이션에서 Reader-LM의 효율성과 신뢰성을 강조합니다.

2단계 교육에 대한 혁신적인 접근 방식

Jina AI는 데이터 준비, 2단계 학습, 모델 성능 저하 및 사이클링 문제를 극복한 방법 등 Reader-LM 학습 프로세스에 대한 자세한 내용을 공개했습니다. 특히 학습 데이터 품질의 중요성을 강조하며 비교 검색 및 반복 중지 기준과 같은 기술적 수단을 통해 모델의 안정성과 생성 품질을 보장했습니다.

궁극

Jina AI의 Reader-LM은 소규모 언어 모델링 분야의 획기적인 발전일 뿐만 아니라 개방형 웹 콘텐츠 처리 기능도 크게 향상시켰습니다. 이 두 모델의 출시는 개발자와 데이터 과학자에게 효율적이고 사용하기 쉬운 도구를 제공할 뿐만 아니라 콘텐츠 추출, 정리 및 변환에서 AI 애플리케이션의 새로운 가능성을 열어줍니다.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...