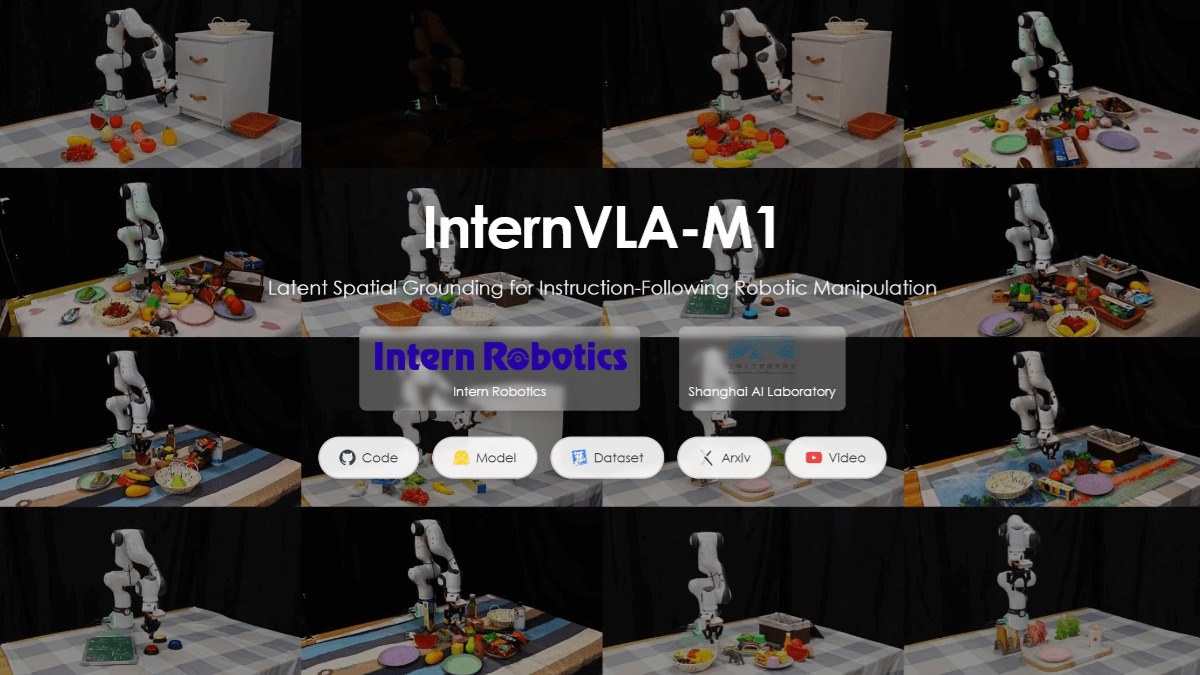

InternVLA-M1이란 무엇인가요?

InternVLA-M1은 상하이 인공 지능 연구소의 오픈 소스로 구현된 운영 '두뇌'로, 명령에 따라 작동하는 두 가지 시스템 운영의 대형 모델입니다. 이 모델은 '사고-행동-학습'을 포괄하는 완전한 폐쇄 루프를 구축하며 높은 수준의 공간 추론과 작업 계획을 담당합니다. 이 모델은 먼저 공간 지각 사전 훈련을 통해 공간 추론 및 계획 능력을 향상시킨 다음, 암묵적 공간 추론을 통해 효율적인 사후 훈련을 달성하는 2단계 훈련 전략을 채택합니다. 효율적인 훈련을 위해 '공간 계획 힌트'만 필요하므로 비용이 크게 절감됩니다. InternVLA-M1은 SimplerEnv와 같은 공공 운영 벤치마크에서 국제 최고 수준에 도달했으며, 명령 추종 및 보이지 않는 객체 일반화 기능은 다른 유사 모델보다 훨씬 뛰어납니다. 자체 개발한 시뮬레이션 플랫폼인 InternData-M1을 기반으로 하는 InternVLA-M1은 복잡한 시나리오와 장거리 작업에 적합한 대규모 사전 훈련을 완료합니다.

InternVLA-M1의 기능적 특징

- 고차원적 공간 추론 능력복잡한 공간 환경을 정확하게 인지하고 추론하여 작업 경로와 동작 순서를 효과적으로 계획할 수 있습니다.

- 이중 시스템 교육 전략공간 지각 사전 훈련과 행동 사후 훈련을 결합하여 다양한 작업에서 모델의 적응력과 일반화 능력을 향상시킵니다.

- 효율적인 교육 및 비용 최적화공간 계획 단서를 통해 효율적인 훈련을 달성하고, 훈련 비용과 시간을 크게 줄이며, 모델 활용도를 개선합니다.

- 지시 사항 따르기 및 일반화 기능강력한 명령 구문 분석 및 실행 기능, 자연어 명령의 정확한 이해 및 실행, 보이지 않는 객체 및 새로운 작업에 대한 우수한 일반화 성능.

- 자율 학습 및 폐쇄 루프 제어모델을 실제로 학습하고 최적화하여 동적 환경에 맞게 조정할 수 있도록 완전한 '사고-행동-학습' 폐쇄형 루프를 구축합니다.

- 복잡한 장면 적응성실제 기계가 복잡한 장면과 장거리 작업에서 뛰어난 성능을 발휘하여 산업 자동화, 물류 및 창고와 같은 다양한 실제 적용 시나리오에 적합합니다.

- 오픈 소스 및 커뮤니티 지원오픈 소스 데이터 및 코드로, 연구자와 개발자가 커뮤니티에서 혁신과 애플리케이션 개발을 촉진할 수 있도록 풍부한 리소스를 제공합니다.

InternVLA-M1의 핵심 이점

- 효율적인 인스트럭션 팔로우 및 일반화 기능자연어 명령을 정확하게 이해하고 실행 가능한 작업 시퀀스를 생성하며 보이지 않는 객체와 새로운 작업에 대한 강력한 일반화 기능을 보여줍니다.

- 혁신적인 듀얼 시스템 아키텍처공간 인식 사전 학습과 행동 사후 학습을 결합하여 인식에서 행동까지 폐쇄 루프 실행을 달성하고 모델의 안정성과 적응성을 향상시킵니다.

- 공간 계획에 기반한 교육 전략공간 계획 힌트를 도입하여 훈련 효율성과 모델 성능을 크게 향상시키는 효율적인 훈련이 가능합니다.

- 대규모 시뮬레이션 데이터 지원자체 개발한 시뮬레이션 플랫폼 InternData-M1을 기반으로 대량의 고품질 학습 데이터를 생성하여 모델의 일반화 능력과 업무 적응력을 높입니다.

- 오픈 소스 및 커뮤니티 지원오픈 소스 코드와 데이터를 제공하여 연구자와 개발자가 커뮤니티에서 혁신과 애플리케이션 개발을 촉진할 수 있도록 풍부한 리소스를 제공합니다.

- 최고의 성능특히 복잡한 시나리오와 장거리 작업에서 여러 공공 운영 벤치마크에서 국제적인 리더십을 달성했습니다.

- 멀티 시나리오 적용 가능성가정, 산업, 물류, 교육 등 다양한 분야에 적용 가능하며, 범용 로봇의 실제 현장 적용을 위한 강력한 기술적 기반을 구축합니다.

InternVLA-M1의 공식 웹사이트는 무엇인가요?

- 프로젝트 웹사이트:: https://internrobotics.github.io/internvla-m1.github.io/

- 깃허브 리포지토리:: https://github.com/InternRobotics/InternVLA-M1

- 허깅페이스 모델 라이브러리:: https://huggingface.co/collections/InternRobotics/internvla-m1-68c96eaebcb5867786ee6cf3

- 허깅페이스 데이터 링크:: https://huggingface.co/datasets/InternRobotics/InternData-M1

- 기술 문서:: https://github.com/InternRobotics/InternVLA-M1/blob/InternVLA-M1/assets/InternVLA_M1.pdf

InternVLA-M1이 표시되는 사람

- 인공 지능 및 로봇 공학 연구원구현 지능, 로봇 조작, 시각 언어 모델링 분야의 연구자들은 InternVLA-M1을 사용하여 새로운 기술 경로와 응용 시나리오를 탐색할 수 있습니다.

- 로보틱스 시스템 개발 엔지니어로봇 시스템의 개발, 통합 및 최적화에 관여하는 엔지니어는 인턴VLA-M1을 사용하여 복잡한 작업에서 로봇의 작동 및 명령 수행 능력을 향상시킬 수 있습니다.

- 대학 및 연구 기관의 교사 및 학생컴퓨터 과학, 자동화, 로봇 공학 및 기타 관련 분야의 교수진과 학생은 실습 프로젝트와 학술 연구를 위한 교육 및 연구 도구로 InternVLA-M1을 사용할 수 있습니다.

- 산업 자동화 및 지능형 제조 기업InternVLA-M1은 생산 라인에 더 스마트하고 유연한 로봇 솔루션을 도입하여 자동화 업그레이드와 효율성 향상을 실현하고자 하는 기업을 위해 설계되었습니다.

- 물류 및 창고 업계 실무자물류 자동화 및 창고 최적화에 관심이 있는 기업 및 전문가를 위해 InternVLA-M1은 상품 피킹 및 취급의 지능적인 작업에 사용할 수 있습니다.

- 서비스 로봇 개발자InternVLA-M1은 로봇의 상호작용 및 작업 수행 능력을 향상시키고 홈 서비스 로봇과 상업용 서비스 로봇을 개발하는 팀의 적용 범위를 확장할 수 있습니다.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...